Статистика Дарбина

реклама

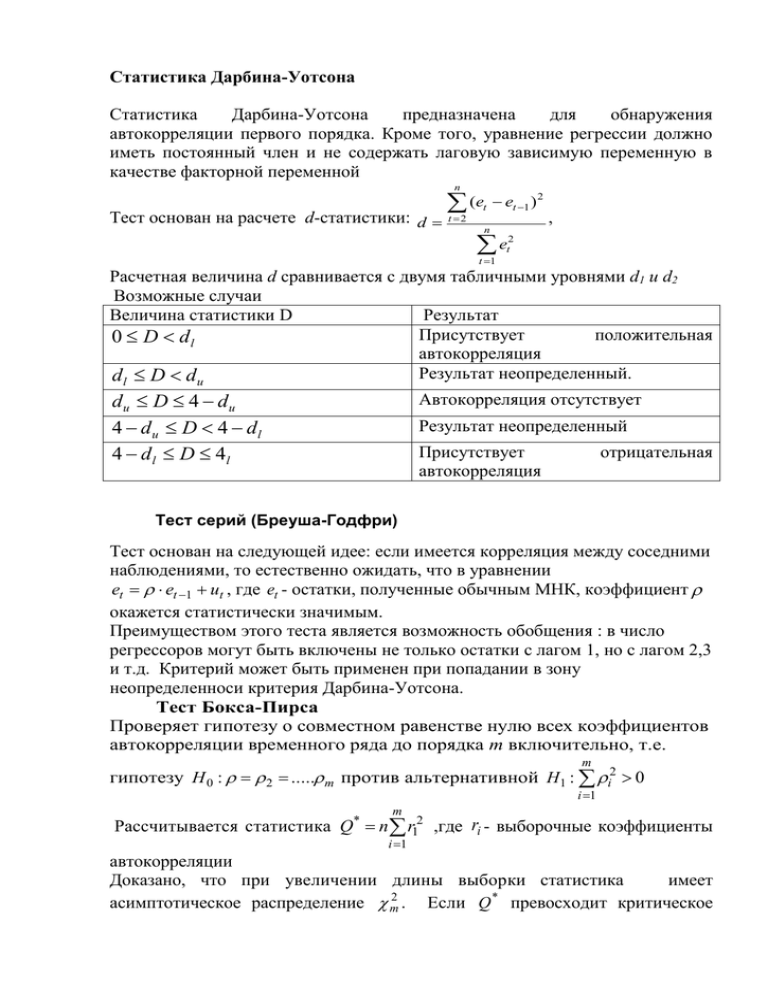

Статистика Дарбина-Уотсона Статистика Дарбина-Уотсона предназначена для обнаружения автокорреляции первого порядка. Кроме того, уравнение регрессии должно иметь постоянный член и не содержать лаговую зависимую переменную в качестве факторной переменной n Тест основан на расчете d-статистики: d (et et 1 ) 2 t 2 n , et2 t 1 Расчетная величина d сравнивается с двумя табличными уровнями d1 и d2 Возможные случаи Величина статистики D Результат Присутствует положительная 0 D dl автокорреляция Результат неопределенный. dl D du du D 4 du 4 du D 4 dl 4 d l D 4l Автокорреляция отсутствует Результат неопределенный Присутствует автокорреляция отрицательная Тест серий (Бреуша-Годфри) Тест основан на следующей идее: если имеется корреляция между соседними наблюдениями, то естественно ожидать, что в уравнении et et 1 ut , где et - остатки, полученные обычным МНК, коэффициент окажется статистически значимым. Преимуществом этого теста является возможность обобщения : в число регрессоров могут быть включены не только остатки с лагом 1, но с лагом 2,3 и т.д. Критерий может быть применен при попадании в зону неопределенноси критерия Дарбина-Уотсона. Тест Бокса-Пирса Проверяет гипотезу о совместном равенстве нулю всех коэффициентов автокорреляции временного ряда до порядка т включительно, т.е. m гипотезу H 0 : 2 ..... m против альтернативной H1 : i2 0 i 1 m Рассчитывается статистика Q* n r12 ,где ri - выборочные коэффициенты i 1 автокорреляции Доказано, что при увеличении длины выборки статистика имеет 2 * асимптотическое распределение m . Если Q превосходит критическое значение m2 , то автокоррелирован. нулевая гипотеза отвергается и ряд остатков Тест Бокса-Льюинга m Рассчитывается статистика Q (n 2) n (n i) 1ri2 i 1 По сравнению со статистикой Бокса-Пирса различным слагаемым приданы разные веса. Доказано, что эта статистика имеет также асимптотическое распределение m2 , но лучше им аппроксимируется при конечном числе наблюдений. Если расчетное значение статистики Бокса и Льюнга превосходит критическое значение m2 , то признается наличие автокорреляции (до m -го порядка) в ряду остатков. Метод множителей Лагранжа Методом МНК строится обычная регрессия вида Y 0 1 X 1 2 X 2 k X k . Обозначим остатки ее оценочной модели через et . Строится регрессия либо той же объясняемой переменной Yt , либо остатков et на старые регрессоры и остатки с лагом до р включительно (то есть в качестве дополнительных объясняющих переменных используем ( et 1, et 2 ....et p ) Проверяется гипотеза о том, что группа дополнительных переменных является излишней, Если в качестве объясняемой переменной используются остатки, то 2 2 статистика U= nR где n - число наблюдений, a R — коэффициент множественной детерминации имеет асимптотическое (при увеличении 2 числа наблюдений) распределение с р степенями свободы. 2 U , p Если то гипотеза об отсутствии автокорреляции отвергается Для проверки гипотезы о равенстве нулю группы переменных можно использовать Fстатистику, но только при нормальном распределении случайного члена. Применение же теста множителей Лагранжа не требует нормальности распределения. Методы устранения автокорреляции Воспользуемся авторегрессионным преобразованием. В линейной регрессионной модели либо в моделях, сводящихся к линейной, наиболее целесообразным и простым преобразованием является авторегрессионная схема первого порядка AR(1). Для простоты изложения AR(1) рассмотрим модель парной линейной регрессии. y 0 1 x (1) Тогда наблюдениям t и t 1 соответствуют уравнения: yt 0 1 xt t (2) yt 1 0 1 xt 1 t 1 (3) Пусть случайные отклонения подвержены воздействию авторегрессии первого порядка: t t 1 ut (4) где ut — случайные отклонения, удовлетворяющие всем условиям Гаусса-Марка, а коэффициент известен. Вычтем из (2) соотношение (3), умноженное на : Yt Yt 1 0 (1 ) 1 ( xt xt 1 ) ( t t 1 ) (5) Сделаем замену переменных, положив: y *t yt yt 1 x*t xt xt 1 *0 0 (1 ) . Получим Y *t *0 1 x*t ut В силу того что случайные отклонения u t удовлетворяют условиям Гаусса-Маркова оценки *0 и 1 будут обладать свойствами наилучших линейных несмещенных оценок и автокорреляции не будет * * Однако способ вычисления Yt и xt приводит к потере первого наблюдения Число степеней свободы уменьшится на единицу, что при больших выборках не так существенно, но при малых выборках может привести к потере эффективности. Эта проблема обычно преодолевается с помощью поправки Прайса—Винстена: (6) Отметим, что авторегрессионное преобразование может быть обобщено на произвольное число объясняющих переменных, т.е. использовано для уравнения множественной регрессии. Авторегрессионное преобразование первого порядка AR(1) может быть обобщено на преобразования более высоких порядков AR(2), AR(3) и т.д.: t t 1 2 t 2 ut и т.д. Однако на практике значение коэффициента обычно неизвестно и его необходимо оценивать. Существует целый ряд методов оценивания. Приведем наиболее употребляемые. 2. Метод Кохрана—Оркатта Это иттеративный процесс. Опишем его на примере парной регрессии : (1) y 0 1 x и авторегрессионной схемы первого порядка t t 1 ut . 1. Оценивается по МНК регрессия и для нее определяются оценки et отклонений t , t 1, n 2. Оценивается регрессионная зависимость t t 1 ut , и в качестве приближенного значения берется его МНК оценка ̂ . 3. На основе этой оценки строится уравнение: Y *t *0 1 x*t ut , (2), где y *t yt ˆ yt 1 x*t xt ˆ xt 1 *0 0 (1 ˆ ) . С помощью уравнения (2) оцениваются коэффициенты *0 и 1 (в этом случае значение ̂ известно). 4. Значения 0 и 1 подставляются в (7)и вновь вычисляются оценки et отклонений и процесс возвращается к этапу 2. Чередование этапов осуществляется до тех пор, пока не будет достигнута требуемая точность, т.е. пока разность между предыдущей и последующей оценками не станет меньше заданной точности. 3. Метод Хилдрета—Лу По данному методу регрессия оценивается для каждого возможного значения из отрезка [-1, 1] с любым шагом (например, 0,001; 0,01 и т.д.). Величина ̂ , дающая наименьшую стандартную ошибку регрессии, принимается в качестве оценки коэффициента . Значения *0 и 1 оцениваются из уравнения регрессии именно с данным значением ̂ . Этот итерационный метод широко используется в пакетах прикладных программ.