В. И. Бидерман

ЭЛЕМЕНТЫ

ТЕОРИИ

ВЕРОЯТНОСТЕЙ

Хабаровск 2017

МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РОССИЙСКОЙ ФЕДЕРАЦИИ

Федеральное государственное бюджетное образовательное учреждение

высшего образования

«Тихоокеанский государственный университет»

В. И. Бидерман

Элементы

теории вероятностей

Утверждено издательско-библиотечным советом университета

в качестве учебного пособия

Хабаровск

Издательство ТОГУ

2017

УДК 519.21(07)

ББК 22.171

Б 597

Р е ц е н з е н т ы:

Кафедра «Высшая математика» ДВГУПС (завкафедрой

д-р физ.-мат. наук, доц. П. В. Виноградова);

Е. А. Мясников, канд. физ.-мат. наук, доц. кафедры М и ММЭ ХГАУиП.

Н а у ч н ы й р е д а к т о р канд. физ.-мат. наук, доц. В. Я. Прудников

Бидерман, В. И.

Б597 Элементы теории вероятностей : учебное пособие / В. И. Бидерман;

[науч. ред. В. Я. Прудников]. − Хабаровск : Изд-во Тихоокеан. гос.

ун-та, 2017. − 232 с.

ISBN 978-5-7389-2152-0

Пособие соответствует федеральному государственному образовательному

стандарту в области математики для технических специальностей и технических и экономических направлений бакалавриата и предназначено для студентов университета дневной, заочной и дистанционной форм обучения.

Рассматриваются классические разделы теории вероятностей. Пособие содержит большое количество задач, иллюстрирующих изучаемые темы.

УДК 519.21(07)

ББК 22.171

c Бидерман В. И., 2017

ISBN 978-5-7389-2152-0

c Тихоокеанский государственный

университет, 2017

Оглавление

Предисловие . . . . . . . . . . . . . . . . . . .

1 Элементы комбинаторики

1.1 Операции над множествами . . . . . . . .

1.2 Правило суммы . . . . . . . . . . . . . . .

1.3 Правило произведения . . . . . . . . . . .

1.4 Понятие факториала . . . . . . . . . . . .

1.5 Перестановки . . . . . . . . . . . . . . . .

1.6 Размещения без повторения . . . . . . . .

1.7 Перестановки с повторениями двух типов

1.8 Сочетания без повторения . . . . . . . . .

1.9 Размещения с повторением . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2 Введение в теорию вероятностей

2.1 Понятие события. Классификация событий . .

2.2 Классическое определение вероятности . . . .

2.3 Статистистическое определение вероятности .

2.4 Геометрическое определение вероятности . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

.

.

.

.

.

.

.

.

.

5

5

8

9

11

12

12

13

14

15

.

.

.

.

18

18

20

26

28

3 Алгебра событий

3.1 Сложение вероятностей событий . . . . . . . . . . . . . . . .

3.2 Умножение вероятностей событий . . . . . . . . . . . . . . .

3.3 Примеры применения алгебры событий . . . . . . . . . . . .

3.3.1 Связь между вероятностями противоположных событий

3.3.2 Вероятность работы схем теории надёжности . . . . .

3.4 Формула полной вероятности . . . . . . . . . . . . . . . . . .

3.5 Формула Байеса . . . . . . . . . . . . . . . . . . . . . . . . .

34

34

37

41

41

44

46

50

4 Схема Бернулли

4.1 Формула Бернулли . . . . . . . . . . . . . . . . . . . . . .

4.2 Формула Пуассона . . . . . . . . . . . . . . . . . . . . . .

4.3 Локальная и интегральная теоремы Лапласа . . . . . . .

4.4 Вероятность отклонения относительной частоты события

от постоянной вероятности в независимых испытаниях .

4.5 Наивероятнейшее число наступлений события

в схеме независимых испытаний . . . . . . . . . . . . . .

. .

. .

. .

54

54

56

60

. .

65

. .

67

3

5 Дискретные случайные величины

5.1 Понятие случайной величины . . . . . . . . . . . . . . . . . .

5.2 Закон распределения дискретной случайной величины . . .

5.2.1 Определение закона распределения дискретной случайной величины . . . . . . . . . . . . . . . . . . . . .

5.2.2 Табличное задание закона распределения . . . . . . .

5.2.3 Графическое задание закона распределения . . . . . .

5.3 Функция распределения дискретной случайной величины

и её свойства . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.3.1 Определение функции распределения дискретной

случайной величины . . . . . . . . . . . . . . . . . . .

5.3.2 Свойства функции распределения . . . . . . . . . . .

5.4 Числовые характеристики дискретной случайной величины

5.4.1 Математическое ожидание распределения дискретной

случайной величины . . . . . . . . . . . . . . . . . . .

5.4.2 Вероятностный смысл математического ожидания . .

5.4.3 Понятие индикатора события . . . . . . . . . . . . . .

5.4.4 Свойства математического ожидания . . . . . . . . .

5.4.5 Мода дискретной случайной величины . . . . . . . . .

5.4.6 Дисперсия дискретной случайной величины . . . . . .

5.4.7 Свойства дисперсии . . . . . . . . . . . . . . . . . . .

5.4.8 Среднее квадратическое отклонение . . . . . . . . . .

5.5 Одинаково распределённые независимые случайные

величины . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.6 Примеры распределений дискретных случайных величин . .

5.6.1 Биномиальное распределение вероятностей . . . . . .

5.6.2 Распределение Пуассона . . . . . . . . . . . . . . . . .

6 Непрерывные случайные величины

6.1 Определение непрерывной случайной величины . . . . . . .

6.2 Плотность распределения вероятностей непрерывной

случайной величины и её свойства . . . . . . . . . . . . . . .

6.3 Числовые характеристики непрерывной случайной

величины . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.3.1 Математическое ожидание непрерывной случайной величины . . . . . . . . . . . . . . . . . . . . . . . . . .

6.3.2 Дисперсия непрерывной случайной величины . . . . .

6.4 Равномерное распределение . . . . . . . . . . . . . . . . . . .

6.4.1 Определение и график функции плотности

равномерного распределения . . . . . . . . . . . . . .

4

70

70

71

71

72

77

78

78

82

83

83

87

88

89

91

93

97

98

102

103

103

108

112

112

115

119

119

123

126

126

6.4.2

6.4.3

6.4.4

6.4.5

Интегральная функция равномерного распределения 126

Математическое ожидание равномерного распределения127

Дисперсия равномерного распределения . . . . . . . . 127

Среднее квадратическое отклонение равномерного распределения . . . . . . . . . . . . . . . . . . . . . . . . 128

6.5 Нормальное распределение . . . . . . . . . . . . . . . . . . . 130

6.5.1 Определение и график функции плотности

нормального распределения . . . . . . . . . . . . . . . 130

6.5.2 Нормированное нормальное распределение . . . . . . 133

6.5.3 Интегральная функция нормального распределения . 134

6.5.4 Математическое ожидание нормального распределения 137

6.5.5 Дисперсия нормального распределения . . . . . . . . 137

6.5.6 Среднее квадратическое отклонение нормального

распределения . . . . . . . . . . . . . . . . . . . . . . 138

6.5.7 Вероятность попадания нормально распределённой

случайной величины в заданный интервал . . . . . . 139

6.5.8 Вероятность отклонения нормально распределённой

случайной величины от её центра рассеивания . . . . 140

6.5.9 Правило трёх сигм . . . . . . . . . . . . . . . . . . . . 141

6.5.10 Примеры решения задач, связанных с нормальным

распределением . . . . . . . . . . . . . . . . . . . . . . 142

6.5.11 О роли нормального закона в теории вероятностей и

её приложениях . . . . . . . . . . . . . . . . . . . . . . 147

6.6 Показательное распределение . . . . . . . . . . . . . . . . . . 149

6.6.1 Определение и график функции плотности

показательного распределения . . . . . . . . . . . . . 149

6.6.2 Интегральная функция показательного распределения 149

6.6.3 Математическое ожидание показательного распределения . . . . . . . . . . . . . . . . . . . . . . . . . . . 151

6.6.4 Медиана показательного распределения . . . . . . . . 152

6.6.5 Дисперсия показательного распределения . . . . . . . 153

6.6.6 Среднее квадратическое отклонение показательного распределения . . . . . . . . . . . . . . . . . . . . . . . . 154

6.6.7 Вероятность попадания показательно распределённой

случайной величины в заданный интервал . . . . . . 154

6.6.8 Понятие о роли показательного распределения в теории надёжности . . . . . . . . . . . . . . . . . . . . . . 155

6.7 Понятие о моментах . . . . . . . . . . . . . . . . . . . . . . . 160

5

7 Закон больших чисел

7.1 Неравенство Маркова . . . . . . .

7.2 Неравенство Бьенеме − Чебышёва

7.3 Теорема Чебышёва . . . . . . . . .

7.4 Теорема Бернулли . . . . . . . . .

7.5 Сходимость по вероятности . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

170

170

172

175

179

181

8 Двумерные случайные величины

8.1 Понятие двумерной случайной величины . . . . . . . . . . .

8.2 Дискретные двумерные случайные величины . . . . . . . . .

8.2.1 Закон распределения дискретной двумерной случайной величины . . . . . . . . . . . . . . . . . . . . . . .

8.2.2 Функция распределения дискретной двумерной случайной величины . . . . . . . . . . . . . . . . . . . . .

8.3 Понятие независимости случайных величин . . . . . . . . . .

8.4 Условное распределение вероятностей . . . . . . . . . . . . .

8.5 Условное математическое ожидание . . . . . . . . . . . . . .

8.6 Функции, уравнения и линии регрессии . . . . . . . . . . . .

8.7 Общая характеристика зависимости случайных величин . .

8.8 Вывод уравнения линейной регрессии . . . . . . . . . . . . .

8.9 Свойства ковариации . . . . . . . . . . . . . . . . . . . . . .

8.10 Свойства коэффициента корреляции . . . . . . . . . . . . . .

8.11 Понятие корреляции случайных событий . . . . . . . . . . .

183

183

184

Заключение . . . . . . . . . . . . . . . . . . .

222

184

188

195

199

203

204

208

210

213

216

220

Библиографический список . . . . . . . . . . . . 223

Приложение 1 . . . . . . . . . . . . . . . . . . 225

Приложение 2 . . . . . . . . . . . . . . . . . . 226

Предметный указатель . . . . . . . . . . . . . 227

6

Предисловие

В условиях, когда при переходе на бакалавриат резко уменьшается количество аудиторных часов как лекционных, так и практических, а содержание курса математики при этом меняется незначительно, становится невозможным традиционное чтение лекций, при котором только при помощи

мела и тряпки или их современных заменителей: фломастера и губки −

можно довести до слушателя это самое содержание.

Если к исчезновению аудиторных часов ещё добавить проблемы школьной математики, выпавшие на долю практически каждого из решивших

стать бакалаврами или специалистами, то остаётся только надеяться, что

данное пособие в виде курса лекций совместно со временем, проведённым

студентом на лекциях и практических занятиях в учебных аудиториях,

поможет ему не только выполнить тот объём самостоятельной работы, который свалится на его голову, но и поможет ему найти дорогу от школьной

математики к математике высшей.

Настоящее пособие предназначено для студентов технических специальностей и технических, а также экономических направлений бакалавриата.

Пособие посвящено классическим темам теории вероятностей: алгебре

событий и случайным величинам. В качестве введения включены элементы комбинаторики, необходимой для изучения алгебры событий. Пособие

состоит из восьми глав, в которых рассматриваются вопросы теории и большое количество задач, иллюстрирующих эту теорию.

Причиной написания данного пособия, помимо вышеуказанных, является попытка за счёт использования логических конструкций и большего

внимания к деталям сделать решение задач теории вероятности доступным

не только студентам-отличникам, но и всем тем, кто в силу лаконичности

изложения не может разобраться в классической литературе по теории вероятностей.

При написании пособия автор пользовался классическими учебниками теории вероятностей и литературой по истории теории вероятностей.

Информацию об этих источниках можно найти как в библиографическом

списке, так и в сносках в конце страниц.

Как любое учебное пособие, это пособие имеет свои достоинства и свои

недостатки. Но автор надеется, что достоинства окажут большее влияние,

чем недостатки, и среди читателей найдутся те, для кого чтение предлагаемого пособия станет первым, но не последним шагом в мир теории вероятностей. И, в конечном итоге, они смогут читать классическую литературу по теории вероятностей, обратив своё внимание на библиографический

список литературы, который поможет им найти дорогу в этот мир.

7

Элементы комбинаторики

1

На зачёте по комбинаторике.

Сколькими способами могут зайти в аудиторию

пять студентов?

Ответ студента: Существует пять способов: через

дверь, окно, подкоп, люк в потолке и пролом стены.

Из математического фольклора1

Комбинаторикой называется раздел математики, изучающий соединения между элементами конечных множеств с количественной точки зрения.

Название комбинаторика происходит от латинского слова combina, что

в переводе на русский означает − сочетать, соединять.

В математику его ввёл В. Лейбниц2 , опубликовав в 1666 году «Рассуждения о комбинаторном искусстве».

Знание комбинаторики необходимо там, где приходится иметь дело с

конечными множествами. Так, в частности, в задачах теории вероятности

и математической статистики, которые в курсе математики являются следующим объектом изучения, предполагается умение решать задачи комбинаторики.

В дальнейшем нам понадобятся следующие

1.1

Операции над множествами

Определение 1.1. Объединением элементов двух множеств A и

B называется множество всех элементов этих множеств, каждый из

которых является элементом A или элементом B, или принадлежит и

тому, и другому множеству одновременно.

Обозначается объединение множеств следующим образом:

A ∪ B = {x : x ∈ A или x ∈ B или x ∈ A и B}.

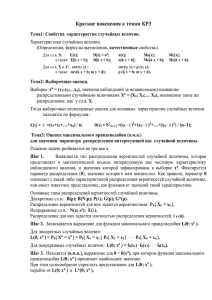

Если множество A является кругом, а множество B квадратом, то графически объединение множеств A ∪ B можно изобразить (рис. 1.1) так:

1

Правильный ответ можно найти на странице 12.

См. Гнеденко Б. В. Курс теории вероятностей. М. : Наука, 1988. С. 85.

Лейбниц Готфрид Вильгельм (нем. Gottfried Wilhelm von Leibniz, 1646 - 1716) − немецкий

философ, логик, математик, механик, физик, юрист, историк, дипломат, изобретатель и языковед.

Наряду с И. Ньютоном основоположник математического анализа. Создатель комбинаторики как

науки, заложил основы математической логики. (См. Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYRL\T2A\cyre\T2A\cyrishrt\T2A\cyrb\T2A\cyrn\T2A\cyri\

T2A\cyrc,_\T2A\CYRG\T2A\cyro\T2A\cyrt\T2A\cyrf\T2A\cyrr\T2A\cyri\T2A\cyrd_\T2A\CYRV\T2A\

cyri\T2A\cyrl\T2A\cyrsftsn\T2A\cyrg\T2A\cyre\T2A\cyrl\T2A\cyrsftsn\T2A\cyrm (дата обращения: 12.06.2016)).

2

8

A

A∪B

B

Рис. 1.1

Например, если множество A состоит из тех, кто знает английский язык,

а множество B − из тех, кто знает немецкий язык, то объединение A ∪ B

включает как тех, кто знает только английский или только немецкий, так

и тех, кто знает оба эти языка.

Определение 1.2. Объединение элементов множеств A и B, не имеющих общих элементов, называется суммой множеств и обозначается

A + B = {x : x ∈ A или x ∈ B}.

A

A+B

B

Рис. 1.2

На рис. 1.2 в виде круга A и квадрата B показано объединение множеств,

не имеющих общих элементов.

Так, если элементами множества A являются знающие только английский язык, а элементами множества B − знающие только немецкий, то

суммой множеств A + B является множество знающих только один иностранный язык.

Определение 1.3. Пересечением множеств элементов A и B называется множество всех общих элементов этих множеств.

A ∩ B = {x : x ∈ A и x ∈ B}.

Если множество A является кругом, а множество B − квадратом, то

пересечение этих множеств изображено на рис. 1.3 в виде незакрашенного

множества клеток внутри множества, окрашенного в серый цвет.

В приведённом примере со знанием языков пересечением множеств является множество людей, знающих одновременно английский и немецкий

языки.

9

A

A∩B

B

Рис. 1.3

Определение 1.4. Произведением множеств элементов A и B

называется множество всех пар элементов (a; b), в которых a ∈ A, b ∈

B, то есть

AB = {(a; b) : a ∈ A, b ∈ B}.

Если, например, элементами множества A являются знающие только

английский язык, а элементами множества B − знающие только немецкий, то можно образовать произведение множеств AB как множество пар,

в каждой из которых один знает только английский, а другой − только

немецкий.

Определение 1.5. Разностью множеств элементов A и B называется множество тех элементов множества A, которые не являются

элементами множества B, то есть

A \ B = {a : a ∈ A, a ∈

/ B}.

Пусть множество A (рис. 1.4) есть серый круг, а множество B − белый

квадрат, тогда разность множеств A \ B выглядит как три четверти серого

круга.

A

A\B

B

Рис. 1.4

В примере с языками разность множеств представляет множество знающих английский язык, но не знающих немецкий.

Предположим, что Ω − представляет универсальное множество всех

изучаемых элементов, а ∅ − пустое множество, то есть множество не

содержащее ни одного элемента. С помощью этих множеств можно дать

следующее

Определение 1.6. Дополнением множества A (до универсального

множества Ω) называется множество всех элементов универсального

10

множества, которые не принадлежат множеству A, то есть

Ā = {x : x ∈ Ω, x ∈

/ A}.

Например, в ситуации с языками Ā − множество людей, незнающих

английский, а B̄ − множество людей, незнающих немецкий.

Сформулируем несколько следствий из приведённых определений.

Следствие 1.1. A + B = (A ∪ B) \ (A ∩ B).

Следствие 1.2. A + Ā = Ω; A ∩ Ā = ∅.

Следствие 1.3. A \ B = A ∩ B̄.

Замечание 1.1. В дальнейшем нам понадобятся такие неопределяемые

понятия как опыт или эксперимент.

Под опытом или экспериментом будем понимать некоторую воспроизводимую совокупность физических условий, на фоне которых наступает изучаемое явление, фиксируется тот или иной результат.

Опыт или эксперимент представляют некоторое универсальное множество Ω, элементами которого являются исходы опыта ω (или исходы эксперимента ω). При этом исходы будут делиться на благоприятные исходы

и неблагоприятные исходы. Благоприятные исходы будут образовывать

изучаемые события, которые будут обозначаться прописными буквами латинского алфавита: A, B, C, . . . Таким образом, событие A можно определить как подмножество исходов ω некоторого опыта Ω, то есть

A = {ω} ⊆ Ω.

С помощью данных определений и следствий обратимся к изучению

комбинаторики, в основе которой лежат два правила − правило суммы и

правило произведения.

1.2

Правило суммы

Теорема 1.1. Правило суммы. Если элементы множества A можно

выбрать m способами, а элементы другого множества B можно выбрать n способами, то элементы множества «A или B», то есть суммы

множеств A + B, можно выбрать m + n способами.

Данное утверждение настолько очевидно, что не нуждается в доказательстве.

Задача 1.1. На столе лежат две коробки с карандашами. В первой

коробке лежат 5 карандашей, а во второй коробке − 4 карандаша. Сколько

существует способов взять один карандаш со стола?

Решение. Событие A − со стола взят один карандаш может произойти

с помощью одного из двух событий:

11

1) событие A1 − из первой коробки взят один карандаш;

2) событие A2 − из второй коробки взят один карандаш.

Так как невозможно взять один карандаш одновременно из двух коробок, то событие со стола взят один карандаш эквивалентно тому, что из

первой коробки взят один карандаш ИЛИ из второй коробки взят один

карандаш. Формально это можно записать так:

A = A1 + A2 .

Так как событие из первой коробки взят один карандаш можно выполнить n1 = 5 способами, а событие из второй коробки взят один карандаш

− n2 = 4 способами, то согласно правилу суммы 1.1 событие со стола взят

один карандаш можно выполнить

NA = n1 + n2

способами. Поэтому NA = 5 + 4 = 9.

Итак, один карандаш со стола можно взять 9 способами .

1.3

Правило произведения

Теорема 1.2. Правило произведения. Если элементы множества A

можно выбрать m способами и если после такого выбора элементы множества B можно выбрать n способами, то элементы произведения множеств AB можно выбрать m · n способами.

Д о к а з а т е л ь с т в о. Так как произведение множеств по

определению (1.4) есть множество пар, то для каждого первого элемента

пары, выбранного с помощью m способов, можно подобрать второй элемент

n способами, поэтому множество пар будет содержать m · n элементов.

Задача 1.2. На столе лежат две коробки с карандашами. В первой

коробке лежат 5 синих карандашей, а во второй коробке − 4 красных

карандаша. Сколько существует способов взять два разноцветных карандаша со стола?

Решение. Событие B − со стола взяты два разноцветных карандаша

может произойти с помощью одного из двух событий:

1) событие B1 − из первой коробки взят один синий карандаш;

2) событие B2 − из второй коробки взят один красный карандаш.

Событие со стола взяты два разноцветных карандаша эквивалентно тому, что из первой коробки взят один синий карандаш И из второй коробки

взят один красный карандаш. То есть, фактически образуется множество

пар (c; к). Формально это можно записать так:

B = B1 B2 .

12

Так как событие из первой коробки взят один синий карандаш можно

выполнить n1 = 5 способами, а событие из второй коробки взят один

красный карандаш − n2 = 4 способами, то согласно правилу произведения

1.2 событие со стола взяты два разноцветных карандаша можно выполнить

NB = n1 · n2

способами. Поэтому NB = 5 · 4 = 20. Таким образом,

два разноцветных карандаша со стола можно взять 20 способами .

Замечание 1.2. О знании языка при решении задач комбинаторики. Объединяя правила суммы и произведения, можно сформулировать

общее правило, опирающееся на конструкции языка, связанные с использованием союзов «и» и «или».

Если предложение о некотором событии можно переформулировать

с помощью союзов «и» и «или», связывающих соответствующие микрособытия, то общее число исходов изучаемого события равно линейной

комбинации числа исходов полученных микрособытий. При этом в составленной линейной комбинации числа исходов союзам «и» соответствует умножение, а союзам «или» − сложение.

Задача 1.3. В магазине лежат 5 книг автора A, 4 книги автора B и 3

книги автора C. Кроме этого, 6 сборников (BC) состоят из произведений

авторов B и C, и 4 сборника (AC) содержат произведения авторов A и

B. Сколько существует вариантов купить по одному произведению всех

трёх авторов?

Решение. Введём обозначения событий, связанных с условием задачи.

Событие D − купить по одному произведению всех трёх авторов;

Событие A − купить одно произведение автора A;

Событие B − купить одно произведение автора B;

Событие C − купить одно произведение автора C;

Событие AC − купить сборник AC;

Событие BC − купить сборник BC.

Рассмотрим подробное текстовое решение задачи:

Купить по одному произведению всех трёх авторов это эквивалентно тому, что: купить одно произведение автора A и купить одно произведение

автора B и купить одно произведение автора C или купить одно произведение автора A и купить сборник BC или купить одно произведение

автора B и купить сборник AC.

Перепишем это решение в символьном виде:

D=A и B и C или A и BC или B и AC.

13

Далее воспользуемся замечанием 1.2, сопоставив каждому событию число его исходов:

ND = nA · nB · nC + nA · nBC + nB · nAC .

Теперь остаётся подставить численные значения соответствующих исходов:

ND = 5 · 4 · 3 + 5 · 6 + 4 · 4 ⇒ ND = 106.

Выходит, что существует

106 вариантов купить по одному произведению всех трёх авторов .

В дальнейшем нам понадобится одно техническое понятие из мира вычислений целых неотрицательных чисел.

1.4

Понятие факториала

Определение 1.7. Факториалом1 натурального числа n называется произведение всех натуральных чисел от единицы до n включительно.

То есть,

n! = 1 · 2 · 3 · . . . (n − 1) · n.

(Читается: «эн факториал»). По определению полагают, что 0! = 1.

Так, например, 3! = 1 · 2 · 3, то есть 3! = 6, а 5! = 1 · 2 · 3 · 4 · 5 ⇒ 5! = 120.

Можно заметить, что, зная то, что 3! = 6, 5! можно вычислить проще:

5! = 3! · 4 · 5, что позволяет значительно уменьшить объём вычислений.

4!

Задача 1.4. Сократите дробь .

7!

4!

4!

1

Решение. Так как 7! = 4! · 5 · 6 · 7, то

=

=

.

7! 4! · 5 · 6 · 7 210

4!

1

Следовательно,

=

.

7! 210

Правила суммы и произведения являются общими правилами решения

задач комбинаторики. С их помощью можно решать самые различные задачи. Но существует целый ряд задач, которые встречаются настолько часто, что есть смысл свести их решение к формулам2 .

1

Факториал (от фр. factor − множитель, производного от лат. factor − производящий) Символ

факториала в 1808 году ввёл в математику К. Крамп (см. Глейзер Г. И. История математики в школе:

IX-X кл. Пособие для учителей М. : Просвещение, 1983. С. 214).

Крамп Кристиан (Кретьен) (фр. Christian Kramp, 1760-1826) − французский математик. Автор работ по теории чисел, геометрии, математической кристаллографии, алгебре и механике. (см. Википедия

[Электронный ресурс] : URL : https://ru.wikipedia.org/wiki/\T2A\CYRK\T2A\cyrr\T2A\cyra\T2A\

cyrm\T2A\cyrp,_\T2A\CYRK\T2A\cyrr\T2A\cyri\T2A\cyrs\T2A\cyrt\T2A\cyri\T2A\cyra\T2A\cyrn

(дата обращения: 12.06.2016)).

2

У формул, правда, тоже есть серьёзная проблема: их надо знать и помнить. Поэтому наряду с ними

там, где есть смысл, будет рассматриваться и второй вариант решения, опирающийся на замечание

1.2.

14

1.5

Перестановки

Определение 1.8. Перестановками1 во множестве из n элементов называются комбинации между всеми элементами множества,

отличающиеся друг от друга порядком входящих в них элементов.

Перестановки обозначаются символом Pn . Также обозначается и число

перестановок, для которого справедлива

Теорема 1.3. ∀ n Pn = n!

Д о к а з а т е л ь с т в о. Представим коробку, содержащую

n горизонтальных ячеек. Заполнив её разноцветными шариками, можно

получить пример перестановки во множестве из n разноцветных шариков.

Рассмотрим процесс построения перестановки (или заполнения коробки).

Заполнить коробку − это совершить такое событие A, которое состоит

из следующих событий:

A1 : положить в коробку первый шарик. Число способов nA1 = n; и

A2 : положить в коробку второй шарик. Число способов nA2 = n − 1; и

A3 : положить в коробку третий шарик. Число способов nA3 = n − 2; и

........................................................................и

An−1 : положить в коробку предпоследний шарик. Число способов nAn−1 = 2;

и

An : положить в коробку последний шарик. Число способов nAn = 1.

Таким образом, A = A1 и A2 и A3 и . . . An−1 и An .

Согласно принципу произведения 1.2

Pn = NA = n · (n − 1) · (n − 2) · . . . 2 · 1 ⇒ Pn = n!

Замечание 1.3. С помощью этой теоремы можно интерпретировать,

почему 0! = 1: Множество, состоящее из нулевого числа элементов, есть

пустое множество ∅. А оно является упорядоченным единственным образом.

Перестановки являются частным случаем следующего типа комбинаций.

1.6

Размещения без повторения

Определение 1.9. Размещениями без повторения2 называются

комбинации выбора k различных элементов во множестве из n элемен1

Перестановки (от лат. permutatio) ввёл в 1656 году в «Теории и практике арифметики»

(Arithmeticae theoria et praxis) А. Таке.

Таке Андре (Tacquet, Andrе, 1612-1660) − фламандский математик. 10 его произведений выдержали с 1654 по 2014 год 330 переизданий, его имя присвоено одному из лунных кратеров (см.

История математики с древнейших времен до начала XIX столетия : В 3 т. Т. 2 / Под ред. А.

П. Юшкевича. М. : Наука, 1970. С. 83, а также Википедия [Электронный ресурс] : URL : http:

//www.worldcat.org/identities/lccn-n86-864683/ (дата обращения: 12.06.2016)).

2

Размещения без повторения впервые рассмотрел в арифметике на иврите в 1321 году Леви бен

Гершом, а затем в 1705 году Яков Бернулли в его работе «Искусство предположений» (лат. Ars

15

тов, отличающиеся друг от друга по составу и порядку входящих в них

элементов. Размещения без повторения обозначаются символом Akn . Также

обозначается и их число, для которого справедлива

n!

Теорема 1.4. Akn =

(n − k)!

Д о к а з а т е л ь с т в о. Доказательство этой теоремы полностью

повторяет процесс доказательства теоремы 1.3, отличие состоит только в

том, что в коробочку надо положить не n шаров, а k шаров. Поэтому

Akn = NA = n · (n − 1) · (n − 2) · . . . (n − (k − 1)).

А так как

n! = n · (n − 1) · (n − 2) · . . . (n − k + 1)(n − k) · (n − k − 1) · . . . 2 · 1, то

n!

n!

. Поэтому Akn =

.

n · (n − 1) · (n − 2) · . . . (n − k + 1) =

(n − k)!

(n − k)!

n!

n!

Следствие 1.4. Pn = Ann =

=

= n!

(n − n)!

0!

В предыдущих случаях перестановки касались различных элементов.

Но так бывает не всегда.

1.7

Перестановки с повторениями двух типов

Теорема 1.5. Если во множестве из n элементов существуют две группы одинаковых элементов, содержащие соответственно n1 и n2 элементов, то число перестановок в этом множестве

P (n1 , n2 ) =

n!

n1 !n2 !

(n = n1 + n2 ).

Д о к а з а т е л ь с т в о. Число элементов в каждой перестановке

равно n = n1 + n2 . Если бы все элементы во множестве были бы различными, то число перестановок Pn = n! Но из-за того, что некоторые элементы

совпадают, получится меньшее число перестановок. Так, в первой из групп

существует n1 ! перестановок, но так как они все одинаковые, то они ничего

conjectandi), опубликованной после его смерти в 1713 году (см. Гнеденко Б.В. Курс теории... С. 85.).

Леви бен Гершом (лат. Gersonides, 1288-1344) − средневековый еврейский учёныйуниверсал: философ, математик, астроном. (см. Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYRL\T2A\cyre\T2A\cyrv\T2A\cyri_\T2A\cyrb\T2A\

cyre\T2A\cyrn_\T2A\CYRG\T2A\cyre\T2A\cyrr\T2A\cyrsh\T2A\cyro\T2A\cyrm

(дата

обращения:

12.06.2016)).

Бернулли Якоб (нем. Jakob Bernoulli, 1655-1705) − швейцарский математик. Один из основателей теории вероятностей, математического анализа и вариационного исчисления. Иностранный

член Парижской и Берлинской академий наук (см. Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYRI\T2A\cyrs\T2A\cyrt\T2A\cyro\T2A\cyrr\T2A\cyri\T2A\

cyrya_\T2A\cyrt\T2A\cyre\T2A\cyro\T2A\cyrr\T2A\cyri\T2A\cyri_\T2A\cyrv\T2A\cyre\T2A\cyrr\

T2A\cyro\T2A\cyrya\T2A\cyrt\T2A\cyrn\T2A\cyro\T2A\cyrs\T2A\cyrt\T2A\cyre\T2A\cyrishrt

(дата обращения: 12.06.2016)).

16

не меняют. Точно также ничего не меняют и n2 ! перестановок во второй

группе.

Так как перестановки в первой и второй группе не зависят друг от друга,

то по правилу произведения 1.2 элементы этих групп можно переставить

n1 !n2 ! способами, при этом перестановка останется неизменной. Следовательно, число различных перестановок с повторениями, которые можно

выполнить с элементами данного множества при условии, что n = n1 + n2 ,

n!

P (n1 , n2 ) =

n1 !n2 !

Помимо множеств, состоящих из различных элементов, интерес представляют и множества, состоящие из одинаковых элементов, в которых

порядок расположения элементов в комбинациях роли не играет.

1.8

Сочетания без повторения

Определение 1.10. Сочетаниями1 без повторения называются комбинации выбора k одинаковых элементов во множестве из n элементов,

отличающиеся друг от друга только по составу входящих в них элементов.

Сочетания без повторения обозначаются символом Cnk . Также обозначается и число сочетаний, для которого справедлива

n!

Теорема 1.6. Cnk =

n!(n − k)!

1

Впервые сочетания определил Тарталья. Масссовое применение сочетания получили после того

m

как

в1654 году Б. Паскаль, а затем в 1806 году Л. Эйлер ввели обозначения Cn (от фр. combinasion)

n

и

соответственно (см. Гнеденко Б. В. Курс теории... С. 83).

k

Тарталья Никколо Фонтана (итал. Tartaglia Niccolо Fontana , 1499-1557) − итальянский математик

(см. Википедия [Электронный ресурс] : URL : https://ru.wikipedia.org/wiki/\T2A\CYRT\T2A\cyra\

T2A\cyrr\T2A\cyrt\T2A\cyra\T2A\cyrl\T2A\cyrsftsn\T2A\cyrya,_\T2A\CYRN\T2A\cyri\T2A\cyrk\

T2A\cyrk\T2A\cyro\T2A\cyrl\T2A\cyro (дата обращения: 12.06.2016)).

Паскаль Блез (фр. Pascal Blaise, 1623-1662) − французский математик, механик, физик,

литератор и философ. Классик французской литературы, один из основателей математического анализа, теории вероятностей и проективной геометрии, создатель первых образцов счётной

техники, автор основного закона гидростатики. (см. Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYRP\T2A\cyra\T2A\cyrs\T2A\cyrk\T2A\cyra\T2A\cyrl\T2A\

cyrsftsn,_\T2A\CYRB\T2A\cyrl\T2A\cyre\T2A\cyrz (дата обращения: 12.06.2016)).

Эйлер Леонард (нем. Euler Leonhard, 1707-1783) − швейцарский, немецкий и российский математик и механик, внёсший фундаментальный вклад в развитие этих наук (а также физики, астрономии

и ряда прикладных наук). Автор более чем 850 работ по математическому анализу, дифференциальной геометрии, теории чисел, приближённым вычислениям, небесной механике, математической

физике, оптике, баллистике, кораблестроению, теории музыки и другим областям. Он глубоко изучал

медицину, химию, ботанику, воздухоплавание, теорию музыки, множество европейских и древних

языков. Академик Петербургской, Берлинской, Туринской, Лиссабонской и Базельской академий

наук, иностранный член Парижской академии наук (см. Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYREREV\T2A\cyrishrt\T2A\cyrl\T2A\cyre\T2A\cyrr,_\T2A\

CYRL\T2A\cyre\T2A\cyro\T2A\cyrn\T2A\cyra\T2A\cyrr\T2A\cyrd (дата обращения: 12.06.2016)).

17

Д о к а з а т е л ь с т в о. Выбирая k одинаковых элементов во

множестве из n элементов, можно заметить, что одновременно происходит

процесс «невыбора» других n − k элементов, которые также можно считать одинаковыми. Поэтому множество из n элементов разбивается на две

группы одинаковых элементов, состоящие из n1 = n и n2 = n−k элементов.

Следовательно, число сочетаний выбора k элементов из n без повторения совпадает с числом перестановок во множестве из двух типов элементов. А значит их число

n!

n!

=

Cnk = P (n1 , n2 ) =

n1 !n2 ! n!(n − k)!

Что и требовалось доказать.

Замечание 1.4. Заметим, что данную формулу можно доказать и

другим способом. Для этого выберем сначала все группы, содержащие k

элементов, не учитывая порядок входящих в них элементов. Таких групп

наберётся Cnk . Затем в каждой такой группе рассмотрим всевозможные перестановки. Общее число перестановок в каждой группе составляет Pk = k!

Тогда общее число комбинаций выбора и упорядочения равно произведению Cnk Pk . Которое по определению совпадает с числом размещения k элементов без повторения во множестве из n элементов. Поэтому Akn = Cnk Pk ,

Akn

n!

k

а значит Cn =

. То есть, Cnk =

.

Pk

n!(n − k)!

Приведём без доказательства некоторые свойства сочетаний.

Свойство 1.1. Cnk = Cnn−k .

Свойство 1.2. Cn0 = Cnn = 1.

Свойство 1.3. Cn1 = Cnn−1 .

В ряде задач важную роль играют

1.9

Размещения с повторением

Определение 1.11. Размещениями с повторением называются комбинации выбора k элементов во множестве элементов из n видов, отличающиеся друг от друга по составу и порядку входящих в них элементов.

Размещения с повторением обозначаются символом Ākn . Для них справедлива следующая теорема.

Теорема 1.7. Ākn = nk .

Д о к а з а т е л ь с т в о. Доказательство теоремы полностью повторяет доказательство теоремы 1.3 о перестановках. Отличие заключается

только в том, что каждый выбор совершается из n элементов множества,

18

поскольку допускает повторения. Поэтому выбирая первый элемент, И второй элемент, И третий элемент, И . . . , И k-й элемент, согласно принципу

произведения мы умножаем n

· · · · n}, что согласно известному из сред| · n{z

k

ней школы правилу сокращённого умножения приводит к возведению n в

степень с показателем k.

Задача 1.5. Номер телефона состоит из 11 цифр. Человек забыл три

последние цифры. Сколько неудачных попыток он может совершить, набирая нужный номер?

Решение. Каждая цифра номера определяет отдельный вид. Общее их

число n = 10. Длина комбинации, то есть нужного «слова» k = 3. Поэтому

Ā310 = 103 . То есть всего он может выполнить 1000 попыток. Но так как

одна удачная, то неудачных будет 999.

Возможен и второй вариант решения без формулы, но использующий

её доказательство и замечание 1.2.

Событие A : забыть последние три цифры. Это означает:

событие A1 : забыть первую цифру; И

событие A2 : забыть вторую цифру; И

событие A3 : забыть третью цифру.

Следовательно, A =A1 И A2 И A3 .

Так как каждая из трёх забытых позиций номера допускает 10 вариантов,

то используя замечание 1.2, сопоставим каждому событию число n = 10.

NA = 10 · 10 · 10 ⇒ NA = 103 ⇒ NA = 1000.

Далее следует учесть, что среди этих попыток есть одна удачная. При самом несчастливом варианте она будет последней. Поэтому

человек может совершить 999 неудачных попыток.

Замечание 1.5. В заключение темы следует заметить, что искусство

комбинаторики пригодилось не только в математике. С помощью математики оно сформировалось и нашло применение в музыкальной науке и

практике XVII-XVIII веков. Теоретические построения «Ars combinatoria»

поначалу были лишь опосредовано связаны с музыкальной практикой. Это

объяснялось не только общим характером музыкальной науки, которая была словесно-числовым осмыслением музыкального бытия, но и происхождением музыкального учения об «Ars combinatoria»: его логическая основа

была взята из математики. Две основные категории этого учения − пермутации и комбинации − также были введены в обиход математиками XVII

века, а словосочетание «Ars combinatoria» послужило в 1666 году заглавием диссертации Лейбница.

Как в математике, так и в музыкальной теории пермутация обозначала

19

перестановку элементов: abcd, abdc, adbc,... а комбинация − замену одних

элементов другими, аналогичными по функции: abcd, aPcd, aPcd.

Авторы трактатов рассматривали возможности пермутаций и комбинаций применительно к самому разному музыкальному материалу. В качестве переставляемых и взаимозаменяемых элементов комбинаторной конструкции мыслились: отдельные тоны в составе формул аккомпанемента;

сами эти формулы в их последовательности или же фигурации в составе

пассажей; мотивы в составе голосов контрапунктической ткани; отклонения в родственные тональности в пределах периода и многое другое1 .

1

Лебедева А. В. Ars combinatoria и музыкальная практика XVIII века : автореферат дис. ... кандидата искусствоведения/ Рос. акад. музыки им. Гнесиных. М., 2002. С. 4.

20

2

Введение в теорию вероятностей

Всегда имеется несколько способов

объяснения явлений, и из них мы

предпочтём наименее невероятное.

Бертран Рассел

2.1

Понятие события. Классификация событий

В предыдущей главе было определено понятие опыта (эксперимента) как

воспроизводимой совокупности физических условий, на фоне которых наступает некоторое изучаемое явление или фиксируется тот или иной результат.

Каждый опыт состоит из исходов опыта, на фоне которых происходит

изучаемое явление, которое в дальнейшем будет называться событие.

Событие, связанное с одним исходом, называется элементарным событием, а событие, связанное со множеством исходов, − составным

событием.

При этом все события можно разбить на три группы: достоверные,

невозможные и случайные.

Определение 2.1. Событие, которое при одних и тех же физических

условиях наступает всегда, называется достоверным событием.

Например, согласно календарю можно утверждать, что наступление после зимы весны является достоверным событием1 .

Определение 2.2. Событие, которое при одних и тех же физических

условиях не происходит никогда, называется невозможным событием.

Любой представитель общества защиты животных скажет, что событие

«на Северном полюсе гуляет верблюд» является невозможным событием.

Определение 2.3. Событие, которое при одних и тех же физических

условиях может произойти или не произойти, называется случайным

событием.

Так, например, при вашем участии в розыгрыше любой корректно устроенной лотереи кто-нибудь выигрывает. Но событие, при котором эту

лотерею выиграете вы, к сожалению для вас, является случайным событием.

В дальнейшем нас будут интересовать только случайные события, так

как теория вероятностей является разделом математики, который изу1

При этом, несмотря на то, что днём наступления весны является 1 марта, фактическое наступление

весны именно первого марта не является достоверным событием.

21

чает закономерности, возникающие при изучении массовых случайных

событий.

Как и в предыдущей главе, множество всех исходов опыта будем называть пространством элементарных исходов опыта Ω. Соответственно

исходы опыта ω являются его элементами: ω ∈ Ω. При этом исходы, составляющие изучаемое событие, являются его благоприятными исходами.

Если Ω состоит из конечного или сравнимого с натуральным рядом множества исходов, то оно называется дискретным пространством исходов опыта, иначе оно называется непрерывным пространством

исходов опыта.

Пространства исходов, связанные с подбрасыванием монеты или игральной кости, являются дискретными пространствами. А пространство множества осадков, выпадавших с первого по тридцать первое июля 1950 года,

является примером непрерывного пространства.

Заметим, что понятие Ω не является однозначным понятием. Так в случае подбрасывания монеты при исследовании выпадания чётного и нечётного числа очков возможны два определения:

Ω1 = {«1», «2», «3», «4», «5», «6»}

(2.1)

Ω2 = {«нечётное число очков», «чётное число очков»}.

(2.2)

и

Определение 2.4. Два события называются несовместными, если

их одновременное наступление является невозможным событием.

Так при подбрасывании монеты одновременное выпадение герба и решётки1 является невозможным событием2 .

Определение 2.5. Два события называются равновозможными,

если связанные с ними исходы являются симметричными относительно

их геометрических и физических свойств.

Например, выпадение «герба» и «решётки» при подбрасывании монеты

или одной из цифр при подбрасывании игральной кости являются событиями равновозможными, так как предполагается, что и монета и кость

сделаны из однородных материалов, имеют постоянную плотность этих материалов и являются геометрически правильными телами.

Определение 2.6. Несовместные и равновозможные события образу1

В XIV-XVI веках на одной из сторон монеты изображалась решётка, которая привела к современному жаргонному слову решка (см. Фëдорова T. JI., Щеглова О. А. Этимологический словарь русского

языка. М. : Ладком, 2012. С. 371).

2

Различают попарно несовместные или несовместные в совокупности события. Несовместные в

совокупности события одновременно являются и попарно несовместными. Обратное отношение может

не выполняться. Так попарная несовместность первого и третьего событий, а также первого и третьего

не влечёт за собой несовместность второго и третьего событий.

22

ют полную группу событий опыта, если в данном опыте невозможно

наступление другого события, отличного от данных.

При подбрасывании игральной кости события выпадения числа очков:

«1», «2», «3», «4», «5», «6» образуют полную группу исходов опыта, так как

эти события не только равновозможны и несовместны, но и невозможным

событием является наступление иного, кроме этих, события при подбрасывании кости.

Определение 2.7. Два события, образующие полную группу событий

опыта, называются противоположными событиями.

При подбрасывании одной монеты события: выпадение «герба» и выпадение «решётки» являются противоположными событиями.

Если обозначить через A некоторое событие, то событие, ему противоположное, обозначается через Ā. Сумма противоположных событий совпадает с Ω, а их пересечение пусто, то есть

A ∩ Ā = ∅.

A + Ā = Ω,

2.2

Классическое определение вероятности

Вопрос: Какова вероятность, выйдя из

дома, встретить слона?

Ответ: 0,5. Так как вы его встретите

или не встретите.

Из математического фольклора

При рассмотрении случайных событий возникает вопрос о степени возможности этих событий, а также о сравнении этих степеней возможности

для разных событий. Логично связать степень возможности с числом, которое становится больше, если увеличивается возможность наступления

события. Это число и называется вероятностью события1 .

Но чтобы что-то сравнивать, нужно найти единицу сравнения. Такой

единицей может быть вероятность достоверного события, которую можно

считать равной единице. Так как невозможное событие является противоположным достоверному, то его вероятность логично принять равной нулю.

Таким образом, диапазон распределения вероятностей случайных событий

совпадает с промежутком от нуля до единицы2 .

1

Не надо только путать это понятие вероятности события с бытовым понятием, очень часто используемым в повседневном общении и даже неоднократно воспетым: по теории вероятностей после

радостей − неприятности.

2

Первой книгой, в которой рассказывалось об этом была «Книга об азартных играх» (Liber de ludo

aleae), написанная в 1564 году Д. Кардано.

Кардано Джироламо (лат. Cardanus Hieronymus , итал. Cardano Girolamo, 1501-1576) − итальянский математик, инженер, философ, медик и астролог. В его честь названы открытые Сципионом

23

Для любого события A его вероятность P (A) удовлетворяет двойному

неравенству1

0 ≤ P (A) ≤ 1.

Предположим, что пространство некоторого опыта Ω состоит из n исходов, образующих его полную группу. И в этом опыте на фоне m исходов

наступает случайное событие A. Тогда имеет место следующее

Определение 2.8. Классическое определение вероятности2

Вероятностью события A называется отношение числа благоприятных данному событию m исходов опыта к числу n всех его исходов.

То есть,

m

P (A) =

.

n

Задача 2.1. Найдите вероятность выпадения нечётного числа очков

при одном подбрасывании игральной кости.

Решение

Вариант 1. Рассмотрим пространство исходов Ω1 (см. 2.1). Так как его

исходы несовместны и равновозможны, то они образуют полную группу из

n = 6 исходов. При этом интересующее нас событие A − «выпало нечётное

число очков» − может наступить три раза. То есть, благоприятное число

исходов m = 3. Поэтому, согласно классическому определению,

3

1

⇒ P (A) = или P (A) = 0, 5.

6

2

Вариант 2. Рассмотрим пространство исходов Ω2 (см. 8.5). В данном случае исходы опыта также несовместны и равновозможны. Поэтому они также образуют полную группу из n = 2 исходов. А интересующее нас событие

A − «выпало нечётное число очков» − может наступить один раз. А значит, благоприятное число исходов m = 1. Таким образом, из классического

определения следует, что

P (A) =

P (A) =

1

или P (A) = 0, 5.

2

При подбрасывании игральной кости один раз вероятность

выпадания нечётного числа очков равна 0,5.

дель Ферро формулы решения кубического уравнения (Кардано был их первым публикатором),

карданов подвес и карданный вал (см. [17, с. 40-41], а также Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYRK\T2A\cyra\T2A\cyrr\T2A\cyrd\T2A\cyra\T2A\cyrn\T2A\

cyro,_\T2A\CYRD\T2A\cyrzh\T2A\cyre\T2A\cyrr\T2A\cyro\T2A\cyrl\T2A\cyra\T2A\cyrm\T2A\cyro

(дата обращения: 12.06.2016)).

1

Из знания этого факта следует, что, имея право на любую ошибку в вычислениях, связанную как

с расчётами, так и с отсутствием знаний, никто не имеет право выдавать за вероятность события число,

не попавшее в данный промежуток. Так как в этом случае он признаётся в том, что ничего не знает

о теории вероятностей.

2

Это определение впервые было дано Я. Бернулли в четвёртой части его работы «Искусство предположений» (см. Бернулли Я. О законе больших чисел. М. : Наука, 1986. С. 24).

24

Задача 2.2. В коробке лежат 10 лампочек из них 3 бракованные.

Найдите вероятность выбрать случайным образом одну стандартную

лампочку.

Решение. Обозначим событие − выбрать одну стандартную лампочку

− через A. Далее определим число n всех исходов и число m благоприятных исходов.

Взять одну произвольную лампочку можно десятью способами1 , поэтому общее число исходов n = 10. Так как стандартных лампочек семь, то

выбрать из них одну можно семью способами. Следовательно, число благоприятных исходов m = 7.

7

Следовательно, согласно определению 2.8, P (A) = . То есть,

10

вероятность выбрать случайным образом одну

стандартную лампочку равна 0,7.

Задача 2.3. В коробке лежат 10 лампочек, из них 3 бракованные.

Найдите вероятность выбрать случайным образом две стандартные лампочки.

Решение. Обозначим событие − выбрать две стандартные лампочки

− через B. Далее определим число n всех исходов и число m благоприятных исходов.

Так как при выборе двух произвольных лампочек, порядок выбора не

играет роли, то при общем числе элементов n = 10 выбор k = 2 элементов

2

определяется числом сочетаний C10 . В силу того, что стандартных лампочек семь, а выбираются две из них также без учёта порядка, то число

2

благоприятных исходов m = C7 .

2

C7

Поэтому согласно определению 2.8 P (B) = 2 . Применяя формулу

C10

n!

, получим

сочетаний Cnk =

k!(n − k)!

2

C7

7! · 2! · 8!

6·7

7

7

=

=

⇒ P (B) = .

2 =

2! · 5! · 10! 9 · 10 15

15

C10

(Здесь 10! = 8! · 9 · 10; 7! = 5! · 6 · 7.)

Таким образом,

1

«Красиво» с помощью формулы это означает, что из 10 одинаковых элементов нужно выбрать

один, не обращая внимания на порядок (ведь при выборе одного элемента порядок устанавливается

единственным образом). Поэтому при общем числе элементов n = 10 выбор k = 1 элементов опреде1

ляется числом сочетаний C10

= 10.

25

вероятность выбрать случайным образом две

7

стандартные лампочки равна .

15

Задача 2.4. В коробке лежат 10 лампочек, из них 3 бракованные.

Найдите вероятность выбрать случайным образом четыре лампочки, из

которых три стандартные.

Решение. Обозначим событие − выбрать случайным образом четыре

лампочки, из которых три стандартные − через C. Далее определим

число N всех исходов выбора четырёх произвольных лампочек из десяти.

Так как лампочки при таком выборе не отличаются друг от друга, то

их выбор определяется с помощью сочетаний N = C104 .

Определим число M благоприятных исходов. Выбрать четыре лампочки, из которых три стандартные, это значит: выбрать три стандартные

лампочки из семи стандартных и выбрать одну нестандартную из трёх

нестандартных. Поэтому событие C является произведением событий C1

− выбрать три стандартные лампочки из семи стандартных и C2 −

выбрать одну нестандартную из трёх нестандартных: C = C1 и C2 .

Следовательно, согласно правилу произведения (см. 1.2) из комбинаторики,

M = MC1 · MC2 .

3

1

При этом MC1 = C7 , а MC2 = C3 .

Так как, согласно классическому определению вероятности, P (C) =

то

3

M

,

N

1

MC1 · MC2

C ·C

⇒ P (C) = 7 4 3 .

P (C) =

N

C10

Теперь остаётся только выполнить арифметические преобразования согласно 2.3:

3

1

C7 · C3

7! · 3! · 4! · 6!

2! · 3 · 4 · 5 · 6 1

=

=

=

C104

3! · 4! · 1! · 2! · 10!

2! · 8 · 9 · 10

2

(здесь использовано то, что: 6! = 2! · 3 · 4 · 5 · 6 и 10! = 7! · 8 · 9 · 10.)

1

Таким образом, P (C) = . А это означает, что

2

вероятность выбрать случайным образом четыре лампоч.

ки, из которых три стандартные, равна 0,5

Задачи 2.2−2.4 являются частными случаями общей задачи о выборе

Задача 2.5. В коробке лежат L элементов, из которых K «хорошие».

Какова вероятность вытащить l элементов, из которых k элементов

являются «хорошими»?

26

Решение. Общее число n вариантов выбора l произвольных элементов

из L определяется с помощью формулы сочетаний 2.3: n = CLl .

Событие D − вытащить l элементов, из которых k элементов являются «хорошими» означает: вытащить k «хороших» элементов из K

«хороших» и вытащить l − k «нехороших» элементов из L − K «нехороших» элементов. Поэтому событие C является произведением этих

событий, которые можно назвать событиями C1 и C2 сооответственно. А

общее число исходов D будет определяться с помощью правила произведения (см. 1.2):

l−k

mD = mD1 · mD2 ⇒ mD = CKk · CL−K

.

Если обозначить интересующее нас событие как E, то из классического

m

определения вероятности 2.8 следует, что его вероятность P (E) = C .

n

Следовательно,

l−k

CKk · CL−K

P (E) =

.

(2.3)

CLl

Замечание 2.1. Следует обратить внимание на то, что в формуле

(2.3) заложена возможность проверки правильности расчётов. Так и в числителе, и в знаменателе выбор происходит из одного числа элементов L,

которые в числителе образуют сумму K + (L − K) = L. Точно также, и

в числителе, и в знаменателе выбирается одно и тоже число элементов l,

которые в числителе образуют сумму k + (l − k) = l.

Чтобы эта проверка имела место и в задаче 2.3, нужно обратить внимание на то, что когда выбираются элементы только одного типа (а в задаче происходит выбор только стандартных лампочек), то автоматически

выбирается нуль элементов другого типа (то есть в данной задаче нестандартных лампочек).

Для этого формулу расчёта вероятности P (B) нужно переписать так:

2

2

0

C7

C7 · C3

.

2 =

C10

C102

Теперь и в числителе и знаменателе описаны одни и те же процессы:

7 + 3 = 10; 2 + 0 = 2.

Задача 2.6. Найдите ошибку, допущенную при «решении» следующей

задачи: Брошены две игральные кости. Найдите вероятность того, что

сумма выпавших очков равна 4.

«Решение». Пусть событие A − сумма выпавших очков равна 4. Пространство элементарных исходов Ω состоит из двух исходов (n = 2): «сумма

27

выпавших очков равна 4» и «сумма выпавших очков не равна 4». Число

1

благоприятных событию A исходов m = 1. Поэтому P (A) = .

2

В данном «решении» предполагается, что исходы опыта равновозможны

(иначе невозможно воспользоваться классическим определением). На самом деле исходы «сумма выпавших очков равна 4» и «сумма выпавших

очков не равна 4» не являются равновозможными.

Рассмотрим, как же решается эта задача. Пространство элементарных

исходов Ω содержит 36 равновозможных исходов, так как подбросить две

кости, это значит: «подбросить первую кость» и «подбросить вторую кость».

На каждой из костей шесть граней, поэтому возможно выпадение любого

из шести чисел. Следовательно можно составить 36 пар чисел, в которых

первым элементом является число выпавших очков на первой кости, а вторым − число очков, выпавших на второй кости. Таким образом, n = 36.

Существует только три исхода, благоприятных событию A: (1; 3), (3; 1),

(2; 2). (В каждой из пар сумма чисел равна 4). То есть, m = 3. Поэтому

3

P (A) = . В результате,

36

1

вероятность того, что сумма выпавших очков равна 4, равна

.

12

Замечание 2.2. Классическое определение вероятности предполагает

несколько ограничений, накладываемых на изучаемые события.

Во-первых, конечное число исходов опыта является очень сильным ограничением, не позволяя определить вероятности событий, связанных с

бесконечным числом исходов опыта.

Во-вторых, условие равновозможности исходов, связанное с симметрией

физических и геометрических условий опыта, оказывается трудновыполнимым при рассмотрении реальных объектов1 .

В-третьих, невозможно представить результаты опыта в виде совокупности элементарных исходов.

При практическом изучении случайных событий учёт этих ограничений

не позволяет решать все задачи, как это хотелось бы в идеале. Эти недостатки привели к появлению новых определений вероятности.

1

Однако польским математикам удалось «обмануть» нестандартность монет. Для этого они предложили в ситуации, в которой выпадает серия герб-решётка, запоминать герб, а в серии решётка-герб

запоминать решётка. В сериях герб-герб и решётка-решётка ничего не запоминать. При таком выборе при любом подбрасывании любых монет вы имеете дело с идеальной монетой (см. Штейнгауз Г.

Задачи и размышления. М. : Мир, 1974. С. 42).

28

2.3

Статистистическое определение вероятности

Допустим, что в некотором опыте, состоящем из n однотипных исходов,

изучается случайное событие A.

Определение 2.9. Отношение числа появлений m события A к общему числу исходов n называется относительной частотой события

A.

Если обозначить относительную частоту события A через Wn (A), то из

определения вытекает, что

Wn (A) =

m

n

.

(2.4)

Так как 0 ≤ m ≤ n, то 0 ≤ Wn (A) ≤ 1.

Из формулы (2.4) вытекает

Следствие 2.1. Число появлений события A равно его относительной

частоте, умноженной на число испытаний, то есть

m = Wn (A) · n.

(2.5)

Задача 2.7. По данным шведской статистики1 , относительная частота рождаемости с 1751 по 1760 год по годам характеризуется следующими числами

1751

1752

1753

1754

1755

1756

1757

1758

1759

1760

0,0384 0,0358 0,0359 0,037 0,0373 0,036 0,0326 0,0334 0,0335 0,0355

Определите коэффициент рождаемости в данном десятилетии.

Решение. Так как относительная частота равна сумме этих чисел, делённых на 10, то число Wn (A) = 0, 0355 можно принять за приблизительное значение коэффициента рождаемости.

В опыте с массовым числом исходов одного и того же типа при числе

исходов n → ∞ относительная частота события Wn (A) → p, где p − некоторое постоянное число. При этом чем больше n, тем меньше относительная

частота отклоняется от этого числа.

Определение 2.10. Статистическое определение вероятности

Почти достоверный предел p = lim Wn (A) называется статистиn→∞

ческой вероятностью2 события A.

1

(См. Википедия [Электронный ресурс] : URL : http://svspb.net/sverige/demografija-shvecii.

php (дата обращения: 12.06.2016)).

2

Определение статистической вероятности было дано Р. Мизесом в 1919 году (см. Хинчин А. Я.

Учение Мизеса о вероятностях и принципы физической статистики. // Успехи физических наук. −

1929. − Т. IX. Вып. 2 С. 143).

фон Мизес Рихард Эдлер (нем. Richard Edler von Mises, 1883-1953) − математик и механик; работы посвящены аэродинамике, прикладной механике, механике жидкостей, аэронавтике,

29

То есть при очень больших n относительная частота события A приближённо совпадает с его статистической вероятностью.

В силу этого совпадения имеет смысл следующее

Определение 2.11. Средним числом появления события A в n

испытаниях называется число

µ = np.

Замечание 2.3. Следует заметить, что при увеличении числа исходов

опыта n статистическая вероятность приближается к вероятности в смысле

классического определения не с полной достоверностью, а с большей вероятностью. И эта вероятность тем больше, чем большее число исходов опыта.

Подробнее об этом рассказывается далее, в последней главе.

Введя понятие статистической вероятности события, можно получить

возможность приписать определённые вероятности, заключённые между

нулём и единицей, не только событиям, для которых можно определить

классическую вероятность, но и тем событиям, для которых эти условия

не применимы. Достаточно, чтобы проводимый опыт обладал свойством

устойчивости относительных частот, то есть мог бы быть неограниченно

воспроизводимым в практически одинаковых физических условиях.

Задача 2.8. В результате работы отдела технического контроля

было обнаружено, что при изучении партии из 200 деталей 188 деталей оказались стандартными. Какова вероятность того, что взятая деталь оказывается стандартной? Какое число деталей может оказаться

стандартным, если исследовать партию из 600 деталей?

Решение. Согласно статистическому определению вероятности

p=

188

⇒ p = 0, 94.

200

На практике, при определении статистической вероятности, часто используют процентное соотношение и говорят, что вероятность равна 94%.

Отсюда следует, что среднее число стандартных деталей в партии из 600

деталей примерно равно

µ = 600 · 0, 94 ⇒ µ = 564.

p = 94%; µ = 564 .

статистике и теории вероятностей. Ввёл в общее употребление интегралы Стилтьеса и первым

разъяснил роль теории марковских цепей в физике (см. Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYRM\T2A\cyri\T2A\cyrz\T2A\cyre\T2A\cyrs,_\T2A\CYRR\

T2A\cyri\T2A\cyrh\T2A\cyra\T2A\cyrr\T2A\cyrd_\T2A\CYREREV\T2A\cyrd\T2A\cyrl\T2A\cyre\T2A\

cyrr_\T2A\cyrf\T2A\cyro\T2A\cyrn(дата обращения: 12.06.2016)).

30

Замечание 2.4. Принципиальным отличием классического и статистического определения вероятности является тот факт, что классическая

вероятность является теоретической вероятностью, определяя вероятность события ещё до того, как это событие произошло.

Статистическая вероятность является практической (эмпирической)

вероятностью, так как определяется уже после опыта, в котором произошло изучаемое событие, исходя из накопленного известного статистического материала.

Замечание 2.5. Для определения статистической вероятности события

A требуется:

во-первых, возможность, хотя бы принципиально, производить неограниченное число испытаний, в каждом из которых событие A наступает или

не наступает;

во-вторых, устойчивость относительных частот появления A в различных сериях достаточно большого числа испытаний.

Недостатком статистического определения является неоднозначность статистической вероятности. Так, например, в задаче 2.7 в качестве вероятности события можно принять не только 0, 481, но и 0,49; 0,48 и так далее.

2.4

Геометрическое определение вероятности

Так как классическое определение вероятности невозможно применить

к опыту с бесконечным числом исходов, то в этом случае используют следующий подход к изучаемому событию.

Предположим, что пространство элементарных исходов опыта Ω является множеством точек, которое можно изобразить в виде ограниченного

множества точек D, расположенного на прямой, на плоскости или в пространстве. Так как изучаемое событие A как множество благоприятных

ему исходов опыта является подмножеством Ω, то его можно изобразить в

виде множества G, являющегося подмножеством множества D.

Если определить меру S соответствующего ограниченного множества

точек прямой, плоскости, пространства как его длину, площадь, объём, то

имеет место

Определение 2.12. Геометрическое определение вероятности

Геометрической вероятностью1 события A называется отноше1

Определение геометрической вероятности в 1740 году ввёл Т. Симпсон в своей работе «Природа и законы случая» (A treatise on the nature and laws of change) (см. Википедия [Электронный ресурс] : URL : https://ru.wikipedia.org/wiki/\T2A\CYRS\T2A\cyri\T2A\cyrm\T2A\cyrp\

T2A\cyrs\T2A\cyro\T2A\cyrn,_\T2A\CYRT\T2A\cyro\T2A\cyrm\T2A\cyra\T2A\cyrs (дата обращения:

12.06.2016)).

Симпсон Томас (англ. Simpson Thomas, 1710-1761) − английский математик. Автор формулы Симп-

31

ние меры множества G к мере множества D, то есть

P (A) =

SG

SD

.

(2.6)

Замечание 2.6. Следует заметить, что данное определение предполагает следующие ограничения для любой точки, принадлежащей множеству

D:

во-первых, каждая точка множества G может быть расположенной

в любой точке множества D;

во-вторых, вероятность принадлежности точки множеству G пропорциональна мере SG и не зависит от расположения множества G во множестве

D.

Задача 2.9. Расстояние от пункта А до В автобус проходит за

2 минуты, а пешеход − за 15 минут. Интервал движения автобусов

25 минут. Вы подходите в случайный момент времени к пункту A и

отправляетесь в B пешком. Найдите вероятность того, что в пути

вас догонит очередной автобус.

Решение. Допустим, что чёрный прямоугольник изображает множество D длина которого SD = 25 единиц (рис. 2.1).

D

G

Рис. 2.1

А серый прямоугольник изображает множество G, длина которого определяется тем, что пешеход может сесть в автобус. Поэтому его длина есть

длина отрезка времени не большего, чем SG = 15 − 2 = 13 единиц (этот

отрезок находится на промежутке времени (10; 23)).

Если событие A − «в пути вас догонит очередной автобус», то согласно геометрическому определению вероятности вероятность этого события

можно вычислить как отношение длин серого и чёрного прямоугольников

13

P (A) = .

25

Следовательно,

вероятность того, что в пути вас догонит очередной автобус, равна 0, 52 .

сона для приближённого вычисления интегралов (см. там же).

32

Задача 2.10. Задача о встрече1 . Два человека условились встретиться в определенном месте между 12 и 13 часами дня. Пришедший

первым ожидает второго в течение четверти часа, после чего уходит.

Найдите вероятность того, что встреча состоится, если каждый человек выбирает момент своего прихода (в промежутке от 12 до 13 часов)

случайным образом.

Решение. Допустим, что множество D есть серый квадрат со стороной

единица (рис. 2.2).

Каждая точка квадрата с координатами (x; y) (0 ≤ x ≤ 1; 0 ≤ y ≤ 1)

определяет время прихода каждого из пришедших в пределах этого часа в

часах.

Они встретятся, если для времени встречи будет выполняться одно из

двух неравенств:

1

1

x−y ≤ ; y−x≤ ,

4

4

что эквивалентно неравенству

1

|x − y| ≤ .

4

y

1

3

4

1

4

0

1

4

3

4

1

x Рис. 2.2

Следовательно, множество встречи G определяется чёрным шестиугольником, ограниченным прямыми

y = 0; y = x − 0, 25; x = 1; y = 1; y = x + 0, 25; x = 0.

Площадь G удобнее вычислить как разность площади квадрата и двух

серых треугольников, вырезанных из квадрата шестиугольником:

SG = 1 − 2 ·

1

7

· (1 − 0, 25)2 . ⇒ SG = .

2

16

1

Задача впервые была опубликована в 1886 году в книге «Выбор и шанс» (Choice and chance)

В. Витворта и после этого включалась в большинство учебников по теории вероятности.

Витворт В. А. (Whitworth William Allen, 1840-1905) − английский математик и священник англиканской церкви (см. [13, c. 408], а также Википедия [Электронный ресурс] : URL : https://en.

wikipedia.org/wiki/William_Allen_Whitworth (дата обращения: 12.06.2016)).

33

Если определить эту случайную встречу как событие B, то согласно геометрическому определению вероятности вероятность этого события можно

вычислить как отношение площадей длин чёрного многоугольника и серо7

го квадрата P (B) =

: 1. В итоге имеем, что

16

вероятность того, что встреча произойдёт, равна 0, 4375 .

Cледующая задача на эту тему является одной из первых в истории

теории вероятностей.

Задача 2.11. Игла Бюффона1 . На плоскости заданы параллельные

прямые, находящиеся друг от друга на расстоянии 2a. Случайным образом на плоскость бросается игла, длина которой 2l, при этом l < a.

Найдите вероятность того, что игла пересечёт одну из прямых.

Решение. Для того чтобы определить, пересекает игла одну из прямых

или нет, нужно определить те параметры иглы, которые отвечают за её

местоположение на плоскости. Этими параметрами могут быть «расстояние от центра иглы до ближайшей прямой» и «угол поворота относительно

ближайшей прямой2 ».

Свяжем с этими прямыми систему координат, привязав к нижней прямой горизонтальную ось, направление на которой будет связано с углом

поворота иглы, который обозначим через α. Вертикальную ось, на которой

определяется расстояние до нижней прямой, обозначим через y. Расстояние от центра иглы до ближайшей прямой также обозначим y (рис. 2.3).

y

2a

l

y

l

α

α Рис. 2.3

Очевидно, что положение центра иглы y меняется от 0 до a, а угол поворота иглы меняется3 от 0 до π.

1

В поисках значения числа π Бюффон рассмотрел данную задачу. Его решение было приведено

в эссе «Опыт нравственной арифметики » (Essai d0 arithmetique morale), в его «Всеобщей и частной

истории» (Histoire naturelle, generale er particuliere) в 1777 году.

Граф де Бюффон Жорж-Луи Леклерк (фр. Georges-Louis Leclerc, Comte de Buffon, 17071788) − французский натуралист, биолог, математик, естествоиспытатель и писатель XVIII века

(см. Гнеденко Б.В. Курс теории... С. 406, а также Википедия [Электронный ресурс] : URL :

https://ru.wikipedia.org/wiki/\T2A\CYRB\T2A\cyryu\T2A\cyrf\T2A\cyrf\T2A\cyro\T2A\cyrn,_\

T2A\CYRZH\T2A\cyro\T2A\cyrr\T2A\cyrzh-\T2A\CYRL\T2A\cyru\T2A\cyri_\T2A\CYRL\T2A\cyre\T2A\

cyrk\T2A\cyrl\T2A\cyre\T2A\cyrr\T2A\cyrk_\T2A\cyrd\T2A\cyre(дата обращения: 12.06.2016)).

2

Поскольку игла образует с прямой острый и тупой углы, то на прямой нужно выбрать направление,

а далее под углом подразумевать «угол между прямой и направлением».

3

При этом местоположение центра иглы не зависит от угла её поворота относительно ближайшей

прямой.

34

Множество всевозможных положений иглы можно описать с помощью

прямоугольника

П = {(α, y) : 0 ≤ α ≤ π, 0 ≤ y ≤ a}.

Игла будет пересекать ближайшую прямую, если расстояние от её центра до ближайшей прямой1 y ≤ l sin α.

На рис. 2.4 площадь, ограниченная кривой y = l sin α, окрашена в серый

цвет.

y

a

π

0

Величина этой площади

Zπ

S=

2

αРис. 2.4

l sin αdα.

0

Вычислим этот интеграл

Zπ

π

l sin αdα = −l cos α

= −l(cos π − cos 0) = 2l.

0

0

Следовательно, S = 2l.

Если вероятность того, что игла пересечёт одну из прямых, определить

как событие C, то согласно геометрическому определению вероятности вероятность этого события можно вычислить как отношение вычисленной

площади S к площади чёрного прямоугольника

2l

.

P (C) =

aπ

Таким образом получаем, что

вероятность того, что игла пересечёт

2l

одну из прямых, равна

.

aπ

Замечание 2.7. Геометрическое определение вероятности также имеет

свои недостатки, одним из которых является следующий:

Известно, что в случае классического определения вероятность достоверного или невозможного событий равна единице, соответственно нулю.

При этом справедливы обратные утверждения: если вероятность события равна единице, то событие достоверно и если вероятность события

равна нулю, то событие невозможно.

1

Если на рис. 2.3 мысленно опустить перпендикуляр на пунктир, то получится прямоугольный

треугольник, в котором вертикальный катет будет равен y = l sin α.

2

cos π = −1, cos 0 = 1.

35

А в случае геометрического определения вероятности обратные утверждения не имеют места. Так, например, вероятность попадания брошенной

точки в одну определенную точку области G равна нулю, однако это событие может произойти, и, следовательно, не является невозможным.

В 1933 году А. Н. Колмогоров1 дал аксиоматическое определение вероятности, для которого все рассмотренные выше определения являются частными случаями. Но рассмотрение этого вопроса выходит за рамки программы данного курса.

1

Колмогоров Андрей Николаевич (1903-1987) − советский математик, один из крупнейших

математиков ХХ века. Один из основоположников современной теории вероятностей, Автор основополагающих результатов в топологии, геометрии, математической логике, классической механике,

теории турбулентности, теории сложности алгоритмов, теории информации, теории функций, теории

тригонометрических рядов, теории меры, теории приближения функций, теории множеств, теории

дифференциальных уравнений, теории динамических систем, функциональном анализе и в ряде

других областей математики и её приложений, а также новаторских работ по философии, истории,

методологии науки и преподаванию математики, статистической физике. Иностранный член 14

Академий и математических обществ (см. Википедия [Электронный ресурс] : URL : https://ru.

wikipedia.org/wiki/\T2A\CYRK\T2A\cyro\T2A\cyrl\T2A\cyrm\T2A\cyro\T2A\cyrg\T2A\cyro\T2A\

cyrr\T2A\cyro\T2A\cyrv,_\T2A\CYRA\T2A\cyrn\T2A\cyrd\T2A\cyrr\T2A\cyre\T2A\cyrishrt_\T2A\

CYRN\T2A\cyri\T2A\cyrk\T2A\cyro\T2A\cyrl\T2A\cyra\T2A\cyre\T2A\cyrv\T2A\cyri\T2A\cyrch

(дата обращения: 12.06.2016)).

36

3

Алгебра событий

Играя против начинающего шахматиста

и против чемпиона, выиграть две партии

подряд вероятнее по схеме «чемпион − новичок − чемпион» или по схеме «новичок

− чемпион − новичок»?

Ф. Мостеллер

3.1

Сложение вероятностей событий

Теорема 3.1. Вероятность суммы двух несовместных событий равна

сумме их вероятностей.

То есть,

P (A + B) = P (A) + P (B), если AB = ∅.

Д о к а з а т е л ь с т в о. Допустим, что n есть число всевозможных

исходов опыта, в котором m1 раз наступает событие A и m2 раз наступает

событие B. Так как события A и B несовместны, то наступление одного из

них исключает наступление другого (см. определение 2.4). Поэтому число