интеллектуальная система распределенного поиска в интернет

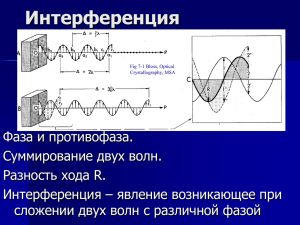

реклама

ИНТЕЛЛЕКТУАЛЬНАЯ СИСТЕМА РАСПРЕДЕЛЕННОГО ПОИСКА В ИНТЕРНЕТ Р.А.Амамра Санкт-Петербургский государственный технический университет, Санкт-Петербург E-mail: [email protected] В настоящее время вопросы создания и применения агентов привлекают все большее внимание. Напомним, что агентом называется программа, которая рекурсивно обходит ресурсы Интернет, извлекая ссылки на новые адреса сайтов из полученных документов. Традиционной областью применения агентов является построение индексов Интернет-ресурсов для поисковых систем. Решение такой задачи требует значительных сетевых и аппаратных ресурсов. Природа Интернет очень динамична: документы постоянно создаются, удаляются, модифицируются как по содержанию, так и расположению. Коллекция должна соответствовать фактическому состоянию Интернет, чтобы обеспечить высокое качество обслуживания пользователей системы /1,2/. Основными составляющими агента являются системы сбора, анализа и оценки релевантности документов, а также база данных. Система сбора документов (Harvester) отвечает за эффективное скачивание документов с НТТР или FTP. Подсистема анализа документов (Document Analyzer) ответственна за разбор HTML-документов. Из входящих документов удаляются все HTML и стандартные стопслова, а затем выполняется отбрасывание окончаний в остальных словах. В результате создается профайл документа, представляющий из себя вектор из пар: терм, т.е. основа слова, и частота использования этого терма в данном документе. Этот профайл используется в дальнейшем для предварительной ("грубой") оценки релевантности рассматриваемого документа. У системы оценки релевантности документов две основные задачи: – отфильтровывание "мусора" (исключение неинформативной составляющей), т.е. уменьшение количества нерелевантных документов, рекомендуемых коллекцией; – "грубое" вычисление оценок релевантности документов для последующего использования при выборе способа обхода известных Интернет-страниц. Известно два вида архитектуры агента, которые условно могут делиться на простую архитектуру (ее пример и приведен выше), которая состоит из системы сбора, анализа и оценки релевантности документов, а также базы данных и архитектуру мультиагента. В последнем случае система включает в себя N агентов, каждый из которых связан с коллекцией. Данная архитектура, очевидно, имеет ряд достоинств, среди которых можно выделить в первую очередь тот факт, что поиск информации в документах может осуществляться более эффективно за счет распределения по агентам документов с определенными темами. В этом случае поиск информации может быть значительно ускорен (тематические коллекции). Обычно поиск информации в документах происходит путем сравнения терминов этих документов с терминами из запроса пользователя. В этих методах есть два существенных недостатка. Во-первых, обычно имеется много способов выражения данного понятия (с помощью синонимов), поэтому относящиеся к делу документы могут быть отвергнуты. Во-вторых, многие слова имеют множественное значение (полисемия), поэтому в результате работы программы могут быть получены ненужные документы. Эти два недостатка приводят к тому, что методы, основанные на сравнении терминов, оказываются неприемлемыми для поиска ответа на запрос пользователя. Более эффективный подход должен позволять пользователю получать информацию, учитывая смысл конкретного документа /3/. Использование моделей семантического анализа (MSA) является попыткой преодоления проблемы сравнения терминов с использованием статистически полученных смысловых параметров вместо отдельных слов. В методе MSA предполагается, что в каждом образце текста имеется некоторая внутренняя скрытая структура, которая не совсем ясна ввиду возможного использования синонимов. Эта структура фиксируется матрицей терминов и документов, которая представляет собой разреженную (т.е. имеется сравнительно немного ненулевых элементов) матрицу строения mxn, получаемую грамматическим анализом текста. Для анализа структуры использования слов в документах используется сингулярное разложение (SVD). Поиск документов может быть осуществлен путем использования k наибольших сингулярных значений и соответствующих сингулярных векторов, где k<<min(m, n). Проведенный анализ показывает, что сингулярные векторы в действительности являются более надежными показателями смысла, чем отдельные слова. SVD является наиболее распространенным примером двустороннего (или полного) ортогонального разложения, в котором матрица представляется в виде произведения трех других матриц: ортогональной, средней и еще одной ортогональной. Средняя матрица – это нижне- (верхне-) трапециевидная или диагональная. Однако среди двусторонних ортогональных разложений, которые могут быть использованы для поиска информации, более эффективным является применение метода MSA. К важному преимуществу данного метода относится тот факт, что количество вычислений по сравнению с SVD уменьшается. Основные вычислительные преимущества MSA над другими методами заключаются в другом подходе к добавлению информации в базу данных. Основная идея в MSA заключается в том, чтобы явно смоделировать взаимосвязи между терминами (через двустороннее ортогональное разложение) и использовать его, чтобы улучшить возможности поисковой системы /4/. В настоящее время все большее значение приобретает теория нейронных сетей, которая находит применение во многих прикладных областях. Система нейронных сетей (Neural Network System) используется при поиске документов по запросам пользователей в коллекциях и при объединении результатов поиска серверами запросов. При кластеризации локальной коллекции в фоновом режиме профайлы, представляющие локальную коллекцию, становятся входными данными для нейронной сети. Нейронная сеть затем строит кластерное дерево: несколько кластеров верхнего уровня, группу субкластеров для каждого из кластеров верхнего уровня и так далее до отдельных документов. Для осуществления поиска в коллекции посредством запросов каждый кластер представлен документом, наиболее близко находящимся к центроиду кластера (cluster centroid) в векторном пространстве профайлов. Таким образом, профайл заданного запроса необходимо сравнить только с профайлами кластерного центроида. Это в значительной степени увеличивает скорость обработки запросов. Кроме этого нейронные сети могут использоваться для кластеризации результатов поиска, поступивших в ответ на запрос от нескольких серверов. Главная задача кластеризации – выдать пользователю репрезентативный набор результатов, если общее результирующее число документов превышает "порог", заданный пользователем. Известно два типа архитектуры нейронных сетей: RCL (Radius-based Competitive Learning – основанную на радиусе, обучающуюся, соревновательного типа), и ее иерархическое расширение, называемое HRCL (Hierarchical Radius-based Competitive Learning, иерархическая, основанная на радиусе, обучающуюся, соревновательного типа). В их основе лежит идея о том, что после каждого введения в систему входного вектора все нейроны упорядочиваются по их расстоянию к точке текущего ввода. Самый близкий к текущему вводу RCL нейрон становится победителем, кроме этого RCL адаптирует все остальные нейроны из нейронного набора. Высокая производительность и универсальность подсистемы нейронных сетей дает все основания для предположения о том, что она будет играть значительно большую роль в различных системах /5/. Литература 1. F. Cheong. Internet Agents: Spriders, Wanders, and Brokers., Indianapolis, 1996. 2. S.Haverkamp. Intelligent information Agents. JASIS,V49,N4,1998. 3. C. Lee Giles. Searching the Word Wide Web. Science, 280(5360): 98-100, 1998. 4. P.Hansen. Low-rank revaling two-sided orthogonal decomposion. TR,CA,octuber 1994. 5. P.Hingston. Neural Network for Document Retrieval ACM/SEGIR.june 1991.