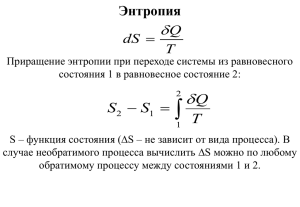

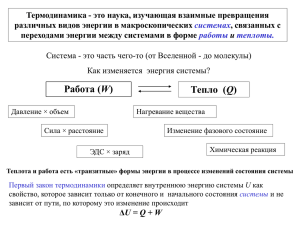

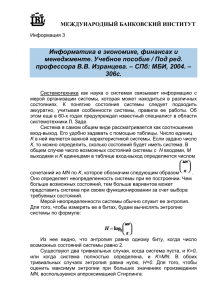

Понятие энтропии. Виды энтропии Клоду Шеннону удалось придумать удивительно простую и глубокую модель передачи информации, без которой теперь не обходится ни один учебник. Он ввел понятия: источник сообщения, передатчик, канал связи, приемник, получатель сообщения и источник шума, который может исказить сигнал. Практически любой, даже очень сложный, обмен сообщениями можно успешно описать в этих терминах. Дискретное сообщение — это любой набор символов, который формируется Источником (им может быть, например, человек). От Источника сообщение переходит к Передатчику, который преобразует его к виду, который уже можно передавать по Каналу связи. Например, Передатчик может кодировать сообщение. Преобразованное сообщение называется Сигналом. Канал связи — это технический комплекс аппаратуры, который позволяет передать Сигнал. В общем случае в процессе передачи сигнал в канале искажается шумом, который исходит от Источника шума. Приемник обычно выполняет операцию, обратную по отношению к той, что производится передатчиком, — т. е. восстанавливает сообщение по сигналам. Процесс преобразования сигнала в сообщения, осуществляемый в Приемнике, называют декодированием. Получатель — это человек или аппарат, для которого предназначено сообщение. Энтропия В 1946 г. американский ученый-статистик Джон Тьюки предложил название БИТ (BIT — аббревиатура от BInary digiT), одно из главных понятий XX века. Тьюки избрал бит для обозначения одного двоичного разряда, способного принимать значение 0 или 1. Шеннон использовал бит как единицу измерения информации. Мерой количества информации Шеннон предложил считать функцию, названную им энтропией. Пусть сообщение — осмысленное предложение на русском языке. Шеннон заметил, что при передаче различных букв мы передаем разное количество информации. Если мы передаем часто встречающиеся буквы, то информация меньше; при передаче редких букв — больше. Это видно при кодировании букв алфавита азбукой Морзе. Наиболее частые буквы передаются коротко, а для редких используют более длинные цепочки. Так, буква «Е» кодируется одной точкой «.», а редкая «Ш» — четырьмя тире «––––» (это самая длинная последовательность на букву в азбуке Морзе). Количество информации на букву связано с частотой употреблений этой буквы во всех сообщениях, формируемых на языке. Чем более редкую букву мы передаем, тем больше в ней информации. Энтропия — мера непредсказуемости. Это понятие Шеннон взял из статистической термодинамики. Пусть вероятность i-того символа алфавита, состоящего из n символов (мера частоты, с которой встречается символ во всех сообщениях языка), равна pi. Тогда информация одного символа: (здесь log — логарифм по основанию 2). Шеннон пишет: «Величина H играет центральную роль в теории информации в качестве меры количества информации, возможности выбора и неопределенности». Количество информации, передаваемое в сообщении, тесно связано с мерой неопределенности, или непредсказуемости передаваемых символов. Понятие информационной энтропии определено Шенноном для случая дискретных данных, и похоже на понятие термодинамической энтропии. Это - величина, обозначающая количество информации, содержащееся в данном сообщении (или последовательности сигналов). По Шеннону информация снятая неопределенность. Точнее получение информации - необходимое условие для снятия неопределенности. Неопределенность возникает в ситуации выбора. Задача, которая решается в ходе снятия неопределѐнности – уменьшение количества рассматриваемых вариантов (уменьшение разнообразия), и в итоге выбор одного соответствующего ситуации варианта из числа возможных. Снятие неопределенности даѐт возможность принимать обоснованные решения и действовать. В этом управляющая роль информации. Информационная энтропия - мера хаотичности информации или мера внутренней неупорядоченности информационной системы. Энтропия увеличивается при хаотическом распределении информационных ресурсов и уменьшается при их упорядочении. Информационная энтропия - мера хаотичности информации, неопределѐнность появления какого-либо символа первичного алфавита. При отсутствии информационных потерь численно равна количеству информации на символ передаваемого сообщения. Информационная энтропия - неопределѐнность появления какоголибо символа первичного алфавита. При отсутствии информационных потерь численно равна количеству информации на символ передаваемого сообщения. Например, в последовательности букв, составляющих какое-либо предложение на русском языке, разные буквы появляются с разной частотой, поэтому неопределѐнность появления для некоторых букв меньше, чем для других. Если же учесть, что некоторые сочетания букв (в этом случае говорят об энтропии n-ого порядка) встречаются очень редко, то неопределѐнность ещѐ более уменьшается. Понятие информационной энтропии определено Шенноном для случая дискретных данных и весьма похоже на понятие термодинамической энтропии. Это величина, обозначающая количество информации, содержащееся в данном сообщении (или последовательности сигналов). Сведения об информационной энтропии необходимы для повышения надѐжности передачи сигналов. Именно на неѐ ориентируются при задании избыточной информации, передаваемой по линии связи. Избыточтость - термин из теории информации, означающий превышение количества информации, используемой для передачи или хранения сообщения, над его информационной энтропией. Для уменьшения избыточности применяется сжатие данных без потерь, в то же время контрольная сумма применяется для внесения дополнительной избыточности в поток, что позволяет производить исправление ошибок при передаче информации по каналам, вносящим искажения (спутниковая трансляция, беспроводная передача и т. д.). Чем меньше вероятность какого-либо события, тем большую неопределенность снимает сообщение о его появлении и, следовательно, тем большую информацию оно несѐт. Концепции информации и энтропии имеют глубокие связи друг с другом, но, несмотря на это, разработка теорий в статистической механике и теории информации заняла много лет, чтобы сделать их соответствующими друг другу. Впервые понятия энтропия и информация связал Шеннон в 1948. С его подачи энтропия стала использоваться как мера полезной информации в процессах передачи сигналов по проводам. Следует подчеркнуть, что под информацией Шеннон понимал сигналы нужные, полезные для получателя. Неполезные сигналы, с точки зрения Шеннона, это шум, помехи. Если сигнал на выходе канала связи является точной копией сигнала на входе то это означает отсутствие энтропии. Отсутствие шума означает максимум информации. Взаимосвязь энтропии и информации нашло отражение в формуле: H + I = 1, где Н – энтропия, I – информация. Этот вывод количественно был обоснован Бриллюэном. Сенсация — это редкое событие, предсказуемость которого очень мала, и потому велика его информационная стоимость. Часто информацией называют новости — сообщения о только что произошедших событиях, о которых мы еще не знаем. Но если о случившемся нам расскажут во второй и третий раз, избыточность сообщения станет очень велика, его непредсказуемость упадет до нуля, и мы просто не станем слушать, отмахиваясь от говорящего со словами: «Знаю, знаю». Поэтому-то средства массовой информации (СМИ) и стараются быть первыми. Вот это соответствие интуитивному чувству новизны, которое рождается неожиданным известием, и сыграло главную роль в том, что статья Шеннона, не рассчитанная на массового читателя, стала сенсацией, которую подхватила пресса и которую приняли как универсальный ключ к познанию природы ученые самых разных специальностей — от лингвистов и литературоведов до биологов. Но понятие информации, по Шеннону, — это строгая математическая теория, и ее применение за пределами теории связи очень рискованно. Зато в самой теории связи она играет центральную роль.