Информатика в экономике, финансах и менеджменте. Учебное пособие / Под ред.

реклама

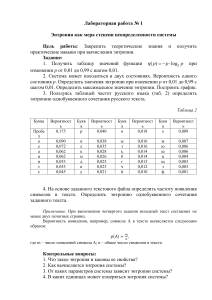

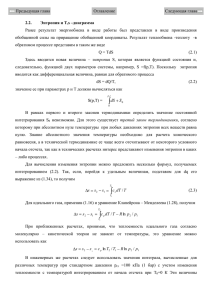

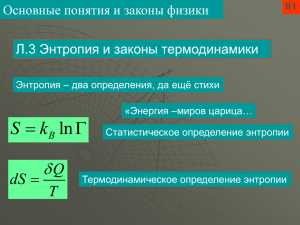

МЕЖДУНАРОДНЫЙ БАНКОВСКИЙ ИНСТИТУТ Информация 3 Информатика в экономике, финансах и менеджменте. Учебное пособие / Под ред. профессора В.В. Изранцева. – СПб: МБИ, 2004. – 306с. Системотехника как наука о системах связывает информацию с мерой организации системы, которая может находиться в различных состояниях. К понятию состояния системы следует подходить аккуратно, учитывая особенности системы, правила ее работы. Об этом еще в 60-х годах предупреждал известный специалист в области системотехники Л. Заде. Cистема в самом общем виде рассматривается как соотношение вход-выход. Его удобно задавать с помощью таблицы. Число единиц K в ней является важной характеристикой системы. Если задано число К, то можно определить, сколько состояний будет иметь система. В общем случае число возможных состояний системы с N входами, M выходами и K единицами в таблице вход-выход определяется числом сочетаний из MN по K, которое обозначим следующим образом . Оно определяет неопределенность системы при ее построении. Чем больше возможных состояний, тем больше вариантов может представить система при своем функционировании за счет выбора требуемых состояний. Мерой неопределенности системы обычно служит ее энтропия. Для того, чтобы измерять ее в битах, будем вычислять энтропию системы по формуле: Из нее видно, что энтропия равна одному биту, когда число возможных состояний системы равно 2. Существуют два тривиальных случая, когда система пуста, и К=0, или когда система полностью определена, и K=MN. В обоих тривиальных случаях энтропия равна нулю, Н=0. Для того, чтобы оценить максимум энтропии при больших значениях произведения MN, воспользуемся аппроксимацией Стирлинга: МЕЖДУНАРОДНЫЙ БАНКОВСКИЙ ИНСТИТУТ Нетрудно убедиться, что оценка энтропии принимает максимальное значение MN в случае, когда число единиц в таблице вход-выход системы принимает значение MN/2. Получив средство для измерения такого важного свойства системы, каким является мера неопределенности - энтропия, можно рассмотреть понятие информации. Для этого предположим, что для системы известна начальная энтропия Ннач. Если о ней ничего неизвестно, то в качестве начальной энтропии целесообразно выбирать энтропию тривиальных случаев, когда Ннач=0. Затем необходимо сформулировать задачу идентификации системы: для данной системы определить число единиц таблицы вход-выход. Эта задача соответствует тому методу, который был использован при определении понятия информации. Зная К и MN, легко вычислить энтропию системы, обозначив ее как конечную энтропию Нкон. Теперь информация, полученная в результате решения задачи идентификации, может быть определена как абсолютная величина полученного приращения энтропии: I=abs(Нкон - Ннач). Функция abs() используется для того, чтобы не получать отрицательных значений информации (дезинформации), когда Ннач > Нкон . Заметим также, что при Ннач=0 информация совпадает с конечной энтропией: I=Нкон .