• .• . • • • • • • •

Элементы

теории вероятностей

и случайных процессов

• • • • • • • • • • • • • • • • • • • -• • • • • • • • • • • • • • • • • • • • • • • •

• • •• • • •• •• • • • •• • • • • • • • • • ••• • ••• • • • • • • • • • •

• • • • • • •• • • • • • • • • • •••• • • • •• • • • • • • • •• • • •• •• • • • •• ••

• • • • • • •• • • • • • • • •• • • • • • • • • • • • •• • • • •• • • • • • • • • • • • • • •

• • • • • • • • • • • • • • • • • • • • • • «• • • • • • • • • • • • • • • • • • • • • • • • • • • »

МОСКВА

ФИЗМАТЛИТ®

2011

УДК 519.21

ББК 22.171

С 30

С е м а к о в С. Л. Элементы теории вероятностей и случайных процессов. - М.: ФИЗМАТЛИТ, 2011. - 232 с. - ISBN 978-5-9221-1345-8.

Излагаются элементы теории вероятностей и теории случайных процессов.

Много внимания уделяется решению задач, которые занимают большую часть

пособия.

Рекомендовано Учёбно-методическим объединением высших учебных заведений Российской Федерации по образованию в области прикладных математики и физики в .качестве учебного пособия для студентов высших учебных

заведений по направлению «Прикладные математика и физика».

© Ф И ЗМ А Т Л И Т , 2011

ISBN 978-5-9221-1345-8

© С. Л . Семаков, 2011

Часть

§1.

§2.

§3.

§4.

§5.

§6.

§ 7.

§8.

§ 10.

§11.

§ 12.

§ 13.

§14.

§ 15.

6

...............................................................

6

Элементы комбинаторики

Задачи ..............................................................................................................

9

14

Определение вероятности.....................

Задачи ............................................................................

17

Условная вероятность, формулы полной вероятности и Байеса . .

30

35

Задачи. . . . ...................................................................................................

Последовательность независимых испы таний...................................

41

43

Задачи ......................

Случайные величины и функции распределения..............................

50

54

Задачи..............................................................................................................

Числовые характеристики случайной величины . . . .....................

64

76

Задачи............................

Системы случайных величин.........................................

90

93

Задачи ..................................

Закон больших чисел и центральная предельная т е о р е м а

109

113

Задачи. ...............................................................................

Часть

§9.

1. Элементы теории вероятностей ........................................

2.

Элементы теории случайных процессов ....................

Исходные фундаментальные определения, понятия и результаты.

Задачи...................

Математическое ожидание, дисперсия и корреляционная функция

случайного п р о ц е с с а

.................................................................

Задачи...............................................................................................................

Пуассоновский процесс

................................

З адачи.................

Виды сходимости в вероятностном пространстве и характеристики гладкости случайного п роц есса.............................................

Задачи...............................................................................................................

Стационарные и нормальные процессы — два важнейших класса

случайных процессов..................................................................................

Задачи ...................................................................................................

Винеровский проц есс........................

Задачи ..........................................................................................

Интегрирование случайных п р о ц е с с о в ...............................................

Задачи ...............................................................................................................

123

123

128

134

136

142

143

155

161

168

174

189

200

207

214

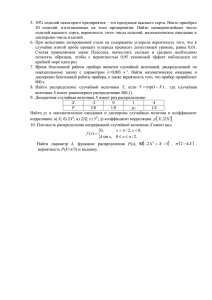

Пособие состоит из двух частей. В первой части излагаются

элементы теории вероятностей: начальные понятия комбинаторики; определение вероятности; условные вероятности; теоремы

сложения и умножения вероятностей; формулы полной вероятности и Байеса; схема независимых испытаний Бернулли и связанные с ней результаты; понятия случайной величины и функции

распределения, их свойства; числовые характеристики случайной

величины; дискретные и непрерывные распределения; понятия

системы случайных величин и функции совместного распределения; закон больших чисел в формулировке Чебышёва и центральная предельная теорема в форме Ляпунова. Изложение разбито на

восемь параграфов, каждый из которых заканчивается решением

задач различной сложности, соответствующих изучаемой теме.

Во второй части пособия, которая может быть прочитана независимо от первой и требует несколько более серьезной — по сравнению с первой — математической подготовки читателя, рассматриваются вопросы, дающие начальное представление о теории

случайных процессов, а именно: формулируются исходные фундаментальные определения и понятия теории; изучаются свойства

двух важнейших классов случайных процессов — стационарных

и нормальных; подробно рассматриваются пуассоновский и винеровский процессы; определяются виды сходимости в вероятностном пространстве и соответствующие им характеристики гладкости случайных процессов; излагаются вопросы, связанные с интегрированием случайных процессов, в частности, определяется

стохастический интеграл Ито. Изложение второй части разбито

на семь параграфов, каждый из которых заканчивается решением

задач. Задачи — как в первой, так и во второй части пособия —

являются неотъемлемой частью основного текста, во многих случаях содержат важные дополнения к нему и способствуют его

более глубокому пониманию и усвоению.

При написании учебного пособия и отборе предлагаемых примеров и задач автор опирался на две классические работы:

• Феллер В. Введение в теорию вероятностей и ее приложения.

Т. 1, 2. - М.: Мир, 1984;

• Гнеденко Б.В. Курс теории вероятностей: Учебник. Изд. 8-е,

испр. и доп. — М.: Едиториал УРСС, 2005.

Кроме того, использовались монография автора

• Семаков C.JI. Выбросы случайных процессов: приложения

в авиации. — М.: Наука, 2 0 0 5 ^ ,

и сборники формулировок задач, составителями которых являются коллеги автора по кафедре математических основ управления

Московского физико-технического института:

• Основы теории вероятностей и стохастических процессов:

Учебно-методическое пособие / Сост. А.А. Натан, О.Г. Горбачев, С.А. Гуз, Е.В. Бурнаев, А.В. Гасников. — М.: МФТИ,

2006;

• Случайные процессы: Учебно-методическое пособие / Сост.

А.А. Натан, О.Г. Горбачев, С.А. Гуз, Е.В. Бурнаев, А.В. Гасников. — М.: МФТИ, 2006.

Многие из представленных в пособии задач разбирались автором

на семинарах со студентами Московского физико-технического

института.

W В этой монографии (ее ядром являются оригинальные результаты

автора, опубликованные в журналах «Теория вероятностей и ее применения», «Известия РАН. Теория и системы управления», «Автоматика

и телемеханика», «Ученые записки ЦАГИ» и др.) излагается взгляд на

теорию случайных процессов как инструмент математического моделирования. Известный специалист по математическому моделированию

сложных систем, академик РАН А.А. Петров охарактеризовал монографию, в частности, так: «... изложенный материал дает образцовое

представление о том, как надо применять методологию математического

моделирования к решению сложных прикладных задач».

§ 1. Элементы комбинаторики

Рассмотрим строку из k элементов (x\,x<i, . .. ,x*.)- Будем считать, что элемент х\ может быть выбран из некоторой совокупности различных элементов, общее число которых равно щ, т. е.

элемент х\ может быть выбран п\ способами. Аналогично будем

считать, что элемент Х2 (который также выбирается из определенной совокупности элементов) при ранее выбранном элементе х\

может быть выбран щ способами, и т.д. Наконец, элемент хк

при ранее выбранных элементах Х\,Х2 , . . . , Х к - \ может быть выбран Пк способами. Поставим вопрос: сколько N различных строк

{Х[,Х2 , . . . ,Xk) М О Ж Н О при ЭТО М составить? Строки {Х\,Х2 , . . . ,Xk)

и (xi,X 2 , . . . ,Хк) по определению различны, если хотя бы для

одного г, где i — 1,2, .. . ,k, х,- Ф х,-. Покажем, что

N = П\Щ . . . rtfe.

Действительно, если k = 2, то утверждение очевидно: оно легко проверяется перебором. Пусть k = 3. Рассмотрим пару (хьхг)

как элемент нового типа. Существует ЩП2 таких пар и щ элементов хз. Каждая тройка (х ^х г.х з) может рассматриваться как

пара, состоящая из (хь хг) и хз. Значит, число троек равно щ щ щ .

Доказательство утверждения для любого k получается по методу

математической индукции.

Доказанное утверждение иногда называют комбинаторным

правилом произведения.

Пример 1. Сколько способов разместить г шаров в п ящиках?

Все шары и все ящики различны, в любом ящике может оказаться

любое число шаров, в том числе нулевое.

Перенумеруем все шары и отдельно все ящики. Каждому размещению шаров по ящикам поставим в соответствие строку из г

позиций, где в 1-й позиции стоит номер ящика, в котором оказал-

ся 1-й шар, во 2-й позиции — номер ящика, в котором оказался

2-й шар, . . . , в r -й позиции — номер ящика, в котором оказался

г-й шар. Тогда число размещений будет равно числу различных

строк, которое, в свою очередь, по правилу произведения равно

п • п • . . . • п = п г.

4------ v------ '

г сомножителей

Определение 1. Число способов расположить п различных

элементов в ряд называется числом перестановок из п элементов

и обозначается Рп.

Покажем, что Рп = п\, где п! есть, по определению, произведение всех натуральных чисел от 1 до п: п! = 1 • 2 • 3 • . . . • п;

при этом, по определению, 0! = 1. Действительно, каждому расположению элементов в ряд соответствует строка из п позиций,

где на первой позиции расположен элемент, занимающий первое

положение в ряду, на второй позиции — элемент, занимающий

второе положение в ряду, и т. д. Ясно, что соответствие взаимно

однозначное, так что число способов расположить п элементов

в ряд будет равно числу различных строк. На первую позицию

в строке можно поставить любой из имеющихся п элементов; при

заполненной первой позиции на вторую позицию можно поставить любой из оставшихся (п — 1) элементов и т. д. В результате

по правилу произведения получим, что число различных строк

равно

п • (п — 1) • (п - 2) • . . . • 2 • 1 = /г!,

что и требовалось доказать.

Определение 2. Числом сочетаний из п элементов по k элементам называется число способов выбрать k элементов из п элементов без учета порядка следования элементов в выборке. Это

число, как правило, обозначается С*.

В качестве примера найдем С |. Пусть для наглядности элементами, число которых п = 3, являются геометрические фигуры:

квадрат, треугольник и круг. Тогда из этих трех фигур две фигуры (k = 2) можно выбрать следующим образом: квадрат и треугольник, квадрат и круг, треугольник и круг, т. е. числом способов, равным 3. Таким образом, Cf = 3.

Покажем, что при произвольных п и k, k < п, число

может

быть вычислено по формуле

r*k

_

п ” k\(n-k)V

Выберем k элементов из п элементов и будем располагать их

в строку в различном порядке. Получим k\ различных строк. Тогда общее количество различных строк из k позиций, которое

можно составить из п элементов, равно k\C„. С другой стороны, это количество строк можно найти по правилу произведения: на первую позицию можно поставить любой из п элементов, на вторую — любой из оставшихся (п — 1) элементов,

на k -ю позицию — любой из оставшихся (ti — (k — 1)) элементов.

Следовательно,

k\ Ckn = п(п - 1)(я - 2 ) . . . (л - (Л - 1)),

откуда

г к _ п(п ~ !)(« - 2) . . . (л - (А; - 1))

Ln~

ki~

~

или, домножая числитель и знаменатель дроби на (п —k)\, получаем

pk_

п ~ k\(n-k)V

что и требовалось доказать.

Пример 2. Каждая кость домино помечается двумя числами.

Сколько различных костей можно образовать, если использовать

натуральные числа 1, 2, . . . , л?

Поскольку числа на костях домино не упорядочены, то количество различных костей без учета дублей (дубль — кость домино, помеченная одинаковыми числами) — это количество способов выбрать два числа из п чисел без учета порядка выбираемых

чисел, т. е. С%. А так как число дублей равно п, то с их учетом

число различных костей домино равно С„ + п. В частности, при

п = 6 получим С | + 6 =

+ 6 = 21.

Определение 3. Числом размещений из п элементов по k

элементам называется число способов выбрать k элементов из

п элементов с учетом порядка следования элементов в выборке.

Это число обычно обозначается А*.

В качестве примера найдем А\ . Пусть, как и выше, элементами, число которых п = 3, являются геометрические фигуры:

квадрат, треугольник и круг. Тогда из этих трех фигур две фигуры (k = 2) с учетом порядка можно выбрать следующим образом:

квадрат и треугольник, треугольник и квадрат, квадрат и круг,

круг и квадрат, треугольник и круг, круг и треугольник, т. е.

числом способов, равным 6 . Таким образом, А | = 6.

При произвольных п и k, k < п, число

лено по формуле

может быть вычис-

A* = n ( n - l ) . . . ( n - ( k - 1)) =

которая следует из правила произведения. Отметим также, что

A kn = CknPk.

Пример 3. Имеются 5 различных автомобилей. Сколько способов можно предложить, чтобы посадить двух человек в эти

автомобили, если в каждый автомобиль можно посадить только

одного человека?

Пусть I и II — упомянутые два человека. Человека I будем

сажать в первый выбранный автомобиль, а человека II — во вто5!

рой. Тогда различное число рассадок есть Л | = ^ = 20 — число

j!

способов выбрать два автомобиля из пяти с учетом порядка выбираемых автомобилей.

Задачи

1. В азбуке Морзе буквы представляются последовательностями тире и точек с возможными повторениями. Сколько букв

можно составить из пяти или менее символов?

Р е ш е н и е . Из одного символа можно составить 2 буквы, из k

символов по правилу произведения можно составить 2k букв. Следовательно, число букв, которые можно составить из пяти или

менее символов, равно

2 + 22 + 23 + 24 + 25 = 2 + 4 + 8 + 16 + 32 = 62.

2 . Сколькими способами можно расположить в ряд т белых

и k черных шаров?

Р е ш е н и е , а) Будем сначала предполагать, что все шары одного цвета неразличимы. Расположение полностью определится,

если указать позиции, в которых будут находиться белые (черные) шары. Эти позиции можно выбрать C™+k (C*+ft) способами.

Следовательно, искомое число способов есть C™+k = C^+k.

б) Будем теперь считать, что шары одного цвета различимы;

для этого их, например, можно перенумеровать. Число способов

выбрать позиции расположения белых шаров равно C™+k. В эти

позиции белые шары можно расставить т\ способами, а в остав-

шиеся позиции черные шары можно расставить k\ способами. Значит, искомое возможное число расположений есть

C™+km\k\ = {m + k)\.

Заметим, что в случае б), когда все шары различимы, задача

сводится к нахождению числа перестановок из (т + k ) различных элементов, так что полученный результат (т + k)\ становится

очевидным.

3. Сколько существует различимых способов размещения г

неразличимых предметов (например, одинаковых по цвету и размеру шаров) по п различимым ящикам?

Р е ш е н и е . Каждому размещению шаров поставим в соответствие цепочку цифр, состоящую из 0 и 1, следующим образом.

Сначала пишем 0 , затем число единиц, равное числу предметов

в первом ящике, затем 0 , затем число единиц, равное числу предметов во втором ящике, затем 0, и т.д. При этом общее число

единиц будет равно г, а общее число нулей, которые играют роль

разделителей, будет равно п + 1. Например, последовательность

011001011100

соответствует размещению 6 предметов по 5 ящикам следующим

образом: в первом ящике — два предмета, во втором — ни одного,

в третьем — один, в четвертом — три, в пятом — ни одного. Первая и последние цифры — всегда нули, а промежуточные — либо

нули, либо единицы. Размещение предметов однозначно определится, если будет указано, какие из промежуточных позиций занимают единицы. Поскольку число промежуточных позиций равно г + п — 1, а число единиц равно г, то число возможных вариантов будет равно Сгг+п_ х.

4. Сколько существует размещений в условиях задачи 3, при

которых ни один ящик не остается пустым? Предполагается, что

г > п.

Р е ш е н и е . Первый способ. Условие, что ни один из ящиков

не оказался пустым, означает, что нет двух стоящих рядом нулей. Между г единицами имеются (г — 1) промежутков, в (п — 1)

из которых помещено по одному нулю. Следовательно, имеется

С*~у вариантов выбора.

Второй способ. Положим сначала в каждый ящик ровно по

одному предмету. А затем посчитаем, сколько способов распределить оставшиеся (г —п) предметов по п ящикам. Это число

способов, как следует из решения задачи 3, равно Cr^ n^ n_ v что

совпадает с C^Z\ •

5.

Найти число различимых способов размещения г\ неразличимых предметов одного вида и Г2 неразличимых предметов

другого вида по п различимым ящикам.

Р е ш е н и е . Зафиксируем какой-либо способ размещения г\

предметов одного вида и будем перебирать различные способы

размещения Г2 предметов второго вида. Этих способов, как следует из решения задачи 3, будет Crr*+n_ v Но способов размещения

предметов первого вида будет Сгг1^ п_ {. Следовательно, искомое

число способов равно

ГГЧ

п г1

ь г2-рл-1 ' 4 ,+ л -Г

6 . Сколько существует различимых результатов бросания г

неразличимых игральных костей?

Р е ш е н и е . Результат бросания г костей можно разбить на

шесть подгрупп: в 1-ю подгруппу попадут г\ костей, на которых

выпали «1», во 2-ю — r<z костей, на которых выпали «2», . . . ,

в 6-ю подгруппу — Гб костей, на которых выпали «6». При этом

r\ + f 2 + ■■■+ Гб = г. Поэтому результатов бросания г костей может быть столько, сколько способов распределить г неразличимых предметов по 6 различимым ящикам, т. е. (см. решение задачи з) с^+6_! = с ;+5.

7. Сколько существует различимых результатов бросания

г монет?

Р е ш е н и е . Результат бросания г монет можно разбить на две

подгруппы: в первую попадут все монеты, на которых выпал герб,

а во вторую — все монеты, на которых выпала решка. Поэтому

результатов бросания г монет может быть столько, сколько способов распределить г неразличимых предметов по двум различимым

ящикам, т. е. (см. решение задачи 3) Crr+2_i = С£+1 = г + 1.

8 . Сколько чисел, заключенных между 1000 и 9999, содержат

цифру 3?

Р е ш е н и е . Первый способ. Числа от 1000 до 9999 включительно — это все четырехзначные числа. Всего таких чисел 9000

штук. Действительно, каждому четырехзначному числу можно

сопоставить строку из четырех позиций, где первую позицию занимает первая цифра числа, вторую — вторая и т. д. По правилу

произведения число различных строк (которое равно числу различных четырехзначных чисел) равно 9 • 10 • 10 • 10 = 9000, ибо

в первую позицию можно вписать любую цифру от 1 до 9, а во

вторую, третью и четвертую позиции — любую цифру от 0 до 9,

так что первую позицию можно заполнить 9 способами, а вторую,

третью и четвертую — 10 способами.

Рассуждая аналогично и используя правило произведения, находим число всех четырехзначных чисел, не содержащих цифру 3:

оно равно 8 • 9 • 9 • 9 = 5832. Следовательно, число всех четырехзначных чисел, содержащих цифру 3, равно N = 9000 —5832 = 3168.

Второй способ. Пусть N\ — число всех четырехзначных чисел, содержащих в своей десятичной записи ровно одну цифру 3,

N 2 — ровно две цифры 3, Л/з — ровно три цифры 3, N 4 — ровно

четыре цифры 3. Тогда N = N\ + N 2 4- Л/3 + N 4 , причем, очевидно,

N 4 = 1.

Найдем N\. Сюда относятся все четерехзначные числа вида

3-----, где пустые позиции (прочерки) могут быть заняты любыми

цифрами кроме цифры 3. Таких чисел, по правилу произведения,

9 • 9 • 9 = 729. Кроме того, к Ni относятся все четырехзначные

числа видов - 3 — , — 3 - , ----- 3, где пустые позиции по-прежнему

могут быть заняты любыми цифрами, за исключением цифры 3,

причем если позиция первая, то она не может быть занята цифрой 0. По правилу произведения четырехзначных чисел вида - 3 —

будет 8 • 9 • 9 = 648 штук, столько же будет чисел вида — 3 - и чисел в и д а

3. Таким образом, N\ = 729 + 3 • 648 = 2673.

Аналогично найдем число N 2 . Сюда относятся все четырехзначные числа видов 33— , 3 -3 -, 3— 3, -3 3 -, -3 -3 , — 33, где

пустые позиции могут быть заняты любыми цифрами за исключением цифры 3, причем если позиция первая, то она не может быть занята цифрой 0. По правилу произведения чисел видов 33— , 3 - 3 - и 3— 3 будет по 9 • 9 = 81 штуке, а чисел видов

- 3 3 -, - 3 - 3 и — 33 будет по 8 • 9 = 72 штуке. Следовательно,

N 2 = 3 • 81 + 3 • 72 = 459.

Осталось найти Л/3. Сюда относятся числа видов 333-, 33-3,

3-33 и -333. Чисел первых трех видов будет по 9 штук, а чисел

вида -333 будет 8 штук. Значит, Л/3 = 3 • 9 + 8 = 35.

Таким образом,

N = М + N 2. + Л/з + N 4 = 2673 + 459 + 35 + 1 = 3168.

9.

Сколькими способами можно рассадить п человек за круглым столом?

Р е ш е н и е . Перенумеруем все места. Пусть наблюдатель А

знает нумерацию мест, а наблюдатель В — нет. Предполагается,

что все места одинаковы, так что в задаче спрашивается, сколько

различных рассадок может быть с точки зрения наблюдателя В.

Обозначим это число через К. Если всех сидящих сдвинуть на

одно место по кругу, то с точки зрения наблюдателя В способ

рассадки людей не изменится. Поэтому п рассадкам с позиции

наблюдателя А будет соответствовать одна и та же рассадка с позиции наблюдателя В. Но с позиции наблюдателя А число рассадок равно «!, так что К ■п = п\, откуда К = (п —1)!.

10. Сколько различных делителей у числа Pj' p^2

где

Pi,p 2 , ■■■,Pk — различные простые числа?

Р е ш е н и е . Любой делитель имеет вид

рТ рТ

где т \, т 2 ........ /и* — неотрицательные целые числа, такие, что

Щ < Щ, m 2 < П2 , .. ■, rrik < щ. Каждому делителю поставим в соответствие строчку (т \, т 2 ,

Тогда число различных делителей будет равно числу различных строк указанного вида.

В качестве mi может быть взято любое из чисел 0,1,2,

т. е. элемент т\ может быть выбран (п\ + 1) способами. При выбранном элементе т\ элемент m 2 может быть выбран (щ + 1) способами, . . . , при выбранных элементах m i, m 2 , ...,/re*_i элемент

может быть выбран (щ + 1 ) способами. Следовательно, по

правилу произведения число различных строк, а значит, и число

различных делителей будет равно (щ + 1)(я2 + 1) . . . (n* + 1).

Рассмотрим практическую ситуацию, связанную со случайным экспериментом, т. е. с некоторым испытанием Е, исход которого определяется случайным механизмом, воздействие которого

заранее предсказать невозможно. Будем интересоваться какимлибо событием А, связанным с £ в том смысле, что в результате Е событие А может произойти, а может не произойти. Во многих жизненных ситуациях возникает необходимость попытаться

предсказать степень возможности реализации события А в результате Е. Эту степень возможности будем характеризовать числом Р{А} — вероятностью события А, которую определим следующим образом.

1.

Рассмотрим сначала случай, когда при каждом испытании Е возможны п несовместных и равновозможных исходов

А[, А 2 , .. ■, А п и только они. Несовместность исходов означает,

что никакие два исхода одновременно, т. е. в одном испытании,

произойти не могут. В этой ситуации любое событие А, связанное

с Е, означает, что в результате Е имел место один из исходов

Aix,Ai2, . . . , A i m. При этом каждое конкретное событие А будет

определяться своим числом т е {0 , 1, 2, . . . , « } и своим набором

чисел г'ь «2, . . . , im € {1, 2, . . . , « } . Положим по определению

Р{А} = - .

п

Особо отметим два частных случая события А. Первый —

событие А происходит всегда при проведении Е. В этом случае

событие А будем называть достоверным. Ему соответствуют значение т = п и вероятность Р{А} = 1. Второй случай — событие А

никогда не происходит при проведении Е. В этом случае событие А будем называть невозможным. Ему соответствуют значение т = 0 и вероятность Р { А } = 0. Достоверное событие принято

обозначать символом П, невозможное — символом 0. Кроме того,

введем понятие противоположного события. Событие А будем называть противоположным событию А, если оно состоит в том,

что А не произошло.

Введенное выше определение вероятности называется классическим.

Пример I. Пусть эксперимент Е состоит в бросании на плоскость геометрически правильного кубика, изготовленного из однородного материала. Если пронумеровать грани цифрами от 1

до 6, то при бросании кубика могут произойти шесть равновозможных событий (и только они): А\ — выпадение грани 1, А 2 —

выпадение грани 2 , А$ — выпадение грани 6. Пусть событие А

означает, что выпала грань с четным номером, т. е. произошло

какое-либо из событий A 2 , A 4 ,Aq. Следовательно, т = 3 (ii = 2,

h = 4, г’з = 6) и Р { А } = т /п = 3/6 = 1/2.

2.

Распространим введенное выше определение на случай,

когда с экспериментом Е связано бесконечное число равновозможных исходов. Предположим, что каждому результату эксперимента Е можно взаимно-однозначно сопоставить точку в некоторой области G (на прямой, на плоскости, в пространстве). При

этом изучаемому событию А, связанному с Е, будет соответствовать попадание точки в некоторое подмножество g С G. Если

все точки области G равновозможны в смысле попадания в них

в результате эксперимента, то вероятность попасть в какую-либо

часть области G пропорциональна мере (длине, площади, объему)

этой части и не зависит от ее расположения и формы. В этом

случае, по определению,

Р{А} = = 1 .

mes и

Такой подход к определению вероятности называется геометрическим.

Пример 2. Предположим, что два человека А и В договорились встретиться в определенном месте между 12 и 13 часами.

Пришедший первым ждет второго в течение 20 мин., после чего

уходит. Чему рана вероятность встречи, если приход каждого

в течение указанного часа может произойти с равной возможностью в любой момент, причем момент прихода одного лица не

влияет на момент прихода другого?

Пусть х — момент прихода лица А, а у — момент прихода

лица В; х и у будем отсчитывать в минутах от 12 ч. Тогда необходимое и достаточное условия встречи дает неравенство

\х - у \ < 20,

а проведение эксперимента (приход двух людей к месту встречи) можно интерпретировать как вбрасывание точки в квадрат

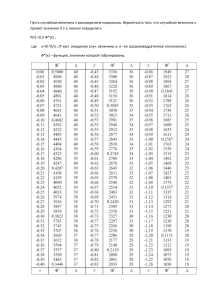

со стороной 60 (рис. 1): абсцисса х точки даст момент прихода

человека А, ордината у — момент прихода человека В. Точки,

Рис. 1

благоприятствующие встрече, расположатся в заштрихованной

области на рисунке. Искомая вероятность будет равна отношению

площади заштрихованной фигуры к площади всего квадрата, т. е.

602 - 402

5

602

“ 9'

3. Описанные выше подходы к определению вероятности применимы только в том случае, когда с экспериментом Е можно связать множество равновозможных исходов, которые исчерпывают

все результаты эксперимента. Этого недостатка лишен аксиоматический подход, предложенный А.Н. Колмогоровым.

Исходным пунктом аксиоматики Колмогорова является множество П, элементы которого называются элементарными событиями. Затем вводится в рассмотрение множество Т подмножеств элементарных событий. Элементы множества Т называются событиями, при этом под операциями над событиями понимаются операции над соответствующими множествами. В табл. 1

представлено соответствие между языком теории множеств и языком теории вероятностей.

Множество Т называется алгеброй множеств (на Г2), если

выполняются следующие условия:

1) П € Т , 0 е Т \

2) если А € Т , то и А е Т \

3) если Л G f и В е f , то A \J В Е Т vl А с \ В £

если дополнительно к перечисленным выполняется еще условие:

4) из того, что А п € Т для любого « = 1 ,2 ,..., следует, что

\JAn € Т ,

п

^ 3"’>

п

то множество Т называется а-алгеброй.

Таблица 1

Термины

Обозначения

теории множеств

теории вероятностей

О

множество, пространство

пространство элементарных событий, достоверное событие

W

элемент множества

элементарное событие

А, В

подмножество А, В

случайное событие А, В

АиВ=А+В

объединение

множеств А и В

сумма событий А и В

А ПВ = АВ

пересечение

множеств А и В

произведение событий А

иВ

А

дополнение

ства Л до О

событие, противоположное событию А

0

пустое множество

невозможное событие

А ПВ = АВ = 0

множества А и В не

пересекаются

события А и В несовместны

А =В

множества А и В равны

события А и В равносильны

множе-

Аксиома 1. Каждому событию А поставлено в соответствие неотрицательное число Р { А }, называемое его вероятностью.

Аксиома 2 . Р {Щ = 1.

Аксиома 3. Если события А \ ,А 2 , . • • Ап> • • • попарно несовместны, то

Р { А Х+ А 2 + . . . + А п + . . . } = P{Ai} + P{A 2} + . . . + Р { А п} + . . . .

Тройка объектов (С1, Л,Р), где С1 — множество элементарных

событий, Т — сг-алгебра подмножеств С1 (называемых событиями), Р{А } — вероятность, определенная на и-алгебре Т , называется вероятностным пространством.

Задачи

1.

В урне находятся N одинаковых по размеру и внешнему виду шаров; среди них М белых и {N — М) черных. Наудачу вынимают п шаров (без возвращения в урну). Чему равна вероятность

того, что среди них окажется т белых?

Р е ш е н и е . Общее число равновероятных исходов равно Сдг,

из них число благоприятных

так что искомая вероятность равна

рт

р п —т

ь N -M

2. Какова вероятность при 24 бросаниях по две игральные

кости получить хотя бы один раз две единицы?

Р е ш е н и е . Пусть событие А состоит в том, что хотя бы один

раз выпали две единицы при 24 бросаниях двух игральных костей. Тогда событие А означает, что ни разу не выпали две единицы. Воспользуемся классическим определении вероятности, согласно которому Р { А } = n /N , где N — общее число равновозможных исходов, п — число благоприятных (т. е. приводящих к событию А) исходов. Поскольку при одном бросании двух игральных костей возможны 36 равновероятных результатов, причем

только один из них приводит к выпадению двух единиц, то по

правилу произведения N = 3624, а п = (36 — I)24 = 3524. Искомая

вероятность

Р{А} = 1 - Р{А) = 1 - £ = 1 -

= 0,4914 . . . .

3. Партия продукции состоит из 10 изделий, среди которых

2 изделия дефектные. Какое наименьшее число k изделий необходимо проверить, для того чтобы среди них с вероятностью не

меньше 0,9 содержалось хотя бы одно дефектное?

Р е ш е н и е . Пусть событие А состоит в том, что среди k выбранных было хотя бы одно дефектное изделие. Тогда событие А

означает, что все k выбранных изделий — нормальные (т. е. не

имеющие дефектов). По классическому определению вероятности

Р{А} = n /N , где N = С — общее число равновозможных исходов, которое в данном случае равно числу способов выбрать k

элементов из 10 элементов, 2, п — С\ — число благоприятных (т. е.

приводящих к событию Р{А}) исходов, которое в данном случае

равно числу способов выбрать k изделий из 10 —2 = 8 нормальных изделий. Таким образом,

Р{А} = \ - Р { А } ^ \ - ^ .

Чо

По условию Р{А} > 0,9, т. е.

откуда

k 2 - т + 81 < о.

Целые положительные k, удовлетворяющие этому условию и ограничению k < 10, — это числа 7, 8, 9, 10. Значит, искомое k = 7.

4.

Найти вероятность того, что из 50 студентов, присутствующих на лекции, хотя бы двое имеют одну и ту же дату рождения.

Р е ш е н и е . Будем считать, что в году 365 дней. Общее число N

равновозможных вариантов распределения дней рождения в году

может быть найдено по комбинаторному правилу произведения:

N = 36550.

Пусть т — число вариантов, когда все родились в разные дни. По

правилу произведения

т = 365 • 364 •

• (365 - 49) = Л ^ 5.

По классическому определению вероятности искомая вероятность

равна

JV—tn

N~

^

365 364

~ 365 ' 365

5.

Группа из п человек разного роста случайным образом выстраивается в шеренгу. Найти вероятность того, что самый высокий и самый низкий окажутся рядом.

Р е ш е н и е . Общее число расстановок людей в шеренгу равно п\. Число благоприятных расстановок можно подсчитать, если

пару «низкий-высокий» условно рассматривать за один объект.

Тогда число благоприятных расстановок будет равно (п — 1)! • 2,

где коэффициент 2 учитывает то обстоятельство, что самый низкий и самый высокий, стоящие рядом, могут поменяться местами.

Искомая вероятность равна

{число благоприятных расстановок} _ 2 • (п — 1)! _ 2

п\

п

{общее число расстановок}

6.

Группа из п человек разного роста случайным образом выстраивается в шеренгу. Найти вероятность того, что между самым высоким и самым низким расположатся более k человек.

Р е ш е н и е . Общее число расстановок людей в шеренгу равно п\. Найдем число расстановок, когда между самым низким

и самым высоким ровно (k + 1 ) человек. Обозначим это число

через Nk+i. Тогда по схеме

1

'

2

3

k

k+ l

k+ 2

'

k+ 3

п

(АН-1) человек

где X и Y — самый низкий и самый высокий, нетрудно сообразить,

что

N k+1 = 2 • (п - 2)! • (п - (k + 3) +1) = 2 • (п - 2)! • (п - k - 2).

'------ V------ '

число сдвиж ек

Здесь 2 • (п —(k + 3) + 1) — число способов зафиксировать двух

определенных человек в шеренге из п человек так, чтобы между

ними было ровно (k + 1) человек; (п — 2)! — число способов разместить оставшихся (п — 2) человек по (п — 2) свободным местам.

Коэффициент 2 в формуле для N^+\ учитывает то обстоятельство,

что X и Y можно поменять местами, не меняя при этом положения

остальных людей.

Аналогично,

N k+2 = 2 •(п - 2)! • (п - (k + 4) + 1) = 2 • (п - 2)! • (п - k - 3),

з = 2 •(л - 2)! • (л - (п - 3 + 2) + 1) = 2 • {п - 2)! • 2,

JV„_2 = 2 •(п - 2)! • (п - (л - 2 + 2) + 1) = 2 • (п - 2)! • 1.

Следовательно, число расстановок т, когда между самымвысоким и самым низким будет более k человек, равно

т = А/&+1 + Nk +2 + • • • + Afn_2 =

2 • (n —2 ) \ - i =

i=i

= 2 • (n - 2)!

2 г = 2 • (n - 2)! • l ±

i=

? ~ k ~ 2

,(n - k -

2)

=

1

= (n — 2)! (n —k — 1)(n — k — 2).

В результате для искомой вероятности имеем по классическому

определению

(п - 2)! ( n - k - 1)(п - k - 2 ) _ ( n ~ k - 1){п - k - 2)

7.

Из колоды, содержащей 52 карты, наугад берутся 6 карт.

Какова вероятность того, что среди них будут представлены все

четыре масти?

Р е ш е н и е . Общее число равновозможных выборов равно С |2Найдем число благоприятных выборов. С этой целью перенумеруем масти: I, И, III, IV. Все благоприятные выборы можно разбить

на 10 типов:

тип 1 — I II, III, IV, I, I;

тип 2 — 1 II, III, IV, I, II;

тип 3 — 1 II, III, IV, I, III;

тип 4 — 1 II, III, IV, I, IV;

тип 5 — I II, III, IV, II, II;

тип 6 — I II, III, IV, II, III;

тип 7 — 1 II, III, IV, II, IV;

тип 8 — 1 II, III, IV, III, III;

тип 9 — 1 II, III, IV, III, IV;

тип 10 - I, II, III, IV, IV, IV.

Пусть Ni — количество различных выборов г-го типа, i =

= 1,2, . . . , 10. Тогда

N l = N 5 = N s = м о = С?з • С\3 • С\з • С}3,

щ = N 3 = V4 = N 6 = М7 = N 9 = Cf 3 ■Cf 3 • C\ 3 ■C\3,

так что искомая вероятность равна

Ni + N2 + ... + N10 4С?зС|зС{зС}з + бС^С^С'зС'з

133 • 38___ _

с |2

"

с562

- 4 7 .49 . 5 -1 7 = 0,426 . . . .

8.

Каждая из п палок одинаковой длины разламывается на две

части —длинную и короткую — так, что все длинные (а значит,

и все короткие) обломки одинаковы по своей длине.Полученные обломки, число которых составляет 2п, случайным образом

объединяют в пары, каждая из которых образует новую палку.

Найти вероятность того, что: а) все обломки объединяются в первоначальном порядке, образуя исходные палки; б) все длинные

обломки объединяются с короткими.

Р е ш е н и е . Найдем сначала общее число равновозможных

исходов — число способов из 2п обломков составить п палок,

когда любой из обломков можно соединить с любым. Число таких

способов с учетом порядка появления палок равно

г 2

г 2

г 2

г 2

_ (2 пУ-

с 2п ‘ с 2л -2 ' и 2 л -4 ' • • • ' и 2 —

2"

’

а без учета порядка (т. е. если нас интересует только конечный

набор образовавшихся палок без учета порядка, в котором они

появлялись)

(2 п)\/ 2 п _ (2л)!

я!

~ п\ 2 п '

В случае а) благоприятный вариант (без учета порядка), очевидно, только один, так что в этом случае искомая вероятность равна

1

_ л!2"

(2я)!/(я!2") ~ (2л)!'

В случае б) число благоприятных вариантов объединения с учетом порядка появления палок равно

(С1п •С\) •(С‘_, • С ф ) . (С\ _ 2 • С‘_2) . . . (С} • С\)= (л!)2.

Здесь (С* •ф —число способов выбрать«правильную»

(длинный обломок + короткий обломок) первую пару, (Cln_j • С\_ j) —

число способов при выбранной «правильной» первой паре выбрать

«правильную» вторую пару, (С1п _ 2 ■Схп_2) — число способов при

выбранных «правильных» первой и второй парах выбрать «правильную» третью пару, и т.д. Число благоприятных вариантов

объединения без учета порядка равно

Последний результат можно получить и по-другому. Расположим

все длинные обломки напротив коротких. Зафиксируем порядок

следования длинных обломков, а короткие обломки будем переставлять и затем состыковывать их с длинными, расположенными напротив. Тогда, очевидно, число различных вариантов объединения будет равно числу возможных перестановок коротких

обломков, т. е. ровно п\.

Таким образом, по классическому определению вероятности

искомая вероятность в случае б) равна

п\

(л!)22"

2 - 4 - 6 ... 2п

(2 п)\/{п\ 2 п) ~ (2л)! _ (я + 1)(л + 2) . . . 2л'

9.

Стержень длиной / разрезан в двух случайно выбранных

точках. Найти вероятность того, что из получившихся трех отрезков можно составить треугольник.

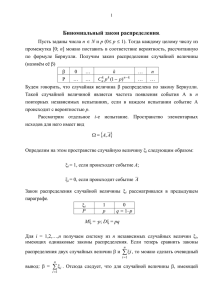

Р е ш е н и е . Пусть х — длина первого отрезка, у — длина

второго. Тогда длина третьего отрезка равна I — (х + у). Ясно,

что должны быть выполнены условия: х > 0 , у > 0 , х + у < /, так

что результат разрезания стержня можно интерпретировать как

выбор произвольной точки из треугольника, изображенного на

рис. 2: выбор точки М означает, что длина первого отрезка (под

которым можно условиться понимать, например, левый обломок

стержня) равна х, длина второго (под которым можно понимать

правый обломок) равна у, а длина третьего (т. е. среднего обломка) равна / —(х + у). Из полученных отрезков можно составить

треугольник тогда и только тогда, когда длина любого из отрезков

будет меньше суммы длин двух других, т. е. когда

х < у + (I — х — у)

у < х + (1 —х —у)

I — х — у < х + у,

или

(х <

<у <

Уу >

1/2

1/2

1/2

— х.

Рис. 2

Последняя система определяет треугольник, заштрихованный

на рис. 3.

Следовательно, в соответствии с геометрическим подходом

к подсчету вероятности искомая вероятность Р может быть вычислена как отношение площади 1/2 - //2 - //2 заштрихованного

треугольника к площади 1/2 • / • / большого треугольника:

i l l

Р= 2 ' 2 ' 2 _ I

2

10.

В гардеробе все шляпы N посетителей оказались случайным образом перепутанными. Шляпы не имеют внешних отличительных признаков. Какова вероятность того, что хотя бы один

посетитель получит свою шляпу?

Р е ш е н и е . Предварительно докажем следующую теорему

о вероятности суммы п событий.

Теорема. Вероятность Р{А\ + . . . + А п} осуществления хотя бы одного из событий А и •.. А п равна

Р{А\ + . .. + А п} = ^ 2 P{Ai\} ~

/i= l

+

Е

P{AhAi2} +

\ < i \ < i 2< n

P{AixAi2Ai3} -

1 < i 1 < /2 < i 3 < n

E

P{AiiAi2Ai3Ai4} + . . .

1 < i 1 < i2 < is < /4 < n

. . . + ( - l )"+1

Y,

P { A kA h . . . A in}.

\ < i X< i 2 < . . . < i n < n

Условие 1 < i\ < /2 < h < - - - < n означает, что в суммах каждая комбинация событий встречается ровно один раз; следовательно, сумма

Е

P { A hAi2 . . . A i m},

1<Ч<*2< —<*т<Я

т < п,

содержит С% слагаемых, а последняя сумма

Е

P { A hA h . . . A in}

\ < i \ < i 2< ...< in < n

сводится к единственному слагаемому

Р{ А \А 2 ■■. А п},

которое является вероятностью одновременного осуществления

всех п событий.

Ниже приведены утверждения теоремы для частных случаев

п = 2,3,4. При п — 2:

Р { А Х+ А 2} = Р{А\} + Р{А 2} - Р { А ХА 2}.

При п = 3:

Р { А ! + Л 2 + Л 3} = Р { А !} + Р { А 2} + Р{А 3} - {Р{АХА 2} + Р { А ХА 3] + Р{А2Л3}) + Р { А \ Л 2Л 3}.

При л = 4:

Р{Л ! + Л2 + Л3 + Л 4} = Р{Л !} + Р{А2} + Р{А3} + Р{Л4} - (Р{АХА 2} + Р { А ХА 3} + Р { А х А а} + Р{Л2Л 3} + Р{А 2А а} +

+ Р { А 3А а}) + Р { А ХЛ 2Л 3} + Р { А хА 2А а} + Р { А хА 3А а} +

+ Р{Л2Л 3Л4} - Р { Л 1Л 2Л 3Л 4}.

Д о к а з а т е л ь с т в о теоремы проведем по методу математической индукции. При п = 2 утверждение теоремы очевидно.

Пусть оно выполняется при п = k. Покажем, что тогда оно будет

выполняться и при п = k + 1. Обозначим Л = А х + Л 2 + . .. + Л*,;

Л, = A tA k+1, г = 1,2, . . . , k. Тогда

Р{Л1 + Л 2 + . . . + Ak + A h +1} =

= Р{Л + Л*+1} = Р{Л} + Р{Л*+1} - Р{ЛЛ*+1.} =

{далее пользуемся легко проверяемым свойством операций над событиями: для любых событий В, С, D справедливо равенство (В + C)D =

= BD + CD}

= Р { А Х+ Л2 + . . . + Ak} + P{Ak+1} —

—P { A xA k+x + Л2Л^+1+ ... + AkAk+1} =

/Ш

= (E pW.}- E

i\=1

p (a M

\<i\<i2<k

... +(-D‘+'

+

E

Р 1 А Ф М + ...

\<i\<i2<iz<k

E

—P { A i + A 2 + ... + Ak} =

,*+i

= (ЕРГадE eMAH \<i\<i2<h<k

E

/i=l

\<i\<i2<k

. . . + (-!)» '

•£

P{A,,Ah - - - A k } ) ~

\<ii<i2<.-.<ik<k

(S ^ W - Е '’ЙАН

й=1

Е

/>{л.-ЛЛ,>+'

1<й< *2 <*з<&

\< i\< i2 < k

... + (_,)*+!

£

Р{Л,,Л(, . - А } ) =

1ей </2^ ^ ik

,k + \

= (E ptM- E

й=1

1<й<г2Е^

Р {А М +

...+(-i)*+'

j

:

E

^й^й^^зЕ^

W H /J +-

р{л,и,г . . . л , , } ) -

- ( «1=1

E W t t 1}- E mAyVi} +

\< i\< i2 < k

+

E

^>{-^/H«2^*3-^*+l} + • • •

1<«1<*2</з<*

+ ( - 1)‘+1

...

Y.

Р {А ‘А г ■■■A A + l } ) =

1<Й<г2<•••<*£<&

{перегруппи ровы ваем слагаем ы е}

k+ \

У

4

k

= E m ,} -( E р{л,а }+ Е /,{'М*+.}) +

+f E

Г{Л,,Л/2Л/з}+

1 < й < * 2 < г’з<&

P{Ai\Ai2Ak+\}\ +. . .

l< « i< « 2 < ^

. . . + ( ( - 1)й+1/>{Л1Л2 . . . Л , } -(-!)*

P{Ai\Ai2 • • ■Ak-iAk+i}') -

E

l < i i < i 2< - < i k - i < b

- ( - 1 ) * +1

k+ \

= E P{Ai\}~

Й=1

Y

E

P { A hA h . . . A ikA k+l}

Я{Л(1Л,2}+

1^Й<С«2^^Ч_1

+ ... + ( - l ) ‘+l

+ (_l)*+2

Y

E

^>{-^г1Лг2Л/3}+

1^Й <С«2<^^3^^“Ь1

P { A hA i l . . . A k } +

£

l<ii<«2<...<^+i<^+l

P{A,,Ah . . . A , w }.

Последнее равенство означает, что утверждение теоремы выполняется при п = k + 1. Таким образом, теорема доказана методом

математической индукции.

Вернемся теперь к решению задачи. Пусть Л г- — событие, состоящее в том, что i-й посетитель взял свою шляпу, / = 1, 2, . . . , п.

Тогда по классической формуле подсчета вероятности

pr/|.i _ ( N - 1 ) ! _ 1

р Г^ ^ 1 _ (N - 2)! _

Л.)

Р1А

П Л , ЯА , Л

к 1 -- tN т~ ~3)!;V(,V

Р1Л - А ■

1 “ 12 "

1

1 ■2) ..................

- !)f;V

А • ) = ^ ~ т ^ = __________ -__________

(m-r

ЛП

N

{

N

• • Л (ЛГ1}

—,

’

P{j4('jy4»2 • •

Поэтому

Е ЯМ

(=1

=

+ +

+ =1>

'-----------v---------- '

число слагаемых C'n = N

J2

P{AiAj} =

1

_

^

число

+ . .. + Щ Г Г 1 ) = 2!’

v

^

^>9t = ----------iV!

слагаемых CN~

(N—

2)!2!

4

\<i<j< k<N

— v*

число слагаемых

V

ил л

Л

1

с?,=

^-(дг_3)!3!

- (w- ”>' I

4

\<il<i2<...<im <N

! ■I $

I <w~ m>! - 1

1111 v —

число слагаемых CN

Z = i(N—

m)\m\

Y

p {AhAi2 ■■-AiN_{} —

1<4<02<-..<(/ v—

+

s—

+ ■• • + jjj — (jv_ n r

— v----------- /

число слагаемых C ^ ~ l = N

Y

\<i\<i2<---<iN<N

p {AiiA i2 ■■•A l = P {A \A 2 .. . A n } =

Следовательно, по доказанной теореме искомая вероятность того,

что хотя бы один посетитель взял свою шляпу, равна

Р{А\ + А 2 + .. . + Av} = 1 — г Г^зУ — ••• +

Заметим, что выражение 1 —Р{А\ + А 2 + .. . + -А } представляет

собой (N-+ 1) первых членов разложения функции е* в ряд Маклорена при х = —1:

так что при больших N

P { A x + A 2 + . . . + A N} & 1 - е-1 = 0,63212 . . . .

Поскольку ряд для экспоненты сходится достаточно быстро, то

искомая вероятность практически не зависит от N и близка к 2/3.

И. Пусть 30 шаров размещаются по 8 ящикам так, что для каждого шара одинаково возможно попадание в любой ящик. Найти

вероятность размещения, при котором будут 3 пустых ящика,

2 ящика с тремя шарами, 2 ящика с шестью шарами и 1 ящик

с двенадцатью шарами.

Р е ш е н и е . Общее число N способов разместить 30 шаров

по 8 ящикам можно найти по комбинаторному правилу произведения. Перенумеруем все шары и все ящики. Каждому размещению

поставим в соответствие строку из 30 позиций, где в первой позиции будет стоять номер ящика, в котором оказался 1-й шар, во

второй позиции — номер ящика, в котором оказался 2-й шар,

в тридцатой позиции — номер ящика, в котором оказался 30-й

шар. Тогда число N будет равно числу различных строк. Первую

позицию в строке можно заполнить 8-ю способами, вторую — при

заполненной первой — тоже 8 способами, третью — при заполненных двух предыдущих — тоже 8 способами и т. д. Следовательно,

по правилу произведения

N =

8

-8 -

...-8

'------V------'

= 830.

30 раз

Найдем теперь число N благоприятных размещений. Для этого снова применим правило произведения. Каждому благоприятному размещению поставим в соответствие строку из 4 позиций,

где первую позицию будет занимать объект из трех пустых ящиков, вторую позицию — объект из двух ящиков с тремя шарами,

третью позицию — объект из двух ящиков с шестью шарами

и четвертую позицию — объект из одного ящика с двенадцатью

шарами.

Первый объект можно выбрать С | способами; второй объект — после того, как был выбран первый — можно выбрать

С | • С| 0 • С | способами (здесь С | — число способов выбрать 2

ящика из пяти оставшихся; С®0 — число способов выбрать 6

шаров из тридцати оставшихся;

— число способов разместить

шесть выбранных шаров поровну между двумя выбранными ящиками); третий объект — после выбранных первого и второго —

можно выбрать С | • С24 • Cf 2 способами (здесь С | — число способов выбрать 2 ящика из трех оставшихся;

— число способов

выбрать 12 шаров из двадцати четырех оставшихся; С®2 — число

способов разместить 12 выбранных шаров поровну между двумя

выбранными ящиками), после чего четвертый объект может быть

выбран С\ ■С\I способами, т. е. одним способом.

Значит, по правилу произведения

\т

/°3 /^*2/^*6 /^3

— С8

• Ь5О301>6 \U3Lr24L42,

и искомая вероятность Р по классическому определению будет

равна

Р = % = 1(Г8 • 4,0269 . . . .

N

§ 3. Условная вероятность,

формулы полной вероятности и Байеса

Пусть события А и В связаны с одним и тем же экспериментом Е, причем Р{В} > 0. Тогда отношение Р{ А В } /Р { В } называется условной вероятностью события А при условии, что

произошло событие В, и обозначается Р{А \ В}:

Можно предложить следующую мотивировку этого определения.

Под условной вероятностью события А при условии В естественно

понимать долю равновозможных и несовместных исходов, приведших к А, среди тех исходов, которые приводят к В. Пусть

эксперимент Е всегда приводит к одному из N равновозможных

и несовместных исходов, при этом Л/д из этих N исходов приводят

к событию A, N b — к событию В, N ^ B — к событию АВ. Тогда

доля исходов, приведших к А, среди исходов, которые привели

к В, есть

Nab

Nb ’

а эту дробь можно представить как

Na

b

/N

N g /N

_

Р {А В }

Р{В}

'

Событие А называется независимым от В, если Р{А \ В } = Р { А ) .

В этом случае Р{АВ} — Р{ А} Р{В }, откуда при Р{А} > 0 получаем Р{В | А} = Р{В}, т. е. В также независимо от А.

Из определения условной вероятности следует

Р{АВ} = Р{А | В }Р { В } — Р { В \ А } Р { А } ,

т. е. вероятность произведения двух событий равна произведению

вероятности одного из этих событий на условную вероятность

другого при условии, что первое произошло. Это правило иногда

называют теоремой умножения вероятностей. Для независимых событий оно принимает вид

Р{АВ} = Р { А } Р { В } .

Пусть теперь событие А может осуществиться с одним и только одним из п несовместных событий Н\,Н2,

Это условие, в частности, выполняется, если сумма несовместных событий Н\ + #2 + . .. + Нп есть достоверное событие (в этом случае

говорят, что # ь # 2, . . . , # я образуют полную группу событий).

Тогда

А = АН\ + AH<i + . .. + А Н п.

Отсюда в силу несовместности событий, суммируемых в правой

части последнего равенства,

P { A }

=

j^ P { A H i

},

(1)

i= i

или, использовав теорему умножения, получаем

P{A} = ' £ P { A \ H i}P{Hi}.

i=\

Это равенство носит название формулы полной вероятности

Далее, по теореме умножения

Р Щ А } = Р{А | Hi}P{Hi} = P{Hi | А }Р { А } ,

откуда

т

\Л } . Р ! * т

р>,

или, используя формулу полной вероятности, приходим к формуле

Р{Я, 1Л}=

w m w )

.

Y ; p {a ]Hi ) p {Hi )

i= 1

Полученная формула называется формулой Байеса. Ее можно

интерпретировать следующим образом. Пусть известно, что к событию А могут привести события Н\,Н 2 , ■■■,Нп. Событие А произошло, но неизвестно, какое из событий Я ^Я г, • • • >Нп предшествовало этому. Если’найдены условные вероятности Р{Я, |Л},

/ = 1, 2, . . . , «, то естественно предположить, что скорее всего событию А предшествовало то из событий Я,-, которому соответствует большая вероятность Я{Я( 1А}. При такой интерпретации

й) Иногда формулой полной вероятности называют также формулу (1).

события Hi, i = 1, 2, . . . , п, называются гипотезами или причинами, объясняющими факт происхождения А, а сама формула

Байеса называется формулой вероятностей гипотез.

Пример 1. На заводе, изготовляющем болты, на долю 1-й, 2-й

и 3-й машин приходится соответственно 25, 35 и 40 % всех изделий. В их продукции брак составляет соответственно 5, 4 и 2%.

Случайно выбранный из продукции болт оказался дефектным.

Какова вероятность того, что он был изготовлен на 1-й машине?

на 2-й машине? на 3-й машине?

Р е ш е н и е . Введем в рассмотрение следующие события: Я г —

случайно выбранный болт изготовлен на i-й машине, i = 1,2,3;

А — случайно выбранный болт оказался дефектным. Тогда по

условию

Р{НХ} = 0,25;

Р{А \Hi} = 0,05;

/>{Я2} = 0,35;

Р{А | Я 2} = 0,04;

Р{Н3} = 0,4;

Р{А | Я3} = 0,02.

Поскольку несовместные события Я ь Я 2,Я з образуют полную

группу, то по формуле Байеса получаем искомые вероятности:

J2P{A\H,}P{H,)

i= 1

0,05 • 0,25

25

“ 0,05 • 0,25 + 0,04 • 0,35 + 0,02 • 0,4 ~ 69’

, й |л ) = Ж

№

•£,Р{А\Н,}Р{Н,}

p № |A} = ^ M № № L = | .

52Р{А\Н,}Р{Н,}

1=1

Пример 2. Два игрока ведут некоторую игру, состоящую из

отдельных партий, до полного разорения одного из них. Капитал

первого равняется а руб., капитал второго b руб. Вероятность выигрыша каждой партии для первого игрока равна р, а для второго

игрока равна q; р + q = 1 (ничьи отсутствуют). В каждой партии

выигрыш одного игрока (а значит, проигрыш другого) равен 1 руб.

Под разорением игрока понимается момент, когда капитал игрока

становится равным нулю. Найти вероятность разорения каждого

из игроков, если результаты отдельных партий независимы.

Р е ш е н и е . Пусть Рп — вероятность разорения первого игрока, когда он имеет п руб. Тогда искомая вероятность для него

есть Ра', при этом Ра+ь = 0 (если капитал первого игрока а + Ь, то

капитал второго равен 0 , и игра закончится, так что первый игрок

никогда не разорится), P q — 1 (если капитал первого игрока 0, то

факт его разорения свершился).

Пусть событие А —- первый игрок разорился при исходном капитале п; событие Я — первый игрок выиграл очередную партию.

Тогда по формуле полной вероятности

Р{А} = Р{А | Н }Р {Н } + Р{А | Н} Р{Н).

Поскольку

Р{А} = Рп,

Р{Н}=р,

Р{Н} = q,

P { A \ H } = Pn+h

Р { А \ Н } = Рп_ ь

то получаем

Р п — Р П + \ Р “I" Р п —\Я '

Отсюда для любого п — 1,2, . . . , а + b — 1 имеем:

Р„(р + q ) = Рп+\Р + Pn-\q,

q{Pn - Р п - 1) = р(Рп+1 - Рп),

Pn+l - P n = ^ P n - P n-l).

Значит,

откуда

£(/>»+. -« о = E ( f ) V i - » k= 0

k= 0

так что, считая пока q ф р, получаем:

Рп+ 1 - Р

0

= (Pi - 1 ) ^ ч

Р

(2>

2)

<

ИЛИ

Л+1

(«Г-1

Л +i - 1 = (Л - 1)-Ч р/------* - 1

р

Положив здесь я = а + b — 1, получим:

й-\-Ь

( i y _ 1

О—1 = (Р\ —1)— ---------, л - 1

I-'

тогда

1_ Я

р

=

l - -q

' ( Г - 1'

J . m "

'р '

р

11 =

Ур/

( l \ a+b_ ( S }

11 =

\р /

Ур>

" ( Г - ' I - “( Г -1 " ( Г - ‘

е) -еу

( Г - ~ -й Г

Отсюда вероятность разорения первого игрока

а+Ь / п \ а

/ г»\ ^

,

р/

Для случая р = q = 1/2 вероятность разорения найдем, вновь обратившись к равенству (2), из которого получим

Pn+i - 1 = (п + 1)(Л - 1).

При п = а + 6 — 1 имеем

О — 1 = (а + b)(P\ — 1),

Я,-1 = - - к ,

а+0

откуда

Р„ = п (Л - 1) + 1 = 1 -

а+ о

в частности,

р . = 1-

а

6

а + Ь а + Ь'

Таким образом, если капитал а первого игрока значительно

больше капитала b второго игрока, а игроки одинаково искусны

(р = q = 1/ 2), то разорение первого игрока практически невоз™

Ъ

Л

,

можно: Ра =

г ~ 0 при о

а.

a+ b

г

Обратимся теперь к анализу формулы (3). Если через Qt, обозначить вероятность разорения второго игрока при его начальном

капитале Ь, то в силу симметрии задачи

(4)

Предположим, что первый игрок играет лучше, чем второй, т. е.

р > q. Тогда, например, при Ь » а (условно считая Ь ~ оо), получим из (3) и (4):

т. е. умелый игрок даже с малым капиталом может иметь меньше

шансов на разорение, чем игрок с большим капиталом, но менее

умелый.

Задачи

1.

Игральная кость бросается до тех пор, пока не выпадет единица. Известно, что при первом испытании единица не выпала.

Найти вероятность того, что потребуется не менее трех бросаний,

считая первое.

Р е ш е н и е . Пусть Л,- — событие, заключающееся в том, что

при г-м бросании единица не выпала. Тогда искомая вероятность

есть

Р{А\ А 2 А 3 + А 1 А 2 А 3А 4 + ... + А\ Л2 • •. AfcA/i-t-i + ... |^4i} —

_ P{A{A 2Az + А 1А 2А 3А 4 + ... + А\Ач ■■•AkAk+i + • ••} _

Р{М)

Р{А\А 2А 3} + Р{А{А 2АгА4\ + ... + Р{А\Ач .. ■AkAk+\} + ...

Р{М)

2. Пусть вероятность рп того, что в семье ровно п детей, равна

оо

ар п при п > 1, и ро = 1 -

а Рк•Предположим, что все комбиk=\

нации полов п детей равновероятны. Найти вероятность того, что

в семье ровно k > 1 мальчиков.

Р е ш е н и е . Комбинации полов п детей могут быть следующими: п девочек, один мальчик и (п — 1) девочек, . . . , (лг — 1) мальчиков и одна девочка, п мальчиков, т. е. всего (п + 1) комбинаций.

По условию для любого k = 1,2, . . . , п

Р{в семье k мальчиков | в семье п детей} =

fi

1

Далее,

Р{в семье k мальчиков} =

Р {в семье (k + т) детей, из которых k мальчиков} =

=

т— О

оо

= ^ 2 (^Ч в семье k мальчиков | в семье (к + т) детей} х

т—О

х Я{в семье (k Н- т) детей}) =

ОО

.

ОО

= V

1

aDk+m =

2s k + m + 1

р ^

т= 0

т= 0

а Р

О

Р

т -0

ЬЛ-т4-\

о о р

-Е

= - V [хк+т dx =

k+m+ l

р -“ J

т= 0 о

A

м

0

Jk

0

р

а

Р

( х к~ { + Хк ~ 2 + . . . + X + 1 +

^ dx =

О

а ( xk

х к~ 1

х2

= ~ J \ T + r r -l + . . . + j +

.

|

,Д

х= р

x + \n \x-l\j

х= 0

= Q/ i i

\Р

'

1- Р

~

т

3.

Вероятность того, что в справочное бюро в течение одного

часа обратятся k человек, равна \ ke~x/k\ при некотором Л > 0.

Для каждого человека вероятность отказа по ответу на его запрос равна р. Найти вероятность того, что в течение одного часа

ровно 5 человек не получат ответа на свой запрос.

Р е ш е н и е . Введем в рассмотрение следующие события: Нт —

в течение часа в справочное бюро обратились ровно т человек,

т — 0 , 1 , 2 , . . . ; Вт — из числа обратившихся в справочное бюро

в течение часа ровно т человек получили ответ на свой запрос,

т — 0 , 1 , 2 , . . . . Тогда искомая вероятность есть

оо

P{HsBo + HS+\B\ + . . . + Hs+mB m + . . . } — ^ 2 P{Hs+mBm} —

m=0

oo

oo

\s+ m

— ^ 2 P{Bm | Hs+m}P{Hs+m} = ^

m= 0

—A

—p)mps

m= 0

o-A __ ps\ se~x ^

(s + m)\n _ )m s \'vs+me~x

(A(l - p)Y

KS^my.,

' e

= P* e

m\s\ K P> P (s + m)\

s!

^

m\

m=0

m=0

=0

Поскольку

E

x2

3

~

m

^ ==1 + v + 2_ + _ +

= ^ P _

+ + 2! + 3 ! + " ’ ^ ml

m=0

— разложение экспоненты в ряд Маклорена, то

v

2^

т= 0

(А(1~ р))т = е^О-Р)

ml

так что искомая вероятность равна

ps\ se - x дАП_р) _ ps\ se~xP

s!

s!

'

Примечание. При вычислении вероятности Р{В т | Hs+m} была

использована формула Бернулли (см. ниже, §4).

4.

При переливании крови надо учитывать группы крови донора и больного. Человеку, имеющему 4-ю группу крови, можно

перелить кровь любой группы; человеку со 2-й или 3-й группой

крови можно перелить кровь либо той же группы, либо 1-й группы; человеку с 1-й группой крови можно перелить только кровь

1-й группы. Среди населения Si = 33,7 % имеют 1-ю, S2 = 37,5 % —

2-ю, S3 = 20,9% — 3-ю и S4 = 7,9% — 4-ю группу крови. Найти

вероятность того, что случайно взятому больному можно перелить кровь случайно взятого донора.

Р е ш е н и е . Пусть событие Я,, i = 1 ,2 ,3 ,4 , состоит в том, что

у случайно взятого больного оказалась кровь г-й группы; событие А — случайно взятому больному можно перелить кровь случайно взятого донора. По формуле полной вероятности

Р {А ) = ^ Р { А \ Н 1}Р{Н,}.

1=1

Здесь P{Hi} = Si, i = 1,2,3,4, где s, = Si/ЮО. Далее, Р{А \ Нх} = si.

Действительно, если больной имеет 1-ю группу крови, то ему можно будет перелить кровь, если случайно взятый донор будет иметь

кровь 1-й группы, а вероятность этого равна sj. Аналогично,

P { A \ H 2} = s 2 + s x,

P { A \ H z} = s 3 + s h

Р { А \ Н 4} = 1.

Таким образом,

Р{А } = sisi + (s 2 + si)s2 + (s3 + si)s3 + s4 =

= sf + s| + S3 + Sl( 52 + S3) + S4 = sf + s| + Sg + 5 i (1

Sj —S4) +54 =

= s | + S3 + Sj + S4O —Si)

- 0,140625 + 0,043681 + 0,337 + 0,052377 = 0,573683.

5. В условиях задачи 4 найти вероятность того, что переливание можно осуществить, если имеются два случайно выбранных

донора.

Р е ш е н и е . Пусть А\ — событие, заключающееся в том, что

кровь можно перелить от первого донора, а Л2 — от второго. Ясно,

что Р{А\} = Р { А 2} = 0,573683 (см. задачу 4). Столь же ясно,

что события А\ и А 2 независимы, ибо выбор первого донора не

меняет статистических свойств генеральной совокупности, из которой затем выбирается и второй донор. Следовательно, искомая

вероятность

Р { А Х+ Л 2} = Р { А Х} + Р {А 2} - Р { А хА 2 } =

Р { А х} + Р { А 2 } - Р { А х} Р { А 2} =

= 1,147366 - 0,3291121 . . . = 0,8182539

6 . В стройотряде 70% первокурсников и 30% студентов второго курса. Среди первокурсников 10% девушек, а среди студентов второго курса — 5 % девушек. Все девушки по очереди дежурят на кухне. Найти вероятность того, что в случайно выбранный

день на кухне дежурит первокурсница.

Р е ш е н и е . Пусть N — общее число студентов в стройотряде.

Тогда среди них 0,7N первокурсников и 0,3,/V второкурсников.

В свою очередь, девушек среди первокурсников 0,1 • 0,7N, а среди

второкурсников 0,05 • 0,3/V. Таким образом, в стройотряде всего

0,1 • 0,7N + 0,05 • 0,3,/V девушек, из которых 0,1 • 0 ,7N первокурсниц. Следовательно, искомая вероятность равна

0,1 • 0,7N

_

0,07

_ 14

0,1 • 0 J N + 0,05 • 0,3N ~ 0,07 + 0,015 - 17'

7. Отдел технического контроля (ОТК) проводит сортировку

приборов, выпускаемых заводом. Каждый прибор независимо от

остальных имеет дефект с вероятностью р. При проверке в ОТК

наличие дефектов обнаруживается с вероятностью а , причем с вероятностью /? исправный прибор при проверке забраковывается.

Найти вероятность qo того, что незабракованный прибор имеет

дефекты, и вероятность q\ того, что забракованный прибор имеет

дефекты.

Р е ш е н и е . Пусть событие А состоит в том, что прибор имеет

дефект, а событие В — в том, что ОТК не забраковал прибор.

Тогда qo = Р{А \ В}, так что

__Р{АВ}_

Р{В\А}Р{А}

(1 - а ) р

_

Яо ~ Р{В} ~ Р { В \ А } Р { А } + Р { В \ А } Р { А } ~ ( 1 - а ) р + ( 1 - / ? ) ( 1 - р ) '

Далее, поскольку q\ = Р{А \ В}, то

_Р{АВ} _

qi ~

Р (В }

Р(В\А}Р{А}

_

ар

~ Р (В | А } Р { А } + Р ( В | А } Р { А } ~ а р + Р ( \ - р ) '

8 . Число отечественных автомобилей превышает число иномарок в 1,5 раза. При проведении технического обслуживания

(ТО) нештатные ситуации с отечественными автомобилями возникают в 2 раза чаще, чем с иномарками. При проведении ТО

с неким автомобилем возникла нештатная ситуация. Какова вероятность, что это отечественный автомобиль?

Р е ш е н и е . Пусть событие А — при проведении ТО автомобиля возникла нештатная ситуация; Н\ — ТО проводится для

отечественного автомобиля, #2 — ТО проводится для иномарки.

Тогда искомая вероятность есть условная вероятность

Р[н М 1

1 11

1

р { А \ н 1} р т

Р { А \ Н 1} Р { Н 1} + Р { А \ Н 2} Р{ Н2}'

Пусть т — число отечественных автомобилей, N — общее число

автомобилей. Тогда

/>{//,} = ^ ,

Р{Н2} = !L = ± .

По условию т = 1,5(АГ—т), откуда Р{Н{\ = 1,5(1 —Р{Н\}), или

Р{Н\} = 0,6, так что Р{Н2} = 0,4. Далее, по условию

Р { Л \ Н 1} __

Р { А | Я 2}

Следовательно,

^ ' л>= ж

р

= 0-75-

9. При рентгеновском обследовании вероятность обнаружить

заболевание туберкулезом у больного туберкулезом равна 1 —/?.

Вероятность принять здорового человека за больного равна а .

Известно, что доля больных туберкулезом по отношению ко всему

населению равна 7 . Найти вероятность того, что признанный при

обследовании больным человек на самом деле здоров.

Р е ш е н и е . Пусть событие Н\ — обследуемый человек здоров,

#2 — обследуемый человек болен, А — обследование показало, что

человек болен. Тогда искомая вероятность есть условная вероятность

рШ М 1_

Р { А \ Н 1} Р { Н 1}

_

а -( 1- 7)

1 11 } P{A\H i}P{Hl} + P{A\H 2 }P{H2} се • (1 —7) + (1 —/3) • 7

10. В 1-й урне содержатся 10 шаров, из них 8 белых; во 2-й урне — 20 шаров, из них 4 белых. Из каждой урны наудачу извлекли

по одному шару, а затем из этих двух шаров случайным образом

выбрали один. Найти вероятность того, что выбран белый шар.

Р е ш е н и е . Пусть событие А — выбран белый шар, так что

Р{А} — искомая вероятность. Пусть событие Hi — из 1-й и 2-й урн

выбраны белые шары, Я2 — их 1-й и 2-й урн выбраны не белые

шары, Яз — из одной урны выбран белый шар, а из другой — не

белый. Тогда

Р ш г - А Л

р / я г - 1 2® - л

* 4

10 20

100’

{ 2*

10 20

100’

Г>{йз} = 1 - Я { Я 1} - Р { Я 2} = 1 - А = ^ .

По формуле полной вероятности

Р{А} = Р{А | Hi }P {H x} + Р{А | Н 2 }Р{Н2} + Р{А | Я3}Р{Я3} =

16

„ 16

1 68

§ 4 . Последовательность независимых испытаний

Пусть некоторый эксперимент Е повторяется п раз. Будем интересоваться определенным событием А, связанным с Е. Пусть

Р{А}=р,

P{A} = l - p = q.

Обозначим через Pn(k) вероятность того, что в серии из п испытаний событие А произошло ровно k раз, где k — любое целое неотрицательное число. Будем считать, что наступление или

ненаступление события А в испытании происходит независимо

от других испытаний серии. Тогда вероятность того, что событие А наступит в k определенных испытаниях, а в остальных

(п — k ) испытаниях не наступит, равна pkqn~k. Значит, по теореме

сложения вероятностей искомую вероятность Pn(k) можно найти

как произведение pkqn~k на число различных способов сочетания

k появлений события А и (п — k) непоявлений среди п испытаний.

Так как число таких способов есть Ckn, то

Pn(k) = Cknpkqn- k.

Полученная формула носит название формулы Бернулли, а описанная схема независимых испытаний — схемы Бернулли.

Введем в рассмотрение функцию

■ф(х) = - = е ~ х2/ 2.

л/27г

.

Оказывается, что при больших п имеет место приближенное

равенство

р "т

к

~ ш т

-

k-np „

где х = —щ = . Точный результат приводится ниже.

Теорема 1 (локальная теорема Муавра-Лапласа). Если п —>оо,

k ->ос и \k — пр\ изменяется в интервале от 0 до Кп, где Кп —

любая неотрицательная функция от п, такая, что К \ / п 2 —> О,

то равномерно по \k — пр\

Pn(k)

lim

ti—►оо ф(х)/ y/npq

= 1,

т. е. для любого е > 0 и достаточно больших п

1 - £ < 4м>(x)/^npq

w(% = < 1 + е Эту теорему иногда называют локальной теоремой МуавраЛапласа.

Обозначим через Pn{k\ < & < &2) вероятность того, что в серии из п независимых испытаний Бернулли событие А появилось

какое-либо число раз из промежутка [6ь&2]. Тогда по теореме

сложения вероятностей несовместных событий

k=k2

Pn(k 1 < k < k2) = £ Pn(k).

k=kl

Используя теорему 1, можно получить приближение для этой вероятности. А именно, имеет место следующая теорема М уавраЛапласа (в отличие от теоремы 1 ее называют также интегральной теоремой Муавра-Лапласа).

Теорема 2 (интегральная теорема Муавра-Лапласа). Для фиксированных Z \ и Z 2

^ lim Р„(пр + zx^/npq < k < n p + Z2 yjnpq) = Ф(г2) - Ф(21),

где

X

X

Ф(х) = [ ф(t) dt = - у = [ e ~ f2/ 2 dt.

J

—00

v

27T

j

—00

Наконец, сформулируем еще один предельный результат, известный как теорема Пуассона.

Теорема 3 (теорема Пуассона). Если р —>0 при п —> оо, то

p n(k) - ^ е ~ х - О,

где А = пр.

Этот результат позволяет при больших п и малых р использовать приближенную формулу

/>„<*, и

называемую приближением Пуассона.

Задачи

1. В семье 10 детей. Считая вероятности рождения мальчика

и девочки равными 1/ 2, найти вероятность того, что в семье:

а) 5 мальчиков и 5 девочек; б) число мальчиков не менее 3 и не

более 8.

Р е ш е н и е . Ясно, что для решения задачи можно привлечь

схему Бернулли при п = 10, р = 1/2. Если под событием А (или

успехом, по общепринятой для схемы Бернулли терминологии)

понимать рождение мальчика, то

Р{в семье 5 мальчиков и 5 девочек} = Яю(5) =

=

- J 2!_ J _ - 63 ■

“ 5!5! ' 210 ~ 256’

k=8

Р{в семье мальчиков от 3 до 8} = ^ P\o(k) =

k= 3

= v r * n V ' V 0- * » . ^

^

10 \ 2/ \ 2 /

1024’

k= 3

2. Найти наиболее вероятное число успехов в серии из п испытаний Бернулли с вероятностью успеха р в одном испытании.

Р е ш е н и е . Речь идет о нахождении такого k в формуле

Бернулли

Pn(k) = Cknpkqn- k

при заданных п и р = 1 —q, при котором вероятность Pn(k) принимает наибольшее значение. С этой целью вычислим отношение

п'

pk+iqn-k-i

Pn(k + 1) _ (k + !)!(« —fe —1)!

____

Pn(k)

n!

k k

k\(n-k)\p q

_

k\(n —k)\

p_ n -k p

~ (k + \ ) \ ( n - k - \ ) \ ' q ~ k + l ' q'

Следовательно,

Pn(k + 1) > Pn(k) <*=>( n — k)p > (k + l ) q

Pn(k + 1) = Pn(k) -ФФ- k = np - q\

Pn(k -I-1) < Pn{k) & k > n p - q.

k < np — q;

Это наблюдение показывает, что вероятность Pn(k) с увеличением k сначала возрастает, затем достигает максимума и далее

убывает. При этом если пр — q является целым числом, то максимальное значение вероятность Pn(k) принимает для двух значений k\ пр — q и пр — q + 1 = пр + р. Если же пр - q не является целым числом, то максимального значения вероятности Pn{k)

достигает при k, равном наименьшему целому числу, большему

пр — q. Суммируя все сказанное, можно написать

пр - q < &Н.В. < пр + р,

(1)

где &н.в. — значение k, при котором Pn(k) принимает наибольшее

значение; при этом если пр — q — целое, то условию (1) удовлетворяют сразу два целых значения £ н.в.> которые дают одинаковое

значение Pn(k), т. е. в этом случае получаем сразу два наиболее

вероятных значения k : kH_B, = пр — q и kH,B. = пр + р.

3.

В институте обучаются 730 студентов. Вероятность того,

что день рождения наудачу взятого студента приходится на определенный день года, равна 1/365 для каждого из 365 дней. Найти

наиболее вероятное число студентов, родившихся 1 января.

Р е ш е н и е . Будем перебирать по очереди всех студентов,

и если очередной студент родился 1 января, то это событие будем

считать успехом. Тогда искомое число — это наиболее вероятное

число &н.в. успехов в серии из п = 730 испытаний Бернулли с вероятностью успеха р = 1/365 в одном испытании. Следовательно,

можно воспользоваться результатами задачи 2:

пр - q < kH.B. < пр + р,

откуда £н.в. = 2.

4.

В условиях задачи 3 найти вероятность того, что найдутся

по крайней мере три студента, родившихся 1 января.

Р е ш е н и е . Искомая вероятность

Р 7зо(3 < k < 730) = 1 - Р 7зо(0 < k < 2 ) =

= 1 - -Р7зо(0) ~ Л'ЗоО) - -Р7зо (2).

Используя приближение Пуассона

где А — пр, найдем

Л'зо(О) = е~2,

Я 730 О )

= 2е-2 ,

Я73о(2) = 2е~2,

так что искомая вероятность равна

1 - 5е-2 « 0,32.

5.

В условиях задачи 3 найти вероятность того, что найдутся

по крайней мере три студента, родившихся в один день (все равно

какой)?

Р е ш е н и е . Для решения этой задачи получим следующее

обобщение формулы Бернулли. Пусть в каждом из п испытаний

может произойти одно и только одно из k событий A i , A 2 , . .. , Л*,

испытания независимы и в каждом из них событие Л* происходит

с вероятностью р Тогда вероятность того, что в п независимых

испытаниях появятся т\ событий А\, m2 событий А 2, . . . ,

событий Ak, равна

Pn(mh m 2 , . . . , m k) = — — ^ ----- -,рТрТ • • -р Г где т\ + m 2 +'.. . + mk = п. Действительно, вероятность того, что

в mi определенных испытаниях произошло событие Л ь в т г определенных испытаниях — событие Лг, ..., в /га*, определенных испытаниях — событие Ak, равна p f ’p™2 • • -Р**- ^ Р и этом из п ис*

пытаний набор т\ можно выбрать С™1 способами, из оставшихся

(п —т\) испытаний набор m 2 можно выбрать C%im способами,

из оставшихся (п — т\ — m 2 ) испытаний набор m3 можно выбрать

числом С ™

способами, и т. д. Общее число вариантов, каждый из которых будет иметь вероятность p f ‘р^ 2 ■■■Р™к>п0 правилу произведения будет равно

/^гп\/^гп2

WW3

г> Щ -\

^ п —т\ ^ п —т \—т 2 ' * * ^ п —rri\—т^ —

т ^ -2

пт ъ

п —т \ —m 2 —

mk - \

п\

(п —ГП\)\

(п —ТП\ —m2)!

m i ! ( n — m i) !

m 2 ! ( я — m i — m 2)!

m 3 ! (гг — m \ — m 2 — m 3 )!

(п - mi - ... - mk- 2)\

x

(n - mi - ... - mk~2 - mk- 1)!

mkl0!

n\

mi!m2! .. •m^!’

что и доказывает приведенную выше обобщенную формулу Бернулли.

Вернемся к решению задачи 5. Пусть В — событие, вероятность которого нужно определить. Тогда противоположное событие В будет означать, что в каждый из 365 дней ровно у двух

студентов день рождения. Пусть событие Л*, k = 1,2, . . . , 365, состоит в том, что у случайно выбранного студента день рождения

в k-Pi день. Тогда pk = P{Ak} = 1/365 для любого k = 1, 2 , . . . , 365.

Вероятность Р{В} есть вероятность того, что в серии из п = 730

испытаний (испытание — выбор очередного студента) каждое из

событий Ak, £ = 1 , 2 , . . . , 365, произойдет ровно два раза. Значит,

по обобщенной формуле Бернулли

Используя известную приближенную формулу Стирлинга

п\ к, V 2 irnnne ” ,

получаем для Я{5} следующее приближенное значение:

-н, _ л /2 ^ 7 3 0 • 730730 • е- 730

' 1~

2365 • З65730

Ясно, что это ничтожно малое число. Следовательно, искомая

вероятность Р{В} = 1 —Р{В} практически равна единице.

6.

Предполагая все комбинации полов детей равновероятными, определить, какую долю семей с шестью детьми будут составлять семьи с тремя мальчиками и тремя девочками.

Р е ш е н и е . Рассматривая рождение ребенка как испытание

(по терминологии схемы Бернулли), а рождение мальчика как

успех, найдем вероятность того, что в семье с шестью детьми

ровно три мальчика:

т. е. в среднем на каждые 16 семей с шестью детьми будет 5 семей,

где мальчиков и девочек поровну.

7.

Найти вероятность того, что среди 13 карт, наугад выбранных из колоды в 52 карты, имеются ровно две карты красной

масти. Сравнить ее с соответствующей вероятностью для испытаний Бернулли (т. е. когда выбранная карта опять возвращается

в колоду) с р = 1/ 2.

Р е ш е н и е . По классической формуле (т.е. как отношение

числа благоприятных исходов к общему числу исходов) искомая

вероятность равна

26!

26!

_ Cl6 • С&_ 21241 11! 15! _ 5 ' 13 • 13 • 19 _ n пПопс

Р~

с£

~

52!

“ 41-43-47-49 ” ’

13! 39!

Если же считать, что выбранная карта опять возвращается

в колоду, топрименима формула Бернулли с р = 1/2 и

Л з ( 2) =

= 2Ш! ' !>TJ = ^ i r = 0 .0 ° 952 " •

8.

Какова вероятность того, что дни рождения шести человек

приходятся ровно на два месяца, оставляя десять месяцев свободными? Предполагаются независимость и равновероятность всех