ТЕОРИЯ ВЕРОЯТНОСТЕЙ И МАТЕМАТИЧЕСКАЯ СТАТИСТИКА для студентов экономического факультета

реклама

ФЕДЕРАЛЬНОЕ АГЕНТСТВО ПО ОБРАЗОВАНИЮ РФ

ФГОУ ВПО «СИБИРСКИЙ ФЕДЕРАЛЬНЫЙ УНИВЕРСИТЕТ»

Т. В. Крупкина, С. В. Бабенышев, Е. С. Кирик

ТЕОРИЯ ВЕРОЯТНОСТЕЙ

И МАТЕМАТИЧЕСКАЯ СТАТИСТИКА

для студентов экономического факультета

Учебное пособие

СФУ 2007

УДК

ББК

000.000

22.17я73

К 84

Рецензенты

Т. В. Крупкина

К 84 Теория вероятностей и математическая статистика: учебное пособие /

Т. В. Крупкина, С. В. Бабенышев, Е. С. Кирик. Сибирский федеральный университет. Красноярск: 2007. 199 с.

ISBN 0-0000-0000-0

Посвящено курсу «Теория вероятностей и математическая статистика», рассмотрены основные понятия теории вероятностей и классические статистические процедуры,

связанные с оцениванием параметров и проверкой статистических гипотез. Включает в себя теоретическую основу курса и контрольные вопросы.

Предназначено для студентов экономических направлений и специальностей.

ISBN 0-0000-0000-0

c Сибирский федеральный университет, 2007

c Т. В. Крупкина, С. В. Бабенышев, Е. С. Кирик. 2007

Принятые обозначения и сокращения.

[x] — целая часть числа x.

exp x, exp{x} — экспонента аргумента x (exp x = exp{x} = ex ).

e — основание натурального логарифма, e = 2, 718 281 828 459 . . .

A, B, . . . , X — события.

A, B, . . . X — отрицания событий A, B, . . . , X.

B ⇔ C, B ⇐⇒ C — «из B следует C и из C следует B».

∃ x — «существует x».

∀ x — «для любого x».

@ x — «не существует x».

def

= — «равно по определению».

≡ — «тождественно равно».

J — начало решения.

I — конец решения.

n, m = n, n + 1, . . . , m при том, что n, m ∈ Z и n < m.

N — множество натуральных чисел.

Z — множество целых чисел.

R — множество вещественных чисел.

R+ — множество вещественных чисел.

3

Введение

Представленное издание предназначено для обеспечения самостоятельной работы студентов экономического факультета Сибирского федерального университета по изучению теоретического материала в курсе

«Теория вероятностей и математическая статистика». Курс занимает один

семестр по 4 часа (2 часа лекций и 2 часа практических занятий) в неделю.

Структура изложения определена учебным планом: пособие содержит

18 лекций, номер параграфа пособия соответствует номеру лекции.

Модуль «Теория вероятностей» состоит из трех разделов: «1. Случайные события» (лекции 1, 2, 3, 4); «2. Одномерные случайные величины» (лекции 5, 6, 7); «3. Многомерные случайные величины» (лекции 8, 9,

10). В разделе 1 излагаются краткие сведения по истории возникновения и

развития теории вероятностей, вводятся понятия элементарного и случайного события, условной вероятности, зависимости и независимости событий, рассматриваются основные вероятностные пространства, схемы испытаний и предельные теоремы для них, выводятся простейшие формулы исчисления вероятностей. Раздел 2 посвящен распределениям случайных величин и их числовым характеристикам. Вводятся понятия непрерывных и

дискретных случайных величин, функции и плотности распределения, независимости случайных величин, математического ожидания и прочих числовых характеристик одномерной случайной величины, рассматриваются их

свойства. В разделе 3 рассматриваются характеристики связи случайных

величин. Вводятся понятия коррелированности, условных распределений,

регрессии. Выводятся формулы для нахождения характеристик связи в двумерном и многомерном случаях. Рассматриваются сходимость случайных

величин, закон больших чисел и центральная предельная теорема.

Модуль «Математическая статистика» состоит из двух разделов: «4.

Выборочный метод » (лекции 11, 12, 13,); и «5. Оценивание и проверка статистических гипотез» (лекции 14, 15, 16, 17, 18). Раздел 4 посвящен введению в математическую статистику. Рассматриваются выборочные характеристики и методы статистической обработки случайной выборки, вводятся

распределения Пирсона, Стьюдента, Фишера, излагаются сведения о распределении выборочных характеристик. В разделе 5 рассматривается точечное и интервальное оценивание параметров, вводятся понятия несмещенных, состоятельных, оптимальных и эффективных оценок, излагаются

методы получения оценок. Много внимания уделяется понятию статистической гипотезы и процедурам проверки гипотез. Рассмотриваются как общие

подходы к проверке статистической гипотезы, так и критерии проверки наиболее важных гипотез.

Все разделы пособия включают широкий набор примеров и контроль4

ных вопросов, которые позволят закрепить и углубить теоретические знания и получить навыки практического использования вероятностных методов в экономических, финансовых и социологических приложениях методов

теории вероятностей и математической статистики.

Авторы выражают глубокую благодарность А. И. Пыжеву за помощь

в подготовке пособия.

5

1. Введение в теорию вероятностей

Высшее назначение математики состоит в том, чтобы

находить скрытый порядок в хаосе, который нас окружает .

Н. Винер1

Лекция 1. Введение в теорию вероятностей

План лекции: предмет теории вероятностей, история возникновения и развития, классическое определение вероятности, некоторые формулы комбинаторики.

1.1. Предмет теории вероятностей

Предмет теории вероятностей — исследование математическими методами случайных явлений. Основные объекты теории вероятностей — случайные события, случайные величины, случайные процессы, то есть фактически весь окружающий нас мир. Теорию вероятностей используют для изучения поведения сложных систем, то есть систем, которые не допускают

полного описания. Все экономические и социальные системы являются в

этом смысле сложными. Важно понимать, что процессы формирования цен,

подъемов и спадов в экономике являются случайными процессами, так же

как уровни безработицы, доходов, курсы валют являются случайными величинами, а факт приобретения покупателем товара — случайным событием. Это не значит, что в случайном нет закономерностей — наоборот, закономерности присутствуют, но они скрыты, и именно теория вероятностей

позволяет выявить такие закономерности в экономике, которые никакими

другими методами выявлены быть не могут. «Реальность такого рода закономерностей не подлежит никакому сомнению», говорил А. Н. Колмогоров2 . Нельзя предсказать поведение отдельного человека, но можно предсказать поведение системы в целом. Например, нельзя предугадать желание человека позвонить по телефону, но теория массового обслуживания

(раздел теории вероятностей) позволяет прогнозировать количество звонков, среднее время, которое потребуется, чтобы дозвониться, и другие характеристики.

Теория вероятностей — раздел математики. Возможно, не каждому экономисту придется на практике самому оперировать сложным математическим аппаратом, но каждому требуется понимать суть экономикоматематических моделей и методов, и уметь выбирать адекватные математические модели для реальных случайных явлений экономической природы.

1

Норберт Винер (англ. Wiener Norbert; 1894—1964) — американский учёный, один из создателей кибернетики.

2

Андрей Николаевич Колмогоров (1903—1987) — великий русский математик XX века.

6

1. Введение в теорию вероятностей

Для приобретения этих профессиональных компетенций нужна серьезная

математическая подготовка, результатом которой будет овладение основными понятиями и методами теории вероятностей и математической статистики, и выработка теоретико-вероятностной интуиции, позволяющей ориентироваться в постановках задач и выбирать подходящие методы для их

решения.

Основы теории вероятностей нужно знать каждому человеку для формирования правильного мировоззрения, для осознания того, что мы живем

в случайном, вероятностном мире.

Психология человека такова, что ему неуютно среди случайностей. Он

жаждет определенности и справедливости, ищет причин и объяснений. Часто таким образом возникают суеверия: например, среди африканских племен распространено поверье о том, что бывают просто львы и львы, в которых переселились души умерших. Последние на людей не нападают. Это

объяснение не несет полезной информации, поскольку нет признаков, по

которым заранее можно было бы определить, из какой категории лев, но

оно успокаивает психологически. Точно так же появляются известные всем

суеверия при сдаче экзаменов. Некоторые суеверия, кстати, основаны на

частотных совпадениях (например, мелких неприятностей и встреч с черной

кошкой). Это относится и к приметам, которые порой подмечают вероятностные закономерности. Так, поговоркам «Беда никогда не приходит одна»

или «Жизнь, она полосатая» соответствует в теории вероятностей закон серий.

Следует помнить и то, что мы живем в мире, где происходят случайные

события, и то, что закономерности пробиваются через массу случайностей.

Чем сложнее система, тем труднее обнаружить закономерности. Именно в

этих случаях и используют вероятностные методы.

1.2. История возникновения и развития теории вероятностей

Теория вероятностей — необычайно интересная наука, и в ее истории было много замечательных событий. То, что частота выпадения шестерки для

каждой кости при большом числе бросков почти постоянна во времени, знали еще древние египтяне. Однако обнаружить, что и в событиях человеческой жизни присутствуют вероятностные закономерности, было гораздо труднее. Впервые это было замечено, видимо, при составлении таблиц

смертности. Развитие теории вероятностей как самостоятельной науки началось с середины семнадцатого столетия и связано с письмами Паскаля3

3

Блез Паскаль (фр. Blaise Pascal; 1623—1662) — французский математик, физик, философ и писатель.

7

1. Введение в теорию вероятностей

к Ферма4 в 1654 году.

Блез Паскаль был, безусловно, гением. В двенадцать лет он самостоятельно открыл геометрию Евклида, в шестнадцать был признан во Франции великим математиком, в двадцать три года изобрел вычислительную

машину. Когда врачи запретили ему заниматься умственной работой, разрешив только переписку с друзьями, он посвящал эту переписку вопросам

математики. В возрасте тридцати одного года Паскаль принял монашество

и отказался от научных занятий, но занимался литературными и философскими трудами, и считается одним из создателей французской классической

прозы. Зная, сколько сделал Паскаль в физике, математике, философии, не

верится, что он прожил всего тридцать девять лет. По преданию, через сто с

лишним лет останки Паскаля отдали алхимикам, чтобы те получили из них

философский камень.

Но вернемся в 1654 год. Это было время, богатое событиями.

В России в этом году Церковный Собор принял реформы патриарха Никона. Состоялась Переяславская Рада и произошло воссоединение

Украины с Россией. В Англии был казнен король Карл I и установлен протекторат Кромвеля. Во Франции правили кардинал Мазарини, Анна Австрийская и юный Людовик XIV — времена «Трёх мушкетеров».

В это время шевалье де Мере5 задал Паскалю два вопроса, касающихся азартных игр. Этим вопросам и посвящены письма Паскаля к Ферма.

Первая задача де Мере состояла в следующем: сколько раз надо бросить две игральные кости, чтобы вероятность выпадения двух шестерок была больше половины? С этой задачей де Мере справился, и Паскаль, обсудив его решение, признал его правильным. Вторая задача оказалась более

сложной. Два игрока играют в азартную игру до n выигрышей. Как следует разделить между ними ставку, если игра прервана, когда первый игрок

выиграл a партий, а второй b партий?

Для решения этой задачи Паскаль ввел основные понятия теории вероятностей. При этом он отчетливо сознавал, что открыл новую область науки. Это видно из письма Паскаля в Парижскую академию, где он, в частности, писал: «Это учение, объединяющее точность математических доказательств с неопределенностью случая и примиряющее эти, казалось бы,

противоречивые элементы, с полным правом может претендовать на титул

– математика случайного.»

В этом же 1654 году в семье швейцарских математиков Бернулли, в

4

Пьер Ферма (фр. Pierre de Fermat; 1601—1665) — французский математик, один из создателей теории

чисел, где с его именем связаны две знаменитые теоремы: великая теорема Ферма и малая теорема Ферма.

5

Антуан Гомбо, шевалье де Мере́ (фр. Antoine Gombaud, chevalier de Méré; 1607—1684) — французский писатель и математик.

8

1. Введение в теорию вероятностей

трех последовательных поколениях которой было восемь математиков, родился Якоб Бернулли6 .

Первая книга, посвященная теории вероятностей, была написана в

1656 году Христианом Гюйгенсом7 , знатным голландским дворянином, красавцем, пренебрегавшим развлечениями света ради физики и математики.

Она представляла из себя «рассуждение о приложении теории вероятностей к азартным играм» и содержала множество изящных и точных расчетов.

Прошло полвека. В Англии основали Гринвичскую обсерваторию,

приняли закон о гарантиях личной свободы (Habeas Corpus Act) и «Билль

о правах», заложивший основы английской конституционной монархии. В

России стал царствовать Петр I. В Европе шли войны. А Якоб Бернулли написал книгу «Искусство предположений». Важнейшая часть в ней — изложение закона больших чисел, утверждающего, что статистические характеристики, вычисленные на больших совокупностях, являются устойчивыми.

Действительно, при единичных наблюдениях проявляются индивидуальные

особенности, при массовых наблюдениях они взаимокомпенсируются и выявляется сущность процесса. Статистическая устойчивость средних была

замечена давно. Но Якоб Бернулли не только сформулировал закон больших чисел, но и выработал условия, при которых суммарное поведение достаточно большого числа случайных величин становится закономерным.

Почему-то Якоб Бернулли не торопился издавать свою книгу. Это

сделали его наследники через восемь лет после его смерти, в 1713 году. С

этого времени теория вероятностей получила прочный базис для развития.

Но он не был использован в полной мере в течение более сотни последующих лет. Вероятно, математики были слишком увлечены развитием дифференциального и интегрального исчислений.

Конечно, нельзя сказать что работы в области теории вероятностей

прекратились. Большой вклад в нее внес английский математик Абраам де

Муавр8 . В 1764 году были посмертно опубликованы работы малоизвестного английского священника Томаса Байеса9 , увековечившие его имя. Бюффон10 , расширил область применения теории, построив пример геометрической вероятности ("Игла Бюффона"). Этот пример позволял экспериментально определить число π, бросая иголку на плоскость, разграфленную

6

Якоб Бернулли (нем. Jakob Bernoulli; 1654—1705) — швейцарский математик, выходец из Голландии.

Старший из семьи швейцарских математиков Бернулли

7

Христиан Гюйгенс (Xёйгенс) (нидерл. Huygens Christian; 1629—1695) — голландский механик, физик

и математик.

8

Абрам (Абраа́м) де Муавр (фр. Abraham de Moivre; 1667—1754) — английский математик, француз по

происхождению.

9

То́мас Ба́йес (Бейес; англ. Reverend Thomas Bayes; 1702—1761) — английский математик и священник.

10

Жорж-Луи Леќлерк Бюффо́н (фр. Georges-Louis Leclerc de Buffon; 1707—1788) — французский естествоиспытатель, автор знаменитой 36-томной «Естественной истории».

9

1. Введение в теорию вероятностей

параллельными прямыми, и подсчитывая частоту пересечений иголки с ними. При проведении многочисленных лотерей и в работе страховых компаний накапливался статистический материал. Но только в XIX веке теория

вероятностей вновь привлекает внимание крупнейших современных математиков, первым из которых следует назвать Лапласа11 Пьер-Симон Лаплас в жизни был противоречивым человеком. Он родился в бедной семье

и попечительством соседей был устроен в школу Ордена Бенедиктинцев,

из которой, однако, вышел убежденным атеистом. Получив в 1771 году место профессора в Париже, он не покидал с тех пор этого города, пережив

в нем Великую Французскую революцию, эпоху Наполеона и реставрацию

Бурбонов. Вначале он был республиканцем, при Наполеоне — министром

внутренних дел. Правда, Лаплас вскоре был уволен с этого поста за то, что

«...вносил слишком много бесконечно малых в дела государства». Однако ему были предоставлены другие почетные посты и титулы. Несмотря на

это, в 1814 году он проголосовал за низложение Наполеона и стал, после

Реставрации, пэром и маркизом. Вклад Лапласа в развитие теории вероятностей весьма велик. В его труде «Аналитическая теория вероятностей»

основным аппаратом служил математический анализ. Сразу после написания (1812 г.) курьер доставил книгу императору Наполеону в Витебск, император собирался посвятить изучению этой работы первые 3 месяца после

взятия Москвы. Эта работа трижды переиздавалась еще при жизни Лапласа.

Дальнейшее развитие теории вероятностей связано с именами Гаус12

са и Пуассона13 .

Во второй половине XIX века появилась блестящая плеяда русских математиков. Ведущими среди них были П. Л. Чебышёв14 , А. А. Марков15 , А. М. Ляпунов16 Профессор Петербургского университета Пафнутий Львович Чебышев совершил в этой науке переворот, выдвинув требование абсолютной строгости формулировки и доказательств теорем теории вероятностей и получения точных оценок отклонений от предельных

закономерностей. Исследования П.Л.Чебышева продолжили его ученики

А.А.Марков и А.М.Ляпунов. Их трудами теория вероятностей стала доста11

Пьер-Симон Лаплас (фр. Pierre-Simon Laplace; 1749—1827) — французский математик, физик и астроном.

12

Карл Фридрих Гаусс (нем. Carl Friedrich Gauss; 1777—1855) — немецкий математик.

13

Симео́н-Дени́ Пуассо́н (фр. Siméon-Denis Poisson; 1781—1840) — французский физик, математик. В

теории вероятностей с именем Пуассона связано понятие распределения и процесса, носящих его имя, а

также закона больших чисел в форме Пуассона.

14

Пафнутий Львович Чебышёв (1821—1894) — величайший, наряду с Н. И. Лобачевским, русский математик XIX века. Математическая школа П. Л. Чебышёва, получившая название Петербургской, сыграла

выдающуюся роль в прогрессе математики не только в России, но и в мировом масштабе.

15

Андрей Андреевич Марков (1856—1922) — русский математик.

16

Александр Михайлович Ляпунов (1857—1918) — русский механик и математик.

10

1. Введение в теорию вероятностей

точно строгой и разработанной областью науки.

Но еще в начале XX века большинство ученых не признавало ее равноправной ветвью математики. По выражению одного из них, теория вероятностей – нечто среднее между математикой, физикой и шаманством. Причиной этого было отсутствие аксиоматического обоснования. В 1900 году на

Международном съезде математиков Гильберт17 составил список важнейших нерешенных проблем математики. Это было своеобразное завещание

XX веку. В этот список он включил проблему аксиоматического обоснования теории вероятностей.

Наиболее интересные попытки решить эту задачу предпринимались

русским математиком Бернштейном (1917) и эмигрантом из Германии Мизесом, а удалось это сделать в 1933 году русскому математику Андрею Николаевичу Колмогорову.

Система аксиоматического обоснования А.Н.Колмогорова стала общепринятой и служит твердой основой для дальнейшего развития теории

вероятностей.

1.3. Классическое определение вероятности

Рассмотрим некоторый опыт с конечным числом n взаимоисключающих

друг друга исходов, которые равновозможны. Пусть A — некоторое событие, связанное с этими исходами. Вероятность p (A) можно определить

как долю тех исходов, в результате которых это событие осуществляется:

n(A)

,

n

p (A) =

(1)

где n — число всех исходов, n(A) — число исходов, в результате которых

осуществляется событие A (благоприятных).

Пример 1.1. Какова вероятность, что при бросании игральной кости выпадет нечетное число очков?

J Рассмотрим множество всех исходов {1, 2, 3, 4, 5, 6}. Исходы несовместны и равновозможны. Обозначим через A событие, состоящее в выпадении

нечетного числа очков: A = {1, 3, 5}. Очевидно, n = 6, n(A) = 3.

p (A) =

3 1

= .

6 2

I

17

Давид Гильберт (Хильберт; нем. David Hilbert; 1862—1943) — немецкий математик.

11

1. Введение в теорию вероятностей

Определение вероятности согласно (1) называется классическим

определением вероятности. Я.Бернулли формулировал его так: «...вероятность события есть отношение числа благоприятствующих случаев к числу всех возможных случаев, все случаи предполагаются равновозможными.» Заметим, что классическое определение вероятности на самом деле не

является определением. Оно дает лишь метод вычисления вероятностей в

простейших случаях, применяемый, однако, очень часто. При вычислении

числа исходов полезны формулы комбинаторики.

1.4. Некоторые формулы комбинаторики

Ф.1. Число перестановок. Число перестановок n различных элементов

равно

Pn = n!

(2)

Пример 1.2. Карточки, на которых написано слово «ВЕРНОСТЬ»,

перемешаны. Какова вероятность, что при случайном выкладывании их в ряд получится слово «РЕВНОСТЬ»?

В Е Р Н О С Т Ь

J Исходом испытания является любая перестановка карточек. Число всех

исходов равно

n = P8 = 8!

Слово «РЕВНОСТЬ» действительно можно сложить из карточек и, очевидно, единственным способом. Поэтому n(A) = 1.

p (A) =

n(A)

1

= .

n

8!

I

Ф.2. Составные наборы Пусть имеется r групп элементов, причем iя группа содержит ni элементов; i = 1, 2, . . . , n. Число способов, которыми

можно выбрать r элементов по одному из каждой группы, равно

N = n1 · n2 · · · · · nr .

(3)

Пример 1.3. Количество посетителей сайта в день выражено трехзначным числом. Какова вероятность, что у этого числа все цифры

различны?

12

1. Введение в теорию вероятностей

J Чтобы найти общее число исходов n, надо сосчитать, сколько существует трехзначных чисел. Первую цифру можно выбрать 9 способами

(любая цифра, кроме 0), вторую цифру 10 способами (любая цифра), третью также 10 способами. По (3) общее количество трехзначных чисел равно n = 9 · 10 · 10. Для нахождения числа благоприятных исходов надо сосчитать, сколько существует трехзначных чисел, все цифры которых различны. Первую цифру можно выбрать 9 способами (любая цифра, кроме

0), вторую цифру тоже 9 способами (любая цифра, кроме первой), для третьей цифры существует 8 вариантов (любая цифра, кроме первой и второй).

По (3) количество трехзначных чисел, все цифры которых различны, равно

n(A) = 9 · 9 · 8. Тогда искомая вероятность равна

p (A) =

n(A)

9·9·8

=

= 0, 72.

n

9 · 10 · 10

I

Важное значение имеет частный случай Ф.2 при n1 = · · · = nr = n.

N = nr .

(4)

Эта формулу часто используют при повторении опытов.

Ф.3. Повторение опытов. Пусть испытание, имеющее n исходов,

независимо повторяется r раз. Число всех возможных наборов исходов

(Ai1 , Ai2 , . . . , Air ) равно

N = nr .

Пример 1.4. Три раза бросают игральную кость. Сколько различных

результатов может получиться?

J Три раза независимо повторяется испытание, имеющее 6 исходов, поэтому число всех возможных результатов равно N = 63 . I

Пример 1.5. Пусть r посетителей случайно распределяются по n отделам магазина. Какова вероятность того, что все посетители окажутся в первом отделе?

J Число исходов испытания равно n, r — число испытаний. Число всех возможных наборов исходов равно N = nr . Благоприятный исход, очевидно,

один.

n(A)

1

p (A) =

= r.

n

n

I

Следующие формулы применимы к схемам выбора. Необходимо

различать выбор с возвращением и выбор без возвращения.

13

1. Введение в теорию вероятностей

Ф.4. Выбор с возвращением. Из n различных элементов выбирают

с возвращением r элементов, то есть каждый элемент регистрируют и возвращают обратно прежде, чем выбирают следующий. Число всех возможных выборок равно

N = nr .

Замечание 1.1. Это еще одна интерпретация формулы (4). Действительно, при повторении опытов исходы выбираются с возвращением.

Две следующие формулы описывают выбор без возвращения.

Рассмотрим выбор без учета порядка: два набора номеров исходов

считаются различными, если они отличаются составом. Наборы, отличающиеся лишь порядком следования номеров, считаются одинаковыми.

Ф.5. Число сочетаний: выбор без возвращения и без учета порядка. Число способов, которыми можно выбрать m из n различных элементов,

равно

n!

Cnm =

(5)

.

m!(n − m)!

Пример 1.6. Среди шести купюр три фальшивые. Если взять случайно две купюры из шести, какова вероятность того, что обе они

фальшивые?

J Число всех исходов равно

n = C62 =

6!

= 15.

2!(6 − 2)!

Число благоприятных исходов

n(A) = C32 =

p (A) =

3!

= 3.

2!(3 − 2)!

n(A)

3

1

=

= .

n

15 5

I

Теперь рассмотрим выбор с учетом порядка: два набора номеров

исходов считаются различными, если они отличаются составом или порядком номеров.

14

1. Введение в теорию вероятностей

Ф.6. Число размещений: выбор без возвращения и с учетом порядка. Число способов, которыми можно выбрать и разместить по различным местам m из n различных элементов, равно

m

Am

n = Cn · m! =

n!

.

(n − m)!

(6)

Пример 1.7. На карточках написано слово

Ф О К У С.

Одна за другой случайно вынимают и выкладывают в ряд три карточки. Найти вероятность, что они лягут в таком порядке

С Ф У

JЧисло всех исходов равно

n = A35 =

5!

= 60.

(5 − 3)!

Число благоприятных исходов

n(A) = 1.

p (A) =

n(A)

1

= .

n

60

I

Ф.7. Число разбиений на группы.

Число способов, которыми можно разбить n различных элементов на

k групп, содержащих соответственно n1 , n2 , . . . , nk элементов, равно

N=

n!

.

n1 !n2 ! . . . nk !

(7)

Пример 1.8. 36 участников тренинга, среди которых 4 красноярца,

случайным образом делят на 4 равные группы. Найти вероятность

того, что красноярцы окажутся в разных группах.

J Число способов разбиения 36 элементов на 4 группы по 9 элементов

каждая, равно, согласно (7)

n=

36!

36!

=

.

9!9!9!9! (9!)4

15

1. Введение в теорию вероятностей

Для подсчета числа благоприятных исходов найдем отдельно число n1 (A)

способов разбиения 4 красноярцев на 4 группы по 1 красноярцу, и число

n2 (A) способов разбиения 32 человек, не являющихся красноярцами, на 4

группы по 8 человек:

n1 (A) =

4!

= 4!,

1!1!1!1!

n2 (A) =

По Ф.2

n(A) = n1 (A) · n2 (A) =

p (A) =

32!

32!

=

.

8!8!8!8! (8!)4

4! · 32!

.

(8!)4

4! · 94 · 32!

.

36!

I

Замечание 1.2. Многие задачи удобно формулировать в терминах

урновой модели: есть урна, содержащая n пронумерованных шаров

определенного состава, мы выбираем из этой урны m шаров. Например, задача «Среди шести купюр три фальшивые. Если взять случайно две купюры из шести, какова вероятность того, что обе они

фальшивые?» может быть переформулирована так: «В урне 3 белых

и 3 черных шара, из урны вынимают два шара, какова вероятность,

что оба они белые?». Очевидно, производится выбор без возвращения, и порядок не важен. Поэтому применяется формула (5).

Задача «Пусть r посетителей случайно распределяются по n

отделам магазина. Какова вероятность того, что все посетители окажутся в первом отделе?» эквивалентна задаче «Пусть r шаров случайно распределяются по n урнам. Какова вероятность того,

что все шары попадут в первую урну?». Обратите внимание, что

вторая задача отличается от первой только тем, что ее условие

сформулировано в терминах урновой модели.

1.5. Контрольные вопросы

1. Дайте определение классической вероятности.

2. Опишите урновую модель.

3. Сформулируйте в терминах урновой модели задачу: испытание

состоит в случайном выборе одной буквы из букв слова «ВЕРОЯТНОСТЬ»; необходимо найти вероятность события A =

{Вынута гласная буква, но не «Е»}.

16

2. Основные понятия теории вероятностей

4. Чему равно число всех

элементного множества?

k-элементных

подмножеств

n-

5. Чему равно число всех упорядоченных k-элементных подмножеств n-элементного множества?

6. Обоснуйте «правило суммы»: если объект a может быть выбран

m способами, а объект b — другими n способами, то выбор «либо

a, либо b» может быть осуществлен m + n способами.

7. Обоснуйте «правило произведения»: если объект a может быть

выбран m способами, а объект b можно выбрать n способами, то

выбор упорядоченной пары ha, bi может быть осуществлен m · n

способами.

8. Выведите формулы числа перестановок, числа размещений, числа сочетаний.

9. Каким числом способов можно переставить буквы слова «ЗАДАЧА»?

10. Выведите формулу числа перестановок с повторениями.

Лекция 2. Основные понятия теории вероятностей

План лекции: статистическое определение вероятности, пространство элементарных событий, операции над событиями, аксиоматическое определение вероятности, свойства вероятности,

σ-алгебры, свойство непрерывности, вероятностное пространство, классическое вероятностное пространство, геометрическое

вероятностное пространство, дискретное и непрерывное вероятностное пространство.

2.1. Статистическое определение вероятности

Определение 2.1. Пусть рассматриваемый опыт можно повторять

многократно, и пусть n — число всех повторений опыта, а n(A) —

число тех из них, в которых осуществлялось событие A. Отношение

n(A)

n называется частотой события A в данной серии испытаний.

Практика показывает,что для многих событий частота n(A)

n

при больших n мало меняется, колеблясь около некоторого постоянного значения p∗ , которое можно назвать вероятностью события

A,

n(A)

p∗ (A) =

.

(8)

n

17

2. Основные понятия теории вероятностей

2.2. Пространство элементарных событий

Будем интерпретировать случайные события как множества. Пространство элементарных событий Ω = {ω} — постулируемое понятие. Элементарные события ω интерпретируют как взаимоисключающие исходы

опыта. Случайное событие A можно рассматривать как подмножество

Ω (интерпретация: A — набор исходов, при которых оно осуществляется),

A = {ωA } ⊆ Ω.

1. Достоверное событие, наступающее при любом исходе, обозначается Ω.

2. Невозможное событие обозначается ∅.

3. A1 = A2 , если A1 ⊆ A2 и A2 ⊆ A1 .

4. A1 и A2 называются несовместными, если множества элементарных исходов {ωA1 } и {ωA2 } не пересекаются.

Пример 2.1. Кость подбрасывают 2 раза.

Ω = {i, j},

Пусть A = {i + j 6 3},

1 6 i 6 6,

B = {j = 6},

1 6 j 6 6.

C = {j четно}.

Тогда A = {(1, 1), (1, 2), (2, 1)}, B = {(i, 6)}, 1 6 i 6 6,

C = {(i, 2), (i, 4), (i, 6)},

1 6 i 6 6.

События A и B несовместны.

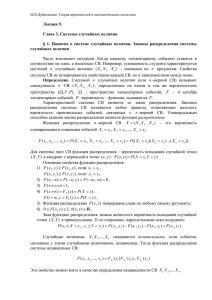

Операции над событиями

Определение 2.2. Суммой или объединением A1 , A2 называется событие A, состоящее в осуществлении хотя бы одного из A1 , A2 :

A = A1 + A2 = A1 ∪ A2 =

(закрашенная область на рис. 1).

A1

A2

Ω

Аналогично определяется A =

S

18

k

Ak .

2. Основные понятия теории вероятностей

Рис. 1. Объединение событий A1 ∪ A2

Определение 2.3. Произведением или пересечением событий A1 , A2

называется событие A, состоящее в осуществлении и A1 и A2 :

A = A1 A2 = A1 ∩ A2 ,

(закрашенная область на рис. 2).

A1

A2

Ω

Рис. 2. Пересечение событий A1 ∪ A2

Аналогично определяется

\

A=

Ak .

k

Определение 2.4. Разностью событий A1 , A2 называется событие

A, которое означает, что происходит A1 , но не происходит A2 :

A = A1 \ A2 ,

(закрашенная область на рис. 3).

A1

A2

Ω

Рис. 3. Разность событий A1 \ A2

19

2. Основные понятия теории вероятностей

Определение 2.5. Противоположным или дополнительным к событию A называется событие Ā, состоящее в том, что событие A

не происходит:

Ā = Ω \ A,

(закрашенная область на рис. 4).

A

Ā

Ω

Рис. 4. Противоположное событие Ā

Определение 2.6. Симметрической разностью событий A и B называется событие

A1 4A2 = A1 Ā2 + A2 Ā1 ,

(закрашенная область на рис. 5).

A1

A2

Ω

Рис. 5. Симметрическая разность событий A1 4A2

Пример 2.2. В условиях примера 2.1

Ω = {i, j},

A = {i + j 6 3},

1 6 i 6 6,

B = {j = 6},

20

1 6 j 6 6,

C = {j четно}.

2. Основные понятия теории вероятностей

Тогда

B + C = C,

AC = {(1, 2)},

C \ B = {(i, 2), (i, 4)},

C̄ = {(i, 1), (i, 3), (i, 5)},

1 6 i 6 6.

1 6 i 6 6.

2.3. Аксиоматическое определение вероятности

Определение 2.7. Вероятностью события называется числовая

функция p (A), удовлетворяющая аксиомам :

1. p (A) > 0.

2. p ( Ω) = 1.

3. Для непересекающихся событий {Ai } справедливо:

p(

∞

[

Ai ) =

i=1

∞

X

p (Ai ).

(9)

i=1

Аксиома 3 в 2.7 называется аксиомой счетной аддитивности.

Свойства вероятности

1. p ( ∅) = 0.

2. A ⊂ B ⇒ p (A) 6 p (B).

3. p (Ā) = 1 − p (A).

4. p (A) 6 1.

Свойства легко доказать на основе определения. Докажем, например,

свойство 2: A ⊂ B ⇒ B = A + B Ā.

События A и B Ā несовместны, так как AB Ā = ∅. По аксиоме (3)

p (A + B Ā) = p (A) + p (B Ā). По аксиоме (1) p (B Ā) > 0, следовательно

p (B) = p (A + B Ā) = p (A) + p (B Ā) > p (A).

Замечание 2.1. Если пространство элементарных событий Ω = {ω}

счетно, то

X

p (A) =

p ( ω)

(10)

ω∈A

21

2. Основные понятия теории вероятностей

и A может быть любым подмножеством Ω.

Если же Ω несчетно, не всякое подмножество Ω является событием. Здесь в качестве событий приходится выделять специальный

класс подмножеств.

σ-алгебры

Пусть F — некоторая система подмножеств множества Ω.

Определение 2.8. F называется алгеброй, если

1) Ω ∈ F,

2) A ∈ F, B ∈ F ⇒ A ∪ B ∈ F, A ∩ B ∈ F,

3) A ∈ F ⇒ A ∈ F.

Определение 2.9. F называется σ-алгеброй, если выполняются

свойства 1, 3, а свойство 2) выполняется для любых счетных последовательностей:

∗

2 ) A1 , A2 , . . . , An ∈ F ⇒

∞

[

Ai ∈ F,

i=1

∞

\

Ai ∈ F.

(11)

i=1

Таким образом, алгебра есть класс множеств, замкнутый относительно конечного числа операций дополнения, пересечения и объединения, а σалгебра — класс, замкнутый относительно счетного числа этих операций.

Рассмотрим некоторые примеры σ-алгебр.

1. {Ω, ∅}.

2. {Ω, A, Ā, ∅}, A — некоторое подмножество Ω.

3. Модель с конечным или счетным числом элементарных событий:

Ω = {ω1 , . . . , ωn },

число случайных событий равно 2n . Для каждого из этих примеров легко

проверить выполнение аксиом 1), 2∗ ), 3).

Множества из σ-алгебры F будем считать событиями. Остальные

подмножества Ω, не входящие в F, событиями не являются.

Выделение той или иной σ-алгебры обусловлено существом рассматриваемой задачи и природой множества F.

Наиболее часто используют борелевские σ-алгебры. Рассмотрим

множество B интервалов из R. Пересечение всех σ-алгебр, содержащих

B, и называется борелевской σ-алгеброй. Ее можно представить как совокупность множеств, полученных из интервалов посредством счетного числа

операций объединения, пересечения и дополнения.

22

2. Основные понятия теории вероятностей

Борелевская σ-алгебра на Ω = R1 содержит все интервалы с различными вариантами включения концов и все одноточечные множества, так как

\

1

1

{x} = {(x − , x + )}.

n

n

n

Замечание 2.2. В дальнейшем, говоря о совокупности событий, мы

будет предполагать (если противное не оговорено), что все они содержатся в одной и той же σ-алгебре F, следовательно, их счетные

объединения и пересечения тоже являются событиями.

Рассмотрим аксиоматику, введенную А.Н."Колмогоровым.

2.4. Вероятностное пространство

Определение 2.10. Вероятностным пространством называется

тройка

(Ω, F, P),

где Ω — пространство элементарных событий, F — σ-алгебра подмножеств множества Ω, P — вероятностная мера, заданная на F.

Напомним аксиоматическое определение вероятности P (2.7): вероятностью события называется числовая функция p (A), удовлетворяющая

аксиомам:

1. p (A) > 0.

2. p ( Ω) = 1.

3. Для непересекающихся событий {Ai } справедливо:

P(

∞

[

Ai ) =

i=1

∞

X

p (Ai ).

i=1

Рассмотрим в качестве примеров два важных вероятностных пространства.

Классическое вероятностное пространство

Ω = {ω1 , . . . , ωn }, исходы равновозможны;

F — совокупность всех подмножеств Ω,

p (A) =

k

kAk

= .

kΩk n

23

A = {ωi1 , . . . , ωik };

(12)

2. Основные понятия теории вероятностей

Это определение вероятности совпадает с классическим определением вероятности (1), поэтому примеры (1.1.1)–(1.1.6) по сути являются примерами использования классического вероятностного пространства.

Геометрическое вероятностное пространство

Эксперимент состоит в случайном выборе точки из ограниченного множества Ω — n-мерного евклидова пространства;

F — система подмножеств Ω, для которых имеет смысл понятие nмерного объема;

kAk

P(A) =

,

(13)

kΩk

где kAk — n-мерный объем множества A.

Рассмотрим более подробно задачи с использованием данного вероятностного пространства. При этом необходимо иметь в виду, что геометрическое определение вероятности (13) применяют только в тех случаях, когда

вероятность попадания точки в любую часть области пропорциональна мере этой части области и не зависит от ее расположения и формы.

Пример 2.3. В каждом углу квадратной площадки со стороной 12

метров посажен розовый куст, запах которого ощущается на расстоянии до 6 метров. Найти вероятность того, что посетитель,

находящийся в случайном месте этой площадки, не почувствует запах.

J Переформулируем задачу в математических терминах. Примем 12

метров за единицу. Эксперимент состоит в случайном выборе точки из квадрата [0, 1] × [0, 1]. Найти вероятность того, что точка отстоит от всех вершин

квадрата не менее, чем на 12 .

Ω — множество точек квадрата (рис. 6); F состоит из областей, для

которых имеет смысл понятие площади; A — множество точек квадрата, отстоящих от всех вершин квадрата не менее, чем на 12 (на рисунке A заштриховано).

Y

1

1

2

0

1

24

X

2. Основные понятия теории вероятностей

Рис. 6.

P(A) =

kAk SA

=

,

kΩk

SΩ

где SA — площадь области A.

SΩ = 1,

2

π

1

SA = π ·

= ,

2

4

π

p (A) = .

4

I

Пример 2.4. Известно, что два покупателя независимо обратились

к товароведу в промежуток времени с 10.20 до 10.50. Какова вероятность, что между их обращениями прошло меньше 15 минут? Если два покупателя обратились к товароведу в промежуток времени длины l минут, какова вероятность, что между их обращениями

прошло меньше 2l минут?

J Переформулируем задачу. Обозначим начальный момент времени

за A, а конечный за B. Моменты обращений покупателей к товароведу обозначим соответственно C и D. Рассмотрим задачу в общем виде.

Испытание состоит в выборе на отрезке AB длиной l двух случайных

точек: C и D, и требуется найти вероятность того, что длина отрезка CD

меньше 2l . Испытание состоит в выборе на отрезке AB длиной l двух случайных точек: C и D. Найти вероятность того, что длина отрезка CD меньше 2l .

Пусть x — длина отрезка AC, y — длина отрезка AD. Переменные

x, y могут принимать значения от 0 до l. Таким образом, можно считать, что

эксперимент состоит в случайном выборе точки из квадрата [0, l] × [0, l] и

Ω — множество точек этого квадрата. Обозначим через A описанное событие: A = {|CD| < 2l }. Запишем A с помощью введенных переменных:

A = {(x, y) : |y − x| < 2l } = {(x, y) : x − 2l < y < x + 2l }. В системе

координат XOY построим области Ω и A.

P(A) =

SA

= SA ,

SΩ

l2

3l2

SΩ = l , SA = l − =

,

4

4

3

p (A) = .

4

2

2

25

2. Основные понятия теории вероятностей

Таким образом, ответы на оба вопросы задачи совпадают: вероятность равна 3/4. I

Дискретное и непрерывное вероятностные пространства

Рассмотрим общие определения дискретного и абсолютно непрерывного

вероятностных пространств (их примерами являются соответственно классическое и геометрическое пространства).

Определение 2.11. Пусть пространство элементарных исходов Ω —

счетное множество (Ω = {ω1 , . . . , ωn . . . }) или Ω — конечное множество (Ω = {ω1 , . . . , ωn }), F — множество всех подмножеств Ω, каждому элементарному исходу P

ωi поставлено в соответствие число

p (ωi ) из отрезка [0; 1], причем p (ωi ) = 1 и

i

P(A) =

X

p (ωi ).

(14)

i: ωi ∈A

Тогда (Ω, F, P) есть дискретное вероятностное пространство.

Определение 2.12. Пусть Ω = {(x1 , x2 , . . . , xn )} — n-мерное действительное евклидово пространство, ψ(x1 , x2 , . . . , xn ) — неотрицательная функция, интегрируемая в любой квадрируемой области

из Ω и такая, что

Z

Z

. . . ψ(x1 , x2 , . . . , xn ) dx1 dx2 . . . dxn = 1.

(15)

Ω

F — σ-алгебра, порожденная квадрируемыми областями из Ω,

Z

Z

P(A) = . . . ψ(x1 , x2 , . . . , xn ) dx1 dx2 . . . dxn .

(16)

A

Тогда (Ω, F, P) есть абсолютно непрерывное вероятностное

пространство.

Рассмотрим еще одно важное свойство вероятности.

Свойство непрерывности

Теорема 2.1 (Свойство непрерывности). Если A1 ⊆ A2 ⊆ · · · ⊆ An ⊆

. . . , то

[

p ( Ak ) = lim p (An ).

(17)

k

n→∞

26

2. Основные понятия теории вероятностей

Теорема 2.2 (Эквивалентная формулировка свойства непрерывности).

Если A1 ⊇ A2 ⊇ · · · ⊇ An ⊇ . . . – монотонно убывающая последовательность событий, то

\

(18)

p ( Ak ) = lim p (An ).

k

n→∞

Этим свойством можно заменить аксиому счетной аддитивности (3) в

определении вероятности (2.7).

2.5. Контрольные вопросы

1. Дайте определение вероятностного пространства.

2. В чем состоят отличия классического вероятностного пространства от общего дискретного вероятностного пространства?

3. Сформулируйте определение классического вероятностного

пространства как частный случай определения дискретного вероятностного пространства.

4. Испытание состоит в бросании правильной игральной кости.

Постройте классическое вероятностное пространство.

5. Испытание состоит в бросании игральной кости. Укажите хотя бы два способа построить пространство элементарных событий Ω.

6. Испытание состоит в бросании игральной кости, Ω = {A, B},

где A = {1}, B = {2, 3, 4, 5, 6}. Укажите хотя бы два способа построить σ-алгебру.

7. Испытание состоит в бросании игральной кости, Ω = {A, A},

→

−

где A = {1}, σ-алгебра F = {Ω, A, A , ∅}. Укажите хотя бы три

способа задать вероятностную меру и уточните, к каким моделям будут применимы полученные вероятностные пространства (кость может быть неправильной).

8. Дайте определение геометрического вероятностного пространства.

9. В чем состоят отличия геометрического вероятностного пространства от общего непрерывного вероятностного пространства?

27

3. Исчисление вероятностей

10. Сформулируйте различия понятий «элементарное событие» и

«случайное событие».

11. Обязательно ли элементарное событие является случайным событием?

12. Может ли в некотором вероятностном пространстве число

элементарных событий быть строго больше, чем число всех событий?

13. Событие A = {Число четное}, событие B = {Число кратно 3}.

Опишите события A + B, AB, AB, A4B.

14. Обязаны ли совпадать события A и B, если B ⊆ A, A ⊆ B?

15. Верно ли равенство (A + B) \ B = A \ A B?

16. Пусть A ⊂ B. Чему равны A B и AB?

Лекция 3. Исчисление вероятностей

План лекции: независимость двух событий, независимость попарная и в совокупности, условная вероятность, теорема умножения, лемма Бореля-Кантелли, теорема сложения, формула

полной вероятности, теорема Байеса.

3.1. Независимость событий

Независимость двух событий

Определение 3.1. События A и B называются независимыми, если

p (AB) = p (A)p (B).

(19)

Пример 3.1. Вероятность сдать в сессию экзамен равна 8/9, вероятность сдать курсовую работу равна 9/10, вероятность сдать и то и

другое равна 8/11. Пусть событие A = {студент сдал экзамен}, B =

{студент сдал курсовую работу}. Являются ли эти события независимыми?

J

p (AB) = 8/11 6= p (A)p (B) = 8/9 · 9/10 = 8/10.

Следовательно, события зависимы.I

28

3. Исчисление вероятностей

Свойства независимых событий

1. Если A и B независимы, то независимы A и B̄, Ā и B, Ā и B̄.

2. Если A и B независимы, A и C независимы, BC = ∅, то независимы A и B + C.

Пример 3.2. Предположим, что в половине сдаваемых на проверку

деклараций о доходах имеются ошибки. Проверяют n деклараций,

(n > 1). Исследовать зависимость событий A и B, где

A = {Среди n деклараций не более одной с ошибками},

B = {Среди них есть как ошибочно, так и правильно заполненная}.

JПо условию вероятность того, что при заполнении отчетной формы

допущены ошибки, равна 1/2. Обозначим буквами П и Н число соответственно правильно и неправильно заполненных деклараций.

p (A) = p (Н = 0) + p (Н = 1) =

n

n+1

1

+

=

.

2n 2n

2n

Событие B означает, что среди n деклараций не менее одной с ошибками и

не менее одной правильно заполненной:

p (B) = 1 − p (B̄) = 1 − [p ( Н = 0) + p (П = 0)] = 1 −

1

1

1

−

=

1

−

,

2n 2n

2n−1

p (AB) = p (Н = 1, П > 1) = p (Н = 1).

Поскольку n > 1, то

p ( Н = 1, П > 1) = p ( Н = 1)

то есть

n

.

2n

События независимы, если p (AB) = p (A)p (B), то есть,

p (AB) = p ( Н = 1) =

1

1

n

(n + 1)( )n · (1 − ( )n−1 ) = n ,

2

2

2

n + 1 = 2n−1 ,

что верно только при n = 3.

Таким образом, события независимы при n = 3, зависимы при остальных n. I

29

3. Исчисление вероятностей

Независимость в совокупности

Определение 3.2. События A1 , . . . An называются независимыми (в

совокупности), если для всех 1 6 i1 < i2 < · · · < im 6 n, m 6 n,

p(

m

\

Aik ) =

k=1

m

Y

p (Aik ).

(20)

k=1

Замечание 3.1. Из попарной независимости событий не обязательно

следует независимость в совокупности.

Пример 3.3. Магазин проводит рекламную акцию. Каждый покупатель, заходящий в магазин, получает одну из карточек:

A B C ABC

Если на карточке есть буква A, покупатель получает скидку при покупке в секции A, и т.д. ( в магазине 3 секции, обозначенные буквами A, B, C). Исследовать, будут ли события, состоящие в получении

скидки в разных отделах а) независимы попарно; б) независимы в совокупности.

JОбозначим

A = {На выбранной карточке есть буква A“};

”

B = {На выбранной карточке есть буква B“};

”

C = {На выбранной карточке есть буква C“}.

”

1

1

p (A) = p (B) = p (C) = , p (AB) = p (AC) = p (BC) = .

2

4

p (AB) = p (A)p (B), p (AC) = p (A)p (C), p (BC) = p (B)p (C),

что означает попарную независимость событий.

Однако

1

1

p (AB) = 6= p (A)p (B)p (C) = ,

4

8

то есть события зависимы в совокупности.I

30

3. Исчисление вероятностей

Лемма Бореля-Кантелли

Эта лемма носит также название «Критерий 0 и 1». Она является частным

случаем так называемых законов нуля и единицы. Позднее мы познакомимся еще с некоторыми законами из этой большой группы теорем.

Теорема 3.1 (лемма Бореля — Кантелли).

тельность событий

A1 , A2 , . . . , An . . . ;

Если ряд

P

18

Рассмотрим последова-

pk = p (Ak ).

pk сходится, то с вероятностью 1 может произой-

k

ти лишь конечное число

P событий из последовательности событий

A1 , A2 , . . . , а если ряд

pk расходится и события A1 , A2 , . . . незавиk

симы, то с вероятностью 1 происходит бесконечное число событий

из последовательности A1 , A2 , . . . .

3.2. Условная вероятность

Определение 3.3. Условной вероятностью события A при условии,

что произошло событие B, называется отношение

p (A/B) =

p (AB)

,

p (B)

(p (B) > 0).

(21)

Пример 3.4. Для каждой из трех акций вероятность того, что ее

курс повысится, равняется 1/6. Какова вероятность того, что повысился курс всех трех акций, если повышения курсов независимы и

известно, что по крайней мере у одной акции курс повысился?

J Пусть

A = {У всех трех акций курс повысился},

B = {По крайней мере у одной акции курс повысился}.

Заметим, что A влечет B, поэтому AB = A.

p (AB)

p (A)

p (A/B) =

=

.

p (B)

p (B)

3

1

5

p (A) = 3 , p (B) = 1 −

.

6

6

1

p (A/B) = .

91

I

18

Франче́ско Па́оло Канте́лли (ит. Francesco Paolo Саntelli; 1875—1966) — итальянский математик.

31

3. Исчисление вероятностей

3.3. Теорема умножения

Теорема 3.2 (Теорема умножения). Пусть p (B) 6= 0. Тогда

(22)

p (AB) = p (A/B)p (B).

Эта теорема вытекает из определения (21). Теорему умножения можно

обобщить для n событий:

Теорема 3.3 (Теорема умножения для n событий). Пусть

p (A1 ) 6= 0, . . . , p (An−1 ) 6= 0. Тогда

p (A1 A2 . . . An ) = p (A1 )p (A2 /A1 ) . . . p (An /A1 A2 . . . An−1 ).

(23)

Доказательство. Для n = 1, 2 индуктивное предположение верно. Пусть

верно для n − 1. Обозначим

C=

n−1

\

Ai ;

A1 A2 . . . An = C ∩ An .

i=1

p (A1 A2 . . . An ) = p ( C)p (An /C) =

p (A1 )p (A2 /A1 ) . . . p (An /A1 A2 . . . An−1 ).

Замечание 3.2. Для независимых событий

p (A1 A2 . . . An ) =

n

Y

p (Aik ).

k=1

3.4. Теорема сложения

По аксиоме счетной аддитивности вероятность суммы несовместных событий равна сумме их вероятностей.

p (A1 + A2 + · · · + An ) = p (A1 ) + p (A2 ) + · · · + p (An ).

Но это соотношение справедливо лишь для несовместных событий. В случае совместных событий вероятность суммы событий можно найти с помощью теоремы сложения вероятностей. Рассмотрим вначале теорему сложения вероятностей для двух событий.

Теорема 3.4 (Теорема сложения для двух событий). Для любых событий A и B

p (A ∪ B) = p (A) + p (B) − p (AB).

(24)

32

3. Исчисление вероятностей

Доказательство.

A = A · Ω = A(B + B̄) = AB + AB̄, B = BA + B Ā,

A ∪ B = AB + AB̄ + B Ā.

Все слагаемые в правых частях несовместны, поэтому

p (A) = p (AB) + p (AB̄), p (B) = p (AB) + p ( ĀB),

p (A ∪ B) = p (AB) + p (AB̄) + p ( ĀB).

Выразим p (AB̄) и p (ĀB) из предыдущих равенств и подставим в

p (A ∪ B) :

p (A ∪ B) = p (A) + p (B) − p (AB).

Пример 3.5. Найти вероятность того, что случайно выбранное натуральное число делится на 2 или на 3.

J Пусть

A = {число делится на 2},

B = {число делится на 3}.

1 1 1 2

p (A ∪ B) = p (A) + p (B) − p (AB) = + − = .

2 3 6 3

I

Замечание 3.3. Разумеется, теорема (3.4) применима и для несовместных событий.

Пример 3.6. В урне находится 4 белых и 2 черных шара. Наугад вынимают 3 шара. Найти вероятность того, что среди них не меньше

двух белых.

J Пусть

A = {вынуто не меньше 2 белых},

B = {вынуто 2 белых, 1 черный шар},

C = {вынуто 3 белых}.

A = B + C, p (A) = p (B) + p (C) − p (BC),

но события B и C несовместны, поэтому p (BC) = 0 и

p (A) = p (B) + p (C).

33

3. Исчисление вероятностей

Число всех исходов равно

n = C63 =

6!

= 20.

3!3!

Число благоприятных исходов для B:

n(B) = C42 · C21 =

4!

· 2 = 12.

2!2!

n(B) 12

=

= 0, 6.

n

20

Число благоприятных исходов для C:

p (B) =

n(C) = C43 =

4!

= 4.

3!1!

n(C)

4

=

= 0, 2.

n

20

p (A) = p (B) + p (C) = 0, 6 + 0, 2 = 0, 8.

p (C) =

.I

Теорема сложения вероятностей легко обобщается на случай n событий.

Теорема 3.5 (Теорема сложения для n событий). Для любых событий

A1 . . . An

p(

n

[

Ai ) =

i=1

X

+

n

X

p (Ai ) −

i=1

X

p (Ai Aj )+

16i<j6n

p (Ai Aj Ak ) − · · · + (−1)n−1 p (A1 . . . An ).

(25)

16i<j<k6n

Доказательство. Для n = 1, 2 верно. Пусть верно для n − 1.

p(

n

[

Ai ) =

i=2

n

X

i=2

X

p (Ai ) −

X

p (Ai Aj ) +

26i<j6n

p (Ai Aj Ak ) − . . .

26i<j<k6n

+(−1)n−2 p (A2 . . . An ).

Применим эту формулу к A1 Ai :

p(

n

[

i=2

A1 Ai ) =

n

X

i=2

p (A1 Ai )−

X

p (A1 Ai Aj )+

26i<j6n

X

26i<j<k6n

+(−1)n−2 p (A1 . . . An ).

34

p (A1 Ai Aj Ak )−. . .

3. Исчисление вероятностей

p(

n

[

Ai ) = p (A1

i=1

n

[

Ai ) = p (A1 ) + p (

i=2

n

[

Ai ) − p (

i=2

Подставим полученные выражения для p (

n

S

Ai ) и p (

i=2

p(

n

[

n

[

Ai ) = p (A1

i=1

Ai ) = p (A1 ) + p (

i=2

=

n

X

p (Ai ) −

i=1

+

X

A1 Ai ).

i=2

n

S

A1 Ai ) в p (

i=2

n

[

Ai ) − p (

i=2

X

n

[

n

S

Ai ):

i=1

n

[

A1 Ai ) =

i=2

p (Ai Aj )+

16i<j6n

p (Ai Aj Ak ) − · · · + (−1)n−1 p (A1 . . . An ).

16i<j<k6n

3.5. Формула полной вероятности

Теорема 3.6 (Формула полной вероятности). Пусть A — случайное

событие, H1 , H2 , . . . , Hn —

несовместные случайные собыSпопарно

n

тия, p ( Hi ) > 0 и A ⊂ i=1 Hi . Тогда справедлива формула полной

вероятности:

n

X

p ( Hi )p (A/Hi ).

p (A) =

(26)

i=1

Доказательство.

Используем

аксиому аддитивности и теорему умножения.

Sn

Sn

A = A ∩ ( i=1 Hi ) = i=1 AHi .

p (A) = p (

n

[

AHi ) =

i=1

n

X

p ( Hi )p (A/Hi ).

i=1

H2

H1

H3

A

H4

35

3. Исчисление вероятностей

Рис. 7. Гипотезы Hi .

Пример 3.7. На сборку телевизоров поступают микросхемы от двух

поставщиков, причем 70% микросхем поставляет первый, а 30% —

второй. В продукции первого поставщика бракованные микросхемы

составляют 2%, в продукции второго — 3%. Какова вероятность

того, что взятая наудачу микросхема окажется бракованной?

J Пусть A = {микросхема является бракованной},

H1 = {микросхема поступила от первого поставщика},

H2 = {микросхема поступила от второго поставщика}.

p ( H1 ) = 0, 7,

p ( H2 ) = 0, 3;

p (A/H1 ) = 0, 02,

p (A/H2 ) = 0, 03.

По формуле полной вероятности

p (A) = p ( H1 )p (A/H1 ) + p ( H2 )p (A/H2 ) =

0, 7 · 0.02 + 0, 3 · 0.03 = 0, 023.

I

3.6. Формула Байеса

Теорема 3.7 (формула Байеса). Пусть

A — случайное

событие,

H1 , HS2 , . . . , Hn попарно несовместны, p ( Hi ) > 0, p (A) > 0 и

A ⊂ ni=1 Hi . Тогда справедлива формула Байеса:

p ( Hi )p (A/Hi )

p ( Hi /A) = Pn

.

i=1 p ( Hi )p (A/Hi )

(27)

Доказательство.

p (AHi ) = p (A/Hi )p ( Hi ) = p ( Hi /A)p (A) ⇒

p ( Hi /A) =

p ( Hi )p (A/Hi )

p ( Hi )p (A/Hi )

= Pn

.

p (A)

i=1 p ( Hi )p (A/Hi )

Пример 3.8. В условиях примера (3.7) взятая наудачу микросхема

оказалась бракованной. Найти вероятность того, что микросхема

поступила от первого поставщика.

36

3. Исчисление вероятностей

J По условию на сборку телевизоров поступают микросхемы от

двух поставщиков, причем 70% микросхем поставляет первый, а

30% — второй. В продукции первого поставщика бракованные микросхемы составляют 2%, в продукции второго — 3%. Пусть A =

{микросхема является бракованной},

H1 = {микросхема поступила от первого поставщика},

H2 = {микросхема поступила от второго поставщика}.

p ( H1 ) = 0, 7,

p ( H2 ) = 0, 3;

p (A/H1 ) = 0, 02,

p (A/H2 ) = 0, 03.

По формуле Байеса

p ( H1 /A) =

p ( H1 )p (A/H1 )

.

p ( H1 )p (A/H1 ) + p ( H2 )p (A/H2 )

0, 7 · 0.02

.

0, 7 · 0.02 + 0, 3 · 0.03

0, 014

.

p ( H1 /A) =

0, 023

p ( H1 /A) =

I

3.7. Контрольные вопросы

1. Может ли событие не зависеть от самого себя?

2. Независимы ли ∅ и любое событие A?

3. Независимы ли Ω и любое событие A?

4. События несовместны. Что можно сказать о их зависимости?

5. События независимы. Что можно сказать о их совместности?

6. Приведите пример, показывающий, что из попарной независимости событий не обязательно следует независимость в совокупности.

7. Сформулируйте теорему умножения для 3 событий.

8. Сформулируйте теорему умножения для независимых событий.

9. Сформулируйте эквивалентное определение независимости

двух событий, использующее условную вероятность.

37

4. Схемы испытаний

10. Сформулируйте теорему сложения для 3 событий.

11. Сформулируйте теорему сложения для несовместных событий.

12. Приведите геометрическую интерпретацию теоремы сложения для 4 событий.

13. Докажите формулу полной вероятности.

14. Сформулируйте и докажите формулу Байеса.

Лекция 4. Схемы испытаний

План лекции: независимые испытания, схема Бернулли, свойства биномиальных вероятностей, полиномиальная схема, пример зависимых испытаний, гипергеометрические вероятности,

предельные теоремы для гипергеометрических вероятностей.

4.1. Независимые испытания

Определение 4.1. Рассмотрим

испытания

S1 , S2 , . . . , Sn ,

соответствующие им вероятностные пространства

и

(Ω1 , F1 , P1 ), (Ω2 , F2 , P2 ), . . . , (Ωn , Fn , Pn ),

а также составное испытание S с вероятностным пространством

(Ω, F, P), где

Ω = Ω1 × Ω2 × · · · × Ωn ,

(элементарное событие интерпретируется как цепочка исходов в n

последовательных испытаниях); F — σ-алгебра, порожденная прямым произведением

F = F1 × F2 × · · · × Fn .

Испытания S1 , S2 , . . . , Sn независимы, если ∀A

A = A1 × A2 × · · · × An ,

Ai ∈ Fi ,

i = 1, 2, . . . , n,

справедливо

p (A) = p1 (A1 ) · p2 (A2 ) · · · · · pn (An ) =

p (A1 × Ω2 × · · · × Ωn ) · p ( Ω1 × A2 × · · · × Ωn ) · · · · · p ( Ω1 × Ω2 × . . . An ).

38

4. Схемы испытаний

4.2. Схема Бернулли

Определение 4.2. Схема n независимых испытаний называется схемой Бернулли, если:

1) испытания одинаковы;

2) каждое испытание имеет два исхода: A (успех) и Ā (неудача);

3) вероятность успеха в каждом испытании постоянна,

p (Ai ) = p,

p ( Āi ) = 1 − p = q,

i = 1, . . . , n.

Вероятность элементарного события (цепочки из n исходов, содержащей на

фиксированных местах ровно m успехов) в силу независимости испытаний

равна

p ( ω) = pm q n−m .

Теорема 4.1 (Формула Бернулли). Вероятность осуществления ровно m успехов в n испытаниях равна

pn (m) = Cnm pm q n−m .

(28)

Доказательство. Пусть A есть множество цепочек из n исходов, содержащих на произвольных местах ровно m успехов. Вероятность p (A) в силу

аддитивности равна

X

p (A) = pn (m) =

p ( ω) = Cnm pm q n−m , m = 0, 1, . . . , n.

ω∈A

Пример 4.1. В семье 6 детей. Найти вероятность того, что среди

этих детей: а) 2 мальчика; б) не более 2 мальчиков; в) более 2 мальчиков; г) не менее 2 и не более 3 мальчиков. Вероятность рождения

мальчика принять равной 0,515.

J Применим формулу Бернулли при n = 6, p = 0, 515, q = 0, 485: а) p6 (2) =

C62 (0, 515)2 (0, 485)4 ≈ 0, 22;

б)

p ( m 6 2) = p6 (0) + p6 (1) + p6 (2) =

(0, 485)6 + C61 (0, 515)1 (0, 485)5 + C62 (0, 515)2 (0, 485)4 ≈ 0, 313;

в) p ( m > 2) = 1 − p ( m 6 2) ≈ 0, 687;

г) (p ( 2 6 m 6 3) = p6 (2) + p6 (3) ≈ 0, 530. I

39

4. Схемы испытаний

Свойства схемы Бернулли

1. Проверим, что p ( Ω) = 1.

p ( Ω) =

X

p ( ω) =

X

m n−m

p q

=

2.

pn (m)

pn (m − 1)

Cnm pm q n−m = (p + q)n = 1.

m=0

ω∈Ω

ω∈Ω

n

X

=

< 1, m > np + p

= 1, m = np + p

> 1, m < np + p.

Доказательство.

pn (m)

Cnm pm q n−m

n!(m − 1)!(n − m + 1)! p (n − m + 1)p

= m−1 m−1 n−m+1 =

=

=

pn (m − 1) Cn p

q

m!(n − m)!n!

q

mq

< 1, m > np + p

=

= 1, m = np + p

> 1, m < np + p.

3. Наивероятнейшее число успехов m0 : pn (m0 ) = maxm pn (m).

np + p, np + p − 1 при целом np + p,

m0 =

(29)

[np + p] при нецелом np + p.

Пример 4.2. В семье 6 детей. Считая, что вероятность рождения

мальчика равна 0,515, найти наивероятнейшее число мальчиков в семье.

J Число np+p = 6·0, 515+0, 515 = 3, 605 не является целым. Поэтому

m0 = [np + p] = [3, 605] = 3. I

4.3. Полиномиальная схема

Определение 4.3. Схема n независимых испытаний называется полиномиальной схемой, если:

1) испытания одинаковы;

Sk

2) каждое испытание имеет k исходов A1 , . . . , Ak ,

i=1 Ai = Ω;

любого исхода в каждомPиспытании постоянP3)

Pвероятность

k

l

на,

p (Ai ) = pi , l = 1, . . . , n, i = 1, . . . , k,

i=1 pi = 1.

40

4. Схемы испытаний

Найдем

pn (m1 , . . . , mk ) =

p{A1 произошло m1 раз , . . . , Ak произошло mk раз },

k

X

mi = n.

i=1

Аналогично (28)

pn (m1 , . . . , mk ) =

k

X

n!

mk

1 m2

pm

1 p2 . . . pk ,

m1 !m2 ! . . . mk !

k

X

pi = 1,

i=1

(30)

mi = n.

i=1

Пример 4.3. 80 % студентов сдают экзамен с первого раза, 17% —

со второго раза и 3% отчисляются из университета как не сдавшие

экзамен. Трое студентов пришли впервые сдавать экзамен. Какова

вероятность того, что среди них имеется хотя бы один, который

сдаст экзамен с первого раза, и хотя бы один, который сдаст экзамен со второго раза?

J Будем записывать событие {a студентов сдают экзамен с первого раза,

b — со второго раза и c отчисляются из университета как не сдавшие экзамен} в виде (a, b, c). Данным испытаниям соответствует полиномиальная

схема, так как выполняются условия определения (30). При этом

p1 = 0, 8,

p2 = 0, 17,

p3 = 0, 03.

Событию, вероятность которого надо найти, благоприятствуют исходы

(1, 1, 1), (1, 2, 0), (2, 1, 0).

По (30)

p=

3!

3!

3!

· 0, 8 · 0, 17 · 0, 03 +

· 0, 8 · (0, 17)2 +

· (0, 8)2 · 0, 17

1!1!1!

1!2!0!

2!1!0!

= 0, 42024 ≈ 0, 42

I

41

4. Схемы испытаний

Пример зависимых испытаний. Гипергеометрические вероятности

Пусть из совокупности n предметов, среди которых n1 предметов первого

вида и n2 предметов второго вида (n1 + n2 = n) производится выборка без

возвращения m предметов, 1 6 m 6 n. Вероятность того, что в выборке будет m1 предметов первого вида и m2 предметов второго вида (m1 +m2 = m),

согласно классическому определению вероятности (1), выражается формулой

Cnm11 Cnm22

pn1 ,n (m1 , m) =

(31)

.

Cnm

Данные испытания, очевидно, являются зависимыми. Пример легко

обобщается на случай m видов предметов, в результате получаются многомерные гипергеометрические вероятности.

Предельные теоремы для гипергеометрических вероятностей

Теорема 4.2. Пусть n → ∞ и n1 → ∞ так , что

Тогда

pn1 ,n (m1 , m) → pm (m1 ).

Доказательство.

n1

n

→ p,

0 6 p 6 1.

(32)

Cnm11 Cnm22

=

pn1 ,n (m1 , m) =

Cnm

m!(n − m)!

n1 !

n2 !

=

n!

m1 !(n1 − m1 )! m2 !(n2 − m2 )!

m! nn1 ( nn1 − n1 ) . . . ( nn1 − m1n−1 ) nn2 ( nn2 − n1 ) . . . ( nn2 −

n n

1

n

m−1

m1 !m2 !

n(n − n) . . . (n − n )

→

m!

pm1 (1 − p)m2 = pm (m1 ).

m1 !m2 !

m2 −1

n )

Смысл этой теоремы в том, что (при указанных условиях) гипергеометрические вероятности стремятся к биномиальным вероятностям. Многомерный аналог данной теоремы утверждает, что (при аналогичных условиях) многомерные гипергеометрические вероятности стремятся к полиномиальным вероятностям.

Рассмотрим предельные теоремы для схемы Бернулли.

42

4. Схемы испытаний

4.4. Теорема Пуассона

При числе испытаний, превышающем 20, вычисление точного значения

pn (m) затруднительно из-за расчетов факториалов и степеней. В этих случаях применяют приближенные формулы, вытекающие из соответствующих

предельных теорем. Различают два случая: когда p мало, используют приближение Пуассона, а когда p не мало (и не очень близко к единице), справедливо приближение Муавра — Лапласа. Существует область, в которой

возможно применение обоих приближений.

Теорема 4.3 (Теорема Пуассона). Если n → ∞, p → 0 так, что np →

λ, 0 < λ < ∞, то для любого фиксированного m ∈ N справедливо:

pn (m) = Cnm pm q n−m → pλ (m) =

λm e−λ

.

m!

(33)

Доказательство. Пусть np = λn . Тогда

m n−m

n!

λ

λ

n

n

pn (m) = Cnm pm q n−m =

1−

=

m!(n − m)! n

n

m n−m

n(n − 1) . . . (n − m + 1) λn

λn

1−

=

m!

n

n

n −m

λn

1

2

m−1

λn

λm

n

1−

1−

1−

... 1 −

1−

.

m!

n

n

n

n

n

При n → ∞, λn = np → λ,

n

λn

1

−λ

1−

→e ,

1−

→ 1,

n

n

−m

2

m−1

λn

1−

→ 1, . . . , 1 −

→ 1,

1−

→ 1.

n

n

n

Следовательно,

λm e−λ

pn (m) → pλ (m) =

.

m!

Приближенная формула Пуассона

λm e−λ

pn (m) ≈ pλ (m) =

,

m!

(34)

где λ = np. Приближенную формулу Пуассона применяют при n >

30, p < 0, 1, 0, 1 < λ = np < 10.

43

4. Схемы испытаний

Пример 4.4 (Задача о днях рождения). Какова вероятность, что

среди 500 случайно выбранных людей ни один не родился 1 января?

J По формуле Бернулли

0

p500 (0) = C500

p0 q 500 =

364

365

500

≈ 0, 2537 ≈ 0, 254.

По приближенной формуле Пуассона

λ = np = 500 ×

1

≈ 1, 3699

365

λ0 e−λ

p500 (0) =

≈ e−1,3699 ≈ 0, 2541 ≈ 0, 254.

0!

I Ответ, полученный по формуле Бернулли, более точен, но его получение

затруднительно. Как видим, формула Пуассона в этом примере дает приближенное значение с тремя верными знаками после запятой.

4.5. Локальная предельная теорема Муавра — Лапласа

Теорема 4.4. Если при n → ∞ и постоянном p, не равном 0 или 1, ве√

личина xm = m−np

npq ограничена так, что −∞ < a 6 xm 6 b < +∞,

то

ϕ(xm )

1

,

(35)

pn (m) = √

1+O √

npq

n

2

где ϕ(x) =

x

√1 e− 2

2π

.

Доказательство этой теоремы основано на применении формулы

Стирлинга:

√

1

n −n

n! = n e

2πneO( n ) .

(36)

Из нее вытекает удобная для применения асимптотическая формула.

Локальная приближенная формула Муавра — Лапласа

pn (m) ≈

xm =

ϕ(xm )

√

npq ,

m−np

√

npq .

(37)

Локальную приближенную формулу Муавра — Лапласа применяют при

n > 30, 0.1 6 p 6 0.9, npq > 9.

44

4. Схемы испытаний

4.6. Интегральная предельная теорема Муавра — Лапласа

Теорема 4.5. При n → ∞ и постоянном p, не равном 0 или 1,

Z x2

x2

m − np

1

lim p ( x1 6 √

6 x2 ) = √

e− 2 dx = Φ(x2 ) − Φ(x1 ),

n→∞

npq

2π x1

где

x

Z

1

Φ(x) = √

2π

Z

2

e

− t2

x

dt =

−∞

ϕ(t) dt.

(38)

−∞

Доказательство.

m − np

√

√

6 x2 ) = p ( x1 npq + np 6 m 6 x2 npq + np) =

p ( x1 6 √

npq

√

x2 npq+np

X

=

pn (m) =

√

m−np

√

npq .

pn (m),

m: xm =x1

m=x1 npq+np

где xm =

xX

m =x2

По локальной предельной теореме (35)

xm =x2

x2

1

1 X

m

e− 2 √

(1 + αn ) = In + An .

pn (m) = √

npq

2π

xm =x1

xm =x1

xX

m =x2

(39)

xm =x2

x2

X

x2

1 X

1

1

− 2m

In = √

=

.

e

ϕ(xm ) √

√

npq x =x

npq

2π xm =x1

m

1

Поскольку

m − np

xm = √

,

npq

4xm =

и

In =

m + 1 − np m − np

1

− √

=√

,

√

npq

npq

npq

xX

m =x2

ϕ(xm )4xm ,

xm =x1

что представляет из себя (с точностью до двух слагаемых) интегральную

сумму для интеграла

Z x2

ϕ(x) dx.

x1

Рассмотрим второе слагаемое в (39).

An =

xX

m =x2

ϕ(xm )4xm αn ,

xm =x1

45

4. Схемы испытаний

|An | 6

xX

m =x2

xm =x1

При n → ∞

An → 0

C

ϕ(xm )4xm |αn | 6 √ In .

n

и

m − np

6 x2 ) = lim (In + An ) =

lim p ( x1 6 √

n→∞

n→∞

npq

Z x2

Z x2

x2

1

=

ϕ(x) dx = √

e− 2 dx = Φ(x2 ) − Φ(x1 ).

2π x1

x1

Замечание 4.1. Погрешность имеет порядок O( √1n ). Можно устано1

) не может быть улучшен.

вить, что порядок O( √npq

Интегральная приближённая формула Муавра — Лапласа

m − np

p ( x1 6 √

6 x2 ) ≈ Φ(x2 ) − Φ(x1 ).

npq

(40)

Интегральную приближённую формулу Муавра — Лапласа применяют при

n > 30,

0.1 6 p 6 0.9,

npq > 9.

Следствия интегральной приближённой формулы

Следствие 1.

b − np

p ( a 6 m 6 b) ≈ Φ √

npq

a − np

−Φ √

.

npq

(41)

Следствие 2.

r r m

n

n

p ( α1 6

6 α2 ) ≈ Φ (α2 − p)

− Φ (α1 − p)

.

n

pq

pq

(42)

Следствие 3.

r r m

n

n

− p 6 β2 ) ≈ Φ β2

p ( β1 6

− Φ β1

.

n

pq

pq

(43)

Пример 4.5. Вероятность рождения мальчика равна p = 0, 512. Найти вероятность того, что в группе из 10000 новорождённых число

мальчиков превысит число девочек по крайней мере на 200.

46

4. Схемы испытаний

J n = 10000, p = 0, 512, q = 0, 488, np = 5120, npq ≈ 2500.

p ( m > 5100) = p ( 5100 6 m 6 10000) ≈

5100 − 5120

10000 − 5120

√

√

−Φ

Φ

2500

2500

≈ Φ(100) − Φ(−0, 4) ≈ 0, 6554.

I

Пример 4.6. Вероятность появления события в каждом из 9000

независимых испытаний равна 0,85. Найти такое положительное

число ε, чтобы с вероятностью 0, 96 абсолютная величина отклонения относительной частоты появления события от его вероятности не превышала бы ε.

J По условию n = 9000, p = 0, 85. Воспользуемся следствием 3 интегральной приближенной формулы:

r r m

n

n

p ( | − p| 6 ε) ≈ Φ ε

− Φ −ε

=

n

pq

pq

r n

2Φ ε

− 1 = 0, 96.

pq

r n

Φ ε

= 0, 98.

pq

По таблице значений функции Φ(x) находим приближенное значение аргумента, при котором функция принимает значение 0,98: Φ(2, 1) ≈ 0, 98. Решаем уравнение

r

9000

ε

= 2, 1.

0, 85 · 0, 15

ε ≈ 7, 53 · 10−3 .

I

Замечание 4.2. При небольших npq формулы (41)–(43) заменяют на

(44)–( 4.6):

1∗ .

b − np + 0.5

p ( a 6 m 6 b) ≈ Φ

√

npq

47

a − np − 0.5

−Φ

.

√

npq

(44)

4. Схемы испытаний

2∗ .

m

p ( α1 6

6 α2 ) ≈

n

r

r

n

1

n

1

Φ (α2 − p)

+ √

− Φ (α1 − p)

− √

.

pq 2 npq

pq 2 npq

3∗ .

m

− p 6 β2 ) ≈

n

r

r

1

1

n

n

Φ β2

+ √

− Φ β1

− √

.

pq 2 npq

pq 2 npq

(45)

p ( β1 6

(46)

Пример 4.7. К электросети подключено 100 приборов, каждый из которых имеет мощность 2 квт и потребляет в данный момент энергию с вероятностью 0,2. Найти вероятность того, что потребляемая в данный момент мощность не превышает 50 квт.

J n = 100, p = 0, 2, q = 0, 8, np = 20, npq = 16. Пусть x — потребляемая мощность, m — число работающих приборов.

p ( x 6 50) = p ( m 6 25) = p ( 0 6 m 6 25) ≈

25 − 20 + 0.5

0 − 20 − 0.5

Φ( √

) − Φ( √

)=

100 · 0, 2 · 0, 8

100 · 0, 2 · 0, 8

Φ(1, 375) − Φ(−5, 125) ≈ 0, 915.

I

4.7. Свойства функций ϕ(x), Φ(x), Φ0 (x)

x2

Свойства функции ϕ(x) = √12π e− 2

(плотность стандартного нормального распределения)

1. ϕ(−x) = ϕ(x).

2. ϕ(0) = √12π ≈ 0, 3989.

3. ϕ(x) → 0 при x → ±∞, ϕ(±4) < 0, 001.

ϕ(x)

x

0

48

4. Схемы испытаний

Рис. 8. График ϕ(x)

2

Rx

Свойства функции Φ(x) =

dt

=

e

−∞ ϕ(t) dt

−∞

(функция стандартного нормального распределения).

1. Φ(x) + Φ(−x) = 1.

2. Φ(x) → 1 при x → ∞, Φ(3, 8) > 0, 9999.

3. Φ(x) → 0 при x → −∞, Φ(−3, 8) < 0, 0001.

4. Φ(0) = 1/2.

R x t2

Rx

Свойства функции Φ0 (x) = √12π 0 e− 2 dt = 0 ϕ(t) dt

(функция Лапласа).

√1

2π

Rx

− t2

1. Φ0 (−x) = −Φ0 (x).

2. Φ0 (x) → 21 при x → ∞.

3. Φ0 (x) → − 21 при x → −∞.

4. Φ0 (0) = 0.

4.8. Контрольные вопросы

1. Докажите формулу Бернулли.

2. Применима ли формула Бернулли, если вероятность успеха имеет различные значения в разных опытах?

3. Каким образом с помощью формулы Бернулли можно найти вероятность хотя бы одного появления события?

4. Каким образом в схеме Бернулли можно найти вероятность появления успеха не меньше данного числа раз?

5. Приведите пример испытаний, описываемых гипергеометрической схемой и укажите параметры этой схемы.

6. Приведите пример гипергеометрической схемы испытаний, которая может быть приближенно описана схемой Бернулли.

7. Каким образом с помощью формулы Пуассона можно найти вероятность хотя бы одного появления события?

8. Каким образом с помощью формулы Пуассона можно найти вероятность появления успеха не меньше данного числа раз?

9. Найдите наивероятнейшее число успехов в схеме Пуассона с параметром λ.

49

5. Функции распределения. Дискретные случайные величины

10. Приведите пример испытаний, описываемых схемой Пуассона.

11. Приведите пример схемы испытаний Бернулли, которая может

быть приближенно описана схемой Пуассона.

12. Приведите пример схемы испытаний Бернулли, которая может

быть приближенно описана схемой Муавра — Лапласа.

13. Каким образом с помощью формул Муавра — Лапласа можно

найти вероятность появления успеха ровно m раз?