ТЕОРИЯ ВЕРОЯТНОСТЕЙ, МАТЕМАТИЧЕСКАЯ СТАТИСТИКА И

реклама

ФЕДЕРАЛЬНОЕ АГЕНТСТВО СВЯЗИ РФ

ГОУ ВПО «ПОВОЛЖСКАЯ ГОСУДАРСТВЕННАЯ

АКАДЕМИЯ ТЕЛЕКОММУНИКАЦИЙ

И ИНФОРМАТИКИ»

В.Н. ТАРАСОВ, Н.Ф. БАХАРЕВА

ТЕОРИЯ ВЕРОЯТНОСТЕЙ,

МАТЕМАТИЧЕСКАЯ СТАТИСТИКА

И СЛУЧАЙНЫЕ ПРОЦЕССЫ

ИЗДАНИЕ ВТОРОЕ,

ПЕРЕРАБОТАННОЕ

Рекомендуется ГОУ ВПО МГТУ

им. Н.Э. Баумана к использованию

в образовательных учреждениях,

реализующих

образовательные

программы

ВПО

по

специальностям

направления

«Информатика и вычислительная

техника».

Самара 2008

ББК 22.17я73

Т 19

УДК 519.2(075.8)

Рецензенты:

Заведующий

кафедрой

информационных

систем

и

технологий Самарского государственного аэрокосмического

университета, заслуженный работник высшей школы РФ,

Академик международной академии информатизации, д.т.н.,

профессор С.А. Прохоров;

д.ф.-м.н., профессор кафедры «Высшая математика»

МГТУ им. Н.Э.Баумана А.В. Филиновский.

Тарасов В.Н., Бахарева Н.Ф.

T 19 Теория вероятностей, математическая статистика и

случайные процессы.– Оренбург:ИПК ОГУ, 2008 –

280 с.

ISBN 5-7410-0415-6

Учебное пособие предназначено для студентов

специальностей направления 230100 – Информатика и

вычислительная техника.

ББК 22.17я73

ISBN 5-7410-0415-6

©Тарасов В.Н., Бахарева Н.Ф.

СОДЕРЖАНИЕ

1

1.1

1.2

1.3

1.4

1.5

1.6

1.7

1.8

1.9

1.10

1.11

1.12

1.13

1.14

1.15

2

2.1

2.2

2.3

2.4

2.4.1

2.4.2

2.4.3

2.5

2.5.1

2.5.2

2.5.3

2.5.4

2.5.5

Введение

Основные понятия теории вероятностей

Испытания и события

Классическое определение вероятности

Статистическое определение вероятности

Геометрические вероятности

События и действия над ними

Аксиоматическое определение вероятности

Основные теоремы теории вероятностей

Формула полной вероятности

Формула Бейеса

Повторение испытаний. Формула Бернулли

Локальная формула Муавра−Лапласа

Интегральная формула Муавра−Лапласа

Формула Пуассона

Простейший поток событий

Задание №1 на самостоятельную работу. Решение типовых задач

Одномерные случайные величины. Законы распределения вероятностей случайных величин

Случайные величины

Функция распределения вероятностей случайной

величины

Плотность распределения вероятностей непрерывной случайной величины

Примеры дискретных распределений вероятностей

Биномиальное распределение

Распределение Пуассона

Геометрическое распределение

Примеры непрерывных распределений

Закон равномерного распределения вероятностей

Нормальный закон распределения

Экспоненциальный закон распределения

Распределение Вейбулла

Гамма – распределение

7

9

9

10

10

11

12

14

15

18

19

20

21

21

23

23

25

31

31

32

34

37

37

38

38

39

39

41

43

45

46

3

2.6

3

3.1

3.2

3.3

3.4

4

4.1

4.2

4.3

4.4

4.5

4.6

4.7

4.8

4.9

5

5.1

5.2

5.3

5.4

5.5

5.6

6

6.1

6.2

6.3

6.4

4

Задание №2 на самостоятельную работу. Решение типовых задач

Числовые характеристики случайных величин

Математическое ожидание случайной величины

Свойства математического ожидания

Дисперсия случайной величины. Моменты высших порядков

Задание №3 на самостоятельную работу

Многомерные случайные величины

Многомерная случайная величина. Совместная

функция распределения

Дискретные двумерные случайные величины

Непрерывные двумерные случайные величины

Условные законы распределения компонент двумерной случайной величины

Условные числовые характеристики

Зависимые и независимые случайные величины

Числовые характеристики двумерной случайной

величины. Ковариация и коэффициент корреляции

Многомерное нормальное распределение

Задание №4 на самостоятельную работу

Функции от случайных величин. Числовые характеристики и законы распределения

Примеры функциональной зависимости между

случайными величинами

Функции от одномерной случайной величины

Функции от случайного векторного аргумента

Математическое ожидание функции от случайной величины

Дисперсия функции от случайной величины

Задание №5 на самостоятельную работу

Предельные теоремы теории вероятностей

Закон больших чисел и центральная предельная

теорема

Неравенство Чебышева

Закон больших чисел (теорема Чебышева)

Обобщенная теорема Чебышева. Теоремы Маркова и Бернулли

47

51

51

54

56

62

65

65

66

68

69

71

74

75

80

81

87

87

88

90

92

94

95

100

100

100

102

103

6.5

Понятие о

теореме Ляпунова. Формулировка

центральной предельной теоремы

6.6

Задание № 6 на самостоятельную работу

7

Элементы математической статистики

7.1

Основные задачи математической статистики

7.2

Статистическая совокупность и статистическая

функция распределения

7.3

Гистограммы

7.4

Числовые характеристики статистического распределения

7.5

Критерии согласия

7.6

Статистические оценки для неизвестных параметров распределения

7.7

Оценки для математического ожидания и дисперсии

7.8

Доверительный интервал и доверительная вероятность

7.9

Связь между доверительным интервалом и проверкой гипотез о среднем значении

7.10 Оценка неизвестной вероятности по частоте

7.11 Точечные оценки для числовых характеристик

многомерных случайных величин

7.12 Задание №7 на самостоятельную работу

8

Основные понятия теории случайных процессов

8.1

Определение случайного процесса. Классификация случайных процессов

8.2

Законы распределения и основные характеристики случайных процессов

8.3

Канонические разложения случайных процессов

8.4

Характеристики стационарных случайных процессов

8.5

Спектральное разложение стационарного случайного процесса

8.6

Классификация и определение марковских процессов

8.6.1 Дискретный марковский процесс

8.6.2 Непрерывный марковский процесс. Уравнение

Фоккера – Планка – Колмогорова

106

108

114

114

115

118

120

126

137

140

142

148

152

155

160

164

166

169

180

183

195

201

203

208

5

8.6.3 Диффузионное приближение систем массового

обслуживания

8.6.4 Обобщенная двумерная диффузионная модель

систем массового обслуживания типа GI/G/1/∞ с

бесконечной очередью и GI/G/1/m с конечной

очередью и потерями

9

Моделирование случайных величин, процессов и

потоков событий

9.1

Генерирование и статистический анализ псевдослучайных чисел

9.2

Моделирование непрерывных случайных величин

9.3

Задание №8 на самостоятельную работу

9.4

Содержание отчёта

9.5

Аппроксимация законов распределения

9.5.1 Задача сглаживания статистических рядов. Теоретические основы лабораторной работы

9.5.2 Задание №9 на самостоятельную работу

9.5.3 Содержание отчёта

9.6

Аппроксимация корреляционных функций и

спектральных плотностей ортогональными функциями Лагерра

9.6.1 Теоретические основы лабораторной работы

9.6.2 Задание №10 на самостоятельную работу

9.6.3 Содержание отчёта

Список использованной литературы

Приложение

6

216

220

230

230

232

239

239

246

246

251

252

258

258

267

267

271

272

ВВЕДЕНИЕ

1. Предмет теории вероятностей. Теория вероятностей

есть математическая наука, изучающая закономерности в

массовых однородных случайных явлениях (событиях).

Случайное явление – это такое явление, которое при неоднократном воспроизведении одного и того же опыта протекает каждый раз несколько по иному. В качестве примера

рассмотрим стрельбу из орудия, установленного под заданным углом Θ 0 к горизонту, начальной скоростью V 0 и баллистическим коэффициентом снаряда С. Используя эти параметры можно определить теоретическую траекторию

снаряда. При многократном повторении этого опыта фактически получится пучок траекторий за счет совокупного

влияния многих случайных факторов, таких как: отклонение веса заряда снаряда от номинала, ошибки установки

ствола в заданное положение, метеорологические условия и

т.д.

Такие случайные отклонения неизбежно сопутствуют

любому закономерному явлению. Методы теории вероятностей по природе приспособлены для исследования массовых случайных явлений и дают возможность предсказать

средний суммарный результат массы однородных случайных явлений. При этом они не дают возможность предсказать исход отдельного случайного явления.

Практика показывает, что, наблюдая в совокупности

массы однородных случайных явлений, можно обнаружить

в них определенные закономерности (свойство устойчивости). Например, при многократном бросании монеты частота появления герба (отношение числа выпавших гербов к

общему числу бросаний) приближается к определенному

числу 1/2.

Методы теории вероятностей широко применяются в

различных областях науки и техники, таких как: теория надежности, теория массового обслуживания, теоретическая

физика, теория связи и во многих других теоретических и

прикладных науках.

В этом учебном пособии многие вопросы теории вероятностей, статистики и случайных процессов рассмотрены

7

с точки зрения вероятностного и статистического моделирования.

2. Краткая историческая справка. Систематическое

исследование задач, связанных с массовыми случайными

явлениями можно найти в начале XVII века у знаменитого

физика Галилея. Он анализировал ошибки физических измерений, рассматривал их как случайные и оценивал их вероятности.

Однако первые работы, в которых зарождались основные понятия теории вероятностей, представляли собой попытки создания теории азартных игр (Кардано, Гюйгенс,

Паскаль, Ферма и др. в XVI- XVII вв.). Само слово азарт

(фр. «le hasard») означает случай.

Следующий этап развития теории вероятностей связан с

именем Я.Бернулли (1654-1705), которому принадлежит доказательство так называемого закона больших чисел, установление связи между вероятностью события и частотой

его появления.

Дальнейшее развитие теории вероятностей связано с

именами Муавра (1667-1754), Лапласа (1749-1827), Гаусса

(1777-1855), Пуассона (1781-1840) и др. Стройной математической наукой теория вероятностей стала с работами

П.Л.Чебышева (1821-1894) и его учеников А.А. Маркова

(1856-1922) и А.М. Ляпунова (1857-1918) – ученых Петербургской математической школы. Дальнейшее развитие

теории вероятностей и математической статистики связано

с именами русских математиков (С.Н. Бернштейн, В.И. Романовский, А.Н. Колмогоров, А.Я. Хинчин, Б.В. Гнеденко,

Н.В. Смирнов и др.). Из зарубежных математиков в области

случайных процессов особо следует выделить Н. Винера,

В. Феллера, Д. Дуба, а в теории вероятностей и математической статистике – Р.Фишера, Ю. Неймана, Г. Крамера,

Э.Пирсона и др.

8

1. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

1.1 Испытания и события

Случайным событием называют всякий факт, который

может произойти или не произойти при проведении конкретного опыта при осуществлении некоторого комплекса

условий (обозначим А, В, С, … ). Таким образом, событие

будем рассматривать как испытание.

Вероятность события – численная мера объективной

возможности наступления события.

Предположим, что в результате эксперимента может наступить одно и только одно событие из n равновозможных

событий. Под равновозможностью событий понимают тот

случай, когда можно принять гипотезу о том, что в заданных условиях определенные исходы опыта возможны в

равной мере. Тогда полагают, что вероятность каждого из

этих событий равна 1/n.

Например, вероятность выпадения герба при бросании

монеты 1/2, а одной из граней игральной кости - 1/6.

Каждое из n равновозможных событий называют элементарными исходами и обозначаются ω 1 , ω 2 , . . . , ω n .

Случайное событие А связано с наступлением какоголибо элементарного события ω i из пространства элементарных событий Ω={ω 1 , ω 2 , ..., ω n }, т. е. при некотором

значении ω событие А наступает, а при некоторых не наступает.

Элементарные исходы ω , при которых событие А наступает, называются элементарными исходами, благоприятствующими событию А.

Пример 1.1. Событие А состоит в выпадении четного

числа очков при бросании игральной кости. Пространство

элементарных событий Ω={1,2,3,4,5,6}. Событию А можно

сопоставить таблицу:

ω1 ω2 ω3 ω4 ω5 ω6

0

1

0

1

0

1

,

9

где 1 - благоприятствующий исход; 0 - не благоприятствующий исход, тогда событию А благоприятствуют исходы

(2,4,6).

Данные n равновозможных события определяют 2 n различных случайных

событий. Именно столько, сколько

можно составить функций с двумя возможными значениями

при n возможных значениях аргумента.

Индикатор события

1, ω благоприятствуют событию А,

I A (ω) =

0, ω неблагоприятствуют событию А.

1.2 Классическое определение вероятности

Вероятностью события А называют отношение числа m

благоприятствующих исходов к общему числу n равновозm

можных событий, образующих полную группу Р(А)=

или

n

n

P( A) = (1 / n) ⋅ ∑ I A (ωi ) .

i =1

Отдельно выделим достоверное событие Ω , которому

благоприятствуют все элементарные события и P( Ω )=1; невозможное событие Ø: Р (Ø)=0.

Для случайных событий 0< Р (A)<1.

Пример 1.2. Брошены 2 игральные кости. Найти вероятность того, что сумма полученных очков равна 4.

Решение. Пространство элементарных событий Ω ={(1,

1), (1,2), …, (6,6)}.

Всего исходов − n=6 · 6=36 .Число благоприятствующих

исходов m=3. Благоприятствующие исходы – {(1,3), (3,1),

(2,2)}.

Вероятность события - P(A)=3/36=1/12.

1.3 Статистическое определение вероятности

Число равновозможных исходов конечно, поэтому классическое определение ограничено. К тому же результат испытаний не всегда можно представить в виде совокупности

10

элементарных событий. Поэтому вводят понятие статистической вероятности.

Частотой события А называют отношение числа m испытаний, в которых событие А появилось, к общему числу

n проведенных испытаний. Аналогично, используя индикатор события ν i =l, если в i-м испытании событие А произошло и ν i =0, если событие А не произошло, определим

частоту

р * =(l/n)·(ν 1 +ν 2 +. . .+ ν n )- частота события А в n испытаниях.

Если допустить, что опыты проводились в одинаковых

условиях и число испытаний велико и р * →р при

n →∞, где р-const, то событие А обладает вероятностью

равной (р=Р(А)), где р * - статистическая вероятность. Коротко этот факт записывают как р * →

р.

p

Пример 1.3. Пусть завод выпускает массовую продукцию. Если изделия, выпущенные заводом и поступившие в

продажу, выходят из строя в течение года, то требуется его

заменить. Сколько требуется запасных изделий, если в течение года продается N изделий ?

Решение. Обозначим событие А - отказ изделия.

1. Предположим, что событие обладает некоторой вероятностью р; отношение m вышедших из строя изделий к общему числу N есть частота события А при N испытаниях

р * =m/N. Если N − велико, то частота приблизительно совпадает с вероятностью р. Тогда р * ≈ р, отсюда m ≈ Nр.

2. Пусть р неизвестная величина, тогда надо поставить

n опытов (испытание n изделий в течение года); и пусть

среди них в k случаях изделие отказало. Отсюда р * =k/n, и

если n - велико, тогда р * ≈ р, m ≈ n·р * .

1.4 Геометрические вероятности

Выше было отмечено, что классическое определение неприменимо в случае бесконечного числа исходов. Чтобы

преодолеть этот недостаток, вводят вероятности попадания

точки в область (отрезок, часть плоскости и.д.). Рассмотрим геометрические вероятности на примере.

11

Пример 1.4. Пусть на плоскости начерчены две концентрические окружности, радиусы которых r=5 см, R=10

см соответственно. Найти вероятность того, что точка,

брошенная наудачу в большой круг, попадет в кольцо.

Решение. Площадь кольца S k =π(R 2 −r 2 )=π(10 2 −5 2 )=75π

(см 2 ). Площадь большого круга S=πR 2 =100π (см 2 ). Искомая вероятность P(A)=S k /S=0,75.

Геометрические вероятности могут сводиться к отношениям длин отрезков, площадей, объемов.

1.5 События и действия над ними

В каждой вероятностной задаче задается некоторое

множество Ω элементов или точек ω (Ω − пространство событий, ω − элементарные события). Ω − конечное множество точек в классическом определении вероятности, но в

ряде задач Ω − бесконечное множество.

Для такого случайного события, как отказ физического

элемента любой системы пространство Ω={ω≥0}, где ω −

момент отказа.

Должно быть задано пространство Ω и любое событие,

отождествленное с некоторым подмножеством A ⊂ Ω, тогда

событие будет интерпретироваться как попадание элементарного события ω в множество А.

В виду такого тесного соответствия между событием и

множеством они обозначаются одними и теми же символами. Над событиями можно проводить те же операции что и

над множествами. Пусть А α некоторое событие (α∈I) и заданное множество − часть простого события Ω.

1. Объединение событий U А α − событие, состоящее в

α

n

наступлении хотя бы одного из событий А α ( ∑ Ai ).

i =1

2. Пересечение событий I А α − событие, состоящее в

α

том, что произойдут все события (A 1 ·A 2 ·. . .·A n ).

Достоверное событие Ω={ ω ∈ Ω }.

Невозможное событие Ø={ ω ∈ Ø }.

12

3. Разность событий А\В − событие, состоящее в том,

что происходит А, но не происходит В (А−В).

A =Ω\A − дополнение к событию А ( противоположное

событию А).

Р( A )=1-Р(A).

Установим соответствие между событиями и логическими высказываниями, используя символ ⊂ принадлежности. Запись A⊂B означает, что любой элемент А входит в

множество В (A − частный случай В или из А следует В).

Действия над событиями.

1. A U А=А

10. Если A ⊂ B, то В=А U (B\A)

2. А ∩ А=А

11. А \ В=А B

12. A U В=A U (В\A)

3. A U A = Ω

13. A U (В U С)=(A U В) U С

4. A ∩ A =Ø

14. A∩(В∩С)=(A∩В)∩С

5. A U Ω = Ω

15. A∩(В U С)=(A∩В) U (A∩С)

6. A ∩ Ω =A

7. A U Ø=A

16. A U (В∩С)=(A U В)∩(A U С)

8. А ∩ Ø=Ø

17. U Aα = I Aα

9. Если A ⊂ B и B ⊂ C, то A ⊂ C

α

α

18. I Aα = U Aα

α

α

При небольшом числе событий (3-5) все эти операции

можно анализировать с помощью диаграмм Эйлера - Венна.

A1 A 2

A1

A1

A2

A1 A 2

A2

A1A 2

A1A 2

Рис. 1.1

Два события A и В называются несовместными, если А ∩ В=Ø,

т.е. они не могут наступить одновременно; А и A − несовместны.

События Аα (α ∈ I) называются несовместными, если несовместны два события Аα и Аβ, где α≠β; α, β ∈ I.

13

События Аα образуют полную группу, если их объединение по

всем α есть достоверное событие Ω ( U Аα=Ω и Аα∩Аβ=Ø ), т. е. в

α

данном опыте произойдет одно и только одно из событий Аα. Сумма вероятностей событий, удовлетворяющих этим условиям равна

1.

1.6 Аксиоматическое определение вероятности

Пусть дано произвольное множество Ω={ω} элементарных событий. Пусть определена некоторая система Q подмножеств

Ω−называемых случайными событиями и для каждого события А ∈

Q определяется некоторая числовая функция P(A).

Множество Q должно обладать следующими свойствами (σ −

алгебра):

1. Ω ∈ Q;

2. если А ∈ Q, то A ∈ Q;

3. если А α ∈ Q, то U А α ∈ Q; ∩ А α ∈ Q.

α

Числовая функция P(A) определенная для всех событий,

входящих в Q, удовлетворяет следующим условиям (аксиомам):

1. Р(A)≥ 0, A∈Q – аксиома неотрицательности;

2. P(Ω)=1 – аксиома нормированности;

3. P( U А α )= ∑ P(А α ) – расширенная аксиома сложения

α

α

(А α – несовместные события).

Тройку {Ω,Q, P}называют вероятностным пространством.

Два события А и В независимы, если Р(A·В)=Р(A)·Р(В),

в противном случае события называют зависимыми.

Пример 1.5. Пусть событие А - выпадение герба у первой монеты; В - выпадение герба у второй монеты. Тогда

вероятности Р(A)=Р(В)=1/2, Р(A·В)=1/4,

P(A·B)=P(A)·P(B). Отсюда следует, что А и В - независимые события.

С другой стороны, если A и В независимы, то независимы A , В; А, B ; A , B .

События А 1 , А 2 , ..., А n независимы в совокупности, если для любой подгруппы Ai1 ,...,Aik выполнено соотношение

14

P( Ai1 ⋅ ⋅ ⋅ Aik ) = P (Ai1 )⋅ ⋅ ⋅ P (Aik ).

Пример 1.6. Пусть на ЭВМ решается некоторая задача.

Обозначим события:

А − правильное решение задачи;

A 1 − отсутствие ошибок в программе;

А 2 − отсутствие ошибок в исходных данных;

А 3 − правильный ввод информации в ЭВМ;

A 4 − отсутствие сбоев при решении задачи;

A 5 − отсутствие сбоев у принтера.

Приняв гипотезу о независимости этих событий можно

найти вероятность события A: P(A)=P(A 1 )·…·Р(A 5 ) .

Пусть A и В случайные события и Р(A)>0. Тогда отношение Р(A·В)/Р(В) называют условной вероятностью события А при условии, что произошло событие В ( обозначается Р(A/В) ).

1. 7 Основные теоремы теории вероятностей

Теорема 1. Сложение вероятностей.

Вероятность суммы двух несовместных событий равна

сумме вероятностей этих событий.

Р(A+В)=Р(A)+Р(В), где А и В − несовместные события.

Доказательство. Пусть n - общее число возможных элементарных исходов, а m 1 −число исходов, благоприятствующих событию А; m 2 − число исходов, благоприятствующих событию В. Тогда P(A)=m 1 /n, P(B)=m 2 /n.

Так как события А и В − несовместные, то нет таких исходов, благоприятствующих наступлению A и В вместе.

Следовательно, событию (А+В) благоприятствуют (m 1 +m 2 )

исходов и вероятность

Р(А+В)=(m 1 +m 2 ) /n=P(A)+P(В).

Замечание. Теорема 1 повторяет аксиому 3. Тем не менее мы ее здесь доказали с использованием схемы случаев.

Следствие 1. Вероятность появления одного из нескольких попарно несовместных событий равна сумме вероятностей этих событий

Р(А 1 +...+A n )= Р(А 1 )+…+ Р(A n ).

Следствие 2. Вероятность суммы n событий, образующих полную группу несовместных событий, равна 1. Сумма

15

этих событий есть достоверное событие.

Противоположными событиями называют два несовместных события, образующих полную группу и обозначают как А и A .

Следствие 3. Сумма вероятностей противоположных

событий равна 1, т.е. Р(A)+Р( A )=1.

Теорема 2. Умножение вероятностей.

Вероятность произведения двух событий равна произведению вероятности одного из них на условную вероятность другого, вычисленную при условии, что первое событие произошло, т.е.

Р(А·В)=Р(А)·Р(В/А).

Доказательство. Пусть n − общее число возможных элементарных исходов;

m − число исходов, благоприятствующих событию А;

k − число исходов, благоприятствующих событию В.

Так как А и В могут быть совместными, то существуют

исходы, благоприятствующие и А и В вместе. Пусть число

таких исходов равно l. Тогда

Р(А·В) = l/n, Р(А)=m/n.

Вычислим условную вероятность события В при условии, что событие А произошло. Если А произошло, то из

ранее возможных n исходов остаются возможными только

те m, которые благоприятствуют А, а из них l исходов благоприятствуют В. Тогда

Р(В/А)= l/m и Р(А)·Р(В/А) =(m/n)·(l/m)=l/n=P(А·В).

Следствие 1. Если событие А не зависит от события В,

то и В не зависит от А, т.е. Р(A/В)=Р(A) или Р(В/A)=Р(В).

Следствие 2. Вероятность произведения двух независимых событий равна произведению вероятностей этих событий: Р(A·В)=Р(A)·Р(В).

Следствие 3. Если события А 1 ,А 2 , . . . , A n –зависимые,

то

Р(А 1 ·А 2 ·...·A n ) =Р(A 1 )·Р(A 2 /A 1 )·Р(A 3 /A 1 A 2 )·...

Р(А n /А 1 А 2 ...A n ).

Если события A 1 , А 2 , . . ., A n – независимые, то

Р(А 1 ·А 2 ·...·A n )=Р(A 1 )·Р(A 2 )·Р(A 3 )·...·Р (А n ).

16

Пример 1.7. Прибор, работающий в течении времени t,

состоит из трех узлов, каждый из которых, не зависимо

один от другого, в течении этого времени может выйти из

строя. Отказ хотя бы одного узла приводит к отказу прибора в целом. За время t надежность (вероятность безотказной работы) первого узла равна 0,8, второго – 0,9, третьего

– 0,7. Найти надежность прибора в целом.

Решение. Обозначим через А − надежность прибора в

целом, а A i − надежность i-го узла (i=1,2,3). Тогда

А=А 1 ·А 2 ·А 3 и

Р(А) =P(A 1 )·P(A 2 )·P(A 3 )=0,8·0,9·0,7=0,504.

Теорема 3. Сложение вероятностей совместных событий.

Эта теорема устанавливает связь между теоремой 1 и

теоремой 2.

Вероятность появления хотя бы одного из двух совместных событий равна сумме вероятностей этих событий без

вероятности их совместного появления.

Доказательство. Для наступления события А достаточно, чтобы произошло хотя бы одно из следующих несовместных событий: A·В, A· B .

Аналогично для В: А·В, A ·В. Тогда вероятности событий А и В соответственно равны: Р(А)=Р(А·В)+Р(А· B ),

Р(В)=Р(A·В)+Р( A ·В).

Для наступления хотя бы одного из событий А или В

достаточно, чтобы произошло одно из трех попарно несовместных событий: А·В, A· B , A ·В. Следовательно,

Р(A+В)=Р(А·В)+Р(A· B )+Р( A ·В).

Подставив первые два равенства в последнее равенство,

получим

Р(A+В)=Р(A)+Р(В)−Р(A·В).

Следствие. Методом математической индукции данную

теорему можно обобщить на случай суммы n событий:

Р(А 1 + А 2 +. . .+A n )=1−Р( A1 · A2 ·…· An )=l−q 1 ·q 2 ·…·q n ,

где P( Ai )=q i =1−p i .

Пример 1.8. Чтобы вывести самолет из строя при разрыве снаряда на некотором расстоянии R от самолета, необходимо поразить осколками либо оба двигателя, либо

кабину летчика. При разрыве снаряда на расстоянии R от

17

самолета вероятность поражения осколками каждого из

двигателей равна 0,2, а кабины летчика – 0,3. Найти вероятность поражения самолета при разрыве снаряда на расстоянии R, если агрегаты выходят из строя независимо.

Решение. Ведем события: С − поражение самолета;

L − поражение кабины летчика;

D 1 − поражение первого двигателя;

D 2 − поражение второго двигателя. Тогда

С=D 1 D 2 +L P(C)=P(L)+P(D 1 D 2 )−P(L·D 1 ·D 2 )=

=0,3+0,2·0,2−0,3·0,2·0,2=0,328.

Пример 1.9. В электрическую сеть последовательно

включены три элемента, работающие независимо один от

другого. Вероятности отказов этих элементов соответственно равны 0,1; 0,15; 0,2. Найти вероятность того, что тока в цепи не будет.

Решение. Обозначим через A событие, что тока в цепи

нет. Тогда

Р(A)=1−(1−0,1)(1−0,15) (1−0,2)=0,388.

1.8 Формула полной вероятности

Предположим, что некоторое событие А может наступить лишь при условии появления одного из несовместных

событий В 1 , В 2 , …, В n , образующих полную группу. Известны вероятности этих событий Р(В i ) и условные вероятности

Р(А/В i ). Как найти вероятность события А?

Теорема. Вероятность события A, которое может наступить только при условии появления одного из несовместных событий В 1 , ...,В n , образующих полную группу, равна

сумме произведений вероятностей каждого из этих событий на соответствующую условную вероятность события А.

n

P(A)= ∑ P(B i )P(A/ B i ).

i =1

Доказательство. Появление события А означает появление одного из несовместных событий В 1 ·А, В 2 ·А, ..., В n ·А,

т.е. А=В 1 А+В 2 А+…+В n А. По теореме сложения вероятностей Р(A)=Р(В 1 A)+...+Р(В n A). По теореме умножения вероятностей зависимых событий

P(B 1 A)=P(B 1 )·P(A/B 1 ), ..., Р(В n A)=Р(В n )·Р(A/В n ).

18

n

Отсюда получим P(A)= ∑ P(B i )P(A/ B i ).

i =1

Пример 1.10. Имеется два ящика деталей. Вероятность

того, что деталь из первого ящика стандартная, равна 0,8 и,

что деталь из второго ящика стандартная, равна 0,9. Найти

вероятность того, что взятая наудачу деталь из наудачу выбранного ящика стандартная.

Решение. Обозначим события:

А − взятая деталь стандартная;

B 1 − деталь взята из первого ящика;

В 2 − деталь взята из второго ящика.

P(A/B 1 ) − вероятность того, что из первого ящика будет

взята стандартная деталь; Р(A/В 2 ) − вероятность того, что

из второго ящика будет взята стандартная деталь;

Р(В 1 )=Р(В 2 )=0,5;

P(A/B 1 )=0,8;

P(A/B 2 )=0,9. Тогда искомая вероятность

Р(A)=Р(В 1 )·Р(A/В 1 )+Р(В 2 )·Р(A/В 2 )=0,5·0,8+0,5·0,9=0,85.

1.9 Формула Бейеса

В формуле полной вероятности несовместные события

В i образуют полную группу и эти события называют гипотезами, поскольку заранее неизвестно, какое из них наступит.

Предположим, что произведен опыт, в результате которого появилось событие А. Поставим следующую задачу:

как изменятся в связи с наступлением события А вероятности гипотез В i . Событие А зависит от каждого из событий

B 1 ,...,B n . Задача состоит в определении условных вероятностей

Р(В 1 /А), ..., Р(В n /А).

Найдем P(B i /A)( i = 1, n ) по теореме умножения. Откуда

имеем

P(AB i )=P(A)·P(B i /A)=P(B i )·P(A/B i ) ( i = 1, n ).

Отсюда условные вероятности

P ( Bi ) ⋅ P ( A / Bi )

P(B i /A)=

.

P ( A)

19

Выражая Р(А) с помощью формулы полной вероятности,

получим

P( B ) ⋅ P ( A / Bi )

P(B i /A)= n i

.

∑ P( Bi ) ⋅ P( A / Bi )

i =1

Формула Бейеса позволяет переоценить вероятности

гипотез после того, как произошло событие А.

Пример 1.11. Детали, изготовленные в цехе, поступают

для проверки их на стандартность к одному из двух контролеров. Вероятность того, что деталь попадет к первому

контролеру равна 0,6, ко второму − 0,4. Вероятность того,

что деталь будет признана стандартной первым контролером равна 0,94, вторым − 0,98. Деталь при проверке признана стандартной. Найти вероятность того, что эту деталь

проверил первый контролер.

Решение. А − деталь признана стандартной;

B 1 − деталь проверил первый контролер;

В 2 − деталь проверил второй контролер.

Вероятности гипотез: P(B 1 )=0,6; Р(В 2 )=0,4;

0, 6 ⋅ 0, 94

P(B 1 /A)=

≈ 0,59.

0, 6 ⋅ 0, 94 + 0, 4 ⋅ 0, 98

1.10 Повторение испытаний. Формула Бернулли

Пусть проводятся несколько испытаний , причем вероят ность появления события А в каждом испытании постоянна

и равна р и не зависит от исходов других испытаний . Сле довательно , вероятность ненаступления события А в каж дом испытании также постоянна и равна q=l−p .

Поставим задачу вычисления вероятности того , что в n

испытаниях событие А наступит ровно k раз и не наступит

(n−k) раз . Например , если А появилось три раза в четырех

испытаниях , то можно составить следующие сложные со бытия : ААА A , АА A А , А A АA , A ААА .

Искомую вероятность обозначим Р n ( k ) .

Вероятность одного сложного события , состоящего в

том , что в n испытаниях событие А наступит k раз и не на ступит ( n−k ) раз , по теореме умножения вероятностей ,

20

равна p k q n-k . Таких сложных событий всего C n k . Тогда

P n (k)=C n k p k q n -k .

Следствие. Вероятность того, что в n испытаниях событие наступит:

а) менее k раз−Р n (0)+Р n (1) + ... +P n (k−l);

б) не менее k раз −P n (k)+P n (k+1)+...+Р n (n);

в) более k раз −P n (k+l)+P n (k+2)+...+Р n (n);

г) не более k раз−P n (0)+P n (l)+...+P n (k).

1.11 Локальная формула Муавра−Лапласа

При больших значениях n использование формулы Бернулли затруднительно, и поэтому в таких случаях пользуются приближенной формулой Муавра − Лапласа.

Если вероятность р наступления события А в n испытаниях постоянна и отлична от нуля и единицы (0<р<1), то

вероятность появления события А в n испытаниях ровно k

раз приблизительно равна значению функции

2

1

1

k − np

у=

φ( x) при х=

, где функция φ( x) =

⋅ e− x / 2 npq

npq

2π

табулированная функция. Как видно из выражения, функция φ(х) четная. Таким образом,

1

P n (k) ≈

ϕ ( x) .

npq

Формула тем точнее, чем больше число испытаний n.

Пример 1.12. Вероятность поражения мишени стрелком

при одном выстреле равна 0,75. Найти вероятность того,

что при 10 выстрелах стрелок поразит мишень 8 раз.

Решение. В данном случае n=10; k=8; p=0,75; q=0,25;

8 − 10 ⋅ 0, 75

x=

= 0, 36 ; φ(0,36)≈0,3739;

10 ⋅ 0, 75 ⋅ 0, 25

1

P10 (8) ≈

⋅ 0, 3739 = 0, 273 .

10 ⋅ 0, 75 ⋅ 0, 25

Для сравнения найдем эту вероятность по формуле Бер8

нулли: Р 10 (8)= C10

·0,75 8 ·0,25 2 =0,282.

21

1.12 Интегральная формула Муавра−Лапласа

Пусть проводится n испытаний, в каждом из которых

вероятность появления некоторого события А равна р

(0<р<1). Как вычислить вероятность P n (k 1 ,k 2 ) того, что событие А в n испытаниях появится от k 1 до k 2 раз (не менее

k 1 и не более k 2 раз).

Теорема. Если вероятность p наступления события А в

каждом испытании постоянна и отлична от 0 и 1, то вероятность Р n (k 1 ,k 2 ) того, что событие появится от k 1 до k 2 раз,

приблизительно равна значению определенного интеграла

1 x ′′ − t 2 / 2

k − np

k − np

dt ,

где х'= 1

, х"= 2

.

∫e

npq

npq

2π x′

Введем функцию (интеграл) Лапласа:

1 x −t 2 / 2

⋅ ∫e

dt .

Ф 0 (х)=

2π 0

Таким образом,

1 x ′′ − t 2 / 2

1 x′ −t 2 / 2

P n ( k 1 , k 2 )≈

e

dt

−

dt =Ф 0 ( x ") − Ф 0 ( x ').

∫

∫e

2π 0

2π 0

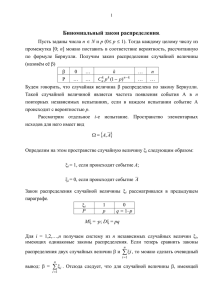

Ф 0 (х) – нечетная функция. График функции Ф 0 (х) приведен на рис. 1.2

Ф0(х)

0,5

0

x

-0,5

Рис. 1.2

Пример 1.13. Вероятность того, что деталь не пройдет

проверку ОТК равна 0,2. Найти вероятность того, что среди

400 случайным образом отобранных деталей окажется непроверенных от 70 до 100.

Решение. В данном случае n =400, k 1 =70, k 2 =100, p =0,2,

q =0,8. Значения аргументов функции Лапласа:

22

70 − 400 ⋅ 0,2

100 − 400 ⋅ 0,2

≈ −1,25 , х" =

≈ 2,5 .

400 ⋅ 0,2 ⋅ 0,8

400 ⋅ 0,2 ⋅ 0,8

Ф 0 (1,25)=0,3944,

Ф 0 (2,5)=0,4938,

Р 400 (70, 100) ≈0,4938+0,3944=0,8882.

Следствие. Отклонение частоты события от постоянной

вероятности в n испытаниях выражается формулой:

Р (| m/n −p | ≤ ε) ≈ 2Ф 0 (ε n /( pq ) ).

1

1 x −t 2 / 2

Определение. Функцию Ф( х) = Ф 0 ( х) + =

dt

∫e

2

2π − ∞

называют функцией стандартного нормального (гауссова)

распределения.

1.13 Формула Пуассона

x′ =

Пусть n – число испытаний, р – вероятность наступления события в каждом из них (n·p=λ ). Тогда по формуле

Бернулли

n ⋅ ( n − 1) ⋅ ... ⋅ [ n − (k − 1)] k n-k

P n (k)=C n k ·p k ·q n-k =

·p ·q .

k!

λ k −λ

Предел этой вероятности lim P n (k)= ⋅ e , откуда

n→∞

k!

k

λ

P n (k) ≈ ⋅ e− λ . Последнее выражение носит название

k!

формулы Пуассона. Эта формула используется в тех случаях, когда число испытаний «велико», а вероятность наступления события А в каждом из них «мала», причем «мало»

также произведение λ=n·p.

Пример 1.14. Завод отправил на базу 5000 доброкачественных изделий. Вероятность того, что в пути изделие повредится равна 0,0002. Найти вероятность того, что на базу

прибудут 3 негодных изделия.

Решение. В этом случае k=3,

n=5000,

р=0,0002,

λ=n·р=1,

Р 5000 (3)≈(1/3!)·е -1 ≈0,06.

23

1.14 Простейший поток событий

Рассмотрим события, которые наступают в случайные

моменты времени. Потоком событий будем называть последовательность событий, которые наступают в случайные

моменты времени. Например: поступление вызовов на

пункт скорой помощи, последовательность отказов элементов какой-либо системы и т. д.

Основные свойства потока.

1. Стационарность. Она характеризуется тем, что вероятность появления k событий на любом промежутке времени t зависит только от числа k и от длительности t и не зависит от промежутка отсчета.

2. Отсутствие последействия означает, что вероятность

появления k событий на любом промежутке времени не зависит от того, появились или не появились события до рассматриваемого промежутка времени. Условная вероятность

появления k событий на любом промежутке времени t, вычисленная при любых предположениях о том, сколько событий произошло до рассматриваемого промежутка, равна

безусловной вероятности.

3. Ординарность характеризуется тем, что появление 2х и более событий на малом промежутке времени практически невозможно.

Простейшим (пуассоновским) потоком называется поток событий, обладающий этими тремя свойствами.

Интенсивностью потока λ называют среднее число событий, которые появляются в единицу времени. Если интенсивность потока λ известна, то вероятность появления k

событий за промежуток времени t определяется формулой

Пуассона:

(λt ) k ⋅ e− λt

P t (k)=

.

k!

Пример 1.15. Среднее число вызовов, поступивших в

АТС за 1 минуту, равно 2. Найти вероятность того, что за 5

минут поступит а) 2 вызова, б) не менее 2-х вызовов.

Решение. λ=2, t=5, k=2.

24

10 2 ⋅ e −10

а) Р 5 (2)=

≈0,00225.

2!

б) P 5 (k≥ 2)=l−P 5 (k<2)=l−(e -10 +10e -10 )≈0,999505 − практически достоверное событие.

1.15 Задание №1 на самостоятельную работу. Решение

типовых задач

1.1 Задумано двузначное число. Найти вероятность того, что задуманным числом окажется:

а) случайно названное двузначное число;

б) случайно названное двузначное число, цифры которого различны.

Ответ: а) Р=1/90, б) Р=1/81.

1.2 Брошены две игральные кости. Найти вероятности

следующих событий:

а) сумма выпавших очков равна 7;

б) сумма выпавших очков равна 8, а разность 4.

Ответ: а) Р=1/6, б) Р=1/18.

1.3 Куб, все грани которого окрашены, распилен на тысячу кубиков одинакового размера, которые затем тщательно перемешаны. Найти вероятность того, что наудачу

извлеченный кубик имеет окрашенных граней: а) одну; б)

две.

Ответ: а) Р=0,384; б) Р=0,096.

1.4. В пачке 20 карточек, помеченных номерами

101, 102, ..., 120 и произвольно расположенных. Наудачу извлечены две карточки. Найти вероятность того, что

извлечены карточки с номерами 101 и 120.

2

Ответ: Р=1/ C20

=1/190.

1.5 В ящике имеется 15 деталей, среди которых 10 окрашенных. Сборщик наудачу извлекает 3 детали. Найти вероятность того, что извлеченные детали окажутся окрашенными.

3

3

Ответ: P = C10

/C15

= 24 / 91 .

1.6 В конверте среди 100 фотокарточек находится 1 разыскиваемая. Из конверта наудачу извлечены 10 карточек.

25

Найти вероятность того, что среди них окажется нужная.

9

10

Ответ: P = C99

/C100

= 0 ,1 .

1.7 В ящике 100 деталей, из них 10 бракованных. Наудачу извлечены 4 детали. Найти вероятность того, что среди извлеченных деталей нет бракованных.

4

4

Ответ: P = C90

/C100

≈ 0 ,65 .

1.8 В партии из N деталей имеется n стандартных. Наудачу отобраны m деталей. Найти вероятность того, что среди отобранных деталей ровно k стандартных.

Ответ: P = Cnk ⋅ C Nm−−nk /C Nm .

1.9 В группе 12 студентов, среди которых 8 отличников.

По списку наудачу отобраны 9 студентов. Найти вероятность того, что среди них 5 отличников.

9

Ответ: P = C85C44 /C12

= 14 / 55 .

1.10 В «секретном» замке на общей оси 4 диска, каждый

из которых разделен на 5 секторов, на которых написаны

различные цифры. Замок открывается только в том случае,

если диски установлены так, что цифры на них составляют

определенное четырехзначное число. Найти вероятность

того, что при произвольной установке дисков замок будет

открыт.Ответ: Р=1/5 4 .

1.11 В сигнализатор поступают сигналы от двух устройств, причем поступление каждого из сигналов равновозможно в любой момент промежутка времени длительностью Т. Моменты поступления сигналов независимы один

от другого. Сигнализатор срабатывает, если разность между моментами поступления сигналов меньше t (t < T). Найти

вероятность того, что сигнализатор срабатывает за время Т,

если каждое из устройств пошлет по одному сигналу.

Ответ: P = t( 2T- t)/T 2 .

1.12 Задача о встрече. Два студента условились встретиться в определенном месте между 12 и 13 часами дня.

Пришедший первым ждет второго в течении 1/4 часа, после

чего уходит. Найти вероятность того, что встреча состоится, если каждый студент наудачу выбирает момент своего

прихода (в промежутке от 12 до 13 часов).

Ответ: Р=7/16.

26

1.13 В ящике 10 деталей, из которых 4 окрашены.

Сборщик наугад взял 3 детали. Найти вероятность того, что

хотя бы одна из взятых деталей окрашена.

3

Ответ: P = 1 − C63 /C10

= 5/ 6 .

1.14 Для сигнализации об аварии установлены два независимо работающих сигнализатора. Вероятность того, что

при аварии сигнализатор сработает, равна 0,95 для первого

сигнализатора и 0,9 для второго. Найти вероятность того,

что при аварии сработает только один сигнализатор.

Ответ: Р=0,14.

1.15 Два стрелка стреляют по мишени. Вероятность попадания в мишень при одном выстреле для первого стрелка

равна 0,7, а для второго 0,8. Найти вероятность того, что

при одном залпе в мишень попадает только один из стрелков.

Ответ: P=0,38.

1.16 Вероятность одного попадания в цель при одном

залпе из двух орудий равна 0,38. Найти вероятность поражения цели при одном выстреле первым из орудий, если

известно, что для второго орудия эта вероятность равна

0,8.

Ответ: P=0,7.

1.17 Отдел технического контроля проверяет изделия на

стандартность. Вероятность того, что изделие стандартно,

равно 0,9. Найти вероятность того, что из двух проверенных изделий только одно стандартное.

Ответ: P=0,18.

1.18 Из партии изделий товаровед отбирает изделия

высшего сорта. Вероятность того, что наудачу взятые изделия окажутся высшего сорта, равна 0,8. Найти вероятность

того, что из 3 произведенных изделий только 2 изделия

высшего сорта.

Ответ: P=0,384.

1.19 Вероятность того, что нужная сборщику деталь находится в первом, втором, третьем, четвертом ящике, соответственно равны 0,6; 0,7; 0,8; 0,9. Найти вероятность того,

что деталь содержится:

а) не более чем в 3 ящиках;

б) не менее чем в 2 ящиках.

27

Ответ: а) Р=0,6976,

б) Р=0,9572.

1.20 Среди 100 лотерейных билетов есть 5 выигрышных. Найти вероятность того, что 2 наудачу выбранные билета окажутся выигрышными.

Ответ: Р=(5/100)·(4/99)=1/495.

1.21 Студент знает 20 из 25 вопросов программы. Найти

вероятность того, что студент знает предложенные ему экзаменатором три вопроса.

Ответ: Р=(20/25)·(19/24)·(18/23)=57/115.

1.22 Для разрушения моста достаточно попадания 1

авиационной бомбы. Найти вероятность того, что мост будет разрушен, если на него сбросить 4 бомбы, вероятность

попадания которых соответственно равны: 0,3; 0,4; 0,6; 0,7.

Ответ: P=0,95.

1.23 В ящике содержится 12 деталей, изготовленных на

заводе № 1, 20 деталей на заводе №2 и 18 деталей на заводе

№3. Вероятность того, что деталь, изготовленная на заводе

№1, отличного качества, равна 0,9, для деталей, изготовленных на заводах №2 и №o3, эти вероятности соответственно равны 0,6 и 0,9. Найти вероятность того, что извлеченная наудачу деталь окажется отличного качества.

Ответ: P=0,78.

1.24 В первой урне содержится 10 шаров, из них 8 белых, во 2-й урне 20 шаров, из них 4 белых. Из каждой урны

наудачу извлекли по одному шару, а затем из двух шаров

наудачу взят один шар. Найти вероятность того, что взят

белый шар.

Ответ: P=0,5.

1.25 В каждой из трех урн содержится 6 черных и 4 белых шара. Из первой урны наудачу извлечен один шар и

переложен во вторую урну, после чего из второй урны наудачу извлечен один шар и переложен в третью урну. Найти

вероятность того, что шар, наудачу извлеченный из третьей

урны, окажется белым.

Ответ: P=0,4.

1.26 Два автомата производят одинаковые детали, которые поступают на общий конвейер. Производительность

первого автомата вдвое больше производительности второго. Первый автомат производит в среднем 60% деталей от28

личного качества, а второй – 84%. Наудачу взятая с конвейера деталь оказалась отличного качества. Найти вероятность того, что эта деталь произведена первым автоматом.

Ответ: Р=10/17.

1.27 В пирамиде 10 винтовок, из которых 4 снабжены

оптическим прицелом. Вероятность того, что стрелок поразит цель из винтовки с оптическим прицелом, равна 0,95;

для винтовки без оптического прицела - 0,8. Стрелок поразил мишень из наудачу взятой винтовки. Что вероятнее:

стрелок стрелял из винтовки с оптическим прицелом или

без него?

Ответ: Вероятнее, что винтовка была без оптического

прицела (вероятность того, что винтовка была без оптического прицела, равна 24/43, с оптическим прицелом –

19/43).

1.28 Число грузовых автомашин, проезжающих по шоссе, на котором стоит бензоколонка, относится к числу легковых машин, проезжающих по тому же шоссе, как 3:2. Вероятность того, что будет заправляться грузовая машина,

равна 0,1; для легковых машин эта вероятность равна 0,2. К

бензоколонке подъехала для заправки машина. Найти вероятность того, что это грузовая машина.

Ответ: P=3/7.

1.29 В больницу поступают в среднем 50% больных с

заболеванием К, 30% − с заболеванием L, 20% − с заболеванием М. Вероятность излечения болезней соответственно

равны 0,7; 0,8; 0,9. Больной поступивший в больницу, был

выписан здоровым. Найти вероятность того, что этот больной страдал заболеванием К.

Ответ: Р=5/11.

1.30 Два равносильных противника играют в шахматы.

Что вероятнее: а) выиграть одну партию из двух или две

партии из четырех? б) выиграть не менее двух партий из

четырех или не менее трех партий из пяти? Ничьи во внимание не принимаются.

Ответ: а) Вероятнее выиграть одну партию из двух:

Р 2 (1)=1/2; Р 4 (2)=3/8; б) вероятнее выиграть не менее двух

партий из четырех:

Р 4 (2)+Р 4 (3)+Р 4 (4)=1−[Р 4 (0)+Р 4 (1)]=11/16;

29

Р 5 (3)+ Р 5 (4)+ Р 5 (5)=8/16.

1.31 Монету бросают 5 раз. Найти вероятность того, что

«герб» выпадет:

а) менее двух раз;

б) не менее двух раз.

Ответ: а) Р=3/16, б) Р=13/16.

1.32 В семье 5 детей. Найти вероятность того, что среди

этих детей: а) 2 мальчика;б) более двух мальчиков.

Ответ: а) Р=10/32, б)Р=1/2.

1.33 Вероятность рождения мальчика равна 0,51. Найти

вероятность того, что среди 100 новорожденных окажется

50 мальчиков.

Ответ: Р 100 (50)≈0,0782.

1.34 Монета брошена 2N раз (N велико!). Найти вероятность того, что «герб» выпадет ровно N раз.

Ответ: P2 N ( N ) ≈ 0,5642 / N .

1.35 Монета брошена 2N раз. Найти вероятность того,

что «герб» выпадет на 2m раз больше, чем надпись.

Ответ: P2 N ( N + m) ≈ 2 / N

2/ N m .

1.36 Вероятность появления события в каждом из 2100

независимых испытаний равна 0,7. Найти вероятность того,

что событие появится: а) не менее 1470 и не более 1500

раз;

б) не менее 1470 раз.

Ответ:

а)Р 21 00 (1470,1500)≈0,4236,

б)

Р 2100 (1470,

2100)≈0,5.

1.37 Вероятность появления события в каждом из 21 независимых испытаний равна 0,7. Найти вероятность того,

что событие появится в большинстве испытаний.

Ответ: Р 21 (11,21)≈0,95945.

1.38 Монета брошена 2N раз (N велико!). Найти вероятность того, что число выпадшего «герба» будет заключено

между числами N − 2N / 2 и N + 2N / 2 .

Ответ: Р≈Ф(1)−Ф(−1)=2Ф(1)=0,6826.

1.39 Французский ученый Бюффон (XVIII в.) бросил

монету 4040 раз, причем «герб» появился 2048 раз. Найти

вероятность того, что при повторении опыта Бюффона относительная частота появления «герба» по абсолютной ве-

(

30

)

личине не более чем в опыте Бюффона.

Ответ: Р≈2Ф(0,877)=0,6196.

1.40 Отдел технического контроля проверяет 475 изделий на брак. Вероятность того, что изделие бракованное,

равна 0,05. Найти с вероятностью 0,95 границы, в которых

будет заключено число m бракованных изделий среди проверенных.

Ответ: 15≤m≤33.

31

2 ОДНОМЕРНЫЕ СЛУЧАЙНЫЕ ВЕЛИЧИНЫ. ЗАКОНЫ РАСПРЕДЕЛЕНИЯ ВЕРОЯТНОСТЕЙ СЛУЧАЙНЫХ ВЕЛИЧИН

2.1 Случайные величины

Случайная величина − такая величина, которая в результате опыта принимает то или иное значение, неизвестное заранее и зависящее от случайных причин. Это значение называют возможным значением случайной величины.

Обозначение случайных величин: X, Y, Z и т.д. Обозначение возможных значений случайной величины X: x 1 , x 2 , x 3 ,

... .

Примеры:

1. Число очков при бросании игральной кости –случайная

величина, возможные значения которой 1, 2, 3, 4, 5, 6.

2. Число мальчиков среди 100 новорожденных − случайная

величина возможные значения которой 0, ..., 100.

3. Расстояние R, которое пролетит снаряд, есть случайная

величина, возможные значения которой принадлежат некоторому отрезку [a, b].

Дискретная случайная величина − величина, которая

принимает отдельные возможные значения из счетного

множества с определенными вероятностями. Возможные

значения дискретной случайной величины можно перечислить.

Для задания дискретной случайной величины необходимо перечислить все возможные значения и соответствующие их вероятности.

Непрерывной случайной величиной называется величина, возможные значения которой заполняют некоторый

промежуток (несчетное множество) и нельзя перечислить

все возможные значения этой случайной величины.

Законом распределения

вероятностей дискретной

случайной величины называют соответствие между возможными значениями этой величины и их вероятностями.

Этот закон задают в виде таблицы, которую называют рядом распределения

Ряд распределения будет иметь вид

32

X x1 x2 x3 … xn

P

p1 p2 p3 … pn

.

События (X=x 1 ), (Х=х 2 ),..., (Х=х n ) образуют полную

n

группу, т.е. ∑ pi = 1.

i =1

Пример 2.1. В лотерее 100 билетов . Разыгрывается 1

выигрышный по 50 руб и 10 выигрышных по 1 руб . Соста вить

закон

распределения

случайной

величины

X −стоимости возможного выигрыша по 1 билету .

X 50 1 0

Р 0,01 0,1 0,89

Для наглядности ряд распределения можно изобразить в

виде многоугольника распределения ( см . рис .2.1).

Рис . 2.1

Ряд распределения можно указать только для дискрет ной случайной величины , для непрерывной случайной ве личины такой характеристики нельзя построить , так как

нельзя перечислить все возможные значения непрерывной

случайной величины .

2.2 Функция распределения вероятностей случайной

величины

Отдельные возможные значения непрерывной случай ной величины не обладают отличными от нуля вероятно стями , по аналогии с тем , что отдельные точки тела не об ладают массой . Поэтому для количественной характери 33

стики любой случайной величины удобно воспользоваться

не вероятностью события (Х=х), а вероятностью события

(Х<х). Вероятность этого события Р(Х<х) есть функция F(x)

и она называется функцией распределения вероятностей

случайной величины F(x)= P(X<x).

Ее также называют интегральным законом или интегральной функцией распределения вероятностей. Данную функцию можно построить для любых случайных величин. Геометрически равенство F(x)=P(X<x) можно истолковать таким образом: функцию F(x) можно представить

как вероятность того, что случайная величина X примет на

числовой оси возможные значения левее точки х (рис.2.2).

Рис. 2.2.

Случайная величина X называется непрерывной, если

ее функция распределения есть непрерывная кусочнодифференцируемая функция с непрерывной производной.

Свойства функции распределения:

1. 0≤F(x)≤l;

2. F(x) - неубывающая, т .е. F(x 1 )≤F(х 2 ) если x 1 <х 2 ;

3. F (−∞) = lim F ( x) = 0, F (+∞) = lim F ( x) = 1;

x→−∞

x→+∞

4. Р(х 1 ≤х<х 2 )= F(x 2 )−F(х 1 );

5. F ( x) = F ( x − 0) = lim F ( y ) , т.е. F(x) – непрерывная

y → x −0

слева функция.

Докажем, например, свойство 4. Для определения вероятности Р[α≤х<β) попадания случайной величины Х в заданный промежуток [α, β) введем 3 события:

А−(Х<β);

B−(X<α);

C - (α≤X<β). Тогда A=B+C и Р(A)=Р(В)+Р(С) и

F(β)=F(α)+Р(α≤x<β).

β

Отсюда

Р(α≤x<β)=F(β)−F(α)= ∫ F'(x)dx.

α

Вероятность попадания случайной величины в проме34

жуток ∆х есть приращение функции распределения

P(x≤X<x+ ∆ x)=F(x+ ∆ x)−F(x)→0 при ∆ х→0.

Таким образом, вероятность того, что непрерывная величина примет некоторое определенное значение, равна 0.

Пример 2.2. Построить функцию распределения для

дискретной случайной величины Х, заданной рядом распределения

X 1 4 8

P 0,3 0,1 0,6

При

х<1

F(x)=0;

1≤х<4

F(x)=0,3;

4≤х<8

F(x)=0,4;

х≥8

F(x)=l.

F(x)

1

0,4

0,3

0

1

8

4

x

Рис. 2.3

2.3 Плотность распределения вероятностей непрерывной случайной величины

Кроме функции распределения, непрерывную случайную величину можно задать с помощью так называемой

функции плотности распределения вероятностей. Эту

функцию называют дифференциальной функцией или

дифференциальным законом распределения вероятностей.

Плотностью

распределения

называют

функцию

f(x)=F'(x). Таким образом, для описания дискретной случайной величины эта функция неприменима. Вероятность

попадания случайной величины на заданный участок можβ

но представить как Р(α≤x<β)= ∫ f ( x)dx .

α

35

Свойства плотности распределения:

1. f(x) ≥0;

∞

2. ∫ f ( x )dx =l;

−∞

x2

3. P( x1 ≤ X < x2 ) = ∫ f ( x)dx ;

x1

4. Р ( Х = х )=0.

Вероятностный смысл функции плотности f(x):

F ( x + ∆x ) − F ( x )

f(x)= lim

.

∆x →0

∆x

Отсюда следует , что

P(x ≤ X<x+ ∆ x) ≈ f( х ) ∆х .

Вероятность того , что случайная величина X примет

значение , принадлежащее интервалу [х , х + ∆х ), приблизи тельно равна произведению функции плотности на длину

этого промежутка .

P( x ≤ X < x + ∆ x )

P( x ′ ≤ X < x ′ + ∆ x )

x′ x′ + ∆ x

x + ∆x

Рис. 2.4

Пример 2.3 . Задана плотность распределения вероятно стей случайной величины X:

x < 0;

0,

f ( x) = 2 x, 0 ≤ x < 1;

0,

x ≥ 1.

Найти вероятность того , что случайная величина X примет

значение из интервала (0,5; 1).

1

1

0,5

0,5

Решение . Р (0,5<X<1)= ∫ 2xdx = x 2

36

=1 − 0,25=0,75.

Нахождение функции

функции плотности:

распределения

по

известной

x

F ( x) = ∫ f ( x ) dx .

−∞

На практике иногда встречаются случайные величины ,

которые нельзя отнести ни к дискретным , ни к непрерыв ным случайным величинам , как показывает следующий

пример .

Пример 2.4. На перекрестке стоит автоматический све тофор , в котором τ 1 =1 мин . горит зеленый свет , τ 2 = 0,5 мин .

– красный , снова 1 мин . – зеленый , 0,5 мин . – красный и т . д .

В случайный момент времени , не связанный с работой све тофора , к перекрестку подъезжает автомобиль .

Покажем , что случайная величина Х – время ожидания у

перекрестка не является ни дискретной , ни непрерывной .

Обозначим τ = τ 1 + τ 2 =1,5 мин . цикл работы светофора . С

одной стороны , с вероятностью τ 1 / τ =2/3 автомобиль про едет перекресток не останавливаясь , т . е . Х принимает зна чение ноль с вероятностью 2/3 > 0. Поэтому Х не может

быть непрерывной случайной величиной . С другой сторо ны , на второй 0,5 – минутной части цикла время ожидания

Х может принять любое значение от 0 до 0,5. Значит , Х не

может быть также дискретной случайной величиной . Таким

образом , здесь Х представляет « смесь » дискретной и не прерывной случайных величин .

Построим график функции распределения вероятностей

случайной величины Х . При х≤ 0 F ( х )=0. Если 0 <х≤ 0,5, то

событие ( Х < х ) происходит в том случае , когда автомобиль

либо попадает на первую часть цикла работы светофора

( зеленый свет ), либо подъедет к светофору при красном

свете , но до включения зеленого света остается время ,

меньшее х . Тогда по определению геометрической вероят ности

τ + x x +1

F ( x) = P ( X < x ) = 1

=

.

τ

1,5

Поскольку автомобиль в любом случае проведет у пере крестка не более 0,5 мин ., то F ( х )=1, х> 0,5.

Таким образом ,

37

0,

x ≤ 0;

x +1

F ( x) =

, 0 < x ≤ 0, 5;

1

,

5

1,

x > 0, 5.

График функции F(х) приведен на рисунке 2.5

Рис. 2.5

2.4 Примеры дискретных распределений вероятностей

2.4.1 Биномиальное распределение

Пусть производится n испытаний, в каждом из которых

некоторое событие А может появиться либо не появиться.

Вероятность наступления события А во всех испытаниях

постоянна и равна р, тогда вероятность не появления этого

события q=l−p. В качестве дискретной случайной величины

X рассмотрим число появления события A в n испытаниях.

Возможные значения x 1 =0, x 2 =l, …, x n+1 = n, а их вероятности определяются по формуле Бернулли:

P n (k)=C n k ·p k ·q n-k , k=0, …, n.

Биноминальным называется распределение вероятностей, определенное по формуле Бернулли, т. к. правую

часть формулы Бернулли можно рассматривать как общий

член разложения бинома Ньютона

(p+q) n =C n n ·p n +C n n-1 ·p n -1 ·q+…+C n 0 ·q n .

Ряд распределения в этом случае выглядит таким образом:

X

P

38

n n-1

... k

n

n -1

p np q . . . C n k ·p k ·q n-k

... 0

. . . qn

.

2.4.2 Распределение Пуассона

Рассмотрим те же условия задачи что и в предыдущем

пункте, но значение n велико, вероятность р мала. Это

случай «массовых», но «редких» событий. В этом случае

вероятность

λ k ⋅ e −λ

P n (k)≈

, где λ= n·р.

k!

Тогда ряд распределения имеет, вид:

X

р

0

e -λ

1

2

… k

2 -λ

-λ

λе /1! λ е /2! … λ k ·e -λ /k!

…

…

Такое распределение вероятностей случайной величины

называют распределением Пуассона.

2.4.3 Геометрическое распределение

Пусть производятся n испытаний, в каждом из которых

вероятность появления события А равна р (0<р<1). Вероятность непоявления события q=l−p. Испытания заканчиваются, как только появится событие А. Следовательно, если

событие А появилось в k-м испытании, то в предшествующих (k−1) испытаниях оно не появилось. Введем дискретную случайную величину Х − число испытаний, которые

нужно провести до первого появления события А. Возможные значения Х: x 1 =l, x 2 =2, ... . По формуле умножения вероятностей независимых событий, вероятность того, что

число испытаний равно k

P(X=k)=q k -1 ·p.

Полагая в этой формуле k=l, 2, ... получим геометрическую

прогрессию с первым членом р и со знаменателем q: p, pq,

pq 2 , ..., pq k -1 . Такое распределение вероятностей называется

геометрическим.

Ряд распределения Х:

X

P

1

р

2

…k

p·q … p·q k -1

39

Пример 2.5. Из орудия производится стрельба по цели

до первого попадания. Вероятность попадания при одном

выстреле 0,6. Найти вероятность того, что попадание произойдет при третьем выстреле.

Решение. По условию р=0,6; q=0,4; k=3.

Тогда P(X=3)=0,4 2 ·0,6=0,096.

2.5 Примеры непрерывных распределений

2.5.1 Закон равномерного распределения вероятностей

Распределение вероятностей называется равномерным,

если на интервале, которому принадлежат возможные значения случайной величины, плотность распределения сохраняет постоянное значение. Функция плотности равномерного распределения f(х) имеет вид:

x < a;

0 ,

f ( x) = 1/ (b − a) , a ≤ x ≤ b;

0 ,

х > b.

Отсюда следует, что функция распределения

х < a;

0 ,

х − a

F ( x) =

, а ≤ х ≤ b;

b

−

а

х > b.

1,

Графики плотности f(х) и функции распределения F(х)

приведены на рис. 2.6 а) и 2.6 б).

а)

б)

1

в−а

Рис.2.6

40

Вероятность попадания равномерно распределенной

случайной величины в интервал (α, β):

Р(α<х<β)=(β−α)/(b−а).

Пример 2.6. Шкала измерительного прибора проградуирована в некоторых единицах. Ошибку при округлении

отсчета до ближайшего целого деления можно рассматривать как случайную величину X, которая может принимать

с постоянной плотностью вероятности любое значение между двумя соседними целыми делениями. Таким образом, X

распределена по равномерному закону с функцией плотности:

x < a;

0 ,

f ( x) = 1/ (b − а) , а ≤ х ≤ b;

0 ,

х > b.

Пример 2.7. Случайная величина Х, равномерно распределенная в интервале [0,1] имеет плотность распределения

1, 0 ≤ x ≤ 1;

f ( x) =

0 , в противном случае.

x

x

0

0

Тогда функция распределения F ( x) = ∫ f ( y )dy = ∫ 1dy = x .

Графики функций f(x) и F(x) приведены на рис. 2.7 а) и

2.7 б).

Рис.2.7

Вероятность попадания такой случайной величины Х в

интервал 0≤х<х+∆х≤1

41

x + ∆x

P( x ≤ X < x + ∆x) = ∫ f ( y )dy = F ( x + ∆x) − F ( x) = ( x + ∆x) − x = ∆x .

x

Отсюда следует, что случайная величина Х, равномерно

распределенная в интервале [0, 1] с одинаковой вероятностью попадет в любой интервал длиной ∆х∈[0, 1]. Поэтому

такая величина Х имеет огромное значение в имитационном

моделировании, т.к. она служит основой генерирования на

компьютерах любых случайных величин, потоков событий

и случайных процессов.

2.5.2 Нормальный закон распределения

Случайная величина X называется распределенной по

нормальному закону, если ее плотность распределения

имеет вид:

2

2

1

φ m,σ ( x) =

⋅ e − ( x − m) / (2σ ) .

σ 2π

Нормальное распределение зависит от двух параметров:

m, называемого математическим ожиданием или средним

значением, и σ, называемого средним квадратическим

отклонением. Этот закон распределения называют еще

предельным или законом Гаусса.

Функция нормального распределения имеет следующий

вид:

x −

( x − m) 2

1

2

∫ e 2 σ dx .

σ 2π − ∞

Общим называется нормальное распределение с параметрами m, σ, где −∞<m<+∞- математическое ожидание,

σ>0 − среднее квадратическое отклонение.

Стандартным нормальным распределением называется распределение с параметрами m =0, σ=1.

Путем линейной замены общее нормальное распределение можно привести к стандартному нормальному распределению.

Плотность стандартного распределения записывается в

2

1

виде: φ( x) =

⋅ e− x / 2 , а функция распределения:

2π

Φ m, σ ( x ) =

42

x

2

Φ 0 (x)= 1 ∫ e −t / 2 dt .

2π −∞

Эти функции были использованы ранее в локальной и интегральной формулах Муавра – Лапласа (см. п.1.10, 1.11). На

рис. 2.8 а) и 2.8 б) приведены графики функций φ m, σ (х) и

Φ m,σ ( x ) для различных значений m и σ.

а)

б)

Рис. 2.8

Таким образом, относительно функции плотности нормального распределения можно утверждать следующее:

l) функция φ m, σ (х) определена и непрерывна на всей числовой оси (−∞;+∞);

2) область значений функции у∈[0, 1/(σ 2π )];

3) lim ϕ m, σ ( x) = 0 ;

x → ±∞

4) ymax

x =m

= 1 /(σ 2 π ) ;

5) график функции симметричен относительно прямой

х =m ;

6) точки перегиба: х 1 = m -σ , х 2 = m +σ.

Вероятность попадания в заданный интервал нормально

распределенной случайной величины:

β

P (α<Х<β)=Φ m,σ (β)−Φ m,σ (α) = ∫ φm,σ ( x)dx =1/(σ 2π )=

α

1 ( β −m) / σ − y 2 / 2

dx =

dy .

= ∫e

∫ e

2

π

α

(α −m ) / σ

Проводя замену у =( х− m)/ σ, получим

β

−( x − m )2 /( 2σ 2 )

43

β −m

α − m

Р(α<Х<β)= Φ 0

(2.1)

− Φ0

.

σ

σ

Из этой формулы можно определить вероятность отклонения случайной величины от математического ожидания:

Р(Х-m<δ)=2Ф 0 (δ/σ).

(2.2)

Правило трех сигма.

Преобразуем формулу (2.2). Для этого обозначим δ=σt.

Тогда

Р( |X−m|<σt)=2Ф 0 (t).

Положим t=3 , тогда Р(|Х−m|<3σ)=2Ф 0 (3)=0,9973.

Если случайная величина X распределена по нормальному закону, то абсолютная величина ее отклонения от математического ожидания m не превосходит утроенного значения среднего квадратического отклонения, и вероятность

этого отклонения близка к 1, а вероятность противоположного события составляет 0,0027.

Таким образом, можно считать практически достоверным событие, что возможные значения случайной величины, распределенной по нормальному закону, попадут в интервал (m−3σ, m+3σ) (см. рис.2.10).

Рис. 2.10

2.5.3 Экспоненциальный закон распределения

Случайная величина X называется распределенной по

экспоненциальному (показательному) закону, если ее

функция плотности имеет вид:

x < 0;

0,

f ( x ) = − λx

, x ≥ 0,

λe

44

где λ>0−параметр экспоненциального распределения.

Тогда функция распределения будет иметь вид:

x < 0;

0,

F ( x) =

−λx

, x ≥ 0.

1 − e

Графики функции плотности распределения f(x)

функции распределения F(x) приведены на рис.2.11.

а)

и

б)

Рис.2.11

Вероятность попадания показательно распределенной

случайной величины в заданный интервал определяется по

формуле:

P(α<X<β)=F(β)−F(α)=e -λ α − e -λβ .

(2.3)

Экспоненциальный закон распределения занимает важное место в теории массового обслуживания, теории надежности и других областях. Например, функция

R(t)=1−F(t)=e -λt называется показательным законом надежности.

Пример 2.8. Случайная величина Т – время работы радиолампы – имеет показательное распределение. Найти вероятность того, что время работы лампы будет не меньше

600 часов, если среднее время работы лампы 400 часов.

Решение. Р(Т≥600)=1−Р(Т<600)=

=1−( е (1/4 00)·0 −e -(1/4 00)600 )=е -1,5 ≈0,2231.

2.5.4 Распределение Вейбулла

Случайная величина X распределена по закону Вейбулла с параметрами α>0, β>0, если ее плотность распределения имеет вид:

45

αβ − α x α −1e − ( x / β ) α , x ≥ 0;

f ( x) =

0,

x < 0.

Параметр α называется параметром формы, а β −

масштабным параметром распределения.

Тогда функция распределения Вейбулла будет иметь

следующий вид:

1 − e − ( x / β ) α , x ≥ 0;

F ( x) =

0,

x < 0.

Графики функций плотности и распределения Вейбулла

при β=1 приведены на рис.2.12 а) и 2.12 б).

Считается, что распределению Вейбулла подчиняются

времена безотказной работы многих технических устройств

и времена выполнения задач. При α=1 распределение Вейбулла переходит в экспоненциальное распределение, а при

α=2 –в так называемое распределение Релея.

а)

б)

f(x)

1,2

1,0

α=3

0,8

α=2

0,6

α=1

0,4

α=1/2

0,2

0

1

2

3

4

5

x

Рис. 2.12

2.5.5 Гамма – распределение

Другим распределением, также достаточно хорошо описывающим времена безотказной работы различных технических устройств, и времена выполнения каких-либо задач,

является гамма-распределение с плотностью

46

β − α x α −1e − x / β

,

f ( x) =

Γ (α )

0,

x ≥ 0;

x < 0,

∞

где Г(α) – гамма-функция, Γ ( z ) = ∫ t z −1e−t dt для любого веще0

ственного числа z>0.

Для вычислений полезно знать следующие свойства функции Г(z):

1. Г(z+1)=z·Г(z), для любого z>0;

2. Г(k+1)=k!, для любого неотрицательного целого числа

k;

3. Г(k+1/2)= π ⋅1 ⋅ 3 ⋅ 5 ⋅ ... ⋅ (2k − 1) / 2k , для любого положительного целого числа k, Γ (1 / 2) = π .

Как и в случае с распределение Вейбулла, α>0 – параметр формы, β>0 – масштабный параметр.

Если α – положительное целое число, тогда функция

распределения имеет вид:

n −1( x / β ) j

−x /β

, x ≥ 0;

∑

1 − e

F ( x) =

j!

j =0

0,

x < 0.

В случае, если 0<α<1, то конечной формы функции распределения не существует, имеются лишь ее приближения.

Замечания.

1. При α=1, гамма-распределение, как и распределение

Вейбулла переходит в экспоненциальное распределение.

2. Для положительного целого числа r (α=r), гаммараспределение переходит в распределение Эрланга порядка r, которое широко используется в теории массового

обслуживания.

3. Гамма−распределение при α=k/2, β=2 представляет не

что иное, как распределение χ 2 (хи – квадрат) с k степенями

свободы, роль которого трудно переоценить в математической статистике. Наконец, на рис. 2.13 приведены графики

функций плотности f(x) и распределения F(x) при различных значениях параметра α при β=1.

47

а)

б)

F(x)

1,0 α=1/2

0,8

α=3

α=2

α=1

0,6

0,4

0,2

0

1

2

3

4

5

x

Рис.2.13

2.6 Задание №2 на самостоятельную работу. Решение

типовых задач

2.1 Из партии в 10 деталей, среди которых две бракованные, наудачу выбирают три детали. Найдите закон распределения числа бракованных деталей среди выбранных.

Постройте функцию распределения.

Ответ:

x ≤ 0;

0,

7 / 15, x ∈ (0,1];

C2i C83−i

=

=

P( X = i) =

,

i

0

,

1

,

2

;

F

(

x

)

3

C10

14 / 15, x ∈ (1,2];

1,

x > 2.

2.2 Вероятность приема самолетом радиосигнала при

каждой передаче равна 0,7. Найдите ряд распределения и

функцию распределения числа X принятых сигналов при

шестикратной передаче.

Ответ: Ряд распределения и функцию распределения

случайной величины X легко построить, зная, что

P( X = i) = C6i (0,7)i (0,3)6−i , i = 0,6.

2.3 В течение часа на станцию скорой помощи поступает случайное число X вызовов, распределенное по закону

Пуассона с параметром λ=5. Найдите вероятность того, что

в течение часа поступит:

а) ровно два вызова;

48

б) не более двух вызовов;

в) не менее двух вызовов.

Ответ:а) Р(Х=2) = 5 2 е -5 /2!≈0,086;

б) Р(Х ≤ 2)=(5 0 /0! + 5 1 /1! +5 2 /2!)е -5 ≈0,127;

в) Р(Х≥2)=1−Р(Х<2)=1−(5 0 /0!+5 1 /1!)e - 5≈0,96.

2.4 Число вызовов, поступающих на АТС (автоматическая телефонная станция) каждую минуту, распределено по

закону Пуассона с параметром λ=1,5. Найдите вероятность

того, что за минуту поступит:

а) ровно три вызова;

б) хотя бы один вызов;

в) менее пяти вызовов.

Ответ: а) 0,12551; 6)0,77687; в) 0,98143.

2.5 По цели производят серию независимых выстрелов

до первого попадания. Даны вероятность р попадания в

цель при одном выстреле и запас патронов n. Найдите ряд

распределения и функцию распределения числа X израсходованных патронов.

pqi −1, i = 0, n − 1 (q = 1 − p);

Ответ: P( X = i) =

q n−1, i = n.

2.6 Летательный аппарат, по которому ведется стрельба, состоит из двух различных по уязвимости частей. Аппарат выходит из строя при одном попадании в первую

часть или трех попаданиях во вторую. Стрельба ведется до

поражения летательного аппарата.

Постройте ряд распределения и функцию распределения

числа попаданий X в летательный аппарат, которое понадобится для его поражения, если каждый попавший в аппарат

снаряд с вероятностью 0,3 поражает первую часть и с вероятностью 0,7 − вторую.

Ответ: Р(Х=1) = 0,3; Р(Х=2)=0,21; Р(Х=3)=0,49.

2.7 Непрерывная случайная величина X распределена по

экспоненциальному закону с параметром λ=0,2. Найдите

вероятность попадания этой случайной величины в интервал (0,2).

Ответ: 1−е -0,4 ≈0,33.

2.8 Длительность времени X безотказной работы элемента имеет экспоненциальное распределение с парамет49

ром λ=0,02 ч -1 . Вычислите вероятность того, что за время

t =100ч элемент: а) выйдет из строя; б) будет исправно работать.

Ответ: а) 1−е -2 ≈0,865; б) е -2 ≈0,135.

2.9 Случайная величина X имеет нормальное распределение с параметрами m=2 и σ=1. Определите вероятность

попадания случайной величины в интервал (1, 5).

Ответ: 0,83999.

2.10 Случайная величина X распределена по нормальному закону с параметрами m=4 и σ=1. Определите вероятность попадания случайной величины X в интервал

(6,

8).

Ответ: 0,0227.

2.11 Случайная величина Х подчинена нормальному закону распределения с m=0. Вероятность попадания случайной величины в интервал (−0,3; 0,3) равна 0,5. Найдите

среднее квадратическое отклонение σ.

Ответ: σ=0,44.

2.12 Измерительный прибор имеет систематическую погрешность 5 м. Случайные погрешности подчиняются нормальному закону со средним квадратическим отклонением,

равным 10 м. Какова вероятность того, что погрешность

измерения не превзойдет по абсолютному значению 5 м ?

Ответ: 0,3413.

2.13 Измерение дальности до объекта сопровождается

случайными погрешностями, подчиняющимися нормальному закону со средним квадратическим отклонением, равным 50 м. Систематическая погрешность отсутствует. Найдите:

а)вероятность измерения дальности с погрешностью, не

превосходящей по абсолютному значению 100 м;

б)вероятность того, что измеренная дальность не превзойдет истинной.

Ответ: а) 0,9545; б) 0,5.

2.14 Высотомер имеет случайную и систематическую

погрешности. Систематическая погрешность равна 20 м.

Случайная погрешность распределена по нормальному закону. Какую среднюю квадратическую погрешность дол50

жен иметь прибор, чтобы с вероятностью 0,9452 погрешность измерения высоты была меньше 10 м?

Ответ: 50 м.

2.15 Время X (в часах) безотказной работы электрической лампочки имеет распределение Вейбулла с параметрами α=0,5 и β=50. Определите вероятность того, что лампочка проработает не менее 10000 ч.

1/ 2

− ( 0 , 02⋅10000 )

Ответ: Р(Х > 10000) = e

≈ 0,14 .

2.16 Время X (в месяцах) безотказной работы некоторой

системы, состоящей из одного основного и двух резервных

элементов, имеет гамма-распределение с параметрами α=3

и β=20. Найдите вероятность того, что система проработает

не менее 5 лет.

Ответ: Р(Х > 60) =е -3 (1+3=3 2 /2)≈0,42.

51

3 ЧИСЛОВЫЕ ХАРАКТЕРИСТИКИ СЛУЧАЙНЫХ

ВЕЛИЧИН

Вероятности любых событий, связанных с каждой случайной величиной, полностью могут быть определены ее

законом распределения. Причем законом распределения

вероятностей для дискретной случайной величины является

ряд распределения, или же функция распределения. Непрерывная случайная величина полностью может быть описана

функцией распределения или плотностью распределения.

Закон распределения полностью характеризует случайную величину, т.е. является ее полной характеристикой.

Однако часто на практике этот закон распределения бывает

неизвестен, или нет необходимости его указывать. Тогда

ограничиваются меньшими сведениями. Для этого используют числовые характеристики случайной величины (неслучайные числа).