Классическая линейная регрессионная модель

реклама

Лекция 2

Классическая линейная

регрессионная модель

(КЛРМ)

1

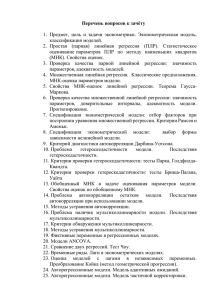

Метод наименьших квадратов

Пусть нас интересует некоторое экономическое явление,

например, потребление электроэнергии населением.

Y

f(X)

Yi

εi

Xi

X

У нас есть данные

о расходах на электроэнергию (У)

и доходах (Х) домохозяйств.

Мы хотим построить по этим

данным зависимость У= f(X),

например,

линейную: f(X) = β0 + β1 X.

Наша задача: подобрать параметры

β0 и β1 так, чтобы линия,

изображающая эту зависимость

прошла через основную массу точек

2

Какими способами можно это

осуществить?

Очевидно, нужно найти такой способ

подбора параметров функции f(X),

при котором различия между

наблюдаемыми значениями Yi и

значениями функции f(Xi)

ε i = Yi − f ( X i ) = Yi − β 0 − β1 X i

(эту разницу называют невязкой или

ошибкой) были как можно меньше

3

Метод наименьших квадратов

Самый простой и удобный способ – МНК

∑ε

i

2

i

= ∑ (Yi − β 0 − β1 X i ) → min

2

i

β

• Его достоинства:

– дифференцируемость функции,

– вычислительная простота,

– единственность решения

• Недостатки:

– неробастность

4

Робастные методы подгонки

зависимости (М-оценки)

∑ ρ (ε i ; β ) → min

β

i

где функция ρ(.) растет по ε медленнее, чем само ε.

• Например:

ρ (ε , β ) =| ε |

• Полученная регрессия называется медианной,

поскольку соответствует условной медиане

5

Робастные методы подгонки

зависимости (М-оценки)

• Функция Хьюбера

⎧ ε 2 / 2,

ρ (ε , β ) = ⎨

2

⎩c | ε | −c / 2,

• При с → ∞

• При

с→0

| ε |< c

| ε |≥ c

получаем МНК

получаем медианную регрессию

6

Робастные методы подгонки

зависимости (М-оценки)

• Бивесовая функция Тьюки

2

⎧

⎡

⎛

⎞⎤

ε

⎛

⎞

2

⎪c / 6 ⎢1 − ⎜1 − ⎜ ⎟ ⎟⎥,

ρ (ε , β ) = ⎨

⎢⎣ ⎜⎝ ⎝ c ⎠ ⎟⎠⎥⎦

⎪

2

/ 6,

c

⎩

| ε |< c

| ε |≥ c

с → ∞ получаем МНК.

• При

• Здесь практически игнорируются далекие

выбросы

7

Квантильная регрессия

• Используется, когда предметом исследования

служат не средние значения зависимой переменной

при фиксированных объясняющих, а определенные

квантили распределения

Pr ob(Y < f ( X ) | X ) = q

• При q=0.5 превращается в медианную регрессию

• Хорошо работает для асимметричных

распределений, например, при исследованиях

– финансового рынка (доли аутсайдеров среди акционеров),

– доли расходов на питание домохозяйств,

– данных о предприятиях, сильно различающихся размером

8

Непараметрическая регрессия

• Является интуитивной формализацией идеи

сглаживания «на глаз», когда линия проводится с

учетом локальных особенностей поведения У вблизи

интересующих исследователя Х

(

)

2

1

Wni ( X i ) Yi − f ( X i ) → min

∑

f (X )

n

• Ее можно интерпретировать, как локально взвешенный

МНК с весами

Wni ( X ) = K hn ( X − X i ) / K hn ( X )

1

K hn ( X − X i )

∑

n i

1

K hn (u ) =

K (u / hn ), где

hn

K hn ( X ) =

∫ K (u )du = 1

9

Непараметрическая регрессия

• hn –окно сглаживания

• K(u) – ядерная функция, может быть выбрана в

виде плотности стандартного нормального

распределения

• Достоинства: нет необходимости в строгой

спецификации модели

• Недостатки: одномерность

• Полезна для проверки точности подгонки

10

Метод наименьших квадратов

(МНК)

Зададимся вопросом о том, какими свойствами могут

обладать оценки МНК, в отсутствие каких-либо

дополнительных ограничений на поведение ошибки

ε i = Yi − f ( X i )

и введем следующую систему обозначений:

Y = Xβ + ε - уравнение регрессии, где

⎛ Y1 ⎞

⎜ ⎟

Y =⎜ # ⎟

⎜Y ⎟

⎝ n⎠

⎛ ε1 ⎞

⎜ ⎟

ε =⎜ # ⎟

⎜ε ⎟

⎝ n⎠

⎛ β0 ⎞

⎜ ⎟

β =⎜ # ⎟

⎜β ⎟

⎝ n⎠

⎛1 X 11 " X k1 ⎞

⎟

⎜

X = ⎜#

#

#

# ⎟

⎟

⎜1 X

"

X

1

n

kn

⎠

⎝

11

Вывод аналитического выражения

оценки вектора коэффициентов β МНК

Поиск min

функции

β

′

S (β ) = ∑ ε i2 = ε ′ε = (Y − Xβ ) (Y − Xβ )

i

Условие 1-го порядка

∂S (β ) ∂

(Y ′Y − β ′X ′Y − Y ′Xβ + β ′X ′Xβ ) =

=

∂β

∂β

∂

(Y ′Y − 2β ′X ′Y + β ′X ′Xβ ) = −2 X ′Y + 2 X ′Xβ = 0

=

∂β

12

Решение системы нормальных

уравнений

•

X ′Xβ = X ′Y

−1

∃ ( X ′X ) , то есть det( X ′X ) ≠ 0

Если

, то

−1

−1

′

′

′

( X X ) X Xβ = ( X X ) X ′Y

и

тогда

β МНК = ( X ′X ) X ′Y

−1

,а

′

(

)

(

)

(

)

min S β = S β МНК = Y − Xβ МНК (Y − Xβ МНК ) = ε ′ε

β

где вводят обозначения:

Y = Xβ

- вектор прогнозных значений Y и

ε = Y − Y - вектор остатков

13

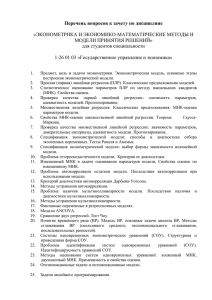

Свойства оценок МНК

• Вектор прогнозных значений Y

является проекцией вектора Y на

плоскость (в случае множественной

регрессии – гиперплоскость),

образованную столбцами матрицы

регрессоров X, и связан с Y выражением

−1

Y = Xβ = X ( X ′X ) X ′Y = PY

где

P = X ( X ′X ) X ′

−1

14

Геометрическая суть МНК для

регрессии со свободным членом

Y

εˆ

X

π

i

Yˆ

15

Свойства оператора P

1.

2.

3.

4.

Матрица оператора Р симметрична Р=Р'

Матрица оператора Р идемпотентна Р=Р²

Р – ортогональный проектор

Собственные значения оператора P –

λ(Р) = ⎧1

k +1

⎨

⎩0 n − k − 1

5. Собственные векторы оператора Р, отвечающие

λ(Р)=1,

- это столбцы матрицы регрессоров Х

16

Свойства оператора I-P

Y

По аналогии с

можно выразить в

операторном виде вектор остатков

ε = Y − Y = Y − PY = ( I − P)Y

1.

2.

3.

4.

Матрица оператора I-Р симметрична I-Р=(I-Р)'

Матрица оператора Р идемпотентна I-Р=(I-Р)²

I-Р – ортогональный проектор

Собственные значения оператора I-P –

λ(I-Р) = ⎧1 n − k − 1

⎨

k +1

⎩0

17

Дисперсионный анализ

результатов регрессии

n

n

TSS = ∑ (Yi − Y ) = ∑ yi2 = y′y

i =1

2

i =1

n

2

ESS = ∑ (Yi − Y ) = ∑ yi2 = y′y

n

i =1

i =1

n

2

RSS = ∑ (Yi − Y ) = ∑ ε i2 = ε ′ε

n

i =1

•

•

•

i =1

TSS – общая сумма квадратов отклонения наблюдаемых значений Y

от среднего значения.

ESS – сумма квадратов отклонения от среднего значения объясненных

с помощью регрессии значений .

RSS – остаточная сумма квадратов отклонения наблюдаемых значений

Y от объясненных с помощью регрессии значений

18

Проверка качества подгонки

регрессии

Очевидно, что регрессия тем лучше, чем меньше

RSS и чем больше ESS.

Более удобным критерием качества является

относительный показатель - коэффициент

детерминации:

ESS

2

R =

TSS

- доля объясненного разброса наблюдений У

0 < R <1

2

R =r

2

2

YY

19

Свойства оценок МНК, обязанные

наличию единичного столбца в

матрице Х

1.

2.

3.

4.

5.

G Сумма остатков равна 0: ∑ ε i = i ′ε = 0

i

Среднее значение наблюдаемых

Y равно среднему

значению оцененных Y: Y = Y

Точка ( X , Y ) лежит на линии регрессии

Выполняется теорема Пифагора TSS=ESS+RSS

Эквивалентны два определения коэффициента

детерминации

ESS

RSS

R =

= 1−

TSS

TSS

2

20

Свойства оценок МНК, обязанные

наличию единичного столбца в

матрице Х

Доказательство свойства 1:

G G

G

G

G G

∑ ε i = i ′ε = i ′( I − P)Y = (i ′I − i ′P)Y = (i ′ − i ′)Y = 0

i

-

G

G

i ′I = i ′ поскольку I - матрица оператора

тождественного преобразования

G

G

- i ′P = i ′ поскольку единичный вектор

является собственным вектором оператора Р,

отвечающим собственному значению λ(Р)=1

21

Свойства оценок МНК, обязанные

наличию единичного столбца в

матрице Х

• Доказательство свойства 4:

GG

ii′

если ввести еще один полезный

π =GG

оператор-проектор –

i ′i

оператор проецирования на единичный вектор,

тогда можно выразить через матрицы введенных операторов

TSS= y ′y = Y ′(I − π )′ (I − π )Y =Y'(I-π)Y

ESS= y ′y = Y ′(P − πP )′ (P − πP )Y =Y'(P-π)Y

′

RSS= ε ′ε = Y ′(I − P ) (I − P )Y =Y'(I-P)Y

22

Доказательство свойства 4:

При выводе выражения для ESS использовано

GG

GG

ii′

ii′

πP= G G P= G G =π

i ′i

i ′i

Если TSS=ESS+RSS, то

Y'(I-π)Y = Y'(P-π)Y + Y'(I-P)Y,

Раскрывая скобки получаем тождество

Y'Y - Y'πY= Y'PY- Y'πY + Y'Y -Y'PY

23

Модифицированный коэффициент

детерминации регрессии

Чем ближе R 2 к 1, тем лучше качество подгонки,

хотя надо заметить, что этот показатель всегда

механически увеличивается при добавлении нового

регрессора, даже если он никак не связан с У.

Более чувствителен к качеству регрессии

модифицированный R 2 , нормированный на

степени свободы :

n −1 R

2

2

Radj = 1 − (1 − R )

n − k −1

.

2

24

Регрессия без свободного члена

1.

2.

3.

4.

5.

Сумма остатков не равна 0

Среднее значение наблюдаемых Y не равно среднему

значению оцененных Y

Точка ( X , Y ) не лежит на линии регрессии

Не выполняется теорема Пифагора TSS≠ESS+RSS

Не эквивалентны два определения коэффициента

детерминации

R2 =

ESS

RSS

≠ 1−

TSS

TSS

25

Регрессия в отклонениях

• Теорема Фриша-Во

⎛ β1 ⎞

Если β = ⎜⎜ ⎟⎟ - оценки МНК для коэффициентов

⎝ β2 ⎠

регрессии Y на X=[X1 X2], то

β 2 - оценки МНК для коэффициентов регрессии

′ ⎞ ′

⎛

P

=

X

X

⎜

(I − P1 )X 2 на (I − P1 )Y , где 1 1 ⎝ 1 X 1 ⎟⎠ X 1

G

(I − P1 )Y = (I − π )Y = y

• Если X 1 = i , то P1 = π

(I − P1 )X 2 = (I − π )X 2 = x2

и оценки регрессии в отклонениях y = xβ + u

совпадают с оценками регрессии в уровнях Y = Xβ + ε

26

Примеры регрессионных моделей,

используемых при анализе

финансовых рынков

• Рыночная модель rit = α i + β i rIt + ε it

где rit

- доходность акции компании i в

момент времени t

rIt - доходность на рыночный индекс

Смысл

β

- чувствительность доходности

акции i к рыночной доходности

27

Примеры регрессионных моделей,

используемых при анализе

финансовых рынков

• Факторная модель

rit = α i + β1i FIt + β 2i ВВПt + β 3i INFt + ε it

• где F – доходность индекса по сектору

экономики (промышленным или

непромышленным предприятиям, например)

28

Примеры регрессионных моделей,

используемых при анализе

финансовых рынков

• CAPM – одна из наиболее важных моделей в

финансах.

• Это равновесная модель, предполагающая, что

инвесторы составляют свой портфель активов

на основании компромисса между его

ожидаемой доходностью и риском, который

измеряется дисперсией доходности.

29

CAPM

Теоретическая модель

Модель исходит из предпосылки, что

• созданный на основе изложенного принципа портфель

является эффективным, т.е. дает максимально возможную

доходность при данном риске;

• множество всех индивидуальных портфелей составляет

эффективный рыночный портфель.

Эти предположения выливаются в нижеследующее

соотношение между ожидаемой доходностью

индивидуального и рыночного портфеля, записанное в

терминах премии за риски E r − r = β E r − r

jt

f

j

mt

f

{

}

{

}

• (индивидуальный риск пропорционален рыночному риску)

30

CAPM

• Обозначения:

• r jt - рисковая доходность индивидуального актива j в

момент времени t,

• rmt - рисковая доходность рыночного портфеля m в

момент времени t,

• r f - безрисковая доходность, постоянная во времени

(обычно это доходность государственных казначейских

облигаций),

βj =

cov(r jt , rmt )

V (rmt )

- коэффициент пропорциональности,

который показывает, насколько сильны колебания

доходности актива j, связанные с оживлением на рынке в

целом. Это измеритель систематического, т.е. рыночного,

риска.

• любой другой фактор, значение которого заранее

известно инвесторам, не должен иметь существенного

влияния на доходность индивидуального актива j. 31

CAPM

• Эконометрический аналог модели

r jt − r f = β j rmt − r f + ε jt

• ошибки независимо одинаково распределены и

некоррелированы с премией за рыночный

риск.

• Интерпретация ошибки: премия за

несистематический риск.

2

β

j V {rmt }

2

2

R =

• Интерпретация R :

V {r jt }

показывает, какую долю индивидуального

риска инвестора составляет рыночный риск.

{

}

32

rit

Модель Фама и Френча

− r = β + β {r − r }+ β SMB + β HML + ε

ft

i0

i1

mt

ft

i2

t

i3

t

it

• Обозначения:

• rit - месячная доходность индивидуального актива i в

момент времени t,

• rmt - месячная доходность рыночного портфеля m в

момент времени t,

• r ft - месячная доходность государственной облигации,

• SMB – размер капитализации (разница в месячной

доходности по индексам крупных и мелких

предприятий),

• HML – отношение балансовой стоимости к рыночной

33

Домашнее задание 1

•

•

•

•

Изучить описательные статистики собранных вами

данных на предмет выявления возможных выбросов

Оценить регрессии для 3-х индивидуальных активов

и сравнить β.

Проверить гипотезу о том, что β =1

Если модель верна, то любой другой регрессор,

значение которого заранее известно инвесторам,

должен иметь незначимый коэффициент. Это

обстоятельство необходимо проверить. Самый

простой способ – включить в регрессию свободный

член или дамми-переменную, соответствующую

январю.

34

Свойства оценок МНК

(теорема Гаусса-Маркова)

Если выполнены следующие условия:

1. Модель Y = Xβ + ε верно специфицирована

2. Матрица Х – детерминирована и имеет ранг

k+1

3. Ошибка – случайный вектор с

математическим ожиданием и

ковариационной матрицей

E (ε ) = 0, V (ε ) = E [(ε − E (ε ))(ε − E (ε )) ′] = σ ε2 I

35

Свойства оценок МНК

(теорема Гаусса-Маркова)

тогда оценка МНК

−1

′

β = ( X X ) X ′Y

является наилучшей (наиболее эффективной) в

классе линейных несмещенных оценок, т.е.

она линейна по Y и по ε, E ( β ) = β

и обладает наименьшей дисперсией в классе

линейных несмещенных оценок.

36

Спасибо за внимание!

37