№1

Основы

Перестановки,

комбинаторики.

размещения

и

Правила

сочетания

без

суммы

и

произведения.

повторений.

Перестановки,

размещения и сочетания с повторениями.

Правило суммы:

Если элемент А1 может быть выбран n1 способами, элемент А2 — другими n2

способами, А3 — отличными от первых двух n3 способами и т.д., А k — n k

способами, отличными от первых ( k – 1), то выбор одного из элементов : или А1, или

А 2, …, или Аk может быть осуществлен n1 + n 2 + …+ n k способами.

Правило произведения:

Если элемент А1 может быть выбран n1 способами, после каждого такого

выбора элемент А2 может быть выбран n2 способами и т.д., после каждого (k – 1)

выбора элемент Аk может быть выбран nk способами, то выбор всех элементов А1,

А2, …, Аk в указанном порядке может быть осуществлен n1 * n 2 …nk способами.

Перестановка без повторения:

Это комбинации элементов, отличающихся только порядком их расположения.

𝑃𝑛 = 𝑛!

Размещение без повторения:

Это комбинации из n элементов по m, отличающиеся либо составом элементов,

𝑛!

либо порядком их расположения (либо и тем и другим). 𝐴𝑚

𝑛 =

(𝑛−𝑚)!

Сочетание без повторения:

Это комбинации из n-элементов по m, отличающиеся только составом элементов

𝑛!

(порядок не важен).

𝐶𝑛𝑚 =

𝑚!(𝑛−𝑚)!

Перестановка с повторением:

Это перестановка из n-элементов, когда некоторые элементы или все могут

𝑛!

оказаться одинаковыми.

𝑃𝑛 (𝑛1; 𝑛2; … 𝑛𝑘 ) =

𝑛1!𝑛2!… 𝑛𝑘 !

Размещение и сочетание с повторением:

Это комбинации из n элементов по m, когда некоторые элементы или все могут

оказаться одинаковыми.

m

̃m

Размещение с повторением: A

n =n

Сочетание с повторением:

𝑚

𝑚

𝐶̃

𝑛 = 𝐶𝑛+𝑚−1

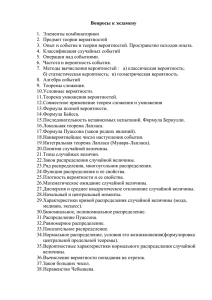

2. Определение вероятности. Случайные события, их виды. Операции над

событиями как операции над множествами. Классическая вероятностная схема.

Схема геометрических вероятностей. Статистическая вероятность. Теорема

сложения вероятностей. Обобщенная теорема сложения вероятностей.

Численная мера степени объективной возможности наступления события

называется вероятностью события.

Событие называют случайным, если оно в будущем может произойти или не

произойти. Случайные события подразделяются на следующие виды:

1.

равновозможные.

называются равновозможными,

Два

или

если условия

несколько

их

случайных

появления

событий

одинаковы

и

нет

основания утверждать, что какое-либо из них в результате испытания имеет больше

шансов осуществиться, чем другие.

2. несовместные. События называются несовместными, если в результате

испытания осуществление одного из них исключает осуществление остальных.

3.совместные. Два события называются совместными, если появление одного из

них не исключает появления другого в одном и том же испытании.

Операции над событиями как операции над множествами.

Под операциями над событиями понимаются операции над соответствующими

множествами.

Для множеств можно ввести операции, аналогичные операциям, совершаемым

над арифметическими числами.

1. Под суммой (объединением) множеств A и B (обозначение: 𝐴 ∪ 𝐵 или A+B)

понимают множество, состоящее из элементов этих множеств, т.е

𝐴 ∪ 𝐵 = {𝑥:

𝑥 ∈ 𝐴 или 𝑥 ∈ 𝐵}

2. Под произведением (пересечением) множеств A и B (обозначение: 𝐴 ∩ 𝐵 или

AB) понимают множество, состоящее из элементов, принадлежащих одновременно

обоим этим множествам, т.е. 𝐴 ∩ 𝐵 = {𝑥:

𝑥 ∈ 𝐴 и 𝑥 ∈ 𝐵}

3. Под разностью множеств A и B (обозначение: A\B) понимают множество,

состоящее из элементов A, не принадлежащих множеству B, т.е.

𝐴\𝐵 = {𝑥:

̅ 𝐵}

𝑥 ∈ 𝐴, => 𝑥 ∈

Классическая вероятностная схема.

Численная мера степени объективной возможности наступления события,

называется вероятностью событий. Условия применения: 1) исходы некоторого

события испытания образуют полную группу событий; 2) они равновозможны.

Вероятность события А равна отношению числа исходов благоприятствующих

событию А к общему числу исходов.

P(A) =

nA

n

Схема геометрических вероятностей.

Какова вероятность, что в наудачу брошенная в область G точка попадет в

область g

𝑃(𝐴) =

𝑆𝑔

𝑆𝐺

Статистическая вероятность.

Подход, основанный на том на сколько часто будет появляться то или иное

событие. Условия применения: 1) рассматриваемые события д.б. исходом испытания,

которое м.б. воспроизведено неограниченное число раз при одном и том же комплексе

условий. 2) события должны обладать статистической устойчивостью. 3) число

испытаний д.б. достаточно велико.

Статистической вероятностью события А называется относительная частота

появления этого события в n испытании.

𝑚

𝑃(𝐴) = 𝑊(𝐴) =

W(A) - относительная частота появления события А, n –

𝑛

общее число экспериментов, m – число появлений события А в этих экспериментах.

Теорема сложения вероятностей.

1. Теорема сложения вероятностей несовместных событий. Вероятность суммы

несовместных событий равна сумме вероятностей этих событий:

𝑛

𝑛

𝑃 (∑ 𝐴𝑖 ) = ∑ 𝑃(𝐴𝑖 )

𝑖=1

𝑖=1

2. Теорема сложения вероятностей двух совместных событий. Вероятность

сложения двух совместных событий равна сумме вероятностей этих событий без

вероятности их совместного появления: P(A + B) = P(A) + P(B) - P(AB).

Обобщенная теорема сложения вероятностей.

Если событие С представимо в виде суммы двух событий А и В, где А и В любые события из одного поля, то P(C)=P(A+B)=P(A) + P(B) - P(AB).

№3.

Условные

вероятности.

Условная

вероятность.

Независимость

событий. Формула полной вероятности. Формула Байеса.

Вероятность события А, вычисленная при условии, что имело место значение В,

называется условной вероятностью события А и вычисляется по формуле:

𝑃(𝐴|𝐵) =

Теорема.

𝑃(𝐴 ⋅ 𝐵)

.

𝑃(𝐵)

Вероятность произведения

2-х

событий

равна

произведению

вероятности одного из них на условную вероятность другого, вычисленную при

условии, что первое событие наступило:

𝑃(𝐴 ⋅ 𝐵) = 𝑃(𝐵) ∙ 𝑃(𝐴|𝐵) = 𝑃(А) ∙ 𝑃(В|А)

Два события А и В называются зависимыми, если вероятность одного события

зависит от того, произошло другое событие или нет.

События А и В называются независимыми, если вероятность одного события

не зависит от того, произошло другое событие или нет.

Пусть А и В – независимые события, тогда:

𝑃(𝐵|𝐴) = 𝑃(𝐵)

𝑃(𝐴 ⋅ 𝐵) = 𝑃(𝐴) ∙ 𝑃(𝐵).

Теорема. Вероятность появления хотя бы одного из двух совместных событий

равна сумме вероятностей этих событий без вероятности их совместного появления:

𝑃(𝐴 + 𝐵) = 𝑃(𝐴) + 𝑃(𝐵) − 𝑃(𝐴 ⋅ 𝐵)

Формула полной вероятности. Вероятность события А, которое может

наступить только при условии появления одного из несовместных событий

Н1 , Н2 , … , Н𝑛 , образующих полную группу событий, равна сумме каждой из гипотез на

условную вероятность события А:

𝑃(𝐴) = 𝑃(𝐻1 ) ∙ 𝑃(А|𝐻1 ) + 𝑃(𝐻2 ) ∙ 𝑃(А|𝐻2 ) + ⋯ + 𝑃(𝐻𝑛 ) ∙ 𝑃(А|𝐻𝑛 )

Формула Байеса:

𝑃(𝐻𝑖 |𝐴) =

𝑃(𝐻𝑖 ) ⋅ 𝑃(А|𝐻𝑖 )

.

𝑃(𝐻1 ) ∙ 𝑃(А|𝐻1 ) + ⋯ + 𝑃(𝐻𝑛 ) ∙ 𝑃(А|𝐻𝑛 )

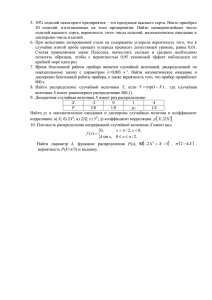

№4. Последовательность испытаний. Биномиальная схема. Формула

Бернулли. Формула Пуассона.

Последовательность испытаний – это повторение одного и того же испытания n

раз.

Биноминальный закон распределения описывает случайные величины, значения

которых определяют количество «успехов» и «неудач» при повторении опыта n раз. В

каждом опыте «успех» может наступить с вероятностью p, «неудача» — с

вероятностью q=1-p. Закон распределения в этом случае определяется формулой

Бернулли:

Формула Бернулли. Пусть в результате n-независимых испытаний, проведенных

в одинаковых условиях, событие А наступает с одинаковой вероятностью p, тогда

противоположное ему будет 1-p.

Когда вероятностью того, что в серии n-испытаний событие А появится К раз

вычисляется по формуле Бернулли:

𝑝𝒏 (𝐾) = 𝐶𝑛𝑘 ∗ 𝑝𝑘 ∗ 𝑞 𝑛−𝑘 =

𝑛!

∗ 𝑝𝑘 ∗ (1 − 𝑝)𝑛−𝑘

𝑘! (𝑛 − 𝑘)!

Формула Пуассона. Допустим вероятность события А (p→0) очень мала. При

этом число испытаний (n→∞) велико. А произведение n⋅p→λ (постоянное число).

Тогда вероятность pn(m) того, что в n – независимых испытаниях события А

появляется n раз примерно равно:

𝜆𝑚 ⋅ 𝑒 −𝜆

𝑝𝑛 (𝑚) ≈

= 𝑝𝑛 (𝜆)

𝑚!

Это табличная величина.

Условия применения:

- n→∞ (n – велико)

- λ = n⋅p ⩽ 10

5. Определение случайной величины. Понятие случайной величины.

Функция

распределения

случайной

величины.

называется

функция,

Свойства

функции

распределения.

Случайной

величиной

заданная

на

множестве

элементарных исходов Ω, т.е. X = X(S), S ∈ Ω

Случайные величины обозначаются латинскими буквами X, Y, Z, а их значения

соответственно строчными буквами: x, y, z.

Существуют дискретные и непрерывные случайные величины.

Случайная величина называется дискретной, если множество его значений

конечное (бесконечное, но счетное).

Случайная величина называется непрерывной, если множество ее значений есть

некоторый интервал числовой осси.

Функция распределения случайно величины Х называют F (x), определяющую

вероятность того, что случайная величина Х в результате испытания примет значение

меньшее чем Х.

F(x) = P (X<x)

Функция распределения существует как для дискретных так и для непрерывных

случайных величин.

Она полностью характеризует случайную величину и является одной из форм

закона распределения.

Свойство функции распределения:

1) 0 ≤ F(x) ≤ 1

2) F(x) – не убывающая функция на всей числовой прямой

F(х2) ≥ F(х1), х2 > х1

3) P ( a ≤ x ≤ b) = F(b) – F(a)

4) на -∞ функция распределения равна 0; на +∞ функция распределения равна 1.

№6. Дискретные случайные величины и их важнейшие числовые

характеристики. Дискретная случайная величина. Ряд распределения и функция

распределения дискретной случайной величины. Математическое ожидание,

дисперсия

и

среднее

квадратическое

отклонение

дискретной

случайной

величины.

Случайная величина называется дискретной, если множество его значений

конечное (бесконечное, но счетное).

Для дискретной случайной величины закон распределения может быть задан в

виде таблицы, в которой в порядке возрастания перечислены все возможные значения

случайной величины и соответствующей им вероятности.

Такая

таблица

называется рядом

распределения

дискретной

случайной

величины.

Функция распределения дискретной случайной величины Х называют функцию

F(x), определяющую вероятность того, что случайная величины Х в результате

испытания примет значение меньшее, чем х. F(x)=P(X<x)

Функция распределения любой дискретной случайной величины есть разрывная

ступенчатая функция, скачки которой происходят в точках, соответствующих

возможным значениям случайной величины, и равны вероятностям этих значений.

Одной из основных числовых характеристик дискретной случайной величины

является ее математическое ожидание.

Мат. ожиданием дискретной случайной величины Х называется сумма

произведений всех возможных значений случайной величины на их вероятности.

Мат. ожидание с точки зрения вероятности приближенно равно среднему

арифметическому наблюдаемому значению случайной величины.

Св-ва: 1. М(С)=С(константа); 2. М(С*Х)=С*М(Х); 3. Если Х и У - независимые

случайные величины, то М(Х*У)=М(Х)*М(У); 4. М(Х+/-У)=М(Х)+/-М(У); 5.

(С=М(Х)) М(Х-С)=М(Х)-С-частный случай; 6. М(Х-М(Х))=М(Х)-М(Х)=0.

Дисперсией (рассеянием) дискретной случайной величины называется мат.

ожидание квадрата отклонения случайной величины от ее мат. ожидания: D(X)=M(XM(X))^2=E(xi-M(X)^2*pi=(x1-M(X))*p1+...+(xn-M(X))^2*pn

D(X)=M(X^2)-(M(X))^2=E xi^2*pi-[M(X)]^2

средним квадратическим отклонением

σ(Х)=√𝐷(𝑋)

Св-ва: 1. Дисперсия константы равна 0. D(C)=0; 2. D(C*X)=C^2*D(X); 3. D(X+/Y)=D(X)+D(Y).

Функция распределения существует как для дискретных, так и для непрерывных

величин.

Она полностью характеризует случайную величину и является одной из форм

закона распределения.

Св-ва:

1. 0 ≤ 𝐹(𝑥) ≤ 1; 2. F(x) - неубывающая функция на всей числовой прямой

𝐹(𝑥2) ≥ 𝐹(𝑥1), 𝑥2 > 𝑥1; 3. 𝑃(𝑎 ≤ 𝑋 ≤ 𝑏) = 𝐹(𝑏) − 𝐹(𝑎); 4. На -∞ функция равна 0;

+∞ функция равна 1.

№7. Биномиальный закон распределения.

Пусть производится n независимых испытаний, в каждом из которых событие А

может появиться с одинаковой вероятностью p в каждом испытании.

Дискретная случайная величина Х имеет биномиальный закон распределения,

если она принимает значения Х=0, 1, 2, …,n с вероятностями:

𝑃𝑛 (𝑋 = 𝑘) = 𝐶𝑛𝑘 𝑝𝑘 𝑞 𝑛−𝑘 =

𝑛!

𝑝𝑘 (1 − 𝑝)𝑛−𝑘

𝑘! (𝑛 − 𝑘)!

и рассчитывается по формуле Бернулли.

Закон распределения записывается следующим образом в виде таблицы:

𝑥𝑖

𝑥1

𝑥2

…..

𝑥𝑛

𝑝𝑖

𝑝1

𝑝2

…..

𝑝𝑛

Например,

𝑥𝑖

0

…..

𝑛

𝑝𝑖

𝑝1

…..

𝑝𝑛

Свойства биномиального распределения:

M(X)=n*p

D(X) = n*p*q

№8. Закон распределения Пуассона.

Допустим, пусть производится n независимых испытаний, в которых событие А

появляется с вероятностью p.

Если число испытаний n достаточно велико, а p – достаточно мала, причем 𝑛 ∗

𝑝 = 𝜆 , тогда:

дискретная случайная величина Х имеет закон распределения Пуассона, если

она принимает значение 0, 1, 2 и т.д. с вероятностями:

𝜆𝑘 𝑒 −𝜆

𝑝(𝑋 = 𝑘) =

𝑘!

M(X) = D(X) = λ

Закон распределения случайной величины Х записывается следующим

образом в виде таблицы:

𝑥𝑖

𝑥1

𝑥2

…..

𝑥𝑛

𝑝𝑖

𝑝1

𝑝2

…..

𝑝𝑛

Например,

𝑥𝑖

0

1

…..

k

…..

𝑝𝑖

𝑝1

𝑝2

…..

𝜆𝑘 𝑒 −𝜆

𝑘!

…..

№9. Гипергеометрический закон распределения

Пусть n, m, N, M - натуральные числа

ДСВ Х имеет гипергеометрическое распределение, если она принимает значения

x=0, 1, 2,…n c вероятностями

𝑚

𝑛−𝑚

𝐶𝑀

∗ 𝐶𝑁−𝑀

𝑝(𝑋 = 𝑚) =

𝐶𝑁𝑛

№10. Непрерывные случайные величины и их важнейшие числовые

характеристики. Функция распределения и функция плотности распределения

непрерывной случайной величины

Функция распределения полностью характеризует непрерывную случайную

величину, она определяется по формуле:

𝐹(𝑥) = 𝑃(𝑋 < 𝑥)

Однако эта функция имеет недостаток, зная ее трудно судить о характере

случайной величины.

Плотностью распределения НСВ Х называется функция f(x), равная

𝑓(𝑥) = 𝐹`(𝑥)

Плотность распределения – одна из форм закона распределения, она существует

только для НСВ. Плотность для дискретной случайной величины (ДСВ) нет!

Случайная величина Х называется непрерывной, если ее функция распределения

F(X) непрерывна на всей числовой прямой оси ОХ.

Свойства плотности распределения:

1.

𝑓(𝑥) ≥ 0 на ОХ

2.

∫−∞ 𝑓(𝑥)𝑑𝑥 = 1!!!!!

3.

𝑃(𝑎 < 𝑋 < 𝑏) = ∫𝑎 𝑓(𝑋)𝑑𝑥

4.

𝐹(𝑋) = ∫−∞ 𝑓(𝑡)𝑑𝑡

+∞

𝑏

𝑋

Математическим ожиданием

НСВ Х

называется

значение

следующего

интеграла:

+∞

𝑀(𝑋) = ∫

𝑥 ∗ 𝑓(𝑥)𝑑𝑥

−∞

Дисперсия НСВ Х равна:

+∞

𝐷(𝑋) = ∫

𝑥 2 ∗ 𝑓(𝑥)𝑑𝑥 − 𝑀(𝑋)2

−∞

11. Равномерный закон распределения.

Непрерывная случайная величина имеет равномерное распределение на отрезке

(a;b), если на этом отрезке плотность распределения случайной величины постоянная,

а вне его=0.

C=

1

- константа всегда такая

𝑏−𝑎

Для того, чтобы случайная величина подчинялась закону равномерного

распределения, необходимо, чтобы её значения лежали внутри некоторого интервала и

были равновероятны.

M(X)=

1

𝑏−𝑎

𝑏−𝑎

D(X)=(

12

*

𝑏2 −𝑎2 𝑎+𝑏

=

2

2

)^2

𝑏−𝑎

σ(X)=√𝐷(𝑋)=

2√3

Вероятность попадания x в интервал [α;β]: P(α<x<β)=

𝛽−2

𝑏−𝑎

12. Показательный закон распределения.

Показательным называют распределение вероятностей непрерывной случайной

величины, которое описывается плотностью:

0, при 𝑥 ≤ 0

f(X)={ −𝜆𝑥

𝜆𝑒 , при 𝑥 ≥ 0

Показательное распределение определяется одним параметром λ. Эта

особенность распределения указывает на его преимущество по сравнению с

распределениями, зависящими от большего числа параметров.

0, 𝑥 < 0

Функция распределения показательного закона: F(X)={

1 − 𝑒 −𝜆𝑥 , 𝑥 ≥ 0

1

1

1

M(X)= ; D(X)= 2 ; σ(X)= ; P(a<x<b)= 𝑒 −𝜆𝑎 - 𝑒 −𝜆𝑏 (вероятность попадания x в

𝜆

𝜆

𝜆

интервал (a;b))

№13. Нормальный закон распределения.

Случайная величина X называется нормальной, если она подчиняется

нормальному закону распределения, т.е. ее плотность распределения задается

формулой

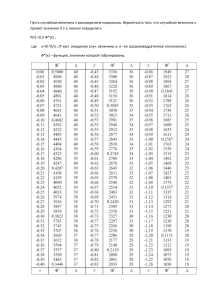

P(α<x<β)=1/2[Ф((β-а)/Ϭ)-Ф((α-а)/Ϭ)]

№14. Закон больших чисел. Неравенство Маркова

Под законом больших чисел в узком смысле понимается ряд теорем, в которых

при определенных условиях доказывается факт приближения средних характеристик

большого числа испытаний к некоторым постоянным

Неравенство Маркова

Т:пусть

случ.велич.Х

принимает

только

неотрицательные

значения,

обозначенные ее математическим ожиданием через М(Х). Тогда для любого

положительного числа А справедливо неравенство:

Р(Х>A)≤M(X)/A (1)

P(X≤A)=1-M(X)/A (2)

Замечание: Пусть М(Х) больше, чем А в этом случае М(Х)/А больше 1 и из

неравенства (1) следует, что вероятность меньше или равна числа большего единицы.

А из неравенства (2) следует, что вероятность больше отрицательного числа. То есть

получает тривиальный результат

№15. Закон больших чисел. Неравенство Чебышёва. Закон больших чисел

Под законом больших чисел в узком смысле понимается ряд теорем, в которых

при определенных условиях доказывается факт приближение средних характеристик

большого числа испытаний к некоторым постоянным.

Теорема:

Пусть х1,х2…хn- попарно независимые случайные величины, причем их Д(Х)

равномерно ограничена, тогда для любого Е>0, такого что близка к 1 вероятность

когда 𝑛 → ∞

lim 𝑃 (|

𝑛→∞

𝑥1 + ⋯ + 𝑥𝑛 𝑀(𝑋1) + ⋯ + 𝑀(𝑋𝑛)

−

| < 𝐸) = 1

𝑛

𝑛

Неравенство Чебышева

Теорема:

Для любых случайных величин Х с М(Х) и D(Х) справедливо неравенство

Чебышева при любых положительных значениях Е

𝐷(Х)

𝜀2

𝐷(Х)

Р(|Х − М(Х)| ≤ 𝜀) ≥ 1 − 2

𝜀

Р(|Х − М(Х)| > 𝜀) ≤

Замечание:

Если D(Х) больше чем Е^2, то мы получим тривиальный результат: вероятность

меньше числа большего 1 и больше отрицательного числа.

Теорема:

Пусть

случайная

величина

Х=m число

появлений

события

А

имеет

биномиальное распределение, тогда неравенство Чебышева примет вид:

М(Х)=n*p

D(X)=n*p*q

𝑃(|𝑋 − 𝑛 ∗ 𝑝| ≤ 𝐸) ≥ 1 −

𝑛∗𝑝∗𝑞

𝐸^2

𝑃(|𝑚 − 𝑛 ∗ 𝑝| ≤ 𝐸)

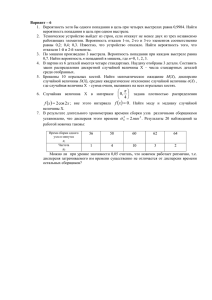

№16. Локальная и интегральная теоремы Муавра — Лапласа.

Локальная теорема Муавра-Лапласа

Если вероятность p события A

0˂p˂1, то вероятность, что в n испытаниях

события появляется n раз примерно равно Pₓ(m)≈

X=

𝑚−𝑛𝑝

√𝑛𝑝𝑞

, а f(x)=

1

√2𝜋

𝑓(𝑥)

√𝑛𝑝𝑞

𝑥²

.

*𝑒 − 2 – функция Гаусса – табличная величина!.

Замечание:

1.Функция f(x) является четной т.е f(-x)=f(x);

2. При х>4 можно считать, что f(x)≈0.

Условие применение:

1.

n-велико !!! (100 и больше)

2.

n*p*q≥20.

Интегральная теорема Муавра-Лапласа

Если вероятность p наступление событий A в каждом из n независимых

испытаний находится на промежутке от 0 до 1, то вероятность того, что n

1

независимых испытаний появится от А до B раз включительно ≈ Pₓ ( a≤m≤b)≈ [𝝋(x₂)2

𝝋(I₁).

x₁=

𝒂−𝒏∗𝒑

√𝒏∗𝒑∗𝒒

x₂=

𝒃−𝒏∗𝒑

√𝒏∗𝒑∗𝒒

𝒕²

𝒙 −

𝝋(x)=

- ∫𝟎 𝒆 𝟐 𝒅𝒕 − функция Лапласса ( интеграл вероятности Лапласса)√𝟐𝝅

𝟐

табличные величины.

Замечание:

1)

Функция Лапласа 𝝋(-х)=-𝝋(х)

2)

При х>4 можно считать 𝝋(х)≈1

Условие применение:

1)

n-велико !!

2)

n*p*q≥20 !!

№17. Основы выборочного метода. Предмет и задачи математической

статистики. Генеральная и выборочная совокупности. Случайная и конкретная

выборки. Случайная повторная и случайная бесповторная выборка.

Основы выборочного метода

Статистическое исследование может осуществляться по данным несплошного

наблюдения, основная цель которого состоит в получении характеристик изучаемой

совокупности по обследованной ее части. Одним из наиболее распространенных в

статистике методов, применяющих несплошное наблюдение, является выборочный

метод.

Под выборочным понимается метод статистического исследования, при котором

обобщающие показатели изучаемой совокупности устанавливаются по некоторой ее

части на основе положений случайного отбора.

Предмет и задачи математической задачи

Предметом математической статистики является изучение случайных явлений

или процессов по результатам наблюдений.

Задачи математической статистики:

1.Сбор, описание, систематизация и визуализация статистического материала.

2.Построение, эмпирич.функций распределений наблюдаемых случ.величин.

3.Оценка числовых значений параметров распределения.

4.Проверка статистических гипотез.

Генеральная и выборочная совокупности

Генеральная совокупность – это вся подлежащая изучению совокупность

объектов,

причем

мат.статистики

генер.совокупность

это

совокупность

всех

мыслимых наблюдений, которые могли бы быть произведены при данном комплексе

условий.

Та часть объектов которая отобрана для непосредственного обучения из

ген.совокупности называется выборочной совокупностью или выборкой.

Случайная повторная и случайная бесповторная выборка

Выборка называется повторной, если случайно отобранный для обследование

объект возвращается в генеральную совокупность перед отбором следующего объекта.

В противном случае выборка называется бесповторной.

№18.

Соотношение

между

предельной

ошибкой

выборки,

уровнем

значимости (риском) и объемом выборки. Использование этого соотношения в

организации выборочных обследований.

Предельной ошибкой выборки Д называется максимально допустимое по

модулю отклонение эмпрической характеристики от теоретической.

Риском а называется вероятность того, что модуль отклонения эмпирической

характеристики от теоретической превысит предельную ошибку тем самым

вероятность

Под теоретической характеристикой будет подразумеваться математическое

ожидание а или вероятность р, а под эмпирической характеристикой — оценка

математического ожидания или вероятности.

№19. Вариационный ряд. Интервальный вариационный ряд. Полигон

частот, кумулята

Первичной

обработкой

полученный

результатов

наблюдений

будет

их

упорядоченность (ранжирование).

Полученный ряд называется вариационным, т.е. одинаковые значения Хi

Случайной величины Х называются варианты. Варианты можно определить в группы

так, что получится последовательность пар (xi, ni). Где xi - варианта – конкретное

значение признака. А ni - частота – численность варианта. В результате получится

сгруппированный ряд, который называется дискретным статистическим рядом.

xi

x1

ni

n1

n1+n2+…nm= объем выборки

x2

n2

x3

n3

xn

nm

В статистич. ряду вместо частот записываю также частости 𝑊𝑖 =

𝑛𝑖

𝑛

– ее

называют статистич. вероятностью.

Разность между наибольшим и наименьшим значением выборки называют

размахом вариации: 𝑅 = 𝑋𝑚𝑎𝑥 − 𝑋𝑚𝑖𝑛

Если Случайная величина Х имеет большое число значений или является

непрерывной, то составляется интервальный статистический ряд.

Для этого множество значений Х разбивают на интервалы [Xнач, Х1), [X1,

X2)…[Xn, Xn-1) либо скобки наоборот (//]

Длина интервалов n находим по формуле Стерджеса ℎ =

Хнач = Хмин

𝑅

, при этом

1+3,322∗lg(𝑛)

ℎ

2

Для графического изображения статистических рядов наиболее часто

используют полигон-гистограмму и кумуляту.

Дискретный стат .ряд. – Полигон – ломанная, в которых концы отрезков имеют

координаты (xi; ni)

Интервальный стат. ряд – Гистограмма – ступенчатая фигура, состоящая из

прямоугольников с одинаковыми основаниями, равными Xi+1-Xi и высотами,

равными ni / wi / ( wi/n) плотность. Если соединить середины верхушек оснований

прямоугольников отрезками прямой, то получится полигон.

Кумулятивная кривая (кумулята) – кривая накопленных частот (частостей).

Дискретный стат. ряд- Кумулята – ломанная, соединяющая точки (xi; ni нак)

или (xi; wi нак).

Интервальный стат. ряд – Кумулята начинается с точки (x нач; 0), другие точки

ломанной соответствуют правым концам интервалов и соответствующим

накопленным частот.

20. Оценка числовых характеристик генеральной случайной величины с

помощью выборочной случайной величины. Выборочное среднее как оценка

математического ожидания. Относительная частота как оценка вероятности.

Выборочная дисперсия как оценка дисперсии.

Числовые характеристики изучаемой случайной величины Х, определенные по

выборке, называются выборочными числовыми характеристиками. Они являются

статистическими оценками генеральных числовых характеристик:

Выборочное среднее х̅ характеризует среднее значение исследуемой случайной

величины и является статистической оценкой ее истинного значения (математического

ожидания).

Мат.ожидание: M(X)= x1p1+…+xnpn

Дисперсия: D(X)=∑ 𝑥𝑖 2 ∗ 𝑝 − (𝑀(𝑋))

2

Среднее квадратическое отклонение: σ(X)= √𝐷(𝑋)

Относительной частотой события называют отношение числа испытаний, в

которых событие появилось, к общему числу фактически произведенных испытаний:

ω=m/n. Это несмещённая, состоятельная оценка для вероятности со сколь угодно

малой среднеквадратической ошибкой.

Выборочная дисперсия – это среднее арифметическое значений вариантов

части отобранных объектов генеральной совокупности (выборки).

Выборочная дисперсия при различии всех значений варианта выборки

находится по формуле: D(X)=

2

∑𝑛

𝑖−1(𝑥𝑖−𝑥̅ в)

𝑛

Квадратный корень из выборочной дисперсии характеризует рассеивание

значений вариантов выборки вокруг своего среднего значения σв(X)= √𝐷в

№21. Точечные оценки параметров. Понятие точечной оценки параметра

генеральной

совокупности.

Свойства

точечных

оценок:

состоятельность,

несмещенность, эффективность.

Выборочная

числовая

характеристика

, используемая в качестве

𝜃𝑛

приближенного значения неизвестного параметра генеральной совокупности θ

называется её точечной статистической оценкой.

Точечные

оценки

обладают

следующими

свойствами:

несмещенность,

состоятельность, эффективность.

Свойство

несмещенности:

Оценка

𝜃𝑛 генеральной характеристики θ

называется несмещенной, если для любого фиксированного числа наблюдений n

выполняется равенство: 𝑀 (𝜃𝑛 ) = 𝜃 , т.е. мат.ожидание оценки = оцениваемой

неизвестной характеристики.

Свойство состоятельности: Оценка 𝜃𝑛

генеральной характеристики θ

называется состоятельной, если она сходится по вероятности к оцениваемому

параметру:

Смысл свойства состоятельности заключается в том, что при увеличении объема

выборки растет уверенность (вероятность) в том, что отклонение оценки от

оцениваемой числовой характеристики генеральной совокупности по абсолютной

величине становится сколь угодно малой.

Свойство

эффективности:

Оценка

𝜃𝑛

генеральной

характеристики

θ

называется эффективной, если она среди всех прочих несмещенных оценок той же

самой характеристики обладает наименьшей дисперсией.

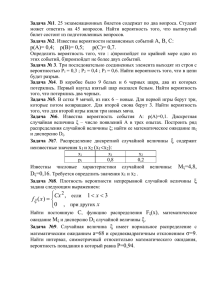

23.

Смещенность

выборочной

дисперсии

как

оценки

дисперсии

генеральной случайной величины. Исправленная выборочная дисперсия как

несмещенная и состоятельная оценка дисперсии генеральной случайной

величины.

Смещенной оценкой генеральной дисперсии служит выборочная дисперсия. Эту

величину вводят для того, чтобы охарактеризовать рассеяние наблюдаемых значений

количественного признака выборки вокруг среднего значения 𝑥в .

Выборочной дисперсией Dв есть смещенная и самостоятельная оценка

дисперсии генеральной совокупности. Это среднее арифметическое квадратов

отклонений значений выборки от выборочного среднего x в.

𝐷в =

2

∑𝑚

̅̅̅)

в ∗𝑛𝑖

𝑖=1(𝑥𝑖 −𝑥

𝑛

Выборочным средним квадратическим отклонением называется величина:

𝜎в = √𝐷в

Величина в характеризует среднее значение отклонения вариант xi от

выборочной средней xв без учета знака этого отклонения. Особенность в состоит в

том, что оно измеряется в тех же единицах, что и данные выборки.

Для устранения смещенности выборочной дисперсии ее умножают на величину

𝑛

𝑛−1

и получают 𝑆 2 =

𝑛

𝑛−1

∗ 𝐷в (используют при относительно малых объемах выборки

для компенсации ошибки).

Величину S2

называют несмещенной или

«исправленной» выборочной

дисперсией. Выборочным несмещенным («исправленным») средним квадратическим

отклонением есть не смещенная и состоятельная оценка генеральной совокупности.

Это корень квадратный из исправленной выборочной дисперсии:

𝑆в = √𝑆 2 = √

𝑛

𝑛−1

∗ 𝐷в

№24. Интервальные оценки параметров. Понятие интервальной оценки

параметра

генеральной

совокупности.

Точные

интервальные

оценки

вероятности, математического ожидания.

Интервальным оцениванием параметра θ («Тэта» - неизвестный параметр ген

совокупности) называется числовой интервал:

(1) (2)

𝜃̃𝑛 , 𝜃̃𝑛

который с заданной вероятностью гамма (γ) накрывает неизвестное значение

параметра θ.

Такой интервал называется доверительным, а p (γ) называется доверительной

вероятностью или уровнем доверия.

Наибольшее отклонение Δ выборочной средней или доли от генеральной

средней, которая возможна с заданной доверительной вероятностью γ, называется

предельной ошибкой выборки.

Ошибка Δ является ошибкой репрезентативности, то есть она возникает потому

что исследуется не вся совокупность, а только ее часть.

Для сред.

Доверительная вероятность

Для доли

𝑃(|𝑋̅ − 𝑋̅в| < ∆) = 𝜑(𝑡)

𝑃(|𝑤 − 𝑝| < ∆) = 𝜑(𝑡)

γ

t

Доверительный интервал

𝑡=

∆

𝜎𝑥̅

(𝑥̅в − ∆; 𝑥̅в + ∆)

𝑡=

∆

𝜎𝑤

(𝑤 − ∆; 𝑤 + ∆)

№25. Статистические гипотезы. Понятие статистической гипотезы. Виды

статистических гипотез.

Статистическая гипотеза – это гипотеза о виде закона распределения /

значениях числовых характеристик наблюдаемых случайных величин.

По

своему

прикладному

содержанию

гипотезы

подразделяются

на

следующие типы:

1.

О равенстве числовых характеристик генеральных совокупностей.

2.

О числовых значениях параметров.

3.

О законе распределения.

4.

Об однородности выбора (т. е. принадлежности их одной и той же

генеральной совокупности).

5.

О независимости элементов выборки.

Виды статистических гипотез:

Проверяемую гипотезу обычно называют нулевой / основной гипотезой и

обозначают Н0 . Наряду с основной гипотезой рассматривают также альтернативную /

конкурирующую гипотезу и обозначают Н1 .

Н1 — это логическое отрицание Н0 .

Основная и конкурирующая гипотезы – это 2 возможности выбора в задачах

проверки статистической гипотезы.

№26. Критерий проверки гипотезы, критическое множество. Проверка

гипотез с помощью интервальных оценок. Ошибки первого и второго родов.

Мощность критерия.

Проверяемую гипотезу обычно называют нулевой / основной гипотезой и

обозначают Н0 . Наряду с основной гипотезой рассматривают также альтернативную /

конкурирующую гипотезу и обозначают Н1 . Н1 — это логическое отрицание Н0 .

Суть проверки гипотезы заключается в том, что, используя специально

̃𝑛 (𝑥1 ; … ; 𝑥𝑛 ) полученную по

составленную выборочную характеристику (статистику) 𝜃

выборке

точное

/

приближенное

распределение

которой

известно,

находят

критическое значение 𝜃крит. такое, что если гипотеза Н0 верна, то вероятность того,

̃𝑛 > 𝜃крит. ) = 𝛼 – очень мала. Тогда, в соответствии с принципом

что 𝑃( 𝜃

практической уверенности в условиях данного исследования, можно с некоторым

̃𝑛 > 𝜃крит. – невозможно.

риском считать, что события 𝜃

Правило, по которому гипотезу Н0 отвергается / принимается, называется

статистическим критерием.

Гипотеза Н0

Принимается

Отвергается

Верна

Правильное решение

Ошибка 1-го рода

Неверна

Ошибка 2-го рода

Правильное решение

Вероятность 𝛼 допустить ошибку 1-го рода, т. е. отвергнуть гипотезу Н0 , когда

она верна, называется уровнем значимости.

Вероятность допустить ошибку 2-го рода, т. е. принять неверную гипотезу,

обозначается через 𝛽.

Вероятность (1 – 𝛽) не совершить ошибку 2-го рода, называется мощностью

критерия.

27. Проверка гипотез о значимости коэффициента корреляции.

Для того чтобы установить наличие значимой линейной связи между двумя

случайными величинами Х и Y, следует проверить гипотезу о статистической

значимости коэффициента корреляции. В этом случае используется следующая

гипотеза:

Ho : pxy = 0

H1 : pxy ≠ 0

Для проверки Н0 по выборке (x1, y1), (x2, y2), .., (xn, yn) объема n строится статистика

T=

rxy ×√n−2

√1−r2xy

где rxy - выборочный коэффициент корреляции.

При выполнении нулевой гипотезы имеет t-распределение Стьюдента с v =n-2

степенями свободы. По таблице критических точек распределения Стьюдента по

заданному уровню значимости α и числу степеней свободы n-2 определяем

критическую точку tα/2,n-2.

Если |Tнабл|< tα/2,n-2, то нет оснований для отклонения Н0. Если |Tнабл|≥ tα/2,n-2, то H0

отклоняется в пользу альтернативной Н1.

Если Н0 отклоняется, то фактически это означает, что коэффициент корреляции

статистически значим (существенно отличен от нуля). Следовательно, Х и Y коррелированы, т.е. между ними существует линейная связь.

28. Критерий согласия χ2 Пирсона. Критерий χ2 Пирсона при неизвестных

параметрах распределения

При использовании критерия Пирсона находится величина ∪ - мера расхождения,

характеризующаяся на сколько эмпирические и теоретические данные отличаются

друг от друга и ∪= 2 = ∑

(𝑛iT −ni ) (*)

nT

i

Алгоритм проверки гипотезы по критерию 2:

1) определить меру расхождения эмпирических и теоретических частот по формуле (*)

2) для выбранного уровня значимости α по таблице 2 – распределения находят

критическое значение 2кр (α;k)

α – уровень значимости

k – число степеней свободы

k=m-r-1

3) если 2расчет. < 2 , то гипотеза принимается

2расчет. > 2 , то гипотеза отвергается

№29. Ранговая корреляция. Коэффициент ранговой корреляции Спирмена.

Проверка гипотез о значимости ранговых коэффициентов корреляции.

Коэффициенты ранговой корреляции используются для измерения

взаимозависимости между качественными признаками, значения которых могут быть

упорядочены или проранжированы по степени убывания (или возрастания) данного

качества у исследуемых социальных объектов.

Коэффициент ранговой корреляции Спирмена используется для измерения

взаимосвязи между качественными признаками, характеризующими объекты одной и

той же природы, ранжированные по одному и тему же критерию. Изменяется от -1 до

+1.

где ri и Si ранги i-го объекта по переменным X и Y; n — число пар наблюдений.

При проверке значимости коэффициента корреляции в качестве основной

гипотезы h0 возьмем гипотезу «линейная корреляционная связи между переменными в

ген. совокупности отсутствует», т.е. коэффициент корреляции в ген. совокупности = 0.

При справедливости этой гипотезы статистика

𝑡=

|𝑟|√𝑛 − 2

√1 − 𝑟 2

имеет t-распределение Стьюдента с (n—2) степенями свободы.

№30. Линейная регрессия. Постановка задачи регрессионного анализа.

Парная линейная регрессия.

Задача регрессионного анализа сводится к поиску неизвестных

переменных для уравнений регрессии вида:

𝑦𝑥 − 𝑦̅ = 𝑏𝑦𝑥 (𝑥 − 𝑥̅ ) (1)

и

𝑥𝑦 − 𝑥̅ = 𝑏𝑥𝑦 (𝑦 − 𝑦̅) (2)

Для этого находим групповые средние 𝑥𝑖 и 𝑦𝑗 , и строим эмпирические линии

регрессии X по Y и Y по X. Графиком являются ломанные.

̅̅̅2 , ̅̅̅

Далее находим выборочные средние 𝑥̅ , 𝑦̅ и 𝑥𝑦

̅̅̅, и их квадраты 𝑥

𝑦2.

Находим выборочные дисперсии переменных 𝑆𝑥2 , 𝑆𝑦2 .

Считаем выборочный корреляционный момент:

𝜇 = 𝑥𝑦

̅̅̅ − 𝑥̅ ∗ 𝑦̅

Считаем коэффициент регрессии:

𝑏𝑦𝑥 =

𝜇

𝑆𝑥2

𝜇

𝑏𝑥𝑦 = 2

𝑆𝑦

Подставляем полученные переменные в соответствующие формулы (1) и (2).

Из полученных уравнений регрессий следует, что линии регрессии пересекаются

в точке (𝑥̅ ; 𝑦̅).