Сжатие данных Кудряшов Борис Давидович

реклама

Теория Информации

Кудряшов Борис Давидович

Часть 1. Измерение информации

Санкт-Петербург

2009

Клод Шеннон, 1916-2001

2

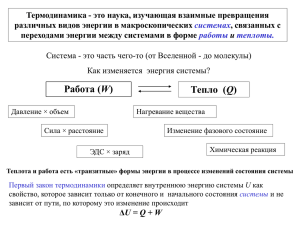

Требования к мере информация

X {x, p ( x)}

1. Неотрицательна

2. Зависит от вероятностей сообщений

3. Монотонна

4.

( p ) k ( p)

k

5. Аддитивна (для независимых сообщений)

3

Информация

X {x, p ( x)}

Ансамбль:

Информация:

Свойства:

I ( x) log 2 p( x)

I ( x) 0, x X .

p ( x) I ( x)

n

I ( x1 ,..., x n ) I ( x i ).

i 1

Маловероятные сообщения несут много информации

4

Примеры

Вероятность

Информация

1/2

1 бит

1/256

8 бит

1/3

1.585 бит

0.95

0.0740 бит

Именно столько места займут сообщения в памяти компьютера или на

компактном носителе при правильном кодировании данных

5

Энтропия

H ( X ) M log p(x) p( x) log p( x)

xX

Свойства:

H ( X ) 0.

H ( X ) log X .

Если X,Y независимы, то

H ( XY ) H ( X ) H (Y )

Чем сильнее отличаются вероятности тем меньше энтропия. Энтропия

максимальна, если сообщения равновероятны

6

Энтропия

• Доказательство

H ( X ) log X .

H ( X ) log | X | p( x) log p( x) p( x) log X

xX

xX

1

1

p( x) log

log e p( x)

1

p( x) | X |

xX

p ( x) | X |

xX

1

log e

p( x) 0.

xX | X | xX

7

Энтропия

x 1

ln x

8

Еще свойства

Если

то

Если

то

Y { y g ( x)}

H (Y ) H ( X )

P( A)

, x A,

p( x) | A |

p( x), x A.

H ( X ' ) H ( X ).

Преобразование (обработка) данных не увеличивает энтропию, а вот

выравнивание вероятностей – увеличивает!

9

Примеры

Ансамбль

Энтропия

{1/2,1/2}

1 бит

{1/256,…,1/256}

8 бит

{1/3, 1/3, 1/3}

1.585 бит

{0.05, 0.95}

0.2864 бит

Именно столько бит в среднем на одно сообщение

потребуется для передачи сообщений, выбираемых из

этих ансамблей. РОВНО СТОЛЬКО !(почти)

10

Двоичный ансамбль

H ( X ) p log p q log q h( p).

11

Выпуклые множества

Пример:

12

Выпуклые функции

• Функция, определенная на выпуклой

области R выпукла вверх, если

f (x (1 )x' ) f (x) (1 ) f (x' )

При

x, x ' R,

[0,1]

13

Выпуклые функции

14

Выпуклые функции

Следствие:

15

Признаки выпуклости

• Сумма выпуклых функций выпукла

• Произведение выпуклой функции на

положительную константу выпукло

• Линейная комбинация выпуклых функций с

положительными коэффициентами выпукла

Следствия:

• Энтропия строго выпукла

• Выравнивание вероятностей увеличивает

энтропию

16

Условная информация и энтропия

Условная информация

I ( x | y ) log p( x | y )

Условная энтропия

H ( X | Y ) M[ I ( x | y )] p( x, y ) log p( x | y )

xX yY

Самое главное свойство:

H(X |Y) H(X )

Дополнительные сведения позволяют экономить биты

17

Доказательство

18

Еще пара свойств

H ( XY ) H ( X ) H (Y | X )

H ( XY ) H (Y ) H ( X | Y ).

H ( X1... X n ) H ( X1 ) H ( X 2 | X1 ) ...

H ( X 3 | X1 X 2 ) .... H ( X n | X1,..., X n1)

19

Важное свойство

H ( X | YZ ) H ( X | Y )

Доказательство:

XYZ {( x, y, z ), p( x, y, z )}

H ( X | y , Z ) M XZ | y [ log p( x | yz )]

H ( X | y ) M X | y [ log p( x | y )]

При каждом y

H ( X | y, Z ) H ( X | y )

Осталось усреднить по у

С увеличением числа условий энтропия не возрастает

20

Невозрастание энтропии при

преобразованиях с.в.

Энтропия не изменяется при обратимом преобразовании

21

Энтропия на сообщение

Теорема

22

Доказательство A, C

A следует из невозрастания энтропии с

увеличением числа условий . Докажем С

Поскольку последнее слагаемое наименьшее,

H ( X ) nH ( X | X

n

n1

)

Отсюда следует С

23

Доказательство B

24

Доказательство D

Отсюда и из С следует D:

25

Пример. Дискретный постоянный

источник

26

Пример. Цепь Маркова

С другой стороны:

27

Теорема о типичных

последовательностях

1.

2.

n

3. n n0 , 0

4.

28

Доказательство

1: Следует из неравенства Чебышева

4: Следует из определения типичного множества

2,3: Следуют из 1 и 4:

29

Выводы

• Энтропия определяет информативность источника,

она максимальная если буквы равновероятны и

независимы

• Энтропия не изменяется при обратимых

преобразованиях сообщений

• Энтропия на сообщение стационарного источника

измеряется величиной

H ( X ) H ( X | X )

• Энтропия определяет экспоненциальную скорость

роста мощности множества типичных

последовательностей на выходе источника

30