Недостатки метода штрафных функций

реклама

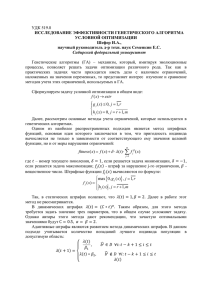

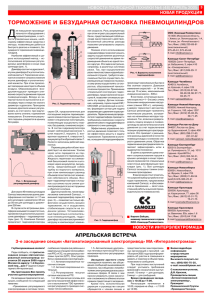

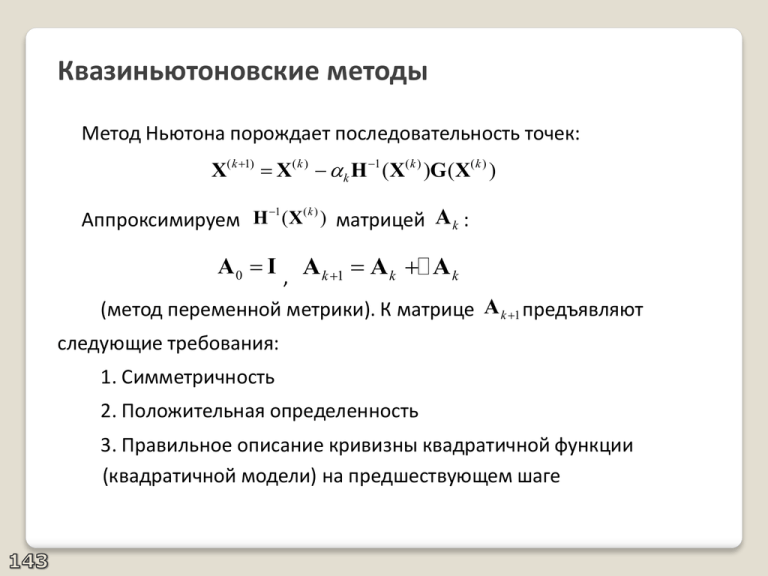

Квазиньютоновские методы Метод Ньютона порождает последовательность точек: X( k 1) X( k ) k H 1 (X( k ) )G(X( k ) ) 1 (k ) Аппроксимируем H (X ) матрицей A k : A 0 I , A k 1 A k A k (метод переменной метрики). К матрице A k 1 предъявляют следующие требования: 1. Симметричность 2. Положительная определенность 3. Правильное описание кривизны квадратичной функции (квадратичной модели) на предшествующем шаге Квазиньютоновское условие 1 2 T T Для квадратичной функции (X) 0 R X X HX : ( X( k ) ) G( X( k ) ) HX( k ) R , ( X( k 1) ) G(X( k 1) ) HX( k 1) R H( X( k 1) X( k ) ) G(X( k 1) ) G( X( k ) ) Пусть Xk X( k 1) X( k ) и по-прежнему G k G(X( k 1) ) G(X( k ) ) . Тогда H X k G k . Для неквадратичных функций по аналогии: H ( X( k ) ) X k G k , Xk H 1 (X( k ) ) G k - ньютоновское условие X k A k 1 G k - квазиньютоновское условие Определение поправки к матрице переменной метрики A k 1 A k A k Xk ( A k A k ) G k A k G k A k G k Xk Полученному уравнению удовлетворяет решение: Xk Y T A k G k ZT Ak T Y Gk ZT G k Y, Z - некоторые векторы (выбор обуславливается свойствами симметричности и положительной определенности матрицы A k 1 ) Поправочная матрица представляет матрицу ранга 1 или 2 (дефектного ранга) – один шаг дает информацию о кривизне вдоль одного направления Способы выбора векторов 1. Метод Дэвидона – Флетчера – Пауэлла Y Xk , Z A k G k Xk XTk A k G k G k T A k A k 1 Ak T Xk G k G k T Ak G k 2. Метод Бройдена Y Z Xk A k G k ( Xk Ak G k )( Xk Ak G k )T Ak 1 Ak ( Xk A k G k )T G k Метод Бройдена-Флетчера-Гольдфарба-Шэнно Bk Hk B k 1 X k G k B k 1 B k B k G k YT B k Xk ZT Bk T Y Xk ZT Xk Y G k ; Z Bk Xk ; G k G kT B k X k X k T B k B k 1 B k T G k Xk Xk T Bk Xk Можно найти соотношение между обратными матрицами вследствие дефекта ранга поправочных матриц. 1 1 Обозначая Ak Bk , Ak 1 Bk 1 Xk G Tk Xk G Tk Xk XTk A k 1 (I ) A k (I ) T T Xk G k Xk G k Xk T G k Сравнение сходимости градиентных методов 1. Метод наискорейшего спуска: линейная сходимость, может быть сколь угодно близким к единице, если матрица H плохо обусловлена 2. Методы сопряженных градиентов: достигается сверхлинейная сходимость по n шагам, а при определенных требованиях к H – квадратичная по n шагам, при условии достаточно точной одномерной минимизации 3. Квазиньютоновские методы имеют сходимость такую же, как методы сопряженных градиентов. По сравнению с последними имеют невысокие требования к точности одномерной минимизации, но предполагают существенные затраты памяти ( n 2 ) и значительный объем промежуточных вычислений ( n 2 ). Специализированные методы решения задачи о наименьших квадратах m ( X) fi 2 ( X) min i 1 Основная идея: проводится линеаризация функций F, получаем квадратичную модель для ( X) . Пусть f1 ( X) f ( X) F ( X) 2 f m ( X) (X) FT (X)F(X) min Разложим в ряд Тейлора все функции F: F( X) F( X(0) X) F0 J (X(0) ) X где F0 F(X(0) ), J ( X) - матрица Якоби. Обозначим J J ( X(0) ) 7 Метод Гаусса-Ньютона (МНК) (X) FT ( X)F( X) (F0 J X)T (F0 J X) F0TF0 2 XT J TF0 XT J T J X Находим стационарную точку квадратичной модели: 2J T J X 2J T F0 0 (J T J ) X J T F0 Если система имеет единственное решение, то получаем траекторию: X (J T J )1 J T F0 Достигается квадратичная сходимость при небольшой F0 T ( J J ) может быть вырождена или плохо обусловлена Матрица Проблемы МНК Матрица (J T J )вырождена, если число m функций F меньше числа n параметров X или, при m n , есть линейно зависимые градиенты F. В случае плохой обусловленности (J T J ) модельная квадратичная функция приобретает овражный рельеф. Линии уровня модельной функции вытягиваются, стационарная точка удаляется от начальной точки шага. При cond (J T J) линии уровня становятся параллельными. X Принятая линейная модель для F становится бессмысленной Плохая обусловленность (J T J ) Модификации МНК 1. Метод с использованием спектрального разложения ( J T J ) 2. Метод с использованием разложения Холесского ( J T J ) 3. Метод Левенберга-Марквардта (демпфированный метод наименьших квадратов) X (J T J pI)1 J T F0 p – демпфер, или демпфирующий множитель. Интерпретация демпфера 1 (X) FT (X(0) X)F(X(0) X) XT X min По-прежнему F( X) F( X(0) X) F0 J (X(0) ) X Стационарная точка определяется системой уравнений: 2J T J X 2 XT X 2J T F0 0 (J T J I) X J TF0 Демпфер имеет смысл весового коэффициента при X 2 . Увеличение демпфера приводит к повороту и уменьшению длины X . ДМНК при изменении демпфера Выбор демпфера: метод доверительной окрестности X( p) Выбор демпфера: другие способы Выбор оптимального демпфера p X (J T J 0 I )1 J T F0 Метод слежения за областью линейности X( k 1) X( k ) (J T J p 2 I)1 J TF0 1) p p0 . Расчет 2) Если 0.9 1.1 то модель близка к линейной; тогда на следующий шаг p сохраняется. Если , 1.1 то на следующий шаг демпфер р уменьшается в k раз. Если , 0.3 0.9 то на следующий шаг демпфер р увеличивается в k раз. Если 0.3 то демпфер р увеличивается в k раз, вернуться к началу шага. Методы условной оптимизации оптических систем Методы, основанные на преобразовании задачи Основная идея: исходная задача условной оптимизации преобразовывается в эквивалентную последовательность задач безусловной минимизации (ибо в одну задачу). Каждая подзадача состоит в минимизации обобщенной присоединенной, или расширенной функции: ( X, 1 , 2 ) ( X) 1(t ) P [ci ( X)] 2(t ) W [c j ( X)] min i j 1 , 2 - весовые коэффициенты (или штрафные параметры); P, W -штрафные функции; t – номер подзадачи. При нарушении ограничений функции P, W величивают свое значение, «штрафуя» функцию . Принципы выбора штрафных функций 1. Контроль ограничений равенств: P ci ( X) 0 при ci ( X) 0 2. Контроль ограничений-неравенств: 2.1. Методы внешней точки W ci ( X) 0 при ci ( X) 0 2.2. Методы внутренней точки (барьерных функций) W ci ( X) при ci ( X) 0 Сходимость: lim( 1(t ) P(ci (X *(t ) )) lim( 2(t )W (c j (X *(t ) )) 0 i, j t t Виды штрафов 1. Контроль ограничений равенств: P ci ( X) ci2 ( X) Виды штрафов Точная штрафная функция Пример использования точной штрафной функции ( x) x min 2 При ограничении x 1 0 2 ( x , ) x x 1 Расширенная функция: Минимум достигается при любых 2 Виды штрафов 2. Контроль ограничений-неравенств. Метод внешней точки W c j ( X) [c j ( X)] Оператор срезки: a 0, при a 0 a, при a 0 a 0, при a 0 2 a , при a 0 2 Виды штрафов (продолжение) 2. Контроль ограничений-неравенств. Метод внешней точки Виды штрафов (продолжение) 3. Контроль ограничений-неравенств. Методы внутренней точки - обратная функция 1 W [c j ( X)] c j ( X) - логарифмическая функция W [c j ( X)] ln c j ( X) Виды штрафов (продолжение) 3. Контроль ограничений-неравенств. Методы внутренней точки Виды штрафов (продолжение) 3. Контроль ограничений-неравенств. Методы внутренней точки Алгоритм метода штрафных функций 1. Назначение начальных весовых коэффициентов 1 1(0) ; 2 2(0) ; Метод внешней точки: 2 2 Метод внутренней точки: 2 1/ 2 2. Безусловная минимизация по X 3. Проверка условий сходимости 4. Если условия не соблюдаются, то пересчет коэффициентов: 1(t 1) k 1(t ) ; 2(t !) k 2(t ) ; k 1 (k 10) и продолжение алгоритма: X(0)(t ) X *(t1) иначе – завершение работы алгоритма. Преимущества метода штрафных функций 1. Устойчивость работы алгоритма (достижение точек, в которых не соблюдаются условия Куна-Таккера) 2. Простота реализации 3. Простота оценки множителей Лагранжа Недостатки метода штрафных функций 1. Плохая обусловленность при больших значениях 1 , 2 2 2 Функция ( x1 , x2 ) ( x1 4) ( x2 4) , ограничение x1 x2 5 Недостатки метода штрафных функций (продолжение) Недостатки метода штрафных функций (продолжение) 2. Неопределенность в величине k пересчета весовых коэффициентов 3. Проблемы одномерной минимизации в методе внутренней точки а) разрыв функций б) сильная нелинейность функции вблизи барьера