марковский источник

реклама

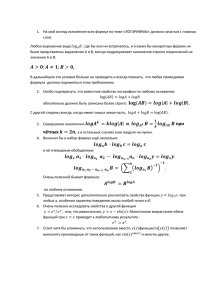

ОСНОВЫ ТЕОРИИ ИНФОРМАЦИИ Основные понятия и термины Информация относится к предельно широким понятиям информация данные сведения и т.п. Для решения инженерных задач требуется количественное определение. В теории и технике связи используется определение предложенное Клодом Шéнноном (Claude Elwood Shannon, 19162001) 2 Определение количества информации 1. Нужно абстрагироваться от физического воплощения источника сообщений 2. Нужно абстрагироваться от смыслового (семантического) содержания сообщений Тогда сообщение предстает как последовательность символов, случайная с точки зрения наблюдателя (получателя) источник сообщений a (a1,..., an ) 3 Определение количества информации источник сообщений a (a1,..., an ) n длина, ak A 1,..., K алфавит источника (K – объем алфавита) P(a) распределение вероятностей, заданное на множестве всех последовательностей произвольной длины может быть каким угодно, но способ вычисления вероятностей д.б. достаточно простым и удобным 4 Источник без памяти – простейший случай дискретного источника символы в последовательности являются независимыми, и распределение полностью определяется набором априорных вероятностей отдельных символов n P(a) P(a1,..., an ) P(a1) P(a2 )...P(an ) P(ak ) k 1 условная вероятность появления символа равна безусловной (априорной) вероятности 5 В моделях источников с памятью условная вероятность символа зависит от того, какие символы ему предшествуют. В телеграмме на русском языке после буквы «щ» можно ожидать букв «а», «у», «е», но не «ю», «я», «й» и т.п. Щ А Б В … Й … Э Ю Я 6 Условная вероятность очередного символа зависит от одного предшествующего символа марковский источник 1 порядка. Марковские источники 2, 3 и т.д. порядков. Обычно чем выше порядок учитываемых связей, тем сильнее условные вероятности символов отличаются от безусловных (пример: чем больше учитывается символов, тем вернее предсказание): …(.) в скобках может быть всё что угодно …и(.) …ни(.) …чни(.) в скобках могут быть буквы в, к, л, м, ц, с, т …очни(.) …точни(.) …сточни(.) …источни(.) в скобках может быть только буква к Далее рассматриваются источники без памяти Буквы английского языка в порядке убывания вероятностей: еtaoinhsrdlmuwycfgpbvkxjqz 7 Кодирование Информационная последовательность символов, представляющая собой сообщение, может быть заменена другой, кодовой последовательностью, состоящей из символов кодового алфавита. Целью кодирования может быть: 1.более полное использование канала связи (экономное кодирование) или 2.повышение достоверности передачи (помехоустойчивое кодирование). 3.согласование сообщения с каналом (кодирование в аппарате Бодо). 8 Кодирование Естественно, кодовые последовательности характеризуются другими распределениями вероятностей, нежели информационные последовательности. a, b, c, d ,..., z ,..., кодер 9 Дискретный канал связи X x1,..., xL Полное описание – канал связи P ( y | x) Y y1,..., yM для всех возможных x и y описывает вероятностный механизм действия помех в канале. В случае канала без памяти полностью определяется набором условных вероятностей для всех пар отдельных символов P( y j | xi ), xi X, y j Y Если количество символов не изменяется в канале, то n n P( y1 y2 ... yn | x1x2 ...xn ) P( y j | xi ) j 1 i 1 10 Информация – это свойство сообщения снимать (или уменьшать) неопределенность относительно исхода некоторого случайного опыта (например, относительно переданного символа). Количество получаемой информации, очевидно, должно быть связано со степенью снятия неопределенности. Так, получая сообщение о событии, которое достоверно известно, информации мы не получаем (неопределенности нет, и снимать нечего). 11 Требования к количественной мере информации если исход опыта единствен (достоверное событие), то количество информации в сообщении о нем должно быть равно нулю; количество получаемой информации тем больше, чем более неожиданным является исход общее количество информации в нескольких сообщениях об исходах опытов, независимых в вероятностном смысле, должно равняться сумме количеств информации в отдельных сообщениях (аддитивность информации) 12 Требования к количественной мере информации Если определить «неожиданность» сообщения то выполняется только второе требование 1/ P(a) , А если ввести логарифмическую меру, то все три: 1 log m log m P(a) P(a) m2 me m 10 [бит] [нат] [хартли] 13 Количество информации дискретного источника Поскольку событие, состоящее в выдаче сообщения, случайно и происходит с некоторой вероятностью, то и количество информации, связанное с этим сообщением, также является случайной величиной. Введем собственную информацию символа I ( i ) log p( i ) 14 Количество информации дискретного источника Информационная производительность дискретного источника – среднее количество информации на символ – математическое ожидание этой случайной величины. Для источника без памяти среднее количество информации, приходящееся на один символ энтропия K H ( ) p( k )log p( k ) k 1 Энтропия мера информативности источника сообщений 15 Основные свойства энтропии K H ( ) p( k )log p( k ) k 1 1. Энтропия любого источника неотрицательна H ( A) 0. Это следует из того, что вероятность любого события неотрицательна и не превосходит единицы 2. Энтропия равна нулю, если один из символов имеет вероятность 1, а остальные – вероятности 0. log1/ p log q 1/ q log e lim ( p log p) lim lim lim 0 1 p 0 p 0 1/ p q q q 16 3. При заданном объеме алфавита энтропия максимальна, если все символы равновероятны K H ( ) max при pk 1 k 1 Составим целевую функцию (метод неопр. мн. Лагранжа) K ( p1,..., pK ) pk log pk pk 1 k 1 k 1 K Условие экстремума pi K K pk log pk pk 1 0, i 1, K k 1 k 1 17 Условие экстремума pi K K pk log pk pk 1 0, i 1, K k 1 k 1 1 1 1 ln pi pi 0 1 ln pi 0 ln 2 pi ln 2 ln 2 Решая относительно pi получаем pi exp( ln 2 1) независимо от i, т.е. энтропия максимальна при равных вероятностях символов 18 В частности, при K=2 энтропия максимальна при вероятностях символов ½ и равна 1 биту Таким образом, 1 бит – это количество информации, доставляемое одним из двух равновероятных символов, вырабатываемых источником без памяти. 19 Совместная энтропия двух источников H ( , ) p(i , j )log p(i , j ) i j H ( , ) H (, ) ─ очевидно H ( , ) p(i ) p( j | i )log p(i ) p( j | i ) i j p(i ) p( j | i )log p(i ) i j p(i ) p( j | i )log p( j | i ) i j 20 p(i ) p( j | i )log p(i ) p(i ) p( j | i )log p( j | i ) i j i j p(i ) p( j | i ) p(i , j ) p(i ) j j тогда первое слагаемое p(i )log p(i ) H () i Второе слагаемое – условная энтропия p(i , j )log p( j | i ) H ( | ) i j 21 Совместная энтропия, таким образом, равна H (, ) H () H ( | ) H () H ( | ) Если источники статистически независимы, то H ( , ) H ( ) H () (аддитивность информации) Условная энтропия двух связанных источников канал связи рассматривается как новый источник Канал описывается набором всех условных вероятностей P( | ) Некоторые из них должны быть близки к 1, остальные к 0. 22 Количество информации в символе относительно символа i I (i ; j ) log Если j p(i | j ) p(i ) p ( i | j ) p( i ) , то 0, Если p ( i | j ) 1 , то столько информации, сколько несет символ i 23 Очевидно I ( i ; j ) log log p ( i | j ) p( j ) p ( i ) p ( j ) p( j | i ) p( i ) p ( i ) p ( j ) log log p( j | i ) p( j ) p( i , j ) p( i ) p( j ) I ( j ; i ) Это – взаимная информация символов j и i 24 Наблюдение выходной последовательности символов не снимает полностью неопределенность относительно переданного сообщения. Канал характеризуется энтропией входного алфавита при условии наблюдения выходных символов. Чем меньше эта условная энтропия, тем лучше канал передает информацию: L M H ( | ) p(i , j )log p(i | j ) i 1 j 1 25 Свойства условной энтропии 1. Если источники сообщений являются независимыми H ( | ) H ( ), H ( | ) H () p ( i | j ) p( i ) Действительно, из независимости L M L M i 1 j 1 i 1 j 1 H ( | ) p(i , j )log p(i ) log p(i ) p(i , j ) M Но p(i , j ) p(i ) j 1 L откуда H ( | ) p( i )log p( i ) H ( ) i 1 условная энтропия равна безусловной 26 Свойства условной энтропии 2. Если символы источников жестко связаны, то условная энтропия равна нулю. В самом деле, при жесткой связи в выражении некоторые условные вероятности равны 1, а остальные 0. Но как было показано выше, в этом случае сумма равна нулю. 27 Пример Пусть на входе двоичного канала действует источник с равновероятными символами 0 и 1, а искажения символов при передаче происходят с некоторыми вероятностями p0 p( y 1| x 0), p1 p( y 0 | x 1). Найдем количество информации в выходном символе относительно входного Безусловные вероятности выходных символов p( y 0) p( y 0 | x 0) p( x 0) p( y 0 | x 1) p( x 1) 1 p0 p1 2 p( y 1) p( y 1| x 0) p( x 0) p( y 1| x 1) p( x 1) 1 p1 p0 2 28 Взаимные информации 2(1 p0 ) p( y 0 | x 0) I (0;0) log log p( y 0) 1 p0 p1 p( y 0 | x 1) 2 p1 I (1;0) log log p( y 0) 1 p0 p1 2 p0 p( y 1| x 0) I (0;1) log log p( y 1) 1 p1 p0 p( y 1| x 1) 2(1 p1) I (1;1) log log p( y 1) 1 p1 p0 29 Частные (предельные) случаи а. Канал без помех p0 p1 0. I (0;0) I (1;1) 1, I (1;0) I (0;1) , энтропия источника равна 1 биту и взаимная информация входных и выходных символов равна также 1 биту при их совпадении, такой канал обеспечивает передачу информации без потерь б. «Обрыв канала» p0 p1 0.5 I (0;0) I (1;1) I (0;1) I (1;0) 0 30 Если энтропия входного источника в отсутствие передачи равна H ( ), а после приёма выходного символа она становится равной H ( | ) , то, очевидно, среднее количество передаваемой информации на символ равно разности I ( , ) H ( ) H ( | ) Это взаимная информация входа и выхода канала (на символ) H ( | ) – ненадежность, равна 0 при отсутствии помех в канале и равна энтропии источника при обрыве канала 31 Вспомним совместную энтропию H (, ) H () H ( | ) H () H ( | ) Отсюда следует I (, ) H () H ( | ) H () H ( | ) I (, ) а также H ( | ) H (, ) H ( ), H ( | ) H ( , ) H () Тогда I ( , ) I (, ) H ( ) H () H (, ) 32 Итак, среднее количество передаваемой информации на символ I ( , ) I (, ) H ( ) H () H (, ) L M L M i 1 j 1 i 1 j 1 I ( ) p(i , j )log p(i ) p(i , j )log p( j ) L M L M p(i , j ) i 1 j 1 i 1 j 1 p(i ) p( j ) p(i , j )log p(i , j ) p(i , j )log 33 Производительность источника H ' Hvп H / Tп Скорость передачи информации по каналу I ( ) I '( ) Tп Пропускная способность канала 1 C max I '( ) max I ( ) Tп P ( A) P ( A) 34