Энтропийный подход к решению задач классификации

реклама

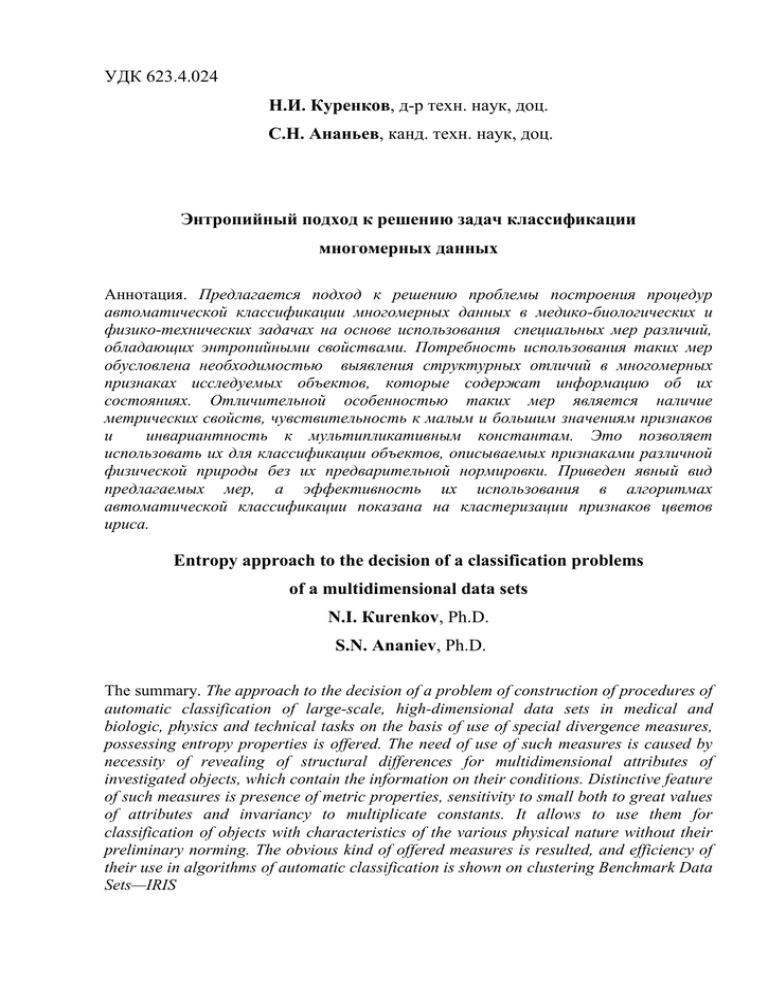

УДК 623.4.024

Н.И. Куренков, д-р техн. наук, доц.

С.Н. Ананьев, канд. техн. наук, доц.

Энтропийный подход к решению задач классификации

многомерных данных

Аннотация. Предлагается подход к решению проблемы построения процедур

автоматической классификации многомерных данных в медико-биологических и

физико-технических задачах на основе использования специальных мер различий,

обладающих энтропийными свойствами. Потребность использования таких мер

обусловлена необходимостью выявления структурных отличий в многомерных

признаках исследуемых объектов, которые содержат информацию об их

состояниях. Отличительной особенностью таких мер является наличие

метрических свойств, чувствительность к малым и большим значениям признаков

и

инвариантность к мультипликативным константам. Это позволяет

использовать их для классификации объектов, описываемых признаками различной

физической природы без их предварительной нормировки. Приведен явный вид

предлагаемых мер, а эффективность их использования в алгоритмах

автоматической классификации показана на кластеризации признаков цветов

ириса.

Entropy approach to the decision of a classification problems

of a multidimensional data sets

N.I. Кurenkov, Ph.D.

S.N. Аnaniev, Ph.D.

The summary. The approach to the decision of a problem of construction of procedures of

automatic classification of large-scale, high-dimensional data sets in medical and

biologic, physics and technical tasks on the basis of use of special divergence measures,

possessing entropy properties is offered. The need of use of such measures is caused by

necessity of revealing of structural differences for multidimensional attributes of

investigated objects, which contain the information on their conditions. Distinctive feature

of such measures is presence of metric properties, sensitivity to small both to great values

of attributes and invariancy to multiplicate constants. It allows to use them for

classification of objects with characteristics of the various physical nature without their

preliminary norming. The obvious kind of offered measures is resulted, and efficiency of

their use in algorithms of automatic classification is shown on clustering Benchmark Data

Sets—IRIS

2

В настоящее время научная деятельность в медицине, биологии, физике,

технике, информатике и других областях тесно связана с обработкой и

анализом массивов данных, которые содержат информацию об интересующих

явлениях и объектах предметной области. В ходе анализа таких данных,

например, в исследованиях и диагностике сложных технических и

биологических систем, исследователю приходится решать типовые задачи

выявления структурных особенностей в данных, которые несут информацию

о состояниях систем, а также целенаправленного поиска этих особенностей в

данных с целью идентификации искомых состояний.

Усилия многих

исследователей направлены на автоматизацию решения этих задач путем

создания эффективных математических методов и их реализации в

алгоритмах классификации, называемых «распознаванием с учителем» [1], и

алгоритмах автоматической классификации, называемых «распознаванием

без учителя» или кластеризации [1, 12]. Разработка таких методов

представляет для исследователей собой серьезную проблему, называемую

«проблемой построения процедуры классификации» [1], или «проблемой

машинного обучения» [12], центральным вопросом которой является выбор

(построение) меры различий (однородности) характеристик элементов

исследуемого множества (выборок) [14]. Рассмотрим подход к построению

меры

различий,

которая

предназначена

для

выявления

структурных

особенностей в значениях характеристик элементов исследуемых множеств, и

разработке на ее основе алгоритмов классификации с «учителем» и

автоматической классификации.

1. Постановка задачи

Пусть S {s1, s2 ,...sn} одно из исследуемых множеств. Элементы sk этого

множества

представляются

положительными

x ( x1, x2 ,...xn )

набором

характеристик

с

вещественными

значениями,

которые

соответственно

обозначим

x Rn {y ( y1 , y2 ,... yn ) | yi 0 i 1, n} . В качестве меры

3

однородности распределения у элементов sk множества

S

значений

характеристик x , совпадающих с их нормированными значениями p , можно

использовать энтропию Шеннона,

n

H pi log pi

(1)

i 1

n

где p n {q (q1 , q2 ,...qn ) | qi 1, qi 0 i 1, n} ,

(2)

i 1

поскольку

её

наибольшее

значение

достигается

на

равномерном

распределении p p 0

1

pi0 i 1, n ,

n

а

наименьшее

–

на

распределении

(3)

p p 0 i 1, n : pi0 1, p0j 0, j i ,

являющимся вырожденным.

С другой стороны энтропия позволяет оценить степень неопределенности

в результатах исходов опыта по выбору элементов sk из S с распределением

(2).

Последнее

обстоятельство

позволяет

формировать

имеющие

информационный смысл меры количества информации, которые можно

интерпретировать как меры снятия неопределенности.

В общем случае совокупность характеристик каждого элемента из S

может представлять собой многомерный массив. Совокупность самих

элементов

представим

матрицей

X,

строки

которой

соответствуют

элементам, а столбцы - их характеристикам (матрица «объект-признак» [1]). В

дальнейшем исследовании будем рассматривать матрицы X с n строками и m

столбцами, характеристики элементов которой имеют строго положительные

значения. Совокупность таких матриц обозначим через M nm .

Определим информационную меру H (p, X) для матрицы X , которая

зависит от некоторого распределения p n и значений характеристик

матрицы X . Поскольку наличие информации об элементах с различными

свойствами в X определяется разнообразием (отличием) значений их

характеристик, то вводимая мера при фиксированном распределении p

4

должна характеризовать это свойство (разнообразие значений характеристик

элементов):

чем

большее

сходство

имеют

структуры

значений

их

характеристик, тем меньшее значение она должна принимать и, наоборот, чем

больше эти структурные отличия характеристик друг от друга, тем больше её

значение. Формально это условие можно сформулировать в виде требования,

заключающегося в том, что при одинаковых значениях всех характеристик

элементов мера H (p, X) должна иметь минимальное значение, совпадающее

со значением энтропии на распределении p .

Для того, чтобы решить вопрос о существовании таких мер, расширим

множество функций неопределенности. Следуя работе [8], определим класс

функций неопределенности H , для которых выполняются следующие

аксиомы

1. Н(р) непрерывна по р n;

2. Н(р) 0 для р n, Н(р) = 0 для вырожденного распределения;

3. Н(р) унимодальна по рn, причем максимум Н(р) на n достигается

при

p10 p20 ... pn0 1 n ;

4. Н(р0) - монотонно возрастает при увеличении n;

5. Н(р) вогнута (выпукла вверх) по р n.

Очевидно энтропия Шеннона (1), информационная энтропия

n

H è (p) 1 pi2

(4)

i 1

и энтропия Реньи порядка ( 1, 0)

H (p)

n

1

log pi

1

i 1

(5)

относятся к энтропии этого типа. Энтропии (1), (4) и (5) часто используются в

анализе данных [2, 5, 7, 4, 9-11]. Например, энтропия (5) успешно

применялась для оценки числа кластеров в задачах автоматической

классификации [12, 13].

Формализуя вышеприведенные рассуждения, можно констатировать,

что вводимая мера должна удовлетворять следующему условию

min H (p, X) H (p) H

XM nm

(6)

5

Приведем примеры. Пусть матрица X совпадает с вектор-столбцом

x n , x 0 с положительными компонентами. Тогда непосредственными

вычислениями нетрудно показать, что имеют место следующие утверждения:

n

А). H (p, x) xi log pi , тогда H(p) в (7) - энтропия Шеннона.

i 1

n pi

n

В). Для H (p, x) log min

(7)

H (p, x) 2log pi .

x

n

i 1

i 1 xi

n

n

p

n

С). Для x 0 H (p, x) log pi xi i min

H

(

p

,

x

)

2log

pi . (8)

x

n

i 1 xi

i 1

i 1

Множество функций, определенных на распределениях p n и матрицах

X M nm ,

будем

называть

энтропийными

функционалами,

которые

представляют собой отображения, определенные на прямом произведении

n M nm , и ставящие каждой паре (p, X) действительное положительное

число.

Имея соотношения (6) для вектор-столбцов X j , легко построить

энтропийные функционалы для матриц X [ X1 , X 2 ,...X m ] M nm . Пусть r m

некоторое распределение, определенное на столбцах матрицы X , тогда

m

H(p, X) rj H(p, X j ) .

(9)

j 1

Легко видеть, что для (9) всегда имеет место (6).

Нас в первую очередь будут интересовать данные об элементах

множества S , которые представим как отношения характеристик этих

элементов. При таком представлении исходных данных выполняется

принципиально важное для анализа их структурных отличий условие,

заключающееся в необходимости обеспечения инвариантности процедур

обработки к мультипликативным константам. Отсюда следует, что эта мера

должна удовлетворять условию:

H (p, X) H (p, X) Rn

(10)

6

Очевидно, функционал

удовлетворяет

H (p, X) , построенный по

формулам (8, 9),

свойству (10), тем самым множество таких энтропийных

функционалов не пусто. Выпишем его в явном виде. Имеем:

m

Η1 (p, X) rj log

j 1

pT X j Xj T pT

(11)

Усреднение по столбцам можно проводить «внутри логарифма»

m

Η 2 (p, X) log rj

j1

pT X j Xj T p log pT X diag (r) XT p

(12)

1

1

Рассмотрим частные случай. При p { } и r { } из (12) следует

m

n

H 2 ( X) log(eT XX T e) log( nm)

(13)

Для матрицы X , состоящей из одного вектор-столбца x , будем иметь

H 2 ( X) log(eT XX T e) log(n)

(14)

Применим полученные результаты к решению задачи кластеризации.

Определим меру близости на множестве Rn

n

xi n

y

x R , y R , p n (x, y ) H 2 (p, x / y ) log pi pi i ,

yi i1

xi

i1

n

n

(15)

которая [5]:

симметрична -

(x, y ) ( y, x) x, y Rn

удовлетворяет неравенству треугольника в том смысле, что существует

константа c , не зависящая от компонент векторов x и y , для которой

справедливо

(x, y ) c (x, z) c (z, y ) c x, y, z Rn

(x, y ) log n x y Rn . (16)

и свойству «минимальности» - xmin

n

, yR

Именно

последнее

свойство

отличает

(15)

от

формально

строгой

(«настоящей») меры близости, которая в случае равенства x и y должна

быть равно нулю. Поскольку в задачах кластеризации важно уметь находить

вектора, доставляющие экстремальное значение используемым мерам

7

близости, то аддитивная константа log n в (16) не может повлиять на

результат кластеризации. Что касается мультипликативной константы Rn ,

то предлагаемую меру близости целесообразно использовать в задачах

кластеризации данных, представляющих собой отношения эмпирических

характеристик объектов. Это является следствием учета важнейшего

методологического требования, которым следует руководствоваться при

решении задач кластеризации: процедура кластеризации на основе таблицы

экспериментальных данных должна быть таковой, чтобы кластеризуемые

данные и результаты кластеризации не зависели от единиц измерений

эмпирических данных [6].

Успех в решении задач кластеризации во многом зависит от

эффективности

процедуры

агрегирования

признаков

(характеристик)

кластеризуемых данных, смысл которой заключается в группировании и

представлении совокупности наборов характеристик элементов объектов

некоторой обобщенной характеристикой («центром тяжести») кластера.

Пусть X некоторая выборка данных, описывающих множество

кластеризуемых объектов, представленная в виде матрицы «объект-признак».

Для

их

компактного

аппроксимировать

описания

матрицей

W,

целесообразно

состоящей

из

матрицу

X M nm

столбцов,

имеющих

одинаковую структуру значений характеристик. Пусть это будут вектор-

w Rn так, что W [w, w,...w] w eTm , где eTm - вектор-строка,

столбцы

m

состоящая из m единиц. Для удобства дальнейшего изложения представим

1

меру близости (15) для матриц с распределением весов p { } , выбирая в

n

качестве вектора х некоторую матрицу U в виде «большого» вектора, а в

качестве вектора y – матрицу V. Через операцию выделения следа матрицы

n

Sp( A) aii A (aij ) M nn формула (15) перепишется в виде (аддитивная

i 1

константа log(n) для упрощения записи опущена)

8

(U, V ) log Sp(U V T ) log Sp(V U T ) U, V M nm

(17)

T

Тогда «расстояние» от матрицы X до матрицы W w e m будет

( X, W) log Sp( X W T ) log Sp( W X T ) log Sp( X e m w T )

log Sp(w eTm X) log w T X e m eTm X T w

(18)

При m 1 (для одностолбцовой матрицы Y ) формула (18) очевидно

перепишется в виде

( X, W) log w T Y Y T w

(19)

Применяя (19) к каждому столбцу X j матрицы X можно определить меру

близости между X и W по другому:

1 (X, W) log w T X j Xj T w .

m

(20)

j 1

Или

m T

2 (X, W) log w X j Xj T w log w T X XT w

j 1

Теперь найдем «расстояние» от матрицы

(21)

X M nm до матрицы D u vT .

Аналогично (18) (с учетом аддитивной константы log(n m) ) получим

( X, D) ( X, u, v) log u T X v 1 vT X T u log(n m)

(22)

Отметим некоторые свойства меры (22).

(X, u, v) имеет место разложение по столбцам X j и

1. Для (u, v) arg umin

0, v 0

строкам Xi

m

min ( X, u, v) ( X, u, v ) 2 log u T X j X j T u log( n m)

u 0, v 0

j 1

n

2 log v T Xi XiT v log(n m)

i1

2.

uT Xv 1 uT X1v

min ( X, u, v) ( X, u, v) 2log

log(n m)

u0, v 0

2

Доказательство вытекает из экстремального представления

(23)

(24)

9

1

u T X v 1 vT XT u min

u T X v 1 vT XT u

0

(25)

2

и сводится к не сложным техническим выкладкам.

2. Алгоритм классификации, использующий предложенные меры

близости

Выявленные

метрические

свойства

энтропийных

функционалов

позволяют перейти к решению задач классификации. Рассмотрим два типа

таких задач: без «обучения» и с «обучением» [1].

При решении задач без «обучения» первая трудность, с которой

сталкивается исследователь - это разделение выборки данных на два кластера.

Покажем, как решается эта задача с помощью алгоритма, использующего

предлагаемые меры близости.

Первый шаг. Всю исследуемую совокупность данных, представленных в

виде матрицы «объект–признак»

X M nm , аппроксимируем матрицей

D u vT , которую можно интерпретировать как произведение двух агрегатов

u и v - обобщенных характеристик строк и столбцов соответственно. По

формуле

(23)

определим

вклад

каждой

строки

(характеристики

кластеризуемых объектов) в значение меры близости Li

i 1, n Li vT Xi XiT v ,

(26)

а так же значение срединного элемента массива {Li } (медиану med ).

Второй шаг. Умножим справа матрицу X на диагональную матрицу

diag (1./ v) , производя тем самым умножение каждого столбца на

соответствующее значение компоненты вектор-столбца v :

X X diag (1./ v ) .

Отметим, что при таком преобразовании вклады (26) останутся без

изменения.

10

Третий шаг. Все строки i, для которых Li med инвертируем, то есть

осуществляем переход от строки

Xi

к строке

Yi Xi1

поэлементная). И снова определяем агрегаты u и

преобразованной

матрицы

Y

(для

строк,

1

(операция

Xi

v , но уже для

которые не

подверглись

(Y, u, v) .

инвертированию, полагаем Yi Xi ). Обозначим (u1 , v1 ) umin

0, v0

Четвертый шаг. По значениям компонент векторов v и v1 строим два

вектора

q1 v v1

и

q 2 v./ v1

(операции

умножения

и

./ -

поэлементные). Указанные вектора q1 и q 2 определяют начальную итерацию

по следующей схеме.

Пятый шаг. Для каждой строки Xi с использованием формулы (21) при

m 1 определяем минимальное значение. Если это значение достигается на

векторе q1 , то строку (объект) относим в первый класс, иначе – во второй

класс.

Шестой шаг. Для каждого из двух классов строим обобщенные

характеристики, минимизируя одну из мер близости (21) или (22).

Обозначаем их через q1 и q 2 и в соответствии с шагом пять находим новое

разбиение. Если это разбиение совпадает с предыдущим шагом, то процесс

заканчиваем, иначе

процедуру разбиения продолжаем. Заметим, что

поскольку мера близости ограничена снизу и её суммарное значение на

элементах может только уменьшаться, то построенный итерационный

процесс разбиения будет всегда сходящимся.

Имея процедуру разбиения на два класса, обобщив ее, легко построить

процедуру разбиения выборки на несколько классов. Для этого оценивается

мера близости каждого из двух кластеров и выбирается тот, у которого

значение мер (21, 22) наибольшее (разнообразие его элементов выше, чем в

оставшемся). Затем этот кластер разбивается на два класса, две обобщенные

характеристики которых вместе с обобщенной характеристикой оставшегося

определяют начальную итерацию для процедуры кластеризации на три класса

11

посредством мер близости (21, 22) таким образом, как это определено выше.

В свою очередь, полученное на этом этапе начальное разбиение, аналогично

случаю двух классов, что позволяет разбить всю совокупность данных на три

кластера. Очевидно, этим методом всегда можно разбить рассматриваемую

выборку на заданное число классов.

Идейная сторона этого способа

кластеризации

именем

хорошо

известна

под

«метод

динамических

сгущений», который детально описан в работе [3]. По этой причине не будем

останавливаться на формальном описании этого метода, отсылая читателя к

указанному источнику.

При классификации «с учителем» достаточно построить обобщенные

характеристики

(эталон)

v

с

использованием

обучающих

выборок,

содержащих элементы данных объекта каждого класса, а затем вычисляя

значение меры близости (21) между каждым входным образом и каждым

эталоном, относить этот образ к тому классу, к эталону которого он «ближе».

Эталон, в общем случае, может быть сложным, т.е. состоять из нескольких

обобщенных характеристик v , которые возможно получить на каждой

обучающей выборке путем инвертирования её элементов так, как это

показано выше. В этом случае «расстояние» между входным образом и

сложным эталоном определяется минимальным значением меры (21) до

одной из обобщенных характеристик сложного эталона.

3. Оценка работоспособности алгоритма классификации, использующего

предлагаемые меры близости

Приведем несколько примеров, иллюстрирующих работоспособность

предложенного методического подхода. Для предлагаемого и известных

методов

классификации

сравним

результаты

классификации

данных,

описывающих цветы ириса, которые используются исследователями в

качестве

экзаменационных

при

оценке

эффективности

алгоритмов

классификации [14]. Задача классификации состоит в том, чтобы по данным

12

измерения длины и ширины чашелистиков и лепестков цветков ириса отнести

ирис к одному из трех типов: setosa, versicol, virginic. На сайте

http://www.ics.uci.edu/~mlearn/MLRepository.html. можно найти данные для

этого примера. Они содержат результаты измерений 150 цветков ириса по 50

для каждого типа.

Для наглядности проведем их сортировку так, чтобы

первые пятьдесят ирисов соответствовали первому классу, вторые пятьдесят –

второму классу, следующие пятьдесят - третьему классу.

Результаты автоматической классификации, представленной в виде

матрицы перепутывания P ( pij ) , где pij которой есть число ирисов i-го

класса, попавшие в j -ый класс, для двух методов - предлагаемого и

существующего метода К-средних приведены в таблице 1.

Классификации с обучением предшествовал этап построения эталонов

цветков на соответствующих им обучающих выборках («обучения»).

Эталонами цветков являлись обобщенные характеристики элементов этих

выборок, а их получение осуществлялось в соответствии с [5]. При обучении

строились два варианта эталонов: простой эталон, состоящий из одной

обобщенной характеристики элементов обучающей выборки, и сложный

эталон, - включающий две обобщенные характеристики. Сложный эталон

строился с целью обеспечения учета структурных отличий элементов в

каждой обучающей выборке. Для этого они предварительно кластеризовались

с использованием приведенного выше алгоритма, каждая на два кластера, для

которых затем строились соответствующие обобщенные характеристики.

Результаты классификации с «обучением» при использовании простого

эталона совпадали с результатами автоматической классификации и в таблице

не приводятся.

13

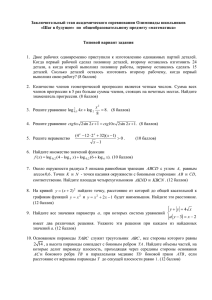

Таблица 1

Результаты кластеризации цветов ириса

Автоматическая классификация (кластеризация)

Предлагаемый метод

Метод кластеризации к-

кластеризации

средних

45

P 3

0

5

47

0

0

0

50

36 14 0

P 2 48 0

0 0 50

Классификация с обучением

Вариант эталона – сложный (две обобщенные характеристики)

Объем обучающей выборки –

все ее элементы

Объем обучающей выборки –

30% ее элементов

49 1 0

P 4 46 0

0 0 50

47 3 0

P 3 47 0

0 0 50

Как видно из таблицы, в первой задаче кластеризации процент ошибок у

предлагаемого метода в два раза ниже, чем у метода К-средних. Результаты

решения

второй задачи показывают, что при «обучении» алгоритма его

ошибки классификации составили 3,3% и 4 % (при использовании в качестве

обучающей выборки соответственно всех данных и 30% данных ирисов).

Эти результаты показывают, что предлагаемый метод позволяет

повысить эффективность автоматической классификации по сравнению с

классическим методом, а также обладает хорошими свойствами адаптации к

структуре исходных данных при «извлечении» из обучающей выборки

информации об образе объекта распознавания.

14

Литература

1. Айвазян С.А., Енюков И.С., Мешалкин Л. Д. Прикладная статистика:

Классификация и снижение размерности.- М.: Финансы и статистика,

1989.-608 с.

2. Вильсон А.Дж. Энтропийные методы моделирования сложных систем. -М.:

Наука, 1978.-247с.

3. Гоппа В.Д. Введение в алгебраическую теорию информации. -М.: Наука,

1995.-112 с.

4. Ивченко Б.П., Мартыщенко Л.А., Монастырский М.А.. Теоретические

основы информационно-статистического анализа сложных систем. СПб.:

Лань, 1997. - 320 с.

5. Куренков Н.И., Лебедев Б.Д. Энтропийный анализ многомерных данных.

//Современные проблемы механики гетерогенных сред. Сб. ИПМ РАН к

10-летию его основания. М.: РАН, 2000.

6. Лбов Г.С. Методы обработки разнотипных экспериментальных данных Новосибирск: Наука, 1981. - 158 с.

7. Плетнев И.Л. Рембеза А.И., Соколов Ю.А., Чалый-Прилуцкий В.А.

Эффективность и надежность сложных систем — М.: Машиностроение,

1977. - 216 с.

8. Трухаев Р.И. Модели принятия решений в условиях неопределенности. М.: Наука, 1981. - 258 с.

9. Цыпкин Я. З. Информационная теория идентификации. - М.: Наука, 1995.

-336 с.

10. Шеннон К.Э. Работы по теории информации и кибернетике (сборник

статей) / Под ред. Р. Л. Добрушина и О. В. Лупанов - М.: ИЛ, 1963. - 829 с.

11. Шилейко

А.В.,

Кочнев

В.Ф.,

Химушкин

Ф.Ф.

Введение

информационную теорию систем. - М.: Радио и связь, 1985.-278 с.

в

15

12. R. Jenssen. An Information Theoretic Approach to Machine Learning. A Diss.

for the Deg. of Dг. Scientiarum. Department of Physics University of Tromso,

NO-9037 Tromso, Norway, 2005 г.

13. K. Torkkola. Feature Extraction by Non-Parametric Mutual Information

Maximization. Journal of Machine Learning Research//-2003. -v.3.-p.14151438.

14. Rui Xu, D., Wunsch II. Survey of clustering algorithms// IEEE Transactions on

Neural Networks. -2005.-v.16, № 3.-р. 645.