Раздел: Теория вероятности и математическая статистика

реклама

3

1. ОСНОВНЫЕ ПОНЯТИЯ И ЗАКОНОМЕРНОСТИ ТЕОРИИ

ВЕРОЯТНОСТЕЙ.

1.1. Элементы комбинаторики.

При решении многих практических задач приходится выбирать из

некоторой совокупности объектов элементы, обладающие тем или иным

свойством, и располагать эти элементы в определенном порядке. В этих

задачах речь идет о тех или иных комбинациях элементов. Такие задачи

называются комбинаторными, а раздел математики, изучающий эти задачи

называется комбинаторикой.

Определение:

Сочетаниями из n (различных) элементов по k элементов называют

комбинации, составленные из данных n элементов по k элементов, которые отличаются друг от друга хотя бы одним элементом.

n!

k

Cn = -----------k!*(n-k)!

Пример: Дано множество {a,b,c} . Составить сочетания по 2 элемента.

3!

2

2

C3 : ab, bc, ac

;

C3 = ----------- = 3 их количество

2!*1!

Пример: В ящике 20 шаров: 12 белых, остальные черные. Сколькими

способами можно отобрать 2 белых щара?

2 черных шара? 1

черный и 1 белый шар?

1) C12

2

12!

11*12

8!

8*7

2

= ------------- = ---------- = 66 ; 2) C8 = ------------ = ---------- = 28 ;

2!*10!

2

2!*6!

2

3) C12 *

1

С81

12!

8!

= --------- * ----------- = 12*8 = 96 .

1!*11!

1!*7!

Определение:

Размещениями из n различных элементов по k элементов называют

комбинации, составленные из данных n элементов по k элементов, которые различаются между собой либо самими элементами, либо их порядком.

n!

k

An = -----------(n-k)!

Пример:

Составить для множества {a,b,c} размещения по два элемента

и определить их количество.

4

2

A3 :

ab, ac, bc

ba, ca, cb

3!

A3 = --------- = 6

1!

2

;

- их количество.

Пример : Сколько различных 3-х значных чисел можно составить из

множества цифр {1, 2, 3, 4, 5} без повторений?

5!

А53 = ------- = 60 .

(5 – 3)!

Определение:

Перестановками из n различных элементов называют множества из

данных n элементов, каждое из которых отличается от другого порядком

элементов.

Pn = n!

Пример: Составить для множества {a,b,c} перестановки и определить их

количество:

P3 = 3! = 6 :

abc, bca, cba, bac, cab, acb.

1.2. Основные понятия теории вероятностей.

Основным понятием теории вероятности является понятие случайного события.

Случайным событием будем называть событие, которое при осуществлении некоторых условий может произойти или не произойти.

Теория вероятностей изучает закономерности, которым подчиняются случайные события.

Определение: Опыт, эксперимент, наблюдение, явление в теории вероятностей называют испытанием.

Примеры испытаний в теории вероятностей – подбрасывание монеты, выстрел по мишени и т.д..

Определение: Результат, исход испытания, называют событием.

События обозначают буквами:

А, В, С, ….

Примеры:

А = {выпадание орла} ;

В = {выпадание решки}.

Классификация событий.

Определение: Событие называется достоверным, если оно неизбежно

произойдет при данном испытании.

Пример: Событие C = {выпадание числа от 1 до 6} при подбрасывании

игральной кости.

Определение: Два события называются несовместными, если появление

одного из них исключает появление другого в одном и том же

испытании.

5

Пример: Выпадание «орла» или «решки» при подбрасывании монеты.

Определение: Два события А и В называют противоположными, если в

данном испытании они несовместны и одно из них обязательно

происходит (обозначают А и А ).

Пример: При выстреле по мишени противоположны:

А = {попадание}

и

А = {промах}.

Определение: Суммой двух событий “А” и “В” называют событие “С”,

состоящее в наступлении или события “А”, или события “В”.

Пример:

По мишени стреляют два стрелка одновременно.

А = {попадает первый стрелок},

В = {попадает второй стрелок},

С = А+В = {попадает в мишень хотя бы один из стрелков}.

Определение: Произведением двух событий “А” и “В” называют событие

“С”, состоящее в том, что события “А” и “В” произойдут одновременно.

Пример:

С = А*В = {попадают в мишень и первый и второй стрелок}.

Определение: Относительной частотой случайного события называют отношение числа m появлений события к общему числу n проведенных одинаковых испытаний.

m

*

P (A) =

.

n

Пример: Проводится 6 серий выстрелов. Относительная частота события

А = {попадание в мишень}:

в первой серии испытаний

P*1(A) = 4/10,

во второй

P*2(A) = 8/15,

в третьей

P*3(A) = 13/25,

в четвертой

P*4(A) = 27/50,

в пятой

P*5(A) = 51/100,

в шестой

P*6(A) = 74/150.

Опыт показывает, что относительная частота событий стремится к

некоторому числу P. Это число P в дальнейшем будем называть вероятностью события A. Для рассмотренного примера серий выстрелов P*(A)1/2.

1.3.

Классическое определение вероятности.

Возможные, исключающие друг друга результаты данного испытания будем называть элементарными событиями.

Определение:

Вероятностью события А ( P(А) ) называют отношение

числа m благоприятствующих исходов к общему числу n элементарных испытаний.

6

m

P(A) = ------ .

n

P(A) = 1, если

A - достоверно

P(A) = 0, если

A – невозможно

Очевидно в общем случае

0 P(A) 1 .

Пример:

Монета подбрасывается 2 раза. Найти вероятность того, что

оба раза выпадает герб? Событие А={два раза выпадает герб}

гг; гр; рг; рр

- 4 возможных исхода

гг

- 1 исход благоприятен ,

P(A) = 1/4.

Пример: Из колоды в 36 карт извлекают одну карту. Какова вероятность,

что эта карта дама?

B={извлекли даму}.

Возможных исходов

- 36

Благоприятных исходов

-4

P(B) = 4/36 = 1/9.

1.4. Сложение вероятностей.

События образуют полную группу событий, если при каждом испытании может появиться любое из них и не может появиться какое-либо

иное событие, несовместное с ними.

Теорема: Вероятность суммы двух несовместных событий равна сумме

вероятностей свершения каждого из этих событий.

P(A+B) = P(A) + P(B).

Доказательство: События A и B несовместны.

Пусть

ma

P(A) = ----n

,

mb

P(B) = ------ .

n

Т.к. события А и В несовместны, то число благоприятствующих случаев одновременного появления событий А и В равно нулю, а число случаев благоприятствующих повлению событий А или В равно ma + mb, тогда, по классическому определению вероятности:

ma + mb

ma

mb

P(A+B) = ------------- = ------- + ------ = P(A) + P(B) .

n

n

n

Теорема доказана.

Следствие 1: Если имеются А1, А2, А3, …., Аn несовместных событий, то

вероятность суммы этих событий равна сумме вероятностей каждого из этих событий.

P(А1+А2+А3+….+Аn) = P(А1)+P(А2)+….+P(Аn)

Пример: В ящике имеются 10 белых, 15 черных, 20 синих и 25 красных

шаров. Из ящика достают один шар.

Найти вероятность следующего события:

7

A = {из ящика достают белый или черный шар}.

Событие А представим как сумму двух несовместных событий:

A = A1 + A2 , где

A1 = {из ящика достают белый шар} ,

A2 = {из ящика достают черный шар} .

P(A1+A2) = P(A1) + P(A2) = 10/70 + 15/70 = 5/14 = 5 / 14 .

Следствие 2: Сумма вероятностей противоположных событий равна 1.

P(A) + P(A) = 1.

Доказательство: Поскольку А и А противоположные события, то сумма

событий А + А – является событием достоверным, а вероятность

достоверного события равна единице. Поэтому

P(A+ A) = P(A) + P( A ) = 1 .

Пример: Вероятность того, что день ясный равна 0,8. Какова вероятность

того, что день будет пасмурным?

A = {день ясный}

A = {день пасмурный}

P( A ) = 1 - P(A) = 1 – 0,8 = 0,2 .

Следствие 3: Сумма вероятностей событий образующих полную группу

равна 1.

Доказательство: Пусть А1, А2, А3, …., Аn – образуют полную группу событий. Тогда сумма этих событий есть событие достоверное и его

вероятность равна 1. Следовательно

P(А1+А2+А3+….+Аn) = P(A1) + P(A2) + P(A3) +…. + P(An) = 1 .

1.5. Геометрические вероятности.

Чтобы избежать недостатка классического определения вероятностей, состоящего в том, что оно неприменимо при испытаниях с бесконечным числом исходов, вводят понятие геометрической вероятности, т.е. вероятности попадания точки в заданную область, на заданный отрезок.

Пусть отрезок l является частью отрезка L . На отрезок L наугад

ставят точку. Вероятность попадания точки на отрезок l пропорциональна

его длине и не зависит от расположения отрезка на большом отрезке L.

длина l

Вероятность попадания точки на отрезок l

P = ------------- .

Длина L

Аналогично вводится геометрическая вероятность для плоских фигур. Пусть фигура g является частью фигуры G. Тогда

8

вероятность попадания точки в область фигуры g

площадь g

P = -----------------площадь G

Пример:

В сигнализатор поступают сигналы от двух устройств. Поступление каждого из сигналов равновозможно в любой момент

промежутка времени Т. Моменты поступления сигналов не зависят

друг от друга. Сигнализатор срабатывает, если разность между моментом поступления сигналов меньше t. Найти вероятность того,

что сигнализатор сработает за время Т, если каждое из устройств

пошлет по сигналу.

Решение: Обозначим через x, y моменты поступления сигналов, при

этом:

0 x T, 0 y T .

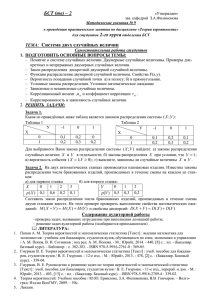

y

C

T

y=x+t

B y=x

y=x-t

O

A

x

T

Областью G является квадрат OABC. Сигнализатор сработает,

если x-y<t

при x y,

и

если y-x<t

при x < y.

Область g будет задана:

y>x-t

y<x+t

,

,

при x y,

при x < y.

Тогда по определению

T2 – (T – t)2

P = --------------- .

T2

1.6. Условные вероятности.

Случайным событием мы называем событие, которое может произойти либо не произойти. Если при этом существуют некоторые дополнительные условия, то при вычислении вероятности накладываются дополнительные ограничения и вероятность при этом называется условной

(иначе безусловной).

Например, требуется вычислить вероятность события А, но при условии,

что событие В уже произошло.

9

Пример: В ящике 3 белых и 3 черных шара. Из ящика извлекают 2 шара.

Найти вероятность появления белого шара при втором испытании,

если при первом испытании был извлечен черный шар:

А = {первый шар черный}

В = {второй шар белый}. При извлечении второго шара в ящике всего пять

шаров, при этом три из них белых, поэтому

PA(B) = 3/5 .

P(A*B)

Иначе вероятность можно вычислить:

PA(B) =------------ (без доказательства).

P(A)

Проверим на примере ( при этом примем во внимание, что общее число

исходов равно числу размещений из шести по два):

P(A) = 3/6 = 1/2; P(A*B) = m/n , n=A62 = 6!/4! = 30,

P(A*B) = 9/30 = 3/10, исходя из этого:

m=3*3 = 9,

3/10

PA(B) = --------- = 3/5 .

1/2

1.7. Теорема умножения.

Теорема: Вероятность совместного появления двух событий равна произведению вероятности одного из них на условную вероятность другого, вычисленную при условии, что первое событие уже произошло.

P(A*B) = P(A)* PA(B) или

P(A*B) = P(B)* PB(A) .

Из теоремы следует:

P(A)* PA(B) = P(B)* PB(A) .

Следствие: Вероятность совместного появления нескольких событий

равна произведению вероятности свершения одного из них на

условные вероятности всех оставшихся, причем вероятности последующих событий вычисляются в предположении, что все

предыдущие события уже произошли.

P(А1*А2*А3*….*Аn) = P(A1)*PA1(A2)*PA1A2(A3)*….*PA1A2A3…An-1(An) .

Пример: В корзине 5 белых, 4черных и 3 синих шара. Событие состоит

в том, что из корзины наугад извлекают 1 шар без возврата. Найти

вероятность последовательности событий, которая состоит в том,

что при первом испытании извлечен белый шар, при втором – черный, при третьем – синий.

А = {б.}

,

В = {ч.}

,

С = {син.} .

P(ABC) = P(A)*PA(B)*PAB(C) = 5/12 * 4/11 * 3/10 = 1/22

10

1.8. Независимые события. Теорема умножения для независимых

событий.

Определение: Событие В называется независимым относительно события

А, если появление события А не изменяет вероятность появления

события В, т.е. выполняется следующее равенство.

PA(B) = P(B)

Условие независимости является взаимным для события B.

P(A)*PA(B) = P(B)*PB(A),

P(A)*P(B) = P(B)*PB(A)

,

то

P(A) = PB(A).

Теорема: Вероятность совместного появления двух независимых событий

равна произведению их вероятностей.

P(AB) = P(A)*P(B).

Доказательство: P(AB) = P(A)*PA(B) = P(A)*P(B) .

Теорема доказана.

Пример: Найти вероятность поражения цели двумя орудиями, если для

первого орудия вероятность попадания P1 = 0.8, а для второго

P2 = 0.9

А = {попадает первое} ,

В = {попадает второе}.

P(AB) = P(A)*P(B) = 0,8*0,9 = 0,72 .

Определение:

Несколько событий называются попарно независимыми, если каждые два из них независимы.

Определение: Несколько событий называются независимыми в совокупности, если независимы каждые два из них и независимы каждое

событие и все возможные произведения остальных.

События A1, A2, A3 независимы в совокупности, если независимы

A1 и A2 , A2 и A3 , A3 и A1 , а также A1 и A2*A3 , A2 и A1*A3 , A3 и A1*A2 .

В практических заданиях независимость событий определяется по

смыслу задач.

Следствие: Вероятность произведения нескольких событий, независимых

в совокупности, равна произведению вероятностей данных событий.

P(A1A2…An) = P(A1)*P(A2)*….*P(An) .

1.9. Вероятность появления хотя бы одного события.

Теорема: Вероятность появления хотя бы одного из событий A1, A2, …,

An независимых в совокупности, равна разности между единицей

и произведением вероятностей противоположных событий:

P(A) = 1 - P(A1)*P(A2)*….*P(An)

11

Доказательство: Событие А состоит в том, что происходит хотя бы одно

из событий A1, A2, … , An. В этом случае А и A1, A2, …An будут

противоположными, т.е.

P(A) + P( A1*A2*А3*…*An) = 1 .

Тогда P(A) = 1 - P(A1)* P(A2)*…. *P(An) .

Пример: Вероятности попадания в цель при стрельбе каждого из трех орудий, соответственно равны

P1 = 0,8; P2 = 0,9; P3 = 0,7 .

Вычислить вероятность того, что в цель попадает хотя бы одно из орудий.

Решение. Обозначим события следующим образом:

A1 = {в мишень попадает первое орудие},

A2 = {в мишень попадает второе орудие},

A3 = {в мишень попадает третье орудие},

A = {в мишень попадает хотя бы одно орудие}.

1)

P(A) = 1 - P(A1)*P(A2)*P(A3) = 1 – 0,2*0,1*0,3 = 1 – 0,006 = 0,994 .

Можно иначе:

2) A = A1*A2*A3 + A1*A2*A3 + A1*A2*A3 +A1*A2*A3 + A1*A2*A3 +

+ A1*A2*A3 + A1*A2*A3 .

1.10. Теорема сложения вероятностей совместных событий.

Теорема: Вероятность появления хотя бы одного из двух совместных событий равна сумме вероятностей этих событий без вероятности их

совместного появления.

P(A+B) = P(A) +P(B) – P(A*B) .

Доказательство: Так как А и В совместны, то А + В наступает, если

наступит хотя бы одно из следующих событий А*В, А*В, А*В, тогда по теореме о вероятности суммы несовместных событий вероятность события А + В будет равна сумме вероятностей

P(A+B) = P(A*B) + P(A*B) + P(A*B)

Событие А происходит в том случае, если происходит хотя бы одно из

следующих событий А*В и

А*В, то

P(A) = P(A*B) + P(A*B) => P(A*B) = P(A) – P(A*B) ,

аналогично

P(B) = P(A*B) + P(A*B) => P(A*B) = P(B) – P(A*B) =>

P (A+B) = P(A*B) + P(B) – P(A*B) + P(A) – P(A*B) = P(A) + P(B) – P(A*B).

12

Пример: Два стрелка стреляют одновременно, вероятности попадания в

мишень каждого из них равны соответственно P1 = 0,2

;

P2 = 0,8.

Найти вероятность того, что в мишень попал хотя бы один.

События А = {попал первый стрелок}; В = {попал второй стрелок}.

1)

P(A+B) = P(A) + P(B) – P(A*B) = 0,2 + 0,8 – 0,2*0,8 = 0,84 .

Можно иначе:

2)

P(A+B) = P(A*B) + P(A*B) + P(A*B)

0,2*0,2 + 0,8*0,8 + 0,2*0,8 = 0,04+0,64+0,16 = 0,84 .

1.11. Формула полной вероятности.

Пусть событие А может произойти при условии, что произошло одно

из несовместных событий H1, H2, … Hn, которые называют гипотезами.

Эти события должны образовывать полную группу событий.

Теорема: Вероятность события А, которое может наступить лишь при

условии появления одного из событий H1, H2, … Hn, равна сумме

произведений вероятностей каждого из них на соответствующую

условную вероятность события А, т.е.

P(A) = P(H1)*PH1(A) + P(H2)*PH2(A) + …..+ P(Hn)*PHn(A) .

Доказательство: По условию теоремы событие А может наступить, если

наступит одно из несовместных событий Н1, Н2,…., Нn. Следовательно по теореме о сумме и произведении вероятностей

A = A*H1 + A*H2 + …+ A*Hn ,

откуда

P(A) = P(H1)*PH1(A) + P(H2)*PH2(A) + …..+ P(Hn)*PHn(A) и т.д.

Пример: Есть два набора деталей одинаковых по количеству. Вероятность

того, что деталь 1-го набора стандартна равна 0,9; второго - 0,8.

Найти вероятность того, что наугад взятая деталь оказалась стандартной.

Решение:

A = {деталь стандартная},

H1 = {выбран первый набор деталей} ,

H2 = {выбран второй набор деталей} .

Тогда P(A) = P(H1)*PH1(A) + P(H2)*PH2(A) ,

P(H1) = 1/2 ,

P(H2) = 1/2,

PH1(A) = 0,9

Таким образом

,

PH2(A) = 0,8.

P(A) = 1/2 * 0,9 + 1/2 *0,8 = 0,85 .

1.12. Формула Байеса.

Пусть событие А может наступить при условии, что происходит одно из несовместных событий Н1, Н2,…., Нn. Предположим, что событие А

уже произошло и вычислим условные вероятности PA(H1), PA(H2), …,

PA(Hn).

По теореме умножения вероятностей

13

P(A* H1) = P(A)* PA(H1) = P(H1)*PH1(A) =>

P(H1)*PH1(A)

P(H1)*PH1(A)

=> PA(H1) = ----------------- = ------------------------------------------------------------- .

P(A)

P(H1)*PH1(A) + P(H2)*PH2(A) + ..+ P(Hn)*PHn(A)

Пример: Цех изготавливает детали. Их проверяют два контролера. Вероятность того, что деталь попадает к первому контролеру равна 0,6,

ко второму – 0,4. Вероятность того, что деталь признана стандартной первым контролером – 0,94 , вторым – 0,98.

Деталь при проверке оказалась стандартной.

Найти вероятность того, что ее проверял первый контролер.

Решение:

A = {деталь стандартная},

H1 = {деталь проверял первый контролер},

H2 = {деталь проверял второй контролер }.

Тогда

P(H1)*PH1(A)

0,6*0,94

PA(H1) = ----------------------------------- = -------------------------- = 0,589998 .

P(H1)*PH1(A)+P(H2)*PH2(A) 0,6*0,94+0,4*0,98

1.13. Повторные испытания. Формула Бернулли.

Если проводится несколько испытаний, причем вероятность события

А в каждом испытании не зависит от исходов других испытаний, то такие

испытания называются независимыми относительно события А.

Пусть в независимых испытаниях событие А имеет одну и ту же вероятность. Проводится n независимых испытаний, в каждом из которых

событие А может произойти и не произойти.

Вероятность события А в каждом испытании равна числу p, а вероятность ненаступления события А равна числу q = 1 – p .

Вычислим вероятность того, что в n испытаниях событие А произойдет ровно k раз - Pnk(A). Эта вероятность вычисляется по формуле

Бернулли.

Вероятность одного сложного события, состоящего в том, что в n

испытаниях событие А произойдет ровно k раз и не наступит n – k раз по

теореме умножения вероятностей независимых событий будет равна

pk * qn-k .

Таких событий будет столько, сколько можно составить сочетаний из n по

k

-

(Cnk ) .

Т.к. сложные события будут несовместны, то по теореме сложения вероятностей

Pnk(A) равна сумме вероятностей этих сложных событий

Pnk(A) = Cnk * pk * qn-k .

14

Пример: Пусть нам требуется вычислить вероятность того, что в четырех

независимых испытаниях событие А должно произойти 3 раза .

P43(A) = C43*p3*q

, где A = AAAA + AAAA + AAAA + AAAA .

Пример: Монета подбрасывается 10 раз. Найти вероятность того, что герб

выпадает 2 раза.

А = {герб} ,

n = 10,

k=2 ,

p=1/2

,

q=1/2

P102(A) = C102*(1/2)2*(1/2)8 = 45/1024 .

Пример: Проводится 8 независимых испытаний в каждом из которых вероятность события А равна 0,1. Найти вероятность того, что события

А в 8 испытаниях появится хотя бы 2 раза.

p = 0,1

,

q=0,9 ,

n=8.

Найдем вероятность противоположного события

P80(A)+P81(A) = C80*0,10*0,98+C81*0,11*0,97 = 1,7*0,97

Ответ:

1 - 1,7*0,97

1.14. Локальная теорема Лапласа.

Пользоваться формулой Бернулли при больших значениях n затруднительно. Поэтому в том случае, когда число независимых испытаний n

велико пользуются формулой Лапласа.

Теорема: Если вероятность появления события А в каждом испытании постоянна и отлична от нуля и единицы, то вероятность события, состоящего в том, что в n независимых испытаниях событие А произойдет ровно k раз приблизительно равна:

1

k

Pn (A) ---------------- * (x), где

x = (k-n*p)/ n*p*q .

n*p*q

Функция (x) табулирована. Функция четная (x) = (-x) .

Пример: Найти вероятность того, что при 400 испытаниях событие А

наступит ровно 104 раза, если дано, что вероятность появления события А в каждом отдельном испытании равна 0,2.

n = 400,

q = 0,8

,

p = 0,2

,

k = 104.

P400

104

1

(A) = --------------------- * ((104-400*0,2) / 400*0,2*0,8) =

400*0,2*0,8

= 1/8*(3) = 0,0044

15

1.15. Интегральная теорема Лапласа.

Теорема: Если вероятность p появления события А в каждом испытании

постоянна и отлична от нуля и единицы, то вероятность того, что

событие А появится в n испытаниях от k1 до k2 раз вычисляется

по следующей формуле:

k2 –n*p

Pn(k1 k k2) ------------- n*p*q

k1 –n*p

- ----------------- ,

n*p*q

где (x) – функция Лапласа. Значения данной функции находятся по таблице. Функция четная - (x) = ( -x). Для x 5 значение функции

Лапласа равно 0,5.

Пример: Вероятность поражения мишени стрелком при 1 выстреле равна

0,75. Найти вероятность того, что при 100 выстрелах мишень будет

поражена не менее 70 и не более 80 раз.

n = 100,

q = 0,25

,

p = 0,75

,

k1 = 70 ,

k2 = 80.

80-100*0,75

70-100*0,75

P100(70 k 80) ----------------------- - ---------------------- =

100*0,75*0,25

100*0,75*0,25

= (5/4,33) - (-5/4,33) = 2*(1,15) = 2*0,0749 = 0,1498 .

2. СЛУЧАЙНЫЕ ВЕЛИЧИНЫ.

2.1. Понятие случайных величин.

Мы рассматриваем события, состоящие в появлении того или иного

числа, например при бросании игральной кости может появиться число

очков от 1 до 6. Заранее определить число очков невозможно, поскольку

оно зависит от многих случайных факторов. В этом случае число очков

есть величина случайная, а числа 1,2, 3, 4, 5, 6 – возможные значения данной величины.

Определение: Случайной называют величину, которая в результате испытания принимает только одно возможное значение, заранее неизвестное и зависящее от случайных причин.

Случайные величины обычно обозначаются большими латинскими буквами, а их значения – малыми.

Определение: Дискретной случайной величиной (ДСВ)называют величину,

которая принимает отдельные изолированные значения.

Пример: Рассмотрим случайную величину Х – число очков при бросании

игральной кости. x = 1, 2, 3, 4, 5, 6.

Определение: Непрерывной случайной величиной называют величину, которая принимает все возможные значения из некоторого конечного или бесконечного интервала.

16

Пример: Рассмотрим случайную величину Y – температура в Новгороде

зимой. Y(-350C, +100C).

2.2. Законы распределения вероятностей для ДСВ .

Определение: Законом рапределения вероятностей ДСВ называют соответствие между возможными значениями величины и их вероятностями.

Закон распределения можно задавать либо аналитическим, либо табличным, либо графическим способами.

X

x1

x2

x3

……

xn

P

P1

P2

P3

……

Pn

P1 = P(Х = x1) , P2 = P(Х = x2) , ……., Pn = P(Х = xn) .

В одном испытании случайная величина принимает одно и только

одно возможное значение: x1, x2, x3, ….. xn, т.е. события {Х = x1}, {Х = x2,},

….., {Х = xn} будут образовывать полную группу событий, и сумма их вероятностей равна единице

,

P1 + P2 +…..+ Pn =1 .

Пример: Стрелок имеет 4 патрона и стреляет в цель до первого попадания.

Вероятность попадания при каждом выстреле равна 0,8. Составить

закон распределения случайной величины X – числа использованных патронов:

X

1

2

3

4

P

0,8

0,16

0,032 0,008

P(X=1) = 0,8

,

A = {попадание при одном выстреле} .

P(X=2) = P(A*A) = P(A)*P(A) = 0,2*0,8 = 0,16 ,

P(X=3) = P(A*A*A) = P(A)*P(A)* P(A) = 0,2*0,2*0,8 = 0,032 ,

P(X=4) = 1 – (0,8+0,16+0,032) = 0,008 .

2.3. Биноминальное распределение.

Пусть проводятся n независимых испытаний, в каждом из которых

событие А может произойти или нет. В каждом испытании вероятность

свершения события А равна p , а вероятность непоявления события А равна q=1-p.

Рассмотрим случайную величину X – число появлений события А в

n испытаниях.

Данная случайная величина имеет следующий закон распределения:

X

P

0

qn

1

Cn1*p*q(n-1)

2

Cn2*p2*q(n-2)

3

Cn3*p3*q(n-3)

Вероятности вычисляются по формуле Бернулли

….

….

n

pn

17

Pk = Pnk (А)= Cnk*pk*q(n-k) , P1 = P(X=0) = Cn0*p0*q(n) = q(n) ,……,

Pn = p n .

Закон распределения вероятностей, для которого вероятность вычислена по формуле Бернулли, называется биноминальным.

Пример: Монета подбрасывается 2 раза. Составить закон распределения

случайной величины X, где X – число выпаданий орла.

А = {выпадание орла при одном подбрасывании}.

X

0

1

2

P

1/4

1/2

1/4

0

0

0

(2-0)

P0 =P(X=0) = P2 (А)= C2 *(1/2) *(1/2)

= 1/4 ,

1

1

1

1

P1 = P2 (А)= C2 *(1/2) *(1/2) = 2*1/2*1/2 = 1/2 ,

P2 = P22 (А)= C22*(1/2)2*(1/2)0 = 1*(1/2)2*(1/2)0 =1/4 .

2.4. Распределение Пуассона.

Пусть проводится n независимых испытаний, в каждом из которых

вероятность появления события А равна p. Для определения вероятности

того, что в n независимых испытаниях событие А произойдет k раз используется формула Бернулли.

Если число испытаний n велико, то используется приближенная

формула Лапласа.

Если же число испытаний n велико, а вероятность свершения события А мала, то эту формулу использовать нецелесообразно (точность мала). В этом случае целесообразнее использовать формулу Пуассона, которая применяется в случае, когда

= n*p 10 .

По формуле Бернулли вероятность того, что в n независимых испытаниях событие А происходит k раз:

Pnk(A) = Cnk*pk*(1-p)(n-k) , т.к. p*n = , то p= /n и

n!

Pn (A) = -------------- * pk*(1-p)(n-k) =

k!*(n-k)!

k

n*(n-1)*(n-2)*…..*(n-k+1)

k

= -------------------------------------- * ------ * 1 - --k!

n

n

где = n*p .

(n- k)

,

18

Будем предполагать, что среднее число появлений А остается постоянным. Т.к. число испытаний у нас велико, то вычислим предел при n ,

стремящемся к бесконечности.

k

1

2

k

1

-k

lim Pnk(A) = ---- * lim 1* 1- --- * 1- --- * ….* 1- ---- + --- * 1 - --- *

n

k ! n

n

n

n

n

n

n

k

n

* 1 - --= --- * lim 1 - --- * 1 - --n

k! n

n

n

-k

k

= ---- * e- * 1

k!

,

k*e (-)

Pnk(A) -----------, где

= n*p 10 .

k!

Закон распределения, вероятность для которого рассчитывается по

данной формуле, именуется закон Пуассона.

Пример: Завод отправил на базу 5 тысяч качественных изделий. Найти вероятность того, что на базу поступят 3 бракованных изделия. Вероятность того, что изделие повредится = 0,0002.

n = 5000,

p = 0,0002 ,

= n*p = 1 < 10 .

3 * e (-1)

1

3

P 5000 (A) ------------- = --------- = 0,06 .

3!

6*e

2.5. Числовые характеристики ДСВ. Математическое ожидание.

Закон распределения вероятности полностью характеризует случайную величину. Однако часто закон неизвестен и приходится ограничиваться меньшими сведениями - числовыми характеристиками.

К числовым характеристикам ДСВ относятся:

1) Математическое ожидание,

2) Дисперсия,

3) Среднее квадратическое отклонение.

Определение: Математическим ожиданием ДСВ называют сумму произведений всех возможных их значений на соответствующие им вероятности.

Пусть ДСВ задана законом распределения:

X

P

x1

P1

x2

P2

x3

P3

……

……

xn

Pn

.

Математическое ожидание данной ДСВ будет

M(X) = P1 * x1 + P2 * x2 + ….. + Pn * xn =

n

xi Pi

i=1

19

Пример: Вычислить математическое ожидание следующей случайной величины:

X

1

2

3

P

0,2

0,5

0,3

M(X) = 1*0,2+2*0,5+3*0,3 = 2,1 .

Вероятностный смысл математического ожидания.

Пусть произведено n испытаний, в которых случайная величина X

приняла значения

x1 – m1 раз,

x2 – m2 ,

x3 – m3, …., xk – mk раз,

при этом: m1 + m2 + ….+ mk = n .

Найдем среднее значение данной случайной величины:

x1*m1 + x2*m2 +…..+ xk*mk

X = ------------------------------------- =

n

= x1*(m1 /n) + x2*(m2 /n) + ….. + xk*(mk /n) .

Величина (mk /n) - - это относительная частота значения xk.

Относительная частота (mk /n) pk - (примерно вероятность)

X x1 * p1 + x2 * p2 + …. + xk * pk

X M(X) , если n велико.

2.6. Свойства математического ожидания.

Свойство 1: M ( C ) = C, где C = const . Математическое ожидание постоянной величины равно самой постоянной.

X

P

С

P1

С

P2

С

P3

……

……

С

Pn

M ( C ) = С* P1 + С* P2 + …. + С* Pn + = С*( P1 + P2 + …. + Pn ) = С*1=С .

Определение: Произведением постоянной случайной величины С на случайную величину Х называют новую случайную величину, значения которой равняются произведениям значений случайной величины на константу (const).

C*X

P

С*x1

P1

С*x2

P2

С*x3

P3

……

……

С*xn

Pn

Свойство 2: M(C*X) = C* M(X) – постоянный множитель можно выносить за знак математического ожидания.

20

Определение: Две случайные величины называют независимыми, если закон распределения одной из них не зависит от того, какие значения принимает другая величина.

Определение: Произведением независимых случайных величин X и Y

называют случайную величину, возможные значения которой

равняются произведениям каждого возможного значения случайной величины X на каждое возможное значение величины Y, а

вероятность равняется произведениям вероятностей возможных

значений.

Свойство 3: Математическое ожидания произведения независимых случайных величин равно произведению математических ожиданий.

M(X*Y) = M(X) * M(Y) .

Даны законы распределения вероятностей двух независимых случайных

величин:

X

P

x1

P1

x2

P2

Y

P

y1

Q1

y2

Q2

Тогда закон распределения произведения:

X*Y

P

x1*y1

P1*Q1

x1*y2

P1*Q2

x2*y1

P2*Q1

x2*y2

P2*Q2

M(X*Y) = x1*y1*P1*Q1 + x1*y2*P1*Q2 + x2*y1*P2*Q1 + x2*y2*P2*Q2 =

= x1* P1*(y1* Q1 + y2*Q2 ) + x2* P2*(y1* Q1 + y2*Q2 ) =

= ( x1*P1 + x2*P2 ) * (y1*Q1 + y2*Q2 +) = M(X)*M(Y) .

Свойство 4: Математическое ожидание суммы случайных величин равняется сумме математических ожиданий каждой из случайных величин

M(X+Y) = M(X) + M(Y) .

Доказательство: Имеем две случайные величины X и Y с законами распределения

X

x1

x2

Y

y1

y2

P

P1

P2

P

Q1

Q2

Составим закон распределения для суммы случайных величин

(X+Y):

X+Y

x1+y1

x1+y2

x2+y1

x2+y2

P

P11

P12

P21

P22

Вычислим математическое ожидание суммы случайных величин:

21

M(X+Y) = ( x1+y1 )* P11 + ( x1+y2 )* P12 + ( x2+y1 )* P21 + ( x2+y2 )* P22 =

= (P11 + P12)* x1 + (P21 + P22)* x2 +(P11 + P21)* y1 +(P12 + P22)* y2 .

Докажем, что сумма вероятностей (P11 + P12) = P1 .

Событие {X = x1} равно сумме событий:

X = x1

Y = y1

и

X = x1

Y = y2

Тогда по теореме сложения вероятностей, вероятность первого события равна P1 = P11 + P12 , где

P1 = P(X=x1),

P11 =P(X=x1,Y=y1) , P12 =P(X=x1,Y=y2)

Применив теорему сложения вероятностей к остальным событиям получим

M(X+Y) = x1* P1 + x2*P2 + y1 * Q1 + y2 * Q2 = M(X) + M(Y) .

Пример: производят 3 выстрела с вероятностями попадания при каждом:

№ выст.

P

1

0,4

2

0,3

3

0,6

Найти математическое ожидание общего числа попаданий при трех

выстрелах.

X – общее число попаданий при трех выстрелах.

P1 = 0,4 , P2 = 0,3 , P3 = 0,6 , X = X 1 + X 2 + X 3 ,

где

X 1 – число попаданий при первом выстреле , X 2 – число попаданий при

втором выстреле, X 3 – число попаданий при третьем выстреле.

X1

P

0

0,6

1

0,4

X2

P

0

0,7

1

0,3

X3

P

0

0,4

1

0,6

M(X) = M(X1)+M(X2)+M(X3) = 0*0,6+1*0,4+0*0,7+1*0,3+0*0,4+1*0,6 = 1,3.

Математическое ожидание числа появлений события в независимых испытаниях.

Пусть проводится n независимых испытаний в каждом из которых

вероятность свершения события А есть число p.

Теорема: Математическое ожидание числа появлений события А в n независимых испытаниях равна произведению числа независимых испытаний на вероятность появления события А в каждом из этих испытаний.

M(x) = n*p .

Доказательство: Рассмотрим случайную величину X – число свершений

события А в n независимых испытаниях. Данную случайную величину представляем как сумму n случайных величин, где случайная

2.7.

22

величина X1 – число появления события А в первом испытании, X2

– число появления события А в втором испытании, и так далее.

Составим закон распределения вероятности случайной величины X 1:

1

X1 0

P 1-p

p

M(X 1) = 0*(1-p) + 1*p = p .

Математическое ожидание каждой

случайной величины

M(X 1) = M(X 2) = …. = M(X n) = p .

M(X) = M(X 1) + M(X 2) + …. + M(X n) = n*p .

2.8. Дисперсия случайной величины.

Рассмотрим случайную величину Х и ее математическое ожидание

М(Х). Чтобы оценить, как рассеяны возможные значения случайной величины относительно математического ожидания, пользуются числовой характеристикой, именуемой дисперсией.

Определение: Отклонением случайной величины от ее математического

ожидания назовем новую случайную величину Х - М(Х) .

Если случайная величина Х имела закон распределения:

X

P

x1

P1

x2

P2

x3

P3

……

……

xn

Pn

Закон распределения новой случайной величины будет

X-M(X)

P

x1 – M(X) x 2 – M(X) x 3 – M(X)

P1

P2

P3

……

……

x n – M(X)

Pn

Теорема: Математическое ожидание отклонения случайной величины от

ее математического ожидания равно 0.

M(X-M(X)) = 0.

Доказательство: M(X-M(X)) = M(X) + M(-M(X)) = M(X) – M(X) = 0 . Теорема доказана.

Определение: Дисперсией (или рассеянием) СВ называют математическое

ожидание квадрата отклонения случайной величины от ее математического ожидания.

D(X) = M(X – M(X))2 .

X

P

X-M(X)

P

x1

P1

x1 – M(X)

P1

x2

P2

x2 – M(X)

P2

x3

P3

……

……

x3 – M(X)

P3

……

……

xn

Pn

xn – M(X)

Pn

23

D(X) = M(X – M(X))2 =

= (x1 – M(X))2 * P1 + (x2 – M(X))2 * P2 + … +(xn – M(X))2 * Pn =

n

=

(xi – M(X))2 * Pi .

i=1

2.9. Формула для вычисления дисперсии.

Теорема: Дисперсия равна разности между математическим ожиданием

квадрата случайной величины X2 и квадратом математического

ожидания случайной величины X.

D(X) = M(X2) – M2(X)

Доказательство: D(X) = M(X-M(X))2 = M(X2-2*X*M(X)+M2(X))=

= M(X2)-2*M(X*M(X))+M(M2(X)) = M(X2) – 2*M(X)*M(X) + M2(X) =

= M(X2) – M2(X), что и требовалось доказать.

Пример: Вычислить дисперсию следующей случайной величины:

X

P

2

0,1

3

0,6

5

0,3

M(X) = 2*0,1+3*0,6+5*0,3 = 3,5 ,

X2

P

4

0,1

9

0,6

25

0,3

M(X2) = 4*0,1+9*0,6+25*0,3 = 13,3 ,

D(X) = M(X2) – M2(X) = 13,3 – (3,5)2 = 1,05 .

2.10. Свойства дисперсии.

1) Дисперсия постоянной величины равна нулю.

D( C ) = 0 ,

C = const .

Доказательство:

D( C ) = M(C – M( C ) )2 = M(0) = 0 .

2) Постоянный множитель можно выносить за знак дисперсии.

D( C*X) = C2*D(X) .

Доказательство:

D( C*X) = M(C*X – M( C*X ) )2 = C2 *M(X – M(X ) )2 = C2*D(X) .

3) Дисперсия суммы двух независимых случайных величин равна сумме

дисперсий.

D(X+Y) = D(X) + D(Y),

где X,Y –независимые случайные величины.

Доказательство:

D(X+Y) = M(X+Y) 2 – M2(X+Y) = M(X2+2*X*Y +Y2) –(M(X)+M(Y)) 2 =

24

= M(X2)+2*M(X)*M(Y)+M(Y2)-M2(X) - 2*M(X)*M(Y) - M2(Y) =

= M(X2) -M2(X) + M(Y2) - M2(Y) = D(X) + D(Y) .

Дисперсия числа появлений событий в независимых испытаниях.

Теорема: Дисперсия числа появлений события А в n независимых испытаниях равна произведению числа испытаний на вероятность появления и непоявления события в каждом испытании.

D(X) = n*p*(1-p) .

2.11.

Доказательство: Рассмотрим случайную величину X – число появлений

события А в n независимых испытаниях.

X = X1 + X2 + … + Xn

, где

X 1 – число появлений события А в первом испытании,

….,

X n – в n-ном испытании.

X 2 – во втором,

В соответствии с последним свойством

D(X) = D(X 1) + D(X 2) +…..+ D(X n) .

Вычислим дисперсию для каждой случайной величины. Рассчитаем

закон распределения для первой случайной величины.

D(X 1) = M(X 12) – M2(X 1) = p – p2 = p*(1-p)

, то

M(X 12) = p ,

M(X 1) = p .

X1

0

1

P

1-p

p

Все остальные случайные величины имеют такие же дисперсии, тогда

D(X) = n*p*(1-p) ,

что и требовалось доказать.

2.12. Среднее квадратическое отклонение.

Для оценки рассеяния возможных значений случайной величины вокруг ее среднего значения служит среднее квадратическое отклонение.

Определение: Средним квадратическим отклонением случайной величины

Х называется корень квадратный из дисперсии данной случайной

величины.

(X) = D(X) .

Пример:

X

2

3

10

P

0,1

0,4

0,5

Вычислим среднее квадратическое отклонение.

Сначала найдем дисперсию: D(X) = M(X2) – M2(X) , M(X) = 6,4 .

Построим закон распределения для X2 :

X2

4

9

100

P

0,1

0,4

0,5

25

Определим M(X2) = 0,1*4+0,4*9+0,5*100 = 54 , D(X) = 54 – (6,4)2 = 13,04 ,

(X) = 13,04 3,6 .

Среднее квадратическое отклонение суммы взаимно независимых случайных величин.

Теорема: Среднее квадратическое отклонение суммы взаимно независимых случайных величин равно корню квадратному из суммы квадратов средних квадратических отклонений каждой из величин.

2.13.

(Х) = 2(Х 1) + 2(Х 2) + …. +2(Х n) .

Доказательство: Пусть случайная величина Х есть сумма взаимно независимых случайных величин Х = Х 1 + Х 2 + ….. + Х n .

Тогда D(X) = D(Х 1) + D(Х 2) + ….. + D(Х n) .

Следовательно D(X) = D(Х 1) + D(Х 2) + ….. + D(Х n).

Вычислив корень квадратный от обеих частей, получим

(X) = 2(Х 1) + 2(Х 2) + ….. + 2(Х n)

.

Теорема доказана.

2.14. Одинаково распределенные взаимно независимые величины.

Рассмотрим n взаимно независимых случайных величин Х 1 , Х 2 ,

… , Х n , которые имеют одинаковые распределения.

M(Х 1) = M(Х 2) = … = M(Х n) = a ,

D(Х 1) = D(Х 2) = …. = D(Х n) = D ,

( Х 1) = (Х 2) = ….. = (Х n) = .

Рассмотрим случайную величину Х , равную среднему арифметическому

случайных величин

Х 1 + Х 2 +… + Х n

X = ----------------------------------

.

n

Свойства среднего арифметического.

1)

M(X) = a .

Х 1+Х 2 +…+Х n

M ---------------------- = 1/n* (M(X1) + M(X2) + ….+ M(Xn)) = 1/n * n*a = a.

n

2) D(X) = D/n .

Х 1+Х 2+…+Х n

D ---------------------- =1/n2*(D(Х 1)+ D(Х 2) + ... + D(Х n)) = 1/n2 * n*D = D/n.

n

3) ( X ) = / n

.

26

(X) = D(X) = D / n = D / n = / n .

2.15. Центральные и начальные моменты случайных величин.

Начальным моментом порядка k случайной величины Х называют

математическое ожидание случайной величины Xk ,

k = M(Х k) .

1 = M(Х) ,

2 = M(Х 2) ,

D(x) = M(Х 2) – M2(Х) = 2 - 12 .

Центральным моментом порядка k случайной величины Х называют математическое ожидание случайной величины (X-M(X))k:

k = M(Х -M(X))k ,

1 = M(Х -M(X))1 = 0 ,

2 = M(Х -M(X))2 = D(X) = 2 - 12 .

27

3. НЕПРЕРЫВНЫЕ СЛУЧАЙНЫЕ ВЕЛИЧИНЫ.

3.1.

Функция распределения вероятностей случайной величины.

Определение: Функцией распределения вероятностей непрерывной случайной величины Х называют вероятность того, что случайная

величина Х принимает значение меньшее, чем значение х:

F(x) = P(X<x)

, где x – число

Геометрически это равенство можно истолковать так:

функция F(x) есть вероятность того, что случайная величина принимает

значение, которое изображается на числовой оси точкой, лежащей левее

точки x.

Непрерывной случайной величиной назовем такую величину, функция распределения вероятностей которой есть функция непрерывная, кусочно-дифференцируемая и имеющая непрерывную производную.

Свойства функции распределения.

1) F(x) [0;1]

2) F(x2) F(x1), если x2 x1 .

Доказательство: Пусть значение x2 x1 , тогда событие {X < x2} можно

представить в виде суммы двух событий: {X< x1 } и { x1 X < x2} .

В этом случае по теореме сложения вероятностей

P(X < x2) = P(X < x1) + P(x1 X < x2) ,

P(x1 X < x2) = P(X < x2) - P(X < x1)

F(x2) - F(x1) = P(x1 X < x2) ,

F(x2) - F(x1) 0

3) если X (a,b), то

F(x) = 0

F(x) = 1

,

, F(x2) F(x1) .

при x a ,

при x > b .

Следствие 1:

Вероятность того, что случайная величина примет значение из отрезка [a;b] равна приращению функции распределения

на этом отрезке.

P(a X b) = F(b) - F(a) .

Следствие 2: Вероятность того, что случайная величина примет значение

равное конкретному числу равна 0.

P(X = x1) = 0 .

3. Если непрерывная случайная величина может принимать значения

(- ;+) , то пределы

28

lim F(x) = 0

x-

,

lim F(x) = 1 .

x+

3.2.

График функции распределения.

Из свойств функции распределения следует, что ее график расположен в полосе между прямыми

y=0 ,

y=1 .

При возрастании x F(x) будет возрастать. При x a график функции совпадает с y = 0

,

при x b - с y = 1.

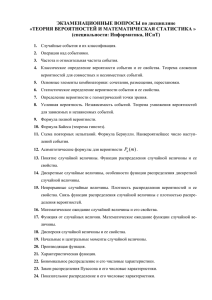

F(x)

1

0

x

a

b

Для дискретной случайной величины также можно ввести функцию распределения и ее график будет иметь ступенчатый вид:

X

P

1

0,3

4

0,1

8

0,6

Если x 1, F(x) = 0

1< x 4,

F(x) = 0.3

4<x8

F(x) = 0.4

x>8

F(x) = 1

1

0,4

0,3

x

1

4

8

Плотность распределения вероятностей непрерывной случайной величины.

Определение:

Плотностью распределения вероятностей непрерывной

случайной величины называют функцию f(x) , которая равна

первой производной от функции распределения вероятностей

случайной величины .

f(x) = F’(x) .

Из этого определения следует, что функция распределения является

первообразной для плотности распределения.

3.3.

29

Для дискретной случайной величины (ДСВ) плотность распределения неприменима.

Вероятность попадания непрерывной случайной величины в

заданный интервал.

Теорема: Вероятность того, что непрерывная случайная величина принимает значения из отрезка [a;b] равна определенному интегралу от

плотности распределения вероятности, взятого в пределах от a до

b.

3.4.

b

P(a X b) = f(x)*dx .

a

Доказательство: По свойству функции распределения, вероятность того,

что

P(a X b) = F(b)-F(a), а т.к. функция распределения F(x) является первообразной для плотности распределения f(x), то по формуле НьютонаЛейбница

b

F(b) – F(a) =

Теорема доказана.

f(x)*dx .

a

0,

x 0

2

Пример: Найти P(0,5<X<1), если F(x) = x , 0< x 1

1,

x >1

Построить графики функции распределения вероятности и плотности распределения

P(0,5<X<1) = F(1) - F(0,5) = 1 –0,52 = 0,75

0,

x 0

f(x) = F’(x) = 2*x, 0 < x 1

0

x>1.

1

1

P(0,5<X<1) =

2 * x * dx

x

= 1 –0,52 = 0,75

2

0,5

0,5

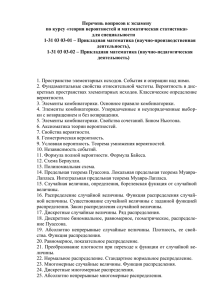

F(X)

f(x)

2

1

1

X

1

2

x

30

Нахождение функции распределения по плотности вероятностей.

Пусть задана непрерывная случайная величина X и ее плотность

распределения f(x). Необходимо найти функцию распределения для этой

случайной величины.

x

F(x) = P(X<x) = p(- <X < x) =

f ( x) * d x .

3.5.

0,

xa

f(x) = 1/(b-a), a < x b

0,

x>b .

Пример:

xa,

x

F(x) =

x

f ( x) * d x 0 * d x

= 0.

a<xb,

x

F ( x)

a

x

f ( x) * dx 0 * dx 1 /(b a) * dx 1 /(b a) * x |a

x

= x / (b-a) – a / (b-a) =

a

( x a)

.

(b a )

x>b,

a

F ( x)

b

x

0 * dx 1 /(b a) * dx 0 * dx x /(b a) |a

b

a

b

= b / (b-a) – a / (b-a) = 1 .

F(x) =

0,

xa

(x-a) / (b-a), a < x b

1,

x>b .

3.6. Свойства плотности распределения.

1) Плотность распределения есть функция неотрицательная, т.е. f(x) 0.

Доказательство: т.к. плотность есть производная от функции распределения, а функция распределения есть функция неотрицательная и

неубывающая, то плотность также будет функцией неотрицательной.

31

2) Интеграл от плотности распределения в бесконечных пределах равен

единице .

f ( x)dx

=1.

Доказательство:

f ( x)dx

= P( - < x < + ) = 1 .

Пример: Задана плотность распределения:

0

,

f(x) =

a *cosx ,

0

,

По 2-му свойству:

/2

x -/2 ,

-/2<x< /2 ,

x +/2 ,

f ( x)dx = 1 ;

a * cos x * dx = a * sin x

/ 2

= a *sin(/2) – a *sin (-/2) = 2* a = 1,

| // 22

определить a .

=

откуда

a = 1/2

3.7.

Вероятностный смысл плотности распределения.

Пусть непрерывная случайная величина X имеет функцию распределения F(x).

F(x+x) – F(x)

P(x<X<x+x)

f(x) = F’ (x) = lim ------------------------ = lim ---------------------x 0

x

x 0

x

Получили, что предел отношения вероятности того, что непрерывная случайная величина примет значение из интервала (x, x + x) к длине этого

интервала при x стремящемся к нулю, равен плотности распределения

вероятности, вычисленной в точке x.

F(x+x) – F(x) d(F(x)) = F’(x)*x = f(x)*x, т.о. вероятность того, что непрерывная случайная величина принимает значение из интервала (x, x+x) примерно равна произведению плотности распределения

вероятности на длину данного интервала. Геометрически это равенство

можно истолковать таким образом: вероятность того, что случайная величина принимает значение из интервала от x до x+x равна площади прямоугольника (фигуры) с высотой f(x) и шириной x.

32

y

f(x)

x

a x

x+x

b

3.8. Числовые характеристики непрерывной случайной величины.

Все определения числовых характеристик для ДСВ распространяются и на непрерывные случайные величины. Пусть непрерывная случайная

величина Х принимает все свои возможные значения из интервала (a;b)

Интервал (a;b) разобьем на n интервалов, длины которых x1, x2,,xn .

В каждом из этих интервалов выберем произвольные точки x1, x2,,xn .

Составим сумму произведений возможных значений xi на вероятность

попадания в соответствующий интервал

n

S = xi*f(xi)*xi .

i=1

Тогда M(X) непрерывной случайной величины будет равно (аналог M(X)

для ДСВ)

n

M(X) = lim xi*f(xi)*xi ,

n i=1

а это есть не что иное, как интегральная сумма на отрезке [a;b] для функции f(x):

b

M(X) =

x*f(x)*dx .

a

Дисперсия непрерывной случайной величины:

b

D(X) = M(X – M(X))2 =

(x – M(X))2*f(x)*dx .

a

Среднее квадратическое отклонение

(x) =

D(x) .

Все свойства доказанные для числовых характеристик ДСВ сохраняются и для непрерывных случайных величин. Для непрерывных случайных величин (НСВ) вводятся также понятия центральных и начальных моментов.

33

3.9. Равномерное распределение.

Определение: Плотности распределения НСВ называются законами

распределения.

Определение: Распределение вероятностей называется равномерным, если

на интервале, которому принадлежат все возможные значения случайной величины, плотность распределения вероятностей сохраняет

постоянное значение.

Найдем плотность равномерного распределения f(x):

f(x)

если x a или x > b, f(x) = 0

если a< x b ,

f(x) = C , C – const .

С

x

a

Так как

b

xa

0,

f(x)*dx = 1

,

то

f(x) =

a

b

C * dx = C * x

Т.к.

|ba

1 / (b-a)

0,

= C * (b a) 1 ,

b

a<x<b .

xb

получаем

a

C = 1 / (b-a) .

Вычислим числовые характеристики для равномерного распределения:

b

1

1

x 2 b 1 *1 / 2

ba

M(X) =

,

* x * dx

*

|a

* (b 2 a 2 )

(b a) a

ba 2

ba

2

b

D(X) = x 2 * f ( x) * dx [ M ( X )] 2

a

1

1

ab 2

* * x 3 | ba (

)

ba 3

2

( a b) 2 1

1

3

3

* (b a )

* (4 * (b 2 a * b a 2 )

=

3 * (b a)

4

12

3 * (a 2 2 * a * b b 2 ))

(b a) 2

.

12

34

(x)=

ba

2* 3

.

3.10. Нормальное распределение.

Нормальным распределение называется такое распределени, плотность которого равна:

( x a) 2

f ( x)

* exp

,

2

2

*

* 2 *

1

где

a M ( X ), ( X ) .

Покажем, что параметр a M (X ) , для чего вычислим:

xa

M (X )

x * f ( x) * dx

=

1

* 2 *

*

x*e

t

( xa)2

2* 2

* dx

x *t a

dx * dt

t2

t2

2

a

2

2

* *t *e

* dt a * e

* dt

* e t * dt

2 *

2 *

1

=

a

2 *

* 2 * a .

Вычислим дисперсию:

D( X )

( x a) 2 * f ( x) * dx

xa

=

1

* 2 *

* ( x a) 2 * e

( xa)2

2* 2

* dx

t

x *t a

dx * dt

=

1

* 2 *

* * 2 * t 2 * e

t2

2

* dt

35

u * dv u * v v * du

v dv t * e

t2

* t * e 2

2 *

t2

2

2

u t , du dt

* dt t * e

e

t2

2

t2

2

2

1

t2

*

* d ( ) e t

(t )

2

=

2

2

t

2

2

* dt

* e

* dt

* 2 * 2 .

2 *

2 *

( X ) D( X ) 2 .

Нормированным нормальным распределением называется нормальное

распределение с параметрами

1 .

a 0,

( x)

1

2 *

*e

x2

2

.

x

Ф( X ) f ( x) * dx

- Функция Лапласа.

0

3.11. Нормальная кривая.

График плотности нормального распределения называют нормальной кривой или кривой Гаусса.

( x a) 2

f ( x)

* exp

,

2

2

*

* 2 *

1

Исследуем эту функцию:

1) Область определения:

x(- ; +)

2) f(x) непрерывна в пределах области определения. Точек разрыва нет.

3)

4)

y a;

a lim f(x) = 0 ; y = 0 – горизонтальная асимптота.

x

f ' ( x)

1

* 2 *

( x a)

* 2 * *

2

Знак производной:

*e

( xa)2

2* 2

1

*

* 2 * ( x a)

2

2 *

( xa)2

*e

2* 2

0 ;

x a 0; x a - точка экстремума.

36

+

,

x

a

на интервале (- ; a ) – функция возрастает, на интервале ( a ;+) – функция убывает, следовательно x = a - точка максимума .

1

fmax( a ) =

* 2 *

( xa)2

1

2

* ( x a) * e 2*

5) f '' ( x) 3

* 2 *

'

( xa)2

( xa)2

2

*

(

x

a

)

1

2

2

3

* e 2* ( x a) * e 2* *

2 * 2

* 2 *

1

3 * 2 *

*e

( xa)2

2* 2

( x a) 2

0 .

* 1

2

Приравняли вторую производную к нулю для поиска точек перегиба. Решим уравнение:

(1 ( x a) 2 ) / 2 0 , откуда

- точки перегиба.

x1, 2 a

f (a )

1

* 2 *

*e

1

2

f (a )

y”

+

a-

+

a +

x

6) График ось 0х не пересекает.

y

a

x

a - a +

Выясним, как влияют на форму и расположение графика значения

параметров a и :

1) f(x- a ) – получается из графика f(x) сдвигом всех точек вправо на a

единиц ( a >0) .

37

2) Влияние сказывается на растяжение и сжатие графика функции вдоль

оси 0У. Если параметр убывает, график растягивается вдоль оси 0У. Кривая имеет острую вершину. В противном случае кривая становится более

плоской.

Вероятность попадания в заданный интервал нормальной

случайной величины.

Пусть величина Х имеет нормальное распределение, тогда вероятность того, что она

xa

t

3.12.

P( X ) f ( x) * dx

a

1

1

2 *

1

2 *

*

* 2 *

e

t2

2

* e

* 2 *

2* 2

* dx

x *t a =

если x ,

dx * dt

a

,

t

если x ,

t

a

.

* * dt

a

2

0 t

e 2

*

a

0

t2

e 2

* dt

a

1

* dt

*

2 *

a

*

1

( xa)2

1

2 *

e

t2

2

* dt

0

a

*

0

e

t2

2

a

a

* dt Ф

Ф

,

где Ф(x) - функция Лапласа.

3.13.

Вероятность отклонения нормальной случайной величины

от ее математического ожидания.

Вычислим:

P X a P( X a ) P(a X a )

a a

a a

Ф

Ф

Ф Ф

2 * Ф ,

38

a M (X ) .

где

Вероятность того, что случайная велиична отклоняется по модулю от

величины ее математического ожидания на величину равна удвоенному

значению функции Лапласа в точке /.

3.14.

Используя формулу:

случая

3 *

Правило трех сигм.

P x a 2 * Ф ,

вычислим для

3 *

P x a 3 * 2 * Ф

2 * Ф3 2 * 0,4985 0,997 1 .

Правило трех сигм: Если случайная величина имеет нормальное распределение, то абсолютная величина ее отклонения от M(X) не превосходит утроенного среднего квадратического отклонения.

3.15. Понятие о теореме Ляпунова.

Теорема: (Центральная предельная теорема.) Если случайная величина

Х представляет собой сумму большого числа взаимо независимых

случайных величин, то эта случайная величина Х имеет распределение близкое к нормальному.

3.16. Оценка отклонения распределения вероятностей от нормального. Мода, медиана, эксцесс, асимметрия случайной величины.

Для ДСВ модой называют такое ее значение, которое имеет

наибольшую вероятность.

Пример:

x

1

3

10

P

0,1

0,5

0,4

m0 = 3 .

Для НСВ модой называют точку максимума плотности распределения ее вероятностей.

y

m0 = a = M(X) .

Нормальное

распределение .

f (x)

x

a

Медианой случайной величины называют такое ее значение x1/2, что

выполняется следующее равенство:

P(X< x1/2 ) = P(X> x1/2 ) = 1/2 ,

me = x1/2 .

39

Из определения следует, что значение функции распределения

F(me) = 1/2 .

Пример: X – непрерывная случайная величина:

0,

если x 0 ,

3

F(x)= x ,

если 0<x<1,

1,

если x 1 .

1

1

1

1

F ( x) ; x 3 ; x 3 me 3 .

2

2

2

2

Асимметрией для НСВ называют отношение центрального момента

третьего порядка к кубу среднего квадратического отклонения:

As = 3 / 3 .

Для нормального распределения асимметрия равна 0 (нулю):

y

As = 0 .

x

a

Если для случайной величины As > 0, то график плотности распределения смещен относительно моды вправо. Если As <0, то график смещается относительно моды влево. As > 0, если левая часть плотности распределения по сплошной линии, а правая - по пунктирной; As <0, если

наоборот.

Эксцессом для НСВ называют разность между отношением центрального момента четвертого порядка к четвертой степени среднего квадратического отклонения и тройкой:

Ek = (4 / 4 - 3)

Ek > 0

Для нормального распределения эксцесс равен 0.

Ek < 0

Ek=0

m0

Если для случайной величины Ek > 0, то график ее плотности поднимается

выше графика нормального распределения.

3.17. Показательное распределение.

Показательным распределением НСВ называют распределение,

плотность которого равна:

,

40

если x < 0 ,

*e(-*x) ,

если x 0,

0

f (x) =

где > 0 .

f(x)

x

Найдем функцию распределения для данной случайной величины:

F ( x)

x

x

f ( x) * dx * e

x

0

e *x

x

0

e *x

* dx *

x

0

1 e *x ;

0

,

если x < 0 ,

1 - e(-*x)

,

если x 0 .

F(x) =

F(x)

1

x

Найдем вероятность попадания показательной случайной величины в заданный интервал:

P( X ) F ( ) F ( ) e * e * .

Найдем числовые характеристики показательного распределения:

u * dv u * v v * du

M (X )

0

0

x * f ( x) * dx x * * e

*x

* dx u x; dv e *x * dx

du dx; v

1

* e *x

41

x * e *x

*

x*e

*x

0

0

e *x

e *x

0

* dx x * e *x

00

0

1

1

e *x * dx

0

0

.

D( X ) M ( X 2 ) M 2 ( X ) .

u x 2 ; dv e *x * dx

M ( X ) x * f ( x) * dx x 2 * * e *x * dx

2

2

0

du 2 * x * dx;

0

v

x 2 * e *x

*

0

0

0

e *x

2

*

1

* 2 * x * dx x 2 * e *x

2

2

0

,

2

D( X ) M ( X 2 ) M 2 ( X )

( X ) D( X )

e *x

1

2

1

2

.

1

2

1

2

.

2

* e *x * x * * dx

0

42

4. ЗАКОНЫ БОЛЬШИХ ЧИСЕЛ.

Нельзя заранее предвидеть какое из возможных значений примет

случайная величина, но при некоторых условиях можно установить закономерности суммарного поведения большого числа случайных величин.

Эти закономерности указываются в теоремах, которые называются законами больших чисел:

- теорема Чебышева,

- теорема Бернулли,

- неравенство Чебышева.

4.1.

Неравенство Чебышева.

Неравенство Чебышева справедливо для ДСВ и НСВ.

Докажем для ДСВ:

Пусть дана ДСВ Х и ее закон распределения.

X

P

x1

P1

x2

P2

x3

P3

……

……

xn

Pn

Теорема: Вероятность абсолютного отклонения случайной величины от

M(X) на число не превосходящее не меньше разности

1- ( D(X) / 2)

P( x – M(X) < ) (1 - ( D(X) / 2) )

Доказательство: События { x – M(X) < } и { x – M(X) } противоположны. Тогда вероятность первого события:

P( x – M(X) < ) = 1 - P( x – M(X) ) .

Вычислим

D( X ) ( x1 M ( X )) 2 * p1 ( x 2 M ( X )) 2 * p 2 .... ( x n M ( X )) 2 * p n .

Все слагаемые D(X) положительные. Отбросим из данной суммы те

слагаемые, для которых ( xi – M(X)) < ,

тогда:

D( X ) ( x k 1 M ( X )) 2 * p k 1 .... ( x n M ( X )) 2 * p n

В последнем неравенстве в правой части остались те слагаемые, для которых

( xi – M(X)) , ( xi – M(X))2 2 , откуда D(X) 2 *( pk+1 + pk+2 +…+ pn ) .

Сумма вероятностей pk+1 + pk+2 + …. + pn - есть не что иное, как вероятность того, что:

P(X – M(X) ),

тогда D(X) 2 * P(X – M(X) ) ,

P(X – M(X) ) D(X)/2 ;

P(X – M(X)< ) 1 - D(X)/2 ,

43

что и требовалось доказать.

4.2. Теорема Чебышева.

Теорема: Если случайные величины X1 , X2 , … , Xn , попарно независимы

и дисперсии этих величин ограничены, (D(Xi) C)

то

X X 2 ... X n M ( X 1 ) M ( X 2 ) ... M ( X n )

lim P 1

1

n

n

n

Доказательство: Рассмотрим случайную величину

X X 2 ... X n

X 1

.

n

Тогда по свойству математического ожидания:

M (X )

D( X )

M ( X 1 ) M ( X 2 ) ... M ( X n )

,

n

D( X 1 ) D( X 2 ) ... D( X n )

n2

C*n

n2

C

.

n

Воспользуемся неравенством Чебышева:

P x M ( X ) 1 D( X ) / 2 ,

X X 2 ... X n M ( X 1 ) M ( X 2 ) ... M ( X n )

C

P 1

1

n

n

n * 2

.

Вычислим предел от данного неравенства:

X X 2 ... X n M ( X 1 ) M ( X 2 ) ... M ( X n )

lim P 1

n

n

n

C

lim 1

n

n * 2

,

откуда

X X 2 ... X n M ( X 1 ) M ( X 2 ) ... M ( X n )

lim P 1

1;

n

n

n

Так как

0 P 1 , то

X X 2 ... X n M ( X 1 ) M ( X 2 ) ... M ( X n )

lim P 1

1;

n

n

n

что и требовалось доказать.

Из данной теоремы следует, что если отдельные случайные величины могут принимать значения далекие от их математического ожидания,

44

то среднее арифметическое случайных величин принимает значение очень

близкое к значению среднего арифметического их математических ожиданий.

4.3. Теорема Бернулли.

Пусть проводится n независимых испытаний, в каждом из которых

вероятность наступления события А равна p .

Теорема: Если в каждом из n независимых испытаний вероятность p появления события А постоянна, то

m

lim P p 1,

n

n

0

где m/n - относительная частота события А.

Доказательство: Рассмотрим следующие случайные величины:

X1 – число появлений события А в первом испытании,

X2 – число появлений события А в втором испытании, … ,

Xn – число появлений события А в n испытании .

Для всех этих случайных величин М(Xi) одинаковы.

М(Xi) = p,

D(Xi) = p*q ,

Так как в сумме p+q = 1,

Рассмотрим X

q = 1-p

то D(Xi) 1 / 4

X 1 X 2 ... X n

,

n

тогда

M (X )

p*n

p

n

Поскольку D(X) ограничены, можно применить теорему Чебышева:

X X 2 ... X n M ( X 1 ) M ( X 2 ) ... M ( X n )

lim P 1

1;

n

n

n

X X 2 ... X n

lim P 1

p 1;

n

n

Величина

то есть

X 1 X 2 ... X n m

относительная частота события А,

n

n

m

lim P p 1; что и требовалось доказать.

n

n

45

5. СИСТЕМА СЛУЧАЙНЫХ ВЕЛИЧИН.

5.1. Понятие о системе нескольких случайных величин.

Ранее рассматривались величины, возможные значения которых выражались одним числом. Такие величины называют одномерными. Кроме

одномерных случайных величин изучают величины, значения которых

определяются двумя, тремя и т.д. числами. Такие величины называют многомерными.

Двумерной случайной величиной называют величину, значение которой определяется двумя числами, обозначают (X,Y), где случайные величины

X и Y называют компонентами или составляющими двумерной случайной величины.

Закон распределения вероятностей для дискретных двумерных случайных величин.

Определение: Законом распределения называется перечень возможных

значений двумерной случайной величины и их вероятностей.

Обычно закон распределения записывают в виде следующей таблицы:

X

Y

x1

x2

….

xn

y1

P(x1,y1)

P(x2,y1)

…..

P(xn,y1)

y2

P(x1,y2)

P(x2,y2)

….

P(xn,y2)

…

…..

…..

…..

…..

ym

P(x1,ym)

P(x2,ym)

…..

P(xn,ym)

Так как события {X= xi , Y= yj } ,

i = 1….n

j = 1….m ,

образуют полную группу событий, то сумма всех вероятностей в таблице

равна 1.

Зная закон распределения двумерной случайной величины можно

найти законы распределения для ее составляющих, например:

P(X= x1) = P(x1, y1) + P(x1, y2) + ….. + P(x1, ym),

P(X= x2) = P(x2, y1) + P(x2, y2) + ….. + P(x2, ym),

5.2.

…………………………………………………………….,

P(X= xn) = P(xn, y1) + P(xn, y2) + ….. + P(xn, ym).

5.3. Функция распределения двумерной случайной величины и

плотность распределения вероятностей непрерывной двумерной

случайной величины.

Пусть (X,Y) – двумерная случайная величина дискретная или непрерывная.

Определение: Функцией распределения двумерной случайной величины

(X,Y) называется функция F(x,y) , которая определена для любой

пары чисел x,y:

F(x,y) = P(X<x, Y<y) .

Свойства функции распределения:

46

1) 0 F(x,y) 1

2) F(x,y) – функция неубывающая по каждому из аргументов, т.е.

F(x1,y) F(x2,y),

x1 x2 ,

F(x, y1) F(x, y2),

y1 y2 .

Доказательство:

Пусть значение x1> x2 , тогда событие {X<x1,Y<y} можно представить в

виде суммы двух событий {X< x2,Y<y) (x2 X< x1,Y<y}, тогда по теореме

сложения вероятностей P(X<x1,Y<y) = P(X< x2,Y<y) + P(x2 X< x1,Y<y).

F(x1,y)=F(x2,y)+ P(x2 X< x1,Y<y),

F(x1,y) - F(x2,y) 0,

F(x1,y) F(x2,y)

- функция неубывающая по аргументу x.

Следствия:

1) F(-, y) = 0

2) F(x, -) = 0

3) F(-,-) = 0

4) F(+,+) = 1

3) F(x,+) = F1(x) ,

F(+,y) = F2(y) .

Доказательство:

,

,

,

.

Y<+ , тогда

F(x; +)=P(X<x)=F1(x) .

4) P(x1 X x2,Y<y)= F(x2,y) - F(x1,y),

P(x1 X x2, y1 Y y2)= F(x2,y2) - F(x1,y2) – (F(x2,y1) - F(x1,y1)) .

Пусть дана двумерная непрерывная случайная величина (X,Y).

Определение: Плотность распределения случайной величины (X,Y) называют вторую смешанную производную по переменным x и y от

функции распределения .

2 F ( x, y )

f ( x, y )

Fxy" ( x, y ) .

x * y

Свойства плотности распределения:

1) f ( x, y ) 0 ,

2)

f ( x, y) * dx * dy 1 .

Условные законы распределения составляющих двумерных

случайных величин.

Рассмотрим двумерную ДСВ (X,Y), возможные значения которой

следующие:

x1 , x2 , x3 , … , xn

5.4.

47

y1 , y2 , y3 , … , ym .

Обозначим условную вероятность того, что случайная величина X=x1

при условии, что случайная величина Y=y1 через P(x1/y1) .

Определение: Условным распределением составляющей Х при условии что

Y = yj называют совокупность условных вероятностей:

P(x1/yj), P(x2/yj) , ….. , P(xn/yj),

вычисленных в предположении, что событие {Y = yj } уже наступило.

Аналогично можно определить условное распределение составляющей Y .

Зная законы распределения дискретных двумерных случайных величин,

можно вычислить условные законы распределения составляющих, используя формулу:

PB ( A)

P( AB )

P( B)

;

P( x i / y j )

P( x i , y j )

P( y j )

.

Пусть дана двумерная непрерывная случайная величина (X,Y) .

Определение: Условной плотностью (x/y) распределения составляющих

Х при данном значении Y=y называют отношение плотности

совместного распределения (X,Y) к плотности распределения составляющей Y :

( x / y)

f ( x, y )

.

f 2 ( y)

5.5. Условное математическое ожидание.

Условным математическим ожиданием ДСВ Y при условии, что

ДСВ Х приняла значение равное х, называют сумму произведений возможных значений Y на их условные вероятности, т.е.:

m

M (Y / X x) y i * P( y i / x) .

i 1

Для непрерывных случайных величин:

M (Y / X x)

y * ( y / x) * dy .

M (Y / X x) f ( x)

-

функция регрессии Y на X .

M ( X / Y y) f1 ( y)

-

функция регрессии X на Y.

48

5.6. Зависимые и независимые случайные величины.

Определение: Две случайные величины называются независимыми, если

закон распределения одной из них не зависит от того, какие значения принимает другая величина.

Теорема 1: Для того, чтобы случайные величины X и Y были независимыми необходимо, чтобы функция распределения двумерной случайной величины (X,Y) была равна произведению функции распределения составляющих X и Y , т.е.

F(x,y) = F1(x) * F2(y)

Доказательство:

Необходимость: Пусть случайные величины X и Y независимы, тогда независимы события {X<x}, {Y<y}.

Используя теорему о произведении вероятности независимых событий получим:

P(X<x, Y<y) = p(X<x)*p(Y<y) ,

то

F(x,y) = F1(x) * F2(y).

Достаточность:

Пусть

F(x,y) = F1(x) * F2(y)

,

отсюда

P(X<x, Y<y) = p(X<x)*p(Y<y)

Получили, что вероятность совместного свершения событий равна

произведению вероятностей этих событий. Это значит, что независимы

события

{X<x}, {Y<y}, независимы X,Y ,

теорема доказана.

Теорема 2: Для того, чтобы две непрерывные случайные величины X и

Y были независимы, необходимо и достаточно, чтобы плотность

их совместного распределения была равна произведению плотностей распределения каждой из них, т.е.

f(x,y) = f1(x) * f2(y) .

Доказательство:

Необходимость Если X и Y независимы, то по первой теореме

F(x,y) = F1(x) * F2(y) .

Продифференцируем (возьмем производную) последнее равенство по x и

y последовательно:

F ( y ) F2 ( y ) F1 ( x)

2 F ( x, y )

F1 ( x) * 2

*

,

x * y

x

y

y

x

f ( x, y ) f 2 ( y ) * f 1 ( x ) .

49

Достаточность:

Пусть f(x,y) = f1(x) * f2(y) .

попеременно по x и y, получим:

x

y

y

Проинтегрируем это равенство

x

f ( x, y) * dx * dy f 2 ( y) * dy * f1 ( x) * dx

,

то

F(x,y) = F1(x) * F2(y)

.

Тогда по первой теореме из данного

равенства следует, что случайные величины X и Y независимы.

Что и требовалось доказать.

5.7. Корреляционный момент. Коэффициент корреляции.

Определение: Корреляционным моментом случайных величин X и Y

называют математическое ожидание от произведения отклонения

данных случайных величин:

xy M (( X M ( X )) * (Y M (Y ))) .

Эту формулу можно переписать следующим образом:

xy M ( X * Y ) M ( X ) * M (Y ) .

Для вычисления корреляционного момента ДСВ используется следующая формула:

n

m

xy ( x i M ( X )) * ( y j M (Y )) * p( x i , y j ) .

i 1 j 1

Для непрерывной случайной величины корреляционный момент будет равен:

xy

x

y

( x M ( X )) * ( y M (Y )) * f ( x, y) * dx * dy .

Корреляционный момент служит для характеристики связи между

случайными величинами X и Y.

Теорема 1: Корреляционный момент двух независимых случайных величин X и Y равен 0 (нулю).

Доказательство: Пусть случайные величины независимы. Вычислим их

корреляционный момент в соответствии с определением:

xy M ( X * Y ) M ( X ) * M (Y ) .

По свойству математического ожидания независимых случайных величин:

M ( X * Y ) M ( X ) * M (Y ) M ( X ) * M (Y ) M ( X ) * M (Y ) 0 .

Теорема доказана.

50

Следствие: Если корреляционный момент xy 0 (не равен нулю), то

случайные величины X и Y зависимые.

Определение: Коэффициентом корреляции случайных величин X и Y

называется отношение корреляционного момента к произведению средних квадратических отклонений случайных величин X и

Y,

rxy

xy

x * y

.

Из определения следует, что коэффициент корреляции для независимых случайных величин равен нулю.

Теорема 2: Модуль корреляционного момента двух случайных величин не

превосходит среднего геометрического дисперсий данных величин:

xy D( X ) * D(Y ) .

Доказательство: рассмотрим случайную величину : z1 y * X x * Y

Вычислим дисперсию:

D( Z 1 ) M ( Z 1 ) 2 M 2 ( Z 1 ) M ( y * X x * Y ) 2 M 2 ( y * X x * Y )

y * M ( X 2 ) 2 * y * x * M ( X * Y ) x * M (Y 2 ) y * M 2 ( X )

2

2

2

2 * x * y * M ( X ) * M (Y ) x * M 2 (Y )

2

2 * y * x * ( M ( X * Y ) M ( X ) * M (Y )) y * ( M ( X 2 ) M 2 ( X ))

2

x * ( M (Y 2 ) M 2 (Y )) 2 * y * x * xy y * x x * y

2

2

2 * y * x * xy 2 * y * x 0

2

2

т.о.

,

Аналогично, используя случайную величину

можно получить: xy x * y

;

2

2

2

xy x * y .

z2 x * Y y * X ,

xy x * y ,

xy D( X ) * D(Y ) ,

что и требовалось доказать.

Теорема 3: Коэффициент корреляции по модулю не превосходит единиrxy 1 .

цы.

51

Доказательство: Из теоремы 1 имеем:

Поделим все части на

1

xy

x * y

1 ,

x * y

откуда

x * y xy x * y .

получим:

1 rxy 1

и

rxy 1 ,

что и требовалось доказать.

Определения: Две случайные величины X и Y называют коррелированными, если их корреляционный момент отличен от 0 (нуля).

Две случайные величины X и Y называют некоррелированными,

если их корреляционный момент равен 0 (нулю).

Из этих определений следует, что две коррелированные величины

будут также зависимы. Обратное утверждение не всегда справедливо: если

две случайные величины зависимы, то они могут быть как коррелированными, так и некоррелированными.

Линейная регрессия. Прямые линии среднеквадратической регрессии.

Пусть даны две случайные величины (X, Y), где X и Y зависимые.

Предположим, что одна величина может быть выражена через другую величину линейно, т.е. представим случайную величину Y как линейную

функцию от Х:

5.8.

Y g (X) = a + b*X

.

Найдем коэффициенты a и b , используя метод наименьших квадратов.