Математическое ожидание и энтропия дискретной случайной

реклама

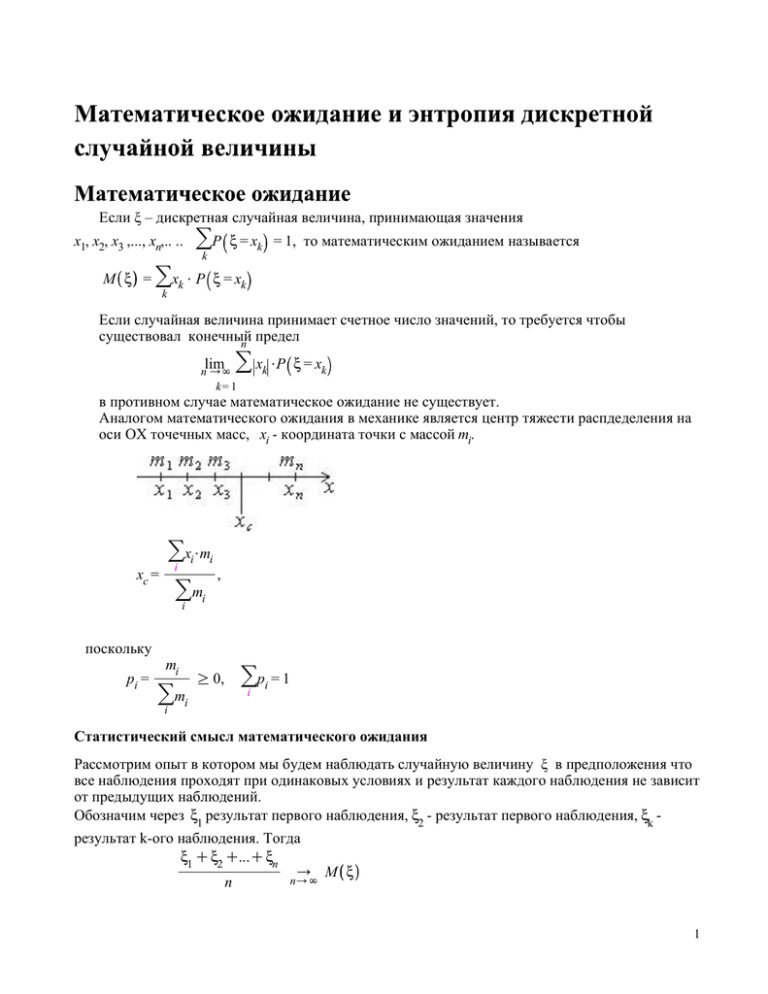

Если ξ – дискретная случайная величина, принимающая значения >P x = x x1, x2, x3 ,..., xn,.. .. M x = = 1, то математическим ожиданием называется k k >x $ P x = x k k k Если случайная величина принимает счетное число значений, то требуется чтобы существовал конечный предел n lim > x $P x = x n /N k= 1 k k в противном случае математическое ожидание не существует. Аналогом математического ожидания в механике является центр тяжести распдеделения на оси ОХ точечных масс, xi - координата точки с массой mi. >x $m x = , m > i i i c i i поскольку pi = mi > i mi R 0, >p = 1 i i Статистический смысл математического ожидания Рассмотрим опыт в котором мы будем наблюдать случайную величину ξ в предположения что все наблюдения проходят при одинаковых условиях и результат каждого наблюдения не зависит от предыдущих наблюдений. Обозначим через x1 результат первого наблюдения, x2 - результат первого наблюдения, xk результат k-ого наблюдения. Тогда x1 Cx2 C...Cxn / M x n/N n 1 Пример 1: Задан ряд распределения случайной величины ξ. Найти ее математическое ожидание. x K1 0 1 P 0.2 0.6 0.2 Mξ = (–1) · 0.2 + 0 · 0.6 + 1 · 0.2=0.0 С точки зрения механики ответ очевиден сразу. Т.к. центр тяжести находится в точке ξ = 0, то Mx = 0 Рассмотрим основные свойства математического ожидания. Теорема 1 (математическое ожидании функции от случайной величины): Если η = 4(ξ), то M h = >4 k xk $ P x = xk Пример 2: Случайная величина ξ имеет ряд распределения: x K1 P 0 0 1 2 0.2 0.3 0.4 . 2 Найти математическое ожидание случайной величины η = x . h 1 0 4 P 0 .4 0.2 0.4 Mh = 1 $ 0.4 C4 $ 0.4 = 2 С применением теоремы: Mh = K 1 2 $ 0.1 C02 $ 0.2 C12 $ 0.3 C22 $ 0.4 = 2 Теорема 2 2 1) Математическое ожидание постоянной величины равно самой постоянной: MC = C x=C C P 1 M C = C$1 = C 2) Постоянный множитель можно выносить за знак математического ожидания M C $ x = C$M x 3) Математическое ожидание суммы двух случайных величин равно сумме математических ожиданий слагаемых: M x1 Cx2 = M x1 CM x2 4) Если x1 и x2 – независимые случайные величины, то математическое ожидание их произведения равно произведению их мат. ожиданий M x1 $ x2 = M x1 $M x2 Если ξ – дискретная случайная величина, принимающая значения x1, x2, x3 ,..., xn,.. .. >P x = x k k H x = M Klog2 P x = 1, то энтропией случайной величины H x = > Klog k 2 P x = xk называется величина $P x = xk Основание логарифма может быть другим, для осноыания 2 энтропия вычисляется в битах. Основные свойства энтропии Теорема 1. Если x, - дискретная случайная величина, принимающая n различных значений , то её мера неопределенности n > H x =K P x = xi $log2 P x = xi i=1 не зависит от значений которые принимает случайная величина x,, и достигает максимального 1 значния при P x = xi = . n 3