ТЕОРИЯ ВЕРОЯТНОСТЕЙ И МАТЕМАТИЧЕСКАЯ СТАТИСТИКА

реклама

Теория вероятностей и математическая статистика

Федеральное агентство по образованию

ГОУ ВПО «Иркутский государственный университет»

В. Н. Докин

Т. Г. Тюрнева

ТЕОРИЯ ВЕРОЯТНОСТЕЙ

И МАТЕМАТИЧЕСКАЯ СТАТИСТИКА

Учебное пособие

Иркутск

2007

1

В. Н. Докин, Т. Г. Тюрнева

2

УДК 45.65.789

ББК 6.937

Д63

Печатается по решению ученого совета ИМЭИ

Иркутского государственного университета

Рецензенты:

д-р. физ.-мат. наук, проф. В. Н. Сенаторов,

канд. техн. наук, доц. Л. Н. Ежова

Д63

Докин В. Н.

Теория вероятностей и математическая статистика :

учеб. пособие / В. Н. Докин, Т. Г. Тюрнева. – Иркутск :

Иркут. гос. ун-т, 2007. – 183 с.

ISBN 978-5-9624-0141-6

В основе учебного пособия курсы лекций по теории вероятностей и математической статистике, читавшиеся в течение ряда

лет студентам специальностей 010503 – «Математическое обеспечение и администрирование информационных систем» и

010501 – «Прикладная математика и информатика». Помимо

теоретического материала по каждой теме приводятся примеры с

их полным решением. Кроме того, в конце каждой главы предлагаются вопросы для самопроверки и задачи. В Приложениях помещены таблицы основных распределений, необходимые для

решения наиболее типичных задач теории вероятностей и математической статистики. Биографический словарь содержит краткие сведения о математиках, имена которых упоминаются в настоящем пособии.

Предназначено для студентов естественнонаучных, технических, экономических и педагогических специальностей вузов, а

также может быть использовано преподавателями и инженерами.

Библиогр. 11 назв. Ил. 25. Прил. 5.

УДК 45.65.789

ББК 6.937

ISBN 978-5-9624-0141-6

© Докин В. Н., Тюрнева Т. Г., 2007

© ГОУ ВПО «Иркутский государственный

университет», 2007

Теория вероятностей и математическая статистика

Оглавление

ВВЕДЕНИЕ ………………………………………………………… 6

Глава 1. СЛУЧАЙНЫЕ СОБЫТИЯ …………………………… 8

§ 1.1. Случайные события и соотношения между ними.

Непосредственный подсчет вероятностей ……….. 8

§ 1.2. Геометрическая вероятность ………………………... 13

§ 1.3. Статистическая вероятность ………………………… 15

§ 1.4. Условные вероятности. Теорема умножения

вероятностей ……………………………………………. 17

§ 1.5. Теорема сложения вероятностей для совместных

событий …………………………………………….…… 20

§ 1.6. Формула полной вероятности ……………………….. 22

§ 1.7. Теорема гипотез (формула Байеса) ……………….. 23

§ 1.8. Последовательные независимые испытания.

Схема Бернулли ………………………………………. 25

1.8.1. Вычисление вероятностей Рn(m) в схеме

Бернулли ……………………………………………… 26

1.8.2. Наивероятнейшее число наступлений события

при повторных независимых испытаниях ……… 28

Вопросы для самопроверки ……………………………………… 29

Задачи к главе 1 …………………………………………………… 29

Глава 2. СЛУЧАЙНЫЕ ВЕЛИЧИНЫ ………………………….. 32

§ 2.1. Понятие случайной величины ………………………. 32

§ 2.2. Закон распределения вероятностей дискретной

случайной величины ………………………………….. 33

§ 2.3. Функция распределения ……………………………… 36

§ 2.4. Плотность распределения …………………………… 40

§ 2.5. Понятие о системе случайных величин ……………. 44

§ 2.6. Закон распределения системы случайных величин.

Таблица распределения ……………………………… 45

§ 2.7. Функция распределения системы двух случайных

величин ………………………………………………….. 46

§ 2.8. Плотность распределения системы двух

случайных величин ……………………………………. 47

§ 2.9. Условные законы распределений …………………... 50

§ 2.10. Зависимые и независимые случайные величины 52

§ 2.11. Системы произвольного числа случайных величин 54

§ 2.12. Числовые характеристики случайных величин

56

2.12.1. Понятие числовых характеристик ……………. 56

2.12.2. Математическое ожидание случайной величины 57

3

4

В. Н. Докин, Т. Г. Тюрнева

2.12.4. Свойства математического ожидания ………… 61

2.12.5. Мода и медиана случайной величины ………….... 64

§ 2.13. Ковариация. Коэффициент корреляции ………..… 69

§ 2.14. Моменты случайных величин ……………………… 73

§ 2.15. Нормальное распределение ……………………….. 74

§ 2.16. Биноминальное распределение …………………… 79

§ 2.17. Распределение Пуассона (закон распределения

редких явлений) ……………………………………….. 81

Вопросы для самопроверки …………………………………….. 83

Задачи к главе 2 …………………………………………………… 84

Глава 3. ЗАКОНЫ РАСПРЕДЕЛЕНИЯ ФУНКЦИЙ

СЛУЧАЙНЫХ АРГУМЕНТОВ ………………………………….. 87

§ 3.1. Закон распределения функции одной случайной

величины ………………………………………………… 88

3.1.1. Закон распределения монотонной функции

одного случайного аргумента ……………………. 88

3.1.2. Закон распределения немонотонной функции

одного случайного аргумента …………………… 91

§ 3.2. Закон распределения функции двух случайных

величин ………………………………………………….

§ 3.3. Закон распределения суммы двух случайных

величин. Композиция законов распределения ……

Вопросы для самопроверки ……………………………………..

Задачи к главе 3 …………………………………………………..

93

95

97

97

Глава 4. ПРЕДЕЛЬНЫЕ ТЕОРЕМЫ ТЕОРИИ

ВЕРОЯТНОСТЕЙ ………………………………………………… 99

§ 4.1. Неравенство Чебышева …………………………….… 99

§ 4.2. Закон больших чисел: теорема Маркова

и ее следствия ……………………………………….… 101

§ 4.3. Понятие о центральной предельной теореме ….… 104

§ 4.4. Характеристические функции ……………………….. 105

§ 4.5. Центральная предельная теорема для одинаково

распределенных случайных величин ………………. 108

§ 4.6. Центральная предельная теорема Муавра-Лапласа 112

Вопросы для самопроверки ……………………………………... 114

Задачи к главе 4 …………………………………………………… 115

Глава 5. ЭЛЕМЕНТЫ МАТЕМАТИЧЕСКОЙ СТАТИСТИКИ 117

§ 5.1. Генеральная совокупность и выборка …………..…. 117

§ 5.2. Эмпирические распределения и их графические

представления ……………………………………..…… 120

§ 5.3. Числовые характеристики эмпирических

распределений …………………………………………. 123

Теория вероятностей и математическая статистика

5

§ 5.4. Статистическое оценивание параметров ………….. 127

5.4.1. Свойства точечных оценок ………………………… 127

5.4.2. Определение приближенного значения измеряемой

величины и приближенного значения дисперсии

в случае прямых равноточных измерений ……… 129

5.4.3. Метод наибольшего правдоподобия для

нахождения оценок параметров распределений 133

5.4.4. Метод моментов …………………………………….. 137

5.4.5. Понятие об интервальном оценивании.

Построение доверительных областей …………. 140

§ 5.5. Сглаживание экспериментальных зависимостей

по методу наименьших квадратов ………………….. 144

§ 5.6. Статистическая проверка гипотез …………………… 151

5.6.1. Общая задача проверки гипотез ………………….. 151

5.6.2. Понятие о критериях согласия …………………… 153

5.6.3. Критерий

5.6.4. Критерий

χ 2 в случае простой гипотезы ………. 156

χ 2 в случае сложной гипотезы ………. 158

Вопросы для самопроверки ……………………………………… 163

Задачи к главе 5 …………………………………………………… 163

ОТВЕТЫ К ЗАДАЧАМ …………………………………………….. 165

БИОГРАФИЧЕСКИЙ СЛОВАРЬ ………………………………… 167

1

2π

Приложение 1. Значения функции Ф0(х) =

Приложение 2. Значения функции f(t) =

Приложение 3.

1

2π

e

−

x

∫e

−

u2

2

du …. 176

0

t2

2

…………. 178

χ 2 -распределение ……………………………

180

Приложение 4. Распределение Стьюдента ………………..… 182

Приложение 5. Распределение Колмогорова ………………… 184

БИБЛИОГРАФИЧЕСКИЙ СПИСОК …………………………….. 185

В. Н. Докин, Т. Г. Тюрнева

6

ВВЕДЕНИЕ

В научных исследованиях, технике, массовом производстве

часто приходится встречаться с явлениями, которые при неоднократном воспроизведении одного и того же опыта в неизменных

условиях протекают каждый раз несколько по иному. Такие явления называются случайными. Так, например, при стрельбе по мишени результат каждого отдельного выстрела будет случайным.

Совершенно очевидно, что в природе нет ни одного физического явления, в котором не присутствуют в той или иной мере

элементы случайности. Как бы точно и подробно ни были фиксированы условия опыта, невозможно достигнуть того, чтобы при

повторении опыта результаты полностью и в точности совпадали.

Например, при подбрасывании монеты эксперимент имеет всего

два исхода, монета выпадает вверх либо гербом, либо цифрой, при

этом до получения результата эксперимента нельзя сказать, какой

именно исход осуществится. Это происходит оттого, что мы практически не в состоянии учесть все факторы, влияющие на положение монеты в момент её падения. Примерно то же самое будет

происходить, если каждую лотерею покупать один билет и пытаться предугадать выиграет он или нет. В таких ситуациях при

рассмотрении отдельных опытов бывает очень трудно обнаружить какие-либо закономерности. Однако если обратить внимание

на последовательность большого числа такого рода одинаковых

экспериментов, то обнаружится интересное явление. Если индивидуальные результаты ведут себя очень «неправильно», то средние результаты обнаруживают устойчивость.

Предметом теории вероятностей и является математическая

наука, изучающая закономерности массовых случайных явлений.

Возникновение теории вероятностей как науки относится к

середине XVII в. и связано с именами Гюйгенса, Паскаля, Ферма

и Якоба Бернулли. В переписке Паскаля и Ферма (см., например,

[6]), вызванной задачами, связанными с азартными играми и не

укладывающимися в рамки математики того времени, выкристаллизовывались постепенно такие важные понятия, как вероятность

и математическое ожидание. Однако вследствие низкого уровня

развития естествознания того времени, азартные игры, а также

Теория вероятностей и математическая статистика

7

вопросы страхования и демографии ещё долго продолжали оставаться тем единственным конкретным материалом, на основе которого создавались понятия и методы теории вероятностей. Последующее развитие теории вероятностей, а также широкое привлечение её результатов и методов исследования в естествознание

и в первую очередь в физику показали, что классические понятия

и классические методы не потеряли своего интереса и в настоящее время.

Серьёзные требования со стороны естествознания (теория

ошибок наблюдения, задачи теории стрельбы, теория массового

обслуживания, проблемы статистики, в первую очередь статистики народонаселения) привели к необходимости более развитого

аналитического аппарата. Особенно значительную роль в развитии аналитических методов теории вероятностей сыграли Муавр,

Лаплас, Гаусс, Пуассон.

С середины XIX столетия и приблизительно до двадцатых

годов ХХ в. развитие теории вероятностей связано в большей степени с именами русских учёных: П. Л. Чебышева, А. А. Маркова,

А. М. Ляпунова. Основное непреходящее значение работ этих выдающихся ученых в области теории вероятностей состоит в том,

что именно ими было введено и широко использовано понятие

случайной величины.

Современное развитие теории вероятностей характеризуется

всеобщим подъёмом интереса к ней, а также расширением круга

её практических приложений. В США, Франции, Швеции, Японии

и других странах мира имеются немало ученых, обогащающих

теорию вероятностей важными результатами. В этой напряжённой работе российская школа теории вероятностей продолжает

занимать видное место. Среди представителей российских ученых, прежде всего, должны быть названы имена А. Я. Хинчина,

Б. В. Гнеденко, Ю. В. Прохорова и многих других.

Особое значение в развитии теории вероятностей и математической статистики имеют работы А. Н. Колмогорова. Он дал

наиболее совершенное аксиоматическое построение теории вероятностей. Работы А. Н. Колмогорова в области теории случайных

функций являются основой всех исследований в данной области.

8

В. Н. Докин, Т. Г. Тюрнева

Глава 1. СЛУЧАЙНЫЕ СОБЫТИЯ

§ 1.1. Случайные события и соотношения между ними.

Непосредственный подсчет вероятностей

В основе теории вероятностей, как и в основе любой другой

науки, лежат некоторые определения, основные понятия. При помощи этих понятий даётся логическое определение последующих

более сложных понятий.

В качестве одного из основных понятий, которым оперирует

теория вероятностей, является событие.

Событием (или «случайным событием») называется всякий

факт, который в результате опыта может произойти или не произойти. События принято обозначать заглавными буквами латинского алфавита. Например, событие А – выпадение трех очков на

верхней грани игральной кости.

Различные события отличаются между собой по степени

возможности их появления и по характеру взаимосвязи.

Для правильной ориентировки в теоремах теории вероятностей необходимо разобраться в существующей классификации

событий.

Если при всех опытах (испытаниях) рассматриваемое событие всегда наступает, то оно называется достоверным. Если же

при всех опытах рассматриваемое событие никогда не наступает,

то оно называется невозможным. Все достоверные события обозначаются буквой U, все невозможные буквой V.

Суммой двух событий А и В называется событие С=А+В, состоящее в появлении хотя бы одного из событий А или В.

Суммой нескольких событий называется событие, состоящее

в появлении хотя бы одного из этих событий.

Произведением двух событий А и В называется событие С=АВ,

состоящее в совместном появлении события А и события В.

Произведением нескольких событий называется событие, состоящее в совместном появлении всех этих событий.

Теория вероятностей и математическая статистика

9

Если каждое появление события А сопровождается появлением события В, то пишут А ⊂ В и говорят, что событие А влечет

за собой событие В, или А есть частный случай В.

События А и В называются несовместными, если АВ= V.

Два события А и В называются совместными, если появление

одного из них не исключает появление другого.

Если А=В1+В2+…+Вn и события Вi попарно несовместные,

т. е. ВiBj=V при i ≠ j, то говорят, что событие А подразделяется на

частные случаи В1,В2,…,Вn.

События А и A называются противоположными, если

А A = V и А + A = U.

События А1,А2, . . ., Аn образуют полную группу событий, если в

результате опыта непременно должно произойти хотя бы одно из

них, т. е. А1 +А2 + . . .+Аn = U.

Два или несколько событий в данном опыте называются равновозможными, если по условиям симметрии опыта нет оснований считать, какое-либо из них более возможным, чем любое другое.

Математической вероятностью называется числовая характеристика степени возможности появления какого-либо определенного события в тех или иных определенных, могущих повторяться неограниченное число раз условиях. Вероятность события

А обозначается символом Р(А).

Несовместные, равновозможные события, образующие полную группу событий называются случаями (или «шансами»).

Если какой-либо опыт по своей структуре обладает симметрией возможных исходов, то случаи представляют собой исчерпывающую систему равновозможных и исключающих друг друга

исходов опыта. Про такой опыт говорят, что он «сводится к системе случаев» (иначе – к «схеме урн»).

Схема случаев по преимуществу имеет место в искусственно

организованных опытах, в которых заранее и сознательно обеспечена одинаковая возможность исходов опыта (как, например, в

азартных играх). Для таких опытов возможен непосредственный

подсчет вероятностей, основанный на оценке доли так называемых «благоприятных» случаев в общем числе случаев.

В. Н. Докин, Т. Г. Тюрнева

10

Случай называется благоприятным (или «благоприятствующим») некоторому событию, если появление этого случая влечет

за собой появление данного события.

Если опыт сводится к схеме случаев, то вероятность события

А в данном опыте можно оценить по относительной доле благоприятных случаев. Вероятность события А вычисляется как отношение числа благоприятных случаев к общему числу случаев:

Р( А ) =

m

,

n

(1.1.1)

где n – общее число случаев, m – число случаев благоприятных

событию А.

В общем случае рассмотрим какую-либо группу G, состоящую из n несовместных равновозможных событий (назовём их

элементарными событиями):

Е1, Е2, …,Еn.

Образуем теперь систему S, состоящую из невозможного события V, всех событий Ek группы G и всех событий A, которые

могут быть подразделены на частные случаи, входящие в состав

группы G.

Легко установить, что система S есть поле событий. В самом

деле, очевидно, что сумма, разность и произведение событий из S

входят в S; невозможное событие V входит в S по определению, а

достоверное событие U входит в S, так как оно представляется в

виде

U=E1+E2+…+ En.

Классическое определение вероятности дается для событий

системы S и может быть сформулировано так:

Если событие А подразделяется на m частных случаев, входящих в полную группу из n попарно несовместных и равновозможных событий, то вероятность Р(А) события А равна

Р( А ) =

m

n .

Например, при однократном бросании игральной кости полная группа несовместных и равновероятных событий состоит из

Теория вероятностей и математическая статистика

11

событий Е1, Е2, Е3, Е4, Е5, Е6, которые состоят соответственно в

выпадении 1, 2, 3, 4, 5, 6 очков. Событие С= Е2+Е4+Е6, состоящее

в выпадении четного числа очков, подразделяется на три частных

случая, входящих в состав полной группы несовместных и равновероятных событий. Поэтому

Р(С ) =

3 1

=

6 2.

В соответствии с приведенным определением каждому событию А, принадлежащему построенному сейчас полю событий S,

приписывается вполне определенная вероятность

Р( А ) =

m

,

n

где m есть число тех событий Е исходной группы, которые являются частными случаями события А. Таким образом, вероятность

Р(А) можно рассматривать как функцию от события А, определенную на поле событий S.

Функция эта обладает следующими свойствами:

1. Для каждого события А поля S

Р(А)≥0.

2. Для достоверного события U

Р(U)=1.

3. Если событие А подразделяется на частные случаи В и С и

все три события А, В и С принадлежат полю S, то

Р(А)=Р(В+С)=Р(В)+Р(С).

Это свойство называется теоремой сложения вероятностей.

Свойство 1 очевидно, так как дробь

m

не может быть отриn

цательна.

Свойство 2 не менее очевидно, так как достоверному событию U благоприятствуют все n возможных результатов испытания, и поэтому

Р( U ) =

n

= 1.

n

В. Н. Докин, Т. Г. Тюрнева

12

Докажем свойство 3. Пусть событию В благоприятствует m′ ,

а событию С – m′′ событий Ei группы G. Так как события В и С

по допущению несовместны, то события Ei , благоприятствующие одному из них, отличны от событий Ei , благоприятствующих другому. Всего таким образом, имеется m ′ + m′′ событий Ei ,

благоприятствующих появлению одного из событий В или С, т. е.

благоприятствующих событию В+С=А. Следовательно,

P( A) =

m′ + m′′ m′ m′′

=

+

= P( A) + P(C ).

n

n

n

Отметим ещё несколько свойств вероятности.

Методом полной математической индукции свойство 3 легко

обобщается на произвольное число несовместных событий.

Теорема сложения вероятностей. Вероятность появления

одного из нескольких несовместных событий равна сумме вероятностей этих событий

Р(А1+А2+…+Аn)= Р(А1)+Р(А2)+…+Р(Аn).

(1.1.2)

4. Bероятность события А , противоположного событию А

равна

Р( А ) = 1 – Р(А).

Действительно, так как А+ А = U, то согласно свойству 2

Р(А+ А )=Р(U)=1,

а так как события А и А несовместны, то по свойству 3

Р(А+ А )=Р(А)+Р( А ).

Два последних равенства доказывают наше предположение.

5. Вероятность невозможного события равна нулю.

Так как U+V= U и события U и V несовместны, то

Р(U)=Р(U+ V)=Р(U)+Р(V),

откуда следует, что Р(V)=0.

6. Если событие А влечет за собой событие В, то

Теория вероятностей и математическая статистика

13

Р(А) ≤ Р(В).

Очевидно, что В=А+ А В. В силу свойств 3 и 1 получаем

Р(В)=Р(А+ А В)=Р(А)+Р( А В) ≥ Р(А).

7. Вероятность любого события заключена между нулем и

единицей.

Из того, что для любого события А имеют место соотношения

V ⊂ А+ V =А=А·V ⊂ U,

следует, в силу предыдущего свойства, что имеют место неравенства

0=Р(V) ≤ Р(А) ≤ Р(U)=1.

§ 1.2. Геометрическая вероятность

В классическом определении вероятности рассматривается

полная группа конечного числа равновозможных событий. На

практике же очень часто встречаются такие испытания, число

возможных исходов которых бесконечно. В таких случаях классическое определение неприменимо. Однако иногда в таких случаях можно воспользоваться другим методом вычисления вероятности, в котором по-прежнему основную роль играет понятие

равновозможности некоторых событий. Применяется этот метод в

задачах, сводящихся к случайному бросанию точки на конечный

участок прямой, плоскости или пространства. Отсюда и возникает

само название метода – геометрическая вероятность.

Для определенности ограничимся двумерным случаем. Одномерный и трехмерный случаи отличаются только тем, что вместо площадей в них нужно говорить о длинах и объемах.

Итак, пусть на плоскости имеется некоторая область D, площадь

D

которой SD, и в ней содержится

другая область D, площадь которой

d

Sd (рис. 1.2.1). В область D наудачу

бросается точка. Спрашивается,

чему равна вероятность того, что

точка попадет в область d?

Рис. 1.2.1

В. Н. Докин, Т. Г. Тюрнева

14

При этом предполагается, что наудачу брошенная точка может попасть в любую точку области D, и вероятность попадания в

какую-либо часть области D пропорциональна площади этой части и не зависит от её расположения и формы. В таком случае вероятность попадания в область D при бросании наудачу точки в

область D равна

Р=

Sd

.

SD

Таким образом, в общем случае, если возможность случайного появления точки внутри некоторой области на прямой, плоскости или в пространстве определяется не положением этой области

и её границами, а только её размером, т. е. длиной, площадью или

объёмом, то вероятность появления случайной точки внутри некоторой области определяется как отношение размера этой области к размеру всей области, в которой может появляться данная

точка.

Пример. Задача о встрече. Два лица договорились о встрече,

которая должна произойти в определенном месте в любой промежуток времени Т. Определить вероятность того, что встреча состоится, если моменты прихода каждого лица независимы и время

ожидания одним другого не более τ.

Решение. Обозначим

момент прихода одного лиY

ца через x , а другого – через y. Будем рассматривать

x и y как декартовы коордиТ

наты на плоскости. Все

возможные исходы изобразятся точками квадрата со

стороной Т. Встреча состоится в том и том случае,

если случайная точка (x,y)

τ

лежит в этом квадрате и

x − y ≤ τ . Этим условиям

0

Т

τ

X

Рис. 1.2.2

удовлетворяют точки, лежащие в заштрихованной

части квадрата (рис. 1.2.2).

Теория вероятностей и математическая статистика

15

Искомая вероятность равна отношению площади заштрихованной

фигуры к площади всего квадрата, т. е.

2

τ⎞ .

T 2 − ( T − τ )2

⎛

P=

= 1 − ⎜1 − ⎟

T2

T⎠

⎝

§ 1.3. Статистическая вероятность

Формула (1.1.1) для непосредственного подсчета вероятностей применима только тогда, когда опыт, в результате которого

может появиться интересующее нас событие, обладает симметрией возможных исходов (сводится к системе случаев). Очевидно,

что далеко не всякий опыт может быть сведен к схеме случаев, и

существует обширный класс событий, вероятности которых нельзя вычислить по формуле (1.1.1).

Давно замечено, что частота появления событий (относительная частота) не сводящихся к схеме случаев, при многократно

повторяющихся опытах имеет тенденцию стабилизироваться около какой-то постоянной величины. Это свидетельствует о том, что

данные события также обладают определенной степенью объективной возможности появления в опыте, меру которой можно

представить в виде относительной частоты.

Знаменитый швейцарский ученый Якоб Бернулли привел математическое доказательство того, что при большем числе испытаний относительная частота стремится воспроизвести вероятность и в пределе при большом числе опытов должна практически

совпадать с ней. Это положение носит название закона больших

чисел (этот закон будет рассмотрен в § 4.2). Многие ученые проводили опыты для проверки закона Бернулли, вычисляя относительную частоту появления событий, сводящихся к схеме случаев

и сравнивая её с вероятностью, вычисленной по классическому

определению вероятности (1.1.1). Так французский натуралист

Бюффон и английский статистик Пирсон проводили опыты с бросанием монеты (подсчитывали число случаев выпадения «герба»).

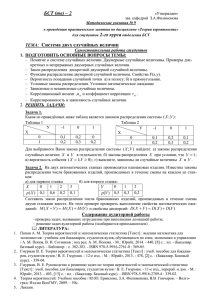

Результаты их опытов приведены в следующей таблице.

В. Н. Докин, Т. Г. Тюрнева

16

Опыты

Вероятность

Опыт Бюффона

Первый опыт Пирсона

Второй опыт Пирсона

0,5000

0,5000

0,5000

Отклонение

Относительная относительной

Число

частота

частоты от

испытаний

вероятности

0,5069

0,5016

0,5005

0,0069

0,0016

0,0005

4040

12 000

24 000

Как следует из данных таблицы, уже 4040 испытаний достаточно для совпадения эмпирической относительной частоты и вероятности до сотого знака, а 24 000 испытаний дают практически

полное совпадение относительной частоты и вероятности. Таким

образом, можно считать эмпирически подтвержденным, что относительная частота событий, сводящихся к схеме случаев, при

большом числе произведенных опытов стремится к их вероятности. Это свойство случайных событий, известное под названием

устойчивости частот, можно перенести и на другие типы случайных событий, не обладающих симметрией исходов и не составляющих полную группу. Правда, подсчет теоретической вероятности для таких событий представляет известные трудности.

Так возникло понятие статистической вероятности события, под которой понимается относительная частота появления

события А в N произведенных опытах. Статистическая вероятность вычисляется на основании результатов опытов по следующей формуле

ω ( A) =

M

N ,

где М – число появлений события А в N опытах.

В § 1.1. было показано, что вероятность достоверного события равна единице, а вероятность невозможного события равна

нулю. Однако на практике приходится сталкиваться с событиями,

вероятности которых не точно равны единице или нулю, а весьма

близки к этим значениям. Первые из этих событий называют

практически достоверными, а вторые – практически невозможными. Если события имеют такие вероятности, то можно предсказать результат опыта, руководствуясь так называемым принципом

практической уверенности, который заключается в следующем:

если вероятность некоторого события А в данном опыте весьма

Теория вероятностей и математическая статистика

17

мала, то можно быть практически уверенным в том, что при однократном выполнении этого опыта событие А не произойдет.

Вопрос о том насколько мала или велика должна быть вероятность, решается в каждом отдельном случае в зависимости от

важности исследуемого явления и не является предметом обсуждения в теории вероятностей.

§ 1.4. Условные вероятности. Теорема

умножения вероятностей

Определение. Вероятность события А, найденная в предположении, что событие В наступило, называется условной вероятностью события А относительно события В.

Условную вероятность события А относительно события В

обозначают символом Р(А/В).

Теорема умножения вероятностей. Вероятность произведения двух событий равна произведению вероятности одного из них

на условную вероятность другого, вычисленную при условии, что

первое имело место:

Р(АВ)=Р(А)Р(В/А).

(1.4.1)

Докажем теорему умножения для схемы случаев. Пусть возможные исходы опыта сводятся к n случаям. Предположим, что

событию А благоприятны m случаев, а событию В благоприятны k

случаев. Так как мы не предполагали события А и В несовместными, то вообще существуют случаи, благоприятные и событию

А, и событию В одновременно. Пусть число таких случаев l. Тогда

P( AB ) =

l

m

, P( A ) = .

n

n

Вычислим Р(В/А), т. е. условную вероятность события В в

предположении, что событие А имело место. Если известно, что

событие А произошло, то из ранее возможных n случаев остаются

возможными только m, которые благоприятствовали событию А.

Из них l случаев благоприятны событию В. Следовательно,

P( B / A ) =

l

.

m

В. Н. Докин, Т. Г. Тюрнева

18

Подставляя выражения Р(АВ), Р(А) и Р(В/А) в формулу

(1.4.1), получим тождество. Теорема доказана.

Очевидно, при применении теоремы умножения вполне безразлично, какое из событий А или В считать первым, а какое вторым и теорему умножения можно записать и в таком виде:

Р(АВ) = Р(В)Р(А/В).

(1.4.2)

Теорема. Вероятность произведения, или совместного наступления, нескольких событий равна произведению вероятности

одного из них на условные вероятности остальных событий, вычисленные в предположении, что все предшествующие события

имели место.

Р(А1 ·А2·…·Аn) = Р(А1)·Р(А2/ А1)·…·Р(Аn/ А1А2…Аn-1). (1.4.3.)

Доказательство. Для доказательства теоремы применим метод полной математической индукции.

Пусть теорема имеет место для n-1 событий:

Р(А1 ·А2·…·Аn-1 )= Р(А1)·Р(А2/ А1)·…·Р(Аn-1 / А1А2…Аn-2).

Введем событие С как произведение n-1 событий А1А2…Аn-1:

С = А1 А2…Аn-1.

Тогда в силу теоремы умножения для двух событий

Р(А1А2 …А n-1Аn) = Р(С Аn) = Р(С)Р(Аn /С).

Но

Р(С)=Р(А1А2 …Аn-1) = Р(А1)Р(А2/ А1)…Р(Аn-1 / А1А2…Аn-2).

Следовательно,

Р(А1А2 …A n-1Аn) =Р(А1)Р(А2 /А1)…Р(Аn /А1А2…Аn-1).

Теорема доказана.

Из теоремы умножения для двух событий следует, что если

событие А не зависит от события В, то и событие В не зависит от

события А. Так как событие А не зависит от события В, то

Р(А/В) = Р(А).

Предположим, что Р(А)≠ 0.

Напишем теорему умножения в двух формах:

(1.4.4)

Теория вероятностей и математическая статистика

19

Р(АВ) = Р(А)Р(В/А),

Р(АВ) = Р(В)Р(А/В),

откуда

Р(А)Р(В/А) = Р(В)Р(А/В),

или, согласно условию (1.4.4)

Р(А)Р(В/А) = Р(В)Р(А).

Разделив обе части последнего равенства на Р(А), получим

Р(В/А) = Р(В),

т. е. событие В не зависит от события А.

Таким образом, зависимость или независимость событий всегда взаимны. В связи с этим можно дать следующее новое определение независимых событий.

Два события называются независимыми, если появление одного из них не изменяет вероятность появления другого, в противном случае события А и В называются зависимыми.

Теорема умножения для двух независимых событий А и В

принимает наиболее простой вид.

Р(АВ) = Р(А)Р(В).

(1.4.5)

Независимость более чем двух событий может иметь различный характер.

События А1, А2, …Аn называются попарно независимыми, если

любые два из них независимы между собой.

События А1, А2, …Аn называются независимыми в совокупности, если каждое из них и любая комбинация остальных событий,

содержащая либо все остальные, либо часть из них, есть события

независимые. Например, если события А1, А2, А3 независимы в совокупности, то это значит, что будут независимы следующие события:

А1 и А2, А1 и А3 , А2 и А3, А1А2 и А3, А1А3 и А2, А3А2 и А1.

Теорема умножения (соотношение (1.4.3)) для независимых в

совокупности событий принимает вид

Р(А1А2…Аn) = Р(А1)Р(А2)…Р(Аn).

(1.4.6)

В. Н. Докин, Т. Г. Тюрнева

20

Соотношения (1.4.5) и (1.4.6) иногда принимают в качестве

определения попарной независимости и независимости в совокупности (см., например, [7]).

Нижеследующий пример показывает, что независимость событий А1, А2, …Аn в совокупности – более сильное свойство, чем

попарная их независимость.

Пример. Пусть из чисел 2, 3, 5 и 30 выбирается одно число,

причем каждое из чисел может быть выбрано с вероятностью 1 .

4

Обозначим через Аk события, состоящее в том, что выбранное

число делится на k. Легко видеть, что события А2, А3, А5 попарно

независимы, но зависимы в совокупности, так как

Р(А2)=Р(А3)=Р(А5)=

1

,

2

Р(А2 А3)=Р(А2 А5)=Р(А5 А3)=

Р(А2А3А5)=

1

,

4

1

.

4

§ 1.5. Теорема сложения вероятностей

для совместных событий

В § 1.1. была рассмотрена теорема сложения вероятностей

для несовместных событий. Пользуясь теоремой сложения вероятностей для несовместных событий, вместе с теоремой умножения докажем следующую теорему сложения вероятностей для совместных событий.

Теорема. Вероятность появления хотя бы одного из двух совместных событий равна сумме вероятностей этих событий без

вероятности их совместного появления:

Р(А+В) = Р(А)+Р(В) – Р(АВ).

(1.5.1)

Доказательство. Для наступления события А+В достаточно,

чтобы произошло хотя бы одно из следующих несовместных событий А или А В . Аналогично, для наступления события В доста-

Теория вероятностей и математическая статистика

21

точно, чтобы произошло хотя бы одно из следующих несовместных событий А В или АВ.

Поэтому на основании правила сложения вероятности для

несовместных событий имеем:

(1.5.2)

Р(А+В) = Р(А)+Р( А В )

и

(1.5.3)

Р(В) = Р(АВ)+Р( А В ).

Вычитая из равенства (1.5.2) равенство (1.5.3), найдем

Р(А+В)–Р(В)=Р(А)–Р(АВ).

Отсюда следует, что

Р(А+В) = Р(А)+Р(В) – Р(АВ).

Теорема доказана.

Методом полной математической индукции полученную

формулу (1.5.1) можно обобщить на случай вероятности суммы

произвольного числа совместных событий. При этом будем иметь:

Р(А1+А2+…+Аn) = Р(А1)+Р(А2)+…+Р(Аn) – Р(А1А2) – Р(А1А3) –…

…– Р(Аn-1Аn)+Р(А1А2А3)+…+Р(Аn-2Аn-1Аn) – …

…+(-1) n+1Р(А1А2…Аn).

(1.5.4)

Заметим, что при решении задач с использованием формулы

(1.5.4) часто приходится производить громоздкие вычисления,

поэтому лучше перейти к противоположному событию. В таком

случае

Р(А1+А2+…+Аn) =1 – Р( А1 ⋅ А2 ⋅ ... ⋅ Аn ).

(1.5.5)

Пример. Производится три независимых выстрела по одной

и той же мишени. Вероятность попадания при первом выстреле

равна 0,7, при втором – 0,8, для третьего – 0,9. Найти вероятность

того, что в мишени будет хотя бы одна пробоина.

Решение. Рассмотрим событие А – попадание при первом выстреле, событие В – попадание при втором выстреле и событие

С – попадание при третьем выстреле. Их вероятность Р(А)=0,7,

Р(В)=0,8, Р(С)=0,9.

В. Н. Докин, Т. Г. Тюрнева

22

Так как А, В и С являются совместными и независимыми событиями, то вероятность того, что в мишени будет хотя бы одна

пробоина, согласно формуле (1.5.4), равна

Р(А+В+С) = Р(А)+Р(В)+Р(С)–Р(А)Р(В)–Р(А)Р(С)–

–Р(В)Р(С)+Р(А)Р(В)Р(С)=

=0,7+0,8+0,9–0,7×0,8–0,7×0,9–0,8×0,9+0,7×0,8×0,9=0,994.

Если же перейти к противоположному событию, то, применяя формулу (1.5.5) для случая трех событий, получим

Р(А+В+С)=1– Р( А )Р( В )Р( С )=1 – 0,3×0,2×0,1=0,994.

§ 1.6. Формула полной вероятности

Следствием обеих основных теорем – теоремы сложения вероятностей и теоремы умножения вероятностей – является так

называемая формула полной вероятности.

Пусть требуется определить вероятность некоторого события

А, которое может произойти вместе с одним из событий

Н1, Н2, …Нn, образующих полную группу несовместных событий.

Будем эти события называть гипотезами. Вероятности всех гипотез известны. Известны также условные вероятности наступления

события А при осуществлении каждой из указанных гипотез, т. е.

даны Р(А/ Н1), Р(А/ Н2), …,Р(А/ Нn). Вероятность интересующего

нас события А определяется по следующей теореме.

Теорема. Вероятность события А, которое может произойти

вместе с одной из гипотез Н1, Н2, …Нn, равна сумме парных произведений вероятностей каждой из этих гипотез на отвечающие

им условные вероятности наступления события А:

n

Р(А)= ∑ Р( Н i )P( A / H i ) .

i =1

(1.6.1)

Формула (1.6.1) носит название формулы полной вероятности.

Доказательство. Так как гипотезы Н1, Н2, …Нn образуют

полную группу событий, то событие А можно представить в виде

следующей суммы событий:

A=AU=A(H1+H2+…+Hn)=AH1+AH2+…+AHn.

Теория вероятностей и математическая статистика

23

Поскольку события Hi несовместны, то и события AHi

(i=1, 2, …, n) также несовместны. Это обстоятельство позволяет

применить для определения вероятности события А теорему сложения вероятностей несовместных событий (1.1.2.)

P(A) =

n

∑ Р( АН

i =1

i

).

Применяя к вероятности произведения AHi теорему умножения вероятностей (1.4.2), получим

n

Р(А)= ∑ Р( Н i )P( A / H i ) .

i =1

Пример. Имеются две одинаковые на вид урны: в первой урне три белых и два черных шара; во второй – один белый и четыре

черных шара. Некто выбирает наугад одну из урн и вынимает из

неё шар. Найти вероятность того, что этот шар белый.

Решение. Рассмотрим две гипотезы. Н1 – выбрана первая урна, Н2 – выбрана вторая урна и событие А – появление белого шара из наудачу выбранной урны.

Так как гипотезы по условию задачи равновозможны, то

Р(Н1)=Р(Н2)=

1

.

2

Условные вероятности события А при этих гипотезах соответственно равны:

Р(А/ Н1) =

3

1

, Р(А/ Н2) = .

5

5

По формуле полной вероятности

Р(А)=

1 3 1 1 4

. + . =

2 5 2 5 10.

§ 1.7. Теорема гипотез (формула Байеса)

Следствием теоремы умножения и формулы полной вероятности является так называемая теорема гипотез или формула Байеса.

Поставим теперь следующую задачу. Имеется полная группа

несовместных гипотез Н1, Н2, …, Нn. Известны вероятности каждой из гипотез Р(Н1), Р(Н2), …, Р(Нn). Произведен опыт, в резуль-

В. Н. Докин, Т. Г. Тюрнева

24

тате которого наблюдено появление некоторого события А.

Спрашивается, как следует изменить вероятности гипотез в связи

с появлением этого события?

Здесь, по существу, речь идет о том, чтобы найти условную

вероятность Р(Нi/А) для каждой гипотезы.

Ответ на поставленную задачу дает следующая теорема гипотез.

Теорема гипотез. Вероятность гипотезы после испытания

равна произведению вероятности гипотезы до испытания на соответствующую ей условную вероятность события, которое произошло при испытании, деленному на полную вероятность этого

события:

P( H i / A ) =

P( H i )P( A / H i )

n

∑ P( H

k =1

k

, i = 1, 2, …, n.

(1.7.1)

)P( A / H k )

Формула (1.7.1) носит название формулы Байеса.

Доказательство. По теореме умножения имеем

Р(АНi) = Р(А) Р(Нi/А) = Р(Нi) Р(А/Нi), i = 1, 2, …, n

или, отбрасывая левую часть,

Р(А) Р(Нi/А) = Р(Нi) Р(А/Нi), i = 1, 2, …, n,

откуда

P( H i / A ) =

P( H i )P( A / H i )

, i = 1, 2, …, n.

P( A )

Выражая Р(А) с помощью полной вероятности (1.6.1), имеем

P( H i / A ) =

P( H i )P( A / H i )

n

∑ P( H

k =1

k

, i = 1, 2, …, n.

)P( A / H k )

Пример. Два автомата производят одинаковые детали, которые сбрасываются на общий конвейер. Производительность первого автомата вдвое больше производительности второго. Первый

автомат производит в среднем 80 % деталей отличного качества, а

второй – 90 %. Наудачу взятая с конвейера деталь оказалась от-

Теория вероятностей и математическая статистика

25

личного качества. Найти вероятность того, что эта деталь произведена вторым автоматом.

Решение. Обозначим через А событие, состоящее в том, что с

конвейера взята деталь отличного качества. Можно сделать два

предположения (выдвинуть две гипотезы) о способах происхождения события А:

Н1 – деталь произведена первым автоматом, причем (поскольку первый автомат производит вдвое больше деталей, чем

первый), Р(Н1) =

2

;

3

Н2 – деталь произведена вторым автоматом, причем

Р(Н2) =

1

.

3

Условные вероятности события А при гипотезах Н1 и Н2 соответственно равны Р(А/Н1) = 0,8, Р(А/Н2) = 0,9.

По формуле Байеса (1.7.1) находим вероятность гипотезы Н2

после испытания

P( H 2 )P( A / H 2 )

=

P( H 2 / A ) =

P( H1 )P( A / H1 ) + P( H 2)P( A / H 2 )

1

⋅ 0 ,9

9

3

=

= .

2

1

⋅ 0 ,8 + ⋅ 0 ,9 25

3

3

§ 1.8. Последовательные независимые испытания.

Схема Бернулли

Проводится n независимых испытаний, каждое из которых

имеет k несовместных исходов A1( S ) , A2( S ) ,…, Ak( S ) , причем вероятность исхода Ai( S ) не зависит от номера испытания S и равна pi

(i=1, 2, …, k). В силу несовместности и единственной возможно(S)

i

сти исходов A

k

, очевидно, имеем

∑p

i =1

i

= 1. Описанная схема

испытаний носит название схемы последовательных независимых

испытаний. Эта схема для случая k=2 впервые была рассмотрена

В. Н. Докин, Т. Г. Тюрнева

26

Я. Бернулли. В схеме Бернулли обычно полагают р1 = р,

р2 = 1 – р = q.

Подробное исследование таких последовательностей испытаний заслуживает исключительного внимания, как в силу непосредственного их значения в теории вероятностей и в приложениях, так и в силу выявившейся в процессе развития теории вероятностей возможности обобщения тех закономерностей, которые

впервые были открыты при изучении схемы последовательных

независимых испытаний, в частности схемы Бернулли. Многие

факты, подмеченные на этой частной схеме, впоследствии служили путеводной нитью при изучении более сложных схем.

1.8.1. Вычисление вероятностей Рn(m) в схеме Бернулли

Пусть проводятся n независимых испытаний, в каждом из которых может произойти либо событие А с вероятностью р, либо –

противоположное ему событие Ā с вероятностью q = 1 – p.

Рассмотрим событие Вm, состоящее в том, чтобы событие А в

этих n испытаниях наступит ровно m раз и, следовательно, не наступит ровно n–m раз. Событие А может появиться m раз в разных

последовательностях или комбинациях, чередуясь с противоположным событием Ā. Число возможных комбинаций такого рода

равно числу сочетаний из n элементов по m, т. е.

Cnm =

n!

. Следовательно, событие Вm можно предстаm! ( n − m )!

вить в виде суммы различных комбинаций событий, несовместимых между собой, причем число слагаемых равно C nm :

Bm = A1A2…AmĀm+1…Ān + Ā1A2A3…Am+1Ām+2…Ān + …

… + Ā1Ā2…Ān–mAn–m+1…An,

(1.8.1)

где в каждое произведение событие А входит m раз, а событие Ā

входит n–m раз. Вероятность каждой последовательности, входящей в формулу (1.8.1), по теореме умножения вероятностей для

независимых событий, равна pm(1–p)n–m = pmqn–m. Так как общее

число таких последовательностей равно C nm , то, используя теорему сложения вероятностей для несовместных событий, получим

вероятность события Вm (обозначим ее Pn(m)):

Теория вероятностей и математическая статистика

Pn(m) = C nm pmqn–m.

27

(1.8.2)

Полученная формула (1.8.2) носит название формулы Бернулли.

Так как события, состоящие в различном числе появлений

события А в серии из n испытаний, несовместны и образуют полную группу, то

n

n

∑ P ( m ) = ∑C

m=0

n

m=0

m

n

p m q n − m = ( p + q )n .

(1.8.3)

Учитывая, что p+q = 1, имеем

n

∑ P ( m ) = 1.

m=0

n

Так как члены суммы (1.8.3) совпадают с членами разложения бинома, вероятности Pn(m), вычисляемые по формуле Бернулли (1.8.2) иногда называют биномиальными, а последовательность

вероятностей Pn(m), m = 1, 2, …, n – биномиальным распределением.

Во многих случаях практики, кроме вероятности Pn(m) ровно

m раз появлений события А, приходится рассматривать вероятность не менее m появлений события А.

Обозначим Cm событие, состоящее в том, что событие А появится не менее m раз, а вероятность события Cm обозначим Rm,n.

Очевидно, что

Cm = Вm + Вm+1 + …+ Вn,

откуда по теореме сложения вероятностей для несовместных событий

Rm,n = Pn(m) + Pn(m+1) + … + Pn(n).

(1.8.4)

При вычислении Rm,n часто бывает удобнее не пользоваться

непосредственно формулой (1.8.4), а переходить к противоположному событию и вычислять вероятность Rm,n по формуле

m −1

Rm,n = 1 –

∑P (i ).

i =0

n

Если же при проведении n последовательных, независимых

испытаний в условиях схемы Бернулли возникает необходимость

в вычислении вероятности того, что событие А появится не менее

В. Н. Докин, Т. Г. Тюрнева

28

m1 и не более m2 (включая m2 раз), то на основании теоремы сложения вероятностей следует воспользоваться формулой

m

Р(m1 ≤ m ≤ m2) =

∑C

m = m1

m

n

pmqn–m.

1.8.2. Наивероятнейшее число наступлений события

при повторных независимых испытаниях

Определение. Наивероятнейшим числом m0 появления события А в n независимых испытаниях называется то значение m,

при котором вероятность Pn(m), рассматриваемая как функция

аргумента m, достигает своего наибольшего значения.

Для определения наивероятнейшего числа m0 не обязательно

вычислять вероятности всех возможных чисел появления события

А, достаточно знать число испытаний n и вероятность появления

события А в отдельном испытании.

Действительно, пусть наивероятнейшему числу m0 соответствует вероятность

Pn ( m0 ) = C nm0 p m0 q n − m0 =

n!

p m0 q n − m0 . (1.8.5)

m0 ! ( n − m0 )!

Тогда согласно определению наивероятнейшего числа m0

должны выполняться условия Pn(m0) ≥ Pn(m0+1) и Pn(m0) ≥ Pn(m0-1).

Разрешая эти неравенства относительно m0 и учитывая при

этом формулу (1.8.5), получаем двойное неравенство, которое и

служит для определения наивероятнейшего числа:

np – q ≤ m0 ≤ np + p.

(1.8.6)

Так как длина интервала, определяемого неравенством

(1.8.6), равна единице, а событие А может произойти в n испытаниях только целое число раз, то следует иметь в виду, что:

а) если np+p – целое число, то существует два значения наивероятнейшего числа, а именно m′0 = np-q = np+p–1 и m″0 = np+p;

б) если np+p – нецелое число, то существует одно наивероятнейшее число m0 =[np+p], где [np+p] – целая часть числа np+p.

Пример. Производится n бросаний правильной монеты. Найти наиболее вероятное число появлений «герба», если: а) n=6,

b) n=5.

Теория вероятностей и математическая статистика

Решение. Для обеих задач р =

29

1

1

. В случае (а) np+p = 6· +

2

2

1

1

= 3 , следовательно, имеем одно наивероятнейшее число

2

2

1

m0 = [3 ] = 3.

2

1 1

В задаче (b) np+p = 5· +

= 3, поэтому существует два наи2 2

+

вероятнейших числа: m′0 = np+p–1 = 2 и m″0 = np+p = 3, причем,

Р5(2) = Р5(3) =

10

.

5

2

Вопросы для самопроверки

1. Какие события называются случайными? Приведите примеры случайных событий.

2. Какие события образуют полную группу несовместных

событий?

3. Сформулируйте классическое определение вероятности

события. В каких пределах изменяется вероятность события?

4. Сформулируйте теорему сложения вероятностей для событий, образующих полную группу?

5. Как следует вычислять вероятность появления хотя бы одного из нескольких совместных событий?

6. При решении каких задач применяется формула Байеса

(теорема гипотез)?

7. Дайте определение наивероятнейшего числа при повторных

независимых испытаниях и приведите правило его вычисления.

Задачи к главе 1

1. Пусть А, В, С – три произвольных события. Найти выражения для событий, состоящих в том, что из А, В, С:

1) произошло только А;

2) произошли А и В, но С не произошло;

3) все три события произошли;

4) произошло, по крайней мере, одно из событий;

5) произошло одно и только одно событие;

30

В. Н. Докин, Т. Г. Тюрнева

6) ни одно событие не произошло;

7) произошло не больше двух событий.

2. В лотерее разыгрывается тысяча билетов. Среди них один

выигрыш в 1000 рублей, пять выигрышей в 500 рублей, двадцать

выигрышей по 100 рублей и пятьдесят выигрышей по 10 рублей.

Некто покупает один билет. Найти вероятность: а) выиграть не

менее 100 рублей; б) какого-либо выигрыша.

3. В урне шесть белых и четыре чёрных шара. Из урны вынимают наугад два шара. Найти вероятность того, что шары не

одного цвета.

4. Какова вероятность того, что трёхзначный номер случайно

отобранного автомобиля в большом городе а) имеет все цифры

разные? б) имеет только две одинаковые цифры?

5. Брошено пять игральных костей. Предполагается, что все

комбинации выпавших очков равновероятны. Найти вероятности

событий:

а) не выпало ни одной «6»;

б) выпало ровно три «6»;

в) выпала хотя бы одна «6».

6. Из карточек разрезной азбуки составлено слово

«КАРЕТА». Затем из этих шести карточек по схеме случайного

выбора без возвращения отобрано пять карточек. Найти вероятность того, что из отобранных карточек можно составить слово

«АРТЕК».

7. Найти вероятность того, что при случайной расстановке

двух ладей на шахматной доске они не будут угрожать друг другу.

8. Случайная точка Х равномерно распределена в квадрате

А={(x,y): x + y ≤ a }. Найти вероятность того, что квадрат с центром А и сторонами длины b, параллельными осям координат, целиком содержатся в квадрате А.

9. Случайная точка Х равномерно распределена в круге

S={(x, y): x 2 + y 2 ≤ R 2 }. Найти вероятность того, что параллельный оси абсцисс отрезок длины R с серединой в точке X целиком

содержится в круге S.

10. У квадратного трёхчлена x2+px+q коэффициенты p и q

выбраны наудачу из отрезка [-1,1]. Какова вероятность того, что

квадратный трёхчлен имеет действительные корни?

Теория вероятностей и математическая статистика

31

11. В первой урне находится 1 белый и 9 чёрных шаров, а во

второй 1 чёрный и 5 белых шаров. Из каждой урны случайным

образом удалили по одному шару, а оставшиеся шары ссыпали в

третью урну. Определить вероятность того, что вынутый из третьей урны шар, окажется белым.

12. В стройотряде 70 % первокурсников и 30 % студентов

второго курса. Среди первокурсников 10 % девушек, а среди студентов второго курса – 5 % девушек. Все девушки по очереди дежурят на кухне. Найти вероятность того, что в случайно выбранный день на кухне дежурит первокурсница.

13. Известно, что 95 % выпускаемой продукции удовлетворяет стандарту. Упрощенная схема контроля признает пригодной

стандартную продукцию с вероятностью 0,98 и нестандартную – с

вероятностью 0,06. Определить вероятность того, что изделие,

прошедшее упрощенный контроль, удовлетворяет стандарту.

14. Из урны, содержащей 3 белых и 2 черных шара, по схеме выбора без возвращения отобрали 2 шара. Шар, взятый наудачу из этих двух, оказался белым. Какова вероятность того, что

второй шар тоже белый?

15. Проведено 20 независимых испытаний, каждое из которых заключается в одновременном подбрасывании трёх монет.

Найти вероятность того, что хотя бы в одном испытании появятся

три «герба».

16. По цели производятся пять независимых выстрелов. Вероятность попадания в цель при одном выстреле равна 0,4. Для

получения зачета по стрельбе требуется не менее трёх попаданий.

Найти вероятность получения зачета.

17. В посёлке 2500 жителей. Каждый из них примерно 6 раз

в месяц ездит на поезде в город, выбирая дни поездок по случайным мотивам независимо от остальных. Какой наименьшей вместимостью должен обладать поезд, чтобы он переполнялся в

среднем не чаще одного раза в 100 дней (поезд ходит раз в сутки).

18. Вероятность отказа каждого прибора при испытании

равна 0,3. Сколько таких приборов нужно испытать, чтобы с вероятностью 0,99 получить хотя бы один отказ.

19. Вероятность появления события А в опыте равна 0,25.

Опыт повторили 8 раз независимым образом. Чему равно наиболее вероятное число появлений события А?

32

В. Н. Докин, Т. Г. Тюрнева

Глава 2. СЛУЧАЙНЫЕ ВЕЛИЧИНЫ

§ 2.1. Понятие случайной величины

До сих пор мы имели дело со случайными событиями. Событие является качественной характеристикой случайного результата опыта. Но случайный результат опыта можно характеризовать

и количественно. Например, число выпадений «герба» при десяти

бросаниях монеты, число вызовов, поступающих на телефонную

станцию в течение суток и т. д. Количественной характеристикой

случайного результата опыта является случайная величина.

Определение. Случайной величиной называется величина,

которая в результате опыта может принять то или иное значение,

неизвестно заранее, какое именно.

Понятие случайной величины является фундаментальным

понятием и играет очень большую роль в теории вероятностей.

Случайные величины обычно обозначаются заглавными буквами конца латинского алфавита X, Y, …, а их возможные значения – соответствующими прописными буквами x, y, ….

Как видно из определения случайной величины, она характеризуется множеством числовых значений, которые способна принимать. Это множество называется спектром случайной величины, а совокупность вероятностей, с которыми реализуются различные числовые значения случайной величины из ее спектра,

дает распределение вероятностей вдоль этого спектра.

Среди случайных величин, с которыми чаще всего приходится встречаться в практике, можно выделить два основных типа:

дискретные величины и непрерывные величины.

Дискретной случайной величиной называется такая величина,

спектр возможных значений которой – либо конечное, либо бесконечное счетное множество (множество, элементы которого могут быть перенумерованы).

Приведем примеры дискретных случайных величин.

Число попаданий при трех выстрелах.

Теория вероятностей и математическая статистика

33

Возможные значения случайной величины Х, выражающей

число попаданий при трех выстрелах будут следующие:

х1 = 0, х2 = 1, х3 = 2, х4 = 3.

1. Число вызовов, поступающих на телефонную станцию в

течение суток.

Случайная величина Х в данном примере может принять следующие числовые значения.

х1 = 0, х2 = 1, х3 = 2, …

Непрерывной случайной величиной называется такая величина, возможные значения которой непрерывно заполняют некоторый интервал (конечный или бесконечный) числовой оси.

Примеры непрерывных случайных величин:

1. Время безотказной работы электролампы.

2. Ошибка при измерении дальности радиолокатором.

§ 2.2. Закон распределения вероятностей

дискретной случайной величины

Рассмотрим дискретную случайную величину Х, возможные

значения которой х1, х2, …, хn нам известны. Очевидно, что знание

возможных значений случайной величины еще не позволяет полностью описать случайную величину, так как мы не можем сказать, как часто следует ожидать появления тех или других возможных значений случайной величины в результате повторения

опыта в одних и тех же условиях. Для этой цели необходимо знать

закон распределения вероятностей случайной величины.

В результате опыта случайная величина Х может принять одно из своих возможных значений, т. е. может произойти одно из

событий:

Х = х1, Х = х2, …, Х = хn.

(2.2.1)

Очевидно, что события (2.2.1) составляют полную группу,

так как в результате опыта случайная величина Х может принять

только одно значение, и никаких других событий, кроме перечисленных, в результате опыта произойти не может.

Обозначим вероятности этих событий через pk:

Р(Х = х1) = р1, Р(Х = х2) = р2, …, Р(Х = хn) = рn.

В. Н. Докин, Т. Г. Тюрнева

34

На основании того, что события (2.2.1) образуют полную

группу несовместных событий,

n

∑p

k =1

k

= 1.

Эта суммарная вероятность каким-то образом распределена

между отдельными значениями случайной величины. Дискретная

случайная величина будет полностью описана с вероятностной

точки зрения, если будет указано, какую вероятность имеет каждое из событий (2.2.1). Этим мы установим закон распределения

случайной величины.

Определение. Законом распределения случайной величины

называется всякое соотношение, устанавливающее связь между

возможными значениями случайной величины и соответствующими вероятностями.

Зная распределение вероятностей между возможными значениями случайной величины, можно до опыта судить о том, какие

значения случайной величины будут появляться чаще и какие –

реже.

Заметим, что способы или формы представления закона распределения случайной величины могут быть различными (некоторые из них будут рассмотрены позже).

Простейшей формой задания распределения дискретной случайной величины Х является таблица распределения, в которой

перечислены возможные значения случайной величины и соответствующие им вероятности.

xi

pi

x1

p1

x2

p2

…

…

xn

pn

(2.2.2)

Если в таблице (2.2.2) возможные значения случайной величины упорядочены: x1 < x2 < … < xn (или x1 > x2 > … > xn), то такая таблица называется рядом распределения. В дальнейшем под

рядом распределения будем понимать такой ряд распределения, в

котором возможные значения упорядочены в порядке возрастания

x1 < x2 < … < xn.

Чтобы придать ряду распределения более наглядный вид,

часто прибегают к его графическому изображению: по оси абсцисс откладываются все возможные значения случайной величи-

Теория вероятностей и математическая статистика

35

ны, по оси ординат – вероятности этих значений. Для наглядности

полученные точки соединяются отрезками прямых. Такая фигура

называется многоугольником распределения (рис. 2.2.1).

рi

р3

р4

р1

р2

р5

р6

хi

0

х1

х2

х3

х4

х5

х6

Рис. 2.2.1

Многоугольник распределения, так же как и ряд распределения, полностью характеризует случайную величину; он является

одной из форм закона распределения.

рi

0,4

0,3

0,2

0,1

хi

0

Рис. 2.2.2

1

2

3

Пример. Составить

закон распределения числа

попаданий при трех выстрелах, если вероятность

попадания при одном выстреле равна 0,4.

Решение. Обозначим

Х число попаданий. Возможные значения величины Х: х1=0, х2=1, х3=2, х4=3.

Вероятности этих значений находим по формуле Бернулли

(1.8.2): р1 = 0,63 = 0,216; р2 = C31 · 0,4 · 0,62 = 0,432;

р3 = C32 · 0,42 · 0,6 = 0,288; р4 = 0,43 = 0,064.

Ряд распределения случайной величины Х имеет вид:

В. Н. Докин, Т. Г. Тюрнева

36

xi

pi

0

0,216

1

0,432

2

0,288

3

0,064

Многоугольник распределения изображен на рис. 2.2.2.

§ 2.3. Функция распределения

Рассмотренный ряд распределения является удобной формой

представления закона распределения для дискретной случайной

величины с конечным числом возможных значений. Однако ряд

распределения вообще нельзя построить для непрерывной случайной величины. Действительно, непрерывная случайная величина имеет бесчисленное множество возможных значений, которые сплошь заполняют некоторый промежуток, и перечислить их

в какой-либо таблице нельзя. Кроме того (как будет показано в

конце этого параграфа), каждое отдельное значение непрерывной

случайной величины обычно не обладает никакой отличной от

нуля вероятностью. Следовательно, для непрерывной случайной

величины не существует ряда распределения в том смысле, в каком он существует для дискретной случайной величины. Однако

различные области возможных значений случайной величины все

же не являются одинаково вероятными, и для непрерывной величины существует «распределение вероятностей», хотя и не в том

смысле как для дискретной.

Для количественной характеристики распределения вероятностей удобно пользоваться не вероятностью события Х = х, а вероятностью события Х < х, где х – некоторая текущая переменная.

Вероятность этого события, очевидно, зависящая от х, есть некоторая функция от х. Эта функция называется функцией распределения, или интегральным законом распределения случайной величины Х и обозначается F(х):

F(х) = Р(Х< х).

Функция распределения – самая универсальная характеристика случайной величины. Она существует для всех случайных величин: как дискретных, так и непрерывных. Функция распределения

полностью характеризует случайную величину с вероятностной

точки зрения, т. е. является одной из форм закона распределения.

Теория вероятностей и математическая статистика

37

Геометрическая интерпретация функции распределения

очень проста. Если случайную величину рассматривать как случайную точку Х оси Ох (рис. 2.3.1), которая в результате испытания может занять то или иное положение на этой оси, то функция

распределения F(x) есть вероятность того, что случайная точка Х в

результате испытания попадает левее точки х. Для дискретной

случайной величины Х, которая может принимать значения

х1, х2, …. хn, … функция распределения имеет вид

F(x) =

∑ P( X = x ) ,

xi < x

i

где неравенство xi < x под знаком суммы означает, что суммирование распространяется на все те значения xi, которые по своей

величине меньше х.

х

0

Х

Рис. 2.3.1

х

Функция распределения дискретной случайной величины с законом распределения вида (2.2.2) имеет скачки в точках х1, х2, …. Хn,

где случайная величина принимает конкретные числовые значения.

В интервалах между значениями случайной величины функция F(x)

постоянна. Величина скачка в точке xi равна вероятности

pi = P(X = xi). Сумма всех скачков функции распределения равна

единице. График функции распределения дискретной случайной

величины – разрывная ступенчатая ломаная линия (рис. 2.3.2).

1

х1

х2

F(x)

хn-1

0 х3

Рис. 2.3.2

хn

В. Н. Докин, Т. Г. Тюрнева

38

Непрерывная случайная величина имеет непрерывную функцию распределения; график этой функции имеет форму плавной

кривой (рис. 2.3.3).

F(x)

1

х

0

Рис. 2.3.3

Отметим основные свойства функции распределения.

1. Функция распределения F(x) есть неотрицательная функция, заключенная между нулем и единицей:

0 ≤ F(x) ≤ 1.

Это свойство вытекает из определения функции распределения как вероятности осуществления события, заключающегося в

выполнении неравенства. Функция распределения, как и всякая

вероятность, есть величина безразмерная.

2. Функция распределения случайной величины есть неубывающая функция своего аргумента, т. е. при х2 > х1

F(x2) ≥ F(x1),

так как вероятность попасть на отрезок (–∞, х2) не меньше, чем

вероятность попасть на отрезок (–∞, х1) при х2 > x1.

3. F(–∞) = 0, F(+∞) = 1.

Свойство становится очевидным при геометрической интерпретации функции распределения (см. рис. 2.3.1). Если точка х

неограниченно перемещается влево, то попадание случайной точки Х левее х в пределе становится невозможным событием. По-

Теория вероятностей и математическая статистика

39

этому естественно полагать, что вероятность этого события стремится к нулю, т. е. можно записать F(–∞) = 0.

При неограниченном перемещении точки х вправо попадание

случайной точки Х левее х в пределе – достоверное событие. Поэтому естественно полагать, что вероятность этого события стремится к единице, т. е. F(+∞) = 1.

4. Вероятность того, что случайная величина Х примет какоенибудь значение, удовлетворяющее неравенству α ≤ X < β, равна

приращению ее функции распределения F(x) на этом интервале.

Действительно, событие X < β эквивалентно наступлению

одного из двух несовместимых событий, состоящих в том, что

случайная величина Х примет какое-нибудь значение, удовлетворяющее неравенствам X < α и α ≤ X < β. Поэтому согласно теореме сложения вероятностей, имеем

Р(X < β) = Р(X < α) + Р(α ≤ X < β),

откуда

Р(α ≤ X < β) = Р(X < β) – Р(X < α).

Используя для записей вероятностей функцию распределения F(x), получим

Р(α ≤ X < β) = F(β) – F(α).

(2.3.1)

5. Вероятность любого отдельного значения непрерывной

случайной величины равна нулю.

Полагая, что в (2.3.1) β → α, будем неограниченно уменьшать

интервал [α, β). В пределе вместо вероятности попадания случайной величины Х в интервал [α, β) получим вероятность того, что

эта величина примет отдельно взятое значение α:

Р(Х = α) = lim Р(α ≤ X < β) = lim [F(β) – F(α)].

β →α

β →α

(2.3.2)

Значение этого предела зависит от того, является ли функция

F(x) в точке α непрерывной или же терпит разрыв. Если в точке α

функция F(x) имеет разрыв, то предел (2.3.2) равен значению

скачка функции F(x) в точке α. Если же функция F(x) в точке α

непрерывна, то этот предел равен нулю.

Так как непрерывная случайная величина Х имеет непрерывную функцию распределения F(x), то из равенства (2.3.2) следует,

40

В. Н. Докин, Т. Г. Тюрнева

что вероятность любого отдельного значения непрерывной случайной величины равна нулю. На первый взгляд, этот вывод кажется парадоксальным, так как события, вероятности которых

равны нулю, в предыдущей главе рассматривались нами как невозможные. Из изложенного в настоящем параграфе следует, что

нулевой вероятностью обладают не только невозможные, но и

возможные события. Действительно, событие, состоящее в том,

что непрерывная случайная величина Х принимает значение α,

возможно, но вероятность этого события равна нулю. Этим непрерывная случайная величина отличается от дискретной (так называемый парадокс непрерывности).

На основании этого свойства для непрерывной случайной величины можно записать формулу (2.3.1) не включая в рассматриваемый интервал [α, β) левый конец

Р(α ≤ X < β) = Р(α < X < β) = F(β) – F(α).

§ 2.4. Плотность распределения

Функция распределения непрерывной случайной величины

является ее исчерпывающей вероятной характеристикой. Но она

имеет недостаток, заключающийся в том, что по ней трудно судить о характере распределения случайной величины в небольшой

окрестности той или другой точки числовой оси. Более наглядное

представление о характере распределения непрерывной случайной величины в окрестностях различных точек дается функцией,

которая называется плотностью распределения вероятности или

дифференциальным законом распределения случайной величины.

Пусть имеется непрерывная случайная величина Х с функцией распределения F(x), которую мы предположим непрерывной и

дифференцируемой. Вычислим вероятность попадания этой случайной величины на участок от х до х+∆х

Р(х < X < х+∆х) = F(х+∆х) – F(х),

т. е. приращение функции распределения на этом участке. Рассмотрим отношение этой вероятности к длине участка, т. е. среднюю вероятность, приходящуюся на единицу длины на этом участке

Теория вероятностей и математическая статистика

41

P( x < X < x + ∆x ) F ( x + ∆x ) − F ( x ) .

=

∆x

∆x

Переходя в последнем равенстве к пределу при ∆х →0, получим

lim

∆x → 0

P( x < X < x + ∆x ) =

F ( x + ∆x ) − F ( x ) = F'(x).

lim

∆x → 0

∆x

∆x

(2.4.1)

Введем обозначение

f(x) = lim P( x < X < x + ∆x ) .

∆x → 0

∆x

(2.4.2)

Функция f(x) характеризует как бы плотность, с которой распределяются значения случайной величины в данной точке. Эта

функция называется плотностью распределения или («плотностью

вероятности») непрерывной случайной величины Х. Иногда

функцию f(x) называют также «дифференциальной функцией распределения» или «дифференциальным законом распределения»

величины Х.

Из соотношения (2.4.1) следует, что

f(x) = F'(x).

(2.4.3)

Иногда в качестве определения плотности распределения выбирают последнее равенство.

Свойства плотности распределения непосредственно вытекают из ее определения.

В частности, если для непрерывной случайной величины Х с

плотностью распределения f(x) вычислить вероятность попадания

этой величины на отрезок от α до β, то получим (используя свойства функции распределения)

β

Р(α ≤ X < β) = F(β) – F(α) =

∫α dF ( x ) .

А так как из (2.3.4) следует, что dF(x) = f(x)dx, то

β

Р(α ≤ X < β) = F(β) – F(α) =

∫α f ( x )dx .

(2.4.4)

В. Н. Докин, Т. Г. Тюрнева

42

Если в (2.4.4) положить α = –∞, β = х и учесть свойство 3

функции распределения F(x), то получим

x

F(x) =

∫ f ( t )dt .

−∞

Если же в (2.4.4) считать α = –∞, β = +∞, то

+∞

F(+∞) – F(–∞) = 1 =

∫ f ( x )dx .

−∞

Полученное равенство

+∞

∫ f ( x )dx =1.

(2.4.5)

−∞

иногда называют условием нормировки массы вероятности (или

просто условием нормировки).

И, наконец, из (2.4.3) сразу же следует, что f(x) ≥ 0, так как

производная от неубывающей функции всегда неотрицательна.

График плотности распределения иногда называют кривой

распределения.

Пример. Случайная величина Х подчинена закону распределения с плотностью

⎧ 0 , при x < 1

⎪

f(х) = ⎨ c

.

⎪⎩ x 2 , при x ≥ 1

Требуется:

1. Найти коэффициент с.

2. Построить график плотности распределения.

3. Найти функцию распределения F(x) и построить ее график.

4. Вычислить вероятность попадания случайной величины Х

на участок от 2 до 4.

Решение. 1. Значение коэффициента с находится из условия

нормировки

Теория вероятностей и математическая статистика

43

∞

c

∫1 x 2 dx = 1 .

Отсюда

с=

1

= 1.

1

dx

2

х

∞

∫

1

3. Функция распределения F(x) определяется по формуле

x

F(x) =

∫ f ( t )dt .

(2.4.6)

−∞

x

При х ≤ 1 F(x) = 0; при х > 1 F(x) =

dt

1

=

1

–

.

∫1 t 2

х

Таким образом,

⎧ 0,

при x ≤ 1

⎪

F(x) = ⎨ 1

.

1

−

,

при

x

>

1

⎪⎩ x

4. Вероятность Р(2 < X < 4) попадания случайной величины Х

в заданный промежуток вычисляется по формуле (2.4.4).

Р(2 < X < 4) = F(4) – F(2) = (1 –

1

1

1

) – (1 – ) = .

4

4

2

Графики функций f(х) и F(x) изображены на рис. 2.4.1 и

рис. 2.4.2 соответственно.

f(x)

F(x)

1

1

х

0

1

х

0

Рис. 2.4.1

1

Рис. 2.4.2

44

В. Н. Докин, Т. Г. Тюрнева

§ 2.5. Понятие о системе случайных величин

В практических применениях теории вероятностей очень

часто приходится сталкиваться с задачами, в которых результат

опыта описывается не одной случайной величиной, а двумя или

более случайными величинами, образующими систему случайных

величин. Например, точка попадания снаряда определяется не одной, а двумя случайными величинами: абсциссой и ординатой.

Случайное отклонение точки разрыва от цели при дистанционной

стрельбе определяется системой трех случайных величин – тремя

координатами этой точки.

Совместное распределение двух или нескольких случайных

величин приводит к системе случайных величин. Условимся систему нескольких случайных величин Х, Y, …, W обозначать

(X, Y, …, W). При изучении системы случайных величин недостаточно изучить в отдельности случайные величины, составляющие

систему, необходимо учитывать еще и связи или зависимости между этими величинами. Здесь возникают новые, отличные от рассмотренных ранее, задачи.

При рассмотрении системы случайных величин удобно пользоваться геометрической интерпретацией системы. Так, например,

систему двух случайных величин (Х,Y) можно рассматривать как

случайную точку на плоскости хОу с координатами Х и Y или как

случайный вектор на плоскости со случайными составляющими Х

и Y. Систему трех случайных величин (X,Y,Z) можно рассматривать как случайную точку в трехмерном пространстве или как

случайный вектор в пространстве. По аналогии, систему n случайных величин (Х1,Х2, …,Хn) можно рассматривать как случайную точку в n-мерном пространстве или как n-мерный случайный

вектор.

В зависимости от типа случайных величин, образующих систему, могут быть системы дискретных и непрерывных случайных

величин, а также смешанные системы, в которые входят случайные величины различных типов.

При изучении систем случайных величин ограничимся подробным изучением системы двух случайных величин, так как все

положения, касающиеся системы двух случайных величин, можно

легко распространить на систему n случайных величин.

Теория вероятностей и математическая статистика

45

§ 2.6. Закон распределения системы случайных

величин. Таблица распределения

При изучении одной случайной величины мы познакомились

с законом ее распределения и рассмотрели различные его формы.

Аналогичную роль играет закон распределения системы случайных величин.

Определение. Законом распределения системы случайных

величин называется любое соотношение, устанавливающее связь

между областями возможных значений системы случайных величин и вероятностями появления системы в этих областях.

Из этого определения следует, что закон распределения системы случайных величин может быть задан в различных формах.

Рассмотрим сначала такую форму задания закона распределения,

как таблица распределения системы двух случайных величин.

Пусть X и Y – дискретные случайные величины, составляющие систему (X, Y), возможные значения которых (xi, yj), где i = 1,

2, …, n, а j = 1, 2, …, m. Тогда распределение системы случайных

величин (X, Y) может быть охарактеризовано указанием вероятностей pi,j = P (X = xi, Y = yj) того, что случайная величина Х, входящая в систему, примет значение xi и совместно с этим случайная величина Y примет значение yj.

Вероятности pi,j могут быть сведены в таблицу вида

хi

уj

у1

у2

…

уm

х1

х2

…

хn

p1,1

p1,2

…

p1,m

p2,1

p2,2

…

p2,m

…

…

…

…

pn,1

pn,2

…

pn,m

Такая таблица называется таблицей распределения системы

двух дискретных случайных величин с конечным числом возможных значений.

Все возможные события (X = xi, Y = yj), i = 1, 2, …, n, j = 1, 2, …, m

составляют полную группу несовместных событий, поэтому

n

n

m

∑∑ p

i =1 j =1

i, j

=

m

∑∑ P( Х = х , Y = y

i =1 j =1

i

j

) = 1.

В. Н. Докин, Т. Г. Тюрнева

46

При этом

m

∑p

j =1

i, j

n

∑p

i =1

i, j

=

m

∑ P( Х = х , Y = y

j =1

=

i

j

) = P( X = xi ) .

(2.6.1)

j

) = P( Y = y j ) .

(2.6.2)

n

∑ P( Х = х , Y = y

i =1

i

§ 2.7. Функция распределения системы

двух случайных величин

Определение. Функцией распределения системы двух случайных величин называется функция двух аргументов F(x,у), равная вероятности совместного выполнения двух неравенств Х<x и

Y<y, т. е.

F(x,у) = Р(Х<x, Y<y).

(2.7.1)

Геометрически функция распределения системы двух случайных величин представляет собой вероятность попадания случайной точки (Х,Y) в левый нижний бесконечный квадрант плоскости (рис. 2.7.1) с вершиной в точке (х,у).

Указанная геометрическая интерпретация системы двух

случайных

величин

в

соответствии

с

исходным

у

определением (2.7.1) позволяет

наглядно

иллюстрировать

следующие свойства функции

(х,у)

распределения F(x,у), которые

мы приведем без доказательств.

1о. Если один из аргуменх