методическая разработка элективного курса

advertisement

СОДЕРЖАНИЕ

СОДЕРЖАНИЕ ................................................................................................................................................................................. 1

ВВЕДЕНИЕ........................................................................................................................................................................................ 2

Пояснительная записка ..................................................................................................................................................................... 3

Занятие № 1. Случайные события. Мера их неопределенности. Формула Хартли .................................................................... 7

Занятие № 2. Энтропия по Шеннону. Свойства энтропии .......................................................................................................... 14

Занятие № 3. Условная энтропия. Решение задач на условную энтропию ................................................................................ 19

Занятие № 4. Количество информации. Решение задач .............................................................................................................. 23

Занятие № 5. Решение логических задач на взвешивание через энтропию и количество информации ................................ 29

Занятие № 6. Решение логических задач о лжецах через энтропию и количество информации ............................................. 29

Занятие № 7. Защита творческих проектов ................................................................................................................................... 30

ВВЕДЕНИЕ

Современное общество предъявляет к своим членам довольно высокие

требования, относящиеся к умению анализировать случайные факторы, оценивать

шансы, выдвигать гипотезы, прогнозировать развитие ситуации, принимать решение в

ситуациях, имеющих вероятностный характер, в ситуациях неопределенности,

проявлять комбинаторное мышление, необходимое в нашем перенасыщенном

информацией мире. Наиболее эффективно эти умения и навыки позволяет

формировать

курс

«Теория

вероятностей

и

математическая

статистика»,

о

необходимости изучения которого в российской школе люди науки спорят на

протяжении последнего столетия.

Включение теоретико-вероятностных знаний во всеобщее обучение является

одним из основных аспектов модернизации российского школьного математического

образования XXI века. Очевидно, что для качественного преподавания данного курса в

основной и средней школе необходима соответствующая специальная подготовка

педагогов, способных овладеть предметом, имеющим математическую природу и

широчайшее прикладное значение.

2

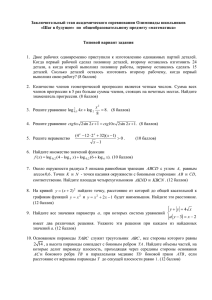

Факультативный курс 11 класс. Тематический модуль:

«Энтропия и информация. Решение логических задач»

Пояснительная записка

Развитое общество предъявляет к своим членам довольно высокие требования,

относящиеся к умению анализировать случайные факторы, оценивать шансы,

выдвигать гипотезы, прогнозировать развитие ситуации и, наконец, принимать

решение

в

ситуациях,

имеющих

вероятностный

характер,

в

ситуациях

неопределенности.

Новая содержательная линия изучения математики призвана сформировать

понимание детерминированности и случайности, помочь осознать, что многие законы

природы и общества имеют вероятностный характер, реальные явления и процессы

описываются вероятностными моделями. Учитывая то, что случайная величина

является математической моделью многих реальных явлений и процессов, необходимо

акцентировать внимание на изучении случайных величин, их числовых характеристик

и степени их неопределенности. Умение ориентироваться в этих показателях помогает

человеку принимать оптимальные решения, адекватно воспринимать информацию.

Как и многие изучаемые в школьном курсе математики темы предполагают

возможность

изучения

дополнительных

разделов

через

элективные

курсы,

факультативы, научно-исследовательскую деятельность, так и «Теория вероятностей и

математическая статистика» может иметь продолжение и возможность интеграции с

обязательными темами изучения в средней школе. Знакомство учащихся с

нетрадиционными вопросами теории вероятностей позволяет увидеть возможности

продолжения понятия вероятности и их применения для решения школьных

логических задач, рассмотреть практическое применение некоторых вопросов

программного материала. Одним из таких вопросов является решение логических

задач с помощью понятия энтропии.

В основной школе учащиеся знакомятся с понятием графа (дерева возможных

вариантов), в рамках элективных курсов могут рассматривать (рассматривают)

логические задачи на выделение элемента множества (задачи на взвешивание,

угадывание задуманного, о лжецах) и их решение с помощью графов и логических

рассуждений. Но при этом остается открытым вопрос о минимально возможном числе

3

взвешиваний или вопросов. Учащиеся не владеют математическими знаниями для

решения подобных задач с целью получения однозначно неопровержимого ответа.

Конечно, при построении графов развивается логическое мышление, внимание,

формируется умение выдвигать гипотезы, но поиск возможных числовых ответов

порой не может убедить, что это «наименьшее».

Введение в средней школе понятия логарифма, и его свойств, интеграция данной

темы с вопросами теории вероятностей, рассмотренными в основной школе,

позволяет не только дать однозначный ответ на вопрос задачи о наименьшем

количестве взвешиваний

(вопросов), но

и

продемонстрировать практическое

приложение понятия логарифма.

Все это раскрывает тема «Энтропия и информация», которая не является

общепринятым материалом курса «Теория вероятностей», но способствует установить

аналогии новых результатов с ранее рассматриваемыми. Удачно занятия по данной

теме проводить параллельно с изучением темы «Логарифмы», но возможно и более

позднее обращение к теме «Энтропия и информация» чем изучение логарифмов.

Первый подход – практическое применение изучаемого, второй подход и практическое

применение изученного и его повторение.

Цели курса «Энтропия и информация»

Развитие логического мышления и формирование базы математических знаний;

Практическое применение изучаемого (изученного) программного материала

средней школы;

Построение простейших вероятностных моделей реальных процессов и явлений,

учитывающих влияние случая;

Создание определенного алгоритма для оценки предсказуемости случая;

Решение логических задач с применением понятия энтропии;

Для достижения поставленных целей необходимо решить следующие задачи:

Расширить представления учащихся о дискретной математике, ее возможностях

при вполне жизненных ситуациях;

Показать учащимся возможности математики для измерения и сравнения

неопределенностей различных ситуаций;

Ввести новые математические понятия энтропии и количества информации;

4

Установить зависимость степени неопределенности от числа равновероятных

исходов;

Определить связь количества информации с мерой неопределенностей;

Показать способы использования ориентированного графа и кодового дерева для

построения рассуждений и выводов;

Интегрировать алгебраический и графический методы для решения задач о лжецах,

на взвешивание и др.;

Предложить комплекс логических задач, решаемых методом подсчета информации.

В результате освоения данного курса ученик должен научиться:

Различать количественные характеристики случайного события: вероятность и

степень неопределенности (энтропию);

Выполнять простейшие вычисления и преобразования, связанные с логарифмом по

основанию 2;

Уметь

находить

степень

неопределенности

через

известную

(найденную)

вероятность случайного события;

Сравнивать два события по их неопределенности;

Находить количество информации об опыте для оптимизации его результатов;

Применять полученные умения и навыки для решения логических задач

алгебраическим и графическим методами.

Актуальность программы определяется необходимостью осознания учащимися связи

теории вероятностей и алгебры с практикой жизни. Курс предполагает овладение

широким понятийным аппаратом, знакомство с различными логическими структурами

определений, развитие умений подводить объект под понятие, применять определения

в процессе рассуждений. Теоретический и практический материал курса в силу своей

компактности, информативности предоставляет возможности школьникам быстрее и с

меньшими трудностями проследить процесс обобщения понятий.

Усвоению знаний должно способствовать развитие умения анализировать,

выявлять закономерности, обобщать, логически излагать свои мысли, ставить и

разрешать проблемы. Курс должен помочь школьникам овладеть способами

исследовательской

деятельности,

стать

фактором

формирования

творческого

мышления.

5

Общие принципы отбора содержания материала:

актуальность,

наглядность,

доступность,

обеспечение мотивации,

целостность,

Системность содержания достигается логикой развертывания учебного материала

таким образом, что изучение всех последующих тем обеспечивается предыдущими, а

между частными и общими знаниями прослеживаются связи.

Организация учебной работы предусматривает:

проблемное изложение и изучение материала (выделение ключевых вопросов,

проблемный, эвристический характер их рассмотрения),

выполнение

самостоятельной

поисковой,

творческой

работы

учащимися

индивидуально, в группах, микрогруппах, коллективе;

реализацию принципа совместного целеполагания: «цель учителя

- цель

ученика».

Учебно-тематический план:

Каждое занятие по 2 часа.

1. Случайные события. Мера их неопределенности. Формула Хартли.

2. Энтропия по Шеннону. Свойства энтропии.

3. Условная энтропия. Решение задач на условную энтропию.

4. Количество информации. Решение задач.

5. Решение логических задач на взвешивание через энтропию и количество

информации.

6. Решение логических задач о лжецах через энтропию и количество информации.

7. Защита творческих проектов.

Итого: 14 часов (можно увеличить количество часов на решение логических

задач)

6

Занятие № 1. Случайные события. Мера их неопределенности. Формула Хартли

Цели занятия:

Вспомнить понятие случайных событий;

Ввести понятие энтропии, ее свойства;

Ввести формулу Хартли, рассмотреть условия применения ее при решении задач

на угадывание;

Задачи занятия:

Научиться среди предложенных событий выбирать неопределенные;

Установить

соответствие

между

вероятностью

события

и

его

неопределенностью;

Научиться подсчитывать энтропию события по формуле Хартли;

Отработать метод половинного деления для решения задач на угадывание;

Разобрать алгоритм решения задач на угадывание с применением понятия

энтропии

Методика организации занятия:

Лекция с элементами диалога;

Дискуссия относительно выдвигаемых гипотез;

Игровые ситуации по содержанию задач;

Работа в микрогруппах, аргументация доказательства конкретной точки зрения.

План занятия:

1. Лекция – диалог «Вероятность – характеристика случайных событий»

2. Упражнение № 1. Неопределенные события, их характеристика.

3. Понятие энтропии по Хартли. Задача 1/1.

4. Решение задачи 2 \1, Решение задач на угадывание 3/1 – 11/1

Ход занятия: I. В рамках курса «Теория вероятностей и математическая статистика»

введен алгоритм определения вероятности того или иного события. Необходимо

вспомнить, как называется событие, вероятность наступления которого отлична от 1.

(Случайное). Обратить внимание на то, что название отражает характер наступления

события (Неизвестно, наступит оно или нет), подобрать слово – синоним к

состоянию неизвестности (неопределенность).

7

СОБЫТИЯ

Р (А) = 1

0<Р(А)< 1

СЛУЧАЙНЫЕ

ДОСТОВЕРНЫЕ

Р (А) = 0

НЕВОЗМОЖНЫЕ

Предметом дальнейшего изучения будут случайные (неопределенные) события.

Упражнение № 1.

1. Первый встречный человек мужского пола.

2. За понедельником будет вторник.

3. За контрольную работу можно получить «отлично».

4. К телефону из пяти членов семьи подойдет младший сын.

5. После 31 января наступит 1 февраля.

6. После лета буде зима.

7. Каждый

из

15

учеников,

посещающих

данные

занятия,

поступит

на

математическую специальность.

8. В лотерее победит билет с номером 777777.

9. Подброшенная монетка упадет гербом вверх.

10.На подброшенном кубике выпадет шесть очков.

11.Из выбираемых наугад карточек с цифрами выберем карточку с цифрой 5.

Задания: среди 11 событий

1. Указать достоверные (2,5)

2. Указать невозможные (6)

3. Указать неопределенные. (1, 3,4,6,7,8,9,10)

4. Среди неопределенных указать те, которые имеют 2 равновозможных исхода (1,9)

5. Неопределенные события расставить в порядке возрастания числа равновероятных

исходов (№ 1,9-2; № 3-4; №4-5; № 10-6; № 11-10; № 7-15; № 8-число проданных

билетов)

6. Назвать событие более неопределенное. (№ 8)

7. Назвать событие менее неопределенное. (№ 1,9)

8

8. Учитывая задания № 6 и № 7, установить зависимость степени неопределенности

от числа равновероятных исходов. (Чем больше равновероятных исходов, тем

больше степень неопределенности)

9. Сделать тот же вывод, используя понятие вероятности. (Чем меньше вероятность,

тем больше степень неопределенности).

Таким образом, степень неопределенности – есть еще одна характеристика

случайного события, которую назвали энтропией. (Н(α)). За единицу энтропии

принимается

неопределенность,

содержащаяся

в

опыте,

имеющем

два

равновероятностных исхода. Единица измерения, учитывая двоичную систему

исчисления, - бит.

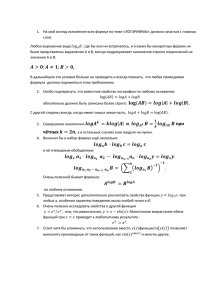

II. Понятие ЭНТРОПИИ

Пусть опыт α меет k равновозможных исходов. От этого числа зависит и значение

вероятности одного из них Р(А)=1/k, и значение энтропии. Но как ее подсчитать, пока

неизвестно. Этому и посвящена основная часть занятия.

Если k=1, то f(k) = 0 (неопределенности нет)

f(k) – возрастающая, т.к. чем больше равновозможных исходов, тем больше

степень неопределенности.

Рассмотрим сложный опыт αβ, где опыт α имеет k равновозможных исхода, а β –

m равновозможных исхода. Очевидно, что неопределенность сложного опыта αβ

будет складываться из неопределенностей каждого опыта в отдельности. т.е.

f(km) = f (k) + f(m)

Сопоставляя полученную информацию с имеющими знаниями функциональных

зависимостей, получаем, что f (k) – есть логарифмическая зависимость: log2k или logk

Заметим, что выбор основания системы логарифмов здесь несуществен, так

как в силу известной формулы log b k log b a log a k переход от одной системы

логарифмов к другой сводится лишь к умножению функции f (k ) log k на постоянный

множитель (модуль перехода log b a ), т. е. равносилен простому изменению единицы

измерения степени неопределенности. В конкретных примерах «меры степени

неопределенности» обычно используют логарифмы при основании два. Это означает,

что за единицу измерения степени неопределенности здесь принимается неопределенность, содержащаяся в опыте, имеющем два равновероятных исхода (например, в

9

опыте, состоящем в подбрасывании монеты и выяснении того, какая сторона ее

оказалась сверху, или в выяснении ответа «да» или «нет» на вопрос, по поводу

которого мы

с равными

основаниями

можем ожидать, что ответ будет

утвердительным или отрицательным). Такая единица измерения неопределенности

называется двоичной

единицей

или

битом1. В дальнейшем будем все время

пользоваться двоичными единицами (битами); таким образом, запись log k (где мы, как

правило, не будем указывать основания системы логарифмов) будет обычно означать

log2k. Заметим, что

ничего не изменилось бы, если бы мы использовали более

привычные десятичные логарифмы; это лишь означало бы, что единицу степени

неопределенности опыта, имеющего 10 равновероятных исходов. Таким является,

например,

опыт,

состоящий

в

извлечении

шара

из

урны

с

десятью

перенумерованными шарами, или опыт по отгадыванию одной цифры, если любая из

десяти цифр имеет одинаковую вероятность быть загаданной. Эта последняя единица

степени неопределенности (которую называют десятичной единицей или дитом)

примерно в 3

1

1

раза больше двоичной единицы (так как log 2 10 3,32 3 ).

3

3

Учтем, что logk = -1/k log 1/k

Именно такой подход к определению степени неопределенности опыта лежит в

основе идеи американского инженера-связиста Хартли (1928). Пусть опыт α меет k

1

1

1

равновозможных исходов. H ( ) log k log log k . Этой формулой

k

k

k

удобно пользоваться, когда исходы равновероятны.

Задача № 1/1. Что имеет большую степень неопределенности угадывание месяца или

дня недели рождения случайно встреченного человека.

Решение: Так как месяц рождения имеет 12 равновероятных исходов, а день недели

имеет 7 равновероятных исхода, то степень неопределенности угадывания месяца

рождения больше, чем угадывание дня недели.

Задачи на угадывание. Решение с помощью формулы Хартли.

Характерной особенностью задач на угадывание, в которых можно применить понятие

энтропии,

1

является наличие условия: на вопросы при угадывании отвечающий

Английское слово бит было образовано с помощью сжатия слов binary digit, означающих «двоичная цифра» или

«двоичная единица»

10

говорит «да» или «нет». Исходы равновероятны, значит уместно применять формулу

Хартли.

Задача № 2/1. Какую степень неопределенности имеет угадывание месяца рождения

случайно встреченного человека.

Решение:

Методические рекомендации: Так как месяц рождения имеет 12 равновероятных

исходов, то воспользуемся формулой Хартли: Н(α) = log k = log12 = 2 + log 3.

Ответ: 2 + log 3.

Ключевой вопрос занятия: Сколько вопросов следует задать, чтобы быстрее

отгадать конкретный месяц? Отвечающий говорит «да» или «нет».

Интересно выслушать предположения относительно ответа на задачу 2/1.

Так как неопределенность данного опыта равна 2 + log 3, а число вопросов – целое, то

для полного снятия неопределнности требуется число вопросов – ближайшее целое

число, превышающее (или совпадающее, если Н(α) целое) с Н(α), т.е. n ≥ Н(α) = log k.

Решение задачи №2/1:

n ≥ Н(α) = log k

3<2+log3 <4; 2+log 3≈ 3,24, Значит, вопросов должно быть 4.

Ответ: 4.

Предложить вариант системы вопросов. Например,

1. В первой половине года? (Да)

2. В первой половине выбранной половины? (Да)

3. Это средний из трех месяц? (Нет)

4. Это первый из трех месяц? (Нет) Значит, третий месяц сезона.

Рассмотреть алгоритм рассуждений при формировании группы вопросов. Обратить

внимание на то, что сначала делим на две группы, затем еще раз на две, и лишь затем

на три, формулируя вопросы для максимального снятия неопределенности.(метод

половинного деления)

Далее группа разбивается на 3 микрогруппы, каждая получает свою задачу. В течение

5 минут проводят решение, которое затем предлагается всей группе.

11

Задача № 3 / 1

Задача № 4 /1

Задача № 5 / 1

Сколько вопросов необходимо задать, чтобы отгадать задуманное собеседником целое положительное число, не превышающее 10.

Отвечающий дает ответы

«да» или «нет»

Сколько вопросов необходимо задать, чтобы отгадать задуманное собеседником целое положительное число, не превышающее 100.

Отвечающий дает ответы

«да» или «нет»

Решение:

Сколько вопросов необходимо задать, чтобы отгадать задуманное собеседником целое положительное число, не превышающее 1000.

Отвечающий дает ответы

«да» или «нет»

n ≥ Н(α) = log k;

log 10 = log 2+ log 5 ≈

1+ 2,32 = 3,32

n ≥ Н(α) = log k;

log 100= log 4 + 2 log 5 ≈

2+2*2,32 = 6,64

n=4

n=7

n ≥ Н(α) = log k;

log 1000 = log 8 + log 125 =

log 8 + 3 log 5 ≈ 3+3*2,32 =

9,96

n=10

Далее можно проиграть задачи в конкретной ситуации, предложив группе

загадать число в соответствии с условием задачи, а другой провести систему вопросов.

Так по цепочке каждую микрогруппу поставить в разную позицию: спрашивающего и

загадывающего. Если группа выходит за пределы контрольного показателя, то

подключается другая группа. Вопросы при этом фиксируются. Необходимо обсудить

вопрос о том, что количество вопросов может быть и меньше (удачный частный

случай), но это нельзя считать общим решением задачи.

Метод, применяемый при составлении системы вопросов, называется методом

половинного деления: вопросы ставить так, чтобы число элементов исследуемого

множества уменьшалось вдвое или почти вдвое.

Далее группа делится на 5 микрогрупп, каждая получает свою задачу, на

предположение ответа, решение и обсуждение (проигрывание системы вопросов)

которой отводится 10 минут, после чего проходит защита своего решения. На доске

плакат. Сразу после прочтения задачи, группа заполняет столбец гипотезы, затем

решает и сверяет свою математическую интуицию.

Курсивом указано то, что

появляется после работы групп. (таблица)

№

6/1

Содержание

Гипотеза

Человек живет в пятиэтажном доме с

четырьмя подъездами и четырьмя

квартирами на каждом этаже. За

какое наименьшее число вопросов

можно определить точно номер

квартиры, если на все вопросы

человек будет отвечать «Да» или

«Нет»?

Решение

Число квартир = 80

n ≥ Н(α) = log k;

log80= log 16 + log5 ≈ 4+2,32 =

6,32

n=7

12

№

7/1

Содержание

Гипотеза

За сколько вопросов, на которые

отвечают «Да» или «Нет», можно

угадать дату рождения конкретного

человека?

8/1

За сколько вопросов, на которые

отвечают «Да» или «Нет», можно

угадать

номер

шестизначного

телефона?

За сколько вопросов, на которые

отвечают «Да» или «Нет», можно

отгадать одного из загаданных

учащихся группы из 27 человек?

10/1 За сколько вопросов, на которые

отвечают «Да» или «Нет», можно

отгадать одного из загаданных

учащихся группы из 32 человек?

11/1 Одна

из

составных

частей

бензинового двигателя имеет форму

валика, для измерения толщины

которого используется стальная

лента с 15 шаблонными отверстиями

от 10 мм до 10,56 через каждые 0,04

мм. Калибровка калика заключается

во вкладывании валика в отверстия

контрольного стенда. За какое

наименьшее

число

испытаний

обязательно удастся найти диаметр

валика? (знание данного метода

позволит

автослесарю

работать

эффективнее)

9/1

Решение

Дней в году 365

n ≥ Н(α) = log k;

log365 = log73 + log 5 ≈ 6,19+2,32

= 8,51

n=9

Учитывая знания по

комбинаторике, получаем, что

всего шестизначных номеров

9*105

n ≥ Н(α) = log k;

log(9*105)= log9 + 5log10 ≈ 2log3 +

5log2+5 log5= 2*1,24

+5+5*2,32=19,8

n=20

n ≥ Н(α) = log k;

log27= log33 =3 log3 ≈ 3*1,24 =3,72

n=4

n ≥ Н(α) = log k;

log32= log25 =5 log2= 5

n=5

n ≥ Н(α) = log k;

log15= log3+ log5≈

1,24 + 2,32=3,56

n=4

Итог решения задач на угадывание:

Если исходы каждого отдельного испытания равновероятны, то для решения

задачи оптимально применить формулу Хартли;

Задачи на угадывание при ответах «Да», «Нет» решаются методом половинного

деления, что позволяет определить оптимальную систему вопросов;

Наименьшее число вопросов – ближайшее натуральное число, при округлении

дробного значения - с избытком, т.е. n ≥ Н(α) = log k;

Домашнее задание: придумать 2-3 задачи на данный метод, оформить для банка

упражнений.

13

Занятие № 2. Энтропия по Шеннону. Свойства энтропии

Цели занятия:

Продолжить усвоение понятия энтропия и ее свойств через введение формулы

Клода Шенона

Задачи занятия:

Создать проблемную ситуацию невозможности решить задачу с помощью

формулы Хартли;

Ввести формулу Клода Шеннона;

Рассмотреть анализ условий задач табличным и графическим методами;

Ввести алгоритм решения задач на сравнение неопределенностей событий;

Свойства энтропии;

Провести тренинг сравнения степеней неопределенности событий.

Методика проведения занятия: Лекция с элементами диалога;

План занятия:

1. Переход от формулы опытов с равновероятными исходами к опытам с

неравновероятными исходами;

2. Понятие энтропии в общем случае;

3. Решение задач 1 / 2 - 4 / 2

4. Домашнее задание

Ход занятия: Итак, пусть опыт имеет k равновероятных исходов, тогда общая

неопределенность опыта равна logk. Каждый отдельный исход, имеющий вероятность

1\k, вносит неопределенность, равную

1\k logk, а учитывая рассмотренные ранее

формулы, имеем 1\ k logk = -1\ k log1\k. Так рассуждал Джон Хартли, который не учел

возможность неравновероятных исходов. Ошибочность точки зрения Хартли была

показана Клодом Шенноном, американским математиком и инженером, который

предложил принять в качестве меры неопределенности опыта α с возможными

k

k

i 1

i 1

исходами А1, А2, … Аk величину H ( ) P( Ai ) log P( Ai )1 P( Ai ) log P( Ai )

Исходы опыта

А1

А2

А3

Аk

Вероятности

p(А1)

p(А2)

p(А3)

p(Аk)

Мера неопр.

-p(А1) log p(А1)

-p(А2) log p(А2)

-p(А3) log p(А3)

-p(Аk) log p(Аk)

14

Общая мера неопределенности опыта есть сумма мер неопределенностей

отдельных исходов: -p(А1) log p(А1) - p(А2) log p(А2) - p(А3) log p(А3) … -p(Аk) log

p(Аk) = Н (α), что называется энтропией опыта α.

Рассмотрим все сказанное выше на задачах.

Задача №1/2.

Имеются 2 урны. Первая содержит 20 шаров – 10 белых, 5 черных и 5 красных; вторая

содержит 16 шаров: 4 белых, 4 черных и 8 красных во второй. Из каждой урны

вытаскивают по одному шару. Исход какого из этих двух опытов следует считать

более неопределенным?

Решение:

Первый опыт связан с первой корзиной:

Цвет вынутого шара

Вероятность

Энтропия

(неопределенность)

белый

1\2

-1\2 log 1\2

черный

1\4

-1\4 log 1\4

красный

1\4

-1\4 log 1\4

Неопределенность данного опыта, или энтропия равна:

Н (α)= -1\2 log 1\2 - 1\4 log 1\4 - 1\4 log 1\4 = 1\2 +1\2 +1\2 = 3\2 бита

Второй опыт связан со второй корзиной:

Цвет вынутого шара

Вероятность

Энтропия

(неопределенность)

белый

1\4

-1\4 log 1\4

черный

1\4

-1\4 log 1\4

красный

1\2

-1\2 log 1\2

Неопределенность данного опыта, или энтропия равна:

Н (β)= -1\2 log 1\2 - 1\4 log 1\4 - 1\4 log 1\4 = 1\2 +1\2 +1\2 = 3\2 бита

Ответ: опыты одинаково неопределенны.

Изобразить решение задачи

соответствующие значения

графически,

вписать

в

пунктирные

рамки

.

белый

α

черный

α

красный

вероятность=1

неопределенность=3\2

белый

15

β

β

черный

красный

вероятность=1

неопределенность=3\2

Задача №2/2.

Какую степень неопределенности содержит опыт угадывания цвета двух шаров,

извлеченных из урны, в которой находятся 2 белых и 3 черных шара?

Решение: построим графическую модель опыта

Р=2\5

Р=1\4

Р=3\5

Р=2\4

Р=2\4

Р=3\4

Р=3\10

Р=3\10

Р=3\10

Р=2\5 * 1\4 =1\10

H ( )

3

1

1

3 1

10 1

1

3

3

log 3 log log 10 3 log log 2 5 3 log 10

10

10

10 10

3 10

3

10

10

10

1

9

1 1

9

1

9

1

(log 2 log 5) log 10 log (1 log 5) 1 log 5 log 1 log 5 log

10

10

3 10

10

3

10

3

9

1 log 5 log 3 (бит).

10

Ответ: Н ( ) 1 log 5

9

log 3 (бит).

10

Задача №3/2.

Из многолетних наблюдений за погодой на определенной территории известно, что 15

июня вероятность осадков равна 0,4; а 15 ноября вероятность осадков равна 0,8.

Какой из прогнозов является более неопределенным?

Решение:

15 июня

Погода

Осадки

Отсутствие осадков

Вероятность

0,4

0,6

Неопределенность

-0,4 log0,4

-0,6 log0,6

16

H ( )

4

4 6

6

4

4

1 6

1 6

1

log log

log 4 log 6 log 4 log (log 6

10

10 10

10

10 10 10 10

10

10 10

1

4

4

6

6

4

4

6

6

8

log 4 log 10 log 6 log 10 2 log 10 log 6 log 10

10

10

10

10

10

10

10

10

10

10

6

4

6

log 10 log 6 log 5 log 6 (бит).

10

10

10

log

15 ноября

Погода

Осадки

Отсутствие осадков

Вероятность

0,8

0,2

Неопределенность

-0,8 log0,8

-0,2 log0,2

H ( 1 )

2

2 8

8

2

2

1

1 8

1

log log

log 2 log 8 log 2 log

10

10 10

10

10 10 10 10

10

10

8

1

2

8

8

2

2

8

8

log 8 log log 10 log 8 log 10 1 log 10 3 log 10

10

10

10

10

10

10

10

10

10

6

6

2 log 10 1 log 5 (бит).

10

10

2

6

6

8

6

8

6

6

log 5 log 6 (1 log 5) 1 log 6 1 1 log 3

10

10

10

10 10

10 10

10

2 6

6

1 log 3 (2 log 3) 0, т.к. 1 log 3 2

10 10

10

H ( ) H ( 1 )

H ( ) H (1 ).

Ответ: Прогноз на15 июня является более неопределенным

Задача №4/2. (Немного изменяем условие задачи №3/2: уточним вероятности

возможных осадков. Можно сначала учащихся попросить высказать гипотезы

относительно ответа)

Из многолетних наблюдений за погодой на определенной территории известно, что 15

июня вероятность осадков равна 0,4; а 15 ноября вероятность осадков равна 0,8,

причем вероятность дождя равна 0,48,а вероятность снега 0,32. На какое число прогноз

погоды является более неопределенным?

Решение:

15 июня (без изменений)

Погода

Осадки

Отсутствие осадков

Вероятность

0,4

0,6

Неопределенность

-0,4 log0,4

-0,6 log0,6

17

H ( )

4

4

6

6

4

4

1 6

1 6

1

log

log

log 4 log 6 log 4 log (log 6

10

10 10

10

10 10 10 10

10

10 10

1

4

4

6

6

4

4

6

6

8

log 4 log 10 log 6 log 10 2 log 10 log 6 log 10

10

10

10

10

10

10

10

10

10

10

6

4

6

log 10 log 6 log 5 log 6 (бит).

10

10

10

log

15 ноября (с уточнением вероятностей видов осадков)

Погода

Дождь

Снег

Отсутствие осадков

Вероятность

0,48

0,32

0,2

Неопределенность

-0,48 log0,48

-0,32 log0,32

-0,2 log0,2

H ( 1 )

2

2

48

48 32

32

2

1 32

1 48

log

log

log

log 2

log 48

10

10 100

100 100

100

10 10 100

100 100

1

2

1 48

1 32

1

2

log 32

log 2 log

log 48 log

log 32 log

log g 2

100

10

10 100

100 100

100

10

2

48

32

2

2

48

48

8

32

log 10

log 100

log 100 1 log 10

4

log 3 log 100

5

10

100

100

10

10

100

100

10

100

2

92

6

2

8

72

2

2

6

6

92

1

1 log 10 log 100 3

log 5 1 1 log 5 1

10 100 10 10

10

100 10 10

10 10

100

8

1 log 5 (бит).

10

H ( ) H (1 ) log 5 0,6 log 3 0,4 (1,92 1,8 log 5) 1,52 (0,6 log 3 0,8 log 5) 0,

т.к. 1<log3<2, то 0,6< 0,6log3<1,2

2<log5<2,5, то1,6< 0,8log5<2

2,2< 0,6 * log3+ 0,8 log5<3,2

Н (α) < Н (α1).

Ответ: Прогноз на15 ноября с уточнением вероятностей видов осадков является более

неопределенным.

Домашнее задание

№1. Найдите степень неопределенности извлечения 2 шаров из урны, содержащей

один белый, 2 черных и три красных шара.

№2. Одна урна содержит 1 белый и 2 черных шара, а другая 2 белых и 3 черных. В

каком случае угадывание цвета вынутого шара более предсказуемо?

№3. в первой урне 2 белых и 4 черных шара, а во второй – 3 белых и 3 черных. Из

каждой урны вынимают по 2 шара. Исход какого из этих 2 опытов менее предсказуем?

18

Занятие № 3. Условная энтропия. Решение задач на условную энтропию

Цель занятия: введение понятия условной энтропии для решения соответствующих

задач.

Задачи занятия:

Ввести понятие условной энтропии;

Обозначить тип задач, решаемых с применением условной энтропии;

Ввести алгоритм решения задач на условную энтропию;

Разобрать набор задач;

Ввести свойства энтропии, привести доказательство;

План занятия:

1. Проблемная ситуация через задачу 1 / 3

2. Разбор Графа условной энтропии в общем виде;

3. Применение общих подходов к конкретной ситуации;

4. Решение задач 2 / 3 – 4 / 3

5. Свойства энтропии. Доказательство свойства № 5.

6. Домашнее задание.

Ход занятия:

Задача № 1/3. Какую энтропию содержит опыт угадывания простой цифры при

извлечении из цифровой азбуки при условии, что одна карточка утеряна?

Анализ условия показывает, что задача отличается от предыдущих, т.к. есть

дополнительное условие. Такие задачи принято относить к условной энтропии.

Условной энтропией опыта β относительно опыта α называется математическое

ожидание условной энтропии опыта β относительно всех исходов опыта α: Н (β/α) =

∑Р(Аi) Н (β/Аi), где Н (β/Аi) – условная энтропия опыта β относительно исхода Аi

Н (β/Аi) = ∑ [Р(Вj /Аi) log (Р(Вj /Аi))-1] Граф нахождения условной энтропии выглядит следующим

образом:

A1

H ( / A1 )

P(A2)

A1

P(An)

…

P(A1)

An

H ( / A2 )

α

Н ( / An )

19

Решение задачи № 1 / 3:

Н (β /α) = Р(А1) Н (β/А1)+ Р(А2) Н (β/А2)

Опыт α = {утеряна одна карточка} = {А1, А2 }

А1 = {утеряна карточка с простой цифрой}, n(А1) = 4, Р(А1)= 4/10 =2/5,

А2 = {утеряна карточка с непростой цифрой}, n(А2) = 6, Р(А2)= 6 /10 =3/5

β = {угадывание карточки с простой цифрой}

Н (β/А1) определяется с учетом того, что утеряна карточка с простой цифрой и их

осталось 3 среди 9 карточек: Н (β/А1) = 3/9 log 9/3 + 6/9 log 9/6 = log3-2/3, аналогично считаем

Н (β/А2) = 4 /9 log 9/4 + 5/9 log 9/5 = 2log3-5/9 log5 -8/9;

Н (β /α)=2/5(log3-2/3) + 3/5(2log3-5/9 log5 -8/9) = (8/5log3- 1/3log5 – 4/5) = 1,6 *1,6 –0,33*2,33 – 0,8 ≈

1(бит).

Построим граф двух зависимых опытов α и β:

опыт α

β

3 34

9 5

9 2

2

log log log 3 log 2

2 59

4 9

5 5

3

34

8 5

5

4

24

24 30

15

2

log 9 log 9 log 5 log 3 log 2 log 3

log 3 log 5

59

9 9

9

15

45

45 45

45

5

72

1

36 8

1

4

log 3 log 5

log 3 log 5 1,6 1,6 0,33 2,3 0,8 1 (бит).

45

3

45 5

3

5

Тогда H ( / )

21

2

log 3 log

53

3

Ответ: 1 бит.

Задача № 2/3. Какую неопределенность содержит опыт угадывания четности суммы

очков случайно взятой кости домино, если известно, что одна кость утеряна?

Решение: утеряна может быть кость с четной суммой или с нечетной, что задает

предварительный опыт α:

опыт α

β

20

45

9 4

9 3 16

27 11

27 4

5

8

log 2 log 3 log 5

log log log

79

5 9

4 7 27

16 27

11 7

9

9

3

16

11

20

11

32

17

3 log 3

4 log 11 log 3 log 5 log 11 (бит).

7

27

27

63

63

21

7

H ( / )

Ответ: 17/7log3 -20/63log5 – 11/63log11 – 32/21(бит)

Задача № 3\3. Найти энтропию угадывания простых цифр при извлечении двух

карточек из цифровой азбуки.

Решение: Из десяти цифр четыре являются простыми: 2,3,5,7.

Вероятность угадать простую цифру равна 4/10=2/5; Вероятность угадать непростую

цифру равна 6/10 = 3/5.

Карточки с какими цифрами вытащены (простыми или непростыми – неизвестно)

Если первой выбрана карточка с простой цифрой, то вероятность для второй карточки

3/9 или 6/9; если первой выбрана карточка с непростой цифрой, то вероятность для

второй карточки 5/9 или 4/9. Построим граф двух зависимых опытов α и β, учитывая,

что Р(Пр, Пр)=2/15; Р(Пр, Пр)=4/15; Р(Пр, Пр)=4/15; Р(Пр, Пр)=1/3

опыт β

опыт α

H ( )

2

15 4

15

1

2

2

2 8

8

log log 2 log 3 log 3 log 5 log 3 log 5

15

2 15

4

3

15

15

15 15

15

8

1

2

6

2 log 3 log 3 log 5 (бит).

15

3

3

5

2

6

Ответ: H ( ) log 3 log 5 (бит).

3

5

Задача № 4/3. Найти энтропию угадывания простых цифр при извлечении трех

карточек из цифровой азбуки.

Решение: Из десяти цифр четыре являются простыми: 2,3,5,7.

Вероятность выбрать простую цифру равна 4/10=2/5;

21

Вероятность выбрать непростую цифру равна 6/10 = 3/5.

Карточки с какими цифрами вытащены вторыми простыми или непростыми –

неизвестно.

карточки

простое

непростое

Р=4/10

Р=6/10

простое

Р=3/9

простое

Р=2/8

Р=1/30

непростое

Р=6/9

непростое

Р=5/9

простое

Р=4/9

непростое

непростое

непростое

Р=4/8

Р=4/8

простое

Р=3/8

непростое

Р=5/8

простое

Р=3/8

простое

Р=6/8

Р=1/10

Р=1/6

Р=1/10

Р=1/6

Р=1/6

Р=1/10

Р=1/6

Р=5/8

Н (α βγ)= 1/30log30 + 3(1/10log10) + 4(1/6 log6) = (1/30 + 1/30log5 +1/30log3 + 3/10 + 3/10log5 +2/3 +

2/3 log3)= (1/3 log5 + 7/10 log3 +1)(бит).

Ответ: (1/3 log5 + 7/10 log3 +1)(бит)

После решения такого количества задач можно обозначить свойства энтропии:

1. Н(α) ≥0 (очевидно)

2. Н(α) = 0, если Р (Аi) = 1, а все Р (Аj) = 0 (очевидно)

3. Н(α) – max, если все Р(Аi)=1/n, т.е. равновероятны

4. Н(αβ) = Н(α) + Н(β), если α и β - независимы

5. Н(αβ) = Н(α) + Н(β/α), в общем случае, если α, β содержат по два исхода

6. 0 ≤Н(β/α) ≤ Н(β)

7. Н(α1, …. αk) ≤ Н(α1) + …. Н( αk)

Доказательство: 5. Н(αβ) = Н(α) + Н(β/α), в общем случае, если α, β содержат по два исхода

Пусть α={A1 , A2 } β={В1 , В2 }, тогда αβ = { A1В1 , A2 В2, A1В2, A2 В1}

Н (α β)= -[Р(A1В1)log Р(A1В1)+Р(A1В2)log Р(A1В2)+Р(A2В1) log Р(A2В1) + Р(A2В2) log Р(A2В2)] = Р(А1)Р(В1/А1)[logР(A1)+logР(В1/A1)] - Р(А1)Р(В2/А1)[logР(A1)+log Р(В2/A1)] - Р(А2)Р(В1/А2)

[log Р(A2)+ log Р(В1/A2)] - Р(А2)Р(В2/А2)[ log Р(A2)+ log Р(В2/A2)] = Н(α) + Р(А1)Н(β/А1) + Р(А2)

Н(β/А2) = Н(α) + Н(β/α)

Домашнее задание: №1. Какую степень неопределенности содержит опыт извлечения

двух костей домино относительно «дуплей»?

№ 2. Найти энтропию угадывания дней рождения двух случайно встреченных людей.

№3. Найти энтропию угадывания месяцев рождения двух случайно встреченных.

22

Занятие № 4. Количество информации. Решение задач

Цель занятия: Введение понятия количества информации для решения задач.

Задачи занятия:

Ввести новые понятия и формулы: количество информации, ориентированный

граф, свойства количества информации;

Разобрать типовые задачи на количество информации;

Провести интерпретацию информации через энтропию;

Доказать ряд свойств количества информации;

План занятия:

1. Введение понятия количества информации;

2. Введение ориентированного графа для решения соответствующих задач;

3. Решение задач

Ход занятия: Основные задачи, которые ставил перед собой К. Шеннон в середине

XX в. при создании направления, в последующие годы получившего название «теория

информации», были связаны с чисто техническими вопросами электросвязи и

радиосвязи. Работы Шеннона оказали большое стимулирующее влияние на

исследования, относящиеся к передаче и сохранению какой бы то ни было

информации в природе и технике. За количество меры информации события А

принимается величина I (А) = log[Р(A)]-1= - log[Р(A)]. Информацию сложного опыта

можно измерить числом, которое называется количеством информации об опыте β,

содержащемся в опыте α:

I(α, β )=Н(β) – Н(β /α ).

Количество информации : I(α, β) показывает, насколько осуществление опыта α

уменьшает

неопределенность

опыт α

опыта β.

В1

log[ P( B1 )]

1

log[ P( B2 )]1

P( B1 )

P( B2 )

P( A1 )

…

P( Bm )

Вm

β

A2

…

log[ P ( Bm )]1

H ( / A1 )

H ( / A2 )

P( A2 )

В2

β

A1

P( An )

H ( / An )

An

23

Количество

информации

предлагается

находить

на

ориентированном

графе,

позволяющем найти Н(β) и Н(β/α), при этом считаем, что Н(β) – энтропия опыта β без

влияния других опытов, Н(β/α) – энтропия опыта β при осуществлении опыта α. граф –

авторское изобретение ректора ЯГПУ им. К.Д. Ушинского В. В. Афанасьева.

Задача 1/4. В урне два белых и два черных шара. Опыт β состоит в извлечении из

урны двух шаров, а опыт α – предварительном извлечении из той же урны (без

возвращения) одного шара. Найти количество информации об опыте β, содержащейся

в опыте α.

Решение. Построим ориентированный граф опытов α и β

β

β

1 1

1

1

1

1

1

I ( , ) log 6 2 log 3 2 log 3 3 log 3 3 log 3 log 3 .

3

3

6

3

3

2 3

Задача № 2/4. Найти количество информации при вынимании козырной карты из 16

карт с картинками, содержащейся в предварительно извлеченной одной карте.

Решение: Пусть опыт β = {извлечение карты из 16 с картинками}, а опыт α =

{предварительное извлечение одной карты}. Для вычисления I ( , ) используем

ориентированный граф.

24

опыт α

β

β

Н(β) = 1\4 Log4 + 3\4 Log4/3 = 1 \2 + 3\2 – 3\4 Log3 = 2 - 3\4 Log3 (бит);

Н(β/α)=1\4*3/15* Log5 + 1\4 *12/15Log5/4 + 3\4 * 4/15 * Log15/4 + 3\4 *11/15* Log15/11 =

1\20* Log5 + 1\5*(Log5 – Log4+Log5 + Log3– Log4) + 11\20*(Log5 + Log3– Log11) =

Log 5 + 3/4 Log 3 – 11\ 20 Log 11 – 4\5(бит).

I(α,β) =2-3\4Log3-Log 5-3/4Log3 + 11\20Log11 + 4\5 = 14\5 –3/2Log3 - Log5+ 11\20 Log11 (бит).

Ответ: 14\5 –3/2Log3 - Log5+ 11\20 Log11 (бит).

Таким образом, понятно, что граф (ориентированный граф) является не только

наглядным сопровождением решения, но и точной схемой решения, дающего

безошибочный ответ. Рассмотрим свойства количества информации

Свойства количества информации

1. 0 ≤I(β/α) ≤ Н(β)

2. I(α,β) = Н(α) + Н(β) - Н(α*β),

3. I(α,β) = I(β,α)

4. I(α,β,γ) ≥I(α,β), где α,β,γ- три произвольных опыта

Доказательство

2. I(α,β) = Н(α) + Н(β) - Н(α*β)

Учитывая, что Н(α*β) = Н(α) + Н(β/α) и I(α, β )=Н(β) – Н(β /α ) = Н(β) + Н(α) – Н(α*β).

3. I(α,β) = I(β,α)

Учитывая, что Н(α*β) = Н(α) + Н(β/α) =Н(β*α) = Н(β) + Н(α/β)

I(α, β )=Н(β) – Н(β /α ) = Н(α) - Н(α/β) = I(β,α)

Задача 2/4. В задаче 1/4 поменяем местами очередность проведения опытов и .

Найти количество информации об опыте , содержащемся в опыте .

1

2

1

2

Решение. H ( ) log 2 log 2 1. Найдем условную энтропию H ( / ) по графу

25

опыт β

α

H ( / )

1

11

2

(1 log 1) 2 log 2 4 .

6

3 2

3

Отсюда I ( , ) H ( ) H ( / ) 1

2 1

.

3 3

Эти две задачи (1/4 и 2/4) иллюстрируют свойство 3. количества информации.

Задача № 3/4 В урне находятся один белый и два черных шара. Найдите количество

информации об извлечении шара, содержащейся в предварительном извлечении

одного шара.

Решение: Для вычисления I(α,β) построим ориентированный граф.

α = {предварительный шар}

β = {изъятие шара }

2/3

Log3/2

Log2

1/2

Log2

2/3

Н(β)

β

1/2

Н(β /α )

β/α

Log1

Log3

1/3

1/3

2/2

Log2

0/2

I(α, β )=Н(β) – Н(β /α ).

Н(β) = 2\3 Log3/2+ 1\3 Log3 =Log3 – 2/3(бит);

Н(β/α)=2\3*1/2* Log2 + 2\3 *1/2Log2 + 1\3*2/2 * Log1 = 1/3 +1/3 +0 = 2/3 (бит).

I(α,β) = Log3 – 2/3 – 2/3 = Log3 – 4/3бит).

Ответ: Log3 – 4/3(бит).

26

Задача 4/4. В урне находятся 2 белых и 4 черных шара. Опыт β состоит в

вытаскивании 2 шаров с предварительным вытаскиванием одного. Найти количество

информации об опыте β в опыте α.

Решение: Построим ориентированный граф:

2/5

опыт α

3/4

Log10/3

2/4

Log10/3

2/4

Log10/3

2/5

Log15/4

4/6

Log5/2

4/6

3/5

3/5

Н(β)

4/5

Log15

1/4

1/5

2/6

2/6

Log5

3/4

Log15/4

4/5

Log5/3

1/5

-----

------4/4

Log5

I(α, β )=Н(β) – Н(β /α ).

Н(β) = 2(4\15Log15/4) + 2\5Log5/2 + 1/15Log15= Log5 + 3/5 Log3 – 22/15 (бит);

Н(β/α)=4\6*(3* 3\10Log10/3+ 1\10Log10) + 2\6(2*1/5Log5 + 3/5 Log5/3) =

= Log5 - 4\5Log3 + 2/3 (бит).

I(α,β) = Log5 + 3/5 Log3 – 22/15 - Log5 + 4\5Log3 - 2/3 = 7/5 Log3 - 32/15 (бит).

Ответ: 7/5 Log3 - 32/15 (бит).

Задача № 5/4. В урне находятся 2 белых и 4 черных шара. Опыт β состоит в

предварительном вытаскивании 2 шаров с последующим вытаскиванием одного α .

Найти количество информации об опыте α в опыте β .

Решение:

I(β,α )=Н(α) – Н(α/ β).

Н(α) = 4\6Log6/4 + 2\6Log6/2 = Log3 – 2/3 (бит);

Построим ориентированный граф:

27

опыт β

3/4

Log4/3

2/5

1/4

Log 4

2/4

4/6

Log 3/2

4/6

Log4/2

3/5

2/4

Н(α)

Log4/2

4/5

1/4

2/6

Log4

2/6

Log 3

3/4

Log4/3

1/5

-----

------4/4

Log1

Н(α/β)= 4\15*(3/4Log4/3+ 1\4Log4) + 2\5 (2*1/2Log2) + 4\15*(1/4Log4+ 3\4Log4/3) =

= - 2\5Log3 + 22/15 (бит).

I(α,β) = Log3 – 2/3 + 2\5Log3 - 22/15 = 7/5 Log3 - 32/15 (бит).

Ответ: 7/5 Log3 - 32/15 (бит).

Вывод: сравнивая результаты 2 последних задач, получили подтверждение свойства 3

количества информации.

Домашнее задание:

№ 1. найдите количество информации при вынимании козырной карты из колоды в 52

карты, содержащейся в предварительно извлеченной одной карте.

№ 2. предлагается угадать карту, наудачу вынутую из колоды в 36 карт. Какое

количество информации получит угадывающий, если дополнительно сообщить:

а) масть вынутой карты;

б) что вынутая карта оказалась тузом.

28

Занятие № 5. Решение логических задач на взвешивание через энтропию и

количество информации

Цель занятия: разобрать оптимальный способ решения логических задач на

взвешивание через формулы энтропии и количества информации.

Задачи занятия:

Ввести типологию задач на взвешивание, решаемых методом энтропии и

количества информации;

Осуществить переход от решения задач через графы к решению через формулы

энтропии и количества информации;

Отработать общий алгоритм решения задач на взвешивание в зависимости от

исходных условий.

Ход занятия:

1. Предложенные для занятия задачи, классифицировать по какому–либо признаку.

Свое решение обосновать.

2. Разобрать решение задачи на угадывание одной фальшивой монеты из 9, если

известно, легче она или тяжелее; если неизвестно легче она или тяжелее;

3. Провести решение оставшихся задач через понятие энтропии и количества

информации;

4. Домашнее задание: составить кодовые деревья для каждой решенной задачи.

Занятие № 6. Решение логических задач о лжецах через энтропию и количество

информации

Цель занятия: разобрать оптимальный способ решения логических задач о лжецах

через формулы энтропии и количества информации.

Задачи занятия:

Ввести типологию логических задач о лжецах, решаемых методом энтропии и

количества информации;

Осуществить переход от решения задач через графы к решению через формулы

энтропии и количества информации;

Отработать общий алгоритм решения логических задач о лжецах в зависимости

от исходных условий.

29

Ход занятия:

1. Предложенные для занятия задачи, классифицировать по какому–либо признаку.

Свое решение обосновать.

2. Найти отличительные черты для выделения задач о лжецах из многообразия

других задач;

3. Разобрать решение

задач с использованием энтропии и двоичной системы

счисления;

4. Провести решение оставшихся задач через понятие энтропии и количества

информации;

5. Провести иллюстрацию решения логических задач о лжецах на кодовом дереве;

6. Домашнее задание: составить кодовые деревья для каждой решенной задачи.

Задачи для решения берутся из Главы II § 8.

Занятие № 7. Защита творческих проектов

Цель: обобщение изученного материала, формирование творческой математической

индивидуальности учащихся.

Идея: На первом занятии учащимся предлагаются формы творческих заданий по

изучаемой теме:

Реферат

Web – сайт

Компьютерная презентация

Составление опорной таблицы и опорных конспектов модуля

Решебник домашних задач с приведением дополнительных;

На данном занятии происходит творческая защита – представление выбранной формы

с конкретным содержанием по теме изучаемого модуля.

В течение работы над освоением данного модуля, учащиеся изучают дополнительную

литературу, консультируются с учителем, и выполняют свое задание. Реферат,

решебник и составление опорных конспектов предполагают индивидуальную работу,

составление сайта и презентации предполагает коллективную работу и требует

специальных навыков в данной технологии.

30