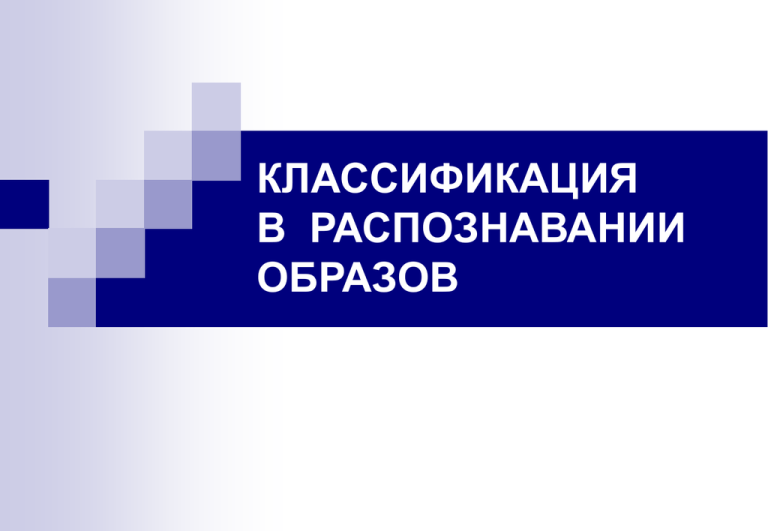

Классификация в распозновании образов

реклама

КЛАССИФИКАЦИЯ В РАСПОЗНАВАНИИ ОБРАЗОВ Схема системы распознавания Система распознавания образов состоит из нескольких подсистем: Объект Датчики Формирователь информативных признаков Обучающая выборка и решающее правило для случая двух информативных признаков x1, x2 и двух классов. Классификатор Решение x2 h(x , x )=0 1 2 G1 h ( x , x )> 0 1 2 G2 h( x , x ) < 0 1 2 x1 Байесовская теория принятия решений при дискретных признаках Одномерный вариант Рассматриваем m классов (полную группу несовместных случайных событий) и один дискретный информативный признак X. По формуле Байеса вычисляем апостериорные вероятности для всех рассматриваемых классов: P( j | X = xi ) = p xi | j P ( j ) p xi m , pxi = pxi |l P(l ) j = 1, m l =1 Выносим решение об истинности того класса (с номером ), для которого апостериорная вероятность максимальная: P( | X = xi ) = max P( j | X = xi ) , j = 1, m Байесовская теория принятия решений при дискретных признаках Многомерный вариант Для простоты считаем, что имеются два информативных признака X и Y. X принимает возможные значения x1,…,xn1, Y принимает возможные значения y1,…,yn2. По формуле Байеса вычисляем апостериорные вероятности для всех рассматриваемых классов: P(k | [( X = xi )(Y = y j )]) P(k | xi , y j ) = pxi , y j |k P(k ) m pxi , y j |l P(l ) , k = 1, m l =1 Выносим решение об истинности того класса (с номером ), для которого апостериорная вероятность максимальная: P( | xi , y j ) = max P( k | xi , y j ) , k = 1, m Байесовская теория принятия решений при дискретных признаках Одномерный вариант X = xi 1 Решающее устройство m Многомерный вариант X = xi Y = yj 1 Решающее устройство m Байесовская теория принятия решений при непрерывных признаках f ( x | i ), i = 1, 2, Одномерны вариант: Апостериорные вероятности классов по формуле Байеса : f ( x | i ) P (i ) P(i | x) = , i = 1, 2 f ( x) P( j | x) 1 если P(1| x ) 0 G1 P( 2| x ) c то принимается решение о 1-м классе, иначе о 2-м классе. x G2 P (1| x ) > P (2| x ) Байесовская теория принятия решений при непрерывных признаках Вероятность ошибки классификации при двух классах: Pîø1 = f ( x | 1) P(1)dx Pîø2 = f ( x | 2) P(2)dx G1 G2 f ( x|1) P(1) Pош.2 G1 f ( x|2) P(2) Pош.1 c x G2 Идеи классификации Случай 1. Известны полностью условные плотности распределения вероятности для признаков. f ( x |i ) x2 f ( x|1) f ( x|2) G1 c h( x1 , x2 ) = 0 h( x1 , x2 ) > 0 h( x1 , x2 ) < 0 x G2 Одномерный случай x1 Двумерный случай Идеи классификации Случай 2. Условные плотности распределения вероятности для признаков известны не полностью, а с точностью до параметров. Неизвестные параметры доопределяются с помощью одного из методов математической статистики, например с помощью метода максимального правдоподобия, на основе обучающей выборки. Дальнейшая классификация проводится, как и в случае 1. По обучающей выборке доопределяются и априорные вероятности: P(1) = n1 n2 , P(2) = n1 n2 n1 n2 Идеи классификации Случай 3. Условные плотности распределения вероятности неизвестны, но известна обучающая выборка. Здесь возможны два варианта. Вариант 1. Восстанавливается решающая функция. Вариант 2. По обучающей выборке восстанавливаются условные плотности Идеи классификации Случай 4. Число классов неизвестно и нет обучающей выборки. Вернее, нет учителя, который мог бы измерения признаков разбить на группы, соответствующие своим классам. Это самая сложная и распространенная на практике ситуация. Приходится строить самообучающиеся системы классификации. Прямые методы восстановления решающей функции 1, если истинным является класс 1, yi = 1, если истинным является класс 2. y 1 h(x) x -1 Персептроны Чу вс тв по ите ле ль но е 1 ( x) j (x) M (x) a1 a11 ( x) 1 aj aM Преобразователи, Усилители предикаты, нейроны h( x, a) Пороговое устройство 1 sgn h Блок обучения