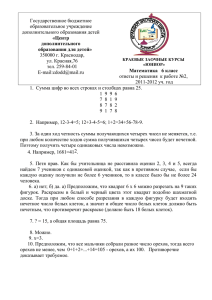

Какое сообщение содержит большее количество информации?

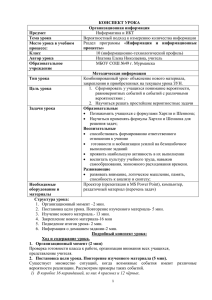

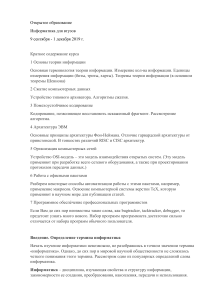

реклама

ИНФОРМАЦИЯ Презентация к урокам №1,2 в 10 классе ИНФОРМАЦИЯ (INFORMATIO) – РАЗЪЯСНЕНИЕ, ОСВЕДОМЛЕНИЕ, ИЗЛОЖЕНИЕ (БЫТОВОЕ) Объект Сигналы, знаки Обработка данных мозгом Орган ы чувств Данные Информация об объекте КЛАССИФИКАЦИЯ Основной Способ ИНФОРМАЦИИ Форма признак восприятия представления Виды информации Визуальная Аудиальная Вкусовая Обонятельная Тактильная Текстовая Числовая Звуковая Графическая Комбинированная Субъекты обмена (способы обмена информацией) Назначение Личная Общественная Специальная (научная, управленческая, производственная и т.д.) Вид информации Представители человеческого общества Социальная Автоматы, люди и автоматы Т ехническая Представители живой природы Биологическая Клетки растительного или животного мира Генетическая СВОЙСТВА ИНФОРМАЦИИ Свойства (качественные) Информацию можно: Передавать Получать Преобразовывать Сохранять Использовать Измерять Оценивать Распространять Исследовать и т.д. Достоверность Доступность Полнота Актуальность Полезность Понятность Адекватность (уровень соответствия образа, информационного объекта, создаваемого с помощью полученной информации, реальному объекту) ЭНТРОПИЯ Информацию, которую получает человек, можно считать мерой уменьшения неопределенности знаний. Введем величину измеряющую неопределенность H (энтропию).Если некоторое сообщение приводит к уменьшению неопределенности наших знаний, то можно говорить, что такое сообщение содержит информацию. ИЗМЕРЕНИЕ ИНФОРМАЦИИ Минимальная единица измерения в 1 бит уменьшает неопределенность знания в 2 раза Неопределенность знания о результате некоторого события равна количеству возможных результатов события. Неопределенность знания о состоянии какого – либо объекта равна количеству различных состояний объекта. ИНФОРМАЦИИ. ШЕННОНА. ФОРМУЛЫ ХАРТЛИ И Американский инженер Р. Хартли в 1928 г. процесс получения информации рассматривал как выбор одного сообщения из конечного наперёд заданного множества из N равновероятных сообщений, а количество информации I, содержащееся в выбранном сообщении, определял как двоичный логарифм N. ФОРМУЛА ХАРТЛИ Для равновероятных событий верна формула N=2i , где N - количество вероятно возможных результатов события, а i (бит) - количество информации, содержащееся в сообщении о том, что произошло одно из N равновероятных событий. Можно воспользоваться формулой i=log2N. ПРИМЕРЫ Задача 1 В корзине 16 шаров разного цвета. Сколько информации несет сообщение о том, что из корзины достали красный шар? Решение Результат вытаскивания из корзины любого из 16 шаров – событие равновероятное. Поэтому для ответа на вопрос задачи применима формула N=2i , где N = 16, т.е. 2i = 16 => i =4 бита. ПРИМЕРЫ Задача 2 При угадывании целого числа в диапазоне от 1 до N получено 6 битов информации. Укажите диапазон. Решение i =6 битов. N=2i => N =26, т.е. N=64. Диапазон [1,64]. ПРИМЕРЫ Задача 3 Какое минимальное количество вопросов надо задать, чтобы определить загаданное число из заданного набора 32 возможных чисел? Решение N=2i или i=log2N где N = 32, т.е. i = 5 => 5 битов или 5 вопросов. ПРИМЕРЫ Задача 4 Кодовый замок сейфа должен допускать не менее 15000 уникальных комбинаций. Сколько двухпозиционных переключателей необходимо включить в его конструкцию? Решение 15000=2i i=log215000 получится дробное число ≈ 13,878, ближайшая степень числа 2 к 15000 есть число 16384, т.е. 214 , т.о. i = 14 => в конструкцию нужно включить не менее 14 двухпозиционных переключателей. ПРИМЕРЫ Задача 5 Какое количество информации несет сообщение «Встреча назначена на 29 сентября»? Решение Месяц встречи один из 12 месяцев года: N1=12, сообщение о выборе месяца содержит i1 битов информации. В месяце 30 дней: N2=30, сообщение о выборе дня содержит i2 битов. Все сообщение содержит i=i1+i2 =log2N1+ log2N2 = log212+ log230≈8,4918 ≈ 9 битов информации. РЕШИТЕ ЗАДАЧИ Преподаватель договорился заниматься с учеником раз в неделю, причем день каждую неделю мог быть разный. Было составлено расписание на 20 недель и записано в некоторое электронное устройство, которое напоминало о занятиях. Оцените информационный объем этого расписания в байтах. День недели (из 7 возможных) 3 бита, 20 недель, 3 бита*20 недель =60 бит=7,5 байт. Ответ 8 байт. Если к этой задаче добавить фразу «Информация о дне занятия записывалась минимально возможным количеством байтов», задача решалась бы по другому. 3 бита надо для кодирования дня недели, но записать это можно как 1 байт, следовательно 20 байт. РЕШИТЕ ЗАДАЧИ Какое сообщение содержит большее количество информации? a) Монета упала «решкой» вверх b) В библиотеке книга нашлась в 5-м шкафу из восьми c) Вася получил за экзамен 3 балла (единицы не ставятся) по 5-балльной системе d) Из колоды карт (32 шт.) выпала 7 пик a ) N = 2, I =1 b ) N = 8, I =3 c ) N = 4, I = 2 d) N= 32, I = 5. РЕШИТЕ ЗАДАЧИ Словарный запас некоторого языка составляет 256 слов, каждое из которых состоит точно из 4 букв. Сколько букв в алфавите языка? a) 16 b) 256 c) 4 d) 8 алфавита N – количество букв в Мощность алфавите. Максимальное количество букв в слове, записанном с помощью этого алфавита m. Максимальное количество слов L=Nm. 256=N4, следовательно N=4. Определим теперь, являются ли равновероятными сообщения "первой выйдет из дверей здания женщина" и "первым выйдет из дверей здания мужчина". Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины. А если это магазин для женщин? Для задач такого рода американский учёный Клод Шеннон предложил в 1948 г. другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в наборе. Формула Шеннона: I = — ( p1log2 p1 + p2 log2 p2 + . . . + pN log2 pN), где pi — вероятность того, что именно i-е сообщение выделено в наборе из N сообщений. Легко заметить, что если вероятности p1, ..., pN равны, то каждая из них равна 1 / N, и формула Шеннона превращается в формулу Хартли. ИЗМЕРЕНИЕ ИНФОРМАЦИИ. НЕРАВНОВЕРОЯТНЫЕ СОБЫТИЯ. Вероятность события p и количество информации i в сообщении о нем связаны формулой 1/p =2i или i=log2(1/p) = - log2p ПРИМЕРЫ Задача В коробке 8 красных, 12 белых и 12 синих платков. Сколько информации несет сообщение о том, что достали красный платок? Белый? Решение Пусть pk – вероятность того, что из коробки достали красный платок. Всего платков 32, значит pk =8/32=1/4. Это доля красных платков в общем числе платков. Количество информации в сообщении ik = -log2 pk = - log21/4= log24=2 (бит). ЗАДАЧА РЕШЕНИЕ Формула 2i =1/P. Мухомор – i=4 бит (по усл) P вероятность, что мухомор 24 =1/P, P=1/16 P=X/32 => X=2 количество мухоморов Белых 6 Подосиновиков 24 В коробе грибника лежат грибы: белые, подосиновики и мухоморы. Всего 32 гриба. Сообщение о том, что вынули мухомор, несет 4 бита информации. Мухоморов в 3 раза меньше, чем белых. Сколько грибов каждого типа? a) белых — 6, подосиновиков — 24, мухоморов — 2 b) белых — 12, подосиновиков — 16, мухоморов — 4 c) белых — 3, подосиновиков — 28, мухоморов — 1 d) белых — 9, подосиновиков — 20, мухоморов — 3