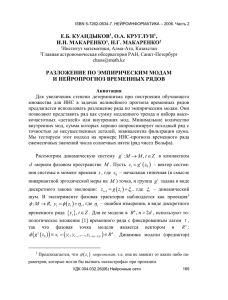

М.В. БУРАКОВ ГЕНЕТИЧЕСКОЕ КОНСТРУИРОВАНИЕ НЕЙРОНЕЧЕТКИХ СИСТЕМ

реклама

реклама