ТеорИя ВерояТносТей И маТемаТИческая сТаТИсТИка часть 1 Учебное пособие

реклама

Федеральное агенТство по образованию

Государственное образовательное учреждение

высшего профессионального образования

САНКТ-ПЕТЕРБУРГСКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ

АЭРОКОСМИЧЕСКОГО ПРИБОРОСТРОЕНИЯ

В. Г. Фарафонов, Вяч. Г. Фарафонов,

В. И. Устимов

Теория вероятностей и

математическая статистика

Учебное пособие

Часть 1

Санкт-Петербург

2009

УДК 519.2

ББК 22.171

Ф24

Рецензенты:

доктор физ.-мат. наук, профессор А. П. Киселев;

доктор физ.-мат. наук, профессор Л. С. Ивлев

Утверждено

редакционно–издательским советом университета

в качестве учебного пособия

Фарафонов В. Г., Фарафонов В. Г., Устимов В. И.

Ф24 Теория вероятностей и математическая статистика: учеб.

пособие / В. Г. Фарафонов, Вяч. Г. Фарафонов, В. И. Устимов. – СПб.: ГУАП, 2009. Ч. 1. – 71 с.: ил.

ISBN 978-5-8088-0426-5

Учебное пособие составлено в соответствии с программой по

высшей математике для студентов экономических специальностей.

В первой части пособия рассмотрены разделы курса теории вероятностей, начиная с понятия случайного события и операций

над ними и заканчивая системами случайных величин. Каждый

раздел содержит теоретические сведения и формулы, проиллюстрированные подробно разобранными примерами. Вопросы математической статистики рассматриваются во второй части учебного

пособия.

УДК 519.2

ББК 22.171

ISBN 978-5-8088-0426-5

© В. Г. Фарафонов, Вяч. Г. Фарафонов,

В. И. Устимов, 2009

© ГУАП, 2009

Введение

Теория вероятностей – это математическая дисциплина, изучающая закономерности, происходящие в массовых однородных случайных явлениях и процессах.

С возникновением теории вероятностей наука получила мощный

аппарат исследования случайных явлений и процессов. До этого исследовались лишь детерминированные явления и опыты, в которых

первоначальные условия однозначно позволяли определить исход.

Между тем случайные явления присутствуют во многих областях

науки (физике, биологии, генетике, агрономии, демографии, психологии, технике и т.д.), когда заранее невозможно предсказать результат опыта.

Одной из важнейших сфер приложения теории вероятностей является экономика. В настоящее время трудно себе представить исследование и прогнозирование без использования различных методов, опирающихся на теорию вероятностей.

3

1. Случайные события и операции над ними

1.1. Случайные события

Определение. Опытом называется всякое осуществление определенных условий и действий, при которых наблюдается изучаемое

случайное явление. Теория вероятностей изучает массовые случайные явления, т.е. предполагается, что любой опыт можно повторять

сколько угодно раз.

Определение. Событием называется любая качественная характеристика результата опыта. Событие называется достоверным, если оно обязательно происходит в результате опыта. Событие называется невозможным, если оно никогда не происходит в результате опыта. Случайным называют событие, которое может произойти

или не произойти в результате опыта.

Определение. Пространством Ω возможных исходов опыта называют множество элементарных событий, т.е. множество всех возможных исходов опыта. Любое случайное событие связано с пространством Ω.

Определение. Случайное событие есть подмножество Ω пространства возможных исходов опыта. Это подмножество состоит из

элементарных событий, благоприятствующих данному случайному

событию, т.е. таких элементарных событий, наступление которых

влечет за собой наступление данного события.

Для обозначения случайных событий используют заглавные

буквы латинского алфавита A, B, C, …. Достоверное событие обозначается буквой U, при этом соответствующее ему подмножество

совпадает с пространством Ω. Невозможное событие обозначается

буквой V, при этом соответствующее ему подмножество пространства Ω не содержит элементов этого пространства, т.е. является пустым множеством Æ.

Рассмотрим следующие примеры.

Пример 1. Производится бросание монеты. В этом опыте возможны два исхода: 1) монета выпадает вверх “орлом” (элементарное событие ω1) и 2) монета выпадает вверх “решкой” (элементарное событие ω2). В данном случае пространство Ω возможных исходов опыта

содержит только два элемента (элементарные события ω1 и ω2), т.е.

Ω = {ω1, ω2}.

Пример 2. Производится бросание игральной кости. Здесь пространство Ω возможных исходов опыта содержит шесть элементарных событий ωк, где к – выпавшее число. Ω = {ω1, ω2, ω3, ω4, ω5, ω6}.

4

И, например, событие A, заключающееся в выпадении четного числа, будет подмножеством, состоящим из трех элементарных событий, а именно A = {ω2, ω4, ω6}.

1.2. Операции над событиями

Событие A влечет за собой событие B (обозначение A Ì B ), если

наступление события A приводит к наступлению события B. Другими словами, все элементы подмножества, соответствующего событию A, являются элементами подмножества, соответствующего

событию B, т.е., если ω Î A Þ ω Î B.

Равенство событий A и B (обозначение A = B) означает, что наступление одного из этих событий влечет за собой наступление

другого события (т.е. A Ì B и B Ì A ). Подмножества, соответствующие событиям A и B, содержат одни и те же элементы, т.е.

ω Î A Û ω Î B.

Объединением событий A и B называется событие C = A È B или

(А + В), состоящее в наступлении хотя бы одного из этих событий

A и B. Подмножество, соответствующее событию A È B , состоит

из элементов подмножеств, соответствующих событиям A и B, т.е.

ω Î C = A È B, если ω Î A или ω Î B.

Пересечением событий A и B называется событие C = A Ç B или

(АВ), состоящее в одновременном наступлении событий A и B. Подмножество, соответствующее событию A Ç B, состоит из элементов,

общих для подмножеств, соответствующих событиям A и B, т.е.

ω Î C = A Ç B, если ω Î A и ω Î B.

Разностью событий A и B называется событие C = A\B. Подмножество, соответствующее событию A\B, состоит из элементов подмножества A за вычетом элементов подмножества B.

Событием, противоположным событию A, называется событие

C = A, состоящее в том, что событие A не происходит. Подмножество, соответствующее событию A, состоит из элементов пространства Ω возможных исходов опыта, не принадлежащих подмножеству, соответствующему событию A, т.е. ω Î A, если ω Ï A (иначе

ω Î (Ω \ A) ).

Из определения разности событий A и B и противоположного события следует соотношение A \ B = A Ç B.

События A и B называются несовместными, если A Ç B = V , т.е.

если невозможно их одновременное наступление.

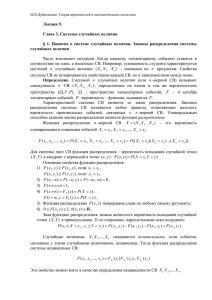

Для лучшего понимания операций над событиями – подмножествами – обычно используют условные графические изображения,

5

представляя достоверное событие Ω как прямоугольник, а другие

события – как круги. Тогда введенные выше операции над событиями могут быть представлены в виде диаграмм Вьенна (рис. 1.1), на

которых результаты операций изображены в виде затемненных фигур (кроме рис. 1.1 (б) и рис. 1.1 (д)). Операция объединения событий

изображена на рис. 1.1 (а), пересечения – на рис. 1.1 (б), разности –

на рис. 1.1 (в). Противоположное событие (дополнение) показано на

рис. 1.1 (г), несовместные события – на рис. 1.1 (д).

а)

б)

AÈB

A

B

г)

в)

AÇB

A

B

д)

A

A

A\B

A

B

AÇB=V

AA

A

B

Рис. 1.1 Диаграммы Вьенна

Определение. События Ak (k = 1, 2, …, n) образуют полную группу, если в результате опыта обязательно должно наступить хотя бы

одно из этих событий, т.е.

n

∪ Ak = U .

k=1

Объединение всех событий Ak является достоверным событием.

Обычно рассматривают полную группу несовместных событий, когда события Ak попарно несовместны:

Ak Ç A j = V при k ≠ j.

Примером полной группы несовместных событий могут служить событие А и противоположное событие A. Действительно

A È A = U , но A Ç A = V .

Ниже приведены свойства, которым подчиняются операции объединения и пересечения событий:

коммутативность A È B = B È A, A Ç B = B Ç A;

ассоциативность A È (B È C ) = (A È B) È C ,

A Ç (B Ç C ) = (A Ç B) Ç C;

6

дистрибутивность A Ç (B È C ) = (A Ç B) È (A Ç C ),

A È (B Ç C ) = (A È B) Ç (A È C ).

Семейство событий A, которое с каждым событием А содержит и

противоположное ему событие A , а с каждой парой событий А и В

содержит события A È B, A Ç B и A\B, называется алгеброй событий.

Иногда приходится рассматривать бесконечные последовательности событий и действия над ними. В этом случае требуют, чтобы

объединение и пересечение бесконечного числа событий также являлись бы событиями.

Чтобы уяснить связь терминологии в теории множеств с терминологией в теории вероятностей, приведём следующую таблицу.

Обозначение

Терминология

в теории множеств

Терминология

в теории вероятностей

Ω

Пространство

(основное множество)

Пространство элементарных исходов, достоверное событие

ωÎ Ω

Элемент ω пространства

Ω

Элементарное событие

(или исход опыта) ω

AÌΩ

Множество A

Событие A

AÈB

Объединение

множеств A и B

Объединение или

сумма событий A и B

Пересечение

множеств A и B

Пересечение или произведение

событий A и B

Пустое множество

Дополнительное множество

Невозможное событие

Противоположное

событие

AB = Æ

AиB

не пересекаются

AиB

несовместны

AÌB

A содержится в B

A влечет B

A=B

A и B совпадают

A и B равны

A+B

AÇB

AB

Æ

A

AÇ B=Æ

1.3. Решение типовых примеров

Пример 1.1. При каких событиях А и В возможно равенство

AÈ B= A?

Решение. Объединение событий A È B есть событие, заключающееся в наступлении хотя бы одного из событий А и В. Следователь-

7

но, наступление события А влечет за собой наступление события

AÈ B:

A Ì A È B.

В каком случае наступление события A È B влечет за собой наступление события А, т.е. A È B Ì A ? Только в том случае, когда наступление события В влечет за собой наступление события А. Таким

образом, равенство возможно только в случае B Ì A.

Пример 1.2. Доказать равенство A Ç B = A È B.

Решение. В результате опыта событие А может произойти или

не произойти (т.е. произойдет противоположное событие A ). Будем

обозначать наступление событий цифрой 1, а ненаступление – цифрой 0.

Рассмотрим все возможные комбинации наступления и ненаступления двух событий А и В и заполним следующую таблицу (таблицу истинности), которая содержит сравниваемые события.

A

B

A

B

AÈB

AÇB

AÇB

0

0

1

1

0

1

0

1

1

1

0

0

1

0

1

0

0

1

1

1

1

0

0

0

0

1

1

1

Мы видим, что столбцы, соответствующие событиям A È B и

A Ç B , совпали, т.е. эти события равны A Ç B = A È B, так как наступление одного из них влечет за собой наступление другого.

Пример 1.3. Имеются события: А – хотя бы один из трех проверяемых приборов бракованный, В – все приборы качественные. Что

означают события A, B, A È B, A Ç B, A \ B ?

Решение. Для решения этой задачи следует правильно выбрать

пространство возможных исходов опытов Ω. Введем Ω = {ω0, ω1, ω2,

ω3}, где элементарное событие ω0 состоит в том, что бракованных

приборов нет, ω1 – только один прибор бракованный, ω2 – ровно два

прибора бракованные, ω3 – все три прибора бракованные. Событиям

А и В будут соответствовать следующие подмножества A = {ω1, ω2,

ω3}, B = {ω0}. Теперь легко записать соответствующие подмножества

для противоположных событий A = {ω0} = B, B = {ω1, ω2, ω3} = A.

Объединение событий A È B дает достоверное событие:

A È B = {ω0 , ω1 , ω 2 , ω3 } = U .

Пересечение событий A Ç B есть невозможное событие, так как

нет общих элементарных событий:

8

A Ç B = V.

Для разности событий A\B в соответствии с определением

A\B = {ω1, ω2, ω3}.

Событие A\B можно представить и в другом виде:

A \ B = A Ç B = A Ç A = A = {ω1 , ω 2 , ω3 },

так как имеет место соотношение B = A.

9

2. Определения вероятностей случайных событий

2.1. Статистическое определение вероятности

Пусть некоторый опыт осуществляется N раз при одинаковых

условиях, при этом случайное событие А происходит N(A) раз. Число N(A) называется частотой события А, а отношение N(A)/N относительной частотой события А. Оказывается, что при больших

N относительная частота для случайных массовых событий (их

можно наблюдать при одинаковых условиях сколько угодно раз) обладает свойством устойчивости, т.е. в нескольких сериях из достаточно большого количества N1, N2,…, Nk наблюдений данного опыта

имеют место приближенные равенства:

N1 ( A) N2 ( A)

N ( A)

»

»¼ » k

.

N1

N2

Nk

(2.1)

Таким образом, относительная частота события А колеблется

около одного и того же числа, которое характеризует данное случайное событие А. Это число p(A) называется вероятностью события

A. Из этого определения следует, что за вероятность события приближенно можно брать его относительную частоту при достаточно

большом числе наблюдений данного опыта в одинаковых условиях.

Пример. Производится бросание “правильной” (симметричной,

однородной) монеты. Событие А заключается в появлении “герба”.

Если подбрасывать монету много раз, то относительная частота события А будет колебаться около числа 1/2, которое и будет вероятностью события А.

2.2. Классическое определение вероятности

Соображения симметрии в случае конечного пространства Ω

возможных исходов опыта позволяет дать простое определение вероятности. Несколько событий в данном опыте называются равновозможными, если по условиям симметрии нет оснований считать

какое-либо из них более возможным, чем другое.

Пусть пространство Ω возможных исходов опыта содержит n элементов Ω = {ω1, ω2,…,ωn}. Если все элементарные события ωk, где k =

1, 2, …, n равновозможные (т.е. равновозможны все исходы данного

опыта), то вероятность события А вычисляется по формуле

10

p( A) =

mA

,

n

(2.2)

где m A – число элементарных событий, благоприятствующих событию А, т.е. число элементов ωk, принадлежащих подмножеству, соответствующему событию А.

Пример. Производится бросание монеты. Монета предполагается “правильной” (симметричной и однородной). Пространство возможных исходов опыта содержит два элемента Ω = {ω1, ω2}, где ω1

состоит в появлении “орла”, а ω2 – “решки”. Событие А состоит в появлении “орла”, A = {ω1} . Согласно классическому определению вероятности p(A) = 1/2.

2.3. Аксиоматическое определение вероятности

Данные выше определения вероятности обладают рядом недостатков.

Классическое определение является ограниченным (частным

случаем), поскольку требует конечности пространства Ω возможных исходов опыта и равной возможности для элементарных событий (исходов), что часто не соответствует действительности.

Статистическое определение опирается на факт устойчивости

относительных частот массовых случайных событий и существование их пределов, которые в математической теории мы пока не можем обосновать.

Само же понятие вероятности очень важно, так как ее можно

рассматривать как объективную меру относительной частоты появления события в серии опытов. Поэтому существование вероятности постулируют.

Вероятностным пространством называется тройка объектов (Ω,

A, p), где Ω – пространство возможных исходов опыта, A – σ-алгебра

событий (т.е. подмножеств пространства Ω), p – числовая функция,

определенная на событиях и называемая вероятностью. Вероятность удовлетворяет следующим аксиомам:

1) p(A) ³ 0 для всех A Î Ω (неотрицательность p);

2) вероятность достоверного события равна единице p(U) = 1 (нормированность p);

3) если A и B несовместные события ( A Ç B = V – невозможное

событие), то p(A È B) = p(A) + p(B) (аддитивность p).

В случае, когда пространство Ω бесконечно, следует ввести дополнительную аксиому:

4) если {An} – последовательность попарно несовместных собыæ¥

ö÷ ¥

ç

тий, то pçç ∪ An ÷÷÷ = å p( An ) (счетная аддитивность p).

çè

÷ø n=1

n=1

11

Из этих аксиом можно вывести следующие свойства:

1) вероятность любого события A является неотрицательным

числом, не превышающим единицы, т.е. 0 £ p(A) £ 1;

2) вероятность невозможного события V равна нулю, т.е.

p(V) = 0;

3) вероятность противоположного события равна

p(A )= 1 - p(A).

Легко проверить, что классическое определение вероятности

полностью согласуется с аксиомами вероятности.

2.4. Элементы комбинаторики

Комбинаторика – раздел математики, посвященный решению

задач выбора и расположения элементов некоторого конечного множества в соответствии с заданными правилами.

Рассмотрим множество X, состоящее из N элементов. Будем составлять из элементов этого множества комбинации по k элементов. Две

комбинации считаются различными, если они отличаются или хотя

бы одним элементом, или их порядком. Приведем важные в практическом отношении понятия размещений, перестановок и сочетаний.

Определение. Размещением из N элементов множества X по k

элементов называется любая упорядоченная комбинация (xj1, xj2,

…, xjk). Две комбинации ((xj1, xj2, …, xjk) и (xi1, xi2, …, xik)) равны тогда и только тогда, когда xjl = xil, l = 1, 2, …, k. Число всех различных

k

размещений из N элементов по k обозначается AN

и вычисляется

по формуле

k

AN

= N ( N - 1) ... ( N - k + 1) =

N!

,

( N - k)!

(2.3)

0

где предполагается, что AN

= 1.

Например, если множество Х состоит из 5 элементов

Х = {ω1, ω2, ω3, ω4, ω5} и мы будем составлять упорядоченные комбинации по 2 элемента, то общее число таких комбинаций (размещений) будет равно

A52 = 5 × 4 = 20.

А именно: ω1ω2

12

ω2ω1

ω2ω3

ω3ω4

ω4ω5

ω1ω3 ω3ω1 ω1ω4

ω3ω2 ω2ω4 ω4ω2

ω4ω3 ω3ω5 ω5ω3

ω5ω4

ω4ω1

ω2ω5

ω1ω5

ω5ω2

ω5ω1

Определение. Частный случай размещения при k = N называется перестановкой из N элементов. Число всех перестановок из N элементов равно:

N

AN

= N ( N - 1) ... 2 × 1 = N ! (2.4)

Например, если множество Х состоит из 3 элементов

Х = {ω1, ω2, ω3}, то возможно всего 6 различных перестановок

A33 = 3 × 2 × 1 = 3! = 6.

А именно: ω1ω2ω3 ω1ω3ω2 ω2ω1ω3 ω2ω3ω1 ω3ω1ω2 ω3ω2ω1

Определение. Сочетанием из N элементов множества X по k называется любая неупорядоченная комбинация{xj1, xj2, …, xjk}, состоящая из k элементов множества Х. Число всех сочетаний из N по k

k

обозначается C N

и вычисляется по формуле

k

=

CN

k

AN

N × ( N - 1) × ¼ × ( N - k + 1)

N!

=

=

.

k!

k × ( k - 1) × ¼ × 2 × 1

k !( N - k)!

(2.5)

0

k

Предполагается, что C N

= 1 и CN

= 0 , если k > N. Из формулы

k

для вычисления числа сочетаний C N

непосредственно следует раk

N -k

венство C N

= CN

.

Например, если множество Х состоит из 5 элементов

Х = {ω1, ω2, ω3, ω4, ω5} и мы будем составлять неупорядоченные

комбинации по 2 элемента, то общее число таких комбинаций (сочетаний) будет равно

C52 =

A52

5!

=

= 10.

2!

2!(5 - 2)!

А именно: ω1ω2

ω1ω3 ω1ω4 ω1ω5

ω2ω3

ω2ω4 ω2ω5

ω3ω4

ω3ω5

ω4ω5

Во всех приведенных формулах встречается выражение

N ! = N ( N - 1)¼ 2 × 1 . При больших N справедлива формула Стирлинга: N ! » 2π N × N N × e- N .

2.5. Решение типовых примеров с использованием

классического определения вероятности

Классическое определение вероятности события А имеет вид

p( A) =

mA

,

n

13

где n – общее число элементарных событий в рассматриваемом

случайном опыте и m A – число элементарных событий, благоприятствующих событию А, т.е. число элементов ωk, принадлежащих

подмножеству, соответствующему событию А.

Таким образом, решение представленных ниже примеров сводится к нахождению чисел m A и n. Для этого следует сначала определить пространство Ω, которое будет наиболее удобным при описании данного случайного опыта.

Пример 2.1. Игральная кость бросается один раз. Найти вероятность следующих событий: 1) А – выпадение четного числа очков; 2)

В – выпадение не менее 5 очков; 3) С – выпадение не более 5 очков.

Решение. В рассматриваемом случае пространство Ω возможных

исходов содержит 6 элементов Ω = {ω1, ω2,…,ω6}, где элементарное событие ωk есть выпадение числа k. Игральная кость считается “правильной”, поэтому все элементарные события являются равновозможными и можно пользоваться классическим определением вероятности. События А, В и C соответствуют следующим подмножествам пространства Ω:

A = {ω2, ω4, ω6},

B = {ω5, ω6},

C = {ω1, ω2, ω3, ω4, ω5},

поэтому число элементарных событий, благоприятствующих событиям A, B и C соответственно равно m A = 3, mB = 2, mC = 5. Теперь

вычисляем вероятности этих событий:

p( A) =

mA 1

m

m

1

5

= , p( B) = B = , p(C ) = C = .

2

3

6

n

n

n

Пример 2.2. В урне k белых и r черных шаров (k > 2). Из урны

вынимают наугад два шара. Найти вероятность того, что оба шара

белые.

Решение. За пространство возможных исходов опыта Ω = {ω} принимаем множество всех сочетаний из (k + r) элементов (общее число шаров) по 2 (число вынутых шаров). Из соображений симметрии

(все шары одинаковые и шары вынимают наугад) следует, что все

элементарные события равновозможные, поэтому для определения

вероятности события (оба вынутых шара белые) можно воспользоm

ваться классическим определением p( A) = A . Число всех элементарных событий равно числу сочетаний из (kn+ r) по 2:

n = C 2k+r =

14

1

× ( k + r) × ( k + r - 1).

2

Так как нас интересует вероятность вынуть два белых шара, то

благоприятные события – возможные сочетания по 2 только из белых шаров. Таки образом, число элементарных событий m A, благоприятствующих событию A, равно числу сочетаний из k элементов

(общее число белых шаров) по 2 (число вынутых шаров):

1

× ( k) × ( k - 1).

2

k × ( k - 1)

.

Вероятность события A равна p(A) =

( k + r) × ( k + r - 1)

Пример 2.3. В партии, состоящей из k изделий, имеется дефектных ( £ k). Из партии выбирается для контроля r изделий.

Найти вероятность того, что из них ровно s изделий будет дефектных (s £ r).

Решение. За пространство возможных исходов опыта Ω = {ω}

принимаем множество всех сочетаний из k элементов (общее число

изделий) по r (число выбранных изделий). Элементарные события

равновозможные, поэтому пользуемся классическим определением вероятности. Событие A состоит в том, что из r выбранных изделий ровно s дефектных. Его вероятность определяется по формуле

m

p(A) = A , где общее число элементарных событий n равно числу

n из k по r, т.е. n = C r . Элементарное событие будет благосочетаний

k

приятствующим событию A, если из r выбранных изделий ровно s

будет дефектных, а (r – s) годных. Поэтому число элементарных событий, благоприятствующих событию A, равно произведению числа сочетаний из (общее число дефектных изделий) по s (выбранное число дефектных изделий) на число сочетаний из (k – ) (общее

число годных изделий) по (r – s) (выбранное число годных изделий):

m A = C 2k =

m A = Cs × Ckr--s .

Вероятность события A равна p(A) =

Cs × Ckr--s

.

Ckr

Пример 2.4. Из урны, содержащей k перенумерованных шаров, наугад вынимают один за другим находящихся в ней шаров

( £ k). Найти вероятность того, что номера вынутых шаров будут

идти по порядку:

s, s + 1,…, s + – 1, при 1≤ s ≤ k– +1.

Решение. За пространство возможных исходов опыта Ω = {ω}

принимаем множество всех размещений из k элементов (общее число шаров) по (число вынутых шаров). Событие A состоит в том, что

номера вынутых шаров будут идти по порядку. В силу симметрии

15

результатов опыта все элементарные события равновозможные, поэтому вероятность события A вычисляется по классическому определению

m

p (A ) = A .

n

Общее число элементарных событий n равно числу размещений

из k по :

n = Ak = k × ( k - 1) ×¼× ( k - + 1).

Элементарное событие будет благоприятствовать событию A, если номера вынутых шаров образуют ряд последовательных натуральных чисел. Такие размещения (цепочка из чисел) определяются первым числом, поскольку затем номера увеличиваются на

единицу. Так как последнее число в цепочке не может превышать

общего числа шаров k, то первый вынутый шар может иметь следующие номера: 1, 2, …, (k – + 1), т.е. число элементарных событий,

благоприятствующих событию A, равно m A = k – +1. Вероятность

события A равна

( k - + 1)

1

p (A ) =

=

.

k × ( k - 1)¼( k - + 1)

k × ( k - 1)¼( k - + 2)

В частном случае =k мы получим очевидный результат

1

p(A) = , так как общее число элементарных событий равно чисk!

лу перестановок, а благоприятствующим является только одно элементарное событие. Если вынимается только один шар, то событие

A является достоверным событием, т.е. p(A) = 1.

Пример 2.5. Имеется 3 ящика с различными материалами. Их

наугад распределяют на 5 полок. Найти вероятность того, что: а) все

ящики будут на последней полке; б) только один ящик будет на последней полке.

Решение. Каждый ящик может находиться на любой из пяти полок, поэтому распределение одного ящика можно описать числом

x1, принимающим одно из значений 1, 2, …, 5, соответствующее номеру полки. Распределение двух ящиков можно описать двумерным вектором (x1, x2), каждый компонент которого принимает одно

из значений 1, 2, …, 5.

За пространство возможных исходов опыта примем множество

трехмерных векторов (x1, x2, x3), каждый компонент которого принимает одно из значений 1, 2, …, 5. Событие A состоит в том, что все

ящики будут на последней (пятой) полке, событие B – только один

ящик на последней полке. В силу симметрии результатов опыта, все

16

элементарные события равновозможные, поэтому для определения

вероятности событий A и B пользуемся классическим определением:

m

m

p(A) = A , p (B) = B .

n

n

Общее число элементарных событий n равно числу трехмерных

векторов (x1, x2, x3), каждый компонент которых принимает одно из

значений 1, 2, …, 5:

n = 53 = 125.

Число элементарных событий, благоприятствующих событию A,

равно m A = 1 (событию A соответствует только один вектор (5, 5, 5),

все компоненты которого равны пяти).

Число элементарных событий, благоприятствующих событию B,

равно m A = 3 × 4 × 4 = 48, так как один из компонентов вектора должен принимать значение пять, а две остальные – значение 1, 2, 3,

4.

Вероятность событий A и B равна

1

48

= 0,008; p(B) =

= 0,384.

125

125

Пример 2.6. В розыгрыше первенства по футболу участвуют 16

команд, из которых случайным образом формируются две группы

по 8 команд в каждой. Среди участников соревнований имеется 5

команд экстра-класса. Найти вероятность следующих событий: A –

все команды экстра-класса попадут в одну и ту же группу, B – две

команды экстра-класса попадут в одну из групп, а три – в другую.

Решение. Будем следить за формированием одной из групп, например первой. Вторая группа формируется автоматически из

оставшихся 8 команд.

За пространство возможных исходов опыта Ω = {ω} примем множество сочетаний из 16 элементов (общее число команд) по 8 (число

команд в первой группе). Все элементарные события равновозможные, поэтому можно пользоваться классическим определением вероятности:

p(A) =

p (A ) =

mA

,

n

p (B) =

mB

.

n

Общее число элементарных событий равно числу сочетаний из 16

команд по 8:

8

n = C16

.

17

Элементарное событие будет благоприятствующим событию A,

если в первой группе нет команд экстра-класса или в нее входят все

пять команд экстра-класса. В первом случае число элементарных

событий, благоприятствующих событию A, равно произведению

числа сочетаний из 5 (общее число команд экстра-класса) по 0 (число команд экстра-класса в первой группе) на число сочетаний из 11

(общее число команд не экстра-класса) по 8 (число команд не экстракласса в первой группе):

8

8

m1 A = C50 × C11

= C11

.

Во втором случае число элементарных событий, благоприятствующих событию A, равно

3

3

m2 A = C55 × C11

= C11

.

Общее число элементарных событий, благоприятствующих событию A, равно

8

3

3

8

3

m A = m1 A + m2 A = C11

+ C11

= 2 × C11

, так как C11

= C11

.

Элементарное событие будет благоприятствовать событию B, если в первой группе две команды экстра-класса или в нее входят три

команды экстра-класса. В первом случае число элементарных событий, благоприятствующих событию B, равно произведению числа

сочетаний из 5 (общее число команд экстра-класса) по 2 (число команд экстра-класса в первой группе) на число сочетаний из 11 (общее число команд не экстра-класса) по 6 (число команд не экстракласса в первой группе):

6

m1 B = C52 × C11

.

5

Во втором случае получим m2 B = C53 × C11

и общее число элементарных событий, благоприятствующих событию B, рав6

5

5

но:

mB = m1 B + m2 B = C52 × C11

+ C53 × C11

= 2 × C53 × C11

,

так как

2

3

6

5

C5 = C5 , C11 = C11 .

Итак, вероятности событий A и B равны

p (A ) =

3

2 × C11

8

C16

, p(B) =

5

2 × C53 × C11

8

C16

.

Пример 2.7. Шесть спортсменок (№1, №2, …, №6) приехали на сборы. Их расселили случайным образом в двух комнатах. Одна комната рассчитана на двух человек, другая – на четырех. Найти вероятность того, что спортсменки №1 и №2 окажутся в одной комнате.

18

Решение. Нам достаточно следить за заселением только комнаты, рассчитанной на двух человек. В четырехместной комнате будут

жить спортсменки, не попавшие в двухместную комнату.

За пространство возможных исходов опыта Ω = {ω} примем множество сочетаний из 6 элементов (общее число спортсменок) по 2

(число спортсменок, заселённых в двухместную комнату). Все элементарные события равновозможные, поэтому можно пользоваться

классическим определением вероятности

p (A ) =

mA

.

n

Общее число элементарных событий равно числу сочетаний из 6

команд по 2:

n = C62 = 15.

А именно: №1–№2 №1–№3 №1–№4 №1–№5 №1–№6

№2–№3 №2–№4 №2–№5 №2–№6

№3–№4 №3–№5 №3–№6

№4–№5 №4–№6

№5–№6

Элементарное событие будет благоприятствовать событию A

(спортсменки №1 и №2 в одной комнате), если в двухместной комнате окажутся спортсменки №1 и №2 или если в двухместной комнате

будут жить спортсменки №3, №4, №5 и №6.

В первом случае спортсменки №1 и №2 будут жить в двухместной комнате, во втором – в четырёхместной.

m1A = 1 (№1–№2)

m2A = 6 (№3–№4, №3–№5, №3–№6, №4–№5, №4–№6, №5–№6)

m A = m1A + m2A = 7

p (A ) =

mA

7

= .

15

n

Эту же задачу мы в дальнейшем разберём с использованием формулы полной вероятности.

19

3. Геометрические вероятности

3.1. Геометрическое определение вероятности

В некоторых случаях за пространство возможных исходов опыта можно принимать область n–мерного пространства (прямой, плоскости, трёхмерного пространства и т.д.).

Предположим, что за пространство Ω={ω} принята некоторая область на плоскости (например, прямоугольник).

Тогда событиями будут являться различные подА

множества множества Ω (см. рис. 3.1). Элементар�

ными событиями ω в данном случае служат точки

области, соответствующей пространству возможРис. 3.1

ных исходов опыта Ω. Множество Ω является бесконечным, так как содержит бесконечное число

точек – элементарных событий.

Если элементарные события ω равновозможны (т.е. точки области Ω равноправны), то вероятность попадания точки в область А

пропорциональна площади этой области и не зависит от формы области А и расположения в её внутри области Ω:

SА

,

(3.1)

SΩ

где SΩ – площадь области Ω, а SА – площадь области А.

Рассмотрим одномерный случай. За пространство возможных

исходов опыта Ω принимается отрезок АВ, тогда событиями будут

являться подмножества этого отрезка. Пусть вероятность попадания точки на отрезок СD пропорциональна длине этого отрезка и не

зависит от его расположения внутри отрезка АВ (равновозможность

элементарных событий – точек отрезка АВ) (рис. 3.2).

p (A ) =

A

C

D

B

Рис. 3.2

Тогда вероятность попадания точки на отрезок СD будет равна

СD

отношению длины отрезков СD и АВ: p =

.

АВ

Аналогично определяется вероятность попадания точки в проm

странственную фигуру v, составляющую часть фигуры V, p = v ,

mV

где mv и mV мера (объем) фигур v и V.

Геометрическое определение вероятности удовлетворяет всем

аксиомам вероятности.

20

3.2. Решение типовых примеров

Пример 3.1. Два студента условились встретиться в определенном месте между 12 и 13 часами дня. Пришедший первым ждёт второго в течении 1/4 часа, после чего уходит. Найти вероятность того,

что встреча состоится, если каждый студент наудачу выбирает момент своего прихода (в промежутке от 12 до 13 часов).

Решение. Обозначим через x и y время прихода студентов к месту

встречи. За момент отсчета времени примем 12 часов дня, тогда имеют место неравенства: 0 £ x £ 1, 0 £ y £ 1.

Введем декартовую систему координат на плоскости.

Моменту прихода студентов D1 соответствует точка М(x, y), которая случайным образом ставится в квадрате ОАО1В.

y

А

С1

y = x + 1/4

О 1 у=x –1/4

D1

С

О

D

В

x

Рис. 3.3

За пространство Ω исходов опыта можно принять квадрат ОАО1В

со стороной, равной единице. Из условия задачи следует, что можно

пользоваться геометрическим определением вероятности. Определим область, расположенную внутри квадрата ОАО1В, которая соответствует тому, что встреча студентов состоится. Для этого необходимо выполнение следующего условия:

x - y < 1 4,

т.е. чтобы моменты прихода студентов к месту встречи отличались

бы менее, чем на ¼ часа. Раскрывая знак абсолютной величины, получим:

x – 1/4 < y < x + 1/4.

Соответствующая область лежит между прямыми y = x – 1/4 и

y = x + 1/4. Итак, искомая область – есть многоугольник ОСС1О1D1D

(см. рис. 3.3). Теперь подсчитываем вероятность встречи студентов:

p=

SOCC1O1 D1 D

SOAO1 B

=

1 - 2 × SCAC1

1

2

1 æ3ö

7

= 1 - 2 × çç ÷÷÷ = .

2 çè 4 ø

16

21

4. Теоремы сложения и умножения вероятностей

4.1. Теорема сложения вероятностей

Аксиома аддитивности позволяет вычислить вероятность объединения двух несовместных событий А и В:

p( A È B) = p( A) + p( B).

Ее следствием является формула для вычисления вероятности объединения конечного числа попарно несовместных событий

( Ai Ç A j = V при i ≠ j):

p( A1 È A2 È¼È An ) = p( A1 ) + p( A2 ) +¼+ p( An ).

Теорема сложения вероятностей: вероятность объединения двух

совместных событий равна сумме вероятностей этих событий без

вероятности их совместного наступления (т.е. без вероятности пересечения этих событий):

p( A È B) = p( A) + p( B) - p( A Ç B). (4.1)

Согласие теорем сложения вероятностей для несовместных и совместных событий очевидно, так как пересечение несовместных событий есть невозможное событие, вероятность которого равна нулю. Приведем формулу для вычисления вероятности объединения

конечного числа совместных событий:

n

æ n

ö÷

ç

pçç ∪ Ak ÷÷÷ = å p(Ak )- å p( Ai Ç A j ) +

çè

ø÷ k=1

k=1

1£i< j£n

+

å

1£i< j< k£n

n

p( Ai Ç A j Ç Ak ) -¼+ (-1) p( A1 Ç A2 Ç A3 Ç¼Ç An ). (4.2)

4.2. Условные вероятности.

Теоремы умножения вероятностей

Для того чтобы сформулировать теорему умножения вероятностей, определим условные вероятности.

Определение. Условной вероятностью события В при условии,

что событие А произошло, называется отношение вероятности совместного наступления двух событий А и В (т.е. их пересечения

A Ç B ) к вероятности события А:

22

pA (B) =

p( A Ç B)

.

p( A)

(4.3)

Теорема умножения вероятностей: вероятность пересечения

двух событий А и В равна произведению вероятности события А на

условную вероятность события В при условии, что событие А уже

произошло, т.е.

p( A Ç B) = p( A) × pA ( B). (4.4)

Таким образом, теорема умножения вероятностей неразрывно

связана с понятием условной вероятности. Следствием этой теоремы является формула для определения вероятности пересечения

конечного числа событий. Вероятность совместного появления нескольких событий (т.е. их пересечения) равна произведению вероятности одного из них на условные вероятности всех остальных, причем вероятности каждого последующего события вычисляются в

предположении, что все предыдущие события уже наступили:

p( A1 Ç A2 Ç¼Ç An ) = p( A1 ) × pA1 ( A2 ) × pA1 Ç A2 ( A3 )¼ pA1 Ç¼Ç An-1 ( An ),

где pA1 Ç A2 Ç¼Ç An-1 ( An ) – вероятность события An при условии, что

события A1, A2, …, An-1 уже произошли.

Определение. События А и В называются независимыми, если

вероятность их совместного появления равна произведению вероятностей этих событий:

p( A Ç B) = p( A) × p( B). (4.5)

Это определение независимости событий А и В эквивалентно требованию совпадения вероятности события В и условной вероятности события В при условии, что событие А уже произошло, т.е.

p( B) = pA ( B) или p( A) = pB ( A).

В случае нескольких событий, независимых в совокупности, вероятность их совместного появления равна произведению этих событий:

p( A1 Ç A2 Ç¼Ç An ) = p( A1 ) × p( A2 ) × p( A3 )¼ p( An ). (4.6)

4.3. Решение типовых примеров

Пример 4.1. Вероятность события А равна p. Доказать, что вероятность противоположного события равна (1 – p).

Решение. Покажем, что события A и A образуют полную группу

несовместных событий. Событие A , противоположное событию A,

наступает в том случае, когда событие А не появилось. Поэтому эти

события несовместны, т. е. они не могут наступить одновременно в

данном опыте. Из определения события A следует, что объедине23

ние противоположных событий А и A дает достоверное событие (событие А произойдет или не произойдет). Итак, события А и A образуют полную группу несовместных событий, т.е. они несовместны и

A È A = U.

Теперь применим теорему сложения вероятностей несовместных

событий, учитывая, что вероятность достоверного события равна 1:

p( A) + p( A) = 1.

Вероятность противоположного события обозначим через q.

Таким образом, q = p( A) = 1 - p( A) = 1 - p.

Пример 4.2. Два стрелка стреляют по мишени. Вероятность попадания в мишень при одном выстреле для первого стрелка равна

0,7, а для второго – 0,8. Найти вероятность того, что при одном залпе в мишень попадет только один из стрелков.

Решение. Пусть событие А есть попадание в мишень первым

стрелком, а событие В – попадание в мишень вторым стрелком. Тогда противоположные события будут соответствовать A – промаху

первого стрелка, B – промаху второго стрелка. Событие С наступает, когда в мишень попадает только один из стрелков. Это событие

можно представить в виде

C = ( A Ç B) È ( A Ç B),

т.е. происходит хотя бы одно из событий: первый стрелок попадает в

мишень, а второй – не попадает ( A Ç B), либо первый стрелок не попадает в мишень, а второй – попадает ( A Ç B).

Поскольку вероятности событий А и В известны, то легко вычислить вероятность противоположных событий (см. пример 4.1):

p( A) = 1 - 0,7 = 0,3;

p( B) = 1 - 0,8 = 0,2.

События ( A Ç B) и ( A Ç B) несовместны, так как при появлении

первого должно наступить событие А, а при появлении второго, события А должно не наступить. Стрелки стреляют независимо друг

от друга, поэтому события А и В можно считать независимыми. Из

теорем сложения и умножения вероятностей имеем

p(C ) = p(( A Ç B) È ( A Ç B)) = p( A Ç B) + p( A Ç B) =

= p( A) × p( B) + p( A) × p( B) = 0,7 × 0,2 + 0,3 × 0,8 = 0,38.

Пример 4.3. ОТК проверяет изделия на стандартность. Вероятность того, что изделие нестандартно, равна 0,1. Найти вероятность

того, что хотя бы одно из трех проверяемых изделий нестандартно.

24

Решение. Введем обозначение событий: Ai – i-е изделие нестандартно (i = 1, 2, 3), В – хотя бы одно из трех проверяемых изделий

нестандартно. Тогда событие A i наступит тогда, когда i-е изделие

стандартно, и вероятность этого события равна

p( Ai ) = 1 - p( Ai ) = 1 - 0,1 = 0,9.

Событие B наступает тогда, когда ни одно из трех проверяемых

изделий не является нестандартным, т.е. когда все три изделия

стандартны. Следовательно, данное событие можно представить в

виде B = A1 Ç A 2 Ç A3 .

Поскольку стандартность или нестандартность изделия не зависит от результатов проверки других изделий, то события A1, A2,

A3 являются независимыми, и по теореме умножения вероятностей

имеем

p( B) = p( A1 Ç A2 Ç A3 ) = p( A1 ) × p( A2 ) × p( A3 ) = 0,93 = 0,729.

Теперь вычисляем вероятность события В:

p( B) = 1 - p( B) = 1 - 0,729 = 0,271.

Заметим, чтобы найти вероятность события В, состоящего в появлении события А хотя бы один раз при нескольких испытаниях,

целесообразно определить сначала вероятность противоположного

события B (не появления события А при этих испытаниях), а уже

затем определить вероятность события В.

Пример 4.4. Брошены три игральные кости. Найти вероятность

того, что на всех трех костях появится разное число очков.

Первый способ решения.

Введем обозначения: событие А наступает тогда, когда на второй

игральной кости выпадает число, отличное от числа, выпавшего на

первой игральной кости. Событие В наступает тогда, когда на третьей игральной кости выпадает число, отличное от чисел на первой

и второй игральных костях. Событие С наступает тогда, когда на

всех трех костях появится разное число очков. Это событие есть пересечение событий А и В, т.е. C = A Ç B.

По теореме умножения вероятностей имеем

p(C ) = p( A Ç B) = p( A) × pA ( B).

Вычислим вероятности событий А и В. Вероятность события А

5

равна p( A) = . Так как общее число случаев (количество чисел,

6

которые могут выпасть на второй кости) равно 6, а число случаев,

25

благоприятствующих событию А (количество чисел, не совпадающих с числом, выпавшим на первой кости) равно 5. Аналогично, вероятность события В при условии, что событие А появилось, рав4 2

на pA ( B) = = . Общее число случаев (количество чисел, которые

6 3

могут выпасть на третьей кости) равно 6, а число случаев, благоприятствующих событию B (количество чисел, не совпадающих с числами, выпавшими на первой и второй костях) равно 4.

Окончательно, вероятность события С

5 2 5

p(C ) = × = .

6 3 9

Второй способ решения.

Вероятность события С можно вычислить, пользуясь только

классическим определением вероятности.

Общее число случаев, которые соответствуют различным упорядоченным цепочкам из трех чисел, принимающих значения 1, 2, ..., 6,

равно n = 63 = 216.

Число случаев, благоприятствующих событию С, которые соответствуют упорядоченным цепочкам из трех различных чисел, равно числу размещений:

mC = A63 = 6 × 5 × 4 = 120.

Таким образом, вероятность события С равна

m

120 5

= .

p(C ) = C =

216 9

n

Как и следовало ожидать, оба способа решения приводят к одному и тому же результату.

Пример 4.5. В читальном зале имеется шесть учебников по теории вероятностей, из которых четыре в жёстком переплете. Библиотекарь наудачу взял три учебника. Найти вероятность того, что все

они в жёстком переплете.

Первый способ решения.

Введем следующие обозначения событий: А – первый учебник в

переплете, В – второй учебник в переплете, C – третий учебник в

переплете, F – все выбранные учебники в переплете.

Событие F есть пересечение событий:

F = A Ç B Ç C.

В рассматриваемом случае события A, B и C не являются независимыми, поэтому по теореме умножения вероятностей имеем

p( F ) = p( A Ç B Ç C ) = p( A) × pA ( B) × pAÇ B (C ).

26

Вычислим эти вероятности, используя классическое определение вероятности.

Вероятность события A равна

mA 4 2

= = .

6 3

n

p( A) =

Условная вероятность события B при условии, что событие A произошло (т.е. осталось 5 учебников, из них 3 в переплете), равна

3

pA ( B) = .

5

Условная вероятность события C при условии, что события A и B

произошли (т.е. осталось 4 учебника, из них 2 в переплете), равна

pAÇ B (C ) =

2 1

= .

4 2

Таким образом, вероятность события F равна

p( F ) =

2 3 1 1

× × = .

3 5 2 5

Второй способ решения.

Эту задачу можно решить, используя только классическое определение вероятности. Общее число случаев равно числу сочетаний:

n = C63 =

6×5× 4

= 20.

1× 2 × 3

Число случаев mF, благоприятствующих событию F, равно числу

сочетаний C43 = 4. Таким образом, вероятность события F равна

p( F ) =

mF

4

1

=

= .

20 5

n

Оба способа приводят к одному и тому же результату.

Пример 4.6. Разрыв электрической цепи может произойти вследствие выхода из строя элемента k или двух элементов k1 и k2.

Элементы k, k1, и k2 выходят из строя независимо друг от друга

с вероятностями 0,3; 0,2 и 0,2 соответственно. Определить вероятность разрыва электрической цепи.

Решение. Введем обозначение событий: A – выход из строя элемента k, Bi – выход из строя элементов ki, (i = 1, 2), C – разрыв электрической цепи. По условию задачи событие C произойдет в том

случае, когда выйдет из строя элемент k или выйдут из строя два

27

элемента k1 и k2. Поэтому событие C можно представить в виде

C = A È ( B1 Ç B2 ).

Согласно теореме сложения вероятностей имеем (события A и Bi

не являются несовместными)

p(C ) = p( A È ( B1 Ç B2 )) = p( A) + p( B1 Ç B2 ) - p( A Ç B1 Ç B2 ).

Так как события A, B1 и B2 независимы, то по теореме умножения вероятностей получим

p(C ) = p( A) + p( B1 ) × p( B2 ) - p( A) × p( B1 ) × p( B2 ) =

= 0,3 + 0,2 × 0,2 - 0,3 × 0,2 × 0,2 = 0,328.

28

5. Формула полной вероятности.

Гипотезы. Формула Байеса

5.1. Формула полной вероятности и формулы Байеса

Введём полную группу попарно несовместных событий H1, H2,

…, Hn, которые в дальнейшем будем называть гипотезами. Для гипотез должны выполняться следующие соотношения:

1) Hi Ç H j = V , при i ¹ j ;

2) p( H1 È H2 È¼È Hn ) = p( H1 ) + p( H2 ) +¼+ p( Hn ) = 1.

Событие A можно представить как

A = A Ç Ω = A Ç ( H1 È H2 È¼È Hn ) =

= ( A Ç H1 ) È ( A Ç H2 ) È¼È ( A Ç Hn ).

Так как несовместность отдельных гипотез приводит к несовместности событий A Ç Hi , то по теореме сложения вероятностей

получим

p( A) = p(( A Ç H1 ) È ( A Ç H2 ) È¼È ( A Ç Hn )) =

= p( A Ç H1 ) + p( A Ç H2 ) +¼+ p( A Ç Hn ).

Событие А может появляться совместно с каждой из гипотез. Используя теорему умножения вероятностей, вероятность события А

можно вычислить по формуле, называемой формулой полной вероятности:

p( A) = p( H1 ) × pH1 ( A) + p( H2 ) × pH2 ( A) +¼+ p( Hn ) × pHn ( A). (5.1)

Каждый член в формуле полной вероятности p( Hi ) × pHi ( A) дает

вероятность соответствующей части ( A Ç Hi ) разбиения события А.

Если до опыта вероятности гипотез были p( H1 ), p( H2 ),¼, p( Hn ),

а в результате опыта появилось событие A, то с учетом этого события, “новые”, т.е. условные вероятности гипотез, можно вычислить

по формуле Байеса:

p A ( Hi ) =

p( Hi ) × pHi ( A)

p( H1 ) × pH1 ( A) +¼+ p( Hn ) × pHn ( A)

=

p( Hi ) × pHi ( A)

p( A)

. (5.2)

Таким образом, формула Байеса дает возможность “переоценить”

вероятности гипотез с учетом наблюдения результата опыта.

5.2. Решение типовых примеров

Пример 5.1. В каждой из двух урн содержится 6 черных и 4 белых шара. Из первой урны наудачу извлечен один шар и переложен

29

во вторую урну, после чего из второй урны наудачу извлечен один

шар. Найти вероятность того, что шар черный.

Решение. Введем полную группу несовместных гипотез: H1 –

шар, извлеченный из первой урны, является черным; H2 – шар, извлеченный из первой урны, является белым. Гипотезы образуют

полную группу, так как их объединение – есть достоверное событие.

Вероятности этих несовместных гипотез равны

6

3

4

2

p( H1 ) =

= , p( H2 ) =

= .

10 5

10 5

Найдем условные вероятности события A (из второй урны извлечен черный шар) при выполнении гипотез H1 и H2. При появлении

события H1 во второй урне будет содержаться 11 шаров: 7 черных и

4 белых. Поэтому условная вероятность события A при условии, что

событие H1 произошло, будет равна

7

pH1 ( A) = .

11

Аналогично вычисляем условную вероятность события при условии, что произошло событие H2. В этом случае во второй урне 11 ша6

ров: 6 черных и 5 белых, поэтому pH2 ( A) = .

11

По формуле полной вероятности вычисляем вероятность события A:

3 7

2 6

3

p( A) = p( H1 ) × pH1 ( A) + p( H2 ) × pH2 ( A) = × + × = .

5 11 5 11 5

Вероятность события A, извлечения черного шара из второй урны, равна вероятности извлечения черного шара из первой урны.

Пример 5.2. Три орудия производят стрельбу по трем целям.

Каждое орудие выбирает себе цель случайным образом и независимо от других. Цель, обстрелянная одним орудием, поражается с вероятностью 0,8. Найти вероятности того, что из трех целей будут

поражены две, а третья – нет.

Решение. Введем полную группу несовместных гипотез:

H1 – обстреляны все три цели;

H2 – все орудия стреляют по одной цели;

H3 – две цели из трех обстреляны, а третья – нет. Эти события несовместны, и они образуют полную группу, так как их объединение

– есть достоверное событие. Вероятность события H1 равна

2 1 2

p( H1 ) = 1 × × = ,

3 3 9

30

так как первое орудие всегда будет стрелять по какой-то цели, вто2

рое орудие будет стрелять по другой цели с вероятностью , а тре3

1

тье орудие – по оставшейся необстрелянной цели с вероятностью .

3

Вероятность события H2 равна

1 1 1

p( H2 ) = 1 × × = .

3 3 9

2 1 2

Так как p(H1) + p(H2) + p(H3) = 1, то p( H3 ) = 1 - - = .

9 9 3

Событие А наступает тогда, когда поражены ровно две цели из

трех. Вычислим условные вероятности наступления события А при

условии, что произошло одно из событий Hi (i = 1, 2, 3). Вероятность

события А при условии, что произошло событие H1, равна

pH1 ( A) = 0,2 × 0,8 × 0,8 + 0,8 × 0,2 × 0,8 + 0,8 × 0,8 × 0,2 = 0,384.

Первое слагаемое соответствует случаю, когда не поражена первая цель, второе – не поражена вторая цель, третье – не поражена

третья цель, а остальные две цели поражены.

Вероятность события А при условии, что произошло событие H2,

равна pH2 ( A) = 0.

Вероятность события А при условии, что произошло событие H3,

равна

pH3 ( A) = 0,8 × (1 - 0,22 ) = 0,768.

В этом случае по одной цели стреляет одно орудие (вероятность

поражения равна 0,8), по другой цели стреляют два орудия (вероятность поражения – хотя бы одного попадания – равна 1– 0,22).

По формуле полной вероятности находим вероятность события А:

2

1

2

p( A) = × 0,384 + × 0 + × 0,768 = 0,5973.

9

9

3

Пример 5.3. Шесть спортсменок (№1, №2, …, №6) приехали на

сборы. Их расселили случайным образом в двух комнатах. Одна

комната рассчитана на двух человек, другая – на четырех. Найти

вероятность того, что спортсменки №1 и №2 окажутся в одной комнате.

Решение. Нам достаточно следить за заселением только комнаты, рассчитанной на двух человек. В четырехместной комнате будут

жить спортсменки, не попавшие в двухместную комнату.

Введем полную группу несовместных гипотез:

H1 – спортсменку №1 поселили в двухместную комнату;

H2 – спортсменку №1 поселили в четырехместную комнату.

31

Эти события несовместны, и они образуют полную группу, так

как их объединение – есть достоверное событие.

Вероятности гипотез равны

p( H1 ) =

2 1

4 2

= , p( H2 ) = = .

6 3

6 3

Чтобы произошло событие A (спортсменки №1 и №2 оказались в

одной комнате) при условии, что произошло событие H1, спортсменка №2 должна быть заселена в двухместную комнату. Всего свободных мест 5, в двухместной комнате осталось одно свободное место,

т.е.

1

pH1 ( A) = .

5

Аналогично, при условии, что произошло событие H2, спортсменка №2 должна быть заселена в четырехместную комнату. Всего свободных мест 5, в четырехместной комнате осталось три свободных

места, поэтому

3

pH2 ( A) = .

5

По формуле полной вероятности получим

p( A) = p( H1 ) × pH1 ( A) + p( H2 ) × pH2 ( A) =

1 1 2 3

7

× + × = .

3 5 3 5 15

Пример 5.4. На вход радиолокационного устройства с вероятностью 0,2 поступает смесь полезного сигнала с помехой, а с вероятностью 0,8 – только одна помеха. Если поступает полезный сигнал

с помехой, то устройство регистрирует наличие какого-то сигнала с

вероятностью 0,95, а если помеха – с вероятностью 0,02. Известно,

что устройство зарегистрировало наличие какого-то сигнала. Найти вероятность того, что в его составе имеется полезный сигнал.

Решение. Из условия задачи следует, что можно ввести следующую полную группу несовместных гипотез: H1 – полезный сигнал на

входе имеется, H2 – полезного сигнала на входе нет. Вероятность этих

событий равна p(H1) = 0,2, p(H2) = 0,8, а их сумма дает единицу.

Событие А наступает тогда, когда устройство регистрирует наличие какого-то сигнала. Условная вероятность события А при условии, что событие H1 произошло, равна

pH1 ( A) = 0,95.

32

Условная вероятность события А при условии, что событие H2

произошло, равна

pH2 ( A) = 0,02.

По условию задачи нужно определить вероятность наличия полезного сигнала, если устройство зарегистрировало какой-то сигнал, т.е. условную вероятность pA ( H1 ). Эта вероятность определяется по формуле Байеса:

p( H1 ) × pH1 ( A)

0,2 × 0,95

=

= 0,922.

pA ( H1 ) =

p( H1 ) × pH1 ( A) + p( H2 ) × pH2 ( A) 0,2 × 0,95 + 0,8 × 0,02

Пример 5.5. Батарея из трех орудий произвела залп, причем два

снаряда попали в цель. Найти вероятность того, что первое орудие

дало попадание, если вероятности попадания в цель первым, вторым и третьим орудиями соответственно равны 0,4; 0,3; 0,5.

Решение. Введем полную группу несовместных гипотез: H1 –

первое орудие попало в цель, H2 – первое орудие не попало в цель.

Вероятности этих событий равны

p(H1) = 0,4; p(H2) = 1 – 0,4 = 0,6.

Событие А наступает тогда, когда два снаряда попадают в цель.

Поэтому условная вероятность события А при условии, что событие

H1 произошло (первое орудие попало в цель) будет суммой двух слагаемых:

pH1 ( A) = 0,3 × (1 - 0,5) + (1 - 0,3) × 0,5 = 0,5.

Здесь первое слагаемое соответствует случаю, когда второе орудие попадает в цель, а третье не попадает. Второе слагаемое соответствует случаю, когда попадает в цель третье орудие, а второе не

попадает.

Условная вероятность события А при условии, что событие H2

произошло (первое орудие не попало в цель), равна

pH2 ( A) = 0,3 × 0,5 = 0,15,

так как в этом случае попадают в цель второе и третье орудия.

По формуле Байеса определяем искомую вероятность попадания

в цель первого орудия при условии, что два снаряда попали в цель:

p( H1 ) × pH1 ( A)

0,4 × 0,5

=

= 0,69.

pA ( H1 ) =

p( H1 ) × pH1 ( A) + p( H2 ) × pH2 ( A) 0,4 × 0,5 + 0,6 × 0,15

33

6. Повторение испытаний

6.1. Схема независимых испытаний. Формула Бернулли

Важным частным случаем применения формул сложения и умножения вероятностей является следующая схема. Пусть проводится конечное число n последовательных независимых испытаний, в

каждом из которых возможно только два исхода: либо успех, либо

противоположное событие – неудача. Такая последовательность испытаний называется схемой Бернулли, если вероятности успеха в

каждом опыте одинаковы.

В схеме Бернулли одному испытанию соответствует множество

элементарных исходов, состоящее из двух элементарных событий:

{ w0, w1 }, w0 = 0 (неудача) и w1 = 1 (успех). Если заданы вероятности

успеха и неудачи в отдельном испытании p(w1) = р; p(w0) = 1– р = q,

то можно по формуле умножения определить вероятность любого

элементарного исхода w, включающего k успехов и (n – k) неудач в

определенной последовательности:

p(w) = p(w0)p(w1) ... p(w0) = qp...q =pkqn–k .

Если нас интересует вероятность pn(k) того, что в n испытаниях

произошло ровно k успехов (не важно в какой последовательности),

то ее можно определить как сумму вероятностей таких элементарных событий по формуле сложения вероятностей. В результате мы

получим формулу Бернулли:

pn ( k) = C nk pk qn-k . (6.1)

Здесь C nk – число сочетаний по k элементов из n.

В ряде задач представляет интерес наивероятнейшее число успехов, т.е. такое число успехов m*, вероятность которого самая большая при данном n. Это число находится в интервале единичной длины вблизи точки np:

np - q £ m* £ np + p.

6.2. Предельные теоремы Лапласа

Формула Бернулли верна при любом n, но при большом числе

опытов по ней затруднительно проводить вычисления. В случае

больших n удобнее пользоваться приближенными формулами.

Если n велико, то применяется локальная формула Муавра–

Лапласа:

34

1

pn ( k) »

npq

Функция ϕ (x) =

× ϕ (x) =

k - np

где 0,1 £ p £ 0,9; x =

npq

1

2π

-

e

1

npq

×

1

2π

-

e

x2

2

,

(6.2)

.

x2

2

табулирована (см. табл. 1 приложе-

ния).

Эта функция имеет следующие свойства:

1) j(х) – четная и имеет максимум при х = 0;

2) точки перегиба х = ±1;

3) при х ≥ 5 функция мала, т.е. j(х) ® 0.

При больших значениях n, для вычисления вероятности того,

что произойдет от k1 до k2 событий по схеме Бернулли, используется интегральная формула Муавра–Лапласа:

pn ( k1 £ k £ k2 ) = Φ (x2 )- Φ (x1 ),

k1 - np

(6.3)

k2 - np

, Φ (x)– функция Лапласа, значения

npq

npq

которой приведены в приложении (табл. 2).

где x1 =

, x2 =

Функция Лапласа Φ (x) =

1

2π

t2

х -2

òе

dt имеет следующие свой-

0

ства:

1) Φ (- x) = -Φ (x) – функция нечетная;

2) функция Φ (x) монотонно возрастает;

3) при больших х (х ≥ 5) Φ (x) ® 1/2 (у = ±0,5 горизонтальные

асимтоты), поэтому функция Φ (x) представлена в виде табл. 2 только для 0 ≤ х ≤ 5.

Вероятность отклонения относительной частоты m /n от вероятности р в независимых испытаниях не более, чем на некоторое число e > 0 вычисляется по формуле

æ

æm

ö

pn çç - p < ε÷÷÷ = 2Φ çççε ×

çè n

÷ø

çè

n ö÷÷

÷. pq ÷ø

(6.4)

35

6.3. Распределение Пуассона

Рассмотрим, как ведут себя биномиальные вероятности при

n ® ¥, p ® 0, np ® λ, т.е. когда проводят большое число наблюдений «редких» событий (np ≈ npq). В этом случае имеем

λ k -λ

e = p( k). (6.5)

k!

Предельные вероятности p(k) в схеме независимых испытаний

n®¥, p®0,np=λ

pn ( k) = C nk pk qn-k ¾¾¾¾¾¾¾®

λ k -λ

e , k = 0, 1, 2, ...

k!

называются пуассоновскими.

p( k) »

6.4. Решение типовых примеров

Пример 6.1. Некоторый стрелок попадает в цель с вероятностью

0,6; он собирается произвести 10 выстрелов. Найти вероятность того, что он попадет в цель: а) три раза, б) хотя бы один раз, в) наивероятнейшее число попаданий в цель.

Решение. В формуле Бернулли параметры равны

p = 0,6, q = 1 – p = 1 – 0,6 = 0,4, n = 10.

Теперь можно вычислить искомые вероятности:

10!

3 3 10-3

a) p10 (3) = С10

p q

=

× 0,63 × 0,47 » 0,255;

(10 - 3)!3!

0 0 10-0

б) p10 ( k ³ 1) = 1 - С10

p q

= 1 - 0,410 ;

в) 10 × 0,6 - 0,4 £ k0 £ 10 × 0,6 + 0,6 ,

5,6 £ k0 £ 6,6 , k0 = 6.

Пример 6.2. Стрелок выполнил 400 выстрелов. Найти вероятность 325 попаданий, если вероятность попадания при каждом выстреле равна 0,8.

Решение. Так как число испытаний (выстрелов) достаточно велико, то можно использовать локальную формулу Муавра–Лапласа

(т.к. npq = 400 × 0,8 × 0,2 = 64 ³ 10 ). Следовательно, по формуле

pn ( k) »

1

npq

×

1

2π

-

e

имеем

pn ( k) »

36

1

npq

ϕ( x),

x2

2

где x =

k - np

npq

. Окончательно,

p400 (325) »

1

64

ϕ(0,63) »

1

× 0,3271 » 0,041.

8

Пример 6.3. Стрелок выполнил 400 выстрелов, вероятность одного попадания равна 0,8. Найти вероятность того, что он попадет от

310 до 325 раз.

Решение. Согласно интегральной формуле Муавра–Лапласа имеем

p400 (310 £ x £ 325) = Φ (x2 )- Φ (x1 ),

где

х2 =

х1 =

k2 - np

npq

k1 - np

npq

=

=

325 - 320

64

310 - 320

64

=

=

5

= 0,63,

8

-10

= -1,25.

8

Окончательно,

p400 (310 £ х £ 325) = Φ (0,63)- Φ (-1,25) = Φ (0,63) + Φ (1,25) =

=0,2357+0,3944=0,6301.

Пример 6.4. В каждом из 10000 независимых испытаний вероятность события р = 0,75. Найти вероятность того, что относительная

частота появления события отклонится от вероятности события по

абсолютной величине не более чем на 0,0001.

Решение. По условию задачи n = 10000, p = 0,75, q = 1 – p = 1 –

0,75 = 0,25, e = 0,0001. Следовательно,

æ

æm

ö

p10000 çç - 0,75 < 0,0001÷÷÷ = 2Φ çççε ×

÷ø

çè n

çè

æ

n ö÷÷

10000 ö÷÷

ç

÷ = 2Φ çç0,0001 ×

÷=

pq ÷ø

0,75 × 0,25 ÷ø

èç

= 2Ф(0,23) = 0,182.

Таким образом, вероятность того, что отклонение относительной

частоты успеха от его вероятности в 10000 независимых испытаниях не превысит 0,0001, равна 0,182.

Пример 6.5. Завод отправил 5000 качественных изделий. Вероятность того, что в пути разбили одно изделие 0,0002. Найти вероятность того, что в пути будет повреждено:

37

а) 3 изделия;

б) 1 изделие;

в) не более трех изделий.

Решение. В задаче рассматривается случай большого числа «редких» событий. При решении задачи нужно воспользоваться формулой Пуассона

p( k) »

λ k -λ

e ,

k!

где λ = np = 5000 × 0,0002 = 1. Теперь можно найти:

а) при к = 3 p5000 (3) »

13 -1

1

e =

» 0,061;

3!

6e

б) при к = 1 p5000 (1) »

13 -1 1

e = » 0,366;

1!

e

в) p5000 (0 £ х £ 3) = p5000 (0) + p5000 (1) + p5000 (2) + p5000 (3) =

=

38

1 1 1

1

16

8

+ +

+

=

=

» 0,981.

е е 2е 6 е 6 e 3е

7. Случайные величины

7.1. Случайная величина. Функция распределения

Под случайной величиной понимается величина, которая в ряде

повторных опытов может принимать различные значения и в каждом осуществлении опыта принимает одно и только одно значение,

заранее неизвестно какое (зависящее от случайного исхода опыта).

Определение. Случайной величиной ξ называется дейст­

вительная числовая функция ξ = ξ(ω), ω Î Ω , определенная на множестве Ω элементарных событий рассматриваемой зада­чи, для которой определена вероятность p(ξ Î B) = p{ω : ξ(ω) Î B} принадлежности ξ каждому из заданных множеств B числовой оси (B∈R1).

В качестве множеств B обычно рассматриваются интервалы вида

(a, b), [a, b), (a, b], [a, b] и их объединения.

Вероятность p(ξ∈B) может быть вычислена, если известна вероятность p(ξ < x) = p{ω: ξ(ω) < x}.

Определение. Функцией распределения Fξ ( x) случайной величины ξ называется вероятность события (ξ < x), рассматриваемая

как функция переменной x (x∈R1):

Fξ ( x) = p(ξ < x) (7.1)

(если не возникает недоразумений, то пишут Fξ ( x) = F( x) ).

Свойства функции распределения:

1. 0 ≤ F(x) ≤ 1 – неотрицательность;

2. F( x2 ) ³ F( x1 ) при x2 ³ x1 , т.е. F( x) – неубывающая функция;

3. F(-¥) = 0, F(¥) = 1;

4. lim F( x - ε) = F( x) – непрерывна слева (в точках разрыва

ε>0, ε®0

непрерывности).

Если x = xk – точка разрыва непрерывности функции F(x), то величина скачка равна вероятности события {ξ = xk}

F( xk + 0) - F( xk ) = p(ξ = xk ). Если в точке x = xk функция F(x) непрерывна, то

(7.2)

(7.3)

p(ξ = xk ) = 0. Задачи вычисления вероятностей вида p(ξ∈B) с помощью функции распределения F(x) решаются с использованием следующих

формул:

p(ξ Î [ a, b)) = p( a £ ξ < b) = F(b) - F( a); (7.4)

39

для непересекающихся интервалов [ai, bi) (i = 1, 2, …, m) имеем

m

m

i=1

i=1

p(ξ Î

∪ [ ai , bi )) = å p(ξ Î [ ai , bi )). (7.5)

7.2. Дискретная случайная величина

Определение. Случайная величина ξ называется дискретной, если множество ее возможных значений конечное ({ xi }1n ) или счетное

({ xi }1¥ ) (множество Ω дискретно).

В соответствии с определением и свойством (7.2) функция распределения дискретной случайной величины является кусочнопостоянной функцией и однозначно определяется положением точек разрыва xi (i = 1, 2, ..., n) и величиной скачков (7.2) в этих точках.

Соответствие между последовательностями xi и pi = p(ξ = xi) (i =

1, 2, ..., n) называется законом (рядом) распределения дискретной

случайной величины

xi

x1

x2

…

…

xn

pi

p1

p2

…

…

pn

Вероятность p(ξ∈[a, b)) вычисляется по формуле

p(ξ Î [ a, b)) =

å

xi Î[ a,b)

pi ;

Кроме того, справедливо условие нормировки

n

å pi =

i=1

å

xi Î(-¥,¥)

p(ξ = xi ) = 1. (7.6)

Определение. Математическим ожиданием дискретной случайной величины ξ, принимающей возможные значения xi с вероятностями pi = p(ξ = xi), при i = 1, 2, …, n, называется неслучайная величина M[ξ], определяемая формулой

n

M[ξ] = mξ = å xi × pi , i=1

где n – число возможных значений.

Свойства математического ожидания:

1. M [С ]= С , если С – const;

40

(7.7)

2. M [C × ξ ]= С × M [ξ ]; (7.8)

3. M[ξ + η] = M[ξ] + M[ η].

(Подробнее о сумме случайных величин см. п. 8).

Математическое ожидание случайной величины η, являющейся

функцией случайной величины ξ, т.е. η = ϕ(ξ), определяется формулой

n

M[ η] = mη = å ϕ( xi ) × pi . i=1

(7.9)

Определение. Дисперсией Dξ случайной величины ξ называется

неслучайная величина, определяемая формулой

n

Dξ = M[ξ 2 ] = å ( xi - mξ )2 × pi , i=1

•

(7.10)

где ξ = ξ - mξ – центрированная случайная величина. Для вычислений дисперсии удобен другой вариант формулы (7.10):

•

Dξ = M[(ξ)2 ] = M[(ξ - Mξ )2 ] =

n

= M[ξ2 ] - M 2 [ξ ] = å xi2 × pi - mξ2 (7.11)

i=1

Свойства дисперсии:

1. D[С] = 0, если С – const;

2. D[С × ξ] = С 2 × D[ξ]; (7.11а)

3. D[ξ + η] = D[ξ] + D[ η], если ξ, η – независимые случайные величины.

Величина σξ = Dξ называется средним квадратическим отклонением случайной величины ξ.

Вероятностный смысл Мξ и Dξ заключается в том, что математическое ожидание дает среднее значение случайной величины, а дисперсия (и среднее квадратическое отклонение) характеризует степень ее отклонения от среднего значения.

Начальные моменты α k и центральные моменты β k определяются в соответствии с выражением (7.9) формулами:

n

α k = M[ξ k ] = å xik × pi ,

i=1

n

β k = M[ξ k ] = å ( xi - mξ )k × pi ,

( k = 1, 2, ¼);

( k = 1, 2, ¼). (7.12)

i=1

41

7.3. Непрерывная случайная величина

Определение. Случайная величина ξ называется непрерывной,

если ее функция распределения F(x) непрерывна при всех значениях x.

Для любого из возможных значений x непрерывной случайной

величины ξ выполняется условие (7.3); поэтому имеет смысл лишь

вычисление вероятностей p(ξ∈B), где B = [a, b) конечный интервал

(или объединение таких интервалов).

Иными словами, вероятность того, что непрерывная случайная

величина примет какое-либо конкретное значение равна нулю. Отличной от нуля является вероятность попадания в какой-то конечный интервал.

Для вычисления указанной вероятности используется общая

формула (7.4).

Определение. Случайная величина ξ называется абсолютно непрерывной (рас­пре­деленной с некоторой плотностью), если существует такая интегрируемая, неотрицательная функция f(x), что

при любом x:

x

F( x) = ò f ( x)dx. (7.13)

-¥

Функция f(x), называемая плотностью распределения вероятностей, равна

dF( x)

(7.14)

f ( x) =

,

dx

и удовлетворяет условиям, следующим из свойств F(x):

1) f ( x) ³ 0, так как F(x) – неубывающая;

¥

2)

ò

f ( x)dx0 = 1, так как p(–∞ < ξ < ∞) = 1;

-¥

3) f (±¥) = 0.

Обычно непрерывной называют абсолютно непрерывную случайную величину. В соответствии с формулами (7.4) и (7.13) для вероятности попадания случайной величины в интервал ( a £ ξ < b)

имеет место равенство

b

p( a £ ξ < b) = ò f ( x)dx.

a

42

Определение. Математическим ожиданием непрерывной случайной величины ξ называется неслучайная величина, определяемая равенством

¥

M[ξ] = mξ = ò x × f ( x)dx. (7.15)

-¥

Математическое ожидание функции η = ϕ(ξ) находится по аналогичной формуле

¥

M[ϕ(ξ)] = ò ϕ( x) × f ( x)dx. (7.16)

-¥

Для дисперсии Dξ имеем

¥

Dξ = M[ξ 2 ] = ò ( x - mξ )2 × f ( x)dx (7.17)

-¥

или

¥

Dξ = M[ξ2 ] - M 2 [ξ] = ò x2 × f ( x)dx - mξ2 . (7.18)

-¥

Свойства математического ожидания и дисперсии определяются

прежними соотношениями (7.8) и (7.11а).

Начальные α k и центральные моменты β k определяются соответственно выражениями:

k

¥

α k = M[ξ ] = ò x k × f ( x)dx

( k = 1, 2, ¼);

β k = M[ξ k ] = ò ( x - mξ )k × f ( x)dx

( k = 1, 2, ¼). -¥

¥

(7.19)

-¥

7.4. Функция случайных величин

Величина η = ϕ(ξ), являющаяся функцией случайной величины ξ, также является случайной величиной.

Основные задачи сводятся к определению ее характеристик – законов распределения и числовых характеристик по аналогичным

характеристикам случайного аргумента.

Пусть ξ – дискретная случайная величина, заданная законом

(рядом) распределения:

43

xi, pi = p(ξ = xi ), (i = 1, 2, …, n).

Учитывая, что возможные значения yi случайной величины η

определяются соотношениями yi = ϕ( xi ) и p( η = yi ) = p(ξ = xi ) = pi ,

получаем закон распределения для η:

yi = ϕ( xi ), pi = p(ξ = xi ), (i = 1, 2, ... , n). (7.20)

Замечание. При неоднозначности функции ϕ(ξ) нескольким xi

может отвечать одно yj (j = 1, 2, …, m, m < n). В этом случае соответствующие вероятности pi следует просуммировать.

Для числовых характеристик справедливы формулы, вытекающие из (7.9):

n

M[ η] = mη = å ϕ( xi ) × pi ; (7.21)

i=1

n

2 ] = å [ϕ( xi ) - mη ]2 × pi . Dη = M[ η

(7.22)

i=1

7.5. Примеры наиболее распространенных

распределений случайных величин

Биномиальное распределение (распределение Бернулли)

Распределением Бернулли называется распределение случайной

величины x – числа успехов в серии из n независимых одинаковых

испытаний. Вероятности отдельных значений x = 0,1,2, ..., n находятся по формуле Бернулли

pn ( k) = C nk pk qn-k ,

все вместе они образуют ряд распределения:

xk

0

1

...

k

....

n

pk

qn

npqn–1

...

k n-k

C nk p q

...

pn

Условие нормировки для распределения Бернулли следует из

формулы (бином Ньютона):

n

n

k=0

k=0

n

å pk = å C nk pk qn-k = ( p + q)

= 1n = 1.

Числовые характеристики биномиального распределения можно найти разными способами. Можно прямо воспользоваться формулами (7.7), (7.11).

44

Альтернативный способ вычислений заключается в том, что случайную величину x представляют как сумму независимых случайных величин xk:

ξ=

n

å ξk.

k=1

Пусть каждая случайная величина xk отвечает отдельному испытанию. Очевидно, что xk равна нулю с вероятностью q = 1 – p и равна

единице с вероятностью p. Числовые характеристики xk определяются следующим образом:

M[ξ k ] = 0 × (1 - p) + 1 × p = p , D[ξ k ] = 02 × (1 - p) + 12 × p - p2 = pq .

Математическое ожидание самой случайной величины x равно

сумме математических ожиданий xk:

Mξ =

n

å Mξ k =

k=1

n

å p = np,

k=1

а дисперсия (учитывая независимость отдельных xk) равна сумме

дисперсий xk:

Dξ =

n

å Dξ

k=1

k

=

n

å pq = npq.

k=1

Распределение Пуассона

λ k -λ

e широко применяется в теk!

ории массового обслуживания. Например, оно определяет вероятность числа k вызовов на АТС в единицу времени при средней интенсивности вызовов l. Другими примерами могут служить поступление вызовов на пункт медицинской помощи, клиентов на предприятие бытового обслуживания, последовательность отказов элементов.

Ряд распределения имеет вид:

Распределение Пуассона p( k) =

xk

0

1

...

k

...

pk

e–l

le–l

...

λ k -λ

e

k!

...

Математическое ожидание и дисперсию пуассоновского распределения можно найти, и они получаются равными l:

45

Mξ = Dξ = λ .

Результат можно проверить прямым счетом по формулам (7.7),

(7.11). Например, для математического ожидания имеем

Mξ =

¥

åk

k=0

¥

λ k -λ

λ k-1 -λ

e =λå

e = λe λ e-λ = λ .

k!

(

k

1)!

k=0

Показательный закон распределения

В теории массового обслуживания время обслуживания одной

заявки распределено по показательному закону, плотность вероятности которого имеет вид (μ > 0)

ìïµe-µx ,

fξ ( x) = ïí

ïï 0 ,

î

x ³ 0,

x<0.

График плотности вероятности приведен на рис. 7.1.

fξ(x)

µ–

x

0

Рис. 7.1. График плотности вероятности показательного закона

Условие нормировки плотности вероятности легко проверяется:

¥

ò

-¥

¥

¥

fξ ( x)dx = ò µe-µx dx = ò e- z dz = -e- z

0

0

¥

0

= 1,

где z = µ x, dz = µ dx.

Функция распределения показательного закона имеет вид

x

Fξ (x) =

ò

-¥

x

-µy

fξ (y)dy = ò µe

0

µx

dy = ò e-zdz = -e-z

0

µx

0

= 1 - e-µx ,

где z = µ y, dz = µ dy.

Найдем теперь математическое ожидание и выясним содержательный смысл параметра μ. Математическое ожидание (среднее

время обслуживания одной заявки) найдем интегрированием по частям:

46

¥

Mξ = ò xµ

-µx

0

¥

1

1

dx = ò ze- z dz = (-ze- z

µ

µ

¥

0

0

¥

+ ò e- z dz) = 0

1 -z