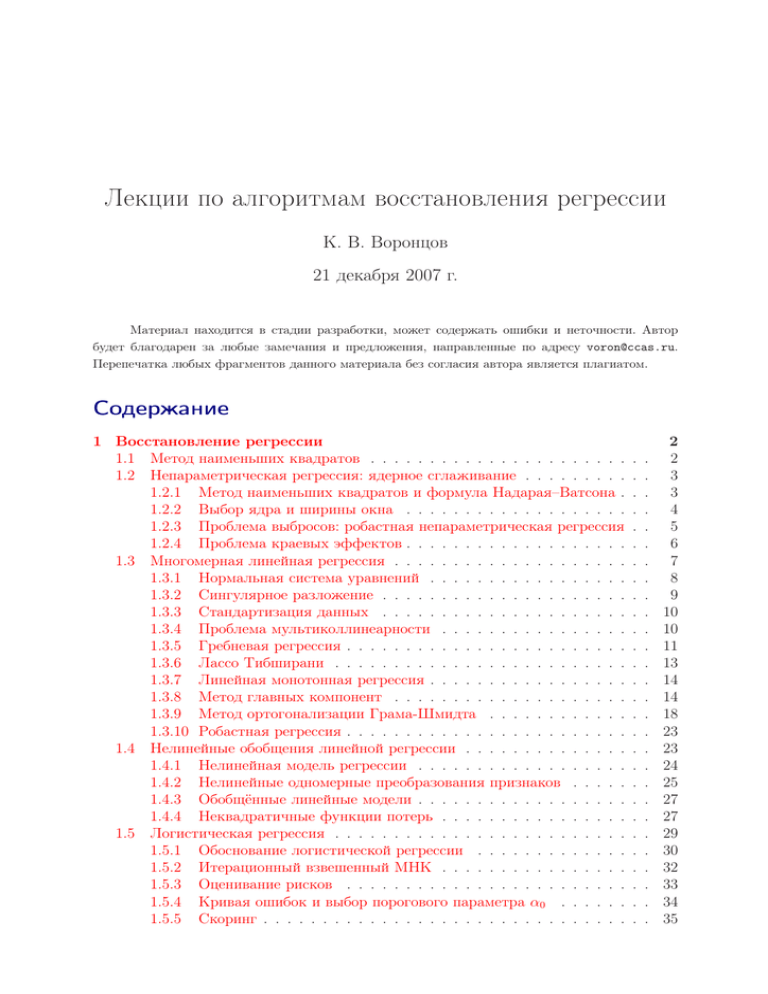

Лекции по алгоритмам восстановления регрессии

реклама