Проблемы практического использования нейросетей

реклама

«Интеллектуальные компьютерные

технологии обработки

социологической информации»

Лекция 5. Проблемы практического

использования нейросетей

Учебные вопросы:

1. Основы функционирования биологических нейронных

сетей

2. Многослойные искусственные нейронные сети

(многослойный персептрон – MLP)

3. Проблемы обучения искусственной нейронной сети (ИНС)

1. Основы функционирования биологических нейронных сетей

(Содержит информацию о

наследственных свойствах и плазму –

основу формирования новых

элементов)

(Приемники

сигналов от

других

нейронов)

Синапс – функциональный узел

между двумя нейронами. Его

волокна связаны с дендритами

другого нейрона. Импульс нейрона

в синапсе высвобождает

химические вещества –

нейротрансмиттеры, которые

возбуждают или затормаживают

способность нейрона-приемника

генерировать импульсы.

Результативность синапсов зависит

от предыстории – они могут

обучаться.

(Тело клетки, генерирует сигналы)

(Канал

передачи

сигналов к

другим

клеткам)

(Синапсы – окончания аксонов, передатчики

сигналов к другим нейронам)

• Число аксонов у

нейрона - 1

• Число дендритов у

нейрона – 103 – 104

• Общее число

нейронов у

человека – 1011

• Общее число

взаимосвязей в

нейронной

биологической сети

– 1014 – 1015

• Продолжительность

импульсов нейрона

– 2 – 5 миллисекунд

• Связи между

нейронами

динамичны

Сравнение компьютера фон-неймановской архитектуры с

биологической нейросистемой

Характеристика

Машина фон Неймана

Биологическая нейронная

система

Процессор

Сложный, высокоскоростной,

один или несколько

Простой, низкоскоростной, очень

большое количество

Память

Отделена от процессора,

локализована, адресация не

по содержанию

Интегрирована в процессор,

распределена, адресация по

содержанию

Вычисления

Централизованные,

последовательные, с

использованием хранимых

алгоритмических программ

Распределенные, параллельные,

с использованием самообучение

Надежность

Высокая уязвимость

Живучесть

Специализация

Числовые и символьные

операции

Проблемы восприятия,

распознавания

Среда

Строго определенная, строго

функционирования ограниченная

Плохо определенная, без

ограничений

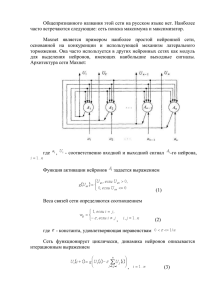

2. Многослойные искусственные нейронные сети (многослойный

персептрон – MLP)

Искусственная нейронная

сеть является вычислительной

машиной с огромным числом

параллельно

функционирующих

простых

процессоров

с

множеством связей.

Пример MLP

Модель персептрона

Основные задачи, решаемые с помощью MLP

• Классификация образов – определение принадлежности входных образов

заранее определённым классам

• Кластеризация / Категоризация – классификация образов по подобию без

предварительного выделения классов

• Аппроксимация функций – нахождение оценки неизвестной функции Y=f(X)

по обучающей выборке {(x1, y1), (x2, y2),…, (xn, yn)}

• Предсказание / Прогноз - определение значений дискретной функции Y в

будущие моменты времени t

• Оптимизация – нахождение решения, удовлетворяющего системе

ограничений, и максимизирующего (минимизирующего) целевую функцию

• Память, адресуемая по содержанию – поддержка ассоциативной памяти

• Управление – расчет входного воздействия, при котором система следует

по заданной (эталонной) траектории (при определении значений весовых

коэффициентов)

3. Проблемы обучения искусственной нейронной сети (ИНС)

Способность к обучению – фундаментальное свойство мозга.

Процесс обучения ИНС может рассматриваться как настройка

архитектуры сети (числа слоев сети и количества нейронов в слоях) и весов

связей (весовых коэффициентов входных сигналов).

Нейронная сеть должна настроить весовые коэффициенты по

имеющейся обучающей выборке в процессе многочисленных итераций – эпох.

Существуют 3 парадигмы обучения – «с учителем», «без учителя»

(самообучение) и смешанная.

В первом случае известны правильные ответы. Веса настраиваются так,

чтобы полученные ответы были как можно ближе к известным значениям (чтоб

ошибка была минимальной).

Обучение «без учителя» не требует знания ответов на каждый пример

выборки. Определяется внутренняя структура данных – корреляция между

образцами, что позволяет распределить образцы по категориям.

Смешанное обучение предполагает использование обеих вариантов.

Три фундаментальных свойства теории обучения на основе

примеров

• Емкость – сколько образцов может запомнить сеть и какие функции и границы

принятия решений могут быть в сети сформированы.

• Сложность образцов - число обучающих примеров, необходимых для достижения

способности сети к обобщению. Малое число примеров может вызвать

«переобученность» сети, когда она хорошо функционирует на примерах обучающей

выборки, но плохо – на тестовых примерах, подчиненных тому же статистическому

определению.

• Вычислительная сложность - количество элементарных операций, затрачиваемых

для решения конкретной задачи. Зависит как от размерности входных данных, так и

их значений. Чем больше вычислительная сложность, тем больше требуется времени

(временная сложность) и вычислительных ресурсов, например, памяти

(пространственная сложность).

Вычислительные алгоритмы, в зависимости от трудоемкости, относят к одному из

двух классов сложности:

В классе P вычислительные затраты линейно растут с увеличением размерности.

Пример: время, требуемое на уборку снега, прямо пропорционально площади. При

увеличении площади уборки вдвое временные затраты также возрастают в два раза.

Класс NP включает задачи, сложность алгоритмов которых экспоненциально

зависит от размерности данных.

Пример: задача поиска выхода из лабиринта. Временные затраты экспоненциально

растут с увеличением числа разветвлений.

Четыре основных типа правил обучения

• Коррекция по ошибке – при обучении «с учителем», известен выходной сигнал. При

несовпадении этот результат включается в обучение, и корректируются веса.

• Обучение Больцмана – стохастическое правило обучения, когда настройка весовых

коэффициентов осуществляется по желаемому распределению вероятностей. Это

специальный случай коррекции по ошибке.

• Правило Хебба – изменение синаптического веса зависит от активности нейрона

(чем больше активность, тем больше вес, «под лежащий камень вода не течет»).

• Обучение методом соревнования – множество выходных нейронов может

возбуждаться одновременно, соревнуясь друг с другом. Модифицируются только

веса «победивших» нейронов: «победитель получает все».

Система считается устойчивой (обученной), если ни один из

примеров

обучающей

выборки

не

изменяет

своей

принадлежности к категории после конечного числа итераций

обучающего процесса.

Обучение нейросети с «учителем»

1. Определяется обучающая выборка (количество входных и выходных

данных и их объем).

2. Устанавливается исходная архитектура

нейросети (количество

скрытых слоев и число нейронов в них) – на основе правила ремонта

многополосной дорожной сети, не допускающей образования

больших пробок, исключая эффект «бутылочного горлышка»,

принятого в реальных популяциях.

3. Устанавливаются начальные значения синаптических весов входных

сигналов.

4. На вход нейросети предъявляется обучающая выборка.

5. Вычисляются отклонения рассчитанных выходных значений от

заданных.

6. Если отклонения превышают

заданные пороговые величины,

корректируются синаптические весы и повторно выполняется шаг 4

(новая эпоха); если отклонения незначительны, процесс обучения

завершается: нейросеть обучена.

7. Если отклонения существенны, но количество эпох исчерпано,

процесс завершается: нейросеть не обучена.

Иллюстрация обучения с «учителем»: распознавание буквы А

Обучение нейрона заключается в постепенной корректировке

весовых коэффициентов wi. - с учителем (известен выходной сигнал) или

без учителя (на основе конкуренции (корреляции) нейронов).

v 1

v 1

v0

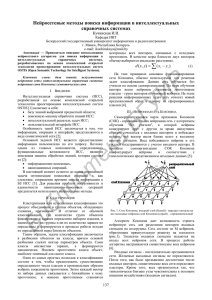

Обучение нейросети без «учителя»

Используется, когда в обучающей выборке можно обнаружить внутренние

взаимосвязи, зависимости, закономерности, существующие между объектами.

Если при обучении с учителем весовые коэффициенты подстраиваются с

целью минимизации ошибки выходных результатов, то при обучении без

учителя

в

самоорганизующихся

картах

Т.

Кохонена

выявленные

взаимозависимости (корреляции) подстраиваются под входные значения.

Нейроны в картах Кохонена располагаются в виде двухмерной (плоской)

матрицы, раскрашенной в зависимости от анализируемых параметров.

Нейросеть Кохонена имеет один входной слой с числом нейронов, равным

числу входов, и единственный скрытый (выходной) слой, образующий

одномерную или двухмерную (решётку. На вход нейросети последовательно

подаются обучающие примеры. На каждом шаге определяется наиболее

схожий нейрон, у которого скалярное произведение весов и поданного на вход

вектора минимально. Такой нейрон объявляется победителем; он будет

являться центром при подстройке весов у соседних нейронов.

Пример самоорганизующихся карт Кохонена

Золотарюк А.В., 2012.