марцинкевич

реклама

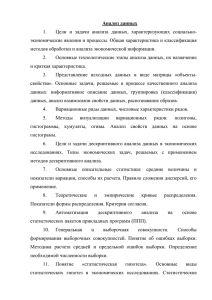

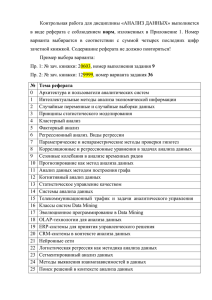

ВВЕДЕНИЕ Актуальность темы дипломной работы определяется тем, что традиционные методы идентификации и аутентификации, основанные на использовании переносных идентификаторов, а также паролей и кодов доступа, имеют ряд существенных недостатков, связанных с тем, что для установления подлинности пользователя применяются атрибутивные и основанные на знаниях опознавательные характеристики, которые можно подделать или украсть. В связи с этим растет интерес к использованию биометрических методов идентификации. Биометрические характеристики являются неотъемлемой частью человека и поэтому их невозможно подделать, забыть или потерять. Среди них есть как хорошо всем известные, отпечатки пальцев, так и менее распространенные, например, аутентификация по ритму работы на клавиатуре - по клавиатурному почерку. Данный способ позволяет выявить нарушителя не только на этапе аутентификации, но и на протяжении всего времени работы за клавиатурой, т.е. если после авторизации сядет другой пользователь, то почерк измениться и система заблокируется. Идентификация людей по клавиатурному почерку реализуется на программном уровне, поэтому является наименее затратной среди биометрических. Так же отсутствие дополнительных устройств делает данный способ скрытым. Степень разработанности проблемы. Исследования данной проблемы представленные в работах таких учёных, как R. Gaines, J. Leggett, W. Lisowski, Alen Peacock, Adrian Perrig, S. Press, N. Shapiro, Dawn Song, D. Umphress, Peter Venable, G. Williams, Иванов А.И., Минниханов Р.Н., Расторгуев С.H. и др. и направленные на статистический анализ данных характеризуются достоверностью аутентификации не выше 90%, ввиду изменчивости почерка в разных психофизиологических состояниях. До сих 2 пор многие вопросы аутентификации пользователей на основе клавиатурного почерка не изучены. Поэтому актуальна дальнейшее развитие методов, алгоритмов и их программно-аппаратных реализаций, повышающих эффективность систем идентификации и аутентификации. Цель дипломной работы: повышение эффективности механизма распознавания пользователя по клавиатурному почерку в системах аутентификации Для этого необходимо решить следующие задачи: - проанализировать существующие методы анализа данных и выбрать несколько наиболее подходящих, исходя из сложности реализации и точности получаемого результата; - собрать и подготовить тестовые данные для проведения исследований; - проанализировать собранные данные выбранными методами; - сравнить результаты и выбрать лучший метод идентификации пользователя. Объектом исследования является повышение достоверности аутентификации по клавиатурному почерку. Предмет исследования - методы интеллектуального анализа данных. Методологической и теоретической основой дипломной работы являются современные научные публикации по изучаемой проблематике. В качестве статистического источника были использованы собранные в ходе работы над дипломом данные. Решение задач, поставленных в работе, основывается на применении методов анализа данных, так называемые методы Data Mining, теории вероятностей и математической экспериментальных выполняется с исследований, использованием статистики, а также компьютерное Microsoft Excel на основе моделирование 2007 и языка программирования VB. 3 Практическая ценность работы. Разрабатываемые методы и средства позволят повысить достоверность аутентификации пользователей по их клавиатурному почерку, предотвращая несанкционированный доступ. 4 1. ОБЗОР МЕТОДОВ АНАЛИЗА ДАННЫХ Под анализом данных понимаются действия направленные на получение новых, неочевидных знаний об объекте. Анализ данных состоит из нескольких этапов (см. рисунок 1.1) [14]: - понимание и формулировка задачи анализа; - подготовка данных для автоматизированного анализа (препроцессинг); - применение методов Data Mining и построение моделей; - проверка построенных моделей; - интерпретация моделей человеком. Рисунок 1.1. Этапы интеллектуального анализа данных В 1989 году Григорием Пятецким-Шапиро был введен термин Data Mining, который он определил как «процесс обнаружения в сырых данных ранее неизвестных, нетривиальных, практически полезных и доступных интерпретации знаний, необходимых для принятия решений в различных сферах человеческой деятельности» [11]. 5 Data Mining (рус. добыча данных, интеллектуальный анализ данных, глубинный анализ данных) - собирательное название, используемое для обозначения совокупности методов. Знания должны быть новые, ранее неизвестные. Затраченные усилия на открытие знаний, которые уже известны пользователю и, следовательно, не представляют для него ценность, не окупаются. Знания должны быть нетривиальны. Результаты анализа должны отражать неочевидные, неожиданные закономерности в данных, составляющие, так называемые скрытые знания. Результаты, которые могли бы быть получены более простыми способами (например, визуальным просмотром), не оправдывают привлечение мощных методов Data Mining. Знания должны быть практически полезны. Найденные знания должны быть применимы, в том числе и на новых данных, с достаточно высокой степенью достоверности. Полезность заключается в том, чтобы эти знания могли принести определенную выгоду при их применении. Знания должны быть доступны для понимания человеку. Найденные закономерности должны быть логически объяснимы, в противном случае существует вероятность, что они являются случайными. Кроме того, обнаруженные знания должны быть представлены в понятном для человека виде [13]. Data Mining - это сочетание широкого математического инструментария (от классического статистического анализа до новых кибернетических методов) и последних достижений в сфере информационных технологий. В технологии Data Mining гармонично объединились строго формализованные методы и методы неформального анализа, т.е. количественный и качественный анализ данных [4]. В Data Mining для представления полученных знаний служат модели. Виды моделей зависят от методов их создания. Наиболее распространенными являются: правила, деревья решений, кластеры и математические функции. 6 К методам и алгоритмам Data Mining относятся следующие: искусственные нейронные сети, деревья решений, символьные правила, методы ближайшего соседа и k-ближайшего соседа, метод опорных векторов, байесовские сети, линейная регрессия, корреляционно-регрессионный анализ; иерархические методы кластерного анализа, неиерархические методы кластерного анализа, в том числе алгоритмы k-средних и k-медианы; методы поиска ассоциативных правил, в том числе алгоритм Apriori, метод ограниченного перебора, эволюционное программирование и генетические алгоритмы, разнообразные методы визуализации данных и множество других методов [11]. Большинство аналитических методов, используемые в технологии Data Mining это известные математические алгоритмы и методы. Новым в их применении является возможность их использования при решении тех или иных конкретных проблем, обусловленная появившимися возможностями технических и программных средств. Метод (method) представляет собой норму или правило, определенный путь, способ, прием решений задачи теоретического, практического, познавательного, управленческого характера. Понятие алгоритма появилось задолго до создания электронных вычислительных машин. Сейчас алгоритмы являются основой для решения многих прикладных и теоретических задач в различных сферах человеческой деятельности, в большинстве - это задачи, решение которых предусмотрено с использованием компьютера. Алгоритм (algorithm) - точное предписание относительно последовательности действий (шагов), преобразующих исходные данные в искомый результат [4]. 7 1.1. Классификация методов Data Mining Все методы Data Mining подразделяются на две большие группы по принципу работы классификации с верхний исходными уровень обучающими определяется данными. на В этой основании того, сохраняются ли данные после Data Mining либо они дистиллируются для последующего использования. 1. Непосредственное использование данных, или сохранение данных. В этом случае исходные данные хранятся в явном детализированном виде и непосредственно используются на стадиях прогностического моделирования и/или анализа исключений. Проблема этой группы методов при их использовании могут возникнуть сложности анализа сверхбольших баз данных. Методы этой группы: кластерный анализ, метод ближайшего соседа, метод k-ближайшего соседа, рассуждение по аналогии. 2. Выявление и использование формализованных закономерностей, или дистилляция шаблонов. При технологии дистилляции шаблонов один образец (шаблон) информации извлекается из исходных данных и преобразуется в некие формальные конструкции, вид которых зависит от используемого метода Data Mining. Этот процесс выполняется на стадии свободного поиска, у первой же группы методов данная стадия в принципе отсутствует. На стадиях прогностического моделирования и анализа исключений используются результаты стадии свободного поиска, они значительно компактнее самих баз данных. Методы этой группы: логические методы; методы визуализации; методы кросс-табуляции; методы, основанные на уравнениях. 8 Логические методы, или методы логической индукции, включают: нечеткие запросы и анализы; символьные правила; деревья решений; генетические алгоритмы. Методы этой группы являются, пожалуй, наиболее интерпретируемыми - они оформляют найденные закономерности, в большинстве случаев, в достаточно прозрачном виде с точки зрения пользователя. Полученные правила могут включать непрерывные и дискретные переменные. Следует заметить, что деревья решений могут быть легко преобразованы в наборы символьных правил путем генерации одного правила по пути от корня дерева до его терминальной вершины. Деревья решений и правила фактически являются разными способами решения одной задачи и отличаются лишь по своим возможностям. Кроме того, реализация правил осуществляется более медленными алгоритмами, чем индукция деревьев решений. Методы кросс-табуляции: агенты, баесовские (доверительные) сети, кросс-табличная визуализация. Последний метод не совсем отвечает одному из свойств Data Mining - самостоятельному поиску закономерностей аналитической системой. Однако, предоставление информации в виде кросстаблиц обеспечивает реализацию основной задачи Data Mining - поиск шаблонов, поэтому этот метод можно также считать одним из методов Data Mining. Методы на основе уравнений. Методы этой группы выражают выявленные закономерности в виде математических выражений - уравнений. Следовательно, они могут работать лишь с численными переменными, и переменные других типов должны быть закодированы соответствующим образом. Это несколько ограничивает применение методов данной группы, тем не менее они широко используются при решении различных задач, особенно задач прогнозирования. 9 Основные методы данной группы: статистические методы и нейронные сети. Статистические методы наиболее часто применяются для решения задач прогнозирования. Существует множество методов статистического анализа данных, среди них, например, корреляционно-регрессионный анализ, корреляция рядов динамики, выявление тенденций динамических рядов, гармонический анализ. Другая классификация разделяет все многообразие методов Data Mining на две группы: статистические и кибернетические методы. Эта схема разделения основана на различных подходах к обучению математических моделей. Следует отметить, что существует два подхода отнесения статистических методов к Data Mining. Первый из них противопоставляет статистические методы и Data Mining, его сторонники считают классические статистические методы отдельным направлением анализа данных. Согласно второму подходу, статистические методы анализа являются частью математического инструментария Data Mining. Большинство авторитетных источников придерживается второго подхода. В этой классификации различают две группы методов: - статистические методы, основанные усредненного накопленного опыта, на использовании который отражен в ретроспективных данных; - кибернетические методы, включающие множество разнородных математических подходов. Недостаток такой классификации: и статистические, и кибернетические алгоритмы тем или иным образом опираются на сопоставление статистического опыта с результатами мониторинга текущей ситуации. Преимуществом такой классификации является ее удобство для интерпретации - она используется при описании математических средств 10 современного подхода к извлечению знаний из массивов исходных наблюдений (оперативных и ретроспективных), т.е. в задачах Data Mining. Методы Data Mining также можно классифицировать по задачам Data Mining. В соответствии с такой классификацией выделяем две группы. Первая из них - это подразделение методов Data Mining на решающие задачи сегментации (т.е. задачи классификации и кластеризации) и задачи прогнозирования. В соответствии со второй классификацией по задачам методы Data Mining могут быть направлены на получение описательных и прогнозирующих результатов. Описательные методы служат для нахождения шаблонов или образцов, описывающих данные, которые поддаются интерпретации с точки зрения аналитика. К методам, направленным на получение описательных результатов, относятся итеративные методы кластерного анализа, в том числе: алгоритм kсредних, k-медианы, самоорганизующиеся иерархические карты методы Кохонена, кластерного методы анализа, кросс-табличной визуализации, различные методы визуализации и другие. Прогнозирующие методы используют значения одних переменных для предсказания/прогнозирования неизвестных (пропущенных) или будущих значений других (целевых) переменных. К методам, направленным на получение прогнозирующих результатов, относятся такие методы: нейронные сети, деревья решений, линейная регрессия, метод ближайшего соседа, метод опорных векторов и др. 1.2. Задачи, решаемые методами Data Mining: - Классификация — отнесение входного вектора (объекта, события, наблюдения) к одному из заранее известных классов. 11 - Кластеризация — разделение множества входных векторов на группы (кластеры) по степени «похожести» друг на друга. - Сокращение описания — для визуализации данных, упрощения счета и интерпретации, сжатия объемов собираемой и хранимой информации. - Ассоциация — поиск повторяющихся образцов. Например, поиск «устойчивых связей в корзине покупателя». - Прогнозирование – нахождение будущих состояний объекта на основании предыдущих состояний (исторических данных) - Анализ отклонений — например, выявление нетипичной сетевой активности позволяет обнаружить вредоносные программы. - Визуализация данных. В дальнейшей работе будет рассматриваться только классификация, т.к. именно она подходят по определению: отнесение входного вектора данных о введенном пароле к одному заранее известному классу – пользователю. 1.2.1. Задачи классификации Классификация является наиболее простой и часто решаемой задачей Data Mining. Классификация - системное распределение изучаемых предметов, явлений, процессов по родам, видам, типам, по каким-либо существенным признакам для удобства их исследования; группировка исходных понятий и расположение их в определенном порядке, отражающем степень этого сходства. Классификация - упорядоченное по некот nорому принципу множество объектов, которые имеют сходные классификационные признаки (одно или несколько свойств), выбранных для определения сходства или различия между этими объектами. 12 Классификация требует соблюдения следующих правил: - при каждом делении необходимо применять только одно основание; - деление должно быть соразмерным, т.е. общий объем видовых понятий должен равняться объему делимого родового понятия; - члены деления должны взаимно исключать друг друга, их объемы не должны перекрещиваться; - деление должно быть последовательным. Различают: - вспомогательную (искусственную) классификацию, которая производится по внешнему признаку и служит для придания множеству предметов (процессов, явлений) нужного порядка; - естественную существенным классификацию, признакам, которая производится характеризующим по внутреннюю общность предметов и явлений. Она является результатом и важным средством научного исследования, т.к. предполагает и закрепляет результаты изучения закономерностей классифицируемых объектов. В зависимости от выбранных признаков, их сочетания и процедуры деления понятий классификация может быть: - простой - деление родового понятия только по признаку и только один раз до раскрытия всех видов. - сложной - применяется для деления одного понятия по разным основаниям и синтеза таких простых делений в единое целое. Классификация - это закономерность, позволяющая делать вывод относительно определения характеристик конкретной группы. Таким образом, для проведения классификации должны присутствовать признаки, характеризующие группу, к которой принадлежит то или иное событие или 13 объект (обычно при этом на основании анализа уже классифицированных событий формулируются некие правила). Классификация относится к стратегии обучения с учителем (supervised learning), которое также именуют контролируемым или управляемым обучением. Задачей классификации часто называют предсказание категориальной зависимой переменной (т.е. зависимой переменной, являющейся категорией) на основе выборки непрерывных и/или категориальных переменных. Другой вариант классификации возникает, если зависимая переменная может принимать значения из некоторого множества предопределенных классов. В этих случаях рассматривается множество классов для зависимой переменной. Классификация может быть одномерной (по одному признаку) и многомерной (по двум и более признакам). 1.2.2. Процесс классификации Цель процесса классификации состоит в том, чтобы построить модель, которая использует параметров и прогнозирующие получает значение атрибуты зависимого в качестве входных атрибута. Процесс классификации заключается в разбиении множества объектов на классы по определенному критерию. Классификатором называется некая сущность, определяющая, какому из предопределенных классов принадлежит объект по вектору признаков. Для проведения классификации с помощью математических методов необходимо иметь формальное описание объекта, которым можно оперировать, используя математический аппарат классификации. Набор исходных данных (или выборку данных) разбивают на два множества: обучающее и тестовое. 14 Обучающее множество (training set) - множество, которое включает данные, использующиеся для обучения (конструирования) модели. Такое множество содержит входные и выходные (целевые) значения примеров. Выходные значения предназначены для обучения модели. Тестовое (test set) множество также содержит входные и выходные значения примеров. Здесь выходные значения используются для проверки работоспособности модели. Процесс классификации состоит из двух этапов: конструирования модели и ее использования. Конструирование модели: описание множества предопределенных классов. Каждый пример набора данных относится к одному предопределенному классу. На этом этапе используется обучающее множество, на нем происходит конструирование модели. Полученная модель представлена классификационными правилами, деревом решений или математической формулой. Использование модели: классификация новых или неизвестных значений. Оценка правильности (точности) модели. Известные значения из тестового примера сравниваются с результатами использования полученной модели. Уровень точности - процент правильно классифицированных примеров в тестовом множестве. Тестовое множество, т.е. множество, на котором тестируется построенная модель, не должно зависеть от обучающего множества. Если точность модели допустима, возможно использование модели для классификации новых примеров, класс которых неизвестен. 15 1.3. Методы, применяемые для решения задач классификации Для классификации используются различные методы. Основные из них: - классификация с помощью деревьев решений; - байесовская (наивная) классификация; - классификация при помощи искусственных нейронных сетей; - классификация методом опорных векторов; - статистические методы, в частности, линейная регрессия; - классификация при помощи метода ближайшего соседа; - классификация CBR-методом; - классификация при помощи генетических алгоритмов. Точность классификации: оценка уровня ошибок Оценка точности классификации может проводиться при помощи кросс-проверки. Кросс-проверка (Cross-validation) - это процедура оценки точности классификации на данных из тестового множества, которое также называют кросс-проверочным множеством. Точность классификации тестового множества сравнивается с точностью классификации обучающего множества. Если классификация тестового множества дает приблизительно такие же результаты по точности, как и классификация обучающего множества, считается, что данная модель прошла кросс-проверку. Разделение на обучающее и тестовое множества осуществляется путем деления выборки в определенной пропорции, например обучающее множество - две трети данных и тестовое - одна треть данных. Этот способ следует использовать для выборок с большим количеством примеров. Если же выборка имеет малые объемы, рекомендуется применять специальные методы, при использовании которых обучающая и тестовая выборки могут частично пересекаться. 16 Оценивание классификационных методов следует проводить, исходя из следующих характеристик [14]: скорость, робастность, интерпретируемость, надежность. В таблице 1 приведена сравнительная характеристика некоторых распространенных методов Data Mining. Из нее видно, что каждый из них имеет свои слабые и сильные стороны, поэтому нельзя однозначно обозначить лучший метод. Метод необходимо подбирать для каждой конкретной задачи, определяя наиболее существенные свойства. использования Популярность, широта Быстрота Разносторонность Трудоемкость использованию Пригодность к Интерпретируемость Методы Точность Свойства Масштабируемость Таблица 1.1. Сравнительная характеристика методов Data Mining Классические методы (линейная средняя высокая высокая/ средняя высокая средняя средняя высокая низкая регрессия) нейронные сети методы визуализации деревья решений k-ближайшего соседа высокая низкая высокая очень низкая низкая высокая высокая низкая высокая высокая низкая низкая средняя низкая очень высокая/ низкая средняя высокая/ средняя средняя очень высокая низкая низкая чрезвыча низкая йно низкая высокая высокая средняя/ очень Низкая высокая/ средняя высокая/ высокая/ средняя средняя низкая высокая низкая 17 1.3.1. Метод деревьев решений Метод деревьев решений (decision trees) является одним из наиболее популярных методов решения задач классификации и прогнозирования. Иногда этот метод Data Mining также называют деревьями решающих правил, деревьями классификации и регрессии. Если зависимая, т.е. целевая переменная принимает дискретные значения, при помощи метода дерева решений решается задача классификации. Если же зависимая переменная принимает непрерывные значения, то дерево решений устанавливает зависимость этой переменной от независимых переменных, т.е. решает задачу численного прогнозирования. В наиболее простом виде дерево решений - это способ представления правил в иерархической, последовательной структуре. Основа такой структуры - ответы "Да" или "Нет" на ряд вопросов. Корень - исходный вопрос, внутренний узел дерева является узлом проверки определенного условия. Далее идет следующий вопрос и т.д., пока не будет достигнут конечный узел дерева, являющийся узлом решения. Бинарные деревья являются самым простым, частным случаем деревьев решений. В остальных случаях, ответов и, соответственно, ветвей дерева, выходящих из его внутреннего узла, может быть больше двух. На этапе построения модели, собственно, и строится дерево классификации или создается набор неких правил. На этапе использования модели построенное дерево, или путь от его корня к одной из вершин, являющийся набором правил для конкретного клиента, используется для ответа на поставленный вопрос. Правилом является логическая конструкция, представленная в виде "если : то :". Внутренние узлы дерева являются атрибутами базы данных. Эти атрибуты называют прогнозирующими, или атрибутами расщепления (splitting attribute). Конечные узлы дерева, или листы, именуются метками класса, являющимися значениями зависимой категориальной переменной. Каждая 18 ветвь дерева, идущая от внутреннего узла, отмечена предикатом расщепления. Последний может относиться лишь к одному атрибуту расщепления данного узла. Характерная особенность предикатов расщепления: каждая запись использует уникальный путь от корня дерева только к одному узлу-решению. Объединенная информация об атрибутах расщепления и предикатах расщепления в узле называется критерием расщепления (splitting criterion). Качество построенного дерева решения весьма зависит от правильного выбора критерия расщепления [7]. Классификационная модель, представленная в виде дерева решений, является интуитивной и упрощает понимание решаемой задачи. Деревья решений дают возможность извлекать правила из базы данных на естественном языке. Алгоритм конструирования дерева решений не требует от пользователя выбора входных атрибутов (независимых переменных). На вход алгоритма можно подавать все существующие атрибуты, алгоритм сам выберет наиболее значимые среди них, и только они будут использованы для построения дерева. 1.3.2. Метод построения правил классификации: алгоритм построения 1-правил [10] Пусть у нас есть независимые переменные A1...Aj...Ak, принимающие значения <x11..x1n>,…<x1j..xnj>,…<x1k..xnk> соответственно, и зависимая переменная C, принимающая значения c1...cr. Для любого возможного значения каждой независимой переменной формируется правило, которое классифицирует объект из обучающей выборки. В если-части правила указывают значение независимой переменной (Если Aj=xij). В то-части правила указывается наиболее часто встречающееся значение зависимой переменной у данного значения независимой переменной (то C = cr). Ошибкой правила является количество объектов, имеющих данное значение рассматриваемой независимой переменной (Aj=xij), но не имеющих наиболее 19 часто встречающееся значение зависимой переменной у данного значения независимой переменной (Ccr). Оценив ошибки, выбирается переменная, для которой ошибка набора минимальна. В случае непрерывных значений манипулируют промежутками. В случае пропущенных значений - достраивают. Наиболее серьезный недостаток - сверхчувствительность, алгоритм выбирает переменные, стремящиеся к ключу (т.е. с максимальным количеством значений, у ключа ошибка вообще 0, но он не несет информации). Эффективен, если объекты классифицируются по одному атрибуту. 1.3.3. Метод k-ближайших соседей Алгоритм k-ближайших соседей решает задачу классификации и позволяет определить среди всех наблюдений, k наиболее похожих на новый, исследуемый, объект, и на основе взвешенного голосования отнести его к одному из существующих классов (пользователей). Алгоритм способен выделить среди всех наблюдений k известных объектов (k-ближайших соседей), похожих на новый неизвестный ранее объект. На основе классов ближайших соседей выносится решение касательно нового объекта. Важной задачей данного алгоритма является подбор коэффициента k – количество записей, которые будут считаться похожими. Плюсы алгоритма заключаются в следующем [16]: 1. Алгоритм устойчив к аномальным выбросам, так как вероятность попадания такой записи в число k-ближайших соседей мала. Если же это произошло, то влияние на голосование (особенно взвешенное) (при k>2) также, скорее всего, будет незначительным, и, следовательно, малым будет и влияние на итог классификации. 2. Программная реализация алгоритма относительно проста. 20 3. Результат работы алгоритма легко поддаётся интерпретации. 4. Возможность модификации алгоритма, путём использования наиболее подходящих функций сочетания и метрик позволяет подстроить алгоритм под конкретную задачу. На первом шаге алгоритма задается число k – количество ближайших соседей. На втором шаге находятся k записей с минимальным расстоянием до вектора признаков нового объекта (поиск соседей). Функция для расчета расстояния должна отвечать следующим правилам: d(x,y) ≥ 0, d(x,y) = 0 тогда и только тогда, когда x = y; d(x,y) = d(y,x); d(x,z) ≤ d(x,y) + d(y,z), при условии, что точки x, y, z не лежат на одной прямой. Для упорядоченных значений атрибутов находится Евклидово расстояние, данная мера близости является одной из самых применяемых в данном алгоритме: 2 DE (xi , yi ) = √∑m i=1(xi − yi ) , (1.1) где m – количество атрибутов, yi - значение атрибута известной записи, xi - значение атрибута новой записи. На следующем шаге, когда найдены записи, наиболее похожие на новую, необходимо решить, как они влияют на класс новой записи. Для этого используется функция сочетания (combination function). Одним из основных вариантов такой функции является простое, не взвешенное голосование (simple unweighted voting), которое заключается в подсчете количества записей каждого класса, вошедших в число ближайших соседей. Класс, который наберет наибольшее количество голосов, присваивается новой записи. Для более точного определения класса новой записи применяют взвешенное голосование, которое учитывает расстояние до новой записи. 21 Чем меньше расстояние, тем более значимый вклад вносит голос. Голоса за класс находятся по следующей формуле: votes(class) = ∑ni=1 1 D2 (xi ,yi ) , (1.2) где D2(xi, yi) – квадрат расстояния от известной записи yi до новой xi, n – количество известных записей класса, для которого рассчитываются голоса, class - наименование класса. Класс, набравший наибольшее количество голосов, присуждается новой записи. При этом вероятность того, что несколько классов наберут одинаковые голоса, почти отсутствует. Алгоритм k-ближайших соседей имеет широкое применение в разных сферах: - Обнаружение мошенничества. Новые случаи мошенничества могут быть похожи на те, которые происходили когда-то в прошлом. Алгоритм KNN может распознать их для дальнейшего рассмотрения. - Предсказание отклика клиентов. Можно определить отклик новых клиентов по данным из прошлого. - Медицина. Алгоритм может классифицировать пациентов по разным показателям, основываясь на данных прошедших периодов. - Прочие задачи, требующие классификацию. На основе изложенного выше материала была составлена сравнительная таблица методов, решающих задачи классификации (таблица 1.2). Таблица 1.2. Сравнение методов, решающих задачи классификации Метод Достоинства Недостатки 22 Деревья решений - извлечение правил на естественном языке - интуитивно понятная классификационная модель - высокая точность прогноза, сопоставимая с другими методами - позволяет легко обрабатывать ситуации, в которых значения некоторых переменных Байесовская неизвестны (наивная) - достаточно просто классификация интерпретируются - позволяет избежать проблемы переучивания, т.е. избыточного усложнения модели 1-правило - извлечение правил на естественном языке - интуитивно понятная классификационная модель - простота реализации - ресурсоемкий процесс обучения - проблема переучивания - требуется серьезная предварительная обработка данных, которая может привести к потере точности - на результат влияют только индивидуальные значения входных переменных, комбинированное влияние значений разных атрибутов не учитывается. - сверхчувствительно сть - требуется репрезентативный - простота реализации набор данных Метод k - не требует предварительной - сравнение каждого ближайших обработки данных исследуемого соседей объекта со всеми данными С учетом всех плюсов и минусов каждого метода для дальнейшего исследования были выбраны два, наиболее подходящие для дальнейшего анализа. Алгоритм 1-правило – прост в реализации, формулируется на естественном языке, но обладает сверх чувствительностью. 23 Алгоритм k – ближайших соседей прост в реализации и не требует предварительной очистки данных от аномальных значений, т.к. они просто не попадают в число ближайших соседей и ни как не влияют на итоговый результат. В качестве недостатков данного метода описано: необходимость репрезентативного набора данных и сравнения каждого исследуемого объекта со всеми данными [13]. 1.4. Выводы по главе 1 В главе 1 рассмотрены вопросы, касающиеся анализа данных с применением методов Data Mining. Приведены различные классификации и обзор методов. Особое внимание было уделено методам, решающим задачи классификации, в соответствие целью работы. Проведен сравнительный анализ методов и выбраны два, наиболее подходящие для дальнейшего исследования. 24 2. ПОСТАНОВКА ЗАДАЧИ И СБОР ДАННЫХ ДЛЯ АНАЛИЗА 2.1. Аутентификация пользователей Важнейшим элементом несанкционированного защиты доступа (НСД) информационной является системы от идентификация и аутентификация пользователей, обеспечивающая контроль доступа к ней. Эти процедуры важны, потому что любой системе защиты от НСД для выполнения своей задачи необходимо, чтобы все легальные пользователи были идентифицированы, и гарантировалось бы соответствие между пользователями и их идентификаторами, так как все остальные элементы системы защиты работают с идентифицированными субъектами [1]. Присвоение субъектам и объектам личного идентификатора и сравнение его с заданным перечнем называется идентификацией. Идентификация обеспечивает выполнение следующих функций: - установление подлинности и определение полномочий субъекта при его допуске в систему, - контролирование установленных полномочий в процессе сеанса работы; - регистрация действий и др. Аутентификацией (установлением подлинности) называется проверка принадлежности субъекту доступа предъявленного им идентификатора и подтверждение его подлинности. Другими словами, аутентификация заключается в проверке: является ли субъект тем, за кого он себя выдает. Обычно методы аутентификации классифицируют по используемым средствам. В этом случае указанные методы делят на четыре группы [2]. 1. Основанные на знании лицом, имеющим право на доступ к ресурсам системы, некоторой секретной информации – пароля. 2. Основанные на использовании уникального предмета: жетона, электронной карточки и др. 25 3. Основанные на измерении биометрических параметров человека – физиологических или поведенческих атрибутах живого организма. 4. Основанные на информации, ассоциированной с пользователем. Рассмотрим наиболее подробно третью группу. Методы аутентификации, основанные на измерении биометрических параметров человека, обеспечивают почти 100 % идентификацию, решая проблемы утраты паролей и личных идентификаторов. Они делятся на две группы: статистические - на основе физиологических характеристик (системы идентификации пользователя по рисунку радужной оболочки или сетчатки глаза, отпечаткам пальцев и ладони, формам ушей и лица) и динамические на основе поведенческих характеристик (системы идентификации пользователя по почерку, походке, тембру голоса). Все системы биометрической аутентификации оцениваются по двум характеристикам: - отказ в доступе (ошибка первого рода – FRR, false rejection rate) – с какой вероятностью система не узнает зарегистрированного пользователя; - ложный доступ (ошибка второго рода – FAR, false access rate) – вероятность ошибочного допуска нелегального пользователям [1]. 2.1.1. Аутентификация по клавиатурному почерку Клавиатурный почерк - поведенческая биометрическая характеристика, которую описывают следующие параметры: - количество ошибок при наборе; - интервалы между нажатиями клавиш; - время удержания клавиш; - число перекрытий между клавишами; - степень аритмичности при наборе; 26 - скорость набора. Временные интервалы между нажатием клавиш на клавиатуре и время удержания (нажатия) охарактеризовать почерк клавиш позволяют работы достаточно пользователя на однозначно клавиатуре, что подтверждается рядом экспериментов [3]. При этом временные интервалы между нажатием клавиш характеризуют темп работы, а время удержания клавиш характеризует стиль работы с клавиатурой (резкий удар или плавное нажатие). Однако существует ряд ограничений на применение данного способа на практике. Применение способа идентификации по клавиатурному почерку целесообразно только по отношению к пользователям с достаточно длительным опытом работы с компьютером и сформировавшимся почерком работы на клавиатуре, т.е. программистам, секретарям-референтам, машинисткам и т.п. В противном случае вероятность неправильного опознавания «легального» пользователя существенно возрастает и делает непригодным данный способ идентификации на практике. Идентификация пользователя по клавиатурному почерку возможна по набору ключевой фразы и произвольного текста. Принципиальное отличие этих двух способов заключается в том, что в первом случае ключевая фраза задается пользователем в момент регистрации его в системе (пароль), а во втором случае используются ключевые фразы, генерируемые системой каждый раз в момент идентификации пользователя. Оба способа подразумевают два режима работы – обучение и идентификацию. На этапе обучения пользователь вводит некоторое число раз предлагаемые ему тестовые фразы. При этом рассчитываются и запоминаются эталонные характеристики данного пользователя. На этапе идентификации рассчитанные оценки сравниваются с эталонными, на основании чего делается вывод о совпадении или несовпадении параметров клавиатурного почерка. 27 На сегодняшний день наиболее известны две системы биометрической аутентификации: система “ID – 007”, разработанная американской фирмой “Enigma Logic” и система “Кобра”, разработчиком которой выступает Академия ФСБ России. Системы такого типа реализуют три основных функции: - сбор информации; - обработка информации (механизмы сравнений с эталонными значениями); - принятие решений по результатам аутентификации. Первая и третья функции в системах “ID – 007” и “Кобра” реализуются алгоритмически одинаково (различие составляют некоторые коэффициенты), а вот вторая функция — обработка информации или механизмы сравнений с эталонными значениями — принципиально отличаются. Сравнение вновь полученных значений времен удержаний клавиш с эталонными значениями в обеих системах производятся по аддитивной характеристике. Сравнение межсимвольных интервалов с эталонными значениями в системе “ID – 007” выполняется по принципу аддитивного соотношения, а в системе “Кобра” – по принципу мультипликативного соотношения. 2.2. Описание процесса сбора данных В рамках дипломного исследования было решено произвести анализ почерка по следующим критериям: - время удержания клавиш; - интервалы между нажатиями клавиш; - интервалы между отпусканием и нажатием следующих клавиш; - скорость набора. В качестве пароля было выбрано слово «rock-music». Буквы данного пароля рассредоточены по клавиатуре, а следовательно позволяют сильнее проявиться индивидуальным особенностям почерка. 28 В качестве тестовой группы были выбраны люди в возрасте от 20 до 25 лет, каждый из которых ежедневно работает на компьютере и имеет стабильный, сформировавшийся почерк. За время эксперимента каждый пользователь совершил по восемь подходов в привычной для него обстановке, на своей клавиатуре, что позволило снизить влияние внешних факторов на почерк и собрать более точные данные. Каждый из подходов состоял из пятидесяти попыток, т.о. в течение каждого подхода пользователь находился в разных психофизических состояниях: медлительность и неуверенность в первых попытках, стабильность в средние, усталость и сбивчивость ближе к концу подхода. Зачастую пользователи совершали более пятидесяти попыток, т.к. все ошибочные попытки не фиксировались. Т.о. при анализе данных можно будет выделить именно стабильные характеристики почерка, сохраняющиеся в любом состоянии. В результате было собрано достаточное количество данных (16000 записей), а изложенное выше позволяет считать их репрезентативными. 2.2.1. Описание программы Программа для сбора статистических данных, пригодных для анализа, была написана на языке Delphi, в среде Borland Delphi 7.0. Она представляет собой окно с полями для ввода: имени пользователя (или индивидуального номера), номера подхода (session) и пароля «rock-music», одинакового для всех, а так же, для удобства пользователя, отображается номер попытки (try) (см. рисунок 2.1). 29 Рисунок 2.1. Интерфейс программы. Пользователь вводит пароль, а программа фиксирует время нажатия (td) и отпускания (tu) клавиш, по средствам функции Time, фиксирующей текущее системное время, внутри стандартных процедур Delphi по работе с клавишами - KeyDown и KeyUp, а так же какая именно клавиша была нажата (переменная Key), для отслеживания и удаления неудачных попыток. В случае неверного ввода хотя бы одной буквы попытка не засчитывается, а на форме высвечивается надпись «Error!». Затем программа рассчитывает время удержания клавиш (Hold), время между нажатиями соседних клавиш (DownDown) и время между опусканием одной клавиши и нажатием следующей (UpDown) (2.1). Т.о. получается 31 столбец, содержащий информацию трех типов о времени ввода. H = |td1 - tu1|; DD = |td2 – td1|; (2.1) UD = |td2 - tu1|; По совершению пятидесятой попытки или по нажатию кнопки «ОК» данные записываются в файл формата .csv, т.о. для каждого подхода каждого пользователя формируется отдельный файл (рисунок 2.2). 30 Рисунок 2.2. Пример файла. 2.3. Подготовка собранных данных к анализу Полученные данные были собраны в один файл. Имена пользователей приведены к общему виду uXX. Все значения имеют числовой формат, следовательно, не требуется производить их кодирование или преобразование, а т.к. данные формировались программой автоматически, то исключены опечатки, пропущенные или ошибочные значения. Для дальнейшего исследования данные были разделены на две части: обучающую и тестирующую выборки, т.к. данных достаточно много, то деление было произведено как 2/3 и 1/3 [4]. К обучающей выборке было отнесено по тридцать пять первых записей из каждого подхода, оставшиеся пятнадцать ко второй. Т.о. размер обучающей выборки составил 11200 записей (по 280 на каждого пользователя), размер тестовой выборки, соответственно, 4800 записей. 31 2.4. Выводы по главе 2 В главе 2 рассмотрены способы аутентификации пользователя различными методами, основанными: на знании какой либо информации – пароля, на использовании уникального предмета (жетона, электронной карточки), на измерении биометрических параметров человека. Рассмотрены характеристики клавиатурного почерка и выбраны некоторые из них для проведения исследования: время удержания клавиш, интервалы между нажатиями клавиш, интервалы между отпусканием и нажатием следующих клавиш, скорость набора. Так же приведено обоснование выбора других параметров исследования. Описана программа, созданная для сбора данных и процесс подготовки данных для дальнейшего анализа. 32 3. РЕЗУЛЬТАТЫ АНАЛИЗА ДАННЫХ И ИНТЕРПРЕТАЦИЯ РЕЗУЛЬТАТОВ 3.1. Анализ с помощью алгоритма k-ближайших соседей (k-nearest neighbor algorithm, KNN). На первом этапе выбрано несколько вариантов числа k, для подбора лучшего экспериментальным путем: 50, 100, 150. Далее, случайным образом, выбиралась одна из записей тестовой выборки, и, в соответствии с алгоритмом приведенном в пункте 1.3.4, для нее находилось Евклидово расстояние по формуле 1.1 до всех записей обучающей выборки. Т.к. все атрибуты по смыслу делятся на три группы, Евклидово расстояние рассчитывается как отдельно для каждой группы, так и для всех атрибутов вместе. Затем выбирались k записей, для которых Евклидово расстояние до новой записи было минимальным, и проводилось взвешенное голосование по формуле 1.2, т.е. для каждого класса подсчитывается сумма обратных квадратов расстояний между записями этого класса и новой записью. Класс, для которого сумма получается наибольшей, присуждался новой записи. Вычисления проводятся в MS Excel с помощью макросов. Выявлено, что наиболее верно пользователь определялся по атрибутам, связанным с удержанием клавиш около, - 92% случаев. А вот существенной разницы между выбором k = 50 / 100 / 150 выявлено не было (рисунок 3.1). Т.о. выбор был сделан в пользу k = 50, т.к. увеличение k не ведет к улучшению результата, при этом требует большие затраты времени и ресурсов. На рисунке 3.1 представлен график результатов взвешенного голосования по атрибутам удержания клавиш. Как видно из графика, при обоих k максимальный результат у пользователя u09, что означает, что новая запись сделана именно им. 33 На рисунке 3.2, представлен график результатов взвешенного голосования на основе атрибутов, содержащих время между нажатием на соседние клавиши, где ближайшим соседом к новой записи, которая, как и в предыдущем примере, сделана пользователем u09, оказался пользователь u21. 20000 18000 количество голосов 16000 14000 12000 10000 k=150 8000 k=50 6000 4000 2000 u39 u37 u35 u33 u31 u29 u27 u25 u23 u21 u19 u17 u15 u13 u11 u09 u07 u05 u03 u01 0 классы (пользователи) Рисунок 3.1. График результатов взвешенного голосования по атрибутам удержания клавиш. 1400 количество голосов 1200 1000 800 600 400 200 u39 u37 u35 u33 u31 u29 u27 u25 u23 u21 u19 u17 u15 u13 u11 u09 u07 u05 u03 u01 0 классы (пользователи) Рисунок 3.2. График результатов взвешенного голосования по атрибутам, связанным со временем между нажатием на соседние клавиши. 34 3.2. Анализ методом 1-Правило на основе интервалов Для каждого класса (пользователя) и для каждого атрибута был определен интервал возможных значений и сформированы правила: «Если каждый атрибут записи принадлежит соответствующему интервалу, то данная запись сделана этим пользователю». По результатам применения правил были получены следующие результаты: в среднем в 13,5% случаев пользователи были неверно приняты за «своего» (рис 3.3), и в 9% «свои» были приняты за «чужих». При проведении предварительной обработки данных, а именно удалении значений имеющие значительное отклонение от среднего, результат работы алгоритма улучшился в среднем до 11%, в то время как количество верно определенных записей, относящихся к данному классу, не изменилось. 35% 30% 25% 20% 15% 10% 5% u39 u37 u35 u33 u31 u29 u27 u25 u23 u21 u19 u17 u15 u13 u11 u09 u07 u05 u03 u01 0% пользователи Рисунок 3.3. График результата работы правил: неверное определение пользователя как «своего» 35 3.3. Анализ методом 1-Правило на основе средних значений Для каждого класса (пользователя) и для каждого атрибута было определено среднее значение и сформированы правила: «Если Евклидово расстояние (1.1) от атрибутов новой записи до средних значений этих же атрибутов данного класса меньше расстояний до средних значений атрибутов других классов, то данная запись принадлежит этому классу». «Если расстояние по Хеммингу (3.1) от атрибутов новой записи до средних значений этих же атрибутов данного класса меньше расстояний до средних значений атрибутов других классов, то данная запись принадлежит этому классу». DH (xi , yi ) = ∑m i=1|xi − yi |, (3.1) где m – количество атрибутов, yi - значение атрибута известной записи, xi - значение атрибута новой записи. Здесь, как и в пункте 3.1, исследование проводилось не для каждого атрибута, а для трех групп, на которые все атрибуты делятся по смыслу, а так же для всех атрибутов сразу. По результатам применения правил были получены следующие результаты: наилучшие результаты были получены для группы атрибутов, связанной с удержание клавиш (рис. 3.4 и 3.5, темно-серый). Для не «очищенной» от аномальных значений выборки, а следовательно имеющей не совсем достоверные средние значения, точность верного определения класса составила при расчете Евклидового расстояния 73%, для расстояния по Хеммингу 75%. При использовании предварительно обработанных данных результаты применения правил почти одинаковые, около 76%. 36 100% 90% 80% 70% 60% 50% 40% 30% 20% 10% u39 u37 u35 u33 u31 u29 u27 u25 u23 u21 u19 u17 u15 u13 u11 u09 u07 u05 u03 u01 0% пользователи Рисунок 3.4. График результатов работы правил: Евклидово расстояние. На рисунке 3.4 темно-серым, показаны результаты расчета расстояний по атрибутам удержания клавиш, серым - по атрибутам, связанным со временем между нажатием на соседние клавиши. 100% 90% 80% 70% 60% 50% 40% 30% 20% 10% u39 u37 u35 u33 u31 u29 u27 u25 u23 u21 u19 u17 u15 u13 u11 u09 u07 u05 u03 u01 0% пользователи Рисунок 3.5. График результатов работы правил: Расстояние по Хеммингу. На рисунке 3.5 темно-серым, показаны результаты расчета расстояний по атрибутам удержания клавиш, серым - по атрибутам, связанным со временем между нажатием на соседние клавиши. 37 3.4. Сравнение построенных модели и интерпретация результатов Хуже всего определил пользователя по клавиатурному почерку алгоритм, основанный на средних значениях обучающей выборки. Лучший результат был получен при учете только атрибутов связанных с удержанием клавиш и предварительной очисткой обучающей выборки от записей, имеющих значительное отклонение – в среднем около 76% процентов случаев. В случае отсутствия такой очистки и применяя в качестве меры близости новой записи и среднего расстояние по Хеммингу, результат получился около 75%, что на 2% выше, чем при использовании Евклидового расстояния. Т.к. при расчете расстояния по Хеммингу, в отличие от Евклидового, разности не возводятся в квадрат и расстояние до среднего меньше. В целом данный результат подтверждает слабость методов на основе среднего значения. Более точные результаты показал алгоритм на основе интервалов допустимых значений. При анализе данным алгоритмом, в отличие от предыдущего, использовались все атрибуты. С точность 91% новая запись верно определялась как принадлежащая данному классу, и с ошибкой в 13,5% запись, определялась как принадлежащая данному классу, хотя не являлась таковой. В случае предварительной отчистки обучающей выборки от записей, имеющих значительное отклонение от среднего, получаются более узкие интервалы значений, и в них попадает меньшее количество записей, не принадлежащих данному классу (в среднем около 11%), в то время как количество верно определенных записей, относящихся к данному классу, не изменяется. Лучший результат показал алгоритм k-ближайших соседей, а именно 92% точности, при k = 50 и учете только атрибутов удержания клавиш. При этом данный алгоритм не требует предобработки данных по удалению 38 аномальных попыток, что позволяет анализировать им данные, в том виде, в котором они собраны. В ходе проведенного анализа данных несколькими методами можно сделать выводы, что наиболее стабильной характеристикой клавиатурного почерка является время удержания клавиши, т.к. наилучшие результаты работы всех алгоритмов были именно по ней. Это можно объяснить разным состоянием человека в разное время ввода пароля и даже в приделах одной попытки. Чем больше раз пользователь вводит пароль, тем быстрее у него это получается, и тем меньше время между нажатием на соседние клавиши. В случае усталости, например к концу подхода, наоборот - интервалы увеличиваются. Все это приводит к невысоким результатам анализа по данной характеристики. Таблица 4.1. Результаты анализа данных Алгоритм Результат применения алгоритма к тестирующей выборке 1-Правило на основе интервалов среднего значения обучающей выборки около 76% случаев 1-Правило на основе интервалов допустимых значений с точность 91% записи, определялись как принадлежащие данному классу, и с ошибкой в 11% записи, определялись как принадлежащие данному классу, хотя не являлись таковыми. k-ближайших соседей 92% точности, при k = 50. 3.5. Выводы по главе 3 В третьей главе описывается анализ данных тремя методами, с вариациями некоторых параметров: 39 1. Алгоритм k – ближайших соседей со значениями k = 50 и 150. 2. Алгоритм1-Правило на основе интервалов среднего значения обучающей выборки с вычислением расстояния между записями как Евклидово расстояние и как расстояние по Хеммингу. 3. Алгоритм 1-Правило на основе интервалов допустимых значений. Проводится сравнение и интерпретация результатов, описываются итоговые выводы. 40 ЗАКЛЮЧЕНИЕ В ходе работы над дипломным проектом решены все поставленные задачи. Рассмотрены вопросы, касающиеся анализа данных с применением методов Data Mining. Приведены различные классификации и обзор методов. Выбраны подходящие методы для дальнейшего анализа. Рассмотрены способы аутентификации пользователя различными методами. Обозначены характеристики клавиатурного почерка и выбраны некоторые из них для проведения исследования. Так же приведено обоснование выбора других параметров исследования. Описана программа, созданная для сбора данных и процесс подготовки данных для дальнейшего анализа. Описаны и применены методы анализа данных, произведено сравнение результатов и их интерпретация, сделаны итоговые выводы. 41 СПИСОК ЛИТЕРАТУРЫ 1. Ходашинский И.А., Технология усиленной аутентификации пользователей информационных процессов / Ходашинский И.А., Савчук М.В., Горбунов И.В., Мещеряков Р.В. – Доклады ТУСУРа, № 2 (24), часть 3, декабрь 2011 2. Гладких А.А., Дементьев В.Е., Базовые принципы информационной безопасности вычислительных сетей: учебное пособие для студентов – Ульяновск : УлГТУ, 2009. – 156 с. 3. Иванов А.И., Биометрическая идентификация личности по динамике подсознательных движений. – Пенза: Изд–во Пенз. гос. ун–та, 2000. – 188 с 4. Чубукова И. А., Курс лекций по Data Mining, 2006 5. Горелик А.Л., Скрипкин В.А., Методы распознавания,. – М.: Высшая школа, 1984. – 80 с. 6. Широчин В.П., Динамическая аутентификация на основе анализа клавиатурного почерка / Широчин В.П., Кулик А.В., Марченко В.В. // Вестник Национального технического университета Украины «Информатика, управление и вычислительная техника». – 1999. – № 32. – С. 3–16. 7. Grunau, Игнатьев И., Конспект лекций по курсу "Методы и средства анализа данных" 8. ГОСТ Р 50739–95. Средства вычислительной техники. Защита от несанкционированного доступа к информации. 9. ГОСТ Р 51241–98. Средства и системы контроля и управления доступом. Классификация. Общие технические требования. Методы испытаний. 10. Волков А.А. Конспект лекций по Системам искусственного интеллекта М.: МГСУ. 2009–72с. 42 11. Дюк В.А. Data Mining: учебный курс / Флегонтов А.В. – СПб.: Изд. Питер, 2001. – 368 с. 12. Интеллектуальные средства анализа, интерпретации и представления данных в информационных хранилищах, ComputerWeek–Москва. 1996. №16. С. 32–33 13. Воронцов К.В., Лекции по метрическим алгоритмам классификации, 2008 г 14. Баресягин А.А., Технологии анализа данных: Data Mining, Visual Mining, Text Mining, OLAP / Баресягин А.А., Куприянов М.С., Степаненко В.В., Холод И.И. – 2-е изд., перераб. и доп. – СПб.: БХВ – Петербург, 2007. – 384с. 15. Гмурман В.Е., Теория вероятностей и математическая статистика. 9–е изд., стер. – М.: Высшая школа, 2003. – 479 с. 16. Царьков С., Алгоритм ближайшего соседа. (Режим доступа: http://www.basegroup.ru/library/analysis/regression/knn/, дата обращения: 15.01.2014) 43