VMIO - Кафедра анализа данных и исследования операций

реклама

Казанский Государственный Университет

Кафедра экономической кибернетики

Миссаров М.Д.

Учебное пособие

«Вероятностные модели в исследовании операций»

2006г.

Предисловие

Основная часть материала, изложенного в этом пособии,

читается в рамках курса «Теория риска и моделирование

рисковых

ситуаций», предназначенного для

студентов

специальности «Математические методы в экономике». В

различных экономико-математических и финансовых теориях

слово риск употребляется в разных смыслах. Одно из основных

употреблений этого слова возникает в теории принятия решений

в условиях риска. Мы решаем такие задачи, когда нам

приходится оптимизировать или сравнивать между собой

экономические или технические системы, на функционирование

которых влияют внутренние и внешние случайные факторы.

Вероятностные модели исследования операций являются

основными поставщиками примеров таких систем. В моделях

финансовой математики слово риск имеет другой смысл и чаще

всего понимается просто как дисперсия или стандартное

отклонение доходности пакета каких-либо финансовых активов.

Такие модели также обсуждаются в курсе по теории риска, но им

будет посвящено другое пособие.

Основной критерий отбора материала состоял в том, чтобы он

был доступен всем студентам, прослушавшим элементарный

курс высшей математики и теории вероятностей для технических

и

экономических

специальностей.

Я

также

пытался

минимизировать

расстояние

между

математическими

определениями и содержательными примерами. Теория

вероятностей наряду с математическим анализом и линейной

алгеброй входит в «золотое ядро» математики и по праву

читается студентам самых разных специальностей. Но из-за

нехватки времени студенты не получают представления о

приложениях теории вероятностей в физике, или, например, в

исследовании операций. Поэтому это пособие будет полезно и

студентам-математикам в рамках курса « Дополнительные главы

теории вероятностей».

Математическую основу курса составляет теория марковских

цепей, изложенная в главе третьей. При этом я обсуждаю только

те аспекты теории, которые непосредственно используются в

элементарных моделях систем массового обслуживания или

марковской теории принятия решений. Например, вопросы

классификации марковских цепей не рассматриваются. Седьмая

глава посвящена вопросам статистического моделирования. В

ней, в частности, обсуждается актуальный в современной

прикладной математике метод моделирования сложных

распределений, использующий марковские цепи ( теория Monte

Carlo Markov Chain). Другим актуальным направлением в

современной науке является стохастическое программирование.

Простейшие примеры из этой темы приводятся в главе первой.

В заключение хочу сказать, что большую помощь в

подготовке этого текста мне оказала Миссарова Ф.Р., за что я

выражаю ей свою благодарность

1. Принятие решений в условиях неопределенности и в

условиях риска

Принятие решений в условиях неопределенности

Условно можно разделить задачи принятия решений в

исследовании операций на три группы: принятие решений в условиях

определенности, в условиях неопределенности и в условиях риска.

Первая группа задач является самой богатой, ей посвящено огромное

количество книг и мы не будем ее обсуждать. В простейшей форме эти

задачи представляются в следующем виде: есть некоторое множество,

имеется конкретная функция или функционал на этом множестве и

надо найти максимум или минимум этой функции. В частности, одним

из основных достижений математического анализа является то, что он

дал методы решения важного класса таких задач. Линейное и

нелинейное программирование, комбинаторика и целочисленная

оптимизация, оптимальное управление вот те разделы исследования

операций, в которых решаются различные задачи принятия решений в

условиях определенности. Задачи принятия решений в условиях

неопределенности образуют самый «бедный» класс задач и мы обсудим

их также целиком в этом разделе. Вся остальная часть пособия будет в

той или иной степени посвящена задачам принятия решений в условиях

риска.

В самой общей форме задача принятия решения в условиях

неопределенности ставится следующим образом. Задано некоторое

множество

{1 , 2 ,, n } состояний «природы» («среды»), а у

лица, принимающего решения (ЛПР), имеется некоторый набор

действий (решений) A {a1 ,, a m } . Кроме того, есть отображение

L : A R ,

L ( a, )

называемое функцией потерь (или выигрышей). Число

интерпретируется как потери (выигрыш) ЛПР в случае, когда он

принял решение a , а состояние «природы» оказалось равным .

Естественно, что ЛПР заранее не знает состояния «природы». В свою

очередь «природа» не настроена злонамеренно по отношению к ЛПР и

не интересуется тем, какое решение оно (ЛПР) приняло. Заметим, что

случай, когда вместо «природы» выступает разумный противник,

имеющий свом собственные интересы, обычно изучается в курсе

теории игр. Удобно записывать набор значений L(a, ), a A, A

в виде матрицы размера m n , которую называют матрицей потерь

(выигрышей). Задачей ЛПР является выбор «хорошего» решения.

Понятно, что в общем случае ситуация очень неопределенная и трудно

рассчитывать на то, что математика даст однозначные рекомендации.

Тем не менее есть несколько критериев, носящих имена знаменитых

математиков.

Рассмотрим следующий пример. У вас есть деньги, которые вы

можете вложить в строительство гостиницы в курортной местности:

a1 в пункте A ,

a 2 в пункте B ,

a 3 в пункте C .

Ходят слухи о том, что в пункте A могут построить экологически

вредное предприятие, а также о том, что в пункте C построят

горнолыжный курорт. Обозначим возможные состояния среды как

1 ничего не изменится,

2 в пункте A построят предприятие,

3 в пункте C построят горнолыжный курорт.

Матрица возможных доходов (в рублях) оценивается следующим

образом:

1

a1

a2

a3

3

2

300000

160000

70000

130000

480000

90000

-60000

70000

600000

1. Критерий Максимина. Этот критерий называют еще

критерием Вальда, а также критерием пессимиста.

ЛПР считает, что «природа» построена против него и при любых

его решениях она выбирает состояние, приносящее наименьший

доход. Поэтому процедура принятия решения по этому критерию

состоит из двух шагов:

Шаг 1. Для каждого действия найти состояние среды, приносящее

наименьший доход.

Шаг 2. Выбрать такое действие, при котором соответствующий

ему наименьший доход максимален.

Другими словами, мы должны найти

a opt arg max min L(a, ) .

a

Для нашего примера действию a1 соответствует наименьший доход

70000 (при состоянии 3 ), действию a 2 90000 (при состоянии

2 ), действию

a 3 (-600000)

(при состоянии

1 ). Значит,

максимальный критерий рекомендует выбрать решение a 2 .

Если L(a, ) является функцией потерь, то критерий называется

минимаксным. В этом случае надо найти

aopt arg min max L(a, ) .

a

2. Критерий оптимиста. По-видимому, этот критерий самый

глупый, поскольку не является именным. Оптимист считает, что

«природа» благоприятствует ему и поэтому в каждой строке матрицы

ищет наибольший доход, и выбирает решение

a opt arg max max L(a, ) .

a

В нашем примере это решение равно a 3 .

3. Критерий Лапласа. Человек, пользующийся этим критерием,

считает, что поскольку вероятности возможных состояний 1 ,, n

не известны, то все состояния равномерны и поэтому равновероятны.

1

, находим среднее значение

n

(математическое ожидание) дохода для каждого из решений a1 ,, a n .

Считая, что

p(1 ) p( n )

Выбирается то решение, для которого средний доход максимален:

1

aopt arg max L(a, ) .

a

n

В нашем примере критерий Лапласа дает ответ a 2 .

4. Критерий Сэвиджа. Предположим, что ЛПР стало известно,

каким будет состояние «природы». Тогда ЛПР может найти

максимально возможный доход, а также вычислить для каждого

решения недополученный доход. Возникает целая матрица

недополученных доходов

r (a, ) max L(b, ) L(a, ) ,

b

L ( a, )

которая называется матрицей сожаления. Если

матрицей потерь, то матрица сожаления определяется как

является

r (a, ) L(a, ) min L(b, )

b

и имеет смысл матрицы лишних потерь (лишних по сравнению с

наименьшими потерями). В любом случае матрица сожаления по

смыслу является матрицей потерь. Далее мы применяем к матрице

r ( a, ) минимаксный критерий Вальда. Оптимальное

сожаления

решение определяется как

aopt arg min max r (a, ) .

a

В нашем примере матрица сожаления выглядит так:

a1

a2

a3

1

2

3

0

320000

530 000

170000

0

360000

510000

410000

0

.

Оптимальное решение равно a 3 .

С точки зрения психологии критерий Сэвиджа кажется разумным.

Осознание недополученной выгоды или чувство зависти к соседу,

ничем от вас не отличающемуся, но угадавшему выигрышное решение,

может служить сильным раздражителем.

5. Критерий Гурвица. Пусть L(a, ) матрица выигрышей.

Если оптимист выбирает решение, максимизирующее (по

a)

max L(a, ) , а пессимист пытается максимизировать min L(a, ) ,

то критерий Гурвица предлагает максимизировать взвешенную сумму

этих величин:

max max L(a, ) (1 ) min L(a, ) .

Выбор

a

отражает субъективную склонность ЛПР к оптимизму,

0 1. Например, если

1

, то в примере с гостиницами этот

2

критерий дает решение a 2 .

Мы видим, что разные критерии дают разные ответы. Хотя

решение a1 не встретилось ни разу, легко построить матрицу

выигрышей, для которой критерии дают все три различные варианты

решений.

Принятие решений в условиях риска

При постановке задачи принятия решения в условиях

неопределенности заранее известно множество всех возможных

действий A , множество состояний «природы» («среды») и

функция выигрышей (потерь) L(a, ) . Если кроме этого имеется

информация о вероятностях всех состояний природы p( ), , то

говорят, что ставится задача принятия решений в условиях риска.

Основной критерий, которым пользуются при решении таких задач,

называется критерием среднего значения. В условиях риска функция

потерь может рассматриваться как случайная величина, зависящая от

параметра a . Поэтому естественно вычислить среднее значение (или

математическое ожидание) этой величины

f (a) M L(a, ) L(a, ) p( ) .

L ( a, )

Пусть для определенности

является функцией

выигрышей. Критерий среднего значения предлагает выбрать то

решение, при котором достигается максимальный средний выигрыш:

a opt arg max M L(a, ) .

a

Мотивировать разумность этого критерия можно, например,

следующим образом. Предположим, что в течении n дней мы

принимаем одно и то же решение a . Пусть i обозначает случайную

величину, задающую состояние среды в i -ый день и пусть для

простоты

являются случайными независимыми

i , i 1,, n

величинами. Тогда выигрыш за n дней будет записываться как

n

L ( a, ) .

i 1

i

По закону больших чисел

1 n

P L(a, i ) f (a) 0 .

n i 1

n

Другими словами, средний (по времени) доход за n дней с большой

вероятностью практически равняется f (a ) . Максимизируя функцию

f (a ) , мы тем самым максимизируем средний (по времени) доход за

большой период времени.

Мы будем понимать задачи принятия решения в условиях риска

несколько более широко – как задачи оптимизации или задачи

сравнительного анализа систем,

функционирование которых

подвержено влиянию случайных факторов. В последующих главах

будет рассмотрено много задач такого рода из теории управления

запасами и теории массового обслуживания.

Рассмотрим пример, не требующий предварительной подготовки.

Необходимо провести медицинское обследование большого количества

людей. Опасный вирус может быть обнаружен в крови с помощью

дорогостоящего анализа. Методика, предложенная Р.Дорфманом при

обследовании призывников в армию США во время второй мировой

войны, позволила сократить число анализов в 5 раз. Идея состоит в

том, что смешиваются пробы крови k человек и анализируется

полученная смесь. Если антител нет, то вся группа является здоровой.

Если антитела обнаруживаются, то необходимо провести еще k

анализов для того, чтобы найти зараженных.

Пусть количество обследуемых равно n , а вероятность того, что

человек болен, равна p . Пусть n делится нацело на k , число групп

n

. Обозначим через j число проверок в

k

j -ой группе. Величины j , j 1,, m являются независимыми и

обследуемых равно m

имеют распределение

P( j 1) (1 p) k

P( j k 1) 1 (1 p) k

(в группе нет больных)

(есть больные)

(1.1)

1 m . Надо найти значение k ,

минимизирующее среднее значение M . Из (1.1) следует

M j 1 (1 p) k (k 1) 1 (1 p) k ,

Общее число проверок

n

1

M1 n1 (1 p) k .

k

k

j 1

Несмотря на то, что k

является дискретной переменной,

M является

разумным приближением к задаче минимизации

m

M M j

минимизация функции

f ( x) 1

1

(1 p) x ,

x

x 0.

Точное нахождение минимума функции f (x ) затруднительно. Но

p

заметим, что при малых

справедливо приближение

(1 p) x 1 px :

1

1

1 px px .

x

x

1

Минимум функции g (x ) достигается при x0

, g ( x0 ) 2 p .

p

f ( x) g ( x) 1

В случае, которым занимался Р.Дорфман,

x0 10,

f ( x0 ) g ( x0 )

p 0,01 . При этом

1

. Значит, при k 10

5

n

M .

5

Обобщением критерия среднего значения является критерий

среднего значения – дисперсии. Пусть L(a, ) – функция выигрышей.

Кроме среднего значения f (a) M L(a, ) величина

характеризуется еще и дисперсией

L ( a, )

D L(a, ) M L(a, ) M L(a, ) .

2

Можно предположить, что существует большое количество ЛПР,

желающих максимизировать средний выигрыш M L(a, ) , но не

желающих, чтобы выигрыш сильно отклонялся от среднего значения

(большие отклонения могут привести к разорению). Отклонения

величины относительно среднего значения характеризуются

дисперсией или стандартным отклонением. Критерий среднего

значения – дисперсии предлагает максимизировать величину

f1 (a) M L(a, ) KD L(a, )

или

f 2 (a) M L(a, ) K D L(a, ) .

Здесь коэффициент K субъективен и характеризует склонность ЛПР к

риску. Большие значения K придают больший вес дисперсии, что

означает несклонность ЛПР к риску.

Учитывать дисперсию можно и в такой постановке:

Максимизировать

при

M L ( a, )

ограничении

D L(a, ) Const

или

минимизировать

D L(a, )

при

ограничении

M L(a, ) Const .

Известным примером задачи такого типа является задача

Марковитца об оптимальном портфеле.

Имеется n акций, доходности которых являются случайными

величинами ri со средними значениями Mri mi и матрицей

ковариаций V (vij ) ,

vij M (ri mi )( r j m j ),

i, j 1,, n .

Напомним, что доходность ценной бумаги за какой-то период

определяется как

C/ C

,

C

r

где C – цена бумаги в начале периода, C / – в конце. Вы должны

решить, какую долю своего капитала инвестировать в ту или иную

бумагу. Пусть x i – доля капитала, инвестированная в i -ую акцию.

Тогда легко видеть, что доходность вашего портфеля

n

rp xi ri ,

i 1

математическое ожидание доходности портфеля

n

Mr p xi mi ,

i 1

дисперсия доходности портфеля

Dr p

n

x v

i , j 1

i ij

xj .

Один из вариантов задачи Марковитца выглядит так

n

x

i 1

i

n

x m

i

i 1

n

x v

i , j 1

i ij

i

1,

mp ,

x j min ,

здесь m p – желаемое значение математического ожидания доходности

портфеля. В случае, когда xi R, i 1,, n , задача решается явно с

помощью

метода

множителей

Лагранжа.

Если

наложено

дополнительное условие xi 0, i 1,, n , она может быть решена

численно с помощью методов квадратичного программирования.

Стохастическое программирование

В последующих главах пособия будут изучаться различные

стохастические модели исследования операций. При анализе этих

моделей мы будем использовать в основном методы элементарной

теории вероятностей и математического анализа.

Но известно, что многие задачи исследования операций могут

быть сведены к задачам линейного программирования. Существует

целое направление в современной науке, называемое стохастическим

программированием, которое изучает вероятностные версии задач

математического программирования. Алгоритмы решения задач

стохастического программирования достаточно громоздки и часто

приводят к решению задач линейного программирования большой

размерности. Поэтому мы ограничимся лишь кратким обсуждением

простейших примеров.

Предположим, что задача линейного программирования имеет

вид:

n

max r j x j

(1.2)

Ax b ,

Cx d ,

x j 0, j 1,, n ,

(1.3)

(1.4)

(1.5)

j 1

при ограничениях

где векторы r (r1 ,, rn ) и

b (b1 ,, bm ) , а также матрица

A (aij ), i 1,, m, j 1,, n являются случайными, а матрица C

и вектор d – не случайными. Предположим, что закон распределения

всех случайных величин известен.

Если случайными величинами являются только коэффициенты

целевой функции r1 ,, rn , то критерий среднего значения предлагает

искать максимум линейной функции

n

n

M r j x j Mr j x j

j 1

j 1

при тех же неслучайных ограничениях (1.3) – (1.5).

Но в общем случае задача (1.2) – (1.5) существенно сложнее.

Простой рецепт, состоящий в том, чтобы заменить все случайные

коэффициенты на их средние значения, может привести к

противоречию. Например, решение такой «усредненной» задачи может

не удовлетворять ограничениям ни при каком наборе значений

коэффициентов a ij , bi .

Один из возможных подходов к постановке задач стохастического

программирования состоит в том, чтобы условия (1.2) – (1.5) заменить

на условия

n

max x j Mr j

(1.6)

j 1

при ограничениях

n

P aij x j bi i , i 1,, m ,

j 1

Cx d ,

x j 0, j 1,, n ,

(1.7)

(1.8)

(1.9)

где 1 ,, m – заданные вероятности. Другой вариант – вместо

выполнения m условий (1.7) потребовать выполнение одного

условия

0 1.

n

P aij x j bi , i 1,, m ,

j 1

Рассмотрим следующий пример. Фирма владеет R единицами

некоторого сырья, из которого можно изготовить два вида продукции.

Спрос на 1-ый вид обозначим D1 , на 2-ой– D2 , D1 и D2 являются

случайными величинами с известными законами распределений. Из

одной единицы сырья можно получить a1 единиц продукции 1-го

вида и a 2 единиц продукции 2-го вида. Руководство фирмы хочет

максимизировать прибыль, но при условии, что вероятности сбыта

продукции были больше заданных вероятностей 1 и 2 . Задача с

вероятностными ограничениями имеет вид:

(1.10)

max (c1 x1 c2 x2 )

при ограничениях

(1.11)

Pa1 x1 D1 1 ,

Pa1 x2 D2 2 ,

x1 x2 R ,

x1 0, x2 0 .

(1.12)

(1.13)

(1.14)

Здесь c1 и c2 – цена продукции 1-го и 2-го вида соответственно. Пусть

D1 и D2 имеют нормальное распределение,

D2 ~ N (m2 , 22 ) . Тогда

Пусть

D1 ~ N (m1 , 12 ) ,

D m1 a1 x1 m1

1 .

(1.15)

PD1 a1 x1 P 1

1

1

u11 – (1 1 ) - квантиль стандартного гауссовского

распределения:

1

2

u11

x2

exp dx 1 1 .

2

Тогда условие (1.15) означает, что

a1 x1 m1

1

u11

или

m1 1

u11 .

a1 a1

Аналогичное условие возникает на x 2 :

m

x2 2 2 u1 2 .

a2 a2

x1

(1.16)

(1.17)

Возникает простая задача линейного программирования, задаваемая

условиям (1.10), (1.13), (1.14), (1.16), (1.17).

В случае, когда коэффициенты матрицы A также являются

случайными величинами с многомерным нормальным распределением,

вероятностные ограничения вида (1.17) приводят к квадратичным

неравенствам. Рассмотренный выше пример модели с вероятностными

ограничениями относится к классу так называемых одноэтапных

стохастических моделей. В одноэтапных задачах мы принимаем

решения за один этап, исходя из критерия среднего значения и

информации о распределениях вероятностей случайных параметров,

входящих в условия задач.

Существует

другой

класс

моделей

стохастического

программирования, называемых двухэтапными моделями. Рассмотрим

конкретный пример такой постановки.

Имеются посевные площади размером в S га и мы выращиваем

на них две посевные культуры, например, зерно и картофель. Для

внутренних потребностей хозяйства (корм для скота и прочее) нам

нужно m1 тонн зерна и m2 тонн картофеля. Если зерна не хватает, то

мы должны купить его на стороне по цене b1 рублей за тонну, а если

образуются излишки, то сможем продать по цене c1 . Для картофеля

соответствующие цены равны b2

и

c2 . Затраты на выращивание

зерна равны a1 рублей на гектар, затраты по выращиванию картофеля

– a 2 рублей на гектар. Урожайность этих культур зависит от

климатических условий. Статистические данные за прошлые годы и

консультации у специалистов дают нам следующую информацию:

будущий сезон будет нормальным с вероятностью p1 , плохим – с

вероятностью

p 2 и хорошим – с вероятностью

p3 .

урожайность по зерну при нормальных условиях равна

гектара, при плохих – r21 ,

Пусть

r11 тонн с

при хороших – r31 тонн с гектара.

Аналогичные величины для картофеля обозначим через r12 , r22 , r32 .

Введем переменные:

– площади, отведенные под зерно и картофель

x1 и x 2

соответственно,

yi1 и y i 2 – количество зерна или картофеля, которое придется

закупить в случае нехватки в сезоне, находящемся в состоянии

i, i 1,2,3 ,

z i1 и z i 2 – излишки зерна и картофеля, которые можно будет

продать в сезоне, находящемся в состоянии i, i 1,2,3 .

Поставим

программирования:

задачу

двухэтапного

max a1 x1 a2 x2

p1 b1 y11 c1 z11 b2 y12 c2 z12

p2 b1 y21 c1 z 21 b2 y22 c2 z 22

p3 b1 y31 c1 z 31 b2 y32 c2 z 32

стохастического

(1.18)

при ограничениях

x1 x2 S ,

r11 x1 y11 z11 m1 ,

r21 x1 y21 z 21 m1 ,

r31 x1 y31 z 31 m1 ,

(1.19)

(1.20)

(1.21)

(1.22)

r12 x2 y12 z12 m2 ,

r22 x2 y22 z 22 m2 ,

r32 x2 y32 z 32 m2 ,

x1 , y11 , z11 , y 21 , z 21 , y31 , z 31 , x2 , y 21 , z 21 , y 22 , z 22 , y32 , z32 0 .

(1.23)

(1.24)

(1.25)

(1.26)

В такой постановке имеются три возможных «сценария» –

нормальный, плохой и хороший. Есть переменные, общие для всех трех

сценариев – x1 и x 2 . С каждым сценарием связаны свои переменные,

которые играют роль компенсирующих переменных. Решения

принимаются в два этапа. На первом этапе решается вопрос о том,

какие площади x1 и x 2 отдать под зерно и картофель. Например, x1

и x 2 находятся из решения задачи линейного программирования

(1.18) – (1.26). После того, как сезон подойдет к концу, можно будет

понять, надо ли закупать зерно или картофель или наоборот, останутся

излишки. Пусть, например, сезон оказался хорошим. В этом случае

надо будет решить задачу:

max b1 y31 c1 z 31 b2 y32 c2 z 32

(1.27)

при ограничениях

(1.28)

r31 x1 y31 z 31 m1 ,

r32 x2 y32 z32 m2 ,

(1.29)

y31 , z 31 , y32 , z32 0

(1.30)

(здесь x1 и x 2 уже известны).

Таким образом, на втором этапе можно будет обнаружить

«невязки» и компенсировать их с помощью набора переменных

y31 , z 31 , y32 , z 32 . Конечно, выбор переменных 1-го этапа x1 и x 2

должен быть таков, что задача 2-го этапа (1.27) – (1.30) имела

решение.

Переменные предварительного плана x1 и x 2 можно находить

также исходя из «усредненного» сценария. Вычислим средние

урожайности по зерну и картофелю:

r1 p1r11 p2 r21 p3 r31 ,

r2 p1r12 p2 r22 p3 r32

и решим задачу ЛП для этих средних значений:

max a1 x1 a2 x2 b1 y1 c1 z1 b2 y2 c2 z 2

при ограничениях

(1.31)

r1 x1 y1 z1 m1 ,

r2 x2 y2 z 2 m2 ,

x1 , x2 , y1 , y2 , z1 , z 2 0 .

(1.32)

(1.33)

(1.34)

Далее ждем окончания сезона. Если он оказался, например, хорошим,

решаем задачу (1.27) – (1.30), используя вместо переменных x1 и x 2

значения, полученные при решении «усредненной» задачи (1.31)–

(1.34).

Очевидным недостатком двухэтапных моделей является резкий

рост размерности задачи при увеличении количества сценариев.

Задачи

1.. Придумайте пример матрицы потерь, для которой критерии

Вальда, Лапласа и Сэвиджа дают разные ответы.

2. Устройство состоит из n блоков, надежность каждого из

них равна p . Выход из строя одного блока выводит из строя все

устройство. Для повышения надежности системы решено провести

дублирование с помощью дополнительных n блоков. Какой способ

дублирования дает большую надежность: а) дублирование каждого

блока; б) дублирование всей системы?

а)

б)

3.

Рассмотрите пример простой задачи линейного

программирования со случайными коэффициентами. Найдите решение

«усредненной» задачи ЛП, в которой все коэффициенты заменены на

их средние значения. Постройте пример задачи, в которой решение

«усредненной» задачи не удовлетворяет условиям ни при каком наборе

значений случайных коэффициентов.

4.

Фирма изготавливает продукцию двух видов, цены на

которые образуют случайный гауссовский вектор (1 , 2 ) со средними

значениями M1 100 рублей,, M 2 120 рублей и матрицей

ковариаций

64

36

36

81

Затраты на производство продукции 1-го и 2-го вида равны 40 и 50

рублей соответственно. При каких минимальных затратах на

производство доход продажи продукции превысит 100000 рублей.

5. Рассмотрите конкретный числовой пример для задачи о

зерне и картофеле (двухэтапная стохастическая модель). Просчитайте

модель (1.18) – (1.26) и (1.31) – (1.346). Сравните полученные

результаты при различных сценариях.

6.

Прогноз спроса на некоторый товар следующий: с

вероятностью 0,6 он будет равен 1000 ед., с вероятностью 0,4 – 1500

единиц. Фирма может сама производить этот продукт по цене 3000

рублей за штуку или импортировать по цене 5000 рублей за штуку.

Фирма обязана удовлетворить спрос, но стремится минимизировать

издержки.

Постройте

двухэтапную

модель

стохастического

программирования для этой задачи и решите ее.

2. Вероятностные модели управления запасами

2.1. Одноэтапная модель управления запасами

Рассмотрим классическую задачу управлениями запасами,

которую называют еще задачей о торговце газетами, или задачей о

рождественской елке. Пусть есть товар, который можно продать только

в течении какого-то периода времени. К концу этого периода товар

либо испортится, либо станет никому не нужным (вчерашние газеты,

елки после Нового года).

Спрос на товар D является случайной величиной с известным

законом распределения. Заказывать товар можно только к началу

периода (сезона). Обозначим через c0 потери, которые мы понесем от

одной единицы нереализованного товара. Пусть c1 обозначает потери,

которые мы понесем при отсутствии одной единицы товара в случае,

когда спрос превысит предложение. Обозначим через q количество

товара, которое мы запасли перед началом периода. Тогда функция

потерь (или издержек) примет вид:

c0 (q D),

c( D, q)

c1 ( D q),

при D q

при D q

(2.1)

В терминах первой главы q обозначает наше действие, D –

состояние среды.

Рассмотрим сначала случай, когда товар штучный. Спрос D

является дискретной случайной величиной,

q – целочисленная

переменная. Критерий среднего значения ставит задачу минимизации

функции.

f (q) Mc ( D, q)

q

i 0

i q 1

c0 (q i ) pi c1 (i q) pi ,

где pi P( D i) .

Предположим, что функция

точке

как

f (q ) достигает минимума в одной

q q0 . Условие на минимум в дискретном случае запишется

f (q0 1) f (q0 ), f (q0 1) f (q0 ) .

Рассмотрим разности h(q ) f (q 1) f (q) :

(2.2)

q 1

h(q) c0 (q 1 i) pi c1 (i q 1) pi

i q

i 0

q

q

1

c0 (q i) pi c1 (i q) pi c0 pi c1 pi .

i q 1

i 0

i q

i 0

Поскольку

q 1

i q

i 0

pi 1 pi

и

q 1

p

i 0

i

P( D q 1) F (q 1) ,

то

h(q) c1 (c0 c1 ) F (q 1) ,

где F (q) P( D q) – функция распределения случайной величины

D . Тогда условия (2.2) запишутся как

c1

(2.3)

F (q0 1)

F (q0 ) .

c0 c1

Мы получим не вполне очевидный ответ для такой простой

задачи.

Рассмотрим теперь случай непрерывного случайного спроса D с

p (x ) . Среднее значение функции издержек

плотностью

(2.1)

запишется как

q

0

q

f (q) Mc ( D, q) c0 (q x) p( x) dx c0 ( x q) p( x) dx .

Тогда

q

df

c0 (q q) p(q) p( x) dx c1 (q q) f (q) p( x) dx

dq

0

q

c0 P( D q) c1 P( D q) F (q)(c0 c1 ) c1 .

Приравнивая эту производную к 0, получаем, что оптимальный

запас находится из уравнения

F (q)

c1

.

c0 c1

(2.4)

В силу монотонности и непрерывности функции F (q) ясно, что

уравнение (2.4) имеет решение. Тот факт, что это решение дает

минимум функции издержек, следует из того, что

d 2 f (q)

p(q)(c0 c1 ) 0 .

dq 2

Пример. Посредническая фирма скупает у дирекции спортивного

комплекса билеты для проведения концерта по цене 500 руб. за штуку

и собирается продавать их по цене 800 руб. Статистика показывает, что

спрос на билеты имеет нормальное распределение с математическим

ожиданием 4000 и стандартным отклонением 300. Сколько билетов

стоит выкупить этой фирме?

Цена покупки c0 500 рублей. В случае, когда спрос превысит

предложение, недополученная прибыль от одного билета равна

c1 800 руб.-500 руб.=300 руб. Мы должны решить уравнение

F (q)

c1

,

c0 c1

где

Dm qm

qm

F ( q ) P ( D q ) P

,

где m 4000, 300, ( x) – функция распределения стандартного

нормального распределения N (0,1) .

Так как

c1

300

0,375

c0 c1 500 300

квантиль нормального распределения u 0,375 0,32 , то

q m u 0,375 3904 .

Заметим, что нормально распределенная величина может принимать и

отрицательные значения, но в нашем случае это не приводит к

противоречиям, поскольку вероятность такого события очень мала.

Константу c0 можно интерпретировать как издержки, связанные

с хранением единицы нереализованной продукции. Издержки,

связанные с дефицитом товара, очень трудно оценить. В предыдущем

примере эти издержки интерпретировались как недополученная

прибыль. Когда речь идет о системе управления запасами на

производстве, дефицит запчастей может привести к простою и

соответствующим убыткам или к штрафным санкциям со стороны

заказчиков.

В том случае, когда оценка издержек дефицита затруднительна,

иногда запас q определяют исходя из требования, чтобы вероятность

возникновения дефицита не превышала заданной вероятности p :

p( x) dx p .

q

Одноэтапная модель с учетом затрат на оформление заказа

Рассмотрим обобщение модели, приведенной в предыдущем

параграфе. Пусть D – случайный спрос с плотностью p ( x ), q –

планируемый уровень запасов,

q 0 – начальный уровень запасов,

c0 (c1 ) – удельные издержки, связанные с хранением (нехваткой) одной

единицы продукции. Кроме того, предположим, что затраты на закупку

дополнительной продукции имеют вид

c 2 c3 ( q q 0 ) ,

где c2 – цена подачи (или оформления) заказа, c3 – стоимость одной

единицы продукции. Тогда полная функция издержек имеет вид:

c2 c3 (q q0 ) c0 (q D), при D q

C / ( D, q)

c2 c3 (q q0 ) c1 ( D q), при D q

Обозначим математическое ожидание издержек как

f1 (q) MC / ( D, q) .

f 1 (q)

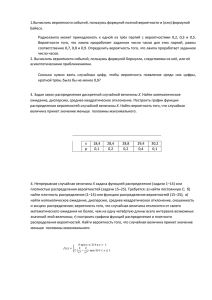

f 0 (q)

s

Рис. 2.1

S

q

Легко видеть, что

f 1 (q) c 2 f 0 (q) ,

где

f 0 ( q ) c3 ( q q 0 ) f ( q ) ,

q

0

q

f (q) c0 (q x) p( x) dx c1 ( x q) p( x) dx .

Используя результаты предыдущего параграфа, получаем

df 0 (q)

df

c3

c3 F (q)(c0 c1 ) c1 ,

dq

dq

где F (q) P( D q) – функция распределения спроса D .

Значит, минимум функции

f 0 (q) достигается в точке

q,

удовлетворяющей уравнению

F (q)

c1 c3

.

c0 c1

(2.5)

Обозначим решение уравнения (2.5) через S . Поскольку функция

f1 (q) отличается от функции f 0 (q) на константу, то минимум f1 (q)

достигается в той же точке S .

Из уравнения (2.5) следует, что функции f 0 (q) и f1 (q) слева

от точки S убывают, а справа от нее – возрастают. Поэтому в

типичной ситуации (см. Рис. 2.1) существует точка s S такая, что

f 0 ( s) f1 ( S ) .

Заметим, что если

q s , то

f 0 (q) f1 ( S ) , а если s q S , то

f 0 (q) f1 ( S ) . Поэтому, если начальный запас q0 s , то средние

издержки без подачи заказа равны f 0 (q0 ) , и т.к. f 0 (q0 ) f1 ( S ) , то

имеет смысл заказать партию товара размера

S q 0 . В этом случае

издержки будут все равно меньше (они равны

f1 (S ) ).

Если же

S q0 s , то и

f 0 (q) f1 (S ) min f1 (q) ,

q

и подавать заказ не выгодно. Ясно, что если

дополнительный заказ также не выгодно.

q0 S , то делать

Стратегию такого вида называют еще ( s S ) – стратегией.

Многоэтапная модель управления запасами

Рассмотрим теперь тот случай, когда товар не портится и может

продаваться в течение нескольких сезонов. Предположим, что спрос на

товар случаен. Кроме того, если торговая фирма заказывает

дополнительную партию товара у поставщика, то время исполнения

заказа тоже может быть случайным. Общепринятая практика состоит в

том, что фирма заказывает партию товара размера q , если уровень

r . За время

запасов на складе упал до критической отметки

выполнения заказа L какое-то случайное количество товара будет

куплено.

p (x )

Обозначим

через

функцию

плотности,

аппроксимирующую плотность случайной величины спроса в течение

времени исполнения заказа:

x

P( D x) p( y) dy F ( x) ,

(2.6)

0

F (x) обозначает функцию распределения спроса D в течение

времени исполнения заказа.

Сразу после прибытия заказанной партии объема q уровень

запасов равняется q r D , в то время как уровень запасов в конце

времени ожидания равняется r D . Расходы на содержание запасов

производятся лишь в том случае, когда запасы неотрицательны.

Математические ожидания запасов в начале и конце периода поставки

пополнения равны соответственно

r

r

(r x) p( x) dx

и

0

(r x) p( x) dx q .

0

Поэтому затраты на содержание запасов пропорциональны среднему

арифметическому этих двух величин:

r

r

1

c0 q (r x) p( x) dx (r x) p( x) dx

0

0

2

r

q

c0 c0 (r x) p( x) dx .

2

0

(2.7)

Хотя спрос имеет случайный характер, мы по-прежнему предположим,

что среднее число заказов в течение года равно M q , т.е. такое же,

как и в детерминированной модели. Поэтому годовая стоимость подачи

заказов равна c2 M q . Наконец, издержки, связанные с дефицитом,

возникают всякий раз, когда D r . Ожидаемые потери от дефицита в

течение периода L равны

c1 ( x r ) p ( x) dx ,

(2.8)

r

а соответствующие годовые потери равны

M

c1 ( x r ) p ( x) dx .

q r

(2.9)

Таким образом, годовые издержки всей системы управления запасами,

которые мы обозначим через c(q, r ) , равны

c ( q, r )

r

c0

q

M

M

c0 (r x) p( x) dx c2

c1

( x r ) p( x) dx . (2.10)

2

q

q

0

r

При выводе этой функции мы фактически не вели учета

неудовлетворенных требований. В случае, когда издержки дефицита

велики, различие между моделями с учетом и без учета

неудовлетворенных требований будут незначительны, поскольку

системы будут стремиться к тому, чтобы сделать случаи дефицита

более редкими.

Для того, чтобы найти оптимальные значения q и r , надо найти

точку стационарности функции c(q, r ) . Получаются два уравнения:

c ( q, r )

1

M

M

c0 c 2 2 c1 2 ( x r ) p ( x)dx 0 ,

q

2

q

q r

r

(2.11)

c ( q, r )

M

c0 p( x) dx c1

( p( x) )dx

r

q1 r

0

c1

M

M

c1 c1 F (r ) 0,

q

q

(2.12)

r

где

F (r ) p( x) dx .

0

итерациями.

Эту систему уравнений можно решить

Предположим, что в выражении для

интегральные члены. Тогда оптимальное q

формулой Уилсона:

q1

опущены

c ( q, r )

задается известной

2Mc 2

.

c0

Подставляя q1 в (2.12), получаем, что оптимальное r1 (в первом

приближении) находится из уравнения

F (r1 )

Mc1

.

Mc1 q1c0

Подставляя r1 в (2.11) и решая относительно

q , получаем 2-ую

итерацию q 2 . Подставляя q 2 в (2.12) и решая относительно r ,

получаем вторую итерацию r2 и т.д. Через некоторое число шагов

итерации (q, r ) практически перестанут изменяться и это будет

означать, что мы нашли оптимальные значения (q, r ) . Конечно,

решение уравнений

(2.11)(2.12)

в общем случае потребует

применения численных методов, но даже первая итерация может

служить разумным выбором параметров (q, r ) .

Управление запасами с учетом издержек на производство

В этом параграфе мы рассмотрим модель, в которой наряду с

издержками, связанными с запасами, учитываются затраты на

производство самой продукции.

Некоторая фабрика производит определенный вид продукции,

для хранения которой имеет свой собственный склад. Продукция

может предназначаться как для внешних потребителей, так и для самой

фабрики. Обозначим через X n спрос на эту продукцию, возникший в

течение n периода (дня, недели и т.д.). Если в начале года уровень

запасов на складе равнялся B , то после первого периода (при

отсутствии пополнения) он упадет до уровня B X 1 , после второго –

до

и т.д. Может оказаться так, что запасы

B X1 X 2

исчерпываются и в этом случае будем учитывать неудовлетворенные

требования, т.е. фактически введем понятие отрицательных запасов.

Предположим, что уровень производства данной продукции на

период n должен быть установлен до того, как становится известным

спрос на этот период. Обозначим через Pn количество единиц

продукции, произведенной в

n -ый период. Естественно, что

отклонения Pn от X n могут быть значительны, и это повлияет на

политику управления запасами.

Рассмотрим следующую стратегию: уровень производства в n ый период всегда равняется спросу в (n 1) -й период.

Pn1 X n ,

n 1,2, .

Если в течение первой недели произведено X 0 единиц товара, то

легко видеть, что уровень запасов в конце n периода равняется

B X 0 X n , n 1,2,. Трудности, связанные с реализацией такой

стратегии очевидны. Производство должно очень гибко реагировать на

флуктуации спроса, что влечет за собой больше издержки. Возникают

проблемы с занятостью рабочих в периоды низкого спроса, со

сверхурочными работами и т.д.

Альтернативная, вторая стратегия, заключается в следующем:

уровень производства в

n период равняется математическому

ожиданию спроса в (n 1) период.

Pn1 M X n ,

n 1,2, .

Если все случайные величины X n имеют одно и то же среднее m ,

Pn1 m,

n 1,2, .

В этом случае производство всегда остается на одном и том же уровне,

поэтому трудностей, типичных для предыдущей стратегии, здесь нет.

Но при этом возникнут трудности, связанные с большими

флуктуациями остатков относительно 0 . В самом деле, если все X m

имеют одну и ту же дисперсию 2 , то остатки продукции I n

(положительные в случае избытка и отрицательные в случае дефицита)

в конце n -го периода имеют дисперсию.

n

D( I n ) D ( xi m) n 2 ,

i 1

n 1,2, .

При n »1 дисперсия может стать как угодно большой. Заметим, что в

первой стратегии

D( I n ) 2 , n 1,2, .

Поэтому во второй стратегии могут возникнуть большие издержки,

связанные с хранением запасов и дефицитом.

Можно предположить еще одну политику управления запасами,

которая в некотором смысле будет компромиссом между двумя

первыми. Эту стратегию естественно называть стратегией

экспоненциального сглаживания.

Пусть

Pn1 X n (1 ) Pn ,

где называется константой сглаживания, 0 1. При 0

мы получаем 2-ой случай, при 1 – первый. Параметры , B

являются варьируемыми переменными:

Справедливы следующие рекуррентные соотношения:

I n I n1 X n Pn , n 2,3, ,

Pn X n1 (1 ) Pn1 ,

Отсюда

n 2,3, .

Pn X n 1 (1 ) X n 2 (1 ) n 2 X 1 (1 ) n 1 P1 ,

I n B X n (1 ) X n 1 (1 ) X n 2

2

1 (1 ) n

(1 ) n1 X 1 P1

.

Видно, что при 0 1 Pn является взвешенным средним от

значений спроса в течение всего прошедшего времени, причем вес

слагаемого

задается выражением

т.е.

X nk

(1 ) k 1 ,

экспоненциально убывает с ростом k . Как и в первой стратегии,

уровень производства Pn реагирует на колебания спроса, но в отличие

от 1-го примера эта реакция носит более сглаженный характер.

Изучим

стратегию

экспоненциального

сглаживания

в

предположении, что случайные величины X n не зависят друг от

друга и имеют нормальное распределение со средним

m и

2

дисперсией .

Тогда, как легко видеть, I n являются нормальными случайными

величинами, при этом

M I n B (m P1 )

1 (1 ) n

1 (1 ) 2 n

D( I n ) 2

.

(2 )

,

В пределе n средние и дисперсии случайных величин

будут сходиться к значениям:

M ( I n ) mI B

m P1

n

D( I n ) I2

n

2

(2 )

,

.

Случайные величины Pn также нормально распределены. При этом

M Pn m (m P1 )(1 ) n 1 ,

M Pn m p m ,

n

1 (1 ) 2 n2

DPn 2

.

2

2

.

DPn p2

n

2

Введем меру, оценивающую изменения уровня производства:

K n M Pn Pn1 .

Если P1 m , то M ( Pn Pn1 ) 0 , и поэтому

K n DPn Pn1 DX n (1 ) Pn1 Pn1

2

2 DX n 2 DPn 1 2

2 2

.

2

Отсюда видно, что если 0 , то I2 , и поэтому вероятность

возникновения неудовлетворенных требований увеличивается. Но при

этом колебания уровня производства становятся незначительными.

Пусть, как обычно, величина c0 характеризует удельные

издержки по содержанию запасов, c1 характеризует издержки,

связанные с наличием неудовлетворенных требований. В общие

издержки необходимо включить затраты, связанные с колебаниями

уровня производства K – соответствующий коэффициент обозначим

через ck . Тогда мы можем написать

c( B, ) c0 B c1

1 zm

I

exp

2

2 I

I

1

0

2

dz ck K .

Здесь предполагаем, что P1 m , и поэтому средний уровень запасов

mI B . Учтено также то обстоятельство, что в пределе n I n

имеет нормальное распределение с параметрами mI , I .

При оптимизации

зафиксируем предварительно

c ( B, )

параметр

, и продифференцируем по B :

1 B

c1

c

c0

exp

B

2 I

2 I

2

.

Отсюда следует, что если

c0

c1

1

2 I

,

то Bopt 0 , в противном случае

Подставим Bopt

c1

Bopt I 2 ln

2 c

0 I

в c ( B, ) , получим

Bopt I

c( Bopt , ) c0 Bopt c1

.

1

exp z 2 dz c k K .

2

2

1

Минимизация по может быть проведена численными методами.

Отметим, что более точно издержки по содержанию запасов

учитываются следующим образом: вместо cc B надо подставить

величину

1 zm

I

c0 z

exp

2 I

2 I

0

Но в этом случае минимум по ( B, )

1

2

dz .

с самого начала надо

искать численными методами.

Задачи

1. Пусть себестоимость производства одной единицы продукта

равна c1 руб., розничная цена одной единицы продукта в сезон равна

c2 руб. По окончании сезона остатки продукции могут быть

распроданы по сниженной цене c3 руб. за единицу. Спрос на продукт

в течение сезона имеет функцию распределения F (x ) . Постройте

функцию издержек и вычислите оптимальный уровень запасов, исходя

из критерия среднего значения.

2. Цена батона в универсаме равна 10 руб. при закупочной цене

7 руб. за один батон. Спрос на батон имеет показательное

распределение со средним значением m1 10000 единиц в день.

Менеджер, отвечающий за торговлю хлебом, исходит из ошибочного

предположения, что спрос имеет показательное распределение со

средним значением m2 9000 единиц. Каковы будут средние потери

в прибыли, если менеджер при расчете запасов исходит из критерия

оптимизации средней прибыли?

3. Запас некоторого химического вещества на складе равен 100

кг. Стоимость хранения одного кг вещества в течение месяца равняется

c0 10 руб. Потери от нехватки 1 кг сырья равны c1 100 руб.

Стоимость подачи заказа равняется 200 руб., а стоимость закупки 1 кг

этого сырья равна 50 руб. Количество вещества в килограммах,

используемого в течение месяца, равномерно распределено в интервале

[200,600] . Какое количество сырья нужно закупить?

4. Фирма продает в течение года в среднем 5000 упаковок

стирального порошка. Спрос на этот товар в течение года имеет

равномерное распределение в интервале [4000,6000] . Цена подачи

заказа равна 3000 руб., закупочная цена одной упаковки равна 150 руб.,

стоимость хранения одной упаковки в течение года составляет 20% от

цены. Время исполнения заказа равно 2 неделям. Менеджеры фирмы

считают, что один случай дефицита обходится фирме в 250 руб.

(потеря хорошего отношения клиента к фирме и затем потеря самого

клиента). Каковы оптимальные значения размера заказа q и точки

подачи заказа r ? Какова вероятность возникновения дефицита?

3. Марковские цепи

3.1. Марковские цепи. Уравнение Колмогорова-Чэпмена

Поведение многих систем в естественных науках, а также в

экономике и исследовании операций можно описывать в рамках

следующей модели. Пусть множество всех возможных состояний

системы S является конечным или счетным. Для удобства будем

нумеровать эти состояния целыми числами. В зависимости от задачи

будем считать, что

S {0,1, , n} , или S N {1,2,} , или

S Z {,2,1,0,1,2,3} .

Обозначим состояние системы в момент времени t через (t ) и

будем считать, что (t ) является случайной величиной, принимающей

значения в множестве S . Простейшее возможное поведение системы

состоит в том, что случайные величины (t1 ), (t 2 ), , (t n ) при

различных наборах моментов времени t1 t 2 t n независимы

между собой. То есть состояние системы в любой момент времени t не

зависит от того, в каких состояниях находилась система прежде.

Более сложное, но более естественное поведение заключается в

том, что состояние системы в какой-то момент в будущем зависит от

состояния системы в текущий момент времени, но не зависит от

поведения в прошлом. Дадим точное математическое определение

таких систем.

(t )

В теории вероятностей случайным процессом

называют функцию от действительного параметра (времени) t T ,

значения (t )

которой при каждом t

являются случайными

величинами.

(t ) называется

Определение 3.1.

Случайный процесс

марковским, если для любых наборов моментов времени

t1 t 2 t n t n1 и любых состояний i1 , i2 ,, in

P (t n1 ) in1 | (t1 ) i1 ,, (t n ) in

P (t n1 ) in1 | (t n ) in

(3.1)

В этом определении момент времени t n задает настоящий

(текущий) момент времени, моменты

t1 ,, t n1

относятся к

прошлому, а t n 1 – к будущему времени.

Общепринято называть марковские случайные процессы с

конечным или счетным множеством состояний марковскими цепями.

Этот класс случайных процессов был введен математиком

А.А.Марковым в 1907г. В настоящее время построена большая и

глубокая теория марковских процессов, имеющая серьезные

приложения во многих науках. Вообще говоря, очень большое число

моделей может быть формализовано в виде марковских моделей,

правда за счет увеличения мощности множества состояний S .

Как следует из определения (3.1), важную роль в теории

марковских

процессов

играют

условные

вероятности

P (t ) j | (u ) i pij (u, t ) ,

называемыми

переходными

вероятностями. В дальнейшем мы будем предполагать, что вероятности

pij (u, t )

не зависят от того, где расположен временной интервал

(u , t ) , а зависят только от его длины t u . Марковские процессы с

таким свойством называются однородными. Значит, в дальнейшем мы

будем считать, что

P (t ) j | (u) i P (t u) j | (0) i

и пользоваться обозначением

P (t ) j | (0) i pij (t ) .

Матрицу переходных вероятностей за t единиц времени будем

обозначать

P(t ) pij (t )i , jS .

Заметим, что матрица P (t ) для любого момента времени t обладает

следующим свойством: все элементы матрицы неотрицательны и сумма

элементов каждой строки равна 1:

pij (t ) 1 , i S .

jS

Заметим также, что P (0) I , I - единичная матрица.

Предложение 3.1. (Уравнение Колмогорова-Чэпмена).

Пусть u и t - произвольные значения времени, u t , t 0 . Тогда

для любых состояний i и j выполнены соотношения

pij (u t ) pik (u ) p kj (t )

kS

(3.2)

Доказательство.

pij (u t ) P (u t ) j | (0) i

P (u t ) j, (u ) k | (0) i

kS

P (u t ) j, (u ) k , (0) i

P (0) i

kS

P (u t ) j | (u ) k , (0) iP (u ) k , (0) i

=

P (0) i

kS

P (u ) k , (0) ipkj (t )

pik (u ) pkj (t ) .

P (0) i

kS

kS

=

Свойство марковости в этом выводе использовалось в том месте, где

мы заменили условную вероятность P (u t ) j | (u) k , (0) i

на P (u t ) j | (u ) k p kj (t ) .

На языке матриц эти соотношения можно записать в следующем

виде:

(3.3)

P(u t ) P(u ) P(t )

Знания матрицы переходных вероятностей недостаточно для того,

чтобы ответить, например, на вопрос о том, с какой вероятностью

система находится в состоянии j в момент времени t . Но если мы

знаем вероятности различных состояний в момент t 0 , то можем

вычислить вероятности любых состояний в любой другой момент

времени. Обозначим P (t ) k pk (t ) . Применяя формулу полной

вероятности, получаем, что

(3.4)

pi (t )

p k (0) p ki (t ) .

kS

В матричной форме соотношение (3.4) можно записать как

p(t ) p(0) P(t ) ,

(3.5)

где p(t ) pi (t ), i S вектор-строка вероятностей системы в

момент времени t .

3.2 Марковские цепи с дискретным временем. Теорема о

предельных вероятностях

В этом параграфе мы будем считать, что время t принимает

неотрицательные целые значения: t 0,1,2,... .Такие марковские цепи

называются марковскими цепями с дискретным временем.

Используя соотношения Колмогорова-Чэпмена (3.3), мы можем

видеть, что

(3.6)

P(n) P(n 1) P(1) ,

где P (n ) - матрица переходных вероятностей за n шагов (единиц

времени). Разрешая это рекуррентное соотношение, мы получаем, что

(3.7)

P(n) P n (1) .

Таким образом, для вычисления матрицы переходных

вероятностей за n шагов достаточно задать матрицу переходных

вероятностей за один шаг и затем возвести ее в n -ую степень.

Матрицу переходных вероятностей за один шаг мы будем обозначать

P , P(1) P и будем называть ее матрицей переходных вероятностей.

Рассмотрим несколько примеров.

Пример 1. Случайное блуждание.

Пусть 1 , 2 ,, n , ... - последовательность независимых,

одинаково распределенных, целочисленных случайных величин.

Определим процесс (n)

как (n) 1 n ,

(0) 0 .

Марковость

этого

процесса

видна

из

соотношения

(n 1) (n) n1 , n 0 . В случае, когда случайные величины

n

принимают значения +1 и -1 с вероятностью

P( n 1) p ,

P( n 1) 1 p , где 0 p 1 , процесс случайного блуждания

называется простым случайным блужданием. Этот пример играет

важную роль в физике, но с помощью процессов такого рода можно

также описывать поведение курсов акций (под (n) понимается цена

акции в момент времени n ). В случае, когда множество состояний

S Z , матрица переходных вероятностей для простого случайного

блуждания является бесконечной. При некотором размышлении можно

научиться возводить такие матрицы в произвольную степень. Но

переходную вероятность за n шагов в простом случайном блуждании

легко найти, не прибегая к возведению бесконечной матрицы P в n ую степень. Пусть pij (n) P (n) j | (0) i . Очевидно, что если

| i j | n , то переход из i в j невозможен и pij (n) 0 . Пусть,

например, j i . Чтобы попасть из состояния i в состояние j ,

n j i

m

необходимо сделать

шагов направо (в сторону

2

увеличения номера состояния), а оставшиеся ( n m) шагов - налево.

При этом порядок совершения шагов направо и налево не важен, и,

кроме того, если m не является целым числом, то pij (n) 0 .

Отсюда мы получаем, что

pij (n) Cnm p m (1 p) nm .

Пример 2.

Случайное блуждание с ограничениями (задача о

разорении).

Игрок приходит в казино с a рублями в кармане. В каждой игре

он выигрывает 1 рубль с вероятностью p и проигрывает один рубль с

вероятностью q 1 p . Игрок уходит из казино , если его капитал

достигает величины b рублей или 0 рублей. Обозначим через (n)

его капитал после

n -ой игры. Ясно, что последовательность

(0), (1),... образует марковскую цепь, причем P( (0) a ) 1 .

Множеством состояний этой цепи является множество {0,1, , b} .

Матрица переходных вероятностей размера (b 1) (b 1) имеет вид

1 0 0.....................0

q 0 p 0.................0

0 q 0 p 0..............0

.

..............................

0.................0 q 0 p

0..................0 0 0 1

(3.8)

Заметим, что из любого состояния данной цепи можно с ненулевой

вероятностью попасть в состояния 0 и b , но из этих состояний выйти

уже нельзя. Такие состояния называются поглощающими. Этот пример

представляет собой случайное блуждание с ограничениями.

Пример 3. (ветвящийся процесс).

Пусть некоторый вид биологических организмов может иметь от

k 0,1, .

каждой особи k потомков с вероятностью

pk ,

Обозначим через (0) количество этих организмов в 0-й момент

времени. Пусть (n) - количество организмов в n -ый момент

времени. Обозначим через n 1, m

случайное количество потомков у

m -ой особи в (n 1) -м поколении, m {1, , (n 1)} . Случайные

величины k ,m независимы между собой при разных парах (k , m) .

Марковский характер процесса следует из очевидной формулы

(n)

( n 1)

m 1

n 1, m

.

Такие марковские процессы называются ветвящимися процессами и

они могут моделировать как процессы размножения в биологических

популяциях, так и цепные реакции в ядерной физике.

Пусть имеется марковская цепь с матрицей переходных

вероятностей P ( pij ) i , jS . Мы будем предполагать, что цепь конечна

и пусть в дальнейшем для определенности S {1,2, , N } .

Определение 3.2.

Распределение вероятностей

1 , 2 ,, N

называется стационарным для данной марковской цепи, если

(3.9)

j i pij , j 1,2, , N

i

Из этого определения следует, что если начальное распределение

вероятностей

состояний

системы

задается

стационарным

распределением pi (0) i , i 1,2, , N , то оно остается таким же

для любого n : pi (n) i , i 1,2, , N .

Если ввести вектор-строку ( 1 , 2 ,, N ) , то условие

стационарности распределения (3.9) перепишется в матричной форме

как

(3.10)

P .

Таким образом, стационарное распределение вероятностей

задается левым собственным вектором матрицы P с собственным

числом 1.

Система линейных уравнений (3.9), задающих стационарное

распределение , является вырожденной ( в силу того, что сумма

элементов каждой строки матрицы P равна 1). Но если дополнить

эту систему условием нормировки

i 1,

is

то можно однозначно определить стационарное распределение .

Определение 3.3. Марковская цепь (n) называется эргодической,

если существуют не зависящие от начального распределения и не

зависящие от i величины p j lim pij (n) , p j 1 .

Вероятности

p ,

j

финальными вероятностями.

n

jS

jS

называют предельными или

Замечательным обстоятельством является то, что при некоторых

условиях матрица переходных вероятностей P (n ) имеет предел при

n , причем этот предел является матрицей, все строки которой

совпадают со стационарным распределением

. Эту теорему

называют теоремой о предельных вероятностях или эргодической

теоремой.

Пусть марковская цепь обладает таким свойством, что

существует

n 0 такое, что все элементы матрицы

P ( n0 )

положительны. Определим величину

1

k (n0 ) 1 sup | pim (n0 ) p jm (n0 ) | ,

2 i, j m

(3.11)

которая называется коэффициентом эргодичности.

Заметим, что для марковской цепи с конечным множеством состояний

из строгой положительности матричных элементов матрицы P (n0 )

следует, что коэффициент эргодичности k (n0 ) 0 . Не все марковские

цепи обладают таким свойством. Например, если матрица переходных

вероятностей

0

P

1

1

,

0

то P(n) P n совпадает с единичной матрицей при четных n и с

матрицей P при нечетных n и поэтому при любом n матрица

P (n ) содержит нулевые матричные элементы.

Теорема 3.1 (теорема о предельных вероятностях). Пусть для конечной

марковской цепи (n) существует

n 0 такое, что матричные

элементы матрицы P (n0 ) положительны. Тогда существуют пределы

lim pij (n) j ,

n

j

1,

j 1,2, , N

(3.12)

j

Другими словами, марковская цепь является эргодической.

Доказательство. Обозначим

m j (n) min pij (n) , M j (n) max pij (n) .

i

Поскольку

i

pij (n 1) pik p kj (n) ,

k

то из того, что

m j (n) p kj M j (n)

m j (n) pij (n 1) M j (n) . Значит

при любом

k

следует

m j (n) m j (n 1) M j (n 1) M j (n) .

Отсюда следует, что существуют пределы последовательностей m j (n)

и

M j (n) при n . Наша цель состоит в том, чтобы доказать

равенство этих пределов.

Пусть l и s - произвольные состояния. Запишем, что

0 plk (n0 ) p sk (n0 )

k

k

k [ plk (n0 ) psk (n0 )] k [ plk (n0 ) psk (n0 )] ,

где суммирование

ведется по таким

k

plk (n0 ) p sk (n0 ) 0 , а

k,

для которых

ведется по таким k , для которых

k

plk (n0 ) p sk (n0 ) 0 . Отсюда следует, что

1

max | plk (n0 ) p sk (n0 ) |

2 l ,s k

1

max k [ plk (n0 ) p sk (n0 )] k [ plk (n0 ) p sk (n0 )]

2 l ,s

max k [ plk (n0 ) psk (n0 )] .

l ,s

max k [ plk (n0 ) p sk (n0 )] 1 k (n0 ) ,

Значит,

где

l ,s

k ( n0 )

задается (3.11). Заметим, что

M j (n0 ) m j (n0 ) max plj (n0 ) min p sj (n0 )

s

l

max [ plj (n0 ) psj (n0 )] max k [ plk (n0 ) psk (n0 )] 1 k (n0 ) .

l ,s

l ,s

Поэтому для любого n 0

M j (n0 n) m j (n0 n) max [ plj (n0 n) psj (n0 n)]

l ,s

max [ plk (n0 ) p sk (n0 )] p kj (n)

max

l ,s

p

l ,s

k

k

(n0 ) psk (n0 )M j (n) k plk (n0 ) psk (n0 )m j (n)

lk

= max

l ,s

p

k

lk

= 1 k (n0 ) M j (n) m j (n) .

Отсюда получаем, что

(n0 ) psk (n0 ) M j (n) m j (n)

M j (Tn0 ) m j (Tn0 ) [1 k (n0 )]T ,

Поскольку

T 1, 2,... .

1 k (n0 ) 0 , последовательность

возрастает, последовательность

M j ( n)

m j ( n)

монотонно

монотонно убывает и

M j (n) m j (n) , то

lim( M j (n) m j (n)) 0 .

n

Значит, последовательности

и

M j ( n)

m j ( n) , а следовательно и

последовательность pij (n) имеют один и тот же предел, который мы

обозначим j :

lim pij (n) j ,

n

i 1,..., N .

Покажем, что предельные вероятности j , j 1, 2,... образуют

стационарное распределение вероятностей. Перейдя в уравнениях

pij (n 1) pik (n) pkj

k

к пределу по n , получаем

j k pkj .

k

Кроме того

j

lim pij (n) lim pij (n) 1 .

j

j

n

n

j

j,

j 1,..., N действительно образуют

стационарное распределение вероятностей. Теорема доказана.

Из этой теоремы следует, что для любого начального

k 1, 2,... безусловные

распределения вероятностей

pk (0) ,

Значит, величины

вероятности p j (n) стремятся к j :

lim p j (n) lim

n

n

p

k

(0) p kj (n)

k

p k (0) lim p kj (n) j p k (0) j .

k

n

k

Отсюда, в частности, следует единственность стационарного

распределения { 1 , 2 ,, N } . Предельную вероятность j

можно интерпретировать как вероятность обнаружить систему в

состоянии j при больших n . Действительно, пусть случайный

момент времени, равномерно распределенный по множеству значений

{1,2, , n} ,

P ( m)

1

,

n

m {1,2,, n} ,

причем

случайная

величина не зависит от случайных величин, задающих нашу

марковскую цепь. Пусть (0) i . Тогда

P ( ) j

P (m) j (0) iP( m)

n

m 1

1 n

j . (3.13)

pij (m) n

n m 1

Из доказательства теоремы следует, что

j 0,

j 1, , N ,

а также то, что для любого начального распределения

p j (n) j C exp( Dn ) ,

C

1

,

1 k ( n0 )

D

p

j

(0)

(3.14)

(3.15)

1

1

.

ln

n0 1 k ( n0 )

Утверждение эргодической теоремы справедливо и для

марковской цепи со счетным множеством состояний. Для

справедливости утверждения в общем случае надо сразу потребовать,

чтобы при некотором

коэффициент эргодичности

k (n0 ) ,

n0

задаваемый формулой (3.11), был положительным.

Что может служить препятствием к существованию предельных

вероятностей? Рассмотрим пример марковской цепи с множеством

состояний S {1,2,3,4} и матрицей переходных вероятностей

0,3

0,8

P

0

0

0

0,2 0 0

.

0 0,4 0,6

0 0,5 0,5

0,7

0

(0) {1,2} , то в пределе получится

распределение e1 (8 15 , 7 15, 0, 0) ,

а если

Если начальное состояние

стационарное

(0) {3,4} , то в пределе марковская цепь «выйдет» на стационарное

e2 (0, 0, 5 11, 6 11) . Множество состояний этой

цепи разбито на подмножества S1 {1,2} и S 2 {3,4} . Нельзя

перейти из состояний множества S1 в состояния множества S 2 и

распределение

наоборот.

Мы говорим, что состояние j достижимо из состояния i , если

существует такое n , что pij (n) 0 . Если состояние j достижимо

из состояния i и состояние i достижимо из состояния j , то

состояния i и j называются сообщающимися. Если все состояния в

множестве

являются сообщающимися, то марковская цепь

S

называется неразложимой.

Другой пример неэргодического поведения задается матрицей

0 0,5 0 0,5

0,5 0 0,5 0

.

P

0 0,5 0 0,5

0,5 0 0,5 0

S {1,2,3,4} этой цепи разбивается на

Множество состояний

подмножества S1 {1,3} и S 2 {2,4} . Мы наблюдаем некоторую

периодичность: за нечетное число шагов цепь переходит из состояний

множества S1 в состояния множества S 2 и наоборот. Такие цепи

называются периодическими. Дадим точные определения.

Состояние i имеет период d d (i ) , если d является

pii (n) 0 только для n , кратных

d : n md , m N . Другими словами,

d является наибольшим

общим делителем чисел n таких, что pii (n) 0 . Если pii (n) 0

i

d (i ) 0 . Состояние

для всех

называется

n 1, то

апериодическим, если d (i ) 1 .

наибольшим числом таким, что

Можно показать, что все состояния неразложимой марковской

цепи имеют один и тот же период и поэтому можно говорить о периоде

неразложимой марковской цепи. Если этот период больше 1, то цепь

называется периодической, а если он равняется 1, то цепь называется

апериодической.

Можно доказать, что конечная неразложимая апериодическая

марковская цепь эргодична.

3.3. Марковские цепи с непрерывным временем. Уравнения

Колмогорова

В этом параграфе мы будем считать, что время t пробегает

вещественную числовую прямую или какой-то отрезок на ней, t 0 .

Всякий раз, когда система попадает в состояние i , она будет

находиться в этом состоянии какое-то случайное время i , которое мы

будем называть временем пребывания в состоянии i . Поскольку

система является марковской цепью, распределение случайной

величины i зависит только от состояния i , но не зависит от того,

как эволюционировала система в прошлом.

Допустим, что в какой-то момент времени t система находится в

состоянии i , и в момент времени t x она еще не вышла из этого

состояния. Вычислим условную вероятность того, что система не

выйдет из этого состояния в момент времени t x y . Поскольку в

момент t x система находится в состоянии i , то в силу

марковского свойства, оставшееся время i/ пребывания в состоянии

i (после момента t x ) будет иметь такое же распределение, что и

случайная величина i . Значит,

P i x y | (t ) i, i x

P y | (t x) i P i y | (t ) i.

/

i

(3.16)

В этом случае говорят, что случайная величина i обладает свойством

отсутствия последействия: каково бы ни было текущее время

пребывания в состоянии i , оставшееся время пребывания не зависит

от прошлого и имеет то же самое распределение, что и все (полное)

i.

время пребывания в состоянии

Оказывается, что это

i

парадоксальное свойство времени пребывания в состоянии

однозначно определяет вид распределения.

Предложение 3.2. Неотрицательная ненулевая случайная величина

обладает свойством отсутствия последействия тогда и только тогда,

когда она имеет экспоненциальное распределение.

Доказательство. Свойство отсутствия последействия величины

означает, что

(3.17)

P( x y x) P( y)

для любых x 0, y 0 . Обозначим P( x) f ( x) . Тогда из

(3.17) следует, что

f ( x y ) f ( x) f ( y ) , x 0, y 0 .

(3.18)

Покажем, что из функционального уравнения (3.18) следует, что

f ( x) exp( x) для некоторого 0 . Действительно, из (3.18)

легко следует, что для любого рационального числа r

n

m

n

n

1

f (r ) f f (1) m f (1) r .

m

Для любого иррационального числа x 0 выберем монотонно

убывающую последовательность рациональных чисел r1 r2 ...

такую, что rn x при n . Поскольку функция

непрерывна справа, то

f ( x) P( x)

f ( x) lim f (rn ) lim f (1)rn f (1) x .

n

n

Так как f ( x) P( x) 0 при x , то 0 f (1) 1 . Если бы

f (1) 0 , то f ( x) P( x) 0 при любом x 0 , что означало бы

что 0 . Обозначив ln f (1) , мы получаем, что

P( x) exp( x) .

Обратное утверждение очевидно. Предложение доказано.

Тот факт, что имеет экспоненциальное распределение с

параметром , мы будем обозначать так: E ( ) .

Ясно, что для каждого состояния i марковской цепи параметр

распределения i вообще говоря зависит от i : i exp( i ) .

Постоянную i называют плотностью выхода из состояния i .

Заметим, что возможен случай, когда i 0 . Но в этом случае

процесс (t ) навсегда остается в состоянии i и такое состояние

называется поглощающим.

Пусть 0 i . Вероятность того, что за малое время t

система выйдет из состояния i , равна

P( i t ) 1 exp( i t )

(i t ) k

1 1 i t

k!

k 2

i t o(t ) ,

(3.19)

где o(t ) обозначает величину более высокого порядка малости по

сравнению с t :

o ( t )

0.

t t 0

Если система выходит из состояния i , то она попадает в какоето другое состояние и мы предположим, что вероятность перехода из

состояния i в состояние j за малое время t в главном члене

пропорциональна этому времени:

pij (t ) ij t o(t ) ,

i j.

(3.20)

ij называется плотностью перехода из i в j . Кроме того, введем

обозначение ii i , i 1,2, . Вообще говоря, за малое время

t система может совершить несколько переходов, прежде чем

попасть из i в j . Но каждый переход возможен с вероятностью,

пропорциональной

и поэтому вероятность многоходовых

t ,

переходов будет давать вклад o(t ) . Из формулы (3.19) также

следует, что

pii (t ) 1 i t o(t ) .

(3.21)

Исходя

из

этих

предположений,

мы

выведем

систему

дифференциальных уравнений для переходных вероятностей p ij (t ) .

Для простоты предположим, что множество состояний марковской

цепи конечно.

p ij (t ) удовлетворяют

Теорема 3.2. Переходные вероятности

дифференциальным уравнениям

dpij (t )

dt

ik p kj (t ) ,

i, j 1,2,

(3.22)

i, j 1,2,

(3.23)

k

и

dpij

dt

pik (t )kj ,

k

с начальными условиями

1, при i j

pij (0)

0, при i j

(3.24)

Доказательство. Пользуясь соотношением Колмогорова-Чэпмена (3.2)

и представлениями (3.20), (3.21), получаем

(3.25)

pij (t t )

pik (t ) p kj (t )

k

ik t o(t ) p kj (t ) 1 i t o(t ) pij (t ) .

k i

Вычтем из обоих частей (3.25) p ij (t ) и разделим на t :

pij (t t ) pij (t )

t

o(t )

ik

pkj (t ) .

t

k

(3.26)

Заметим, что правая часть уравнения (3.26) имеет предел при

t 0 . Следовательно существует предел у левой части, который

является производной по времени от переходной вероятности

p ij (t ) .

Уравнения (3.23) доказываются аналогично.

Системы уравнений (3.22) и (3.23) называют прямой и обратной

системами дифференциальных уравнений Колмогорова.

Безусловные

вероятности состояний марковской цепи

вычисляются по формулам

(3.27)

p j (t )

pi (0) pij (t ),

j 1,2, ,

i

где

pi (0), i 1,2, вероятности состояний цепи в начальный

(нулевой) момент времени. Из (3.27) и (3.23) следует, что уравнения

Колмогорова справедливы и для вероятностей p j (t ) :

dp j (t )

dt

pk (t )kj ,

j 1,2,

(3.28)

k

Система уравнений Колмогорова справедлива и для счетных цепей

Маркова, но в этом случае необходимо потребовать, чтобы для всех

остаточных членов o(t ) , участвующих в соотношениях (3.20),

(3.21)

o(t )

0

при t 0

t

равномерно по всем i , и плотности перехода ij с фиксированным

j были равномерно ограничены:

ij j ,

i 1,2,...

(3.29)

Для марковских цепей с непрерывным временем также

справедлива эргодическая теорема.

t 0 такое, что коэффициент

Теорема 3.3.

Пусть существует

эргодичности

1

k (t 0 ) 1 sup | pik (t 0 ) p jk (t 0 ) |

2 i, j k

положителен. Тогда существуют предельные вероятности

lim pij (t ) j ,

t

j 1,2,...

Из (3.27) и (3.30) следует, что в этом случае

lim p j (t ) j ,

t

для любого начального распределения pi (0), i 1,2,... .

(3.30)

(3.31)

Марковской

цепи

можно

поставить

в

соответствие

ориентированный граф, вершинами которого являются состояния.

Соединим каждую пару вершин i и j ориентированным ребром, если

плотность перехода ij 0 . Этот граф называется графом состояний.

Можно показать, что если граф конечен, и из любого состояния можно

перейти в любое, то предельные вероятности существуют.

Пусть условие теоремы 3.4. выполнено и предельные

вероятности j , j 1,2, существуют. Перейдем к пределу t

в уравнениях (3.28). Кажется правдоподобным ( на самом деле это

можно доказать), что пределы в левой части стремятся к 0. Таким

образом, для предельных вероятностей получается система линейных

уравнений

(3.32)

k kj 0,

j 1,2,...

k

Эту систему необходимо дополнить условием нормировки

k

1

k

Если вспомнить, что jj j

перепишется в виде

k j

j

и j

jk k kj ,

(3.33)

k j

jk

, то система (3.32)

j 1,2,.

(3.34)

k j

В этом виде система уравнений легко запоминается.

Графическая интерпретация уравнений (3.34) говорит о том, что

для каждого состояния j сумма членов, соответствующих ребрам,

выходящим из этого состояния, равна сумме членов, соответствующих

ребрам, входящим в состояние (вершину) j . Эти уравнения называют

еще уравнениями баланса. Прибегая к физической терминологии, мы

говорим, что имеется закон сохранения вероятностей в каждой

вершине – «сколько вероятности вытекает из вершины, столько же туда

и втекает».

Задачи

1. Студент X играет со студентом Y в «орлянку». В каждой

игре он может с вероятностью 1 2 выиграть 1 рубль или с той же

вероятностью проиграть его. Первоначально у студента X был 1

рубль, а у студента Y – 2 рубля. Игроки играют до разорения. Какова

вероятность того, что игра продлится не более 3-х раундов?

0 , 1 , – независимые одинаково распределенные

случайные величины,

P( i 1) 1 p, P( i 1) p . Пусть

n n1 n , n 1,2, . Будет ли последовательность n цепью

2.

Пусть

Маркова?

3. Пусть случайные величины

1 , 2 , , n

независимы,

P( i 1) p, P( i 0) q ,