Лаптин_Сравнение ÐºÐ»Ð°Ñ Ñ Ð¸Ñ

реклама

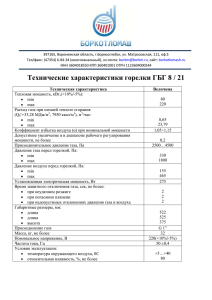

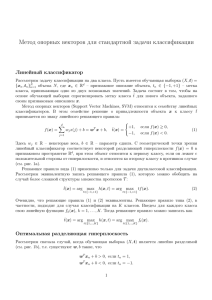

1 СРАВНЕНИЕ НЕКОТОРЫХ ПОДХОДОВ К РЕШЕНИЮ ЗАДАЧ КЛАССИФИКАЦИИ Ю.П.Лаптин Отдел методов негладкой оптимизации Институт кибернетики НАНУ 2 Содержание 1. Задачи построения классификаторов в случае многих классов. 2. Сравнение линейных и последовательных бинарных классификаторов. Ввиду преимуществ последовательных классификаторов в дальнейшем рассматривается случай двух классов. 3. Линейно разделимые множества. Сравнение SVM и методов негладкой оптимизации. 4. Линейно неразделимые множества. Модель минимизации эмпирического риска. Сравнение с математической моделью SVM. Результаты вычислительных экспериментов 3 1. Задачи построения классификаторов в случае многих классов 1 3 ... 4 2 Пример совокупности классов в R 2 m 4 fi ( x,W i ) w i , x w0i , где x R n – вектор признаков, W i ( wi , w0i ) Rn1 – вектор параметров, i 1,..., m, m 2 . Линейный классификатор ( m 2 ): a( x,W ) arg max fi ( x,W i ) : i 1,..., m , x R n , W R L , i (1) где W (W 1,..., W m ) , L m(n 1) . При m 2 1, если f ( x,W ) 0, a ( x, W ) 2, если f ( x,W ) 0. где f ( x,W ) w, x w0 , W (w, w0 ) R n1. (2) 5 Обучающая выборка – i xt R n : t Ti , i 1,..., m , T m Ti . i 1 Классификатор a ( x,W ) правильно разделяет точки из i , i 1,..., m , если a( x,W ) i , для всех x i , i 1,..., m . Зазор классификатора a ( x,W ) в точке xt , t T , m 2 g t (W ) min fi ( xt ,W i ) f j ( xt ,W j ) : j 1,..., m \ i , i i (t ) min wi w j , xt w0i w0j : j 1,..., m \ i , i i(t ) , (3) где i (t ) – номер множества i , которому принадлежит точка xt , t T . При m 2 f ( xt ,W ),если t T1, g t (W ) t f ( x ,W ), если t T2 . (4) 6 g (W ) min g t (W ): t T – зазор классификатора a ( x,W ) на совокупности множеств i , i 1,..., m . a ( x,W ) правильно разделяет точки из i , i 1,..., m , если g (W ) 0 . Множества i , i 1,..., m , разделимы в классе линейных классификаторов, если существует линейный классификатор, правильно разделяющий точки из этих множеств. 7 Задача построения оптимального линейного классификатора: найти (5) (6) g max g (W ) : (W ) 1, W R L . W Эквивалентная форма min (V ) : g (V ) 1, V R L , V min (V ) : g t (V ) 1, t T ,V R L . V Утверждение. Если W оптимальное решение задачи (5), то для * W* оптимального решения V задачи (6) или (7) имеет место V * 1 g *. (7) g *, 8 2. Сравнение линейных и последовательных бинарных классификаторов 1, f 1 4 , f4 f1 <= f2 <= f3 <= f4 <= f1 2 , f2 3, f 3 Пример множеств, неразделимых в классе линейных классификаторов 9 Пусть для каждой пары множеств i , j определен классификатор aij ( x,W ij ) вида (2), разделяющий эти множества. Последовательный бинарный алгоритм классификации заключается в последовательном применении классификаторов aij ( x,W ij ) для анализа точки x . Если в результате применения aij ( x,W ij ) окажется, что точка x принадлежит полупространству, содержащему множество i , то из дальнейшего анализа альтернативное множество j и связанные с ним классификаторы aij ( x,W ij ) должны быть исключены. Утверждение. Для разделимости множеств i , i 1,..., m , в классе последовательных бинарных классификаторов необходимо и достаточно, чтобы выпуклые оболочки этих множеств не пересекались. Последовательные классификаторы близки по конструкции к DAGSVMалгоритмам, введенным в [6]. 10 3. Линейно разделимые множества. Сравнение SVM и методов негладкой оптимизации Задача построения оптимального классификатора g max , w, w0 , w, xt w0 , t T1, w, xt w0 , t T2 , w, w 1. (8) (9) (10) (11) 11 Математическая модель метода опорных векторов t min v, v C , v ,v0 tT (12) v, xt v0 1 t , t T1, (13) v, xt v0 1 t , t T2 , (14) t 0, t T . Параметры генерируемых задач: размерность n признакового пространства R n – от 5 до 100; число точек в обучающей выборке – от 40 до 50 000. (15) 12 Семейство задач Pi , i 1,..., 10 , di 2i . d Метод точных штрафных функций + r -алгоритм Н.З.Шора: точность по целевой функции ~ 106 ), число итераций r -алгоритма ~ 100 ( n 5), ~ 1500 ( n 100 ). Модель SVM ( C 1000 ): при i 5 сформированные задачи решались успешно, при i 7 задачи решены не были. 13 Сравнение с LIBSVM (http://www.csie.ntu.edu.tw/~cjlin/libsvm/), n 100 . Число точек 5000 10000 25000 40000 50000 Время решения, сек. Методы LIBSVM негладкой оптимизации 9.421 20.8 24.234 24.3 83.468 43 186.484 51,1 266.203 84,8 14 4. Линейно неразделимые множества. 4.1. Модель минимизации эмпирического риска Q min yt , w, y tT (16) g t (W ) Bt yt , t T , (17) при ограничениях w, w 1, yt Ti 1, (18) i 1, 2 , (19) tTi 0 yt 1, t T , yt 0,1 , t T . (20) (21) 15 Условие корректности для чисел Bt , t T – при yt 1 ограничения (17) выполняются при любых допустимых значениях остальных переменных. Пусть t T , s T1, T2 , s, t ts min w, w0 w, xt w0 , (22) w, x s w0 , s T1, (23) w, x w0 , T2 , (24) w, w 1. (25) Обозначим Bt max ts : s T1, T2 , s, t , t T . Теорема 1. Числа Bt , t T , удовлетворяют условию корректности в задаче (16)-(21), если (26) Bt Bt , t T . 16 Непрерывная релаксация задачи минимизации эмпирического риска q min d t (W ) при ограничениях (27) W tT w, w 1, (28) t d (W ) Ti 1, i 1,..., m , (29) tTi d t (W ) 1, t T , 1 где d t (W ) max 0, g t (W ) Bt (30) . 17 4.2. Сравнение с математической моделью SVM Модель SVM: найти t min v, v C , v ,v0 tT при ограничениях (31) v, xt v0 1 t , t T1, (32) v, xt v0 1 t , t T2 , (33) t 0, t T . (34) 18 Ослабление ограничений и замена переменных w v, w0 v0 , Byt t , t T1 T2 , приводит релаксацию задачи минимизации эмпирического риска к виду t q min B v,v0 , tT (35) при ограничениях v, xt v0 1 t , t T1, (36) v, xt v0 1 t , t T2 , (37) v, v 1 2 , t 0, t T . (38) (39) 19 Функция Лагранжа L(, , v) t ( v , v 1 2 ) . B tT Лагранжевая релаксация: найти () min L(, , u) v,v0 , при ограничениях (36), (37), (39). () q при любом 0 . Если C , то B t L(, , u ) v, v C 2 , tT (40) 20 4.3. Результаты вычислительных экспериментов Критерий качества – число точек обучающей выборки, классифицируемых неправильно. Программное средство CPLEX. 21 30 25 20 MER 15 RMER SVM 10 5 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 Зависимость ошибки классификации от числа перемещаемых точек, n 5, i 25, i 1, 2 . 22 90 80 70 60 50 RMER SVM 40 30 20 10 0 1 6 11 16 21 26 31 36 41 46 51 56 61 66 71 76 81 86 91 96 Зависимость ошибки классификации от числа перемещаемых точек, n 30 , i 100, i 1, 2 . 23 35 30 25 SVM 1 20 SVM 2 RMER 1 15 RMER 2 10 5 0 1 3 5 7 9 11 13 15 17 19 21 23 25 27 29 Зависимость от числа перемещаемых точек ошибки классификации по каждому классу, n 30 , 1 30, 2 200 , SVM 1 – модель SVM, множество 1;, SVM 2 – модель SVM, множество 2 ; RMER 1 – релаксированная модель минимизации эмпирического риска, множество 1, RMER 2 –модель RMER, множество 2 . 24 Литература 1. Vapnik V. Statistical Learning Theory. New York: Wiley, 1998. 2. Шлезингер М., Главач В. Десять лекций по статистическому и структурному распознаванию. – К.: Наукова думка, 2004. – 545 с. 3. Thorsten Joachims. Learning to Classify Text Using Support Vector Machines: Methods, Theory, and Algorithms. Kluwer, 2002 4. Fung G. M., Mangasarian O. L. Multicategory Proximal Support Vector Machine Classifiers // Machine Learning, 59, 2005, p. 77–97. 5. Chih-Wei Hsu, Chih-Jen Lin A comparison of methods for multiclass support vector machines // IEEE Transactions on Neural Networks. – 2002, Volume 13, Issue: 2. – P. 415 - 425 6. Platt J.C., Cristianini N., Shawe-Taylor J. Large margin DAG’s for multiclass classification // Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2000, vol. 12, pp. 547–553. 25 7. Журавлев Ю.И., Лаптин Ю.П., Виноградов А.П. Минимизация эмпирического риска и задачи построения линейных классификаторов // Кибернетика и системный анализ. 2011, № 4.- С. 155 – 164. 8. Shor N. Z. Nondifferentiable Optimization and Polynomial Problems. – Amsterdam / Dordrecht / London: Kluwer Academic Publishers, 1998. – 381 p. 9. Laptin Yu., Likhovid A. P., Vinogradov A.P. Approaches to Construction of Linear Classifiers in the Case of Many Classes // Pattern Recognition and Image Analysis, Vol. 20, No. 2, 2010, p. 137-145. 10. Петунин Ю.И, Шульдешов Г.А. Проблемы распознавания образов с помощью линейных дискриминантных функций Фишера // Кибернетика. – 1979. – № 6. – C. 134-137. 26 Благодарю за внимание. [email protected]