,

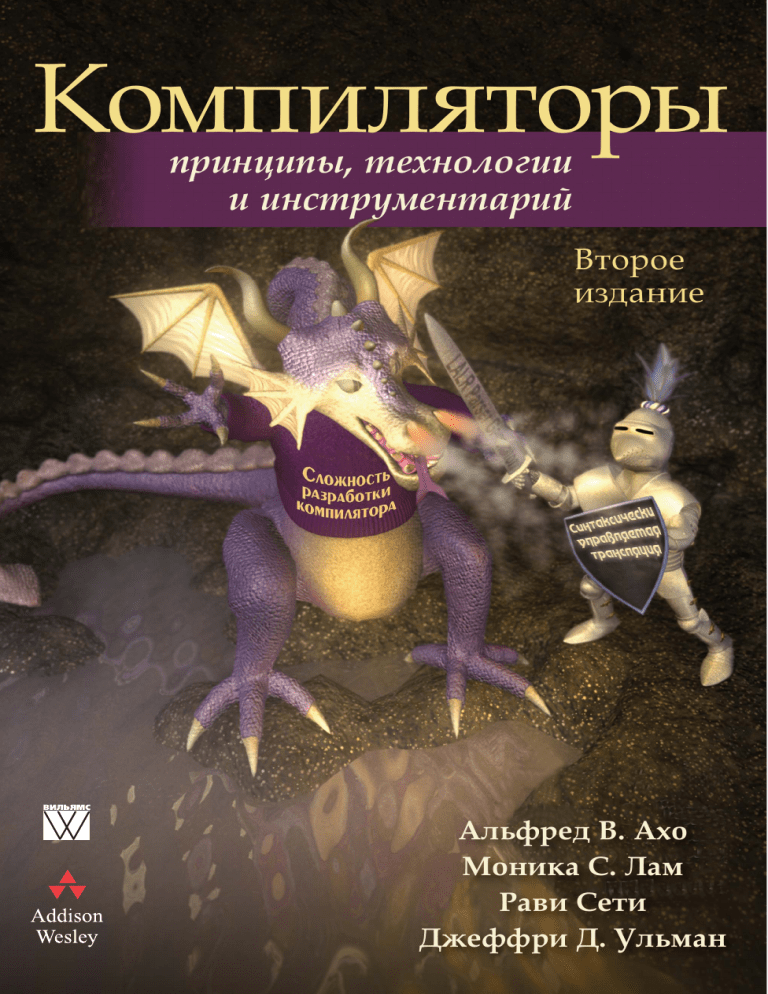

Compilers

Principles, Techniques, & Tools

Second Edition

Alfred V. Aho

Columbia University

Monica S. Lam

Stanford University

Ravi Sethi

Avaya

Jeffrey D. Ullman

Stanford University

Boston · San Francisco · New York

London · Toronto · Sydney · Tokyo · Singapore · Madrid

Mexico City · Munich · Paris · Cape Town · Hong Kong · Montreal

,

. . Avaya

. · -,0'" · 1

2018

ББК 32.973.26018.2.75

К63

УДК 681.3.07

Издательский дом “Вильямс”

Зав. редакцией С.Н. Тригуб

Перевод с английского и редакция канд. техн. наук И.В. Красикова

По общим вопросам обращайтесь в Издательский дом “Вильямс” по адресу:

info@williamspublishing.com, http://www.williamspublishing.com

Ахо, Альфред В., Лам, Моника С., Сети, Рави, Ульман, Джеффри Д.

К63

Компиляторы: принципы, технологии и инструментарий, 2е изд . : Пер . с

англ. — М. : ООО “И.Д. Вильямс”, 2018. — 1184 с. : ил. — Парал. тит. англ.

ISBN 9785845919328 (рус.)

ББК 32.973.26018.2.75

Все названия программных продуктов являются зарегистрированными торговыми марками со

ответствующих фирм.

Никакая часть настоящего издания ни в каких целях не может быть воспроизведена в какой бы

то ни было форме и какими бы то ни было средствами, будь то электронные или механические,

включая фотокопирование и запись на магнитный носитель, если на это нет письменного разреше

ния издательства AddisonWesley Publishing Company, Inc.

Authorized translation from the English language edition published by AddisonWesley Publishing

Company, Inc, Copyright © 2007

All rights reserved. No part of this publication may be reproduced, stored in a retrieval system, or

transmitted, in any form or by any means, electronic, mechanical, photocopying, recording, or otherwise,

without the prior written permission of the publisher.

Russian language edition published by Williams Publishing House according to the Agreement with

R&I Enterprises International, Copyright © 2018.

Научнопопулярное издание

Альфред В. Ахо, Моника С. Лам, Рави Сети, Джеффри Д. Ульман

Компиляторы:

принципы, технологии и инструментарий

2е издание

Литературный редактор

Верстка

Художественный редактор

Корректоры

Л.Н. Красножон

А.Н. Полинчик

С.А. Чернокозинский

Л.А. Гордиенко, Л.В. Чернокозинская

Подписано в печать 20.11.2017. Формат 70x100/16

Гарнитура Times. Печать офсетная

Усл. печ. л. 74,0. Уч.изд. л. 53,0

Доп. тираж 200 экз. Заказ № 0000

Отпечатано в ОАО “Первая Образцовая типография”

Филиал “Чеховский Печатный Двор”

142300, Московская область, г. Чехов, ул. Полиграфистов, д. 1

Сайт: www.chpd.ru, Email: sales@chpd.ru, тел. 8 (499) 2707359

ООО “И. Д. Вильямс”, 127055, г. Москва, ул. Лесная, д. 43, стр. 1

ISBN 9785845919328 (рус.)

ISBN 0321486811 (англ.)

© Издательский дом “Вильямс”, 2018

© Copyright Pearson Education, Inc., 2007

Оглавление

Предисловие

24

Глава 1. Введение в компиляцию

29

Глава 2. Простой синтаксически управляемый транслятор

75

Глава 3. Лексический анализ

155

Глава 4. Синтаксический анализ

251

Глава 5. Синтаксически управляемая трансляция

383

Глава 6. Генерация промежуточного кода

443

Глава 7. Среды времени выполнения

525

Глава 8. Генерация кода

617

Глава 9. Машинно-независимые оптимизации

705

Глава 10. Параллелизм на уровне команд

841

Глава 11. Оптимизация параллелизма и локальности

911

Глава 12. Межпроцедурный анализ

1061

Приложение А. Завершенный пример начальной стадии компилятора

1133

Приложение Б. Поиск линейно независимых решений

1163

Предметный указатель

1167

Содержание

Предисловие

24

Глава 1. Введение в компиляцию

1.1 Компиляторы

1.1.1 Упражнения к разделу 1.1

1.2 Структура компилятора

1.2.1 Лексический анализ

1.2.2 Синтаксический анализ

1.2.3 Семантический анализ

1.2.4 Генерация промежуточного кода

1.2.5 Оптимизация кода

1.2.6 Генерация кода

1.2.7 Управление таблицей символов

1.2.8 Объединение фаз в проходы

1.2.9 Инструментарий для создания компиляторов

1.3 Эволюция языков программирования

1.3.1 Переход к языкам высокого уровня

1.3.2 Влияние на компиляторы

1.3.3 Упражнения к разделу 1.3

1.4 “Компилятороведение”

1.4.1 Моделирование при проектировании и реализации

компилятора

1.4.2 Изучение оптимизации кода

1.5 Применения технологий компиляторов

1.5.1 Реализация высокоуровневых языков программирования

1.5.2 Оптимизация для архитектуры компьютера

1.5.3 Разработка новых архитектур компьютеров

1.5.4 Трансляции программ

1.5.5 Инструментарий для повышения

производительности программного обеспечения

29

29

32

32

33

35

37

38

39

39

40

41

41

42

42

44

45

45

45

46

48

48

50

52

54

55

Содержание

7

1.6

57

58

58

61

65

65

68

70

70

72

73

1.7

1.8

Азы языков программирования

1.6.1 Понятия статического и динамического

1.6.2 Среды и состояния

1.6.3 Статическая область видимости и блочная структура

1.6.4 Явное управление доступом

1.6.5 Динамическая область видимости

1.6.6 Механизмы передачи параметров

1.6.7 Псевдонимы

1.6.8 Упражнения к разделу 1.6

Резюме к главе 1

Список литературы к главе 1

Глава 2. Простой синтаксически управляемый транслятор

2.1 Введение

2.2 Определение синтаксиса

2.2.1 Определения грамматик

2.2.2 Выведение

2.2.3 Деревья разбора

2.2.4 Неоднозначности

2.2.5 Ассоциативность операторов

2.2.6 Приоритет операторов

2.2.7 Упражнения к разделу 2.2

2.3 Синтаксически управляемая трансляция

2.3.1 Постфиксная запись

2.3.2 Синтезированные атрибуты

2.3.3 Простые синтаксически управляемые определения

2.3.4 Обходы дерева

2.3.5 Схемы трансляции

2.3.6 Упражнения к разделу 2.3

2.4 Разбор

2.4.1 Нисходящий анализ

2.4.2 Предиктивный анализ

2.4.3 Использование пустых продукций

2.4.4 Разработка предиктивного анализатора

2.4.5 Левая рекурсия

2.4.6 Упражнения к разделу 2.4

2.5 Транслятор простых выражений

2.5.1 Абстрактный и конкретный синтаксис

2.5.2 Адаптация схемы трансляции

2.5.3 Процедуры для нетерминалов

2.5.4 Упрощение транслятора

75

76

78

79

81

82

84

85

86

89

90

91

92

94

95

97

99

100

101

104

106

106

107

109

109

110

111

113

114

8

Содержание

2.6

2.7

2.8

2.9

2.5.5 Завершенная программа

Лексический анализ

2.6.1 Удаление пробельных символов и комментариев

2.6.2 Опережающее чтение

2.6.3 Константы

2.6.4 Распознавание ключевых слов и идентификаторов

2.6.5 Лексический анализатор

2.6.6 Упражнения к разделу 2.6

Таблицы символов

2.7.1 Таблица символов для области видимости

2.7.2 Использование таблиц символов

Генерация промежуточного кода

2.8.1 Два вида промежуточных представлений

2.8.2 Построение синтаксических деревьев

2.8.3 Статические проверки

2.8.4 Трехадресный код

2.8.5 Упражнения к разделу 2.8

Резюме к главе 2

Глава 3. Лексический анализ

3.1 Роль лексического анализатора

3.1.1 Лексический и синтаксический анализ

3.1.2 Токены, шаблоны и лексемы

3.1.3 Атрибуты токенов

3.1.4 Лексические ошибки

3.1.5 Упражнения к разделу 3.1

3.2 Буферизация ввода

3.2.1 Пары буферов

3.2.2 Ограничители

3.3 Спецификация токенов

3.3.1 Строки и языки

3.3.2 Операции над языками

3.3.3 Регулярные выражения

3.3.4 Регулярные определения

3.3.5 Расширения регулярных выражений

3.3.6 Упражнения к разделу 3.3

3.4 Распознавание токенов

3.4.1 Диаграммы переходов

3.4.2 Распознавание зарезервированных слов

и идентификаторов

3.4.3 Завершение примера

115

118

119

120

121

121

123

128

128

129

133

136

136

137

142

144

151

152

155

155

157

157

159

160

161

162

162

163

165

165

166

168

170

172

173

177

179

181

183

Содержание

3.4.4

3.5

3.6

3.7

3.8

3.9

Архитектура лексического анализатора на основе

диаграммы переходов

3.4.5 Упражнения к разделу 3.4

Генератор лексических анализаторов Lex

3.5.1 Использование Lex

3.5.2 Структура программ Lex

3.5.3 Разрешение конфликтов в Lex

3.5.4 Прогностический оператор

3.5.5 Упражнения к разделу 3.5

Конечные автоматы

3.6.1 Недетерминированные конечные автоматы

3.6.2 Таблицы переходов

3.6.3 Принятие входной строки автоматом

3.6.4 Детерминированный конечный автомат

3.6.5 Упражнения к разделу 3.6

От регулярных выражений к автоматам

3.7.1 Преобразование НКА в ДКА

3.7.2 Моделирование НКА

3.7.3 Эффективность моделирования НКА

3.7.4 Построение НКА из регулярного выражения

3.7.5 Эффективность алгоритма обработки строк

3.7.6 Упражнения к разделу 3.7

Разработка генератора лексических анализаторов

3.8.1 Структура генерируемого анализатора

3.8.2 Распознавание шаблонов на основе НКА

3.8.3 ДКА для лексических анализаторов

3.8.4 Реализация прогностического оператора

3.8.5 Упражнения к разделу 3.8

Оптимизация распознавателей на основе ДКА

3.9.1 Важные состояния НКА

3.9.2 Функции, вычисляемые на синтаксическом дереве

3.9.3 Вычисление nullable, firstpos и lastpos

3.9.4 Вычисление followpos

3.9.5 Преобразование регулярного выражения

непосредственно в ДКА

3.9.6 Минимизация количества состояний ДКА

3.9.7 Минимизация состояний в лексических анализаторах

3.9.8 Компромисс между скоростью и используемой

памятью при моделировании ДКА

3.9.9 Упражнения к разделу 3.9

9

184

187

191

191

192

196

197

198

199

200

201

201

203

204

205

206

210

210

213

218

221

221

221

223

225

226

228

229

229

231

232

234

235

237

242

242

244

10

Содержание

3.10 Резюме к главе 3

3.11 Список литературы к главе 3

Глава 4. Синтаксический анализ

4.1 Введение

4.1.1 Роль синтаксического анализатора

4.1.2 Образцы грамматик

4.1.3 Обработка синтаксических ошибок

4.1.4 Стратегии восстановления после ошибок

4.2 Контекстно-свободные грамматики

4.2.1 Формальное определение контекстно-свободной

грамматики

4.2.2 Соглашения об обозначениях

4.2.3 Порождения

4.2.4 Деревья разбора и порождения

4.2.5 Неоднозначность

4.2.6 Проверка языка, сгенерированного грамматикой

4.2.7 Контекстно-свободные грамматики и регулярные

выражения

4.2.8 Упражнения к разделу 4.2

4.3 Разработка грамматики

4.3.1 Лексический и синтаксический анализ

4.3.2 Устранение неоднозначности

4.3.3 Устранение левой рекурсии

4.3.4 Левая факторизация

4.3.5 Не контекстно-свободные языковые конструкции

4.3.6 Упражнения к разделу 4.3

4.4 Нисходящий синтаксический анализ

4.4.1 Синтаксический анализ методом рекурсивного спуска

4.4.2 FIRST и FOLLOW

4.4.3 LL(1)-грамматики

4.4.4 Нерекурсивный предиктивный синтаксический анализ

4.4.5 Восстановление после ошибок в предиктивном

синтаксическом анализе

4.4.6 Упражнения к разделу 4.4

4.5 Восходящий синтаксический анализ

4.5.1 Свертки

4.5.2 Обрезка основ

4.5.3 Синтаксический анализ “перенос/свертка”

4.5.4 Конфликты в процессе ПС-анализа

4.5.5 Упражнения к разделу 4.5

245

247

251

252

252

253

254

256

258

258

260

261

263

265

266

267

269

272

273

273

275

278

279

280

281

283

285

288

292

295

298

301

302

302

304

306

309

Содержание

11

4.6

309

310

311

317

322

326

328

330

331

332

336

338

344

349

352

353

Введение в LR-анализ: простой LR

4.6.1 Обоснование использования LR-анализаторов

4.6.2 Пункты и LR(0)-автомат

4.6.3 Алгоритм LR-анализа

4.6.4 Построение таблиц SLR-анализа

4.6.5 Активные префиксы

4.6.6 Упражнения к разделу 4.6

4.7 Более мощные LR-анализаторы

4.7.1 Канонические LR(1)-пункты

4.7.2 Построение множеств LR(1)-пунктов

4.7.3 Канонические таблицы LR(1)-анализа

4.7.4 Построение LALR-таблиц синтаксического анализа

4.7.5 Эффективное построение таблиц LALR-анализа

4.7.6 Уплотнение таблиц LR-анализа

4.7.7 Упражнения к разделу 4.7

4.8 Использование неоднозначных грамматик

4.8.1 Использование приоритетов и ассоциативности для

разрешения конфликтов

4.8.2 Неоднозначность “висящего else”

4.8.3 Восстановление после ошибок в LR-анализе

4.8.4 Упражнения к разделу 4.8

4.9 Генераторы синтаксических анализаторов

4.9.1 Генератор синтаксических анализаторов Yacc

4.9.2 Использование Yacc с неоднозначной грамматикой

4.9.3 Создание лексического анализатора в Yacc

с помощью Lex

4.9.4 Восстановление после ошибок в Yacc

4.9.5 Упражнения к разделу 4.9

4.10 Резюме к главе 4

4.11 Список литературы к главе 4

Глава 5. Синтаксически управляемая трансляция

5.1 Синтаксически управляемые определения

5.1.1 Наследуемые и синтезируемые атрибуты

5.1.2 Вычисление СУО в узлах дерева разбора

5.1.3 Упражнения к разделу 5.1

5.2 Порядок вычисления в СУО

5.2.1 Графы зависимостей

5.2.2 Упорядочение вычисления атрибутов

5.2.3 S-атрибутные определения

5.2.4 L-атрибутные определения

353

357

358

361

363

364

368

371

372

375

375

378

383

384

384

387

390

391

391

393

394

394

12

Содержание

5.2.5

5.3

5.4

5.5

5.6

5.7

Семантические правила с контролируемыми

побочными действиями

5.2.6 Упражнения к разделу 5.2

Применения синтаксически управляемой трансляции

5.3.1 Построение синтаксических деревьев

5.3.2 Структура типа

5.3.3 Упражнения к разделу 5.3

Синтаксически управляемые схемы трансляции

5.4.1 Постфиксные схемы трансляции

5.4.2 Реализация постфиксной СУТ с использованием

стека синтаксического анализатора

5.4.3 СУТ с действиями внутри продукций

5.4.4 Устранение левой рекурсии из СУТ

5.4.5 СУТ для L-атрибутных определений

5.4.6 Упражнения к разделу 5.4

Реализация L-атрибутных СУО

5.5.1 Трансляция в процессе синтаксического анализа

методом рекурсивного спуска

5.5.2 Генерация кода “на лету”

5.5.3 L-атрибутные СУО и LL-синтаксический анализ

5.5.4 Восходящий синтаксический анализ L-атрибутных СУО

5.5.5 Упражнения к разделу 5.5

Резюме к главе 5

Список литературы к главе 5

Глава 6. Генерация промежуточного кода

6.1 Варианты синтаксических деревьев

6.1.1 Ориентированные ациклические графы для выражений

6.1.2 Метод номера значения для построения

ориентированных ациклических графов

6.1.3 Упражнения к разделу 6.1

6.2 Трехадресный код

6.2.1 Адреса и команды

6.2.2 Четверки

6.2.3 Тройки

6.2.4 Представление в виде статических единственных

присваиваний

6.2.5 Упражнения к разделу 6.2

6.3 Типы и объявления

6.3.1 Выражения типов

6.3.2 Эквивалентность типов

396

398

399

400

404

406

406

407

407

410

411

414

421

422

423

425

428

434

439

439

441

443

445

445

447

450

450

450

454

455

457

458

459

459

461

Содержание

6.4

6.5

6.6

6.7

6.8

6.9

6.3.3 Объявления

6.3.4 Размещение локальных имен в памяти

6.3.5 Последовательности объявлений

6.3.6 Поля в записях и классах

6.3.7 Упражнения к разделу 6.3

Трансляция выражений

6.4.1 Операции в выражениях

6.4.2 Инкрементная трансляция

6.4.3 Адресация элементов массива

6.4.4 Трансляция обращений к массиву

6.4.5 Упражнения к разделу 6.4

Проверка типов

6.5.1 Правила проверки типов

6.5.2 Преобразования типов

6.5.3 Перегрузка функций и операторов

6.5.4 Выведение типа и полиморфные функции

6.5.5 Алгоритм унификации

6.5.6 Упражнения к разделу 6.5

Поток управления

6.6.1 Булевы выражения

6.6.2 Код сокращенного вычисления

6.6.3 Инструкции потока управления

6.6.4 Трансляция логических выражений с помощью

потока управления

6.6.5 Устранение излишних команд перехода

6.6.6 Булевы значения и код с переходами

6.6.7 Упражнения к разделу 6.6

Обратные поправки

6.7.1 Однопроходная генерация кода с использованием

обратных поправок

6.7.2 Обратные поправки для булевых выражений

6.7.3 Инструкции потока управления

6.7.4 Инструкции break, continue и goto

6.7.5 Упражнения к разделу 6.7

Инструкции выбора

6.8.1 Трансляция инструкций выбора

6.8.2 Синтаксически управляемая трансляция инструкций

выбора

6.8.3 Упражнения к разделу 6.8

Промежуточный код процедур

13

462

462

464

466

467

468

468

470

471

473

475

477

477

478

481

482

487

490

491

492

492

493

496

499

501

502

504

504

505

508

511

512

514

514

515

517

517

14

Содержание

6.10 Резюме к главе 6

6.11 Список литературы к главе 6

Глава 7. Среды времени выполнения

7.1 Организация памяти

7.1.1 Статическое и динамическое распределение памяти

7.2 Выделение памяти в стеке

7.2.1 Деревья активации

7.2.2 Записи активации

7.2.3 Последовательности вызовов

7.2.4 Данные переменной длины в стеке

7.2.5 Упражнения к разделу 7.2

7.3 Доступ к нелокальным данным в стеке

7.3.1 Доступ к данным при отсутствии вложенных процедур

7.3.2 Вложенные процедуры

7.3.3 Язык с вложенными объявлениями процедур

7.3.4 Глубина вложенности

7.3.5 Связи доступа

7.3.6 Работа со связями доступа

7.3.7 Связи доступа для процедур, являющихся параметрами

7.3.8 Дисплеи

7.3.9 Упражнения к разделу 7.3

7.4 Управление кучей

7.4.1 Диспетчер памяти

7.4.2 Иерархия памяти компьютера

7.4.3 Локальность в программах

7.4.4 Снижение фрагментации

7.4.5 Освобождение памяти вручную

7.4.6 Упражнения к разделу 7.4

7.5 Введение в сборку мусора

7.5.1 Цели проектирования сборщиков мусора

7.5.2 Достижимость

7.5.3 Сборщики мусора с подсчетом ссылок

7.5.4 Упражнения к разделу 7.5

7.6 Введение в сборку на основе отслеживания

7.6.1 Базовый сборщик мусора

7.6.2 Базовая абстракция

7.6.3 Оптимизация алгоритма “пометить и подмести”

7.6.4 Сборщики мусора “пометить и сжать”

7.6.5 Копирующие сборщики

7.6.6 Сравнение стоимости

520

521

525

525

527

528

529

532

535

539

540

542

542

543

544

545

547

548

550

551

554

555

555

557

559

561

565

568

568

569

572

574

576

576

577

580

582

583

587

589

Содержание

7.6.7 Упражнения к разделу 7.6

7.7 Распределенная сборка мусора

7.7.1 Инкрементная сборка мусора

7.7.2 Инкрементный анализ достижимости

7.7.3 Основы частичной сборки

7.7.4 Сборка мусора по поколениям

7.7.5 Алгоритм поезда

7.7.6 Упражнения к разделу 7.7

7.8 Дополнительные вопросы сборки мусора

7.8.1 Параллельная сборка мусора

7.8.2 Частичное перемещение объектов

7.8.3 Консервативная сборка мусора для небезопасных

языков программирования

7.8.4 Слабые ссылки

7.8.5 Упражнения к разделу 7.8

7.9 Резюме к главе 7

7.10 Список литературы к главе 7

Глава 8. Генерация кода

8.1 Вопросы проектирования генератора кода

8.1.1 Вход генератора кода

8.1.2 Целевая программа

8.1.3 Выбор команд

8.1.4 Распределение регистров

8.1.5 Порядок вычислений

8.2 Целевой язык

8.2.1 Простая модель целевой машины

8.2.2 Стоимость программ и команд

8.2.3 Упражнения к разделу 8.2

8.3 Адреса в целевом коде

8.3.1 Статическое выделение памяти

8.3.2 Выделение памяти в стеке

8.3.3 Адреса имен времени выполнения

8.3.4 Упражнения к разделу 8.3

8.4 Базовые блоки и графы потоков

8.4.1 Базовые блоки

8.4.2 Информация о дальнейшем использовании

8.4.3 Графы потоков

8.4.4 Представление графов потоков

8.4.5 Циклы

8.4.6 Упражнения к разделу 8.4

15

590

591

591

593

596

597

599

603

604

605

608

608

609

610

611

614

617

619

619

620

621

623

625

625

625

629

630

632

632

635

638

639

640

641

643

644

646

646

647

16

Содержание

8.5

Оптимизация базовых блоков

8.5.1 Представление базовых блоков с использованием

ориентированных ациклических графов

8.5.2 Поиск локальных общих подвыражений

8.5.3 Устранение неиспользуемого кода

8.5.4 Применение алгебраических тождеств

8.5.5 Представление обращений к массивам

8.5.6 Присваивание указателей и вызовы процедур

8.5.7 Сборка базового блока из ориентированного

ациклического графа

8.5.8 Упражнения к разделу 8.5

8.6 Простой генератор кода

8.6.1 Дескрипторы регистров и адресов

8.6.2 Алгоритм генерации кода

8.6.3 Разработка функции getReg

8.6.4 Упражнения к разделу 8.6

8.7 Локальная оптимизация

8.7.1 Устранение излишних загрузок и сохранений

8.7.2 Устранение недостижимого кода

8.7.3 Оптимизация потока управления

8.7.4 Алгебраические упрощения и снижение стоимости

8.7.5 Использование машинных идиом

8.7.6 Упражнения к разделу 8.7

8.8 Распределение и назначение регистров

8.8.1 Глобальное распределение регистров

8.8.2 Счетчики использований

8.8.3 Назначение регистров для внешних циклов

8.8.4 Распределение регистров путем раскраски графа

8.8.5 Упражнения к разделу 8.8

8.9 Выбор команд путем переписывания дерева

8.9.1 Схемы трансляции деревьев

8.9.2 Генерация кода путем замощения входного дерева

8.9.3 Поиск соответствий с использованием

синтаксического анализа

8.9.4 Программы семантической проверки

8.9.5 Обобщенный поиск соответствий

8.9.6 Упражнения к разделу 8.9

8.10 Генерация оптимального кода для выражений

8.10.1 Числа Ершова

8.10.2 Генерация кода на основе помеченных деревьев

выражений

648

648

649

651

652

653

655

656

658

660

661

661

665

667

668

668

669

670

671

671

671

672

672

673

676

676

677

677

678

681

684

685

686

688

688

689

690

Содержание

8.10.3 Вычисление выражений при недостаточном

количестве регистров

8.10.4 Упражнения к разделу 8.10

8.11 Генерация кода с использованием динамического

программирования

8.11.1 Последовательные вычисления

8.11.2 Алгоритм динамического программирования

8.11.3 Упражнения к разделу 8.11

8.12 Резюме к главе 8

8.13 Список литературы к главе 8

Глава 9. Машинно-независимые оптимизации

9.1 Основные источники оптимизации

9.1.1 Причины избыточности

9.1.2 Конкретный пример: быстрая сортировка

9.1.3 Трансформации, сохраняющие семантику

9.1.4 Глобальные общие подвыражения

9.1.5 Распространение копий

9.1.6 Удаление бесполезного кода

9.1.7 Перемещение кода

9.1.8 Переменные индукции и снижение стоимости

9.1.9 Упражнения к разделу 9.1

9.2 Введение в анализ потоков данных

9.2.1 Абстракция потока данных

9.2.2 Схема анализа потока данных

9.2.3 Схемы потоков данных в базовых блоках

9.2.4 Достигающие определения

9.2.5 Анализ активных переменных

9.2.6 Доступные выражения

9.2.7 Резюме

9.2.8 Упражнения к разделу 9.2

9.3 Основы анализа потока данных

9.3.1 Полурешетки

9.3.2 Передаточные функции

9.3.3 Итеративный алгоритм в обобщенной структуре

9.3.4 Смысл решения потока данных

9.3.5 Упражнения к разделу 9.3

9.4 Распространение констант

9.4.1 Значения потока данных для структуры

распространения констант

9.4.2 Сбор в структуре распространения констант

17

692

694

695

696

697

700

700

702

705

706

706

707

710

710

712

713

714

715

718

719

720

722

723

725

733

735

740

740

743

744

750

753

755

759

760

761

762

18

Содержание

9.4.3

Передаточные функции для структуры

распространения констант

9.4.4 Монотонность структуры распространения констант

9.4.5 Недистрибутивность структуры распространения

констант

9.4.6 Интерпретация результатов

9.4.7 Упражнения к разделу 9.4

9.5 Устранение частичной избыточности

9.5.1 Источники избыточности

9.5.2 Все ли избыточные вычисления могут быть устранены?

9.5.3 Отложенное перемещение кода

9.5.4 Ожидаемость выражений

9.5.5 Алгоритм отложенного перемещения кода

9.5.6 Упражнения к разделу 9.5

9.6 Циклы в графах потоков

9.6.1 Доминаторы

9.6.2 Упорядочение в глубину

9.6.3 Ребра в глубинном остовном дереве

9.6.4 Обратные ребра и приводимость

9.6.5 Глубина графа потока

9.6.6 Естественные циклы

9.6.7 Скорость сходимости итеративных алгоритмов

потоков данных

9.6.8 Упражнения к разделу 9.6

9.7 Анализ на основе областей

9.7.1 Области

9.7.2 Иерархии областей для приводимых графов потоков

9.7.3 Обзор анализа на основании областей

9.7.4 Необходимые предположения о передаточных функциях

9.7.5 Алгоритм анализа на основе областей

9.7.6 Обработка неприводимых графов потоков

9.7.7 Упражнения к разделу 9.7

9.8 Символический анализ

9.8.1 Аффинные выражения ссылочных переменных

9.8.2 Формулировка задачи потока данных

9.8.3 Символический анализ на основе областей

9.8.4 Упражнения к разделу 9.8

9.9 Резюме к главе 9

9.10 Список литературы к главе 9

762

763

764

765

767

768

769

771

773

774

775

785

787

787

790

792

794

795

796

798

801

803

804

805

808

810

811

816

818

819

819

822

827

832

833

838

Содержание

Глава 10. Параллелизм на уровне команд

10.1 Архитектуры процессоров

10.1.1 Конвейерная обработка команд и задержки ветвления

10.1.2 Конвейерное выполнение

10.1.3 Многоадресные команды

10.2 Ограничения планирования кода

10.2.1 Зависимость через данные

10.2.2 Поиск зависимостей среди обращений к памяти

10.2.3 Компромиссы между использованием регистров

и параллелизмом

10.2.4 Упорядочение фаз распределения регистров

и планирования кода

10.2.5 Зависимость от управления

10.2.6 Поддержка опережающего выполнения

10.2.7 Базовая модель машины

10.2.8 Упражнения к разделу 10.2

10.3 Планирование базовых блоков

10.3.1 Графы зависимости данных

10.3.2 Планирование списков базовых блоков

10.3.3 Приоритетные топологические порядки

10.3.4 Упражнения к разделу 10.3

10.4 Глобальное планирование кода

10.4.1 Примитивное перемещение кода

10.4.2 Восходящее перемещение кода

10.4.3 Нисходящее перемещение кода

10.4.4 Обновление зависимостей данных

10.4.5 Алгоритм глобального планирования

10.4.6 Усовершенствованные методы перемещения кода

10.4.7 Взаимодействие с динамическими планировщиками

10.4.8 Упражнения к разделу 10.4

10.5 Программная конвейеризация

10.5.1 Введение

10.5.2 Программная конвейеризация циклов

10.5.3 Распределение регистров и генерация кода

10.5.4 Циклы с зависимыми итерациями

10.5.5 Цели и ограничения программной конвейеризации

10.5.6 Алгоритм программной конвейеризации

10.5.7 Планирование ациклических графов зависимости

данных

10.5.8 Планирование графов с циклическими зависимостями

10.5.9 Усовершенствования алгоритма конвейеризации

19

841

842

842

843

844

845

846

846

848

851

852

853

855

856

857

858

859

861

863

864

865

867

868

870

870

874

875

876

876

877

879

882

883

884

888

889

891

899

20

Содержание

10.5.10 Модульное расширение переменных

10.5.11 Условные инструкции

10.5.12 Аппаратная поддержка программной конвейеризации

10.5.13 Упражнения к разделу 10.5

10.6 Резюме к главе 10

10.7 Список литературы к главе 10

900

903

904

904

907

909

Глава 11. Оптимизация параллелизма и локальности

11.1 Фундаментальные концепции

11.1.1 Многопроцессорность

11.1.2 Параллелизм в приложениях

11.1.3 Параллелизм на уровне циклов

11.1.4 Локальность данных

11.1.5 Введение в теорию аффинных преобразований

11.2 Пример посерьезнее: умножение матриц

11.2.1 Алгоритм умножения матриц

11.2.2 Оптимизации

11.2.3 Интерференция кэша

11.2.4 Упражнения к разделу 11.2

11.3 Пространства итераций

11.3.1 Построение пространств итераций вложений циклов

11.3.2 Порядок выполнения вложенности циклов

11.3.3 Матричная запись неравенств

11.3.4 Добавление символьных констант

11.3.5 Управление порядком выполнения

11.3.6 Изменение осей

11.3.7 Упражнения к разделу 11.3

11.4 Аффинные индексы массивов

11.4.1 Аффинные обращения к данным

11.4.2 Аффинное и неаффинное обращения на практике

11.4.3 Упражнения к разделу 11.4

11.5 Повторное использование данных

11.5.1 Типы повторных использований

11.5.2 Собственные повторные использования

11.5.3 Собственное пространственное повторное

использование

11.5.4 Групповое повторное использование

11.5.5 Упражнения к разделу 11.5

11.6 Анализ зависимости данных в массивах

11.6.1 Определение зависимостей данных доступов к массивам

11.6.2 Целочисленное линейное программирование

911

914

914

917

918

920

922

927

927

930

933

933

934

934

936

938

938

939

944

945

948

948

949

950

951

952

953

958

959

962

964

965

966

Содержание

11.7

11.8

11.9

11.10

11.6.3 НОД

11.6.4 Эвристики для решения задачи целочисленного

линейного программирования

11.6.5 Решение обобщенной задачи целочисленного

линейного программирования

11.6.6 Резюме

11.6.7 Упражнения к разделу 11.6

Поиск параллельности, не требующей синхронизации

11.7.1 Вводный пример

11.7.2 Разбиения аффинного пространства

11.7.3 Ограничения разбиений пространства

11.7.4 Решение ограничений разбиений пространств

11.7.5 Простой алгоритм генерации кода

11.7.6 Устранение пустых итераций

11.7.7 Устранение проверок из внутреннего цикла

11.7.8 Преобразования исходного кода

11.7.9 Упражнения к разделу 11.7

Синхронизация между параллельными циклами

11.8.1 Постоянное количество синхронизаций

11.8.2 Графы зависимостей программ

11.8.3 Иерархическое время

11.8.4 Алгоритм распараллеливания

11.8.5 Упражнения к разделу 11.8

Конвейеризация

11.9.1 Что такое конвейеризация

11.9.2 Последовательная сверхрелаксация: пример

11.9.3 Полностью переставляемые циклы

11.9.4 Конвейеризация полностью переставляемых циклов

11.9.5 Общая теория

11.9.6 Ограничения временного разбиения

11.9.7 Решение временны́х ограничений с использованием

леммы Фаркаша

11.9.8 Преобразования кода

11.9.9 Параллелизм с минимальной синхронизацией

11.9.10 Упражнения к разделу 11.9

Оптимизации локальности

11.10.1 Временна́я локальность вычисляемых данных

11.10.2 Сжатие массива

11.10.3 Чередование частей

11.10.4 Алгоритмы оптимизации локальности

11.10.5 Упражнения к разделу 11.10

21

967

969

973

975

976

978

978

981

982

986

990

993

996

998

1003

1005

1006

1007

1009

1012

1013

1013

1014

1016

1017

1018

1021

1022

1026

1029

1035

1037

1039

1040

1041

1044

1047

1050

22

Содержание

11.11 Прочие применения аффинных преобразований

11.11.1 Машины с распределенной памятью

11.11.2 Процессоры с одновременным выполнением

нескольких команд

11.11.3 Векторные и SIMD-команды

11.11.4 Предвыборка

11.12 Резюме к главе 11

11.13 Список литературы к главе 11

Глава 12. Межпроцедурный анализ

12.1 Базовые концепции

12.1.1 Графы вызовов

12.1.2 Чувствительность к контексту

12.1.3 Строки вызовов

12.1.4 Контекстно-чувствительный анализ на основе

клонирования

12.1.5 Контекстно-чувствительный анализ на основе резюме

12.1.6 Упражнения к разделу 12.1

12.2 Необходимость межпроцедурного анализа

12.2.1 Вызовы виртуальных методов

12.2.2 Анализ псевдонимов указателей

12.2.3 Параллельность

12.2.4 Поиск программных ошибок и уязвимых мест

12.2.5 SQL-ввод

12.2.6 Переполнение буфера

12.3 Логическое представление потока данных

12.3.1 Введение в Datalog

12.3.2 Правила Datalog

12.3.3 Интенсиональные и экстенсиональные предикаты

12.3.4 Выполнение программы Datalog

12.3.5 Инкрементное вычисление программ Datalog

12.3.6 Проблематичные правила Datalog

12.3.7 Упражнения к разделу 12.3

12.4 Простой алгоритм анализа указателей

12.4.1 Сложность анализа указателей

12.4.2 Модель указателей и ссылок

12.4.3 Нечувствительность к потоку

12.4.4 Формулировка с применением Datalog

12.4.5 Использование информации о типе

12.4.6 Упражнения к разделу 12.4

12.5 Контекстно-нечувствительный межпроцедурный анализ

1050

1050

1051

1052

1053

1054

1057

1061

1062

1062

1064

1067

1069

1070

1073

1075

1076

1076

1077

1077

1078

1080

1081

1082

1083

1085

1088

1090

1091

1093

1095

1096

1097

1098

1099

1101

1102

1105

Содержание

12.6

12.7

12.8

12.9

12.5.1 Влияние вызовов методов

12.5.2 Построение графа вызовов в Datalog

12.5.3 Динамическая загрузка и отражение

12.5.4 Упражнения к разделу 12.5

Контекстно-чувствительный анализ указателей

12.6.1 Контексты и строки вызовов

12.6.2 Добавление контекста в правила Datalog

12.6.3 Дополнительные наблюдения о чувствительности

12.6.4 Упражнения к разделу 12.6

Реализация Datalog с применением BDD

12.7.1 Диаграммы бинарного выбора

12.7.2 Преобразования диаграмм бинарного выбора

12.7.3 Представление отношений при помощи BDD

12.7.4 Операции отношений и BDD-операции

12.7.5 Использование диаграмм бинарного выбора для

анализа целей указателей

12.7.6 Упражнения к разделу 12.7

Резюме к главе 12

Список литературы к главе 12

23

1105

1107

1108

1109

1109

1110

1113

1114

1115

1115

1116

1118

1119

1120

1123

1124

1124

1128

Приложение А. Завершенный пример начальной стадии компилятора

А.1 Исходный язык

А.2 Main

А.3 Лексический анализатор

А.4 Таблицы символов и типы

А.5 Промежуточный код выражений

А.6 Переходы для булевых выражений

А.7 Промежуточный код для инструкций

А.8 Синтаксический анализатор

А.9 Построение начальной стадии

1133

1133

1135

1135

1139

1140

1144

1149

1153

1160

Приложение Б. Поиск линейно независимых решений

1163

Предметный указатель

1167

Предисловие

Со времени написания первого издания книги в 1986 году в мире разработки компиляторов произошли значительные изменения. Языки программирования

эволюционировали и перед разработчиками возникли новые проблемы. Архитектура компьютеров предлагает массу различных вычислительных ресурсов, которые для получения наивысших результатов должен использовать разработчик

компилятора. Пожалуй, наиболее интересно то, что методы оптимизации кода

нашли применение не только в компиляторах. В настоящее время они используются в инструментарии для поиска ошибок в программном обеспечении и, что

особенно важно, при проверке безопасности существующего кода. Большинство

других методов — грамматика, регулярные выражения, синтаксические анализаторы и синтаксически управляемые трансляторы — также широко используются

не только при разработке компиляторов.

Таким образом, наш подход остался тем же, что и в предыдущих версиях

книги. Мы отдаем себе отчет в том, что лишь малая доля наших читателей будет

заниматься разработкой или хотя бы поддержкой компилятора для какого-то из

основных языков программирования. Однако модели, теория и алгоритмы, связанные с компиляторами, могут применяться для решения широкого диапазона

задач проектирования и разработки программного обеспечения. Таким образом,

мы уделяем особое внимание задачам, которые обычно встречаются при разработке языковых процессоров, независимо от исходного языка или целевой машины.

Использование данной книги

Требуется примерно два семестра, чтобы охватить весь (или, по крайней мере,

бо́льшую часть) материал данной книги. Обычно первая половина книги служит

предметом изучения студентов на первых курсах, в то время как вторая, посвященная оптимизации кода, изучается на старших курсах.

Вот краткое содержание глав книги.

В главе 1 содержится, в основном, мотивационный материал, и при этом раскрываются некоторые базовые вопросы архитектуры компьютера и принципов

языков программирования.

Предисловие

25

В главе 2 разрабатывается миниатюрный компилятор и вводится множество

новых концепций, которые будут затем детально рассмотрены в последующих

главах. Сам компилятор вы найдете в приложении А.

Глава 3 посвящена лексическому анализу, регулярным выражениям, конечным

автоматам и инструментарию для создания сканеров входного потока. Материал

этой главы может быть широко использован при разработке текстовых редакторов.

В главе 4 приведены различные методы синтаксического анализа, нисходящие

(рекурсивного спуска, LL) и восходящие (LR и его варианты).

В главе 5 вы познакомитесь с принципиальными идеями синтаксически управляемых определений и трансляции.

В главе 6 показано, как теория из главы 5 применяется для генерации промежуточного кода в типичном языке программирования.

В главе 7 обсуждаются вопросы сред времени выполнения, в частности управление стеком и сборка мусора.

Глава 8 посвящена генерации объектного кода. В ней рассматриваются построение базовых блоков, генерация кода из выражений и базовых блоков и методы

распределения регистров.

Глава 9 служит введением в методы оптимизации кода, включая потоковые

графы, структуры потоков данных и итеративные алгоритмы для их разрешения.

В главе 10 рассматривается оптимизация на уровне команд. Основной упор

делается на поиск возможностей параллельного вычисления в небольших последовательностях команд и их диспетчеризация для процессоров, способных выполнять несколько команд одновременно.

Глава 11 посвящена поиску крупномасштабной параллельности вычислений

и ее использованию. Здесь упор делается на числовой код, который содержит

связанные циклы, работающие с многомерными массивами.

В главе 12 речь идет о межпроцедурном анализе: анализе указателей, использовании псевдонимов и анализе потоков данных, которые принимают во внимание

последовательность вызовов процедур, достигающих данной точки кода.

Материал данной книги изучался в нескольких университетах — Колумбии,

Гарварде и Стенфорде. В Колумбии в учебных курсах для первокурсников по

языкам программирования и трансляторам регулярно использовался материал

глав 1–8. Основным заданием данного курса являлось написание курсовой работы, выполняющейся небольшими группами студентов и состоящей в реализации

небольшого языка программирования, спроектированного ими самостоятельно.

Разработанные таким образом языки ориентированы на применение в различных

областях, включая квантовые вычисления, генерацию музыки, компьютерную графику, игры, операции с матрицами и многое другое. В своей работе студенты использовали генераторы компонентов компиляторов, такие как ANTLR, Lex и Yacc,

и методы синтаксически управляемой трансляции, рассматривающиеся в главах 2

и 5. Курс для старшекурсников основывался на материале глав 9–12, и основ-

26

Предисловие

ной упор делался на генерацию кода и оптимизацию для современных машин,

включая сетевую и многопроцессорную архитектуры.

В Стенфорде краткий вводный курс охватывал материал приблизительно

глав 1–8, хотя в нем было и введение в вопросы глобальной оптимизации, основанное на материале главы 9. Второй курс, посвященный компиляторам, охватывал

главы 9–12, а также материал по сборке мусора из главы 7. Студенты использовали местную систему Joeq на основе Java для реализации алгоритмов анализа

потоков данных.

Необходимые требования

Читатель должен владеть определенными знаниями в области информатики,

включая, по меньшей мере, курс по программированию и курсы по структурам

данных и дискретной математике. Полезно также знать несколько различных языков программирования.

Упражнения

Практически в каждом разделе книги содержится большое количество упражнений. Более сложные упражнения отмечены одним восклицательным знаком,

а самые сложные — двумя.

Поддержка в Интернете

Начальная страница книги находится по адресу

dragonbook.stanford.edu

Здесь вы можете найти список обнаруженных ошибок и исправлений (http:

//www-db.stanford.edu/~ullman/dragon/errata.html) и дополнительные материалы к книге. Мы надеемся сделать общедоступной информацию

по всем курсам, посвященным компиляторам, которые мы ведем, включая домашние задания, решения задач и экзаменационные вопросы. Мы также планируем

сделать доступной информацию о важных компиляторах, предоставленную их

разработчиками.

Благодарности

Благодарим дизайнера обложки — С.Д. Ульман (S.D. Ullman) из Strange Tonic

Productions.

Джон Бентли (Jon Bentley) основательно помог своими комментариями ряда

глав книги, когда она находилась еще на стадии черновика.

Полезные комментарии и исправления ошибок были сделаны следующими

людьми.

Предисловие

27

Доменико Бьянкулли (Domenico Bianculli), Питер Бош (Peter Bosch), Марцио

Басс (Marcio Buss), Марк Идди (Marc Eaddy), Стефен Эдвардс (Stephen Edwards),

Вибхав Гарг (Vibhav Garg), Ким Хазельвуд (Kim Hazelwood), Гурав Кц (Gaurav

Kc), Вей Ли (Wei Li), Майк Смит (Mike Smith), Арт Стамнесс (Art Stamness),

Криста Свор (Krysta Svore), Оливер Тардью (Olivier Tardieu) и Джия Зенг (Jia

Zeng).

Мы благодарим всех их за помощь. Все оставшиеся в книге ошибки остаются

на нашей совести.

Кроме того, Моника благодарит своих коллег по работе над компилятором

SUIF за 18-летнее обучение. Это Джеральд Айнер (Gerald Aigner), Дзинтарс

Авотс (Dzintars Avots), Саман Амарасингх (Saman Amarasinghe), Дженнифер Андерсон (Jennifer Anderson), Майкл Карбин (Michael Carbin), Джеральд Чинг (Gerald Cheong), Амер Диван (Amer Diwan), Роберт Френч (Robert French), Анвар

Гулом (Anwar Ghuloum), Мери Холл (Mary Hall), Джон Хеннеси (John Hennessy),

Девид Гейне (David Heine), Ших-Вей Лао (Shih-Wei Liao), Ами Лим (Amy Lim),

Бенджамин Лившиц (Benjamin Livshits), Майкл Мартин (Michael Martin), Дрор

Майдан (Dror Maydan), Тодд Моури (Todd Mowry), Брайан Мерфи (Brian Murphy), Джеффри Оплингер (Jeffrey Oplinger), Карен Пипер (Karen Pieper), Мартин

Ринард (Martin Rinard), Олатунджи Рувасе (Olatunji Ruwase), Константине Сапунцакис (Constantine Sapuntzakis), Патрик Сатьянатан (Patrick Sathyanathan), Майкл

Смит (Michael Smith), Стивен Тжианг (Steven Tjiang), Чау-Вен Ценг (Chau-Wen

Tseng), Кристофер Анкель (Christopher Unkel), Джон Воли (John Whaley), Роберт

Вильсон (Robert Wilson), Кристофер Вильсон (Christopher Wilson) и Майкл Вольф

(Michael Wolf).

A. V. A., Чатмен, Нью-Джерси

M. S. L., Менло-Парк, Калифорния

R. S., Фар-Хиллс, Нью-Джерси

J. D. U., Стенфорд, Калифорния

Июнь, 2006

28

Предисловие

От издательства

Вы, читатель этой книги, и есть главный ее критик и комментатор. Мы ценим

ваше мнение и хотим знать, что было сделано нами правильно, что можно было

сделать лучше и что еще вы хотели бы увидеть изданным нами. Нам интересно

услышать и любые другие замечания, которые вам хотелось бы высказать в наш

адрес.

Мы ждем ваших комментариев и надеемся на них. Вы можете прислать нам

бумажное или электронное письмо, либо просто посетить наш Web-сервер и оставить свои замечания там. Одним словом, любым удобным для вас способом дайте

нам знать, нравится или нет вам эта книга, а также выскажите свое мнение о том,

как сделать наши книги более интересными для вас.

Посылая письмо или сообщение, не забудьте указать название книги и ее авторов, а также ваш обратный адрес. Мы внимательно ознакомимся с вашим мнением

и обязательно учтем его при отборе и подготовке к изданию последующих книг.

Наши координаты:

E-mail:

info@williamspublishing.com

WWW:

http://www.williamspublishing.com

Информация для писем

из России:

из Украины:

127055, Москва, ул. Лесная, д. 43, стр.1

03150, Киев, а/я 152

ГЛАВА 1

Введение в компиляцию

Языки программирования представляют собой средство описания вычислений

для людей и машин. Современный мир зависит от языков программирования,

поскольку все программное обеспечение на всех компьютерах мира написано на

том или ином языке программирования. Однако, прежде чем запустить программу,

ее необходимо преобразовать в форму, которая может выполняться на компьютере.

Программные системы, выполняющие такое преобразование, называются компиляторами.

Эта книга о том, как разрабатывать и реализовывать компиляторы. Вы узнаете,

что для построения трансляторов для широкого диапазона языков и машин могут

использоваться всего несколько базовых идей. Принципы и методы проектирования компиляторов применимы в таком количестве многих других областей, что

только редкий ученый-кибернетик не столкнется с ними множество раз в процессе своей деятельности. Изучение написания компиляторов требует обращения

к таким темам, как языки программирования, архитектура компьютера, теория

языков, алгоритмы, разработка программного обеспечения.

В этой вступительной главе вы познакомитесь с различными видами трансляторов, структурой типичного компилятора и узнаете о тенденциях развития языков

программирования и архитектуры вычислительных систем и их влиянии на компиляторы. Здесь также рассматриваются вопросы взаимодействия проектирования

компиляторов и теоретической информатики и применения методов разработки

компиляторов, выходящих за рамки компиляции. Завершится этот краткий обзор

рассмотрением ключевых концепций языков программирования, которые будут

необходимы при изучении компиляторов.

1.1 Компиляторы

Попросту говоря, компилятор — это программа, которая считывает текст программы, написанной на одном языке — исходном, и транслирует (переводит) его

в эквивалентный текст на другом языке — целевом (рис. 1.1). Одна из важных

ролей компилятора состоит в сообщении об ошибках в исходной программе, обнаруженных в процессе трансляции.

30

Глава 1. Введение в компиляцию

Если целевая программа представляет собой программу на машинном языке,

она затем может быть вызвана пользователем для обработки некоторых входных

данных и получения некоторых выходных данных (рис. 1.2).

Исходная программа

Компилятор

Входные данные

Целевая программа

Выходные данные

Целевая программа

Рис. 1.1. Компилятор

Рис. 1.2. Выполнение целевой программы

Интерпретатор представляет собой еще один распространенный вид языкового процессора. Вместо получения целевой программы, как в случае транслятора, интерпретатор непосредственно выполняет операции, указанные в исходной

программе, над входными данными, предоставляемыми пользователем (рис. 1.3).

Исходная программа

Входные данные

Интерпретатор

Выходные данные

Рис. 1.3. Интерпретатор

Целевая программа на машинном языке, производимая компилятором, обычно гораздо быстрее, чем интерпретатор, получает выходные данные на основании

входных. Однако интерпретатор обычно обладает лучшими способностями к диагностике ошибок, чем компилятор, поскольку он выполняет исходную программу

инструкция за инструкцией.1

Пример 1.1. Языковой процессор Java объединяет в себе и компиляцию, и интерпретацию (рис. 1.4). Исходная программа на Java может сначала компилироваться

в промежуточный вид, именуемый байт-кодом (bytecode). Затем байт-код интерпретируется виртуальной машиной. Преимущество такого решения в том, что

скомпилированный на одной машине байт-код может быть выполнен на другой,

например, будучи передан по сети.

1

Обращаем ваше внимание на перевод термина statement в данной книге. Дословно он означает

высказывание, утверждение, однако в применении к компьютерной тематике это не совсем удачно.

Обычно при переводе используется термин оператор, но в данной книге, посвященной формальным

языкам, этот термин имеет собственное значение. Поэтому при переводе термина statement за

редкими исключениями было использовано понятие инструкция — как наиболее близкое по смыслу,

так и использовавшееся в переводе предыдущего издания книги (А. Ахо, Р. Сети, Д. Ульман.

Компиляторы: принципы, технологии и инструменты. — М.: Издательский дом “Вильямс”, 2001). —

Прим. пер.

31

1.1. Компиляторы

Для более быстрой обработки входных данных некоторые компиляторы Java,

именуемые just-in-time-компиляторами, транслируют байт-код в машинный язык

непосредственно перед запуском промежуточной программы для обработки входных данных.

2

Исходная программа

Транслятор

Промежуточная программа

Входные данные

Виртуальная

машина

Выходные данные

Рис. 1.4. Гибридный компилятор

Кроме компиляторов, потребовать создания выполнимой целевой программы

могут и другие программы (рис. 1.5). Исходная программа может быть разделена на модули, находящиеся в различных файлах. Сборка исходной программы

иногда поручается отдельной программе, именуемой препроцессором. ПрепроцесИсходная программа

Препроцессор

Модифицированная исходная программа

Компилятор

Целевая ассемблерная программа

Ассемблер

Перемещаемый машинный код

Компоновщик/Загрузчик

Библиотечные файлы

Перемещаемые объектные файлы

Целевой машинный код

Рис. 1.5. Система обработки языка

32

Глава 1. Введение в компиляцию

сор может также раскрывать сокращения, именуемые макросами, в инструкции

исходного языка.

Модифицированная исходная программа затем передается компилятору. Компилятор может выдать в качестве выходных данных программу на языке ассемблера, поскольку ассемблерный код легче создать и проще отлаживать. Язык ассемблера затем обрабатывается программой, которая называется ассемблер, и дает

в качестве выходных данных перемещаемый машинный код.

Большие программы зачастую компилируются по частям, так что перемещаемый машинный код должен быть скомпонован совместно с другими перемещаемыми объектными файлами и библиотечными файлами в код, который можно

будет выполнять на данной машине. Компоновщик (“линкер”) выполняет разрешение внешних адресов памяти, по которым код из одного файла может обращаться

к информации из другого файла. Загрузчик затем помещает все выполнимые объектные файлы в память для выполнения.

1.1.1 Упражнения к разделу 1.1

Упражнение 1.1.1. В чем заключается разница между компилятором и интерпретатором?

Упражнение 1.1.2. Каковы преимущества (а) компилятора перед интерпретатором и (б) интерпретатора перед компилятором?

Упражнение 1.1.3. Каковы преимущества системы обработки языка, в которой

компилятор дает выход на языке ассемблера, по сравнению с системой, в которой

компилятор дает выход на машинном языке?

Упражнение 1.1.4. Компилятор, который транслирует программу на высокоуровневом языке программирования в программу на другом высокоуровневом языке программирования, называется транслятором из исходного текста в исходный

текст (source-to-source). Каковы преимущества использования языка программирования C в качестве целевого для такого компилятора?

Упражнение 1.1.5. Опишите некоторые из задач, которые должен выполнять ассемблер.

1.2 Структура компилятора

Пока что мы рассматривали компилятор как “черный ящик”, отображающий

исходную программу в семантически эквивалентную ей целевую программу. Если

мы немного приоткроем этот ящик, то увидим, что это отображение разделяется

на две части: анализ и синтез.

Анализ разбивает исходную программу на составные части и накладывает на

них грамматическую структуру. Затем он использует эту структуру для создания

1.2. Структура компилятора

33

промежуточного представления исходной программы. Если анализ обнаруживает,

что исходная программа неверно составлена синтаксически либо дефектна семантически, он должен выдать информативные сообщения об этом, чтобы пользователь мог исправить обнаруженные ошибки. Анализ также собирает информацию

об исходной программе и сохраняет ее в структуре данных, именуемой таблицей

символов, которая передается вместе с промежуточным представлением синтезу.

Синтез строит требуемую целевую программу на основе промежуточного

представления и информации из таблицы символов. Анализ часто называют начальной стадией (front end), а синтез — заключительной (back end).

Если рассмотреть процесс компиляции более детально, можно увидеть, что

он представляет собой последовательность фаз, каждая из которых преобразует одно из представлений исходной программы в другое. Типичное разложение

компилятора на фазы приведено на рис. 1.6. На практике некоторые фазы могут

объединяться, а межфазное промежуточное представление может не строиться

явно. Таблица символов, в которой хранится информация обо всей исходной программе, используется всеми фазами компилятора.

Некоторые компиляторы содержат фазу машинно-независимой оптимизации

между анализом и синтезом. Назначение этой оптимизации — преобразовать промежуточное представление, чтобы синтез мог получить более качественную целевую программу по сравнению с той, которая может быть получена из неоптимизированного промежуточного представления. Поскольку оптимизация необязательна, некоторые фазы оптимизации, показанные на рис. 1.6, в компиляторе могут

отсутствовать.

1.2.1 Лексический анализ

Первая фаза компиляции называется лексическим анализом или сканированием. Лексический анализатор читает поток символов, составляющих исходную

программу, и группирует эти символы в значащие последовательности, называющиеся лексемами. Для каждой лексемы анализатор строит выходной токен (token)

вида

имя_токена, значение_атрибута

Он передается последующей фазе, синтаксическому анализу. Первый компонент

токена, имя_токена, представляет собой абстрактный символ, использующийся во время синтаксического анализа, а второй компонент, значение_атрибута,

указывает на запись в таблице символов, соответствующую данному токену. Информация из записи в таблице символов необходима для семантического анализа

и генерации кода.

Предположим, например, что исходная программа содержит инструкцию присваивания

position = initial + rate * 60

(1.1)

34

Глава 1. Введение в компиляцию

Поток символов

Лексический анализатор

Поток токенов

Синтаксический анализатор

Синтаксическое дерево

Семантический анализатор

Синтаксическое дерево

Таблица символов

Генератор промежуточного кода

Промежуточное представление

Машинно:независимый

оптимизатор кода

Промежуточное представление

Генератор кода

Код целевой машины

Машинно:зависимый

оптимизатор кода

Код целевой машины

Рис. 1.6. Фазы компилятора

Символы в этом присваивании могут быть сгруппированы в следующие лексемы

и отображены в следующие токены, передаваемые синтаксическому анализатору.

1. position представляет собой лексему, которая может отображаться в токен id, 1, где id — абстрактный символ, обозначающий идентификатор,

а 1 указывает запись в таблице символов для position. Запись таблицы символов для некоторого идентификатора хранит информацию о нем,

такую как его имя и тип.

35

1.2. Структура компилятора

2. Символ присваивания = представляет собой лексему, которая отображается

в токен =. Поскольку этот токен не требует значения атрибута, второй

компонент данного токена опущен. В качестве имени токена может быть

использован любой абстрактный символ, например такой, как assign, но

для удобства записи мы будем использовать в качестве имени абстрактного

символа саму лексему.

3. initial представляет собой лексему, которая отображается в токен id, 2,

где 2 указывает на запись в таблице символов для initial.

4. + является лексемой, отображаемой в токен +.

5. rate — лексема, отображаемая в токен id, 3, где 3 указывает на запись

в таблице символов для rate.

6. * — лексема, отображаемая в токен ∗.

7. 60 — лексема, отображаемая в токен 60.2

Пробелы, разделяющие лексемы, лексическим анализатором отбрасываются.

На рис. 1.7 показано представление инструкции присваивания (1.1) после лексического анализа в виде последовательности токенов

id1 = id2 + id3 ∗ 60

(1.2)

При этом представлении имена токенов =, + и * представляют собой абстрактные

символы для операторов присваивания, сложения и умножения соответственно.

1.2.2 Синтаксический анализ

Вторая фаза компилятора — синтаксический анализ или разбор (parsing). Анализатор использует первые компоненты токенов, полученных при лексическом

анализе, для создания древовидного промежуточного представления, которое описывает грамматическую структуру потока токенов. Типичным представлением является синтаксическое дерево, в котором каждый внутренний узел представляет

операцию, а дочерние узлы — аргументы этой операции. Синтаксическое дерево для потока токенов (1.2) показано на выходе синтаксического анализатора на

рис. 1.7.

2

Технически говоря, для лексемы 60 мы должны создать токен наподобие number, 4, где

4 указывает на запись таблицы символов для внутреннего представления целого числа 60, но

обсуждение токенов для чисел мы отложим до главы 2. В главе 3 будут рассмотрены методы

построения лексических анализаторов.

36

Глава 1. Введение в компиляцию

Лексический анализатор

áid,

1ñ á=ñ áid, 2ñ á+ñ áid, 3ñ á*ñ á60ñ

Синтаксический анализатор

=

áid,

+

1ñ

áid,

2ñ

*

áid,

3ñ

60

Семантический анализатор

=

1

2

3

áid,

+

1ñ

áid,

*

2ñ

áid,

3ñ

inttofloat

60

Генератор промежуточного кода

Таблица символов

Оптимизатор кода

Генератор кода

! "#

Рис. 1.7. Трансляция инструкции присваивания

1.2. Структура компилятора

37

Это дерево указывает порядок, в котором выполняются операции в присваивании

position = initial + rate * 60

Дерево имеет внутренний узел, помеченный *, левым дочерним узлом которого

является id, 3, а правым — 60. Узел id, 3 представляет идентификатор rate.

Узел, помеченный *, явно указывает, что сначала мы должны умножить значение

rate на 60. Узел, помеченный +, указывает, что мы должны прибавить результат

умножения к значению initial. Корень дерева с меткой = говорит о том, что

следует присвоить результат этого сложения в позиции памяти, отведенной идентификатору position. Порядок операций согласуется с обычными арифметическими правилами, которые говорят о том, что умножение имеет более высокий

приоритет, чем сложение, и должно быть выполнено до сложения.

Последующие фазы компилятора используют грамматическую структуру, которая помогает проанализировать исходную и сгенерировать целевую программу.

В главе 4 мы будем использовать контекстно-свободные грамматики для определения грамматической структуры языков программирования и рассмотрим алгоритмы автоматического построения эффективных синтаксических анализаторов

для определенных классов грамматик. Из глав 2 и 5 вы узнаете, что синтаксически управляемые определения могут помочь уточнить трансляцию конструкций

языка программирования.

1.2.3 Семантический анализ

Семантический анализатор использует синтаксическое дерево и информацию

из таблицы символов для проверки исходной программы на семантическую согласованность с определением языка. Он также собирает информацию о типах

и сохраняет ее в синтаксическом дереве или в таблице символов для последующего использования в процессе генерации промежуточного кода.

Важной частью семантического анализа является проверка типов, когда компилятор проверяет, имеет ли каждый оператор операнды соответствующего типа.

Например, многие определения языков программирования требуют, чтобы индекс массива был целым числом; компилятор должен сообщить об ошибке, если

в качестве индекса массива используется число с плавающей точкой.

Спецификация языка может разрешать определенные преобразования типов,

именуемые приведениями (coercion). Например, бинарный арифметический оператор может быть применен либо к паре целых чисел, либо к паре чисел с плавающей точкой. Если такой оператор применен к числу с плавающей точкой

и целому числу, то компилятор может выполнить преобразование целого числа

в число с плавающей точкой.

38

Глава 1. Введение в компиляцию

Такое приведение показано на рис. 1.7. Предположим, что position,

initial и rate были объявлены как числа с плавающей точкой и что лексема

60 образует целое число. Проверка типов в семантическом анализаторе на рис. 1.7

определяет, что оператор * применяется к числу с плавающей точкой rate и целому числу 60. В этом случае целое число может быть преобразовано в число

с плавающей точкой. Обратите внимание, что на рис. 1.7 в синтаксическом дереве, полученном на выходе семантического анализатора, имеется дополнительный

узел для оператора inttofloat, который явным образом преобразует свой целый

аргумент в число с плавающей точкой. Проверка типов и семантический анализ

рассматриваются в главе 6.

1.2.4 Генерация промежуточного кода

В процессе трансляции исходной программы в целевой код компилятор может

создавать одно или несколько промежуточных представлений различного вида.

Синтаксические деревья являются видом промежуточного представления; обычно

они используются в процессе синтаксического и семантического анализа.

После синтаксического и семантического анализа исходной программы многие компиляторы генерируют явное низкоуровневое или машинное промежуточное представление исходной программы, которое можно рассматривать как программу для абстрактной вычислительной машины. Такое промежуточное представление должно обладать двумя важными свойствами: оно должно легко генерироваться и легко транслироваться в целевой машинный язык.

В главе 6 мы рассмотрим промежуточное представление, которое называется

трехадресным кодом и состоит из последовательности команд, напоминающих

ассемблерные, причем в каждой команде имеется три операнда и каждый операнд

может действовать, как регистр. Выход генератора промежуточного кода на рис. l.7

состоит из последовательности трехадресных кодов

t1 = inttofloat(60)

t2 = id3 * t1

t3 = id2 + t2

id1 = t3

(1.3)

Следует сделать несколько замечаний по поводу трехадресных команд. Вопервых, каждая трехадресная команда присваивания содержит как минимум один

оператор справа. Таким образом, приведенные команды определяют порядок выполнения операций — в исходной программе (1.1) умножение выполняется раньше сложения. Во-вторых, компилятор должен генерировать временные имена для

хранения значений, вычисляемых трехадресными командами. В-третьих, некоторые “трехадресные команды” наподобие первой и последней в последовательности (1.3) содержат менее трех операндов.

39

1.2. Структура компилятора

В главе 6 мы рассмотрим основные промежуточные представления, используемые компиляторами. В главе 5 вы познакомитесь с методами синтаксически

управляемой трансляции, которые будут применены в главе 6 для проверки типов

и генерации промежуточного кода для типичных конструкций языка программирования, таких как выражения, конструкции управления потоком выполнения

и вызовы процедур.

1.2.5 Оптимизация кода

Фаза машинно-независимой оптимизации кода пытается улучшить промежуточный код, чтобы затем получить более качественный целевой код. Обычно “более качественный”, “лучший” означает “более быстрый”, но могут применяться

и другие критерии сравнения, как, например, “более короткий код” или “код,

использующий меньшее количество ресурсов”. Например, непосредственный алгоритм генерирует промежуточный код (1.3), используя по команде для каждого

оператора в синтаксическом дереве, полученном на выходе семантического анализатора.

Простой алгоритм генерации промежуточного кода с последующим оптимизатором кода представляет собой рациональный способ генерации хорошего целевого кода. Оптимизатор может определить, что преобразование 60 из целого числа

в число с плавающей точкой может быть выполнено единственный раз во время компиляции, так что операция inttofloat может быть устранена путем замены

целого числа 60 числом с плавающей точкой 60.0. Кроме того, t3 используется только один раз — для передачи значения в id1, так что оптимизатор может

преобразовать (1.3) в более короткую последовательность

t1 = id3 * 60.0

id1 = id2 + t1

(1.4)

Имеется большой разброс количества усилий, затрачиваемых различными

компиляторами на оптимизацию на этом этапе. Так называемые “оптимизирующие компиляторы” затрачивают на эту фазу достаточно много времени, в то

время как другие компиляторы применяют здесь только простые методы оптимизации, которые существенно повышают скорость работы целевой программы, при

этом не слишком замедляя процесс компиляции. В главах, начиная с 8, детально

рассматриваются методы машинно-зависимой и машинно-независимой оптимизации.

1.2.6 Генерация кода

Генератор кода получает в качестве входных данных промежуточное представление исходной программы и отображает его в целевой язык. Если целевой язык

40

Глава 1. Введение в компиляцию

представляет собой машинный код, для каждой переменной, используемой программой, выбираются соответствующие регистры или ячейки памяти. Затем промежуточные команды транслируются в последовательности машинных команд,

выполняющих те же действия. Ключевым моментом генерации кода является аккуратное распределение регистров для хранения переменных.

Например, при использовании регистров R1 и R2 промежуточный код (1.4)

может транслироваться в машинный код

LDF

MULF

LDF

ADDF

STF

R2,

R2,

R1,

R1,

id1,

id3

R2, #60.0

id2

R1, R2

R1

(1.5)

Первый операнд каждой команды определяет приемник. F в каждой команде

говорит о том, что команда работает с числами с плавающей точкой. Код (1.5)

загружает содержимое адреса id3 в регистр R2, затем умножает его на константу

с плавающей точкой 60.0. # указывает, что 60.0 следует рассматривать как непосредственное значение. Третья команда помещает id2 в регистр R1, а четвертая

прибавляет к нему предварительно вычисленное и сохраненное в регистре R2

значение. Наконец, значение регистра R1 сохраняется в адресе id1, так что код

корректно реализует инструкцию присваивания (1.1). Подробнее генерация кода

рассматривается в главе 8.

Это беглое знакомство с генерацией кода полностью игнорирует важный вопрос о распределении памяти для идентификаторов в исходной программе. Как

вы увидите в главе 7, организация памяти во время выполнения программы зависит от компилируемого языка. Решения о распределении памяти принимаются

либо в процессе генерации промежуточного кода, либо при генерации целевого

кода.

1.2.7 Управление таблицей символов

Важная функция компилятора состоит в том, чтобы записывать имена переменных в исходной программе и накапливать информацию о разных атрибутах

каждого имени. Эти атрибуты могут предоставлять информацию о выделенной

памяти для данного имени, его типе, области видимости (где именно в программе

может использоваться его значение) и, в случае имен процедур, такие сведения,

как количество и типы их аргументов, метод передачи каждого аргумента (например, по значению или по ссылке), а также возвращаемый тип.

Таблица символов представляет собой структуру данных, содержащую записи

для каждого имени переменной, с полями для атрибутов имени. Структура данных

1.2. Структура компилятора

41

должна быть разработана таким образом, чтобы позволять компилятору быстро

находить запись для каждого имени, а также быстро сохранять данные в записи

и получать их из нее. Таблицы символов рассматриваются в главе 2.

1.2.8 Объединение фаз в проходы

Фазы связаны с логической организацией компилятора. При реализации работа разных фаз может быть сгруппирована в проходы (pass), которые считывают

входной файл и записывают выходной. Например, фазы анализа — лексический

анализ, синтаксический анализ, семантический анализ и генерация промежуточного кода — могут быть объединены в один проход. Оптимизация кода может

представлять собой необязательный проход. Затем может быть еще один проход,

заключающийся в генерации кода для конкретной целевой машины.

Некоторые наборы компиляторов созданы вокруг тщательно разработанного

промежуточного представления, которое позволяет начальной стадии для некоторого языка программирования взаимодействовать с заключительной стадией для

определенной целевой машины. При наличии таких наборов можно создавать

компиляторы для различных исходных языков и одной целевой машины, комбинируя различные начальные стадии с заключительной стадией для этой целевой

машины. Аналогично можно разрабатывать компиляторы для различных целевых

машин, комбинируя начальную стадию с заключительными стадиями для различных целевых машин.

1.2.9 Инструментарий для создания компиляторов

Разработчики компиляторов, как и разработчики любого другого программного обеспечения, могут с успехом использовать современные среды разработки

программного обеспечения, содержащие такие инструменты, как редакторы языков, отладчики, средства контроля версий, профайлеры, средства тестирования

и т.п. В дополнение к этим средствам общего назначения может использоваться

ряд более специализированных инструментов, созданных для помощи в реализации различных фаз компилятора.

Эти инструменты используют собственные специализированные языки для

описания и реализации отдельных компонентов, и многие из них основаны на

весьма сложных алгоритмах. Наиболее успешными являются те инструменты,

которые скрывают детали алгоритма генерации и создают компоненты, легко интегрируемые в компилятор. К широко используемым инструментам для создания

компиляторов относятся следующие.

1. Генераторы синтаксических анализаторов, которые автоматически создают синтаксические анализаторы на основе грамматического описания языка программирования.

42

Глава 1. Введение в компиляцию

2. Генераторы сканеров, которые создают лексические анализаторы на основе

описания токенов языка с использованием регулярных выражений.

3. Средства синтаксически управляемой трансляции, которые создают наборы подпрограмм для обхода синтаксического дерева и генерации промежуточного кода.

4. Генераторы генераторов кода, которые создают генераторы кода на основе набора правил трансляции каждой операции промежуточного языка

в машинный язык для целевой машины.

5. Средства работы с потоком данных, которые облегчают сбор информации

о передаче значений от одной части программы ко всем другим. Анализ

потоков данных представляет собой ключевую часть оптимизации кода.

6. Наборы для построения компиляторов, которые представляют собой интегрированные множества подпрограмм для построения разных фаз компиляторов.

В этой книге будут описаны многие из перечисленных инструментов.

1.3 Эволюция языков программирования

Первые ЭВМ появились в 1940-х годах и программировались исключительно

на машинных языках путем последовательностей нулей и единиц, которые явно

указывали компьютеру, какие операции и в каком порядке должны быть выполнены. Сами операции были очень низкоуровневыми: переместить данные из одной

ячейки памяти в другую, сложить содержимое двух регистров, сравнить два значения и т.д. Надо отметить, что такое программирование было очень медленным,

утомительным и подверженным ошибкам. Однажды написанную программу было

очень трудно понять и модифицировать.

1.3.1 Переход к языкам высокого уровня

Первым шагом в создании более дружественных языков программирования

была разработка мнемонических ассемблерных языков в начале 1950-х годов.

Изначально команды ассемблера являлись всего лишь мнемоническими представлениями машинных команд. Позже в языки ассемблера были введены макросы, так что программист мог определять параметризованные сокращения для

часто использующихся последовательностей машинных команд.