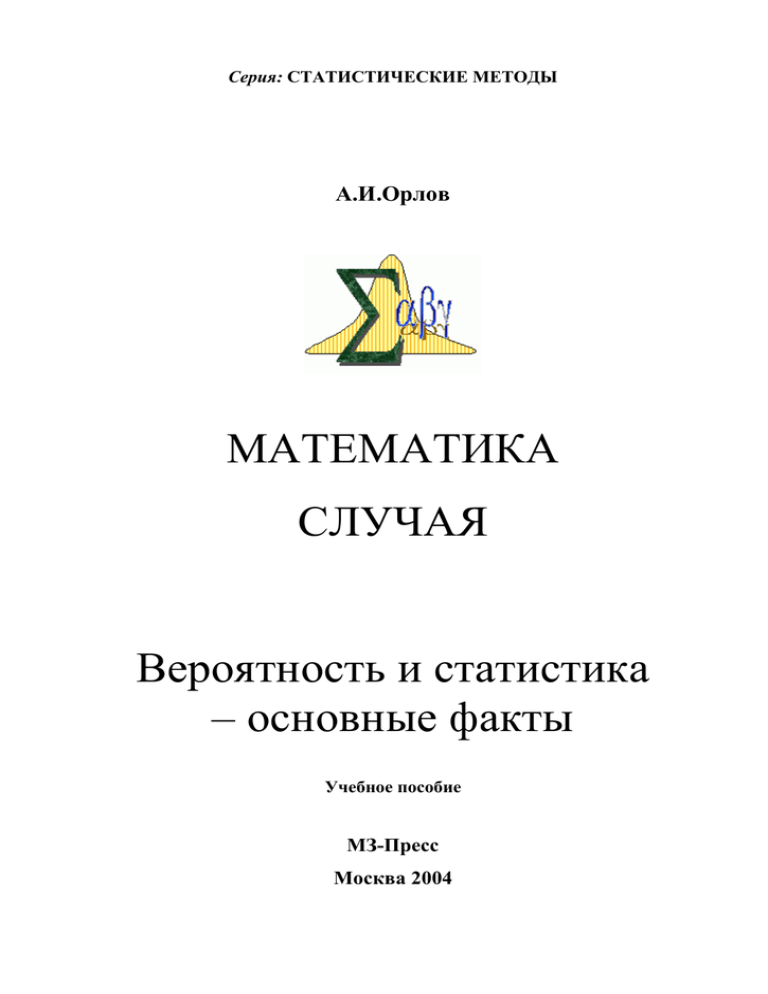

1 - Теория вероятностей и математическая статистика

реклама