Задача про рак груди

реклама

Наивный

байесовский

классификатор

к.х.н. Варламова Екатерина Владимировна

Задача про рак груди

1% женщин в возрасте 40 лет, участвовавших в

регулярных обследованиях, имеют рак груди.

80% женщин с раком груди имеют положительный

результат маммографии.

Только 15%(!)

9.6% здоровых женщин

также получают

врачей

положительный результат (маммография, как любые

измерения, не дает

100% результатов).

отвечают

Женщина-пациент из этой возрастной группы

правильно

получила положительный

результат на регулярном

обследовании.

Какова вероятность того, что она фактически больна

раком груди?

Решение задачи про рак

груди

Возьмем 10 000 женщин.

До маммографии

женщин

можнораком

разделить

на 2 и

группы:

Группа

A: 80 женщин

больных

груди,

с

положительной

Группа

1: 100 женщин

маммограммой.

больных раком груди.

Группа 2: 9,900 женщин не больных раком груди.

Группа C: 950 женщин не больных раком груди, и с

После маммографии

женщин можно разделить на 4 группы:

положительной

маммограммой.

Группа A: 80 женщин больных раком груди, и с положительной

Вероятность того, что женщина с положительной

маммограммой.

маммограммой фактически больна раком груди:

Группа B: 20 женщин больных раком груди, и с отрицательной

маммограммой.

Доля (A) в (A + C)

Группа C: 95080

женщин

больных

груди,

ис

/ (80 не

+ 950)

= 80раком

/ 1030

= 7.8%.

положительной маммограммой.

Группа D: 8,950 женщин не больных раком груди, и с

отрицательной маммограммой.

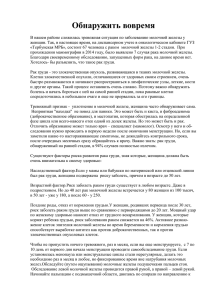

Термины теоремы Байеса

Исходная доля пациенток с раком груди

называется в статистике априорной

вероятностью.

Шанс, что пациентка с раком груди получить

положительную маммограмму, и шанс, что

пациентка без рака получит положительную

маммограмму, называются условными

вероятностями.

Результат - ожидаемая вероятность, что

пациентка больна раком груди, если ее

маммограмма положительна, - называется

апостериорной вероятностью.

Априорная

информация

Обозначения теоремы

Байеса

p(рак):

p(~рак):

0.01

0.99

p(положительный|рак):

p(~положительный|рак):

p(положительный|~рак):

p(~положительный|~рак):

80.0%

20.0%

9.6%

90.4%

p(положительный):

p(~положительный):

p(рак|положительный):

p(~рак|положительный):

p(рак|~положительный):

p(~рак|~положительный):

p(рак&положительный):

p(рак&~положительный):

p(~рак&положительный):

p(~рак&~положительный):

0.008

0.002

0.095

0.895

0.103

0.897

7.80%

92.20%

0.22%

99.78%

Теорема Байеса

,

где

— априорная вероятность гипотезы A;

— вероятность гипотезы A при наступлении

события B (апостериорная вероятность);

— вероятность наступления события B при истинности

гипотезы A;

— полная вероятность наступления события B.

Доказательство теоремы

Байеса

Вероятность совместного события AB двояко

выражается через условные вероятности:

Следовательно

Задача для тренировки ума

Предположим, что в бочке находится множество

маленьких пластиковых капсул.

Некоторые капсулы окрашены в красный цвет,

некоторые - в синий.

У 40% от всех капсул внутри жемчужина, 60%

пусты.

В синий цвет окрашены 30% капсул, содержащих

жемчужины, и 10% пустых капсул.

Какова вероятность, что синяя капсула

содержит жемчужину?

И еще одна задачка

У Вас есть большой контейнер, содержащий кучу

пластиковых капсул.

Некоторые из них содержат жемчужины, остальные

пусты. Некоторые капсулы окрашены в синий цвет,

остальные в красный.

Предположим, что 40% капсул синие,

5/13 от капсул, содержащих жемчужины, синие,

и 20% капсул одновременно пустые и красные.

Какова вероятность, что синяя капсула содержит

жемчужину?

Наивный байесовский

классификатор

Признаки не зависят друг от друга

Множество объектов D = {d1, d2, ..., dm},

Признаки объектов F = {f1, f2, ..., fq},

Множество меток C = {c1, c2, ..., cr}.

Размытие по Лапласу

где

z >= 0 — коэффициент размытия,

q — это количество параметров.

Наивный байесовский

классификатор для

непрерывных параметров

𝑛

𝑐𝑀𝐴𝑃 = 𝑎𝑟𝑔𝑚𝑎𝑥𝑐∈𝐶 ln λ𝑐 𝑃𝑐 +

ln 𝑝 𝑓𝑖 |𝑐

,

𝑖=1

λ𝑐 - величина потери при отнесении объекта к неправильному

классу,

𝑝 𝑓𝑖 |𝑐 - плотность вероятности признака объекта.

𝑚

𝑝 𝑓𝑖 |𝑐 =

𝑖=1

1

𝜌 𝑑, 𝑑𝑖

𝐾

𝑚𝑉 ℎ

ℎ

где m – количество элементов выборки D ∋ di,

ρ – мера на D, h – окрестность di (”ширина окна”),

K – функция ядра, V (h) – нормирующий множитель.

Наивный байесовский

классификатор для

непрерывных параметров

𝑉 ℎ =

𝐾

𝐷

𝜌 𝑑, 𝑑𝑖

ℎ

𝑑(𝑑)

В качестве функции ядра используется ядро

Епанечникова:

𝐾 𝑟 =

3

1 − 𝑟2 , 𝑟 ≤ 1

4

Для определения меры используется

Евклидова метрика:

𝑛

𝜌 𝑑, 𝑑𝑖 =

𝑑 − 𝑑𝑖

𝑖=1

2

Преимущества и недостатки

Преимущества

Простота реализации и низкие вычислительные

затраты при обучении и классификации;

В тех редких случаях, когда признаки (почти)

независимы, наивный байесовский классификатор

(почти) оптимален;

Относительная простота интерпретации.

Недостатки

Низкое качество классификации. Он используется как

эталон при экспериментальном сравнении

алгоритмов;

Неспособность учитывать зависимость результата от

сочетания признаков.

Ограничения

Пригоден для выборок с независимыми параметрами.

Применение метода

Оценка надежности банка,

Классификация структурированной

информации,

Фильтрация спама,

Классификация налогоплательщиков и

заемщиков по группам риска,

Оценка реализации продукции,

Обнаружение корпоративного

мошенничества.

Построение модели в R

Построение модели в R хорошо

описано в следующем источнике:

http://habrahabr.ru/post/184574/