Лекция 7-8

реклама

Принятие

решений

в условиях

неопределенности

Принятие решений при неизвестной априорной информации

При рассмотрении критериев для принятия

решений

в

условиях

неопределенности

предполагается, что распределения вероятностей либо

известны, либо могут быть найдены. Эти вероятности

называются априорными вероятностями.

Возьмем

случай

полной

(«дурной»)

неопределенности, когда вероятности состояний

природы либо вообще не существуют, либо не

поддаются оценке даже приближенно. Обстановка

неблагоприятна для принятия «хорошего» решения –

попытаемся найти хотя бы не самое худшее.

Здесь все зависит от точки зрения на ситуацию, от

позиции исследователя, от того, какими бедами грозит

неудачный выбор решения. Опишем несколько

возможных подходов, точек зрения (или несколько

«критериев» для выбора решения).

Принятие решений при неизвестной априорной информации

Пусть имеется совокупность действий, операций

а1, а2, ..., аm, m 2,

(1)

которые может совершить человек для достижения

поставленной цели, причем одну и только одну операцию аi,

i{1,2, ..., m}, выбирает человек, принимающий решение.

Кроме того, представлен перечень объективных условий,

например, состояний природы

Q1, Q2, ..., Qn,

(2)

одно из которых Qj, j{1, 2, ..., n}, будет иметь место в

действительности.

Для каждой операции аi, i = 1, 2, ..., m, при любом

условии Qj, j = 1, 2, ..., n, задана полезность (выгода, доход)

в некоторых единицах ij. Величины ij, играющие роль платежей

в теории игр, обычно задаются из эвристических, субъективных

соображений. При этом возникают специфические трудности при

их числовой оценке, обусловленные такими факторами, как:

болезни, удовольствия, престиж, репутация и т.д. Величины ij

можно

задавать

относительно,

поэтому

их

называют

показателями предпочтительности.

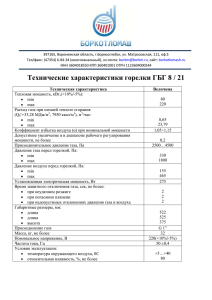

Принятие решений при неизвестной априорной информации

Все

перечисленные

условия,

при

которых

принимается решение, представлены в таблице 1:

Объективные

Условия

Операции

Q1

Q2

…

Qn

a1

11

12

…

1n

a2

21

22

…

2n

…

…

…

…

…

am

m1

m2

…

mn

Если ЛПР не располагает никакой информацией о

состояниях природы (2), то имеем ситуацию принятия

решения в условиях полной неопределенности.

Рассмотрим четыре известных подхода принятия

решений в этой ситуации.

Максиминный критерий Вальда

Согласно этому критерию игра с природой ведется как игра

с разумным, причем агрессивным противником, делающим все

для того, чтобы помешать нам достигнуть успеха. Оптимальной

считается стратегия, при которой гарантируется выигрыш в

любом случае

не

меньший, чем «нижняя цена игры с

природой».

Для каждой операции аi, i = 1, 2, ..., m, находим наихудший

исход:

min ij ij0 ,

j0 1, 2, ..., n (3а)

j

Затем определяется то значение i0, при котором величина

максимальна:

max ij0 i0 j0 , i0 1, 2, ..., m (3в)

i

Принимаемое решение – выбор наилучшей операции из

множества исходных (1). Равенства (3а), (3в) можно объединить

в одно:

max min ij i0 j0

(4)

1i m 1 j n

Максиминный критерий Вальда

Рассмотренная операция максимин соответствует

лучшему из худших исходов. Если руководствоваться

этим

критерием,

олицетворяющим

«позицию,

крайнего пессимизма», надо, всегда ориентироваться

на худшие условия, зная наверняка, что «хуже этого

не будет».

Критерий

максимина

является

чисто

перестраховочным, поскольку природа не может быть

сознательным противником. Очевидно, такой подход

- естественный для того, кто очень боится проиграть не является единственно возможным, но как крайний

случай он заслуживает рассмотрения. Максиминную

операцию использует только крайний пессимист, не

желающий идти ни на какой риск. Обычно такие люди

довольствуются малым и предпочитают спокойную

жизнь.

Критерий минимакса сожалений Сэвиджа

Этот критерий – также крайне пессимистический, но при

выборе оптимальной стратегии советует ориентироваться

не на выигрыш, а на риск. Выбирается в качестве

оптимальной та стратегия, при которой величина риска

(сожаления) в наихудших условиях минимальна. Сожаление

(риска) в ТПР – потери в результате упущенных

возможностей. Пусть природа находится в состоянии Qs

найдем максимальный элемент s-го столбца таблицы 1,

max is i , s 1, 2, ..., n

1im

s

Мера сожаления определяется как разность:

is is is , i 1,2,...,m, s 1,2,...,n,

где is 0; is 0, если i is ; is 0, если i is . Тогда

при

состоянии природы Qs лучшей операцией является ai :s для

нее сожаление равно нулю. Изменяя последовательно

значения s, s = 1,2,…, n, получим сожаление для каждой

операции ai, i=1,2,…, m, при любом состояния природы Qs,

s=1,2,…, n.

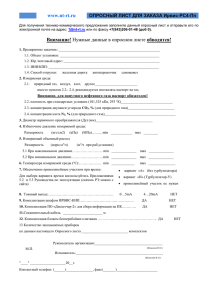

Критерий минимакса сожалений Сэвиджа

Матрица сожалений представлена в таблице 2:

Qj

Q1

Q2

…

Qn

a1

11

12

…

1n

a2

21

22

…

2n

…

…

…

…

…

am

m1

m2

…

mn

ai

Для принятия решения к таблице 2

применяется критерий минимакса (minmax): для

каждой операции ai, i=1,2,…, m,

находится

наибольшее сожаление:

max is isi , i 1,2,...,m.

1 s n

Критерий минимакса сожалений Сэвиджа

Затем среди членов последовательности ,

i=1,2,…, m, s = 1,2,…, n,

находится

минимальный

min isi i0 s0 .

1i m

Последние два равенства соединим в одно:

min max is i0 s0 .

1 i m 1 s n

Принимаемое

решение

–

наилучшая

операция a , i 1,2,...,m .

i0

0

Сущность такого подхода в том, чтобы

всячески избегать большого риска при принятии

решения. В смысле «пессимизма» критерий

Сэвиджа сходен с критерием Вальда, но самый

«пессимизм» здесь понимается по-другому.

Критерий равновозможных состояний (Лапласа)

По этому критерию выбирается та операция ai0, для

которой сумма

n

полезностей Ai

максимальна, Ai0 max Ai

is ,

i

1 m

s 1

Рассмотрим на конкретном примере принятие решений

по трем описанным критериям. Пусть m=3, n=2, и матрица

полезностей представлена в таблице 3:

Qs

Q1

Q2

a1

1

11

a2

10

6

a3

0

41

ai

Критерий равновозможных состояний (Лапласа)

Например, ai – i-ый вариант технологического

процесса для изготовления некоторых изделий, Q1 –

возникновение дефицита в ближайшие два года на

сырье, из которого изготовляются детали, Q2 –

отсутствие такого дефицита.

1. Применяя операцию максимина, получим

min(1, 11) 1, min(10, 6) 6, min( 0, 14) 0, max( 1, 6, 0) 6.

Максиминной операцией является операция а2,

гарантирующая 6 единиц полезности.

2. Для использования критерия минимакса

сожалений необходимо для данных табл. 3 найти

матрицу сожалений. Сначала находим максимальный

элемент каждого столбца этой таблицы:

max ( 1, 10, 0 ) 10, max ( 11, 6, 14 ) 14

.

Критерий равновозможных состояний (Лапласа)

Тогда

матрица

сожалений примет вид, представленный в таблице 4:

Применяя к данным этой

таблицы критерий минимакса, получим:

Qs

Q1

Q2

a1

1

11

a2

10

6

a3

0

41

ai

max(9, 3) = 9, max(0, 8) = 8, max(10, 0) = 10, min(9, 8, 10) =

8.

Следовательно, операцией, соответствующей

минимаксу сожалений, является операция а2.

По критерию равновозможных состояний для

данных

таблицы 3 имеем:

Критерий равновозможных состояний (Лапласа)

Значит, оптимальной операцией по критерию

равновозможных

состояний

природы

является

операция а2. В рассмотренном примере все три

критерия дали один и тот же ответ: операция а2

является оптимальной, она гарантирует 6 ед.

полезности.

Если выбрать операцию а1, то в случае везения

получим 11 ед. полезности, а в случае невезения –

всего 1 ед. полезности. Если выбрать операцию а3, то в

случае везения имеем 14 ед. полезности, а в случае

невезения – 0 ед. полезности. Операция а2 гарантирует

наибольшую полезность, 6 ед. Конкурирующие

операции а1 и а3 гарантируют меньшие полезности: 1

ед. и 0 ед., соответственно.

Критерий Гурвица

Этот критерий охватывает ряд различных подходов к принятию

решений:

от

наиболее

оптимистичного

до

наиболее

пессимистичного. При наиболее оптимистичном подходе можно

выбрать действие, дающее maxai maxj { v(ai, j) }. (Предполагается,

что v(ai, j) представляет выигрыш, или доход.) Аналогично при

наиболее пессимистичных предположениях выбираемое действие

соответствует maxai minj { v(ai, j) }.

Критерий Гурвица устанавливает баланс между случаями

крайнего оптимизма и крайнего пессимизма взвешиванием обоих

способов поведения с соответствующими весами и 1-, где 01.

Если v(ai, j) представляет прибыль, то выбирается действие,

дающее maxai { maxj v(ai, j) + (1-)minj { v(ai, j) }. В том случае,

когда представляются затраты, критерий выбирает действие,

дающее minai { minj v(ai, j) + (1-)maxj { v(ai, j) }. Параметр

определяется как показатель оптимизма: при =1 критерий

слишком оптимистичный; при =0 он слишком пессимистичный.

Значение между 0 и 1 может определяться в зависимости от

склонности лица, принимающего решение, к пессимизму или

оптимизму. При отсутствии ярко выраженной склонности =1/2

представляется наиболее разумным.

Критерий Гурвица

ПРИМЕР:

Одно из предприятий должно определить уровень

предложенных услуг так, чтобы удовлетворить

потребности клиентов в течении предстоящих

праздников. Точное число клиентов не известно, но

ожидается, что оно может принимать одно из четырех

значений: 200, 250, 300 или 350 клиентов. Для каждого

из этих возможных значений существует наилучший

уровень предложения (с точки зрения возможных

затрат). Отклонения от этих уровней приводят к

дополнительным затратам либо из-за превышения

предложения над спросом, либо из-за неполного

удовлетворения спроса. Приводится таблица,

определяющая потери в тысячах $.

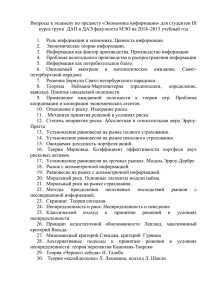

Критерий Гурвица

Клиенты:

Q1

Q2

Q3

Q4

1

5

10

18

25

2

8

7

8

23

3

21

18

12

21

4

30

22

19

15

Положим =1/2.

результаты

необходимых вычислений приведены ниже. Оптимальное

решение заключается в выборе 1

или 2 .

min v( i , Q j ) max v( i , Q j )

j

j

min v( i , Q j )

j

(1 ) max v( i , Q j )

j

1

5

25

15 min

2

7

23

15 min

3

12

21

16,5

4

15

30

22,5

i

i

Принятие решений при проведении эксперимента

Допустим, что вероятности р(Q1),р(Q2),…,р(Qn) в

принципе существуют, но вам неизвестны. Иногда в этом

случае

предполагают

все

состояния

природы

равновероятными

(так

называемый

«принцип

недостаточного основания» Лапласа), но вообще этого

делать не рекомендуется. Обычно более или менее ясно,

какие состояния более, а какие - менее вероятны. Для того,

чтобы найти ориентировочные значения вероятностей

р(Q1),р(Q2),…,р(Qn), можно, например, воспользоваться

методом

экспертных

оценок.

Хоть

какие-то

ориентировочные

значения

вероятностей

состояния

природы лучше, чем полная неизвестность. Неточные

значения вероятностей состояний природы в дальнейшем

могут быть «скорректированы» с помощью специально

поставленного эксперимента. Эксперимент может быть как

«идеальным», полностью выясняющим состояние природы,

так и неидеальным, где, вероятности состояний уточняются

по косвенным данным

Принятие решений в условиях неопределенности

Человек, прежде чем принять решение, пытается получить некоторую

информацию о состоянии природы экспериментальным путем. Предполагается,

что проведение эксперимента не требует никаких затрат,

Пусть проведен эксперимент, имеющий t исходов – возможных прогнозов

состояния природы,

Z=(z1, z2,…, zt), .

Известна условная вероятность Р(zβ/Qj) -го результата эксперимента при

состоянии природы Qj,

Pj= Р(zβ/Qj), =1,2,…,t, j=1,2,…,n.

(7)

Множество значений Pj можно представить в виде матрицы размера t·n,

данной в таблице 5:

Qi

Q1

Q2

…

Qn

Z1

P11

P12

…

P1n

Z2

P21

P22

…

P2n

…

…

…

…

…

Zt

Pt1

Pt2

…

Ptn

Z

Принятие решений в условиях неопределенности

Для использования информации, полученной в

результате эксперимента, введем понятие стратегии.

Стратегия это соответствие последовательности

t

результатов

эксперимента

последовательности t операций,

(z1, z2,…, zt)→ (ai, aj,…, ak).

(8)

Выражение (8) подразумевает, что

z1→ ai, ,

z2→ aj, ,

……………………

zt→ ak, .

Принятие решений в условиях неопределенности

Число возможных стратегий определяется формулой

= mt,

m – число операций, t число результатов

эксперимента. При m=2, t=3 всевозможные стратегии

представлены в таблице 6:

Si

S1

S2

S3

S4

S5

S6

S7

S8

z1

a1

a1

a1

a1

a2

a2

a2

a2

z2

a1

a1

a2

a2

a1

a1

a2

a2

z3

a1

a2

a1

a2

a1

a2

a1

a2

z

Принятие решений в условиях неопределенности

Задача ПР формулируется так: какую одну из операций

a1,a2,…, am следует выбрать в зависимости от одного из

результатов эксперимента z1, z2,…, zt.

Для принятия решения находим усредненные полезности

стратегий Si, i= 1,2, …, , при состояниях природы Qj, j=1, 2,

…, n,

U(Si,Qj)=αiβj Pβj , i= 1,2, …, ,

j=1, 2, …, n,

(9)

где αiβj - полезность β-ой компоненты i-ой стратегии при

состоянии природы Qj, Pβj – условная вероятность β-го

результата эксперимента при состоянии природы Qj.

Стратегия Si определена множеством операций, значения αi β j

берутся из таблицы полезностей значения Pβj – из таблицы 5.

Полученные значения усредненных полезностей U(Si,Qj)

можно записать в виде матрицы размера n·.

Для принятия решения – выбора наилучшей стратегии

можно воспользоваться уже рассмотренными критериями:

максимина, минимакса сожалений и равновозможных

состояний.

Принятие решений в условиях неопределенности

Рассмотрим конкретный пример. Предполагается лишь два

состояния природы: Q1 - теплая погода, Q2 – холодная погода,

и только две операции: a1 – одеться для теплой погоды, a2 –

одеться для холодной погоды. Эта ситуация характерна для

туристов. Матрица полезности дана в таблице 7:

Qi

Q1

Q2

a1

10

0

a2

4

7

a

Qi

Q1

Q2

Z1

0.6

0.3

Z2

0.2

0.5

Z3

0.2

0.2

Z

Критерий максимина гарантирует 4 ед. полезности и рекомендует

выбирать операцию а2. Критерий минимакса дает этот же ответ.

Но есть возможность воспользоваться данными прогноза погоды (в

этом и состоит эксперимент), которые могут быть трех видов:

z1 – ожидается теплая погода,

z2 – ожидается холодная погода,

z3 – прогноз неизвестен.

Принятие решений в условиях неопределенности

Из прошлого опыта известны условные вероятности

этих трех видов прогноза для каждого состояния

природы , =1,2,3, j =1,2, представленные в табл. 8.

Для каждой из 8–ми стратегий и каждого из 2–х

состояний природы определим взвешенные суммы

полезностей по формуле (9), используя данные таблиц

6 – 8,

U(S1,Q1) =100.6 + 100.2 +100.2 =10,

U(S2,Q1) =100.6 + 100.2 +40.2 = 8.8,

U(S3,Q1) =100.6 + 40.2 + 100.2 = 8.8,

........................................................

U(S8,Q1) = 40.6 + 40.2 + 40.2 = 4,

U(S1,Q2) = 00.3 + 00.5 +00.2 = 0,

.........................................................

U(S8,Q2) = 70.3 + 70.5 + 70.2 = 7.

Принятие решений в условиях неопределенности

Все вычисленные значения U(Si,Qj), i = 1,2,…8, j=1,2,

помещены в таблицу 9:

Si

S1

S2

S3

S4

S5

S6

S7

S8

Q1

10

8.8

8.8

7.6

6.4

5.2

5.2

4

Q2

0

1.4

5

4.9

2.1

5

5.6

7

Qi

Из таблицы 9 предварительно следует исключить

плохие стратегии – те стратегии, обе компоненты

которых не больше () соответствующих компонент

какой–либо другой стратегии. Ввиду того, что S2 ≤ S3,

S5 ≤ S4, S6 ≤ S7, то стратегии S2, S5, S6 исключаются из

рассмотрения (в таблице 9 они подчеркнуты).

Принятие решений в условиях неопределенности

К оставшимся, допустимым стратегиям можно применить

известные нам критерии. Используя критерий максимина,

имеем:

min (10, 0) 0 ,

min (8.8, 3.5) 3.5 ,

min (7.6, 4.9) 4.9 ,

min (5.2, 5.6) 5.2 ,

min (4, 7) 4 ,

.

Следовательно, наилучшей стратегией является стратегия

S7, гарантирующая 5.2 ед. полезности. Для сравнения

максиминная операция гарантирует лишь 4 ед. полезности. Так

как S7 = (a2, a2, a1), то в силу (8) имеем

, ,

, ,

max (0, 3.5, 4.9, 5.2, 4) 5.2

z z z a a a

1

2

3

2

2

1

Это значит, что при прогнозе z1 выбирается операция а2, при

прогнозе z2 – a2, при прогнозе z3 – a1, т.е. максиминная

стратегия S7 рекомендует одеваться тепло, если прогноз –

теплая или холодная погода, и одеваться легко, если прогноз

неизвестен. Последнее утверждение весьма непрактично.

Принятие решений в условиях неопределенности

Максиминная стратегия S7 при неблагоприятном

стечении обстоятельств может привести и к худшему

результату, чем максиминная операция .

Например, имеет место холодная погода . Тогда

согласно максиминной операции турист получит 7 ед.

полезности (табл. 7).

С другой стороны, если результат прогноза будет

(прогноз неизвестен) и согласно стратегии S7 будет

выбрана операция (одеться легко), то он получит 0 ед.

полезности.

Это явление –– типичное для теории игр и теории

принятия решений. S7 гарантирует лишь среднюю

полезность в 5.2 ед.

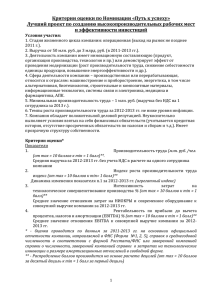

Использование смешанной стратегии

Стратегия S* называется

смешанной, если она представлена

в виде выпуклой комбинации двух

других стратегий,

S* = сSm1 + (1 - с)Sm2,

0<с<1, m1, m2 {1, 2, …, t}.

u1

12

10

8

S8

S*

Это определение базируется

на понятии выпуклой комбинации

точек [14]. Переход к смешанной

стратегии осуществляется с целью

повышения гарантированной

средней полезности.

Стратегии рассмотренного

выше примера изобразим точками

на плоскости с координатами

u1 U (S i , Q ) , u2 U (S i , Q ) ,

1

i=1,3,4,7,8 (рис. В).

2

6

S4

S7

4

S3

2

u1

S1

0

0

2

4

6

Рис. В

8

10

12

Использование смешанной стратегии

По рисунку В видно, что если взять в определенных

пропорциях стратегии S4 и S8, то получим смешанную

стратегию, лучшую по сравнению со стратегией S7.

Проведем биссектрису I-го координатного угла и найдем

точку пересечения ее с отрезком [S4, S8] –– точку .

Запишем уравнение прямой, проходящей через точки S4(7.6;

4.9), S8 (4;7) [15],

u1 4 u 2 7

,

7.6 4

4.9 7

которое приводится к виду:

7u 12u 112 0 .

1

2

Из этого уравнения находим координаты точки S*,для которой u1 u2 ,

* 112 112

S( , ) .

19

19

112

Так как 19 5.89 , то стратегия S*

лучше стратегии S7,

гарантирующей 5.2 ед. полезности, S*>S7.

Использование смешанной стратегии

Теперь остается представить стратегию S* в виде

выпуклой комбинации стратегий S4, S8,

S* = cS4 + (1 – c)S8, 0 < c <1.

(10)

Для определения значения параметра

достаточно записать уравнение (10) для абсцисс

входящих в него точек: 112 38 – +4(1 - –).

19

из которого получаем

принимает вид:

*

S

5

–=

10

19

10

9

S4 S8

19

19

. Тогда равенство (10)

.

(11)

Так как S4 (a1, a2 , a2), S8 (a 2 , a 2 , a 2), то в силу равенства

(11) имеем

9

10

S 19 a 19 a , a , a .

*

1

2

2

2

Использование смешанной стратегии

Практически смешанную стратегию S* можно

реализовать так. Если результат эксперимента есть z2

или z3, то используется операция a2. Если же результат

эксперимента есть z1, то с помощью подходящего

случайного механизма с вероятностью используется

операция a1, и с вероятностью –– операция а2.

Основой случайного механизма могут служить 19

одинаковых карточек, на 10–и из которых записан

символ а1, а на 9–и –– символ а2. Из этого набора 19–

и карточек случайно выбирается одна и используется та

операция, символ, которой изображен на этой карточке.

Спасибо

за внимание!