Глобальные Сети в интересах науки и - Переславль

реклама

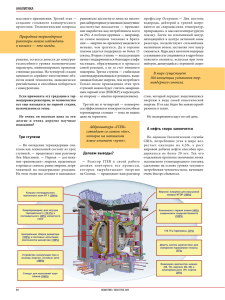

Глобальные Сети в интересах науки и образования Академик Е. П. Велихов (актовая лекция в УГП им. А.К.Айламазяна, 01.09.2004) План доклада Экспоненциальное развитие компьютерных и сетевых технологий Сети для S&E Кому нужны столь чудовищные производительности? GRID-технологии ITER и ITER-GRID Часть 1. Экспоненциальное развитие компьютерных и сетевых технологий Экспоненциальный рост электроники Экспоненциальный рост технологий Быстродействие компьютеров и сетей Компьютеры – в 2 раза за 18 месяцев Сети — в 2 раза за 9 месяцев Сети/Компьютеры — в 10 раз за 5 лет с 1986 до 2000 Компьютеры: рост в 500 раз Сети: рост в 340,000 раз с 2001 до 2010 Компьютеры: рост в 60 раз Сети: рост в 4,000 раз Рост денежных оборотов, связанных с Интернет 1994-2002, млрд. USD 1400 1234 1200 1000 717 800 600 377 400 200 0.008 0.436 2.9 21.8 73.9 180 0 1994 1995 1996 1997 1998 1999 2000 2001 2002 Е-коммерция в США 1998—2003, млрд. USD 1400 B-to-B 1331 B-to-C 1200 1000 843 800 499 600 400 200 251 43 109 33 16 8 100 76 52 0 1998 1999 2000 2001 2002 2003 Океанские подводные кабели США-Европа 1999 Gbps 178.0 2002 Рост Gbps разы 6,822.4 38.3 Европа-Азия 31.1 91.2 2.9 США-Азия 104.1 864.0 8.3 США-Лат. Америка Всего 15.6 4,165.5 267.0 328.8 11,943.1 36.3 Часть 2. Сети для S&E Сети для науки и образования GEANT Pan-European Backbone Соединяет > 31 страны; много линий по 2,5 и 10 Гбит/с UK: SuperJANET Core at 10 Gbps 2,5 Гбит/с Нью-Йорк-Лондон, 622 Мбит/с в ESnet и Abilene France (IN2P3): 2,5 Гбит/с RENATER3 бэкбон Лион-Церн 1 Гбит/c SuperSINET (Japan): 10 Гбит/с Токио-Нью-Йорк – 2х2,5 Гбит/с CA*net4 (Canada): 10 Гбит/с GWIN (Germany): 2,5 Гбит – Бэкбон, в США – 2х2,5 Гбит/с Russia: 155 Мбит/с Moscow-Starlight – 155 Мбит/с ( US NSF + Russia) Moscow-GEANT и Москва-Стокгольм – 155 Мбит/с US High Performance Network (Abilene) США, NSFNet GEANT PanEuropean Backbone 10 > 30 стран Gbps 2.5 Gbps 622 Mbps 155 Mbps China CSTNet (800 НИИ) Схема сети RBNet Переславль-Залесский ЗАО «Компания ТрансТелеКом» 45 000 км ВОЛС GLOBAL RING NETWORK FOR ADVANCED APPLICATIONS DEVELOPMENT Russia-China-USA Science & Education Network Gloriad Продолжение программы NaukaNet (Россия-США) Сохранение принципа паритетного финансирования: Россия – США – Китай Обеспечение наращивания канальной емкости на магистрали от 155 Мбит/с до 10 Гбит/с с замыканием глобального кольца Этапы: “Little GLORIAD” (155 Mbps ring) запущен 1201-2004 “Large GLORIAD” — конец 2004 GLORIAD “Global Ring Network for Advanced Development” network – a 10 Gbps S&E network ringing northern hemisphere – connecting US, Russia and China (and broader Europe and Asia) Connects domestic S&E networks via international backbone services US, Russia and China constructing GLORIAD to support general and highend S&E Океанские подводные кабели СШАЕвропа ЕвропаАзия США-Азия США-Лат. Америка Всего 1999 Gbps 178.0 2002 Рост 2002 Gbps разы MCalls 6,822.4 38.3 478 31.1 91.2 2.9 6 104.1 864.0 8.3 60 4,165.5 267.0 292 15.6 328.8 11,943.1 36.3 836 Часть 3. Кому нужны столь чудовищные производительности ? Большой адронный коллайдер (БАК): потоки данных, этапы обработки и анализа 1-100 ГБ/сек 0.1-1 ГБ/сек детектор Отбор событий и первичная реконструкция 200 MБ/сек 1-6 ПБ/год сырые данные ~100 MБ/сек Моделирование событий 0.5-1 ПБ/год Реко нстр укци я соб РИВК БАК 5-10% ытия Архивное хранение Суммарные данные по событию 200 TБ/год Подгот овка данны х для анализ Данные для анализа (выделенные по а физ. каналам) Интерактивный физический анализ тысячи ученых БАК: потоки данных, этапы обработки и анализа Исходные потоки (сырые данные) Скорости: 0.1 – 10 – 100 Гбайт/с Хранение: 1,000 – 6,000 Тбайт в год Суммарные данные по событиям Хранение: 500 – 1,000 Тбайт в год Скорости доступа: 200 Мбайт/с Архивное хранение: 200 Тбайт в год Пользователей: тысячи LHC: требования 1999 2004 Perf. TFlops Disks TB LAN GB/sec Tapes PB Tape I/O GB/sec Cabinets 0.1 2005 2006 2007 1.4 7.0 10.4 14.0 40 340 540 740 6 31 46 61 0.2 1 3 5 0.2 0.3 0.5 0.5 250 900 1 400 1 900 Часть 4. GRID-технологии Идея GRID План «ГОЭЛРО»: от разрозненных генерирующих мощностей и разрозненных потребителей — вперед к единой системе (к РАО ЕС) Идея GRID: от разрозненных потребителей и разрозненных компьютерных ресурсов — вперед к единой GRID-системе Идея GRID: интеграция ресурсов Компьютерные и сетевые ресурсы: вычислительные ресурсы хранения источники данных средств передачи данных средства коммуникаций (общения) Access Grid Курчатовский институт, Accesse Centre Visualization & 3D-Collabaration GRID: развитие сетей и требования к пропуску трафика От низких к очень низким потерям пакетов (много меньше 0,01% для TCP) Отсутствие узких мест и компромиссов в качестве 1 – 10 Gbps Ethernet в локальных сетях «Tонкая доводка» стека TCP/IP протоколов, тщательная конфигурация всего сетевого оборудования Мониторинг между любыми двумя конечными точками Тесное взаимодействие между локальными и региональными сетевыми командами Новый TCP протокол для передачи данных со скоростями от 1-10 Гбит/с до 100 Гбит/с Часть 5. ITER и ITER-GRID ITER: управляемый термояд Central Solenoid Nb3Sn, 6 modules Outer Intercoil Structure Toroidal Field Coil Nb3Sn, 18, wedged Poloidal Field Coil Nb-Ti, 6 Machine Gravity Supports (recently remodelled) Blanket Module 421 modules Vacuum Vessel 9 sectors Cryostat 24 m high x 28 m dia. Port Plug (IC Heating) 6 heating 3 test blankets 2 limiters/RH rem. diagnostics Torus Cryopump 8, rearranged Divertor 54 cassettes Thermal Shield Magnets and Structures Main Vacuum Vessel Diagnostics ITER: исследования и разработка (R&D = НИОКР) Семь крупных R&D-проектов ITER-Grid Begin with .. ITER sites/laboratories around the world Add the GLORIAD network to link them together Add Grid services and collaboration with Grid scientists Add other fusion/energy-related sites/laboratories _____________________ Shared Collaboratory ITER-GRID: цели Соединение глобального ITERсообщества высокоскоростной сетью с сервисами для вычислений и хранения данных ITER-GRID: цели Единая «виртуальная лаборатория» из распределенных по всему земному шару участников единого процесса исследований, разработок и эксплуатации установок ITER ITER-GRID: задачи Кибер-инфраструктура организации ITER ITER-Grid как частьGLORIAD Поддержка удаленного участия в проекте: Shared Meeting Rooms, Collaboration Facilities Высокоскоростная сеть передачи данных Совместное управление (Collaborative Control Room Facilities) GRID-вычисления и визуализация Виртуальный термояд: Fusion Power Stimulator Shared Meeting Rooms ITER-GRID Collaboration Facilities ITER-Grid will provide an integrated and technically supported suite of tools for online collaboration, including: point-to-point and multi-point audio/videoconferencing with shared applications archived video and web-casting services services for scheduling and running on-line meetings the ITER “Virtual Office” - a single “local area network” spanning ITER sites around the world – providing such services as transparent file sharing, printer sharing, local telephone exchange (via IP telephony), etc. ITER-GRID: высокоскоростная сеть передачи данных The ITER-Grid network will provide both circuit-switched and traditional routed infrastructure, enabling: dedicated use of special circuits when needed for very high-volume traffic ability to experiment with new network protocols without disrupting traditional services ease of communication with broader commodity and high performance Internet services ITER-GRID: совместное управление (Collaborative Control Room Facilities) ITER-Grid will provide on-line tools to simulate the real ITER control-room environment as it develops It will include access to experimental and monitoring data, ability to steer experiments remotely, etc. This will be supplemented with live video feeds/conferencing facilities and video monitoring equipment ITER-GRID: вычисления ITER-Grid will provide integrated standards-based access to advanced distributed computing facilities using wellestablished software such as the Globus ToolKit ITER-GRID: отображение результатов (Visualization Facilities) The ITER-Grid’s combination of high speed networks, distributed computing facilities, data archives and special software will enable better visualization of: live monitoring data collaborative and real-time experimental models Fusion Power Simulator Hardware & software for burning plasma simulations Using Grid technology Desingn & creation of supercomputer center up to pentaflop performance First step-development of roadmap for that task, using ASCI analog. Use second site for FPS location. ITER-GRID ... to be ready for ITER, the various elements – high speed networks, computational facilities, grid software tools, collaboration facilities, data archive facilities and software, virtual control room facilities, etc. – need to be planned and provisioned today ... Благодарю за внимание! ? Готов ответить на вопросы...