Атрибуты тэгов

advertisement

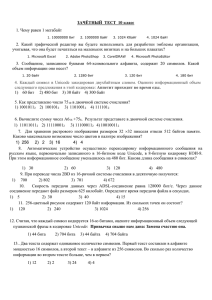

Информация «Двоичное кодирование информации » Занятие № 3 На главную С точки зрения процесса познания информация может рассматриваться как знания. Для количественного определения любой величины необходимо определить единицу измерения. Для определения количества информации необходимо также ввести единицу измерения. За единицу количества информации принято такое количество информации, которое содержит сообщение, уменьшающее неопределенность знания в два раза (из двух возможных событий реализуется одно). Такая единица названа бит. Существует формула, которая связывает между собой количество возможных событий N и количество информации I: N = 2 в степени I На главную Минимальной единицей измерения количества информации является бит, а следующей по величине единицей является байт, причем Компьютер оперирует числами не в десятичной, а в двоичной системе счисления, поэтому в кратных единицах измерения количества информации используется коэффициент 2 в степени n Так, кратные байту единицы измерения количества информации вводятся следующим образом: - 1 байт = 2 в степени 3 бит = 8 бит - 1 Килобайт (Кбайт) = 1024 байт = 2 в степени 10 байт - 1 Мегабайт (Мбайт) = 1024 Кбайт = 2 в степени 20 байт - 1 Гигабайт (Гбайт) = 1024 Мбайт = 2 в степени 30 байт - 1 Терабайт (Тбайт) = 1024 Гбайт = 2 в степени 40 байт - 1 Петабайт (Пбайт) = 1024 Тбайт = 2 в степени 50 байт На главную Количество возможных событий и количество информации. Количество возможных событий и количество информации. Существует формула, которая связывает между собой количество возможных событий N и количество информации /: Для частного, но широко распространенного случая, когда события равновероятны (pj = 1/N), величину количества информации I можно рассчитать по формуле: N=2 в степени I По этой формуле можно легко определить количество возможных событий, если известно количество информации. Например, если мы получили 4 бита информации, то количество возможных событий составляло: N = 2 в степени4 = 16. На главную Алфавитный подход к определению количества информации Набор символов знаковой системы (алфавит) можно рассматривать как различные возможные состояния (события). Тогда, если считать, что появление символов в сообщении равновероятно, по формуле N=2 в степени I можно рассчитать, какое количество информации несет каждый символ. Так, в русском алфавите, если не использовать букву ё, количество событий (букв) будет равно 32. Тогда: 32 = 2 в степени I, откуда I = 5 битов. Количество информации, которое содержит сообщение, закодированное с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на количество знаков. На главную Формула Шеннона I - количество информации, N - количество возможных событий, pi - вероятности отдельных событий. Например, пусть при бросании несимметричной четырехгранной пирамидки вероятности отдельных событий будут следующими: p1 = 1/2, p2 = 1/4, p3 = 1/8, p4 = 1/8,тогда количество информации, которое мы получим после реализации одного из них, можно рассчитать по формуле, приведенной ранее: I = -(1/2·log1/2 + 1/4·log1/4 + 1/8·log1/8 + 1/8·log1/8) бит = (1/2 + 2/4 + 3/8 +3/8) бит = 14/8 бит = 1,75 бит. Для частного, но широко распространенного случая, когда события равновероятны (pi= 1/N), величину количества информации I можно рассчитать по формуле: На главную На главную Информатика « Двоичное кодирование » Пособие составил учитель основ информатики инженер программист Тюменцев А.Б вместе с 8 «а» классом Григориопольской СШ №2 Им. А Стоева. Тел. 3-31-93 Сайт: http://andy.idknet.com E-mail: andy601@mail.ru Григориополь 2006 г. На главную