Принять нельзя отвергнуть (проверка гипотез)

реклама

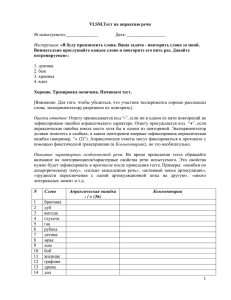

Биостатистика 2. Принять нельзя отвергнуть (проверка гипотез) Рубанович А.В. Институт общей генетики им. Н.И. Вавилова РАН Вероятность упустить и вероятность обознаться До этого момента нас интересовало лишь одно: могут ли наблюдаемые эффекты появиться случайно? Другой аспект той же проблемы: если эффекты не обнаружены, то возможно это тоже проявление случайности? Гипотезы и статистики: необходима формализация Гипотеза – это предположение о виде распределения или значении параметра генерального распределения (например о среднем) Нулевая гипотеза (H0) - обычно предположение о случайном характере наблюдаемых различий или об отсутствии эффектов Альтернативная гипотеза (H1) формулируется в зависимости от характера теста – односторонний или двусторонний. Это совсем не обязательно H 0 Статистический критерий – это правило, согласно которому принимается или отвергается гипотеза. Статистика – это функция от выборочных наблюдений, с помощью которой строится статистический критерий (t, 2, Z, … ) Вероятность упустить и вероятность обознаться В жизни, а также при проведение статистических тестов возможны два типа ошибок: - отвергнуть правильную нулевую гипотезу - принять неправильную нулевую гипотезу Нулевая гипотеза – обычно предположение об отсутствии различий, например, 2 выборки взяты из одной общей (генеральной) совокупности Ошибка I рода () Вероятность отвергнуть правильную нулевую гипотезу = Вероятность обнаружить различия там, где их нет = Вероятность совершить фальшивое открытие Ошибка II рода () Вероятность принять неправильную нулевую гипотезу = Вероятность не обнаружить существующие различия = Вероятность упустить открытие Вероятность упустить и вероятность обознаться Н0 – беременности нет Отвергнута правильная нулевая гипотеза. Сделано фальш-положительное открытие Принята неправильная нулевая гипотеза. Фальш-негативный вывод. Открытие упущено Вероятность упустить и вероятность обознаться «Тест» св. Фомы Неверующего (0033): всегда принимаем Н0 (т.е. различий нет, и все всегда случайно ) Караваджо (1573-1610). Фома Неверующий Каковы ошибки I и II рода для такого теста? =0 =1 Вероятность упустить и вероятность обознаться Простейшая ситуация: тестируем монеты на симметричность Р(0, 1, 2 «орлов» в 10 бросаниях) =БИНОМРАСП(2;10;0,5;1) = 0.0547 Р(0, 1, «орлов» в 10 бросаниях) сумму =БИНОМРАСП(1;10;0,5;1) Считать = 0.0107 от 0 до 2 Но это односторонний тест! Для двустороннего вдвое больше: Р(0, 1 или 9, 10 «орлов» в 10 бросаниях) = 2 0.0107 = 0.0214 Т.о. можно предложить следующий тест на «симметричность» монеты: кидаем 10 раз, и … если #«орлов» = 0, 1 или 9, 10, то монета несимметрична если #«орлов» = 2, 3, …,8 то монета симметрична Каковы ошибки I и II рода для такого теста? Вероятность упустить и вероятность обознаться Н0 – монета симметрична Отвергаем Н0, которая на самом деле верна (ошибка I рода) P(0, 1 или 9, 10 | p 0.5) = 2 * БИНОМРАСП(1;10;0,5;1) = 0.021 Неплохо! Лишь 2% «честных» монет будут неправильно объявлены несимметричными Если уж тест сработал, то монета и впрямь скорей всего несимметрична! Принимаем Н0, которая на самом деле неверна (ошибка II рода) P(2,3...,8 | p 0.4) = БИНОМРАСП(8;10;0,4;1) - БИНОМРАСП(1;10;0,4;1) = 0.952 На картинке это выглядит так: Биномиальное распределение при р = 0,5 и р = 0,4 Н1: монета несимметрична (например, р = 0.4) Н0: монета симметрична (р = 0.5) Ошибка I рода: = сумма красных полосок Ошибка II рода: = сумма желтых полосок Вероятность упустить и вероятность обознаться Н0 – монета симметрична Отвергаем Н0, которая на самом деле верна (ошибка I рода) P(0, 1 или 9, 10 | p 0.5) = 2 * БИНОМРАСП(1;10;0,5;1) = 0.021 Неплохо! Лишь 2% «честных» монет будут неправильно объявлены несимметричными Если уж тест сработал, то монета и впрямь скорей всего несимметрична! Принимаем Н0, которая на самом деле неверна (ошибка II рода) P(2,3...,8 | p 0.4) = БИНОМРАСП(8;10;0,4;1) - БИНОМРАСП(1;10;0,4;1) = 0.952 Плохо! 95% «нечестных» монет будет пропущено Вероятность упустить и вероятность обознаться В каких случая их следует оценивать? Ошибка I рода оценивается всегда! Это гарантия того, что мы не подсунем научной общественности фальшивый результат. Обычно ошибку I рода характеризуют величиной p-value (или просто р): p-value = Р(data | Н0 ) Не вполне точно! p-value = Р(data + data* | Н0 ) где data* - данные с еще более «крутыми» эффектами, Например, проверяя значимость отклонения 1/10 от 0.5, мы вычисляли не P(1 | H 0 ) , а P(0, 1 или 9, 10 | H 0 ) Когда необходимо оценивать ошибку II рода? Это вероятность упустить эффект, если он реально существует. Казалось бы, это наши проблемы Но только не в том случае, если мы публикуем отрицательный результат, т.е. сообщаем об отсутствии эффектов. В этом случае, необходимо приводить ошибку II рода и оценивать при каких объемах выборок она сделается приемлемой. Мощность теста это вероятность правильно отвергнуть нулевую гипотезу или вероятность не упустить открытие Мощность теста = 1- Мощность 80% считается приемлемой Консервативный тест - это тест с низкой мощностью Мощностью теста резко возрастает при увеличении объемов выборок При планировании экспериментов имеет смысл прикинуть возможную мощность тестов Например, Compare2/ Power/ Comparison of proportions Size A - 100 Size B – 100 Мощность = a/A – 0.2 b/B – 0.1 44% … и необходимый объем выборок Например, Compare2/ Sample size/ Proportions Size A/ Size B =1 a/A – 0.2 b/B – 0.1 Общий объем выборок = 398 Прямые и косвенные оценки значимости Для чего придумали статистики – все эти t, 2, Z и т.д. ? Дело в том, что в реальных задачах посчитать напрямую ошибки I и II рода практически невозможно Особенно в случае оценок и сравнений параметров распределений количественных признаков Поэтому, как правило, мы вынуждены поступать по другому: вычисляется некая функция от выборочных наблюдений (т.н. статистика теста), характер распределения которой при нулевой гипотезе заведомо известен. Прямые и косвенные оценки значимости Знакомый пример Эксперимент: 470 орлов в 1000 бросаниях оценка р = 0.47 при n = 1000 Н0 - нулевая гипотеза: р = ½ Н1 - альтернативная гипотеза: р < ½ - односторонний тест 0,4 x 0, 1 Прямая оценка 0,3 f (x ) Вероятность «менее 470 из 1000» при выполнении Н0 (т.е. при условии р = ½ ) = 0.031 0,2 = БИНОМРАСП(470; 1000; 0,5; 1) Принимаем Н1, потому что вероятность отвергнуть правильную Н0 меньше 0.05 Площадь? 0,1 0 Косвенная оценка -4 -3 -2 -1 0 1 2 3 Используем т.н. «Z-статистику»: 1.9 x 4 Z x1 x 2 x x 1 Z 2 p 0.5 = (0,5-0,47)/КОРЕНЬ(0,47*0,53/1000) = 1.9 p(1 p) n = 0.029 =1- НОРМРАСП(1,9; 0; 1;1) Однако по двустороннему тесту (р≠1/2) нам следует отвергнуть Н0: 20.031>0.05 Значимость отличия среднего от нуля Даже в этом простейшем случае получить прямые оценки вероятностей ошибок довольно затруднительно Среднее ошибка среднего Проверяем значимость отличий 21 от 0 (при n = 100). Z - статистика Ошибка I рода x0 x 2 2 1 =1- НОРМРАСП(2; 0; 1; 1) = 0.023 21 vs 0 в STATISTICA (ошибка I рода) SD n SE 100 1 10 21 vs 0 в STATISTICA (ошибка II рода) 21 vs 0 в STATISTICA (ошибка II рода) 1 Sample t-Test: Power Calculation One Mean, t-Test (H0: Mu = Mu0) Power vs. N (Es = 0,2, Alpha = 0,05) ,6 ,5 Power ,4 ,3 ,2 ,1 0,0 0 10 20 30 40 50 60 Sample Size (N) 70 80 90 100 110 21 vs 0 в STATISTICA (ошибка II рода) 1 Sample t-Test: Power Calculation One Mean, t-Test (H0: Mu = Mu0) Power vs. Alpha (Es = 0,2, N = 100) ,9 ,8 Power ,7 ,6 ,5 ,4 ,3 ,2 0,00 0,05 0,10 0,15 Type I Error Rate (Alpha) 0,20 0,25 0,30 Вероятность упустить и вероятность обознаться vs. : противоборство показателей теста Всегда отвергаем Н0 =1, =0 Тест Всегда принимаем Н0 =0, =1 Ошибка I рода Ошибка II рода Гарантирована Уменьшая ошибку I рода, увеличиваем ошибку плохая II рода, воспроизводимость т.е. теряем мощность теста (et converso) Вопрос: рассмотрим варианты 1) = 0.02, = 0.8; 2) = = 0.1; 3) = = 0.5 В каких случаях можно печататься? Какой результат самый надежный? Вероятность упустить и вероятность обознаться В реальных ситуациях мы проверяем обнаруженные эффекты на «случайность» с помощью вспомогательных функций - статистик Частота 0.25 При условии Н0 При условии Н1 0.2 Ошибка I рода 0.15 велика Ошибка II рода велика 0.1 Ошибка II рода мала 0.05 Ошибка I рода мала 0 Высокий Низкий уровень уровень значимости значимости Статистика теста, например, t или 2 От чего зависят ошибки статистических тестов? От размаха реально существующих отличий и разброса данных От объемов выборок • Ошибка I рода (вероятность фальшивого открытия) слабо зависит от объемов выборок, если они сравнимы по величине В каком смысле? Ситуация, типичная для эпидемиологии (или для ассоциативных исследований «case-control») Среди n больных – 9 носителей маркера Среди n контрольных лиц – 1 носитель маркера Рассмотрим случай равных по объему выборок 1 vs 9 1 vs 5 n p-value p-value 30 50 100 200 300 500 0.012 0.016 0.018 0.020 0.020 0.021 0.195 0.204 0.212 p-value почти не зависит 0.215 от n при n > 50 0.216 0.217 При сравнении больших выборок одного порядка ошибка I рода зависит лишь от абсолютных значений эффекта От чего зависят ошибки статистических тестов? От размаха реально существующих отличий и разброса данных От объемов выборок • Ошибка I рода (вероятность фальшивого открытия) слабо зависит от объемов выборок, если они сравнимы по величине • С увеличением объема выборки вероятность ошибки II рода (вероятность упустить открытие) всегда уменьшается Ошибки I и II рода однозначно не связаны. В целом ошибка II рода растет при уменьшении ошибки I рода На сегодня это все Напоследок хочу посоветовать: Односторонние тесты можно использовать лишь в исключительных случаях Попробуйте оценить мощность правила «4 мажоров» Подумайте над тем, ошибки какого рода Вы чаще совершаете – I или II рода?