3 Классификация и регрессия

реклама

Федеральное государственное бюджетное образовательное учреждение

высшего профессионального образования

«Чеченский государственный университет»

Лекции по дисциплине

«Анализ данных»

Направление подготовки

38.03.05 «Бизнес-информатика»

Профиль подготовки

Электронный бизнес

Квалификация

Бакалавр

Форма обучения

Очная

Грозный-2015

Рецензент: _____ С.Р.Шамилев ________________

Составитель; ___ А.Р. Юнусов _________________

Лекции дисциплины «Анализ данных» /сост. А.Р. Юнусов – Грозный: ФГБОУ ВПО

ЧГУ, 2014г.

Лекции предназначены для преподавания дисциплины базовой части цикла

математических и естественнонаучных дисциплин студентам очной формы обучения по

направлению подготовки 38.03.05 «Бизнес-информатика» в 3 семестре.

Лекции составлены с учетом Федерального государственного образовательного

стандарта высшего профессионального образования по направлению подготовки «Бизнесинформатика», утвержденного приказом Министерства образования и науки Российской

Федерации от 14 января 2010 г. N 27

Составитель ____________________ А.Р.Юнусов

(подпись)

«____»____________________2014

А.Р. Юнусов, 2014

ФГБОУ ЧГУ, 2014

Содержание

1 Аффинитивный анализ (affinity analysis) ............................................................................................... 4

2 Кластерный анализ ................................................................................................................................... 5

3 Классификация и регрессия ..................................................................................................................10

4 Классификация и регрессия. Машинное обучение .............................................................................30

5 Анализ и прогнозирование временных рядов .....................................................................................88

6 Ансамбли моделей ...............................................................................................................................121

Литература ...............................................................................................................................................124

1 Аффинитивный анализ (affinity analysis)

Аффинитивный анализ (affinity analysis) — один из распространенных методов Его

название происходит от английского слова affinity, которое в переводе означает

«близость», «сходство». Цель данного метода — исследование взаимной связи между

событиями, которые

происходят совместно. Разновидностью аффинитивного анализа является анализ

рыночной корзины (market basket analysis), цель которого — обнаружить ассоциации

между различными событиями, то есть найти правила для количественного описания

взаимной связи между двумя

или более событиями. Такие правила называются ассоциативными правилами (association

rules). Примерами приложения ассоциативных правил могут быть следующие задачи:

§ выявление наборов товаров, которые в супермаркетах часто покупаются вместе или

никогда не покупаются вместе;

§ определение доли клиентов, положительно относящихся к нововведениям в их

обслуживании;

§ определение профиля посетителей веб-ресурса;

§ определение доли случаев, в которых новое лекарство показывает опасный побочный

эффект.

Базовым понятием в теории ассоциативных правил является транзакция — некоторое

множество событий, происходящих совместно. Типичная транзакция —приобретение

клиентом товара в супермаркете. В подавляющем большинстве случаев клиент покупает

не один товар, а

набор товаров, который называется рыночной корзиной. При этом возникает вопрос:

является ли покупка одного товара в корзине следствием или причиной покупки другого

товара, то есть связаны ли данные события? Эту связь и устанавливают ассоциативные

правила.

Например, может быть обнаружено ассоциативное правило, утверждающее, что клиент,

купивший молоко, с вероятностью 75 % купит и хлеб. Следующее важное понятие —

предметный набор. Это непустое множество предметов, появившихся в одной транзакции.

Анализ рыночной корзины — это анализ наборов данных для определения комбинаций

товаров, связанных между собой. Иными словами, производится поиск товаров,

присутствие которых в транзакции влияет на вероятность наличия других товаров или

комбинаций товаров. Современные кассовые аппараты в супермаркетах позволяют

собирать информацию о покупках, которая может храниться в базе данных. Затем

накопленные данные могут

использоваться для построения систем поиска ассоциативных правил.

2 Кластерный анализ

Кластерный анализ (англ. cluster analysis) — многомерная статистическая процедура,

выполняющая сбор данных, содержащих информацию о выборке объектов, и затем

упорядочивающая объекты в сравнительно однородные группы[1][2][3][4]. Задача

кластеризации относится к статистической обработке, а также к широкому классу

задач обучения без учителя.

Большинство исследователей (см., напр., [5]) склоняются к тому, что впервые термин

«кластерный анализ» (англ. cluster — гроздь, сгусток, пучок) был предложен математиком

Р. Трионом[6]. Впоследствии возник ряд терминов, которые в настоящее время принято

считать синонимами термина «кластерный анализ»: автоматическая классификация,

ботриология.

Спектр применений кластерного анализа очень широк: его используют

в археологии, медицине, психологии, химии, биологии, государственном

управлении, филологии, антропологии, маркетинге, социологии и других дисциплинах.

Однако универсальность применения привела к появлению большого количества

несовместимых терминов, методов и подходов, затрудняющих однозначное

использование и непротиворечивую интерпретацию кластерного анализа.

Кластерный анализ выполняет следующие основные задачи:

Разработка типологии или классификации.

Исследование полезных концептуальных схем группирования объектов.

Порождение гипотез на основе исследования данных.

Проверка гипотез или исследования для определения, действительно ли типы

(группы), выделенные тем или иным способом, присутствуют в имеющихся данных.

Независимо от предмета изучения применение кластерного анализа предполагает

следующие этапы:

Отбор выборки для кластеризации. Подразумевается, что имеет смысл кластеризовать

только количественные данные.

Определение множества переменных, по которым будут оцениваться объекты в

выборке, то есть признакового пространства.

Вычисление значений той или иной меры сходства (или различия) между объектами.

Применение метода кластерного анализа для создания групп сходных объектов.

Проверка достоверности результатов кластерного решения.

Можно встретить описание двух фундаментальных требований предъявляемых к

данным — однородность и полнота. Однородность требует, чтобы все кластеризуемые

сущности были одной природы, описываться сходным набором характеристик[7]. Если

кластерному анализу предшествует факторный анализ, то выборка не нуждается в

«ремонте» — изложенные требования выполняются автоматически самой процедурой

факторного моделирования (есть ещё одно достоинство — z-стандартизация без

негативных последствий для выборки; если её проводить непосредственно для

кластерного анализа, она может повлечь за собой уменьшение чёткости разделения

групп). В противном случае выборку нужно корректировать.

Типология задач кластеризации

Типы входных данных

Признаковое описание объектов. Каждый объект описывается набором своих

характеристик, называемых признаками. Признаки могут быть числовыми или

нечисловыми.

Матрица расстояний между объектами. Каждый объект описывается расстояниями до

всех остальных объектов метрического пространства.

Матрица сходства между объектами[8]. Учитывается степень сходства объекта с

другими объектами выборки в метрическом пространстве. Сходство здесь дополняет

расстояние (различие) между объектами до 1.

В современной науке применяется несколько алгоритмов обработки входных данных.

Анализ путём сравнения объектов, исходя из признаков, (наиболее распространённый в

биологических науках) называется Q-типом анализа, а в случае сравнения признаков, на

основе объектов — R-типом анализа. Существуют попытки использования гибридных

типов анализа (например, RQ-анализ), но данная методология ещё должным образом не

разработана.

Цели кластеризации

Понимание данных путём выявления кластерной структуры. Разбиение выборки на

группы схожих объектов позволяет упростить дальнейшую обработку данных и

принятия решений, применяя к каждому кластеру свой метод анализа (стратегия

«разделяй и властвуй»).

Сжатие данных. Если исходная выборка избыточно большая, то можно сократить её,

оставив по одному наиболее типичному представителю от каждого кластера.

Обнаружение новизны (англ. novelty detection). Выделяются нетипичные объекты,

которые не удаётся присоединить ни к одному из кластеров.

В первом случае число кластеров стараются сделать поменьше. Во втором случае важнее

обеспечить высокую степень сходства объектов внутри каждого кластера, а кластеров

может быть сколько угодно. В третьем случае наибольший интерес представляют

отдельные объекты, не вписывающиеся ни в один из кластеров.

Во всех этих случаях может применяться иерархическая кластеризация, когда крупные

кластеры дробятся на более мелкие, те в свою очередь дробятся ещё мельче, и т. д. Такие

задачи называются задачами таксономии. Результатом таксономии является

древообразная иерархическая структура. При этом каждый объект характеризуется

перечислением всех кластеров, которым он принадлежит, обычно от крупного к мелкому.

Методы кластеризации

Общепринятой классификации методов кластеризации не существует, но можно выделить

ряд групп подходов (некоторые методы можно отнести сразу к нескольким группам и

потому предлагается рассматривать данную типизацию как некоторое приближение к

реальной классификации методов кластеризации)[9]:

1. Вероятностный подход. Предполагается, что каждый рассматриваемый объект

относится к одному из k классов. Некоторые авторы (например, А. И. Орлов)

считают, что данная группа вовсе не относится к кластеризации и

2.

3.

4.

5.

6.

противопоставляют её под названием «дискриминация», то есть выбор отнесения

объектов к одной из известных групп (обучающих выборок).

K-средних (K-means)

K-medians

EM-алгоритм

Алгоритмы семейства FOREL

Дискриминантный анализ

Подходы на основе систем искусственного интеллекта: весьма условная группа,

так как методов очень много и методически они весьма различны.

Метод нечеткой кластеризации C-средних (C-means)

Нейронная сеть Кохонена

Генетический алгоритм

Логический подход. Построение дендрограммы осуществляется с помощью дерева

решений.

Теоретико-графовый подход.

Графовые алгоритмы кластеризации

Иерархический подход. Предполагается наличие вложенных групп (кластеров

различного порядка). Алгоритмы в свою очередь подразделяются на

агломеративные (объединительные) и дивизивные (разделяющие). По количеству

признаков иногда выделяют монотетические и политетические методы

классификации.

Иерархическая дивизивная кластеризация или таксономия. Задачи

кластеризации рассматриваются в количественной таксономии.

Другие методы. Не вошедшие в предыдущие группы.

Статистические алгоритмы кластеризации

Ансамбль кластеризаторов

Алгоритмы семейства KRAB

Алгоритм, основанный на методе просеивания

DBSCAN и др.

Подходы 4 и 5 иногда объединяют под названием структурного или геометрического

подхода, обладающего большей формализованностью понятия близости[10]. Несмотря на

значительные различия между перечисленными методами все они опираются на исходную

«гипотезу компактности»: в пространстве объектов все близкие объекты должны

относиться к одному кластеру, а все различные объекты соответственно должны

находиться в различных кластерах.

k-means (метод k-средних)

k-means (метод k-средних) — наиболее популярный метод кластеризации. Был изобретён

в 1950-х годах математиком Гуго Штейнгаузом[1] и почти одновременно Стюартом

Ллойдом[2]. Особую популярность приобрёл после работы Маккуина[3].

Действие алгоритма таково, что он стремится минимизировать суммарное квадратичное

отклонение точек кластеров от центров этих кластеров:

где — число кластеров,

центры масс векторов

— полученные кластеры,

.

и

—

По аналогии с методом главных компонент центры кластеров называются

также главными точками, а сам метод называется методом главных точек[4] и

включается в общую теорию главных объектов, обеспечивающих

наилучшую аппроксимациюданных[5].

Алгоритм представляет собой версию EM-алгоритма, применяемого также для разделения

смеси гауссиан. Он разбивает множество элементов векторного пространства на заранее

известное число кластеров k.

Основная идея заключается в том, что на каждой итерации перевычисляется центр

масс для каждого кластера, полученного на предыдущем шаге, затем векторы разбиваются

на кластеры вновь в соответствии с тем, какой из новых центров оказался ближе по

выбранной метрике.

Алгоритм завершается, когда на какой-то итерации не происходит изменения центра масс

кластеров. Это происходит за конечное число итераций, так как количество возможных

разбиений конечного множества конечно, а на каждом шаге суммарное квадратичное

отклонение V не увеличивается, поэтому зацикливание невозможно.

Как показали Дэвид Артур и Сергей Васильвицкий, на некоторых классах

множеств сложность алгоритма по времени, нужному для сходимости, равна

.[6]

Нейронные сети Кохонена

Нейронные сети Кохонена — класс нейронных сетей, основным элементом которых

является слой Кохонена. Слой Кохонена состоит из адаптивных линейных

сумматоров («линейных формальных нейронов»). Как правило, выходные сигналы слоя

Кохонена обрабатываются по правилу «Победитель получает всё»: наибольший сигнал

превращается в единичный, остальные обращаются в ноль.

По способам настройки входных весов сумматоров и по решаемым задачам различают

много разновидностей сетей Кохонена[1]. Наиболее известные из них:

сети векторного квантования сигналов[2], тесно связанные с простейшим базовым

алгоритмом кластерного анализа (метод динамических ядер или K-средних);

самоорганизующиеся карты Кохонена (англ. self-organising maps, SOM)[3];

сети векторного квантования, обучаемые с учителем (англ. learning vector

quantization)[4].

Идея и алгоритм обучения

Задача векторного квантования состоит, по своему существу, в

наилучшей аппроксимации всей совокупности векторов данных кодовыми

векторами

. Самоорганизующиеся карты Кохонена также аппроксимируют данные,

однако при наличии дополнительной структуры в совокупности кодовых векторов

(англ. codebook). Предполагается, что априори задана некоторая симметричная таблица

«мер соседства» (или «мер близости») узлов: для каждой пары

(

)

определено число

(

) при этом диагональные элементы таблицы близости

равны единице (

).

Векторы входных сигналов обрабатываются по одному, для каждого из них находится

ближайший кодовый вектор («победитель», который «забирает всё»)

. После этого

все кодовые векторы

, для которых

, пересчитываются по формуле

где

— шаг обучения. Соседи кодового вектора — победителя (по

априорно заданной таблице близости) сдвигаются в ту же сторону, что и этот вектор,

пропорционально мере близости.

Чаще всего, таблица кодовых векторов представляется в виде фрагмента квадратной

решётки на плоскости, а мера близости определяется, исходя из евклидового

расстояния на плоскости.

Самоорганизующиеся карты Кохонена служат, в первую очередь, для визуализации и

первоначального («разведывательного») анализа данных[7]. Каждая точка данных

отображается соответствующим кодовым вектором из решётки. Так получают

представление данных на плоскости («карту данных»). На этой карте возможно

отображение многих слоёв: количество данных, попадающих в узлы (то есть

«плотность данных»), различные функции данных и так далее. При отображении этих

слоёв полезен аппарат географических информационных систем (ГИС). В ГИС

подложкой для изображения информационных слоев служит географическая карта.

Карта данных является подложкой для произвольного по своей природе набора

данных. Карта данных служит заменой географической карте там, где карты данных

просто не существует. Принципиальное отличие в следующем: на географической

карте соседние объекты обладают близкими географическими координатами, на карте

данных близкие объекты обладают близкими свойствами. С помощью карты данных

можно визуализировать данные, одновременно нанося на подложку сопровождающую

информацию (подписи, аннотации, атрибуты, информационные раскраски)[7]. Карта

служит также информационной моделью данных. С её помощью можно заполнять

пробелы в данных. Эта способность используется, например, для решения

задач прогнозирования.

Самоорганизующиеся карты и главные многообразия[править | править викитекст]

Идея самоорганизующихся карт очень привлекательна и породила массу обобщений,

однако, строго говоря, мы не знаем, что мы строим: карта — это результат работы

алгоритма и не имеет отдельного («объектного») определения. Есть, однако, близкая

теоретическая идея — главные многообразия (англ. principal manifolds)[8]. Эти

многообразия обобщают линейные главные компоненты. Они были введены как

линии или поверхности, проходящие через «середину» распределения данных, с

помощью условия самосогласованности: каждая точка на главном

многообразии

является условным математическим ожиданием тех векторов ,

которые проектируются на (при условии

проектирования окрестности

на

),

, где

— оператор

Самоорганизующиеся карты могут рассматриваться как аппроксимации главных

многообразий и популярны в этом качестве[9].

3 Классификация и регрессия

Data Mining — это процесс обнаружения в сырых данных ранее неизвестных,

нетривиальных, практически полезных и доступных интерпретации знаний, необходимых

для принятия решений в различных сферах человеческой деятельности. Это технология,

которая предназначена для поиска в больших объемах данных неочевидных, объективных

и полезных на практике закономерностей.

Основателем и одним из идеологов Data Mining считается Григорий Пятецкий-Шапиро

(Gregory Piatetsky-Shapiro)

Современные технологии Data Mining перерабатывают информацию с целью

автоматического поиска шаблонов (паттернов), характерных для каких-либо фрагментов

неоднородных многомерных данных. В отличие от оперативной аналитической обработки

данных (OLAP) в Data Mining бремя формулировки гипотез и выявления необычных

(unexpected) шаблонов переложено с человека на компьютер. Data Mining — это не один, а

совокупность большого числа различных методов обнаружения знаний. Выбор метода

часто зависит от типа имеющихся данных и от того, какую информацию вы пытаетесь

получить. Вот, например, некоторые методы: ассоциация (объединение), классификация,

кластеризация, анализ временных рядов и прогнозирование, нейронные сети и т. д.

Методы DataMining позволяют решить многие задачи, с которыми сталкивается аналитик.

Из них основными являются: классификация, регрессия, поиск ассоциативных правил и

кластеризация. Ниже приведено краткое описание основных задач анализа данных.

1) Задача классификации сводится к определению класса объекта по его характеристикам.

Необходимо заметить, что в этой задаче множество классов, к которым может быть

отнесен объект, заранее известно.

2) Задача регрессии, подобно задаче классификации, позволяет определить по известным

характеристикам объекта значение некоторого его параметра. В отличие от задачи

классификации значением параметра является не конечное множество классов, а

множество действительных чисел.

3) Задача ассоциации. При поиске ассоциативных правил целью является нахождение

частых зависимостей (или ассоциаций) между объектами или событиями. Найденные

зависимости представляются в виде правил и могут быть использованы как для лучшего

понимания природы анализируемых данных, так и для предсказания появления событий.

4) Задача кластеризации заключается в поиске независимых групп (кластеров) и их

характеристик во всем множестве анализируемых данных. Решение этой задачи помогает

лучше понять данные. Кроме того, группировка однородных объектов позволяет

сократить их число, а следовательно, и облегчить анализ.

5) Последовательные шаблоны – установление закономерностей между связанными во

времени событиями, т.е. обнаружение зависимости, что если произойдет событие X, то

спустя заданное время произойдет событие Y.

6) Анализ отклонений – выявление наиболее нехарактерных шаблонов.

Перечисленные задачи по назначению делятся на описательные и предсказательные.

Описательные (descriptive) задачи уделяют внимание улучшению понимания

анализируемых данных. Ключевой момент в таких моделях — легкость и прозрачность

результатов для восприятия человеком. Возможно, обнаруженные закономерности будут

специфической чертой именно конкретных исследуемых данных и больше нигде не

встретятся, но это все равно может быть полезно и потому должно быть известно. К

такому виду задач относятся кластеризация и поиск ассоциативных правил.

Решение предсказательных (predictive) задач разбивается на два этапа. На первом этапе на

основании набора данных с известными результатами строится модель. На втором этапе

она используется для предсказания результатов на основании новых наборов данных. При

этом, естественно, требуется, чтобы построенные модели работали максимально точно. К

данному виду задач относят задачи классификации и регрессии. Сюда можно отнести и

задачу поиска ассоциативных правил, если результаты ее решения могут быть

использованы для предсказания появления некоторых событий.

По способам решения задачи разделяют на supervised learning (обучение с учителем) и

unsupervised learning (обучение без учителя). Такое название произошло от термина

Machine Learning (машинное обучение), часто используемого в англоязычной литературе

и обозначающего все технологии Data Mining.

В случае supervised learning задача анализа данных решается в несколько этапов. Сначала

с помощью какого-либо алгоритма Data Mining строится модель анализируемых данных –

классификатор. Затем классификатор подвергается обучению. Другими словами,

проверяется качество его работы и, если оно неудовлетворительно, происходит

дополнительное обучение классификатора. Так продолжается до тех пор, пока не будет

достигнут требуемый уровень качества или не станет ясно, что выбранный алгоритм не

работает корректно с данными, либо же сами данные не имеют структуры, которую

можно выявить. К этому типу задач относят задачи классификации и регрессии.

Unsupervised learning объединяет задачи, выявляющие описательные модели, например

закономерности в покупках, совершаемых клиентами большого магазина. Очевидно, что

если эти закономерности есть, то модель должна их представить и неуместно говорить об

ее обучении. Отсюда и название — unsupervised learning. Достоинством таких задач

является возможность их решения без каких-либо предварительных знаний об

анализируемых данных. К ним относятся кластеризация и поиск ассоциативных правил.

При анализе часто требуется определить, к какому из известных классов относятся

исследуемые объекты, т. е. классифицировать их. Например, когда человек обращается в

банк за предоставлением ему кредита, банковский служащий должен принять решение:

кредитоспособен ли потенциальный клиент или нет. Очевидно, что такое решение

принимается на основании данных об исследуемом объекте (в данном случае —

человеке): его месте работы, размере заработной платы, возрасте, составе семьи и т. п. В

результате анализа этой информации банковский служащий должен отнести человека к

одному из двух известных классов «кредитоспособен» и «некредитоспособен».

Другим примером задачи классификации является фильтрация электронной почты. В этом

случае программа фильтрации должна классифицировать входящее сообщение как спам

(нежелательная электронная почта) или как письмо. Данное решение принимается на

основании частоты появления в сообщении определенных слов (например, имени

получателя, безличного обращения, слов и словосочетаний: приобрести, «заработать»,

«выгодное предложение» и т. п.).

В общем случае количество классов в задачах классификации может быть более двух.

Например, в задаче распознавания образа цифр таких классов может быть 10 (по

количеству цифр в десятичной системе счисления). В такой задаче объектом

классификации является матрица пикселов, представляющая образ распознаваемой

цифры. При этом цвет каждого пиксела является характеристикой анализируемого

объекта.

В Data Mining задачу классификации рассматривают как задачу определения ‘значения

одного из параметров анализируемого объекта на основании значений других параметров.

Определяемый параметр часто называют зависимой переменной, а параметры,

участвующие в его определении — независимыми переменными.

Задача классификации и регрессии решается в два этапа. На первом выделяется

обучающая выборка. В нее входят объекты, для которых известны значения как

независимых, так и зависимых переменных. В описанных ранее примерах такими

обучающими выборками могут быть:

– информация о клиентах, которым ранее выдавались кредиты на разные суммы, и

информация об их погашении;

– сообщения, классифицированные вручную как спам или как письмо;

– распознанные ранее матрицы образов цифр.

На основании обучающей выборки строится модель определения значения зависимой

переменной. Ее часто называют функцией классификации или регрессии. Для получения

максимально точной функции к обучающей выборке предъявляются следующие основные

требования:

– количество объектов, входящих в выборку, должно быть достаточно большим. Чем

больше объектов, тем построенная на ее основе функция классификации или регрессии

будет точнее;

– в выборку должны входить объекты, представляющие все возможные классы в случае

задачи классификации или всю область значений в случае задачи регрессии;

– для каждого класса в задаче классификации или каждого интервала области значений в

задаче регрессии выборка должна содержать достаточное количество объектов.

На втором этапе построенную модель применяют к анализируемым объектам (к объектам

с неопределенным значением зависимой переменной).

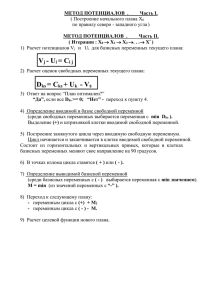

Задача классификации и регрессии имеет геометрическую интерпретацию. Рассмотрим ее

на примере с двумя независимыми переменными, что позволит представить ее в

двумерном пространстве (рис. 2.1.1). Каждому объекту ставится в соответствие точка на

плоскости. Символы «+» и «-» обозначают принадлежность объекта к одному из двух

классов. Очевидно, что данные имеют четко выраженную структуру: все точки класса «+»

сосредоточены в центральной области. Построение классификационной функции сводится

к построению поверхности, которая обводит центральную область. Она определяется как

функция, имеющая значения «+» внутри обведенной области и «-» — вне.

Как видно из рисунка 1, есть несколько возможностей для построения обводящей области.

Вид функции зависит от применяемого алгоритма.

Основные проблемы, с которыми сталкиваются при решении задач классификации и

регрессии, — это неудовлетворительное качество исходных данных, в которых

встречаются как ошибочные данные, так и пропущенные значения, различные типы

атрибутов — числовые и категорические, разная значимость атрибутов, а также так

называемые проблемы overfitting и underfilling.

Рис. 1 Классификация в двумерном пространстве

Суть первой из них заключается в том, что классификационная функция при построении

«слишком хорошо» адаптируется к данным, и встречающиеся в них ошибки и аномальные

значения пытается интерпретировать как часть внутренней структуры данных. Очевидно,

что такая модель будет некорректно работать в дальнейшем с другими данными, где

характер ошибок будет несколько иной. Термином underfitting обозначают ситуацию,

когда слишком велико количество ошибок при проверке классификатора на обучающем

множестве. Это означает, что особых закономерностей в данных не было обнаружено и

либо их нет вообще, либо необходимо выбрать иной метод их обнаружения.

3 Понятие информация, данных, знания

Информация (от лат. informatio, разъяснение, изложение, осведомленность) — сведения о

чем-либо, независимо от формы их представления.

Информация — это:

– данные, определенным образом организованные, имеющие смысл, значение и ценность

для своего потребителя и необходимая для принятия им решений, а также для реализации

других функций и действий;

– совокупность знаний о фактических данных и зависимостях между ними, являющихся

одним из видов ресурсов, используемых человеком в трудовой деятельности и быту;

– сведения о лицах, предметах, фактах, событиях, явлениях и процессах независимо от

формы представления;

– сведения, неизвестные до их получения;

– значение, приписанное данным;

– средство и форма передачи знаний и опыта, сокращающая неопределенность и

случайность и неосведомленность;

– обобщенный термин, относящийся к любым сигналам, звукам, знакам и т.д., которые

могут передаваться, приниматься, записываться и/или храниться

Характерными чертами информации являются следующие:

– это наиболее важный ресурс современного производства: он снижает потребность в

земле, труде, капитале, уменьшает расход сырья и энергии;

– вызывает к жизни новые производства;

– является товаром, причем продавец информации ее не теряет после продажи;

– придает дополнительную ценность другим ресурсам, в частности, трудовым.

Действительно, работник с высшим образованием ценится больше, чем со средним;

– информация может накапливаться.

Известны также следующие трактовки понятия «данные». Данные это:

– факты, цифры, и другие сведения о реальных и абстрактных лицах, предметах,

объектах, явлениях и событиях, соответствующих определенной предметной

области, представленные в цифровом, символьном, графическом, звуковом и любом

другом формате;

– информация, представленная в виде, пригодном для ее передачи и обработки

автоматическими средствами, при возможном участии автоматизированными средствами

с человеком;

– фактический материал, представленный в виде информации, чисел, символов или букв,

используемый для описания личностей, объектов, ситуаций или других понятий с целью

последующего анализа, обсуждения или принятия соответствующих решений.

Из всего многообразия подходов к определению понятия «данные» на наш взгляд

справедливо то, которое говорит о том, что данные несут в себе информацию о событиях,

произошедших в материальном мире, поскольку они являются регистрацией сигналов,

возникших в результате этих событий. Однако данные не тождественны информации.

Станут ли данные информацией, зависит от того, известен ли метод преобразования

данных в известные понятия. То есть, чтобы извлечь из данных информацию необходимо

подобрать соответствующий форме данных адекватный метод получения информации.

Данные, составляющие информацию, имеют свойства, однозначно определяющие

адекватный метод получения этой информации. Причем необходимо учитывать тот факт,

что информация не является статичным объектом — она динамически меняется и

существует только в момент взаимодействия данных и методов. Все прочее время она

пребывает в состоянии данных. Информация существует только в момент протекания

информационного процесса. Все остальное время она содержится в виде данных.

Одни и те же данные могут в момент потребления представлять разную информацию в

зависимости от степени адекватности взаимодействующих с ними методов.

По своей природе данные являются объективными, так как это результат регистрации

объективно существующих сигналах, вызванных изменениями в материальных телах или

полях. Методы являются субъективными. В основе искусственных методов лежат

алгоритмы (упорядоченные последовательности команд), составленные и подготовленные

людьми (субъектами). В основе естественных методов лежат биологические свойства

субъектов информационного процесса. Таким образом, информация возникает и

существует в момент диалектического взаимодействия объективных данных и

субъективных методов.

Переходя к рассмотрению подходов к определению понятия «знания» можно выделить

следующие трактовки. Знания — это:

– вид информации, отражающей знания, опыт и восприятие человека -специалиста

(эксперта) в определенной предметной области;

– множество всех текущих ситуаций в объектах данного типа и способы перехода от

одного описания объекта к другому;

– осознание и толкование определенной информации, с учетом путей наилучшего ее

использования для достижения конкретных целей, характеристиками знаний являются:

внутренняя интерпретируемость, структурируемость, связанность и активность. .

Основываясь на приведенных выше трактовках рассматриваемых понятий, можно

констатировать тот факт, что знание — это информация, но не всякая информация —

знание. Информация выступает как знания, отчужденные от его носителей и

обобществленные для всеобщего пользования. Другими словами, информация — это

превращенная форма знаний, обеспечивающая их распространение и социальное

функционирование. Получая информацию, пользователь превращает ее путем

интеллектуального усвоения в свои личностные знания. Здесь мы имеем дело с так

называемыми информационно-когнитивными процессами, связанными с представлением

личностных знаний в виде информации и воссозданием этих знаний на основе

информации

Таким образом, учитывая вышеизложенное, можно сделать вывод, что фиксируемые

воспринимаемые факты окружающего мира представляют собойданные. При

использовании данных в процессе решения конкретных задач — появляется информация.

Результаты решения задач, истинная, проверенная информация (сведения), обобщенная в

виде законов, теорий, совокупностей взглядов и представлений представляет

собой знания

13 Технология и методы обработки экономической информации

Сбор, хранение, обработка, передача информации в числовой форме осуществляется с

помощью информационных технологий. Особенностью информационных технологий

является то, что в них и предметом и продуктом труда является информация, а орудиями

труда – средства вычислительной техники и связи.

Основная цель информационных технологий — производство необходимой пользователю

информации в результате целенаправленных действий по ее переработке.

Технология автоматизированной обработки экономической информации строится на

следующих принципах:

• интеграции обработки данных и возможности работы пользователей в условиях

эксплуатации автоматизированных систем централизованного хранения и коллективного

использования данных (банков данных);

• распределенной обработки данных на базе развитых систем передачи;

• рационального сочетания централизованного и децентрализованного управления и

организации вычислительных систем;

• моделирования и формализованного описания данных, процедур их преобразования,

функций и рабочих мест исполнителей;

• учета конкретных особенностей объекта, в котором реализуется машинная обработка

экономической информации.

Обработка экономической информации предполагает выполнение логических и

арифметических операций над исходными данными. Логическая обработка включает

операции сортировки (подбор, упорядочение, объединение), выборку данных из

информационной базы и т.п. Арифметические операции – алгебраическое сложение,

деление, умножение и т.д.

Системы обработки финансово-экономической информации служат для обработки

числовых данных, характеризующих различные производственно-экономические и

финансовые явления и объекты, а также для составления соответствующих

управленческих документов и информационно-аналитических материалов. Они

включают: универсальные табличные процессоры (Microsoft Excel); специализированные

бухгалтерские программы («1С: Бухгалтерия»); специализированные банковские

программы (для внутрибанковских и межбанковских расчетов); специализированные

программы финансово-экономического анализа и планирования и др.

При поиске решений в экономической сфере используются следующие методы обработки

и анализа информации:

1. Эвристические — используются когда информации недостаточно и нельзя точно

очертить границы применения формализованных методов, оценить допуск ошибки:

– метод коллективного блокнота;

– мозговой штурм;

– приём синектики;

– кейс-метод;

2. Традиционные методы:

– метод сравнения;

– метод относительных и сравнительных величин;

– графический метод;

– метод группировки.

3. Способ детерминированных факторов:

– способ цепных подстановок;

– способ абсолютных разниц;

– способ относительных разниц;

4. Способы стохастического факторного анализа

– корелляционно-регрессионный анализ;

– дисперсионный анализ;

– компонентный анализ;

– многомерный факторный анализ.

5. Способы оптимизированных показателей

– экономико-математические методы;

– программирование;

– теория массового обследования;

– теория игр;

– исследование операций.

С учётом сферы применения в экономике выделяют:

– банковские информационные системы;

– информационные системы фондового рынка;

– страховые информационные системы;

– налоговые информационные системы;

– информационные системы промышленных предприятий и организаций (бухгалтерские и

иные информационные системы);

– статистические информационные системы и др.

К видам экономических задач относят:

– учётно-операционные работы (в т.ч. учёт труда, зарплаты, материалов и пр.),

– расчёт нормативов, межбанковские расчёты,

– прогнозно-аналитические работы,

– лизинг,

– обслуживание клиентов, в т.ч. с помощью пластиковых карт.

23 Мультимедийные технологии

Технология мультимедиа (лат. multi – «много», media – «среда») – способ представления

информации в компьютере с возможностью одновременного использования текста,

графики, звука, видео и анимационных эффектов.

Мультимедийные технологии — это совокупность современных средств аудио- теле-,

визуальных и виртуальных коммуникаций, используемых в процессе организации,

планирования и управления различных видов деятельности.

Средства мультимедиа позволяют создавать базы, банки данных и знаний в сфере

культуры, науки и производства. Такие продукты всё более завоёвывают рынок

пользователей. Мультимедиа технологии широко используются в рекламной

деятельности, при организации управления маркетингом средств и методов продвижения

товаров и услуг, в обучении и досуговой деятельности.

К компьютерным средствам мультимедиа относят: специальное ПО, а также: CD и DVD

драйверы и компакт-диски к ним; аудиокарты, аудио колонки, наушники и микрофоны;

видеокарты; аудио- и видео периферийные устройства (цифровые кинокамеры и

фотоаппараты и др.).

Технология мультимедиа позволяет вводить, сохранять, перерабатывать и воспроизводить

текстовую, аудиовизуальную, графическую, трёхмерную и иную информацию. Свойство

интегрировать эти виды данных, компактно и длительно хранить их на электронных

носителях, не разрушающихся со временем и не ухудшающих свои характеристики при

копировании, позволяет утверждать, что они могут отражать богатейшие национальные

богатства России в мультимедийных БД, которые вместе с системами гипертекста,

гипермедиа и WWW обеспечат пользователям почти моментальный доступ к любому их

фрагменту.

Организации и подразделения, обладающие информационными ресурсами и средствами

мультимедиа, использующими мультимедийные технологии порой

называют медиатеками. В России медиатеки находят широкое распространение в

библиотеках и учебных заведениях. В этом случае считается, что медиатека – хранилище

информационных медиаресурсов.

Технические средства мультимедиа, как и любые компьютерные информационные

системы, позволяют выполнять все виды информационных процессов.

23 Управление проектами в Microsoft Project

Управление проектами (проектный менеджмент — project management)- это

планирование, координация и контроль работ по проекту для достижения его целей в

рамках установленного бюджета и сроков, с надлежащим качеством.

К достаточно распространенным и поддерживаемым на российском рынке

программным продуктам относятся «большие» мультипроектные профессиональные

системы — PrimaVera Planner , Open Plan Professional и более «скромные» — Microsoft

Project , Sure Track Manager.

Наиболее популярна на сегодняшний день в мире программа управления проектами

MS Project.

Microsoft Project стал фактически стандартом среди средств автоматизации

индивидуальной работы менеджеров проектов. Свою популярность он заслужил

благодаря удачному сочетанию простоты использования, дружеского интерфейса и

наиболее необходимых инструментов управления проектами.

Microsoft Project рассчитан, в первую очередь, на пользователей, которые не являются

профессионалами в управлении проектами. Таким образом, его можно отнести к

«непрофессиональным системам» управления проектами. с другой стороны, с помощью

Microsoft Project можно управлять проектами со значительным количеством работ и

ресурсов.

Microsoft Project входит в семейство Microsoft Office, что подтверждается следующими

его свойствами:

построение интерфейса и справочной системы на единственных с Microsoft Office

принципах;

возможность сохранения данных проектов в базе данных Access;

двусторонний обмен данными с Outlook;

Среди преимуществ Microsoft Project также можно назвать усовершенствованные средства

групповой работы, что позволяют одному менеджеру одновременно управлять

несколькими проектами с большим числом участников. По мнению Gartner Group,

Microsoft Project – лучший выбор для организаций, где используется матричная схема

управления, то есть проектные команды допускают взаимодействие сотрудников из

разных департаментов.

К недостаткам системы можно отнести ограниченные средства управления бюджетом и

отсутствие средств для управления рисками проекта.

Для расширения функциональности системы разработанные дополнительные модули,

доступные для бесплатной загрузки через Internet. Кроме того, существует web-сервис

Microsoft ProjectCentral.com, предназначенный для организации совместной работы над

проектами для групп, распределенных территориально. ProjectCentral.com предоставляет

членам рабочей группы и всем заинтересованным лицам веб-страницы для работы с

информацией проекта.

43 Статистические пакеты

Потребность в средствах статистического анализа данных очень велика, что и послужило

причиной для развития рынка статистических программ.

Наилучший выбор статистического пакета для анализа данных зависит от характера

решаемых задач, объема обрабатываемых данных, квалификации пользователей,

имеющегося оборудования.

Число статистических пакетов, получивших распространение в России, достаточно велико

(несколько десятков). Из зарубежных пакетов

этоSTATGRAPHICS, SYSTAT, STATISTICA, SPSS, SAS, CSS. Из отечественных можно

назвать такие пакеты, как STADIA, ЭВРИСТА, МЕЗОЗАВР, САНИ, КЛАСС-МАСТЕР,

СТАТЭксперт и др.

Для пользователей, имеющих дело со сверхбольшими объемами данных или

узкоспециальными методами анализа, пока нет альтернативы использованию

профессиональных западных пакетов. Среди интерактивных пакетов такого рода

наибольшими возможностями обладает пакетSAS.

Если Вам необходимо обработать данные умеренных объемов (несколько сотен или тысяч

наблюдений) стандартными статистическими методами, подойдет универсальный или

специальный статистический пакет, надо только убедиться, что он содержит нужные

методы обработки.

Пакеты STADIA и STATISTICA являются универсальными пакетами, содержащими

большинство стандартных статистических методов. Пакеты SPSS и SyStat перенесены на

персональные компьютеры с больших ЭВМ предыдущих поколений, поэтому, наряду с

представительным набором тщательно реализованных вычислительных методов, они

сохраняют и некоторые архаические элементы. Однако имеющиеся в них возможности

командного языка (впрочем, очень непростые в изучении и использовании) могут быть

весьма полезны для сложных задач обработки данных.

Пакеты STADIA и STATISTICA исходно разработаны для ПЭВМ, а поэтому проще в

обращении. Эти пакеты, пожалуй, содержат наибольшее количество методов

статистического анализа.

STATISTICA — это универсальная интегрированная система, предназначенная для

статистического анализа, визуализации данных и разработки пользовательских

приложений. Программа содержит широкий набор процедур анализа для применения в

научных исследованиях, технике, бизнесе. Помимо общих статистических и графических

средств в системе имеются специализированные модули, например, для проведения

социологических или биомедицинских исследований, решения технических и

промышленных задач: карты контроля качества, анализ процессов и планирование

эксперимента.

Универсальный российский статистический пакет STADIA — за 15 лет существования и

развития стал аналитическим инструментом для многих тысяч пользователей в различных

областях науки, техники, планирования, управления, производства, сельского хозяйства,

экономики, бизнеса, маркетинга, образования, медицины по всей русскоязычной Евразии.

По своим базовым возможностям сопоставим с наиболее известными западными

статистическими пакетами. Отличается простотой использования применительно к

отечественной аудитории.

Следует обратить внимание на удивительную компактность пакета STADIA: он требует в

несколько раз меньше места на диске, чем его конкуренты, и при этом не уступает, а часто

и превосходит их по своим функциональным возможностям.

Простая линейная регрессия

В предыдущих заметках предметом анализа часто становилась отдельная числовая

переменная, например, доходность взаимных фондов, время загрузки Web-страницы или

объем потребления безалкогольных напитков. В настоящей и следующих заметках мы

рассмотрим методы предсказания значений числовой переменной в зависимости от

значений одной или нескольких других числовых переменных.1

Материал будет проиллюстрирован сквозным примером. Прогнозирование объема

продаж в магазине одежды. Сеть магазинов уцененной одежды Sunflowers на

протяжении 25 лет постоянно расширялась. Однако в настоящее время у компании

нет систематического подхода к выбору новых торговых точек. Место, в котором

компания собирается открыть новый магазин, определяется на основе

субъективных соображений. Критериями выбора являются выгодные условия

аренды или представления менеджера об идеальном местоположении магазина.

Представьте, что вы — руководитель отдела специальных проектов и

планирования. Вам поручили разработать стратегический план открытия новых

магазинов. Этот план должен содержать прогноз годового объема продаж во вновь

открываемых магазинах. Вы полагаете, что торговая площадь непосредственно

связана с объемом выручки, и хотите учесть этот факт в процессе принятия

решения. Как разработать статистическую модель, позволяющую прогнозировать

годовой объем продаж на основе размера нового магазина?

Как правило, для предсказания значений переменной используется регрессионный анализ.

Его цель — разработать статистическую модель, позволяющую предсказывать значения

зависимой переменной, или отклика, по значениям, по крайней мере одной, независимой,

или объясняющей, переменной. В настоящей заметке мы рассмотрим простую линейную

регрессию — статистический метод, позволяющий предсказывать значения зависимой

переменной Y по значениям независимой переменной X. В последующих заметках будет

описана модель множественной регрессии, предназначенная для предсказания значений

независимой переменной Y по значениям нескольких зависимых переменных (Х1, Х2, …,

Xk).2

Виды регрессионных моделей

1

2

Используются материалы книги Левин и др. Статистика для менеджеров. – М.: Вильямс, 2004. – с. 792–872

Если зависимая переменная является категорийной, необходимо применять логистическую регрессию.

В заметке Представление числовых данных в виде таблиц и диаграмм для иллюстрации

зависимости между переменными X и Y использовалась диаграмма разброса. На ней

значения переменной X откладывались по горизонтальной оси, а значения переменной Y

— по вертикальной. Зависимость между двумя переменными может быть разной: от

самой простой до крайне сложной. Пример простейшей (линейной) зависимости показан

на рис. 1.

Рис. 1. Положительная линейная зависимость

Простая линейная регрессия:

(1) Yi = β0 + β1Xi + εi

где β0 — сдвиг (длина отрезка, отсекаемого на координатной оси прямой Y), β1 — наклон

прямой Y, εi — случайная ошибка переменной Y в i-м наблюдении.

В этой модели наклон β1 представляет собой количество единиц измерения переменной Y,

приходящихся на одну единицу измерения переменной X. Эта величина характеризует

среднюю величину изменения переменной Y (положительного или отрицательного) на

заданном отрезке оси X. Сдвиг β0 представляет собой среднее значение переменной Y,

когда переменная X равна 0. Последний компонент модели εi является случайной ошибкой

переменной Y в i-м наблюдении. Выбор подходящей математической модели зависит от

распределения значений переменных X и Y на диаграмме разброса. Различные виды

зависимости переменных показаны на рис. 2.

Рис. 2. Диаграммы разброса, иллюстрирующие разные виды зависимостей

На панели А значения переменной Y почти линейно возрастают с увеличением переменной

X. Этот рисунок аналогичен рис. 1, иллюстрирующему положительную зависимость

между размером магазина (в квадратных футах) и годовым объемом продаж. Панель Б

является примером отрицательной линейной зависимости. Если переменная X возрастает,

переменная Y в целом убывает. Примером этой зависимости является связь между

стоимостью конкретного товара и объемом продаж. На панели В показан набор данных, в

котором переменные X и Y практически не зависят друг от друга. Каждому значению

переменной X соответствуют как большие, так и малые значения переменной Y. Данные,

приведенные на панели Г, демонстрируют криволинейную зависимость между

переменными X и Y. Значения переменной Y возрастают при увеличении переменной X,

однако скорость роста после определенных значений переменной X падает. Примером

положительной криволинейной зависимости является связь между возрастом и

стоимостью обслуживания автомобилей. По мере старения машины стоимость ее

обслуживания сначала резко возрастает, однако после определенного уровня

стабилизируется. Панель Д демонстрирует параболическую U-образную форму

зависимости между переменными X и Y. По мере увеличения значений переменной X

значения переменной Y сначала убывают, а затем возрастают. Примером такой

зависимости является связь между количеством ошибок, совершенных за час работы, и

количеством отработанных часов. Сначала работник осваивается и делает много ошибок,

потом привыкает, и количество ошибок уменьшается, однако после определенного

момента он начинает чувствовать усталость, и число ошибок увеличивается. На панели Е

показана экспоненциальная зависимость между переменными X и Y. В этом случае

переменная Y сначала очень быстро убывает при возрастании переменной X, однако

скорость этого убывания постепенно падает. Например, стоимость автомобиля при

перепродаже экспоненциально зависит от его возраста. Если перепродавать автомобиль в

течение первого года, его цена резко падает, однако впоследствии ее падение постепенно

замедляется.

Мы кратко рассмотрели основные модели, которые позволяют формализовать

зависимости между двумя переменными. Несмотря на то что диаграмма разброса

чрезвычайно полезна при выборе математической модели зависимости, существуют более

сложные и точные статистические процедуры, позволяющие описать отношения между

переменными. В дальнейшем мы будем рассматривать лишь линейную зависимость.

Вывод уравнения простой линейной регрессии

Вернемся к сценарию, изложенному в начале главы. Наша цель — предсказать объем

годовых продаж для всех новых магазинов, зная их размеры. Для оценки зависимости

между размером магазина (в квадратных футах) и объемом его годовых продаж создадим

выборки из 14 магазинов (рис. 3).

Рис. 3. Площади и годовые объемы продаж 14 магазинов сети Sunflowers: (а) исходные

данные; (б) диаграмма разброса

Анализ рис. 3 показывает, что между площадью магазина X и годовым объемом продаж Y

существует положительная зависимость. Если площадь магазина увеличивается, объем

продаж возрастает почти линейно. Таким образом, наиболее подходящей для

исследования является линейная модель. Остается лишь определить, какая из линейных

моделей точнее остальных описывает зависимость между анализируемыми переменными.

Множественная линейная регрессия

Задачей множественной линейной регрессии является построение линейной модели связи

между набором непрерывных предикторов и непрерывной зависимой переменной. Часто

используется следующее регрессионное уравнение:

(1)

Здесь аi - регрессионные коэффициенты, b0 - свободный член(если он используется), е член, содержащий ошибку - по поводу него делаются различные предположения, которые,

однако, чаще сводятся к нормальности распределения с нулевым вектором мат. ожидания

и корреляционной матрицей .

Такой линейной моделью хорошо описываются многие задачи в различных предметных

областях, например, экономике, промышленности, медицине. Это происходит потому, что

некоторые задачи линейны по своей природе.

Приведем простой пример. Пусть требуется предсказать стоимость прокладки дороги по

известным ее параметрам. При этом у нас есть данные о уже проложенных дорогах с

указанием протяженности, глубины обсыпки, количества рабочего материала, числе

рабочих и так далее.

Ясно, что стоимость дороги в итоге станет равной сумме стоимостей всех этих факторов в

отдельности. Потребуется некоторое количество, например, щебня, с известной

стоимостью за тонну, некоторое количество асфальта также с известной стоимостью.

Возможно, для прокладки придется вырубать лес, что также приведет к дополнительным

затратам. Все это вместе даст стоимость создания дороги.

При этом в модель войдет свободный член, который, например, будет отвечать за

организационные расходы (которые примерно одинаковы для всех строительномонтажных работ данного уровня) или налоговые отчисления.

Ошибка будет включать в себя факторы, которые мы не учли при построении модели

(например, погоду при строительстве - ее вообще учесть невозможно).

Пример: множественный регрессионный анализ

Для этого примера будут анализироваться несколько возможных корреляций уровня

бедности и степень, которая предсказывает процент семей, находящихся за чертой

бедности. Следовательно мы будем считать переменную характерезующую процент

семей, находящихся за чертой бедности, - зависимой переменной, а остальные

переменные непрерывными предикторами.

Коэффициенты регрессии

Чтобы узнать, какая из независимых переменных делает больший вклад в предсказание

уровня бедности, изучим стандартизованные коэффициенты (или Бета) регрессии.

Рис. 1. Оценки параметров коэффициентов регрессии.

Коэффициенты Бета это коэффициенты, которые вы бы получили, если бы привели все

переменные к среднему 0 и стандартному отклонению 1. Следовательно величина этих

Бета коэффициентов позволяет сравнивать относительный вклад каждой независимой

переменной в зависимую переменную. Как видно из Таблицы, показанной выше,

переменные изменения населения с 1960 года (POP_ CHING), процент населения,

проживающего в деревне (PT_RURAL) и число людей, занятых в сельском хозяйстве

(N_Empld) являются самыми главными предикторами уровня бедности, т.к. только они

статистически значимы (их 95% доверительный интервал не включает в себя 0).

Коэффициент регрессии изменения населения с 1960 года (Pop_Chng) отрицательный,

следовательно, чем меньше возрастает численность населения, тем больше семей, которые

живут за чертой бедности в соответствующем округе. Коэффициент регрессии для

населения (%), проживающего в деревне (Pt_Rural) положительный, т.е., чем больше

процент сельских жителей, тем больше уровень бедности.

Значимость эффектов предиктора

Просмотрим Таблицу с критериями значимости.

Рис. 2. Одновременные результаты для каждой заданной переменной.

Как показывает эта Таблица, статистически значимы только эффекты 2 переменных:

изменение населения с 1960 года (Pop_Chng) и процент населения, проживающего в

деревне (Pt_Rural), p < .05.

Анализ остатков. После подгонки уравнения регрессии, почти всегда нужно проверять

предсказанные значения и остатки. Например, большие выбросы могут сильно исказить

результаты и привести к ошибочным выводам.

Построчный график выбросов

Обычно необходимо проверять исходные или стандартизованные остатки на большие

выбросы.

Рис. 3. Номера наблюдений и остатки.

Шкала вертикальной оси этого графика отложена по величине сигма, т.е., стандартного

отклонения остатков. Если одно или несколько наблюдений не попадают в интервал ± 3

умноженное на сигма, то, возможно, стоит исключить эти наблюдения (это можно легко

сделать через условия выбора наблюдений) и еще раз запустить анализ, чтобы убедится,

что результаты не изменяются этими выбросами.

Логистическая регрессия

Линейная регрессионная модель не всегда способна качественно предсказывать значения

зависимой переменной. Выбирая для построения модели линейное уравнение, мы

естественным образом не накладываем никаких ограничений на значения зависимой

переменной. А такие ограничения могут быть существенными.

Например, при проектировании оптимальной длины шахты лифта в новом здании

необходимо учесть, что эта длина не может превышать высоту здания вообще.

Линейная регрессионная модель может дать результаты, несовместимые с реальностью. С

целью решения данных проблем полезно изменить вид уравнения регрессии и подстроить

его для решения конкретной задачи.

Вообще, логит регрессионная модель предназначена для решения задач предсказания

значения непрерывной зависимой переменной, при условии, что эта зависимая

переменная может принимать значения на интервале от 0 до 1.

В силу такой специфики, ее часто используют для предсказания вероятности наступления

некоторого события в зависимости от значений некоторого числа предикторов.

Можно использовать логит регрессию и для решения задач с бинарным откликом. Такие

задачи появляются, когда зависимая переменная может принимать только два значения.

Приведем конкретный пример. Пусть требуется предсказать эффективность операции по

пересадке сердца. Такие операции очень сложны и результата от их проведения может

быть только два- пациент жив или умер (точнее, пережил ли он месяц после

трансплантации - этот срок является определяющим).

В качестве предикторов используются данные предоперационного обследования и

клинические параметры, например, возраст, уровень холестерина в крови, давление,

группа крови и т.д. Задача свелась к классификации пациентов на две группы. Для первой

группы прогноз положительный, для второй - отрицательный. Решение подобной задачи

может повлиять на принятие решения о проведении операции - стоит ли вообще

проводить пересадку, если вероятность пережить месяц после трансплантации для

пациента невелика?

Математическая основа логистической регрессии

Итак, как уже было сказано, в логит регрессионной модели предсказанные значения

зависимой переменной или переменной отклика не могут быть меньше (или равными) 0,

или больше (или равными) 1, не зависимо от значений независимых переменных;

поэтому, эта модель часто используется для анализа бинарных зависимых переменных

или переменных отклика.

При этом используется следующее уравнение регреcсии (термин логит был впервые

использован Berkson, 1944):

y=exp(b0+b1*x1+...+bn*xn)/[1+exp(b0+b1*x1+...+bn*xn)]

Легко увидеть, что независимо от регрессионных коэффициентов или величин х,

предсказанные значения (у) в этой модели всегда будут лежать в диапазоне от 0 до 1.

Термин логит произошел от того, что эту модель легко линеаризовать с помощью логит

преобразования. Предположим, что бинарная зависимая переменная y является

непрерывной вероятностью p, лежащей в диапазоне от 0 до 1. Тогда можно преобразовать

эту вероятность p следующим образом:

p' = loge {p/(1-p)}

Это преобразование называется логит или логистическим преобразованием.

Заметим, что p' теоретически может принимать любые значения от минус до плюс

бесконечности. Поскольку логит преобразование решает проблему 0/1 границ для

исходной зависимой переменной (вероятности), то можно использовать эти (логит

преобразованные) значения в обычном линейном уравнении регресии.

Фактически, при проведении логит преобразования обеих частей логит регрессионного

уравнения, приведенного выше, мы получим стандартную линейную модель

множественной регрессии:

p' = b0+ b1*x1+ b2*x2+ ... + bn*xn

Подобное уравнение нам уже знакомо. Решив его, мы получим значения регрессионных

коэффициентов, по которым затем можно восстановить вероятность р.

Особенности логит регрессии

Однако, применение логистического преобразования к уравнению логит регрессии

порождает определенные проблемы.

При решении задачи линейной регрессии мы подгоняли к наблюдаемым значениям

некоторую гиперповерхность - прямую в случае простой регрессии, плоскость - в случае

двух независимых переменных. Также мы требуем нормальность и некоррелированность

ошибок.

При переходе к уравнению логит регрессии подгоняемая поверхность уже не будет иметь

такой простой вид. Также, нас не спасет уже и нормальность ошибок.

Все это делает невозможным использования методов оценивания, применяемых для

линейных задач.

Например, в случае одной независимой переменной для простой регрессии применялся

известный метод наименьших квадратов. В случае простой логит регрессии такой метод

уже неприменим. Неприменимыми являются и подобные методы для решения задач с

большим числом предикторов.

Поэтому для решения задач логит регрессии используется только метод максимального

правдоподобия. Вкратце, процесс оценки регрессионных коэффициентов сводится к

максимизации вероятности появления конкретной выборки (при заданных наблюдаемых

значениях). Это приводит к часто невысокому проценту корректной классификации.

Логит регрессия также слабо устойчива к излишней подгонке.

Множественная логистическая регрессия.

В общем виде рассматривают множественную логистическую регрессию для описания

дискретной зависимой переменной с конечным числом (2 и более) значений.

Множественная логистическая регрессия представляет дискретную переменную Y,

имеющую G (G ≥ 2) значений {Y1, Y2,…,YG} через набор из р независимых переменных

X1, X2, …, Xp. Заметим, что при применении логистической регрессии не

предполагается какое-либо упорядочение значений зависимой переменной, Y

используется как номинальная переменная. Одно из ее значений используется для

определения базовой или референтной группы, а все остальные выступают равноправно

как метки опытных или исследуемых групп. Разница между множественной

логистической регрессией и логистической регрессией для бинарного отклика – чисто

техническая, определяемая числом групп G. Однако в тех случаях, когда исследователь

может выбирать между применением нескольких бинарных и полиномиальной зависимой

переменной, следует остановить свой выбор именно на бинарных переменных, поскольку

интерпретация полученных результатов будет проще. В частности, независимые

переменные, необходимые для описания одной группы, могут оказаться излишними при

описании другой. А при использовании множественной логистической регрессии они все

должны быть включены в уравнения.

Обозначим набор независимых переменных Х = (Х1, Х2, … , Хр), а набор

соответствующих всем значениям зависимой переменной параметров β обозначим

Если для бинарной зависимой переменной логистическая модель задается одним

уравнением, то в общем случае для этого требуется G-1 уравнение - по количеству

значений зависимой переменной минус 1 – из-за использования одной из групп, обычно

первой, в качестве референтной. Необходимость референтной группы связана с тем, что

логистическая модель описывает не вероятности, а отношения вероятностей

принадлежности к группам:

(5.6)

pg – это вероятность того, что наблюдение, для которого независимые переменные имеют

значения X1, X2, …, Xp, относится к группе g, т.е. зависимая переменная Y принимает

значение Yg

pg = Prob(Y = Yg | X)

Обычно в модель включено пересечение, или свободный член, но это не обязательно.

Величины Р1, Р2, … , РG - это априорные вероятности групп.

Референтной (reference) называется первая по порядку группа в уравнениях. Выбор

референтной группы произвольный, но осмысленный. Обычно это наибольшая группа или

контрольная группа, с которой сравниваются все остальные группы.

{βij} – это множество регрессионных коэффициентов (неизвестных), которые требуется

оценить по имеющимся данным. Эти оценки обозначаются {bij}.

Оценки максимального правдоподобия параметров {βij} получаются с помощью

нахождения точки экстремума логарифма отношения правдоподобия. Формулы

приведены в Приложении. Там же описаны основные статистики, применяемые для

оценки результатов применения логистической регрессии.

4 Классификация и регрессия. Машинное обучение

Data Mining — это процесс обнаружения в сырых данных ранее неизвестных,

нетривиальных, практически полезных и доступных интерпретации знаний, необходимых

для принятия решений в различных сферах человеческой деятельности. Это технология,

которая предназначена для поиска в больших объемах данных неочевидных, объективных

и полезных на практике закономерностей.

Основателем и одним из идеологов Data Mining считается Григорий Пятецкий-Шапиро

(Gregory Piatetsky-Shapiro)

Современные технологии Data Mining перерабатывают информацию с целью

автоматического поиска шаблонов (паттернов), характерных для каких-либо фрагментов

неоднородных многомерных данных. В отличие от оперативной аналитической обработки

данных (OLAP) в Data Mining бремя формулировки гипотез и выявления необычных

(unexpected) шаблонов переложено с человека на компьютер. Data Mining — это не один, а

совокупность большого числа различных методов обнаружения знаний. Выбор метода

часто зависит от типа имеющихся данных и от того, какую информацию вы пытаетесь

получить. Вот, например, некоторые методы: ассоциация (объединение), классификация,

кластеризация, анализ временных рядов и прогнозирование, нейронные сети и т. д.

Методы DataMining позволяют решить многие задачи, с которыми сталкивается аналитик.

Из них основными являются: классификация, регрессия, поиск ассоциативных правил и

кластеризация. Ниже приведено краткое описание основных задач анализа данных.

1) Задача классификации сводится к определению класса объекта по его характеристикам.

Необходимо заметить, что в этой задаче множество классов, к которым может быть

отнесен объект, заранее известно.

2) Задача регрессии, подобно задаче классификации, позволяет определить по известным

характеристикам объекта значение некоторого его параметра. В отличие от задачи

классификации значением параметра является не конечное множество классов, а

множество действительных чисел.

3) Задача ассоциации. При поиске ассоциативных правил целью является нахождение

частых зависимостей (или ассоциаций) между объектами или событиями. Найденные

зависимости представляются в виде правил и могут быть использованы как для лучшего

понимания природы анализируемых данных, так и для предсказания появления событий.

4) Задача кластеризации заключается в поиске независимых групп (кластеров) и их

характеристик во всем множестве анализируемых данных. Решение этой задачи помогает

лучше понять данные. Кроме того, группировка однородных объектов позволяет

сократить их число, а следовательно, и облегчить анализ.

5) Последовательные шаблоны – установление закономерностей между связанными во

времени событиями, т.е. обнаружение зависимости, что если произойдет событие X, то

спустя заданное время произойдет событие Y.

6) Анализ отклонений – выявление наиболее нехарактерных шаблонов.

Перечисленные задачи по назначению делятся на описательные и предсказательные.

Описательные (descriptive) задачи уделяют внимание улучшению понимания

анализируемых данных. Ключевой момент в таких моделях — легкость и прозрачность

результатов для восприятия человеком. Возможно, обнаруженные закономерности будут

специфической чертой именно конкретных исследуемых данных и больше нигде не

встретятся, но это все равно может быть полезно и потому должно быть известно. К

такому виду задач относятся кластеризация и поиск ассоциативных правил.

Решение предсказательных (predictive) задач разбивается на два этапа. На первом этапе на

основании набора данных с известными результатами строится модель. На втором этапе

она используется для предсказания результатов на основании новых наборов данных. При

этом, естественно, требуется, чтобы построенные модели работали максимально точно. К

данному виду задач относят задачи классификации и регрессии. Сюда можно отнести и

задачу поиска ассоциативных правил, если результаты ее решения могут быть

использованы для предсказания появления некоторых событий.

По способам решения задачи разделяют на supervised learning (обучение с учителем) и

unsupervised learning (обучение без учителя). Такое название произошло от термина

Machine Learning (машинное обучение), часто используемого в англоязычной литературе

и обозначающего все технологии Data Mining.

В случае supervised learning задача анализа данных решается в несколько этапов. Сначала

с помощью какого-либо алгоритма Data Mining строится модель анализируемых данных –

классификатор. Затем классификатор подвергается обучению. Другими словами,

проверяется качество его работы и, если оно неудовлетворительно, происходит

дополнительное обучение классификатора. Так продолжается до тех пор, пока не будет

достигнут требуемый уровень качества или не станет ясно, что выбранный алгоритм не

работает корректно с данными, либо же сами данные не имеют структуры, которую

можно выявить. К этому типу задач относят задачи классификации и регрессии.

Unsupervised learning объединяет задачи, выявляющие описательные модели, например

закономерности в покупках, совершаемых клиентами большого магазина. Очевидно, что

если эти закономерности есть, то модель должна их представить и неуместно говорить об

ее обучении. Отсюда и название — unsupervised learning. Достоинством таких задач

является возможность их решения без каких-либо предварительных знаний об

анализируемых данных. К ним относятся кластеризация и поиск ассоциативных правил.

При анализе часто требуется определить, к какому из известных классов относятся

исследуемые объекты, т. е. классифицировать их. Например, когда человек обращается в

банк за предоставлением ему кредита, банковский служащий должен принять решение:

кредитоспособен ли потенциальный клиент или нет. Очевидно, что такое решение

принимается на основании данных об исследуемом объекте (в данном случае —

человеке): его месте работы, размере заработной платы, возрасте, составе семьи и т. п. В

результате анализа этой информации банковский служащий должен отнести человека к

одному из двух известных классов «кредитоспособен» и «некредитоспособен».

Другим примером задачи классификации является фильтрация электронной почты. В этом

случае программа фильтрации должна классифицировать входящее сообщение как спам

(нежелательная электронная почта) или как письмо. Данное решение принимается на

основании частоты появления в сообщении определенных слов (например, имени

получателя, безличного обращения, слов и словосочетаний: приобрести, «заработать»,

«выгодное предложение» и т. п.).

В общем случае количество классов в задачах классификации может быть более двух.

Например, в задаче распознавания образа цифр таких классов может быть 10 (по

количеству цифр в десятичной системе счисления). В такой задаче объектом

классификации является матрица пикселов, представляющая образ распознаваемой

цифры. При этом цвет каждого пиксела является характеристикой анализируемого

объекта.

В Data Mining задачу классификации рассматривают как задачу определения ‘значения

одного из параметров анализируемого объекта на основании значений других параметров.

Определяемый параметр часто называют зависимой переменной, а параметры,

участвующие в его определении — независимыми переменными.

Задача классификации и регрессии решается в два этапа. На первом выделяется

обучающая выборка. В нее входят объекты, для которых известны значения как

независимых, так и зависимых переменных. В описанных ранее примерах такими

обучающими выборками могут быть:

– информация о клиентах, которым ранее выдавались кредиты на разные суммы, и

информация об их погашении;

– сообщения, классифицированные вручную как спам или как письмо;

– распознанные ранее матрицы образов цифр.

На основании обучающей выборки строится модель определения значения зависимой

переменной. Ее часто называют функцией классификации или регрессии. Для получения

максимально точной функции к обучающей выборке предъявляются следующие основные

требования:

– количество объектов, входящих в выборку, должно быть достаточно большим. Чем

больше объектов, тем построенная на ее основе функция классификации или регрессии

будет точнее;

– в выборку должны входить объекты, представляющие все возможные классы в случае

задачи классификации или всю область значений в случае задачи регрессии;

– для каждого класса в задаче классификации или каждого интервала области значений в

задаче регрессии выборка должна содержать достаточное количество объектов.

На втором этапе построенную модель применяют к анализируемым объектам (к объектам

с неопределенным значением зависимой переменной).

Задача классификации и регрессии имеет геометрическую интерпретацию. Рассмотрим ее

на примере с двумя независимыми переменными, что позволит представить ее в

двумерном пространстве (рис. 2.1.1). Каждому объекту ставится в соответствие точка на

плоскости. Символы «+» и «-» обозначают принадлежность объекта к одному из двух

классов. Очевидно, что данные имеют четко выраженную структуру: все точки класса «+»

сосредоточены в центральной области. Построение классификационной функции сводится

к построению поверхности, которая обводит центральную область. Она определяется как

функция, имеющая значения «+» внутри обведенной области и «-» — вне.

Как видно из рисунка 1, есть несколько возможностей для построения обводящей области.

Вид функции зависит от применяемого алгоритма.

Основные проблемы, с которыми сталкиваются при решении задач классификации и

регрессии, — это неудовлетворительное качество исходных данных, в которых