Выбор способа представления информации в соответствии с

реклама

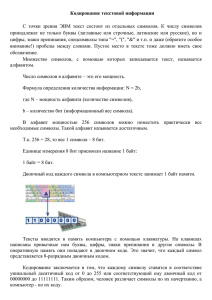

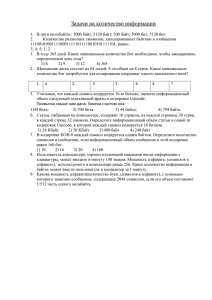

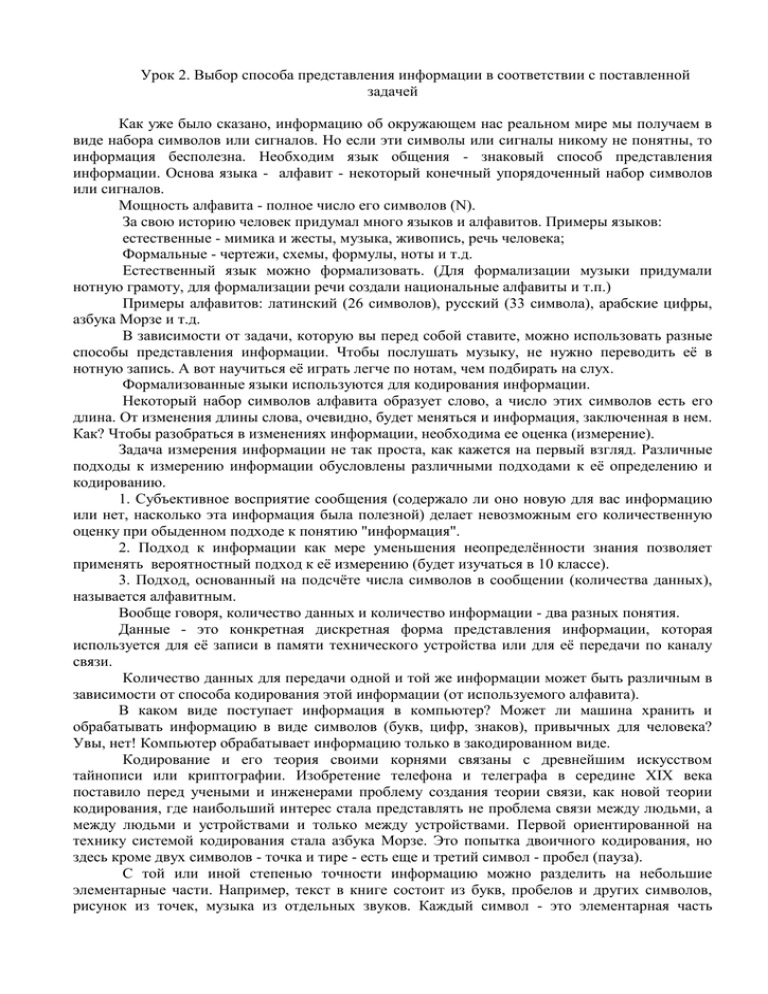

Урок 2. Выбор способа представления информации в соответствии с поставленной задачей Как уже было сказано, информацию об окружающем нас реальном мире мы получаем в виде набора символов или сигналов. Но если эти символы или сигналы никому не понятны, то информация бесполезна. Необходим язык общения - знаковый способ представления информации. Основа языка - алфавит - некоторый конечный упорядоченный набор символов или сигналов. Мощность алфавита - полное число его символов (N). За свою историю человек придумал много языков и алфавитов. Примеры языков: естественные - мимика и жесты, музыка, живопись, речь человека; Формальные - чертежи, схемы, формулы, ноты и т.д. Естественный язык можно формализовать. (Для формализации музыки придумали нотную грамоту, для формализации речи создали национальные алфавиты и т.п.) Примеры алфавитов: латинский (26 символов), русский (33 символа), арабские цифры, азбука Морзе и т.д. В зависимости от задачи, которую вы перед собой ставите, можно использовать разные способы представления информации. Чтобы послушать музыку, не нужно переводить её в нотную запись. А вот научиться её играть легче по нотам, чем подбирать на слух. Формализованные языки используются для кодирования информации. Некоторый набор символов алфавита образует слово, а число этих символов есть его длина. От изменения длины слова, очевидно, будет меняться и информация, заключенная в нем. Как? Чтобы разобраться в изменениях информации, необходима ее оценка (измерение). Задача измерения информации не так проста, как кажется на первый взгляд. Различные подходы к измерению информации обусловлены различными подходами к её определению и кодированию. 1. Субъективное восприятие сообщения (содержало ли оно новую для вас информацию или нет, насколько эта информация была полезной) делает невозможным его количественную оценку при обыденном подходе к понятию "информация". 2. Подход к информации как мере уменьшения неопределённости знания позволяет применять вероятностный подход к её измерению (будет изучаться в 10 классе). 3. Подход, основанный на подсчёте числа символов в сообщении (количества данных), называется алфавитным. Вообще говоря, количество данных и количество информации - два разных понятия. Данные - это конкретная дискретная форма представления информации, которая используется для её записи в памяти технического устройства или для её передачи по каналу связи. Количество данных для передачи одной и той же информации может быть различным в зависимости от способа кодирования этой информации (от используемого алфавита). В каком виде поступает информация в компьютер? Может ли машина хранить и обрабатывать информацию в виде символов (букв, цифр, знаков), привычных для человека? Увы, нет! Компьютер обрабатывает информацию только в закодированном виде. Кодирование и его теория своими корнями связаны с древнейшим искусством тайнописи или криптографии. Изобретение телефона и телеграфа в середине XIX века поставило перед учеными и инженерами проблему создания теории связи, как новой теории кодирования, где наибольший интерес стала представлять не проблема связи между людьми, а между людьми и устройствами и только между устройствами. Первой ориентированной на технику системой кодирования стала азбука Морзе. Это попытка двоичного кодирования, но здесь кроме двух символов - точка и тире - есть еще и третий символ - пробел (пауза). С той или иной степенью точности информацию можно разделить на небольшие элементарные части. Например, текст в книге состоит из букв, пробелов и других символов, рисунок из точек, музыка из отдельных звуков. Каждый символ - это элементарная часть информации. Информация будет закодированной, если любая ее элементарная часть представлена в виде числа или набора чисел. Поскольку компьютеры работают на электричестве, естественно было бы для кодирования выбрать разные состояния электрического тока (сильный - слабый, включено - выключено). Исторически принято эти два состояния обозначать через 0 и 1. В каких единицах измерять эту закодированную информацию? Посмотрите на произвольное число (код): 10100111. Как бы Вы измерили количество информации, закодированной в нем? Проще всего посчитать, сколько цифр потребовалось для кодирования данной информации. Таким образом, единицей информации становится одна двоичная цифра: 0 или 1. Эту минимальную единицу измерения Н. Винер назвал бит (английское bit, сокращенное от binary digit - двоичная цифра). Бит - самое короткое слово двоичного алфавита, причем цифры 0 и 1 при этом равноправны. Количество информации в двоичном коде 10100111 равно 8 бит. Но 1 бит - это очень маленькое количество информации. Для удобства введена более крупная единица, принятая Международной системой СИ за основную - байт (byte). Один байт - это информация, которая кодируется восьмиразрядным (8 цифр) двоичным кодом. 1 байт = 8 бит При алфавитном подходе считается, что каждый символ текста имеет определённый информационный вес (b), зависящий от мощности алфавита. 1 бит - это информационный вес символа двоичного алфавита. С увеличением мощности алфавита увеличивается информационный вес символов этого алфавита. Почему? Тут придется вспомнить комбинаторику. Сколько разных сообщений можно закодировать одной цифрой двоичного алфавита? - Два (0 или 1) Двумя цифрами? - Четыре (00, 01, 10, 11) И т.д. Известна формула: число перестановок (возможных различных кодов) из n цифр равно 2n Другими словами Информационный вес символа, выраженный в битах (b), и мощность алфавита (N) связаны формулой N=2b Символов на нашей клавиатуре около 200 (русский и латинский алфавит, строчные и прописные буквы, цифры, знаки препинания, спецсимволы). Попробуем подобрать число n, достаточное для кодирования этих символов: 27 = 128 (мало), 28 = 256 (хватит). Поэтому в кодировке ASCII 1 символ текста кодируется одним байтом (8 битами). Байт - это не только единица информации, но и элементарная ячейка памяти компьютера. Память компьютера состоит из последовательности таких ячеек. Каждая ячейка имеет адрес - номер ячейки и содержимое - двоичный код, который хранится в ней. Количество данных, обрабатываемых компьютером, измеряется в байтах, но чаще для этого используются более крупные единицы: 1 Килобайт (Кб) = 210 байт = 1024 байт 1 Мегабайт (Мб) = 210 Кб = 1 048 576 байт 1 Гигабайт (Гб) = 210 Мб = 1 073 741 824 байт Тест по теме «Информационные процессы» 1.Что изучает информатика? А) конструкцию компьютера; Б) способы представления, накопления обработки информации с помощью технических средств; В) компьютерные программы; Г) общешкольные дисциплины; 2.Выберете события, которое можно отнести к информационным процессам: А) упражнение на спортивном снаряде; Б) перекличка присутствующих на уроке; В) водопад; Г) катание на карусели; 3. Что изучает из ниже перечисленного имеет свойства передавать информацию? А) камень; Б) вода; В) папирус; Г) световой луч; 4. Что изучает из ниже перечисленного вовлечено в информационный процесс? А) песок; Б) дом; В) камень; Г) человек; 5.Каким свойством обладают объекты: колокол, речь, костёр, радио, электронная почта? А) хранят информацию; Б) обрабатывают информацию; В) передают информацию; Г) создают информацию; 6.Какой объект не могут служить носителем информации при её хранении? А) ткань; Б) бумага; В) магнитные материалы; Г) луч света; 7.Человек принимает информацию: А) магнитным полем; Б) органами чувств; В) внутренними органами; Г) инструментальными средствами; 8. Какой из перечисленных процессов НЕЛЬЗЯ назвать информационным процессом? А) Взвешивании информации; Б) Кодирование информации; В) Хранение информации; Г) Обработка информации 9. Примерами информационных процессов могут служить: А) Процессы строительства зданий и сооружений; Б) Процессы химической и механической очистки воды; В) Процессы поиска нужной литературы с помощью библиотечного каталога; Г) Процессы производства электроэнергии; Д) Процессы извлечения полезных ископаемых из недр Земли.