Эффективность векторной нейронной сети с огрубленной

advertisement

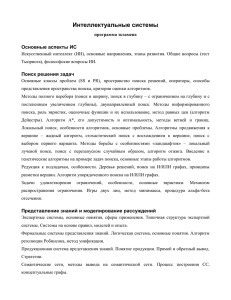

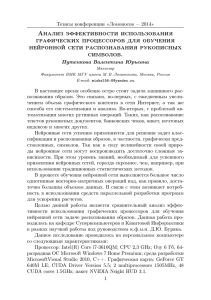

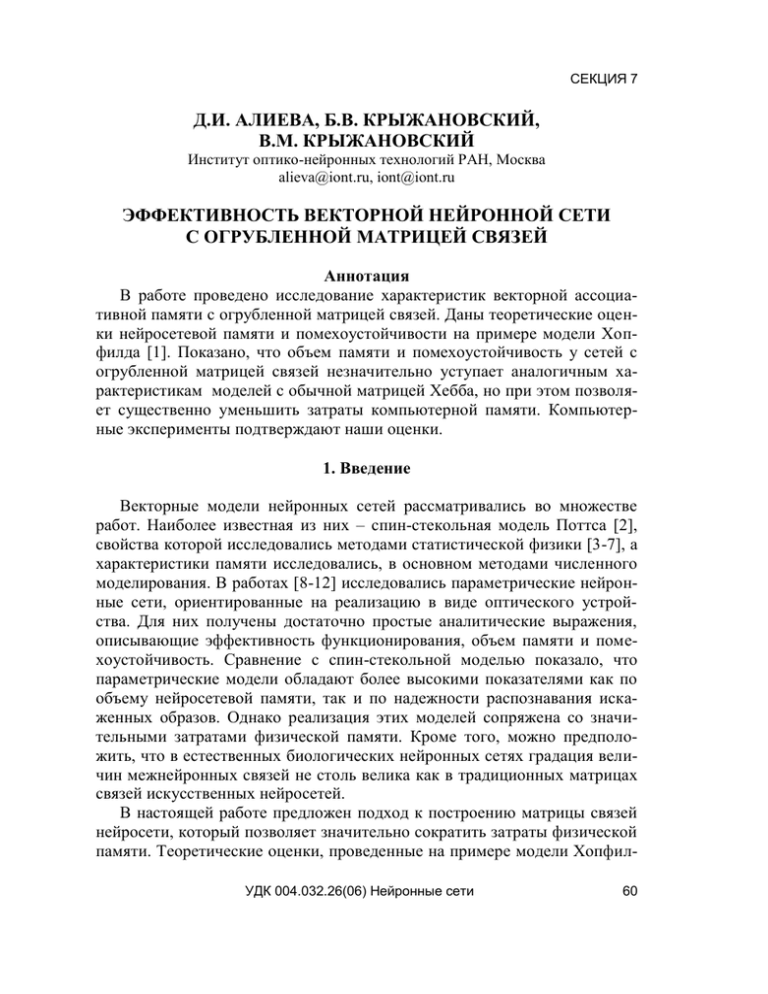

СЕКЦИЯ 7 Д.И. АЛИЕВА, Б.В. КРЫЖАНОВСКИЙ, В.М. КРЫЖАНОВСКИЙ Институт оптико-нейронных технологий РАН, Москва alieva@iont.ru, iont@iont.ru ЭФФЕКТИВНОСТЬ ВЕКТОРНОЙ НЕЙРОННОЙ СЕТИ С ОГРУБЛЕННОЙ МАТРИЦЕЙ СВЯЗЕЙ Аннотация В работе проведено исследование характеристик векторной ассоциативной памяти с огрубленной матрицей связей. Даны теоретические оценки нейросетевой памяти и помехоустойчивости на примере модели Хопфилда [1]. Показано, что объем памяти и помехоустойчивость у сетей с огрубленной матрицей связей незначительно уступает аналогичным характеристикам моделей с обычной матрицей Хебба, но при этом позволяет существенно уменьшить затраты компьютерной памяти. Компьютерные эксперименты подтверждают наши оценки. 1. Введение Векторные модели нейронных сетей рассматривались во множестве работ. Наиболее известная из них – спин-стекольная модель Поттса [2], свойства которой исследовались методами статистической физики [3-7], а характеристики памяти исследовались, в основном методами численного моделирования. В работах [8-12] исследовались параметрические нейронные сети, ориентированные на реализацию в виде оптического устройства. Для них получены достаточно простые аналитические выражения, описывающие эффективность функционирования, объем памяти и помехоустойчивость. Сравнение с спин-стекольной моделью показало, что параметрические модели обладают более высокими показателями как по объему нейросетевой памяти, так и по надежности распознавания искаженных образов. Однако реализация этих моделей сопряжена со значительными затратами физической памяти. Кроме того, можно предположить, что в естественных биологических нейронных сетях градация величин межнейронных связей не столь велика как в традиционных матрицах связей искусственных нейросетей. В настоящей работе предложен подход к построению матрицы связей нейросети, который позволяет значительно сократить затраты физической памяти. Теоретические оценки, проведенные на примере модели ХопфилУДК 004.032.26(06) Нейронные сети 60 СЕКЦИЯ 7 да, показали, что объем нейросетевой памяти и помехоустойчивость таких сетей лишь незначительно уступают аналогичным характеристикам сетей с обычной матрицей Хебба. Проведено компьютерное моделирование, которое подтвердило теоретические оценки. Кроме того, эксперименты показали, что с увеличением уровня искажений помехоустойчивость и емкость нейросетевой памяти моделей как с обычной матрицей Хебба, так и с огрубленной становятся равными. 2. Параметрическая нейросеть с огрубленной матрицей связей Рассмотрим сеть, состоящую из N связанных друг с другом формальных нейронов. Нейрон может находиться в одном из q различных дискретных состояний, где q1. Состоянию нейрона с номером k ставится в соответствие орт ek в пространстве R q ( k 1,2,..., q ). Вектору состояния нейрона следует приписывать еще и знак, поскольку он может быть направлен вдоль или против соответствующего орта. Таким образом, со стояние i-го нейрона будем описывать q-мерным вектором xi xi ek(i) , где ek(i ) R q , i 1,2,..., N , а амплитуда состояния может принимать два зна чения xi 1 . Состояние сети X как целого задается набором из N q мерных векторов xi : (1) X ( x1 , x2 ,...,x N ) . Будем считать, что сеть построена на M паттернах: X ( x 1 , x 2 ,..., x N ) , (2) где 1,2,...,M . Поскольку нейроны у нас являются векторами, локальное поле, дей ствующее на i-й нейрон со стороны сети, тоже будет вектором hi . По аналогии с обычной моделью Хопфилда запишем: N hi ˆ ij x j . (3) j 1 Величина связи между i-м и j-м нейронами – это не скаляр, как в обычной модели Хопфилда, а (q q) -матрица ̂ ij : УДК 004.032.26(06) Нейронные сети 61 СЕКЦИЯ 7 M ˆ ij sign (1 ij ) x i x j , 1 (4) где xi – вектор-столбец, т.е. ij M sign xi x j . (5) Гамильтониан системы примет вид: N H 12 xi ˆ ij x j . (6) i, j Динамику нашей системы q -мерных нейронов определим следующим образом. Пусть X X (t ) – состояние системы в момент времени t . Обо значим орт, проекция локального поля hi (t ) на который больше проекций на все остальные орты через e max . Тогда решающее правило динамики таково: под воздействием локального поля i-й нейрон в момент времени t + 1 ориентируется вдоль орта e max , если emaxh (t ) 0 , или в противопо ложном e max направлении, если emaxh (t ) 0 , т.е. (7) x(t 1) sign [emaxh (t )] emax . Динамика системы состоит в последовательном изменении состояний нейронов по правилу (7). Такая динамика соответствует понижению энергии системы в процессе ее функционирования и, следовательно, алгоритм сходится. На языке спиновых моделей динамика, описываемая решающим правилом (7), означает, что «спин-нейрон» ориентируется вдоль направления, наиболее близкого к направлению внешнего поля (спин не может ориентироваться вдоль направления внешнего поля, поскольку принимает только дискретные состояния). 3. Эффективность распознавания паттернов Можно показать, что при q = 1 параметрическая нейронная сеть переходит в хорошо известную модель Хопфилда. Проведем оценку эффекУДК 004.032.26(06) Нейронные сети 62 СЕКЦИЯ 7 тивности распознавания паттернов для модели Хопфилда с огрубленной матрицей связей. Сеть состоит из N связанных друг с другом нейронов. Нейроны могут принимать значения 1. Состояние сети задается вектором X ( x1 , x 2 ,..., x N ) . Локальное поле, действующее на i-й нейрон со стороны сети, имеет вид hi ij x j , (8) j где ij – величина связи между i-м и j-м нейронами ij sign x i x j . (9) Динамика сети соответствует динамике обычной модели Хопфилда. Пусть начальное состояние сети задается искаженным m-м паттерном X ( x1 , x 2 ,..., x N ) , где xi pi x mi . Здесь pi – оператор искажения, который с вероятностью p меняет значение нейрона на противоположное, а с вероятностью 1 – p оставляет его неизменным. Проанализируем насколько верно нейронная сеть распознает паттерн Xm. Для начала заметим, что если i-й нейрон искажен, для его правильного распознавания необходимо, чтобы он перевернулся под действием локального поля. И наоборот, если нейрон не искажен, для правильного распознавания его состояние должно остаться неизменным. Таким образом, получаем условие правильного распознавания x m i x j sign x m i x m j (1 x m i x m j xi xj ) 0 . j i m (10) Для оценки ошибки распознавания можно воспользоваться центральной предельной теоремой. В результате, для вероятности ошибки распознавания вектора X m получим выражение: Pr NM 2 N exp (1 2 p )2 . M УДК 004.032.26(06) Нейронные сети (11) 63 СЕКЦИЯ 7 С ростом N эта вероятность сходится к нулю всякий раз, когда величина M как функция N растет медленнее, чем M N (1 2 p ) 2 , ln N (12) что позволяет рассматривать величину (12) как асимптотически достижимую емкость памяти данной нейросети. 4. Обсуждение результатов Как видно из выражения (11) сеть с огрубленной матрицей связей лишь незначительно уступает по распознающей способности сети с обычной матрицей Хебба, для которой вероятность ошибки распознавания оценивается как Pr NM 2 N exp (1 2 p) 2 2M Однако компьютерное моделирование показало, что при увеличении уровня искажений сеть с огрубленной матрицей показывает результаты, аналогичные сети с матрицей Хебба. На рис. 1 сплошные кривые соответствуют зависимости ошибки распознавания от уровня загрузки для сети Хопфилда с матрицей Хебба, а маркером отмечена та же зависимость для сети с огрубленной матрицей. Хорошо видно, что при нулевых искажениях сеть с огрубленной матрицей работает немного хуже, а при уровне искажений 30 % кривые совпадают. Машинные эксперименты, которые проводились для параметрической нейронной сети (ПНС) с обычной и огрубленной матрицами связей показали, что при небольшом уровне искажений распознающая способность ПНС с обычной матрицей Хебба несколько выше. Однако с увеличением уровня искажений это превосходство нивелируется. На рис. 2 показана зависимость ошибки распознавания от уровня загрузки сети при различной величине искажений. Сплошные линии соответствуют ПНС с обычной матрицей Хебба, а маркер – с огрубленной. Заметно, что уже при искажении равном 20 % сеть с огрубленной матрицей работает лучше. 1,2 Ошибка 1,0 0,8 0,6 0,4 p=30% УДК 004.032.26(06) Нейронные сети p=0% 64 СЕКЦИЯ 7 Ошибка распознавания P 0,8 0,7 0,6 p = 30 0,5 0,4 p = 20 0,3 p=0 0,2 0,1 0,0 1 3 5 7 9 11 13 15 Загрузка M / N Рис. 2. Сравнение ПНС с обычной (сплошные линии) и огрубленной (маркер) матрицами связей N = 20, q = 16 Более того, при больших значениях q ПНС с огрубленной матрицей работает существенно лучше. На рис. 3 преимущество ПНС с огрубленной матрицей очевидно. шибка распознавания P 1,2 1 0,8 0,6 0,4 0,2 УДК 004.032.26(06) Нейронные сети 65 СЕКЦИЯ 7 На рис. 4, где показана разность ошибки распознавания двух сетей при разных уровнях искажения, легко видеть, что с увеличением искажений преимущество сети с огрубленной матрицей монотонно возрастает. Разность ошибки Огруб-Нормал 0,0400 p=0 p=5 p=10 0,0200 0,0000 -0,0200 p=15 -0,0400 p=20 -0,0600 p=30 -0,0800 -0,1000 1 3 5 7 9 11 Загрузка M / N Рис. 4. Разность ошибки распознавания двух ПНС – сетей (огрубл. и нормал.) при изменении уровня искажений от 0 до 30 % Теоретические оценки для параметрической сети с огрубленной матрицей нами еще не получены. Однако оценки, проведенные для сети Хопфилда с огрубленной матрицей, а так же результаты машинных эксУДК 004.032.26(06) Нейронные сети 66 СЕКЦИЯ 7 периментов позволяют говорить о том, что помимо ожидаемого выигрыша по физической памяти, при определенных параметрах сеть с огрубленной матрицей имеет преимущество перед сетью с обычной матрицей Хебба. Причины данного феномена будут выясняться в дальнейших исследованиях. Работа выполнена при поддержке РФФИ (проекты 04-07-90038, 03-01-00355) и проекта ОИТВС № 1.8. Список литературы 1. Hopfield J.J. //Proc.Nat.Acad.Sci.USA. 1982. V.79. P.2554-255. 2. Ido Kanter. Potts-glass models of neural networks. Physical Review A. 1988. V.37 (7). Р.2739-2742. 3. Cook J. The mean-field theory of a Q-state neural network model. Journal of Physics A. 22. 2000-2012 (1989). 4. Vogt H., Zippelius A. Invariant recognition in Potts glass neural networks. Journal of Physics A. 25. 2209-2226 (1992). 5. Bolle D., Dupont P. & van Mourik J. Stability properties of Potts neural networks with biased patterns and low loading. Journal of Physics A. 24. 1065-1081 (1991). 6. Bolle D., Dupont P. & Huyghebaert J. Thermodynamics properties of the q-state Pottsglass neural network. Phys. Rew. A. 45. 4194-4197 (1992). 7. Wu F.Y. The Potts model. Review of Modern Physics. 54. 235-268 (1982) 8. Крыжановский Б.В., Микаэлян А.Л. О распознающей способности нейросети на нейронах с параметрическим преобразованием частот. Доклады АН. Сер. мат. физика. 2002. Т.383. № 3. С.318-321. 9. Kryzhanovsky B.V., Kryzhanovsky V.M., Mikaelian A.L. and Fonarev A. Parametric dynamic neural network recognition power // Optical Memory&Neural Network. 2001. Vol. 10. № 4. Р.211-218. 10. Крыжановский Б.В., Литинский Л.Б. Параметрическая модель нейронной сети. V Всероссийская научно-техническая конференция «НЕЙРОИНФОРМАТИКА-2003». Сборник трудов. Т.1. С.109-116. 11. Алиева Д.И., Крыжановский Б.В. Безфазовая модель параметрической нейронной сети. Интеллектуальные системы. IEEE AIS’2003. Геленджик-2003. Т.1. С.511-517. 12. Крыжановский Б.В., Микаэлян А.Л. Ассоциативная память, способная распознавать сильно скоррелированные образы. Доклады АН, информатика. 2003. Т.390. № 1. С.27-31. УДК 004.032.26(06) Нейронные сети 67