Курс лекций для студентов специальности ПОИТ

реклама

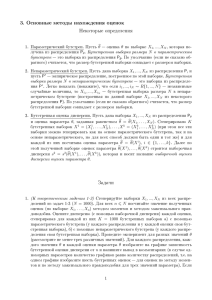

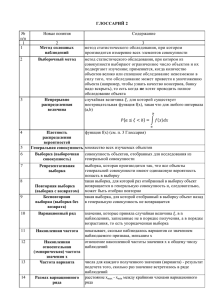

Математическая статистика.

Вариационные ряды и их характеристики.

Определение: Генеральной совокупностью называется совокупность объектов или наблюдений,

все элементы которой подлежат изучению, при статистическом анализе.

Понятие генеральной совокупности аналогична понятию случайной величины.

Генеральная совокупность может быть конечной иди бесконечной.

Определение: Объектом генеральной совокупности называется число её объектов или

наблюдений.

Определение: Выборочной совокупностью или выборкой называется часть объектов генеральной

совокупности использованной для исследования.

Сущность выборочного метода в математической статистике заключается в том, что бы по

определению части генеральной совокупности выборки судить о её свойствах в целом. Для того, что

бы по выборке можно было судить о генеральной совокупности выборка должна быть

репрезентативной.

Определение: Репрезентативная выборка обеспечивается случаем отбора её элементов, т. к. все

элементы генеральной совокупности должны иметь одинаковую вероятность попадания в выборку.

Имеется 2 способа образования выборки:

1)

повторная выборка (когда каждый элемент случайно обобранный и исследованный

возвращается в общую совокупность и может быть отобран повторно);

2)

бесповторная выборка (когда отобранный элемент не возвращается в общую

совокупность).

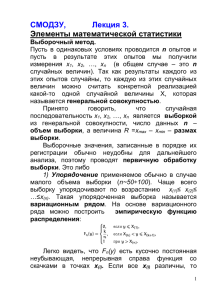

Пусть некоторые признаки описания некоторой СВ X. Рассмотрим выборку x1 , x2 , ..., xn объёма

n из генеральной совокупности. Элементы этой выборки представляют собой значения СВ X. На

первом этапе производится ранжирование выборки, т.е. x1 , x2 , ..., xn , упорядочены по возрастанию.

Определение: Вариантами xi называются различные элементы выборки.

Определение: Частотой варианты xi называется число mi , показывающая сколько раз

варианта xi встречается в выборке.

Определение: Относительной частотой варианты xi называется i

mi

.

n

Определение: Пусть x – некоторое число, тогда, количество вариант m x , значение которой < x

называется накопленной частотой

mx

m .

i: xi x

i

Определение: Относительной накопленной частотой называется x

mx

.

n

Определение: Вариационным рядом называется ряд вариант расположенных в порядке

возрастания с соответственными частотами и относительными частотами.

Вариационный ряды бывают дискретные и интервальные.

Определение: Дискретным вариационным рядом называется ряд, который представляет собой

выборку значений дискретной СВ.

Общий вид вариационного ряда:

Варианты: x1 X2 … xk

Частоты:

m 1 M2 … m k

Определение: Интервальным вариационным рядом называется ряд, который представляет собой

выборку значений СВ.

Построенный интервал вариационного ряда можно разбить на полуинтервалы вида ai ; ai 1 , т.е.

произвести из группировку. Количество интервалов k рекомендовано выбирать по формуле

Стерджеса: k 1 1.4 * ln( n) . Длина каждого интервала

xmax xmin

.

k

1

Подсчитывая количество значений попавших в каждый полуинтервал

значение mi :

Варианты:

a1 ;a2 a2 ; a3

…

ai ; ai 1

получаем

ak ; ak 1

Частоты:

m1

m2

…

mk

Для наглядности представления дискретного и вариационного ряда используются графические

представления:

1. Полигоны.

2. Гистограммы.

3. Камулянты.

Полигон служит для изображения дискретного вариационного ряда и представляет собой

ломаную соединяющую точку с координатой xi , mi , i 1..k . Для интервального ряда используется

полигон, который представляет собой ломаную соединяющую точки:

ci , mi , ci ai 1 ai , i 1..k .

2

Гистограмма служит для представления, только интервальных вариационных рядов и имеет вид

ступенчатых фигур с прямоугольным основанием, который имеет длину интервала , а высота i

или mi .

Кумулянта представляет собой ломаную соединяющую точки с координатами

m xi - накопленные частоты или для интервалов вариационного ряда: точки

x , m , где

i

xi

x , m , i 1,.., k .

i

ai

Определение: Эмпирические функции распределения Fn (x) называются функциями вида:

Fn ( x)

mx

x , mx - накопленные частоты.

n

Определение: Основной характеристикой вариационного ряда называется его среднее

1 n

1 n

арифметическое или выборочное среднее: x xi xi mi .

n i 1

n i 1

Для интервального ряда в качестве x i мы берём середину соответствия интервала.

Вариационный размах: R xmax xmin .

Выборочная дисперсия: S

2

k

( xi x ) 2

i 1

mi

1 k 2

, S 2 x 2 (x) 2 , x 2 xi mi .

n

n i 1

Выборочное среднее квадратичное отклонение: S

k

(x

i 1

i

x) 2

mi

.

n

Основные понятия теории оценок

Будем рассматривать следующую задачу:

Пусть имеется СВ для которой плотность распределения P( X | Q) известна с точностью до .

Например: - распределено по нормальному закону:

1

P( X | a, G 2 )

e

2

( x a ) 2

2 2

2

, ( a, ) .

Требуется оценить параметр . Для решения этой задачи с помощью независимых опытов

получим значения СВ . С помощью математических методов находят оценку неизвестного

параметра. Совокупность опытных данных: X x1 , x2 ,..., xn называется выборкой. xi - значение

величины в i-ом опыте где i 1,.., n и n - объём выборки.

2

Тогда оценка неизвестного параметра есть функция опытных данных:

T ( x1 ,..., xn ) T ( X ) .

Задача теории оценок указания вида функции T .

Определение: Если математическое ожидание оценок равно истинному значению параметра, то

оценок называется несмещённой, т.е. M ( | ) . (1) .

P( X | )

Величина

равна

плотности

распределения

n

i 1

вероятности

выборки

X.

P( X | ) p( xi | ) (условие несмещённости) T ( X ) P( X | )dX

n

i 1

... T ( x1 ,..., x n ) p ( xi | )dx1 ...dx n . Примем условное обозначение:

... .

Определение: Если соотношение (1) не выполняется, то оценка называется смещённой, а

величина b( ) M ( | ) называется смещением.

0

Определение: Если имеет место условие: b( ) n

,

то

называется асимптотически

смещённым. В качестве меры точности оценки берётся её вариация, т.е. среднее значение квадрата

2

разности между оценкой и неизменным значением параметра: V ( ) M ( ) или последнее

равенство переписывается в виде: V ( )

T ( X )

2

p ( X | )dX .

Рассмотрим свойства вариации:

1. V ( ) 0 .

2. Если оценка не смещённая, то вариация оценки равна её дисперсии: V ( ) D ( ) .

Неравенство Чепмена – Роббинса.

Пусть T ( X ) - несмещённая оценка параметра , следовательно используя определение

несмещённости можем записать: T ( X ) p ( X | )dX (1) . Положим: h и запишем

равенство (2):

T ( X )p( X | h)dX h .

Из условия нормировки плотностей можно записать:

p( X | )dX 1 и p( X | h)dX 1 .

Оба условия нормировки умножим справа и слева на и получим равенство:

* p( X | )dX (*) и * p( X | h)dX (**) .

Вычтем из (1) – (*): T ( X ) p ( X | )dX 0 (3) .

Вычтем из (2) – (**): T ( X ) p ( X | h)dX h (4) .

Из (4) вычтем (3): T ( X ) p ( X | h) p ( X | )dx h . Левую часть последнего

равенства домножим и разделим на одно и тоже выражение и разделим на одно и тоже выражение:

T ( X ) p( X | h) p( X | )

T

(

X

)

p

(

X

|

h

)

p

(

X

|

)

p

(

X

|

)

dx

M

h.

p( X | )

3

2

2

2

Справедливо неравенство Шварца: M (uv ) M u M v .

2

p ( X | h) P ( X | )

, где T ( X ) V ( ) .

h M (T ( X ) ) M

P( X | )

2

h

V ( )

2 .

P ( X | h) P ( X | )

M

P

(

X

|

)

Данная формула справедлива для любого h .

2

h

V ( ) sup

2

P( X | h) P( X | )

M

P

(

X

|

)

1

V ( ) sup

2

P ( X | h) P ( X | )

1

dX

p( X | )

P( X | )

2

2

называется неравенство Чепмена - Роббина.

Неравенство информации.

P ( X | h) P ( X | )

P( X | )

h

Т.к. имеет место:

, то неравенство Чепмена-Роббинса

0

n

можно переписать в виде:

2

1

P ( X | h) P ( X | )

1

V ( ) , где I

dX .

I

p( X | )

P( X | )

Последнее неравенство называется неравенство информации, а величина I называется количество

информации по Фишеру, т.е. количество информации выборки X о неизвестном параметре .

2

ln p( X | )

1

p( X | )

ln p( X | )

Т.к.

, то величину I

p( X | )dX

p( X | )

ln p( X ) 2 2 ln p( X | )

1

p( X | )

1

2 p( X | )

,

M

p( X | )

2

2

p( X | ) 2

2 ln( X | )

2 p( X | )

1

2 p( X | )

p( X | )

p( X | )dX

dX I .

dX

p( X | )

2

2

2

Т.к имеет место условие нормировки

p( X | )dX 1 , то

2 p( X | )

2 0 , получаем:

2 ln p( X | )

ln p( X | )

I

p( X | ) M

.

2

2

Т.к. значение СВ получено независимыми опытами, то:

n

n

ln p( xi | )

2 ln p( X | )

p( X | ) p( xi | )

2

2

i 1

i 1

2 ln p( xi | )

i( ) M

- количество информации полученной в i опыте.

2

1

Определение: e

- будем называть эффективностью оценки.

V ( ) * I

4

1 , такая оценка называется

Если e 1, то оценка называется эффективной, если e n

асимптотически эффективной.

Достаточные статистики.

Основная идея достаточных статистик заключается в следующем:

Пусть имеется выборка: X x1 ,..., xn . Объём экспериментальных данных n может быть очень

велик. Встаёт вопрос, нельзя ли эту экспериментальную информацию представить в более компактном

виде, т.е. найти числа t1 t1 ( X ),..., t k t k ( X ) , которых было меньше, чем исходных данных, но

которые добавляли бы столько же информации о , сколько и исходная выборка. Эти числа

называются достаточными статистиками.

Всё что может дать X о параметре , заключается в условной плотности вероятности p ( | X ) .

Аналогично, вся та информация, которую могут дать t t (t1 ,..., t k ) о заключается в условной

плотности вероятности p ( | t ) .

Согласно равенству информации о по выборке X и по достаточной статистике t можно

записать: p( | X ) p( | t ) .

p( X | ) p( )

p(t | ) p( )

Выразим p ( | X ) по формуле Байеса из p ( X | ) : p( | X )

, p( | t )

.

p( X )

p(t )

p( X | ) p(t | )

p(t | )

p( X | ) p( X )

g ( X )h(t , ) - критерий факторизации.

p( X )

p(t )

p(t )

Т. о. плотность вероятности выборки представляется в виде 2-х множителей, первый из которых

зависит только от выборки X , а второй зависит только от достаточных статистик t и параметра .

Пример: Пусть СВ имеет нормальное распределение:

Т.е.

p ( X | ) p ( X | a, 2 )

1

e

2

n

1

p ( X | a, 2 ) p ( xi | a, 2 )

e

2

i 1

n

n

( x a ) 2

2 2

( xi a )2

2

i 1 2

n

, X x1 ,..., xn ,

n

1

e

2

n

1

2

2

n

na2

xi 2 2 2 2

2a

i 1

i 1

n

, t 2 xi .

1

i

т. о. t1

x

i 1

2

i

достаточные статистики

Метод наименьших квадратов(МНК). Оценка параметров линейной модели.

Суть МНК заключается в следующем: y f ( X , ) , где X ( x1 ,..., xn ) . Заменяя значения

yi f ( xi , ) i , где i - ошибка измерений.

Предположим что i - независимые нормально распределённые случайные велечины.

Плотность

n

1

e

2

1 ,... n p(1 ,... n )

n

1

e

2

1

2 2

n

1

2

2

i2

i 1

p( x1 ,..., xn | )

n

yi f ( xi , ) 2

i 1

, при

M i 0, D i 2 .

p( x1 ,..., xn | ) max

5

Данная задача равносильна: R

n

f ( x , ) y

i 1

2

i

i

min .

Метод наименьших квадратов заключается в том, что оценка неизвестных параметров ищется из

условия минимизации суммы квадратов ошибок измерения.

Рассмотрим линейный случай метода наименьших квадратов:

Пусть есть (1 ,..., k ) - вектор неизвестных параметров.

k

yi xij j i , i 1,..., n . (1)

j 1

Ошибки i необязательно нормальные: M ( i ) 0 . Ошибки i - некоррелированы

M ( i j ) 2 ij , где

ij 10,,iijj .

y1

x11 ... x1k

Перепишем зависимость (1) в матричной форме: Y ... ; X ( n*k ) ... ... ... .

y

x

1

n1 ... xnk

1

1

... , ... , тогда имеем Y X , в связи с этим:

k

k

1. M 0 .

T

2

2. M ( ) E n , где En - единичная матрица n*n.

R (Y X)T (Y X) min .

Наценку параметра будем находить из условия:

1

R

0 2(Y X) 0 . X T Y X T X , X T X X T Y T (*).

M M ( X T X ) 1 X T Y ( X T X ) 1 X T MY ( X T X ) 1 X T M ( X ) ( X T X ) 1 X T ( XM M) M

Следовательно, полученная оценка является не смещённой. Найдём вариацию оценки :

V M ( )( ) T , т.к.

( X T X ) 1 X T Y ( X T X ) 1 ( X ) ( X T X ) 1 X T X ( X T X ) 1 X T ( X T X ) 1 X T

( X T X ) 1 X T . Подставляя последнее выражение в соотношение для вариации,

получим:

V M ( X T X ) 1 X T T X ( X T X ) 1 ( X T X ) X T M (T ) X ( X T X ) 1 2 ( X T X ) 1 X T X ( X T X ) 1

(X X ) .

2

T

1

Сформулируем следующую теорему:

Теорема (Оптимальное свойство МНК-оценки): МНК оценка имеют наименьшую дисперсию

в классе линейных несмещённых оценок.

МНК используется в задачах параметризации квадратов использованных в задачах оценки

параметров между 2-я и более переменными.

Пример:

Пусть зависимость между x и y имеет вид:

Y aX b , где Y ( y1 ,..., y n ) , X ( x1 ,..., xn ) , ( x1 ,..., xn ) - значение

Требуется оценить МНК параметры a, b :

n

n

n

R

R ( y i ax i b) 2 min ,

2 ( y i ax i b)( xi ) 0 ( y i ax i b) 0

a, b

a

i 1

i 1

i 1

6

n

n

n

i 1

i 1

y

a

y i a xi nb 0

i 1

i

nb 0

.

n

xi

i 1

n

1 n

b yi a xi

n i 1

i 1

R

0,

b

.

n

n

n

n 2

R

2

(

y

ax

b

)

(

x

)

0

a

x

b

x

xi y i

0

i

i

i

i

i

n

a

i 1

i 1

i 1

i 1

2

R ( y i axi b) min ;

,

n

n

n

a ,b

i 1

R 0 2 ( y ax b) 0

a x nb

yi

i

i

i

b

i 1

i 1

i 1

Решая последнюю систему относительно a и b получим:

a

n

n

n

i 1

i 1

i 1

n xi xi

i 1

i 1

n

n

2

Обозначим:

xy x y

x x

2

2

b

2

n

n

y x

i

i 1

i 1

2

i

n

n

xi xi y i

i 1

i 1

2

n xi xi

i 1

i 1

n

n

n

i 1

i 1

2

n

.

n

xi n x; yi n y; xi n x 2 ; xi yi n xy . Получим:

i 1

a

n

n xi y i xi y i

;b

yx xy

2

i 1

2

x x

2

2

.

Методы оценки неизвестных параметров. Метод моментов.

Пусть есть вектор неизвестных параметров: Q (Q1 ,..., Qr ) , - СВ с плотностью распределения

p ( X | ) , по выборке X {x1 ,...xn } . p ( X | ) p ( X | ) , тогда начальный момент k-го порядка СВ

может быть вычислен по формуле: mk M k

x

k

p ( X | )dX , k 1,..., r - количество

неизвестных параметров.

По выборке X можно вычислить оценку моментов k-го порядка по формуле:

1 n k

mk xi , k 1,..., r .

n i 1

Метод моментов заключается в том, что оценку неизвестных параметров находим из системы

уравнений полученной путём приравнивания теоретических моментов к выборочным.

m1 (1 ,..., r ) m

1

m ( ,..., r ) m2

Система имеет вид: 2 1

. Достоинство данного метода является простота

. . . . . . . . . . . .

m ( ,..., ) m

r

r

r 1

получения оценок, а недостатком – оценки моментов высших порядков дают очень большие ошибки,

7

поэтому нужно использовать моменты не выше 4-го порядка, т.е. число оценок порядка не должно

превышать 4.

Метод максимального правдоподобия.

Пусть X {x1 ,...xn } выборка. Производимые опыты являются независимыми:

n

p ( X | ) p ( xi | ) , где (1 ,..., n ) неизвестные параметры.

i 1

Определение: L( ) p ( X | ) называется функцией правдоподобия.

Метод максимального правдоподобия заключается в следующем:

В качестве оценки неизвестного параметра следует брать те значения аргумента, при котором

функция правдоподобия достигает своего максимума: L( ) max L( ) max p( X | ) .

Определение: Оценка получаемая по методу оценки максимального правдоподобия

называется оценкой максимального правдоподобия.

Замечание: В целях удобства вместо функции правдоподобия рассмотрим её логарифм:

l ( ) ln L( ) , т.к. функция и её логарифм достигают своего максимума при одном и том же .

Оценка параметров нормального распределения методом максимального

правдоподобия и свойства данных оценок.

Пусть есть СВ для которой плотность распределения задаётся формулой:

p ( X | (a, D))

1

2D

e

( xa )2

2D

, где a, D - неизвестные параметры, a - математическое

ожидание, D - дисперсия. Полученная выборка X {x1 ,...xn } является реализованная СВ .

Найдём оценки a и D неизвестных параметров:

Запишем функцию правдоподобия:

n

n

L(a, D) p( X | (a, D)) p( xi | (a, D))

i 1

n

n

1

l (a, D) ln L(a, D) ln(

) ln e

2

2D

i 1

i 1

( xi a ) 2

2D

1

2D

e

( xi a ) 2

2D

n

1 2 n

e

2

D

i 1

( xi a ) 2

2D

,

n

1

1 n

ln(

)

( xi a ) 2

2

2 D i 1

2D

2 n

l (a, D)

( xi a ) 2 0

0

n

n

1

2

2 D i 1

ln 2 ln D

( xi a ) , a

;

.

n

2

2

2 D i 1

2

l (a, D) 0 n 1

( xi a ) 0

D

2 D 2 D 2

i 1

n

Получим:

1 n

1 n

2 1 n

1 n

a xi , D ( xi a ) ( xi x j ) 2 .

n i 1

n i 1

n i 1

n j 1

Свойства оценок нормального распределения:

1)

M a

n

1

M xi

n i 1

, т.к. математическое ожидание случайной величины равно a :

1 n

1

a

n na a .

n i 1

8

1

V

D

2)

n2

an

a

n

D

i 1

xi

1

S

n

S

n2

n

, где

S Dxi .

Исследуем поведение оценки:

n

1 n

2

2 1 n

2 1 n

2

S xi a xi a a a xi a (a a) xi a

n i 1

n i 1

n i 1

n

i 1

n

1 n

1 n

1 n

2

2

2

a a xi a a a xi a (a a) 2

n i1

n i1

i1

n i1

,

n

1

S

S

2

M S M xi a M (a a) 2 D a S Da S S ,

n i1

n

n

1 n

2

M xi a - несмещённая оценка параметра D .

Упражнение: D

n 1 i 1

Основные статистические распределения.

1. - распределение (распределение Пирсана). Это распределение имеет следующий

2

вид:

2 12 ... n 2 , где i 2 - распределено по нормальному закону с параметрами

N (0,1), i 1,.., n . Иногда распределении обозначают: 2 (n) , n – число степеней свободы.

2.

t - распределение (Стьюдента). Пусть имеются СВ:

t

и . Тогда: ~ N (0,1) , ~ 2 (n) ,

, если t-распределение: M 0 и D n , n 2 .

t

t

n2

n

3. Распределение Спедекора-Фишера – это распределение имеет СВ вида: 1 : 2 ,

k1 k 2

1 ~ (k1 )

2 ~ (k 2 )

2

k2

, D 2k 2 (k1 k 2 2) .

k1 ( k 2 2)( k 2 4)

k2 2

2

2

, M

Интервальные оценки.

Если известен закон распределения оценки или её дисперсия, то можно указать приделы в

которых с большой вероятностью находятся неизвестные значения параметра.

Пусть имеется выборка X {x1 ,...xn } . Предположим, что выборочные значения распределены по

закону: P( xi x) F ( x, ) с точностью до .

Предположим, что мы нашли функцию: ( x1 ,..., xn ) и ( x1 ,..., xn ) , причём , x1 , x2 ,..., xn и

p ( x1 ,..., xn ) ( x1 ,..., xn ) 1 2 . Величина 2 называется доверительным уровням.

Обычно 2 берётся очень маленьким: 0.05, 0.01…

9

Вероятность того, что ( , ) покроет неизвестный параметр не зависит от . В этом случаи

интервал ( , ) - доверительный интервал для неизвестного параметра соответствующей

доверительной вероятности 1 2 .

Пример:

Пусть имеется выборка X {x1 ,...xn } . Предположим, выборка распределена по нормальному

закону: xi ~ N (a, 2 ) , где a - неизвестно, а - известно.

Найдём доверительный интервал для параметра a . Известно, что x

центральной предельной теореме) ~ N (a, 2 ) , тогда величина

xa

/ n

x1 ... xn

~ (по

n

~ N (0,1) распределена по

закону N (0,1) . Доверительный интервал будем строить используя следующее соотношение:

x

t2

1

x a

e 2 dt 1 2 (по

p

U 1 2 , где U -находится путём решения уравнения:

2

/ n

a x U

заданному уровню 2 ). Окончательно имеем: p x U

1 2 .

n

n

; x U

.

Доверительный интервал имеет вид: ( , ) x U

n

n

Основные понятия проверки статических гипотез.

Пусть имеется W-пространство неизвестных параметров входящих в плотность распределения

P ( X | ) . Пространство разбито на k областей H 0 , H 1 ,..., H k 1 . По результатам эксперимента надо

ответить на следующий вопрос:

Какой из областей принадлежит неизвестный параметр .

Определение: Предположение о том, что неизвестный параметр принадлежит, какой-либо

области H 0 , H 1 ,..., H k 1 называется альтернативой.

Определение: Совокупность k альтернатив называется k-альтернативной гипотезой.

Замечание: В литературе альтернативой так же называется гипотеза.

Определение: Если область соответствующая какой-либо альтернативе состоит из одной точки,

то это альтернатива называется простой, в противном случае сложной.

Определение: Если все альтернативы простые, то гипотеза называется простой.

Определение: Если хотя бы одна альтернатива является сложной, то гипотеза называется

сложной.

Обозначим решение, что имеет место i-я альтернатива, i 0,..., k 1 через d i . Тогда построим

правило, такое, что для любой X (выборки), ставим в соответствие одно из решений d 0 , d1 ,..., d k 1 .

Решающие правила делятся на:

1. Рандомизированные;

2. Нерандомизированные.

Рандомизированные:

k 1

X : 0 ( X ),..., k 1 ( X ) , где 0 0 ( X ) 1, i ( X ) 1 , d i i (X ) (решение выносится случайным

i 1

образом).

Нерандомизированные:

Выборка X разбивается на k областей и попадание точки в i-ю

область приводит к вынесению решения di .

10

Мы будем рассматривать рандомизированные решающие правила и 2-альтернативные гипотезы:

1 ( X ) ( X )

.

0 ( X ) 1 ( X )

Подход Неймана - Пирсона к выбору решающей функции (x ) .

Определение: Ошибкой I-го рода называется ошибка, когда выносится решение d1 (т.е в пользу

гипотезы H 1 ), а на самом деле верна гипотеза H 0 . Ошибка обозначается: p(d1 | H 0 ) ( ) .

Определение: Ошибкой II-го рода называется ошибка, когда выносится решение d 0 (т.е в пользу

гипотезы H 0 ), а на самом деле верна гипотеза H 1 . Ошибка обозначается: p(d 0 | H1 ) ( ) .

Определение: Вероятность вынесения правильного решения d1 в случаи, когда верна гипотеза

H 1 , называется мощностью критерия: ( ) p{d1 | H1} 1 ( ) . Желательно, что бы ошибка I-го

и II-го рода были равны 0, но это невозможно. При уменьшении вероятности I-го рода мы

увеличиваем вероятность ошибки II-го рода и наоборот.

Подход Неймона - Пирса к выбору решения функции (x ) заключается в следующем:

Функция (x ) выбирается следующим образом:

Вероятность ошибки , нужно делать такой, что бы она не превышала некоторого заданного

значения, т.е.

sup ( ) , а мощность критерия: ( ) max .

H 0

Определение: Величина

(X )

sup ( )

H 0

называется размерностью критерия,

a - уровнем

значимости.

В случаи 2-альтернативных простых гипотез рассмотрим следующую задачу:

H 0 : 0

H 1 : 1 , 1 0

;

p( X | 0 ) p0 ( X )

.

p( X | 1 ) p1 ( X )

Если функция (x ) - решающая функция, т.е. это вероятность вынесения решения в пользу

( ) ( X ) p 0 ( X )dX

решения H1 , то по формуле полной вероятности можно записать: ( ) (1 ( X )) p1 ( X )dX .

( ) ( X ) p1 ( X )dX

Задавая уровень значимости решающую функцию (x ) мы ищем решая задачу:

( X ) p1 ( X )dX max

( X ) p 0 ( X )dX

. Данную задачу решает Лемма Неймана – Пирсона.

0 ( X ) 1

11

Критерии

2 для проверки гипотезы о виде функции распределения.

Пусть дана выборка X {x1 ,...xn } . Проверяется следующая гипотеза:

H 0 : F ( x) F0 ( x)

, где

H 1 : F ( x) F0 ( x)

F0 ( x) - некоторая известная функция распределения. F0 ( x) может быть известна с точностью до

неизвестного параметра. Гипотеза проверяется при заданном уровне значимости .

Для построения критерия выше описанной гипотезы множество выборочных значений

разбивается на k непересекающихся классов.

Определим число выборочных значений попавших в k-ый класс: n1 , n2 ,..., nk .

n1 , n2 ,..., nk сравнивается с теоретическими частотами n1 ' , n2 ' ,..., nk ' . Теоретические частоты

находятся по функции распределения F0 ( x) следующим образом:

Пусть p i - вероятность попадания значения в i -ый класс, где i 1,..., k :

h

h

pi F0 (ai ) F0 (ai ) , где ai - середина i -го класса, а h - ширина класса, при i 1,..., k .

2

2

Теоретические частоты n'i npi , где i 1,..., k .

Если параметры теоретической функции распределения F0 ( x) известны, то величина

k

2

i 1

k

2

i 1

(ni ni ' ) 2

2

, при k стремится к (k 1) . Получаем:

ni '

( ni ni ' ) 2

2

(k (r 1)) , где r - это число параметров.

k

ni '

Если выполняется неравенство вида:

2 2 (k (r 1)) , то принимаем гипотезу H 0 , в

противном случае гипотеза H 0 отвергается.

Критерий согласия Колмогорова. Критерий Колмогорова – Смирнова.

Критерий согласия Колмогорова:

Пусть имеем:

X {x1 ,..., xn }

H 0 : F ( x) F0 ( x)

, H : F ( x) F ( x) , где

1

0

F0 ( x) - некоторая заданная функция

распределения.

Dn max Fn ( x) F0 ( x) , где Fn (x) - эмпирическая функция распределения по выборке X .

x

Распределение величины Dn определил Колмогоров: p Dn n 1 2 1 e 2 k

где k ( ) - функция Колмогорова.

k

2 2

k ( ) ,

k 0

Задавая уровень значимости из соотношения: p Dn n 1 можно найти критерий

значения распределения Колмогорова (по таблице).

Т. о. применяя критерии Колмогорова:

набл. Dn n и сравнивают его с табличным значением: набл. , при заданном , то говорят,

что табличные значения распределены по закону F0 ( x) .

Критерий согласия Колмогорова - Смирнова:

12

Со случайной величиной X проводят 2-е серии опытов. В результате получим 2 выборки: n1 и

n2 (объём).

Пусть F1 ( x) и F2 ( x) функция распределения СВ X в 1-ой и 2-ой серии соответственно.

Будем рассматривать следующие задачи:

H : F ( x) F2 ( x)

Требуется проверить теорию: 0 1

.

H 1 : F1 ( x) F2 ( x)

Пусть Fn1 ( x) и Fn 2 ( x) - выборочные эмпирические функции распределения в 1-ом и 2-ом

выборочном соответствии. Критерии Колмогорова – Смирнова заключается в следующем:

n1n2

D max Fn1 ( x) Fn 2 ( x) . Если D

, то H 0 принимается, в противном случаи

x

n1 n2

принимается гипотеза H1 .

Критическое значение при заданном значении определяется как и в случаи критерия

Колмогорова.

Проверка гипотезы о нормальном распределении выборочных значений по

критерию Пирсона.

Пусть задана выборка X {x1 ,...xn } , причём:

x1 x 2 x3 ... x k

n1 n2 n3 ... nk

k

,

n

i 1

i

n, xi , i 1,..., k - равноотстоящие.

1. Вычислим выборочное среднее и выборочное среднее квадратичное отклонения: x, :

1 k

1 k

x xi ni ,

ni ( xi x) 2 .

n i 1

n 1 i 1

2. Вычислим теоретические частоты: ni ': i 1,..., k , ni '

n

Ф(ni ) Ф(ni 1 ) , Ф(n) 2

функция Лапласа.

3. Сравниваем эмпирические частоты ni с теоретическими ni ' с помощью критерия 2 :

(ni ni ' ) 2

, 2 (k 3) . Если 2 2 (k 3) - говорим, что выборочные значения

ni '

i 1

нормально распределены.

k

2

Проверка гипотезы о распределении выборочных значений по закону Пуассона.

Пусть задана выборка X {x1 ,...xn } , причём:

1. x

x1 x 2 x3 ... x k

n1 n2 n3 ... nk

k

,

n

i 1

i

n, xi , i 1,..., k - равноотстоящие.

1 k

xi ni

n i 1

13

2. В качестве оценки параметра x .

e

i

3. Найти предполагаемый закон Пуассона: pi

i!

, где i 1,..., k .

4. ni ' pi ni , где i 1,..., k (теоретические частоты)

k

5. 2

i 1

(ni ni ' ) 2

, но 2 (k 2) .

ni '

Если 2 2 (k 2) , то выборочное значение распределено по закону Пирсона.

Задача регрессионного анализа.

Рассмотрим следующую задачу:

Есть k независимы переменных и зависящая от них переменная y . Сами переменные могут

быть случайными и при желании можем задать их значения. На величину y также влияют другие

неподдающиеся точному фактору, а это значит, что величина y носит случайный характер.

Нас будет интересовать методы экспериментального определения влияния переменных x1 ,..., x k

на y , а именно: определить по данным эксперимента вид зависимости: y( X ) f ( x1 ,..., xk ) .

Задача регрессионного анализа состоит от экспериментально определённых коэффициентов

k

регрессии вида: y ( X ) i xi путём наблюдения за характером изменений входных переменных

i 0

x1 ,..., x k и выходного y , служат методы активного и пассивного эксперимента.

Пассивный эксперимент основан на регистрации контроля параметра в процессе нормальной

работы объекта без внесений преднамеренных возмущений.

Активный эксперимент основан на использовании искомого возмущения вводимых в объект по

заранее спланированной программе. При активном эксперименте ведение искомых возмущений

позволяет быстро и целенаправленно вскрывать нужные зависимости между параметрами, но

введение искомых возмущений может привести к нарушению нормального хода технологий.

При организованном числе экспериментов невозможно точно найти значение i 0,..., k .

k

Поэтому находят оценки этих коэффициентов i bi , i 0,..., k , y ( x) b i xi определяют оценку

i 0

математического ожидания истинной функции y ( X ) .

Определение оценок коэффициентов регрессии по данным пассивного

эксперимента.

Для определения оценок коэффициентов bi , i 0,..., k проводят серию экспериментов, в каждом

из которых измеряют величины на входах и выходах исследованного объекта.

Рассмотрим l -ый эксперимент, l 0,..., n . Пусть x il и yl , где i 0,..., k , l 0,..., n - значения

k

величин xi и y в этом эксперименте. Оценка y l b i xil будет отличаться от измеренного

i 0

k

значения yl . Величины l y l y l y l b i xil , l 0,..., n . Для определения коэффициентов bi

i 0

14

будет использован метод наименьших квадратов. В этом случаи оценки bi будут находится из

условия: bi : Q

n

l 1

l2

1

b1

y1

2

b2

y

min . Перейдём к матричной форме: , , 2 ,

...

...

...

b

y

n

n

n

x01 ... x k1

x02 ... x k 2

. Тогда наша зависимость запишется в виде: . Для использования метода

... ... ...

x ... x

kn

0n

наименьшего квадрата будем рассматривать следующую величину:

Q T ( )T ( ) T T T T T T 2T T T .

Q

T

1

T

0 2 T 2 T 0 , ( ) . Т.к.

определение оценок коэффициентов p i проводится по искажённым помехам экспериментальных

данных, то для получения точных оценок нужно, что бы число экспериментов было n k 1 , где

Минимум находим из условия:

k 1 -число неизвестных параметров, т.к. bi , i 0,..., k .

Определение: Разность между числом наблюдений n и числом неизвестных параметров k 1

называется число степеней свободы эксперимента: n' n (k 1) .

О правильности построений по экспериментальным данным регрессионной модели с уровнем

надёжности можно судить на основании F - критерия Фишера. Для этого определим отношение:

2

k

Sk

2

F 2 , где S k ( y l y l ) 2 - дисперсия, характеризующая рассеяние эксперимента точек

Sy

l 1

относительно уровня регрессии, S y

2

1 k

( yl y) 2 - дисперсия, характеризующая ошибку

n 1 l 1

1 n

yi - выборочная средняя всех результатов эксперимента. Когда значение F

n i 1

найдено, его сравнивают с табличными значениями Fкр (n' , k 1) . Если F Fкр (n' , k 1) , то

построенная модель считается адекватной.

эксперимента, y

Основные понятия дисперсионного анализа. Однофакторный дисперсионный

анализ.

В практике деятельности часто возникает необходимость выявления и оценки влияния отдельных

факторов на изменчивость какого-либо признака значения, которого могут быть получены опытным

путём виде реализации некоторой случайной величины . Под факторами будет пониматься

независимые различные показатели. Дисперсионный анализ позволяет установить степень влияния

факторов на изменчивость признаков. Количество факторов может быть различно. По количеству

факторов различают однофакторный и двухфакторный анализ. Идея дисперсионного анализа

заключается в том, что дисперсия изучаемого признака раскладывается на сумму составляющих её

дисперсий.

2

2

2

2

Например: 2 A B AB Z , где

A 2 - дисперсия, вызванная влиянием фактора

A

,

B - дисперсия, вызванная влиянием фактора

B

,

2

15

AB 2 - дисперсия, вызванная влиянием фактора

AB ,

Z - дисперсия, вызванная некоторым неучтённым фактором

2 - дисперсия изучаемого признака.

Мы будем рассматривать однофакторный дисперсионный анализ.

2

Z

,

Однофакторный дисперсионный анализ

Будем считать, что некоторый фактор A изучается следующим образом:

На каждом из m уровней проводится по k измерений . Данные эксперимента представлены в

виде следующих таблиц:

Уровни факторов

№

набл. A1 A2 …

Aj

… Am

1

x11

x12

…

x1j

…

x1m

2

…

k

x12

…

xk2

x22

…

xk2

…

…

…

x2j

…

xkj

…

…

…

x2m

…

xkm

x1

x2

…

xk

…

xk m

m

j

уровней по k измерений .

Факторы A j , j 1,..., m .

Будем рассматривать гипотезу:

H0

: фактор A не влияет на .

H 1 : фактор A влияет на .

1 k

x j xij , j 1,.., m - групповые средние.

k i1

1 k m

x

xij - общая выборочная средняя принимаемая

k m i1 j 1

m

QA k x j x

.

2

- фактическая сумма квадратов отклонений групповых средних от общих

j 1

средних.

Эта величина характеризует рассеивание между группами:

k

m

Q0 xij x j

2

- остаточная сумма квадратов отклонений, значения уровня фактов, от

i 1 j 1

групповой средней.

Эта величина характеризует рассеивание внутри группы:

k

m

Q xij x QA Q0 - общая сумма квадратов отклонений выборочных значений от

2

i 1 j 1

общего среднего.

На основании выше перечисленных формул рассчитаем следующие величины:

16

Q0

Q

Q

2

2

, S A A , S0

.

km

m 1

m(k 1)

S2

2

2

Для выяснения влияния фактора A на признак сравниваются S0 и S A . Влияние фактора A

на признак считается заданным при заданном уровне , если выполняется условие:

S A2

S0 2

Fкр ( 1 , 2 )

, где 1

m 1 , 2 m( k 1) .

Если данное неравенство не выполняется, то

влияние считается незначительным.

Пример:

В таблице приведены данные по объёмам работы выполненной на стройке за смену для 4 бригад.

Проверить влияет ли состав бригады на объём выполненной работы.

1

2

3

1

140

144

142

№ бригады:

2

3

150

148

149

149

152

146

4

150

155

154

4

145

152

152

№

147

142,75 150,25 147,5 152,75

xj

H0

: не влияет;

H0

: влияет.

Решение:

x

140 144 145 ... 150 ... 150 155 154 152 148,31

16

Q A 4 142,75 148,31 (150,25 148,31) 2 (147,5 148,31) 2 (152,75 148,31) 2 220,19

2

Q0 140 142,75 (144 142,75) 2 ... (150 150,25) 2 ... (152 152,45) 2 39,27

2

2 220,19

SA

2

SA

220,19 *12

4 1

2

22,43 , F0.05, кр (3,12) 3,49, 0.05 , 22,4 3.49 .

3 * 39,27

S0

S 0 2 39,27

4(4 1)

Оценим степень этой зависимости с помощью коэффициента детерминирования:

Q

220,19

D A , Q Q A Q0 39,27 220,19 259,46 , D

0,849 , 84,9 % общего изменения

Q

259,46

ежедневного объёма выработки связанного с работой смены.

17