Представление информации

реклама

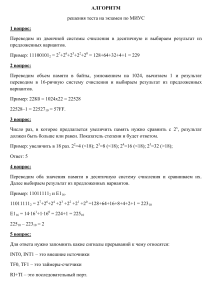

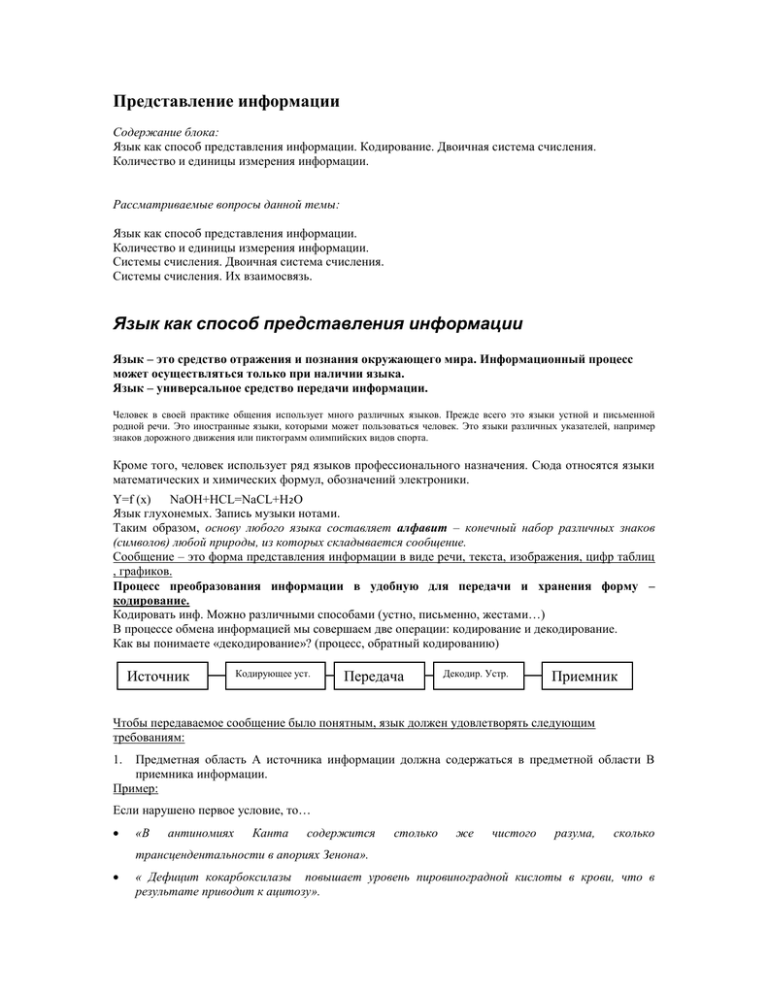

Представление информации Содержание блока: Язык как способ представления информации. Кодирование. Двоичная система счисления. Количество и единицы измерения информации. Рассматриваемые вопросы данной темы: Язык как способ представления информации. Количество и единицы измерения информации. Системы счисления. Двоичная система счисления. Системы счисления. Их взаимосвязь. Язык как способ представления информации Язык – это средство отражения и познания окружающего мира. Информационный процесс может осуществляться только при наличии языка. Язык – универсальное средство передачи информации. Человек в своей практике общения использует много различных языков. Прежде всего это языки устной и письменной родной речи. Это иностранные языки, которыми может пользоваться человек. Это языки различных указателей, например знаков дорожного движения или пиктограмм олимпийских видов спорта. Кроме того, человек использует ряд языков профессионального назначения. Сюда относятся языки математических и химических формул, обозначений электроники. Y=f (x) NaOH+HCL=NaCL+H₂O Язык глухонемых. Запись музыки нотами. Таким образом, основу любого языка составляет алфавит – конечный набор различных знаков (символов) любой природы, из которых складывается сообщение. Сообщение – это форма представления информации в виде речи, текста, изображения, цифр таблиц , графиков. Процесс преобразования информации в удобную для передачи и хранения форму – кодирование. Кодировать инф. Можно различными способами (устно, письменно, жестами…) В процессе обмена информацией мы совершаем две операции: кодирование и декодирование. Как вы понимаете «декодирование»? (процесс, обратный кодированию) Источник Кодирующее уст. Передача Декодир. Устр. Приемник Чтобы передаваемое сообщение было понятным, язык должен удовлетворять следующим требованиям: Предметная область А источника информации должна содержаться в предметной области В приемника информации. Пример: 1. Если нарушено первое условие, то… «В антиномиях Канта содержится столько же чистого разума, сколько трансцендентальности в апориях Зенона». « Дефицит кокарбоксилазы повышает уровень пировиноградной кислоты в крови, что в результате приводит к ацитозу». Мы не можем понять смысл этих высказываний, т.к. не владеем предметной областью. 2. 3. Кодирование и декодирование должны быть взаимно обратными операциями. Информация, имеющаяся у источника и приемника, должна совпадать и не может изменяться во время передачи информации. Язык, в котором каждое слово имеет только один смысл, называют формализованным. Формальными языками являются все языки общения с компьютером. Несмотря на особенности каждого вида информации, общим для них является использование при кодировании двоичной системы счисления, основанной на двух цифрах – 0 и 1. Эти два символа принято называть двоичными цифрами или битами (bit – Binary Digit). С помощью двух цифр можно закодировать любое сообщение. Достоинство двоичного кодирования – простота реализации. Недостаток – длинные коды. Но в технике легче иметь дело с большим числом простых однотипных элементов, чем с большим числом сложных. БИТ – единица измерения информации. Количество и единицы измерения информации. Сколько информации человеку надо? Скажите, пожалуйста, где информации на уроке дают больше: в первом классе или в пятом? Если вы считаете, что в пятом, то почему бы первоклассникам не пойти в пятый класс? Там они получат больше информации и быстрее закончат школу. В пятом классе действительно дадут больше информации, но примет ее ученик не больше, а меньше. Человек защищается от ненужной, непонятной и неприятной информации. Она проходит мимо него. Он не может ее обработать, а значит, не может превратить в знания. Для информации, которая не может быть понятна и усвоена, ученые придумали очень точное слово – шум. (урок математики в пятом классе для первоклассника может стать информационным шумом и будет пропущен мимо ушей.) Человеку трудно потреблять информацию. Он может сделать это только маленькими порциями. Любая перегрузка превращает информацию в шум, и она становится бесполезной. То есть не превращается в знания. Человеку трудно обрабатывать информацию. Он от этого устает. Человек может ошибаться. Из-за информационного шума он может неправильно обработать информацию и превратить ее в ложное знание. (пример: окуните конфету в горчицу и попробуйте что получилось. Шум от горчицы не даст никаких вкусных сигналов от сладкой конфеты) Человек необъективен (значит, воспринимает информацию не такой, как она есть, а такой, какой она ему кажется.) Если информация ему неприятна, он усваивает ее с большим трудом и многое оставляет без внимания. Информация быстро забывается, если не закреплять знания постоянными упражнениями. Единица измерения информации – БИТ (bit – Binary Digit двоичная цифра). Основа – две цифры 0 и 1. Сообщение, уменьшающее неопределенность знаний человека в два раза, несет для него 1 бит информации. Что такое «НЕОПРЕДЕЛЕННОСТЬ ЗНАНИЙ»? Привести пример с бросанием монеты. Ни один из вариантов (орел или решка) не имеет преимущества перед другим. В таком случае говорят, что они РАВНОВЕРОЯТНЫ. Т. е. Неопределенность знаний в этом примере = 2. Узнав результат бросания монеты, вы получили 1 бит информации. Можно сказать, что неопределенность знаний о некотором событии – это количество возможных результатов события. Существует ситуации, когда события имеют различные вероятности реализации. Например, когда одна сторона монеты тяжелее другой. В этом случае вероятность выпадения орла и решки будут различаться. Те. События неравновероятны. В этом случае кол-во вероятности определяется формулой Шеннона ( 1948 год) I = - ∑ p¡ log₂ p¡ Где p¡ - вероятности отдельных событий N – кол-во возможных событий I – кол-во информации Если события равновероятны, то p¡ = 1/N Подставляя в формулу, мы получаем I = log₂N Примеры не равновероятных событий: Вася – лучший ученик в классе. Как вы думаете, какая вероятность больше - получения «5» или «2» за контрольную? В озере 500 карасей 200 окуней и 1000 пескарей. Самая большая вероятность быть пойманной, у какой рыбы? ?Приведите свои примеры не равновероятных событий. Пусть в некотором сообщении содержится сведения о том, что произошло одно из N равновероятных событий (т.е. ни одно событие не имеет преимуществ перед другими). Тогда количество информации, заключенное в этом сообщении, - X бит и число N связаны формулой: 2^x=N Данная формула является показательным уравнением относительно неизвестной х. Из математики известно, что решение такого уравнения имеет вид: Логарифм от N по основанию 2. X = log₂N Задачи ? Сколько двоичных цифр (бит) необходимо, чтобы закодировать одну школьную оценку? (речь идет о мин. Числе бит, необходимых для кодирования оценки. Рассмотрим 4 оценки 2,3,4,5. Для их кодировки достаточно 2 бит) ? “Вы выходите на следующей остановке?” – спросили человека в автобусе. “Нет”, - ответил он. Сколько информации содержит ответ? ? Группа школьников пришла в бассейн , в котором 4 дорожки для плавания. Тренер сообщил, что группа будет плавать на дорожке номер 3. Сколько информации получили школьники из этого сообщения? ? В корзине лежат 8 шаров. Все шары разного цвета. Сколько информации несет сообщение о том, что из корзины достали красный шар? ? Сообщение о том, что Петя живет во втором подъезде, несет 3 бита информации. Сколько подъездов в доме? 1Байт = 8 Бит 1Кб=2¹ºб=1024 б 1Мб=2¹ºКб=1024 Кб 1Гб=2¹ºМб =1024 Мб Компьютер оперирует с числами не в десятичной, а в двоичной системе счисления, поэтому для измерения количества информации используется коэффициент 2ⁿ Из истории. Не всегда байты состояли из 8 битов. Еще в 60-е годы, когда не было ПК и все вычисления проводились на больших ЭВМ, байты могли быть какими угодно. Наиболее широко были распространены ЭВМ, у которых байт состоял из 6 битов, но выли и такие, у которых байт состоял из 4 и даже из 7 битов. Восьмибитный байт появился в начале 70-х.