ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2

advertisement

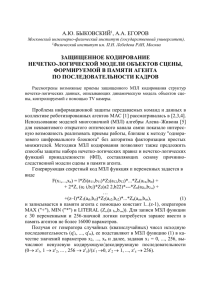

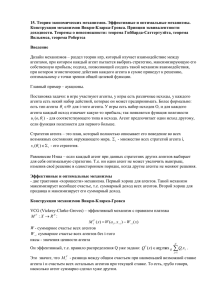

ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 А.Г. КОВАЛЬ Национальный исследовательский ядерный университет «МИФИ», Москва anton-riot@ya.ru МОДЕЛЬ ПОВЕДЕНИЯ ВЗАИМОДЕЙСТВУЮЩИХ АГЕНТОВ Моделируется поведение автономных взаимодействующих агентов в двумерной клеточной среде. В среде имеется пища агентов и хищники. Агенты взаимодействуют друг с другом посредством передачи дискретных сигналов. Рассматривается эффективность выработки агентами стратегий избегания столкновений с хищниками и влияние характеристик системы управления агента на степень и динамику обучаемости. Проводится анализ значимости сигнального взаимодействия в обучении. Ключевые слова: взаимодействующие агенты, компьютерное моделирование, обучение с подкреплением Введение Данная работа относится к проблематике построения и анализа моделей поведения автономных агентов, в рамках которой в настоящее время ведутся активные исследования (см. например, [1, 2]). Изучение многоагентных систем оправдано для многих дисциплин: результаты работ имеют прикладное значение в робототехнике, социально-экономической сфере, при разработке вычислительных систем, а также представляют научный интерес в вопросах, связанных с когнитивной наукой, эволюцией и познанием себя в целом. Взаимодействие между автономными агентами моделировалось в таких работах, как, например, [3], где рассматривается эволюция кооперативного поведения и показывается, что коэволюция агентов может приводить к более удовлетворительным результатам, нежели эволюция некого управляющего ими центра. В [4] на наглядных опытах изучалось поведение агентов в «социуме», когда они имели функционал для отправки и Работа выполнена при частичной поддержке Федеральной целевой программой «Научные и научно-педагогические кадры инновационной России» на 2009– 2013 годы, госконтракт № П812. УДК 004.032.26(06) Нейронные сети 104 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 принятия сигналов. Подчеркивалось, что система сигналов может использоваться роботами неочевидным экспериментатору способом, т.е. эволюционный алгоритм развития сигнализирования может эффективно применяться в прикладных задачах. В [5] было показано, что в эволюционирующей популяции роботов, управляемых рекуррентными нейронными сетями, может формироваться простая сигнальная система, позволяющая решать нетривиальную задачу распределения роботов по кормушкам. В отличие от [5] в настоящей работе решается задача оптимизации поведения агентов с целью избегания столкновения с хищниками. Система управления агентов основана на логических правилах вида «Если имеет место определенная ситуация Sk, то необходимо выполнить определенное действие Ak», где k – номер правила. Каждое правило имеет свой вес Wk . Веса правил модифицируются путем обучения. Отдельный агент имеет ресурс, который пополняется при питании агента и расходуется при выполнении им действий. Обучение осуществляется методом обучения с подкреплением [6], т.е. путем самообучения агента на основе изменения его ресурса. Перед агентами ставится задача избегать встреч с хищниками (естественная потребность в безопасности) и исследуется, насколько эффективно для этого агенты используют возможность передачи друг другу сигналов. Проведенное исследование показывает, что даже простейшая возможность передачи бинарных сигналов позволяет агентам кооперироваться и эффективно взаимодействовать, избегая встречи с хищниками. Описание общей модели Среда обитания агентов представляет собой двумерную клеточную поверхность размером Nx x Ny клеток. Поверхность замкнута в виде тора. Время t дискретно, t = 0, 1, 2, ... В среде находятся агенты, хищники, пища агентов. Каждый агент имеет свой ресурс R(t). Ресурс агента увеличивается при поглощении им пищи и уменьшается при выполнении агентом действий и при нападении хищника на агента. Число агентов и число хищников в среде фиксировано. Количество порций пищи в мире ограничено и постоянно, число клеток с порциями пищи равно Nf . Когда агент съедает порцию пищи, то его ресурс увеличивается на величину ΔRe . После поедания агентом порции пищи новая порция пищи появляется в случайно выбираемой клетке окружающей среды (из тех клеток, в которых пищи не было). УДК 004.032.26(06) Нейронные сети 105 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 Хищники случайно распределены по модельному миру. Они не обучаются, не погибают, не нападают друг на друга, выполняют только два действия: либо случайно перемещаются на одну из четырёх соседних клеток, либо остаются на месте. Если в клетке с хищником оказывается агент, то хищник на него нападает. То есть, поведение хищника выглядит следующим образом: он беспорядочно перемещается по модельному миру, пока не наткнётся на агента, на которого сразу же нападает. При нападении хищника на агента ресурс агента R(t) уменьшается на величину ΔRpr. В одной клетке одновременно может находиться неограниченное количество хищников. Хищник обладает определенной скоростью перемещения v. Каждый такт времени хищник перемещается в случайном направлении (вверх, вниз, влево или вправо) на v клеток. Скорость перемещения v может быть равна 0, тогда хищник неподвижен на протяжении всего процесса моделирования. В пределах одного такта времени хищник сначала атакует, потом перемещается. Агент находится в определенной клетке мира, в одной клетке одновременно могут находиться неограниченное количество агентов. Система управления агента представляет собой совокупность правил вида: Sk Ak , (1) где Sk и Ak – ситуация и действие, соответствующие правилу, k – номер правила. Предполагаем, что имеются фиксированные и настраиваемые правила. В данной модели имеется одно фиксированное правило, соответствующее питанию агента. Когда в той клетке, в которой находится агент, есть порция пищи, агент поглощает эту порцию. Каждое настраиваемое правило имеет свой вес Wk , веса правил модифицируются при обучении агента. Sk есть вектор, компоненты которого являются рецепторами агента и принимают значения 0 либо 1. Агент может выполнять некоторые действия, каждое действие обусловлено своим эффектором. При выполнении каждого из действий ресурс агента уменьшается на величину ΔRm . Каждый такт времени агент выбирает определенное действие и обучается. Вероятность выбора определенного действия в рассматриваемой ситуации пропорциональна весу правила, соответствующего текущей ситуации и данному действию. Обучение проводится методом обучения с подкреплением. Величина подкрепления для данного агента в такт времени t равна r(t) = R(t–1) – R(t–2) . (2) При обучении в момент времени t вес правила W(t–1), примененного агентом в момент времени t–1, меняется следующим образом [6]: УДК 004.032.26(06) Нейронные сети 106 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 ΔW(t–1) = α [r(t) + γW(t) – W(t–1)] , (3) где α – параметр скорости обучения, γ – дисконтный фактор, W(t) – вес правила, примененного в момент времени t. Изначально веса всех правил одинаковы. Во всех экспериментах задавались следующие общие параметры: - число клеток среды обитания агентов по осям x и y , Nx = Ny = 10; - число агентов равно 30, число хищников равно 4, число клеток с порциями пищи, Nf = 30; - увеличение ресурса агента при поглощении им порции пищи ΔRe = 150; - величина ресурса, отнимаемая хищником у агента, ΔRpr = 500; - уменьшение ресурса агента при выполнении им действия (перемещения в соседнюю клетку) ΔRe = 20; - дисконтный фактор, γ = 0,9; - параметр скорости обучения, α = 0,5. Модель № 1 Программное обеспечение для этого и последующих моделирований разрабатывалось на языке ActionScript3 (один из диалектов ECMAScript). Была проведена серия экспериментов для агентов со следующими параметрами: Рецепторы: - присутствует ли в клетке с агентом хищник? (0 если нет, 1 если есть), -был ли получен сигнал опасности слева/сверху/справа/снизу (0 если нет, 1 если да). Т.е. вектор Sk ситуации состоит из 5 компонентов. Эффекторы: - перемещение на 1 клетку влево/вверх/вправо/вниз Итак, система управления содержит 25*4=128 настраиваемых правил, веса которых модифицируются в процессе обучения. Агент автоматически посылает сигнал опасности на соседние 4 клетки, когда его атакует хищник. При хаотичном движении агента посещение им всех клеток мира равновероятно, и частота столкновений составляет: w0 = 1000*Nхищников /Nклеток = 40 (столкновений за 1000 тактов). (4) Сначала моделирование проводилось для случая, когда скорость хищников v = 0 (хищники неподвижны). Четыре хищника располагались в квадрате 2х2. Если агенты не обучались, то в эксперименте частота столкновений с хищниками (частота актов нападения) была такой же, как и при УДК 004.032.26(06) Нейронные сети 107 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 хаотичном движении агента (40). Если агенты обучались, но не передавали друг другу сигналы об опасности (не обрабатывались рецепторы сигналов), то частота столкновений после 30000 тактов устанавливалась равной 38,9 (данные усреднены по 50 расчетам, погрешность определения частоты столкновений не более 0.1). Для обучающихся агентов, передающих друг другу сигналы об опасности, частота столкновений уменьшалась достаточно значительно. Результат моделирования в этом случае представлен на рис. 1. Частота столкновений после 30 000 тактов устанавливается на значении 31.6 (данные усреднены по 50 расчетам, погрешность определения частоты столкновений не более 0.1). Затем аналогичный эксперимент был проведён для случая подвижных хищников, со скоростями v = 1 (каждый такт времени хищник перемещается на случайную соседнюю с ним клетку) и v = 2 (каждый такт времени хищник «перепрыгивает» через любую соседнюю клетку). При v = 1 для обучающихся агентов, передающих друг другу сигналы об опасности, установившаяся частота столкновений составляла 39.2, а при v = 2 частота не уменьшалась. Итак, в этом эксперименте агенты смогли эффективно приспособиться к избеганию хищников только с помощью сигналов и только для случая неподвижных хищников. Рис. 1. Зависимость частоты столкновений от времени для модели № 1 Модель № 2 УДК 004.032.26(06) Нейронные сети 108 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 На следующем этапе моделирования агентам давалась возможность передавать сигнал не только в соседние клетки, но и через клетку по всем 4м направлением. Были проведены эксперименты, в которых: а) агент посылает сигнал опасности через 1 клетку по всем 4 направлениям; б) агент посылает сигнал опасности через 2 клетки по всем 4 направлениям; в) агент посылает сигнал как в соседние, так и через 1 и 2 клетки по всем 4 направлениям. Клетки, на которые посылался сигнал опасности, графически представлены на рис. 2. Это дополнение привело к повышению эффективности избегания агентами встреч с хищниками, результаты приведены в таблице 1 (данные усреднены по 50 расчетам, погрешность определения частоты столкновений не более 0,2). УДК 004.032.26(06) Нейронные сети 109 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 Таблица 1 Результаты второго этапа моделирования Скорость хищника v, клеток/ход Сигнал пере- Сигнал пере- Сигнал пере- Сигнал передаётся на даётся через даётся через даётся на соседние 1 клетку (а) 2 клетки (б) соседние, клетки через 1 и через 2 клетки (в) 0 31,6 28,0 32,8 26,8 1 39,2 37,6 39,8 37,6 2 39,8 38,8 39,9 38,9 Обучение во всех экспериментах занимало не более 30 000 тактов. Как видно, передача сигнала на соседние, через 1 и через 2 клетки (случай в) позволила понизить частоту нежелательных столкновений на 33 %. Рис. 2. Клетки, на которые посылается сигнал тревоги в разных экспериментах (отмечены серым цветом). Символом «х» отмечена клетка с агентом Модель № 3 Возможность передачи сигналов опасности ожидаемо понизила частоту столкновений агентов с хищниками. В следующем опыте агентам добавлялись возможность посылать нейтральный сигнал и соответствующие 4 дополнительных рецептора для возможности получения этого сигнала и определения его направления. Нейтральный сигнал агент посылает каждый такт времени независимо от того, атакует его хищник или УДК 004.032.26(06) Нейронные сети 110 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 нет. Этот сигнал распространяется на 4 соседние клетки. Распространение сигнала опасности соответствует модели №2, случаю в (см. рис. 2). Результат моделирования отличался от предыдущих не только повышением эффективности избегания встреч с хищником (установившаяся частота k = 22,8, произошло уменьшение на 43 % вместо 33 % в предыдущем опыте), но и динамикой обучения: частота столкновений плавно уменьшалась в течение 600 000 тактов (см. рис. 3). Данные усреднены по 50 расчетам, погрешность определения частоты столкновений не более 0,2. Рис. 3. Зависимость частоты столкновений от времени для модели № 3 Модель № 4 В четвёртой, последней из этой серии экспериментов модели, агенты могли решать: отправлять нейтральный сигнал или нет. По сравнению с предыдущей моделью, добавился эффектор (действие) «отправить нейтральный сигнал». Отмечу, что мы не говорим о каком-то конкретном смысловом сигнале – что этот сигнал означает, агенты сами установили в процессе обучения. И сделали это довольно успешно, потому что эффективность избегания встреч с хищниками в этом эксперименте превысила показатели всех ранее проведённых опытов. Приведём полную систему управления агента: Рецепторы: - присутствует ли в клетке с агентом хищник (0 если нет, 1 если есть); - был ли получен сигнал опасности слева/сверху/справа/снизу; - был ли получен нейтральный сигнал слева/сверху/справа/снизу. Т.е. вектор Sk ситуации состоит из 9 компонент. Эффекторы: - перемещение на 1 клетку влево/вверх/вправо/вниз; - передача на 4 соседние клетки нейтрального сигнала. УДК 004.032.26(06) Нейронные сети 111 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 Всего получаем 29*5 = 2560 правил. График зависимости частоты столкновений от времени представлен на рис. 4. В итоге, частота столкновений устанавливалась после 500–600 тыс. тактов на значении 18,0, что означает увеличение эффективности избегания столкновений на 55 % по отношению к ситуации с хаотичным движением агентов. Данные усреднены по 50 расчетам, погрешность определения частоты столкновений не более 0,2. Рис. 4. Зависимость частоты столкновений от времени для модели № 4 Выводы Построены и исследованы различные системы управления в рамках модели взаимодействующих посредством передачи сигналов агентов. Проведён анализ динамики обучения агентов, который выявил быстрое обучение (см. рис. 1, обучение происходит в среднем в течение 30000 тактов) и медленное (см. рис. 2, обучение происходит на протяжении 500000 тактов – на порядок больше быстрого обучения). Причём, как понятно из соответствующих систем управления, быстрое обучение происходит за счёт использования агентами рецепторов сигнала опасности, а медленное – за счёт использования агентами нейтрального сигнала. Исследование генома обучившегося агента в модели №4 показало, что возможность принимать и отправлять нейтральный сигнал дала агентам склонность к кооперации. Другими словами, можно сказать, что агенты в популяции проявили адаптивность поведения, в условиях агрессивной среды (среды, содержащей хищников), самообучение привело к эффективному использованию сигналов опасности (прямое избегание хищников) и нейтральных сигналов (кооперация агентов). Частота столкновений с хищниками за 1000 тактов времени уменьшилась на 55 % – с 40,0 до 18,0. Автор благодарен В.Г. Редько за полезные консультации. УДК 004.032.26(06) Нейронные сети 112 ISBN 978-5-7262-1376-7. НЕЙРОИНФОРМАТИКА – 2011. Часть 2 Список литературы 1. http://laral.istc.cnr.it 2. http://nn.cs.utexas.edu 3. Yong C.H., Miikkulainen R. Coevolution of Role-Based Cooperation in Multi-Agent Systems. Department of Computer Sciences. The University of Texas at Austin. Austin, TX 78712 USA. Technical Report AI07-338, 2007. 4. Ampatzis C., Tuci E., Trianni V., and Dorigo M. Evolution of Signaling in a Multi-Robot System: Categorization and Communication. IRIDIA – Technical Report Series. Technical Report No. TR/IRIDIA/2006-028, December 2006. 5. Marocco D., Nolfi S. Origins of communication in evolving robots // In: Nolfi S., Baldassarre G., Calabretta R., Hallam J., Marocco D., Miglino O., Meyer J-A, Parisi D. (Eds.). From Animals to Animats 9: Proceedings of the Ninth International Conference on Simulation of Adaptive Behavior. LNAI. Volume 4095. Berlin, Germany: Springer Verlag, 2006. P. 789–803. 6. Sutton R.S., Barto A.G. Reinforcement Learning: An Introduction. MIT Press, 1998. УДК 004.032.26(06) Нейронные сети 113