Общий принцип построения деревьев решений был дан в статье

advertisement

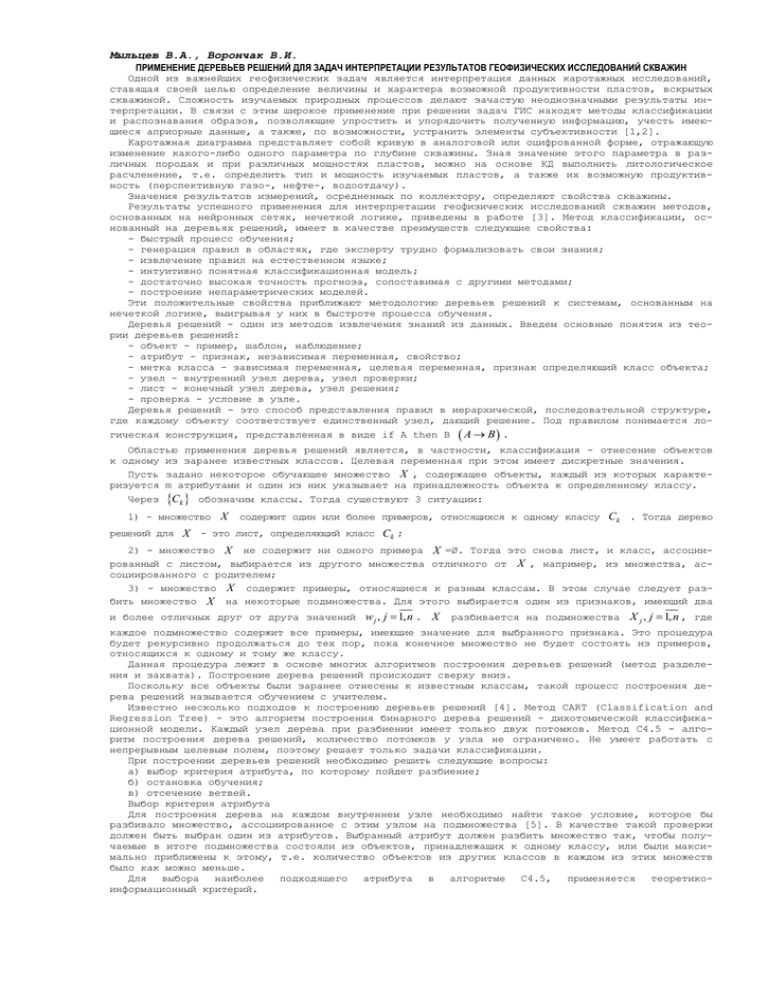

Мыльцев В.А., Ворончак В.И. ПРИМЕНЕНИЕ ДЕРЕВЬЕВ РЕШЕНИЙ ДЛЯ ЗАДАЧ ИНТЕРПРЕТАЦИИ РЕЗУЛЬТАТОВ ГЕОФИЗИЧЕСКИХ ИССЛЕДОВАНИЙ СКВАЖИН Одной из важнейших геофизических задач является интерпретация данных каротажных исследований, ставящая своей целью определение величины и характера возможной продуктивности пластов, вскрытых скважиной. Сложность изучаемых природных процессов делают зачастую неоднозначными результаты интерпретации. В связи с этим широкое применение при решении задач ГИС находят методы классификации и распознавания образов, позволяющие упростить и упорядочить полученную информацию, учесть имеющиеся априорные данные, а также, по возможности, устранить элементы субъективности [1,2]. Каротажная диаграмма представляет собой кривую в аналоговой или оцифрованной форме, отражающую изменение какого-либо одного параметра по глубине скважины. Зная значение этого параметра в различных породах и при различных мощностях пластов, можно на основе КД выполнить литологическое расчленение, т.е. определить тип и мощность изучаемых пластов, а также их возможную продуктивность (перспективную газо-, нефте-, водоотдачу). Значения результатов измерений, осредненных по коллектору, определяют свойства скважины. Результаты успешного применения для интерпретации геофизических исследований скважин методов, основанных на нейронных сетях, нечеткой логике, приведены в работе [3]. Метод классификации, основанный на деревьях решений, имеет в качестве преимуществ следующие свойства: - быстрый процесс обучения; - генерация правил в областях, где эксперту трудно формализовать свои знания; - извлечение правил на естественном языке; - интуитивно понятная классификационная модель; - достаточно высокая точность прогноза, сопоставимая с другими методами; - построение непараметрических моделей. Эти положительные свойства приближают методологию деревьев решений к системам, основанным на нечеткой логике, выигрывая у них в быстроте процесса обучения. Деревья решений - один из методов извлечения знаний из данных. Введем основные понятия из теории деревьев решений: - объект - пример, шаблон, наблюдение; - атрибут - признак, независимая переменная, свойство; - метка класса - зависимая переменная, целевая переменная, признак определяющий класс объекта; - узел - внутренний узел дерева, узел проверки; - лист - конечный узел дерева, узел решения; - проверка - условие в узле. Деревья решений - это способ представления правил в иерархической, последовательной структуре, где каждому объекту соответствует единственный узел, дающий решение. Под правилом понимается логическая конструкция, представленная в виде if A then B A B . Областью применения деревья решений является, в частности, классификация - отнесение объектов к одному из заранее известных классов. Целевая переменная при этом имеет дискретные значения. Пусть задано некоторое обучающее множество X , содержащее объекты, каждый из которых характеризуется m атрибутами и один из них указывает на принадлежность объекта к определенному классу. Через Ck обозначим классы. Тогда существуют 3 ситуации: 1) - множество X решений для X содержит один или более примеров, относящихся к одному классу Ck . Тогда дерево - это лист, определяющий класс Ck ; 2) - множество X не содержит ни одного примера X =Ø. Тогда это снова лист, и класс, ассоциированный с листом, выбирается из другого множества отличного от X , например, из множества, ассоциированного с родителем; 3) - множество X содержит примеры, относящиеся к разным классам. В этом случае следует разбить множество X на некоторые подмножества. Для этого выбирается один из признаков, имеющий два и более отличных друг от друга значений w j , j 1, n . X разбивается на подмножества X j , j 1, n , где каждое подмножество содержит все примеры, имеющие значение для выбранного признака. Это процедура будет рекурсивно продолжаться до тех пор, пока конечное множество не будет состоять из примеров, относящихся к одному и тому же классу. Данная процедура лежит в основе многих алгоритмов построения деревьев решений (метод разделения и захвата). Построение дерева решений происходит сверху вниз. Поскольку все объекты были заранее отнесены к известным классам, такой процесс построения дерева решений называется обучением с учителем. Известно несколько подходов к построению деревьев решений [4]. Метод CART (Classification and Regression Tree) - это алгоритм построения бинарного дерева решений - дихотомической классификационной модели. Каждый узел дерева при разбиении имеет только двух потомков. Метод C4.5 - алгоритм построения дерева решений, количество потомков у узла не ограничено. Не умеет работать с непрерывным целевым полем, поэтому решает только задачи классификации. При построении деревьев решений необходимо решить следующие вопросы: а) выбор критерия атрибута, по которому пойдет разбиение; б) остановка обучения; в) отсечение ветвей. Выбор критерия атрибута Для построения дерева на каждом внутреннем узле необходимо найти такое условие, которое бы разбивало множество, ассоциированное с этим узлом на подмножества [5]. В качестве такой проверки должен быть выбран один из атрибутов. Выбранный атрибут должен разбить множество так, чтобы получаемые в итоге подмножества состояли из объектов, принадлежащих к одному классу, или были максимально приближены к этому, т.е. количество объектов из других классов в каждом из этих множеств было как можно меньше. Для выбора наиболее подходящего атрибута в алгоритме C4.5, применяется теоретикоинформационный критерий. Имеется обучающее множество примеров X x j , Ckj , j 1, p; k 1, K , где каждый элемент этого множе- ства описывается атрибутами x xi , i 1, m и принадлежит одному из классов Ck . Количество примеров в множестве равно p является мощностью этого множества X . Задача заключается в построении иерархической классификационной модели в виде дерева из множе- ства примеров X x j , Ckj , j 1, p; k 1, K . Процесс построения дерева происходит сверху вниз. Сначала создается корень дерева, затем потомки корня и т.д. На первом шаге имеется пустое дерево (есть только корень) и исходное множество, ассоциированное с корнем). Требуется разбить исходное множество на подмножества. Это можно сделать, выбрав один из атрибутов в качестве проверки. Тогда в результате разбиения получаются n (по числу значений атрибута) подмножеств и соответственно создаются n потомков корня, каждому из которых поставлено в соответствие свое подмножество, полученное при разбиении множества X x j , Ckj , j 1, p; k 1, K . Затем эта процедура рекурсивно применяется ко всем подмножествам (потомкам корня) и т.д. Любой из атрибутов можно использовать неограниченное количество раз при построении дерева. Определим в качестве проверки t какой-либо атрибут, принимающий значения Тогда разбиение X по проверке t дает соответствующие подмножества xi wij , i 1, m; j 1, n. X j , j 1, n . Критерий выбора определяется Единственная информацией о том, каким образом классы распределены в множестве его подмножествах, получаемых при разбиении по X и t. Обозначим Piq , k 1, K ; i 1, m; q 1, n вероятность принадлежности классу k k по атрибуту i и q -му по- роговому значению xi wij , i 1, m; j 1, n , а P k - вероятность попадания в класс k . В качестве меры среднего количества информации, необходимого для определения класса примера из множества рется энтропия Шеннона X бе- K H X P k log 2 P k . k 1 Разбиению множества X K H iq k 1 Piqk log 2 Piqk по проверке t соответствует выражение для энтропии . Критерием выбора является выражение H X Hiq max или Hiq min . Минимальное значение энтропии H iq ответствует максимуму вероятности появления одного из классов. Выбранный атрибут и пороговое значение , минимизирующие H iq , i, q ArgMin H iq используются для проверки значения по этому атрибуту и дальнейшее движение по дереву производится в зависимости от полученного результата. Данный алгоритм применяется к полученным подмножествам и позволяет продолжить рекурсивно процесс построения дерева, до тех пор, пока в узле не окажутся примеры из одного класса. Если в процессе работы алгоритма получен узел, ассоциированный с пустым множеством (т.е. ни один пример не попал в данный узел), то он помечается как лист, и в качестве решения листа выбирается наиболее часто встречающийся класс у непосредственного предка данного листа. Для нахождения пороговых величин для числового атрибута значения xij , i 1, m; j 1, p сортируются по возрастанию и wij x i j xij 1 2 , i 1, m; j 1, p 1 определяют порог, с которым должны сравниваться все значения атрибута. Следует отметить, что все числовые тесты являются бинарными, т.е. делят узел дерева на две ветви. Правила остановки разбиения узла 1) Использование статистических методов для оценки целесообразности дальнейшего разбиения. 2) Ограничение глубины дерева. Остановить дальнейшее построение, если разбиение ведет к дереву с глубиной, превышающей заданное значение. 3) Разбиение должно быть нетривиальным, т.е. получившиеся в результате узлы должны содержать не менее заданного количества примеров. Правило отсечения ветвей дерева Предназначено для предотвращения сложных деревьев, трудных для понимания, которые имеют много узлов и ветвей. Примем за точность распознавания дерева решений отношение правильно классифицированных объектов при обучении к общему количеству объектов из обучающего множества, а под ошибкой - количество неправильно классифицированных. Предположим, что известен способ оценки ошибки дерева, ветвей и листьев. Тогда, возможно использовать следующее правило: 1) построить дерево; 2) отсечь или заменить поддеревом те ветви, которые не приведут к возрастанию ошибки. Отсечение ветвей происходит снизу вверх, двигаясь с листьев дерева, отмечая узлы как листья, либо заменяя их поддеревом. Для проведения геофизических исследований скважин применяются разнообразные группы методов: электрометрические, акустические, радиометрические, термометрические и др. Для обработки будем использовать результаты измерений полученные несколькими методами. 1. BK – метод – основан на измерении зондом электрического сопротивления пласта. 2. AK - акустический метод – измерение интервального времени пробега DT продольной звуковой волны. 3. GR – гамма-метод заключается в регистрации кривой изменения интенсивности естественного гамма-излучения пород в разрезе скважины при перемещении в ней радиометра. 4. NGR - нейтронный гамма-метод, основанный на измерении поглощения и рассеяния нейтронов. 5. KM - метод кавернометрии, заключающийся в измерении фактического диаметра необсаженной скважины. Рассмотрена выборка из p =210 точек. Анализ проводился на определении в коллекторе воды, углеводородов либо их смеси. Результирующее дерево показано на рис.1. Рис.1. Дерево классификации разреза скважины на наличие продуктивных пластов Из 210 примеров 167 отнесены к водосодержащим, 28 – к углеводородосодержащим и 19 – к смеси «вода + углеводороды». При этом 4 пласта «Вода» отнесены к смеси «вода + углеводороды». 2 пласта «Углеводороды» также отнесены к смеси. Таким образом, точность распознавания продуктивных пластов-коллекторов достаточно высокая. Время расчета данного дерева значительно меньше времени, требуемого для обучения как нейронной сети, так и системы нечеткого логического вывода. Структура дерева поясняет процесс интерпретации и может быть полезной для эксперта-интерпретатора. ЛИТЕРАТУРА 1. Дьяконова Т.Ф. Применение ЭВМ при интерпретации данных геофизических исследований скважин. М.: Недра, 1991. – 220c. 2. Латышова М.Г. Венделынтейн Б.Ю., Тузов В.П. Обработка и интерпретация геофизических исследований скважин. - М.: Недра, 1990. – 312c. 3. Сенилов М.А., Тененев В.А. Интеллектуальные алгоритмы интерпретации геофизических исследований скважин. СПб: Изд-во СПбГЭТУ «ЛЭТИ»,2004. – 128c. 4. Kiselev, M.V., Ananyan, S. M., and Arseniev, S. B. Regression-Based Classification Methods and Their Comparison with Decision Tree Algorithms, In: Proceedings of 1st European Symposium on Principles of Data Mining and Knowledge Discovery, Trondheim, Norway, Springer, 1997. – pp 134144. 5. Wang Q. R. and C. Y. Suen. Large tree classifier with heuristic search and global training. IEEE Transactions on Pattern Analysis and Machine Intelligence, 9(1):91-102, 1987.