Извлечение и анализ знаний

реклама

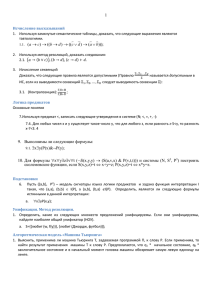

4К УДК 519.95 В.Н. Коваль, Ю.В.Кук Институт кибернетики им. В.М. Глушкова НАН Украины, г. Киев [email protected], [email protected] Извлечение и анализ знаний Предложена методика извлечения знаний из таблицы экспериментальных данных, которая основана на вычислении частот совместного появления одинаковых значений в этой таблице. Рассмотрена связь предикатов в знаниях. Разработана процедура структуризации базы знаний, позволяющая уменьшить ее объем. Получено уравнение, которое описывает зависимость между значениями предикатов в знании и позволяет прогнозировать значения одних предикатов по другим. Введение Данная работа посвящена дальнейшей разработке методов практического извлечения знаний из таблиц экспериментальных данных, а также анализу полученных знаний [1-3]. В ней развиты идеи, изложенные в работах [2-3]. Прежде всего это идея о том, что для представления знаний в форме продукционных правил следует использовать понятие переменного предиката, который может принимать множество значений – так называемых предикатных констант, предикатов в общепринятом смысле. Вторая идея состояла в том, что с каждым значением предиката следует соотносить частоту его появления в таблице данных. С помощью этих частот строилась в [2-3] эмпирическая функция распределения предиката. Эта идея всесторонне развивается и в настоящей работе. Она используется как при получении знаний, так и при их анализе. Наличие нескольких предикатов в знании значительно усложняет построение эмпирической функции распределения знания по сравнению с предикатом, поскольку следует учитывать частоты не только отдельных значений предикатов, но и совместного их появления. С помощью функций распределений в [2-3] находилось расстояние между предикатами. Тот же самый принципиальный подход используется и при нахождении расстояния между знаниями. Из множества формул, рассмотренных в [2-3], которые применялись для вычисления расстояния между предикатами, для этих целей выбрана формула расстояния Хеллингера, поскольку это расстояние обладает всеми общепринятыми свойствами расстояния, хотя его роль может играть и любое другое расстояние, рассмотренное в [2-3]. 1 Расстояние между знаниями В работе предполагается, что имеется некоторый исходный набор таблиц экспериментальных данных. Задача состоит в том, чтобы, анализируя данные этих таблиц, получить некоторые знания, содержащиеся в них. Знания будем представлять в виде продукционных правил типа «если X 1 & & X K , то X K 1 & & X K L », где X 1, , X K , X K 1 , , X K L – некоторые предикаты. Предикаты X 1, , X K будем на- «Штучний інтелект» 3’2004 293 Коваль В.Н., Кук Ю.В. 4К зывать предикатами условия знания, а предикаты X K 1 , , X K L – целевыми предикатами, или предикатами следствия. Число предикатов условия будем обозначать K , а число предикатов следствия – L . Под предикатами будем понимать переменные предикаты [2-3]. Определение 1. Пусть 1m1 , 2m2 ,..., rmr ,... – множество предикатных символов соответственно арности m1 , m 2 ,..., m r ,... , которые называются предикатными константами. Под переменным предикатным символом, или просто предикатом, понимается знак (или последовательность знаков), обозначающий произвольный элемент из . Множество будем называть множеством значений переменного предиката. Пусть P – переменный предикатный символ, множество значений которого состоит из предикатных констант одинаковой арности, равной m , имеющих вид im i ( x1 ,..., x m ) , i 1, 2,..., r ,... , где x1 ,..., x m – символы предметных (индивидных) переменных. Тогда P называется m -арным переменным предикатом, или просто предикатом, и обозначается P( x1 ,..., x m ) . Для интерпретации m -арного переменного предиката P( x1 ,..., xm ) необходимо указать области изменения D1 , D2 ,..., Dm предметных переменных x1 ,..., x m . Обычно D1 D2 ... Dm D . Кроме того, для каждой предикатной константы, входящей в , необходимо задать отображение D1 D2 ... Dm в {И, Л}. Таким образом, интерпретация m -арного переменного предиката P( x1 ,..., xm ) состоит из множества интерпретаций его значений I ( P ) I ( 1m ), I ( 2m ),..., I ( rm ),... . При замене символов предметных переменных x1 ,..., x m в предикатных константах m ой объектов из D1 D2 ... Dm получаем множество высказываний об этой m -е объектов. При m 1 предикат характеризует «свойство» объекта, при m 1 – «отношение» между m объектами. Значения предикатов будем кодировать путем сопоставления им точек некоторого евклидового пространства. Удобно кодировать значения предиката с помощью чисел прямой R1 . Значению предиката с индексом i ставится во взаимно однозначное соответствие точка g (i ) , равная g (i ) ai b , где a – некоторое положительное число, а b – произвольное число. Числа a и b определяют соответственно масштаб и начало отсчета отображения значений предиката на прямую R1 . При анализе знаний будут использоваться также и другие способы кодировки значений предикатов, о которых речь пойдет ниже. Пример 1. Рассмотрим таблицу некого учреждения 1, в которой представлены данные о цвете глаз и цвете волос 680 человек. Предикаты для такой таблицы имеют следующий вид: X 1 – предикат «ЦВЕТ ГЛАЗ (x ) , а X 2 – предикат «ЦВЕТ 1 1 ВОЛОС (x ) . X 1 – предикат с множеством значений 111 , 21 , 31 , состоящим 1 1 из 3 унарных предикатных констант: 11 – «ГОЛУБОЙ (x ) », 21 – «СЕРЫЙ (x ) », 1 1 1 1 31 – «КАРИЙ (x ) ». X 2 – предикат с множеством значений 121 , 22 , 32 , 42 , 1 1 состоящим из 4 унарных предикатных констант: 12 – «СВЕТЛЫЙ (x ) », 22 – 1 1 «РУСЫЙ (x ) », 32 – «ЧЕРНЫЙ (x ) », 42 – «РЫЖИЙ (x ) ». 294 «Искусственный интеллект» 3’2004 Извлечение и анализ знаний 4К Определение 2. Содержанием знания «если X 1 & X 2 & X 3 & X K , то X K 1 & X K 2 & X K 3 & X K L » называется множество W 1 2 ... K L . Произвольный элемент этого множества называется элементом содержания знания. Содержанием условия знания называется множество W1 1 2 ... K . Произвольный элемент этого множества называется элементом содержания условия знания. Содержанием следствия знания называется множество W2 K 1 2 ... L . Произвольный элемент этого множества называется элементом содержания следствия знания. Определение 3. Под вероятностью pi элемента содержания знания wi W будем понимать вероятность события, состоящего в том, что все предикатные константы, составляющие wi , примут логическое значение «И» при подстановке в знание вместо аргументов объектов из областей истинности переменных предикатов, составляющих это знание. Элемент содержания знания w j представляет собой вектор, компонентами которого являются значения переменных предикатов, входящих в это знание. Эти значения индексируются соответствующими индексами. Поэтому элементу содержания знания w j можно поставить в соответствие вектор z j ( z j (1), , z j ( K L)) из R K L . Этот вектор имеет i -ю координату, равную преобразованному с помощью масштабируемой функции g соответствующего индекса предикатной константы предиката X i . Функция распределения знания – это функция от K L аргументов: F ( y ) F ( y (1), y (2),..., y ( K L)) , с областью определения R K L и принимающая значения в пространстве R1 . Она определяется по формуле F ( y ) p j , где z j – z j y отображение элемента содержания знания w j в R K L . Здесь и далее выражение z j y понимается как выполнение условий: z j (i ) y (i ), i 1,..., K L . Как правило, вероятности элементов содержания знания и их функции распределения являются неизвестными. Вместо них при расчетах используют соответственно частоты и эмпирические функции распределения. Рассмотрим процедуру построения эмпирической функции распределения * Fn ( y ) знания при заданной интерпретации его предикатов. Элементу содержания знания w j соответствует вектор z j из R K L . Предметная область знания равна прямому произведению предметных областей составляющих его предикатов. Пусть K L m m i , где mi – арность X i -го предиката. Для построения эмпирической функ- i 1 ции распределения знания берутся произвольным образом выборки по m объектов из его предметной области (всего n выборок по m объектов). Для каждой выборки находится тот элемент содержания знания, при подстановке в который вместо аргументов предикатных констант этой выборки получается истинное высказывание. В результате получим n элементов содержания знания, которые отображаются в n векторов из пространства R K L : z1 , , z n , где z i ( z i (1), , z i ( K L)) . Эмпири- «Штучний інтелект» 3’2004 295 Коваль В.Н., Кук Ю.В. 4К ческая функция распределения Fn* ( y ) строится следующим образом. Для фиксированного вектора y , y ( y (1), , y ( K L)) R K L , рассматривается подмножество следующего вида: B y { z R K L : . z ( j ) y ( j ), j 1, , K L } . Обозначим ( B y ) число тех векторов z1 , , z n , которые попали во множество B y . Тогда для данного y значение эмпирической функции распределения знания определяется по формуле Fn* ( y ) ( B y ) / n , y R K L . Пример 2. Путем прямого подсчета числа совместного появления признаков в таблице данных учреждения 1 можно построить следующую таблицу частот знания: «если X 2 , то X 1 », где X 1 , X 2 – предикаты, рассмотренные в примере 1. В этой таблице на пересечении строки и столбца стоит число случаев совместного появления признаков, а в скобках указана частота, которая получается делением этого числа на общее число случаев – 680 (табл. 1). Таблица 1 111 1 21 1 31 Итого 121 177 (0,26) 95 (0,14) 12 (0,017) 1 22 71 (0,1) 119 (0,175) 44 (0,064) 1 32 17 (0,025) 75 (0,11) 23 (0,034) 1 42 14 (0,02) 25 (0,036) 8 (0,011) 284 (0,417) 234 (0,34) 115 (0,169) 47 (0,069) Итог 279 (0,41) 314 (0,46) 87 (0,12) 680 (1,0) Определение 4. Два знания (ЗН1: «если X 1 & X 2 & X 3 & X K , то X K 1 & X K 2 & X K 3 & X K L » и ЗН2: «если Y1 & Y2 & Y3 & YK , то YK 1 & ... & YK L »), определенные на подмножествах одной и той же предметной области, будем называть сравнимыми, если их предикаты с одинаковыми индексами имеют одно и то же множество значений и могут лишь отличаться вероятностями своих значений. Предикаты знаний с одинаковыми индексами будем называть соответствующими. Если соответствующие предикаты знаний отличаются лишь множествами значений, то их можно привести к сравнимым знаниям с помощью следующего приема. Пусть множество значений предиката X i первого знания содержит некоторые значения, которых нет во множестве значений предиката Yi , входящего во второе знание. Для того чтобы знания сделать сравнимыми, полагаем, что эти отсутствующие значения все же содержатся во множестве значений предиката Yi второго знания, но имеют вероятность, равную нулю. Такие значения предиката Yi будем называть фиктивными. Полагаем, что вероятности элементов содержания знания, содержащих фиктивные значения предикатов, равны нулю. Различие в распределении вероятностей элементов содержания двух сравнимых знаний можно использовать для определения близости этих знаний. Пусть содержание знания ЗН1 равно 1 w11 , w12 ,..., w1r ,... , а содержание знания ЗН2 равно 2 w21 , w22 ,..., w2 r ,... . Обозначим pij ( i 1, 2 ) вероятность элемента со- 296 «Искусственный интеллект» 3’2004 Извлечение и анализ знаний 4К держания wij ( i 1, 2 ). Обозначим распределение вероятностей элементов содер- жания знания ЗН1 через G p11 , p12 ,..., p1r ,... , а распределение вероятностей элементов содержания знания ЗН2 – через Q p 21 , p 22 ,..., p 2 r ,... . Расстояние между знаниями определим как расстояние Хеллингера между распределениями вероятностей их элементов содержания. Это расстояние обладает всеми свойствами расстояния [2]. Определение 5. Расстоянием между сравнимыми знаниями ЗН1 и ЗН2 назовем расстояние Хеллингера d (G, Q) между двумя распределениями вероятностей их элементов содержания G p11 , p12 ,..., p1r ,... и Q p 21 , p 22 ,..., p 2 r ,... , которое вычисляется по следующей формуле: d (G , Q ) p1 j p2 j . 2 j Умея вычислять расстояние между знаниями, можно решить следующую задачу. Пусть на вход базы знаний подается некоторое новое знание. Требуется определить, к какому из подмножеств знаний следует отнести это новое знание. Для решения этой задачи нужно вычислить расстояние между новым знанием и всеми имеющимися знаниями, а затем отнести его к подмножеству, содержащему такое знание, для которого это расстояние принимает наименьшее значение. Пример 3. Пусть, кроме данных учреждения 1 примера 1, в нашем распоряжении имеется таблица данных учреждения 2, в которой также представлены сведения о цвете глаз и цвете волос группы людей. По данным этой таблицы построим таблицу частот (табл. 2). Подставляя частоты из табл. 1 и 2 в формулу для расстояния Хеллингера, получим, что расстояние между знаниями, построенными по данным этих двух учреждений, равно 0,005. Таблица 2 111 1 21 1 31 Итого 121 0,22 0,14 0,02 1 22 0,1 0,24 0,06 1 32 0,01 0,12 0,03 1 42 0,02 0,03 0,01 Итог 0,38 0,4 0,16 0,06 1,0 0,35 0,53 0,12 2 Информативность предикатов в знаниях Пусть дано некоторое знание: «если X 1 & X 2 & X 3 & X K , то X K 1 & X K 2 & X K 3 & X K L ». Целевые предикаты этого знания могут никак не зависеть от некоторого предиката условия. Назовем такой предикат неинформативным. Очевидно, что его можно исключить из продукционного правила без какого-либо ущерба. Если исключить все такие предикаты из исходного знания, то в результате получим знание, не содержащее неинформативных предикатов. Такое знание назовем нормальным. «Штучний інтелект» 3’2004 297 Коваль В.Н., Кук Ю.В. 4К Определение 6. Под информативностью предиката, входящего в условие знания, будем понимать степень его зависимости от целевого предиката. Построим оценки I ij информативности предикатов X i и X j . При подстановке объектов вместо аргументов предикатных констант при некоторой их интерпретации принятие предикатной константой логического значения «И» можно рассматривать как своего рода событие. Из теории вероятностей известно, что события независимы, если вероятность совместного их наступления равна произведению вероятностей наступлений каждого из событий в отдельности. Поэтому для построения оценки информативности I ij предикатов X i и X j поступим следующим обра- зом. Пусть i 1mii , 2mii ,..., smiii m m m и j 1 j j , 2 jj ,..., s j jj – множества их значений, которые состоят соответственно из s i и s j предикатных констант. По таблице данных найдем частоты появления отдельных значений предикатов X i и X j , а также частоты совместного появления всевозможных пар значений предикатов X i и X j . Пусть p i – частота появления значения mii предиката X i , p j – m частота появления значения jj предиката X j . Обозначим p i , j частоту появлеm ния значения mii предиката X i совместно со значением jj предиката X j . Абсолютная величина разности p i , j p i p j определяет степень независимости одновременного появления рассматриваемых значений предикатов. В соответствии с общим принципом наименьших квадратов примем за оценку информативности I ij предикатов X i и X j сумму квадратов таких разностей для всевозможных пар значений рассматриваемых предикатов, причем каждое слагаемое включается в эту сумму с некоторым коэффициентом. Эти коэффициенты могут быть выбраны более n или менее произвольно. Выберем эти коэффициенты равными , при этом эта p i p j сумма превращается в 2 – статистику, распределение которой при достаточно больших значениях n не зависит от исходных плотностей распределения вероятностей предикатов и имеет плотность 2 – распределения с r ( si 1)( s j 1) степенями свободы. Таким образом, информативность предикатов X i и X j равна n p i , j p i p j 2 I ij , p i p j . Каждое слагаемое этой суммы будем называть информативностью соответствующих значений предикатов. Для проверки значимости величины информативности рассмотрим следующие две гипотезы: H 0 – имеет место равенство p i , j p i p j для всех и , и альтернативную ей гипотезу H 1 . Проверим гипотезу H 0 при заданной вероятности ошибки 0,01 . Применим критерий 2 . По таблицам распределения 2 находим критическую точку x0.01 для 2 – рас- 298 «Искусственный интеллект» 3’2004 Извлечение и анализ знаний 4К пределения с r ( si 1)( s j 1) степенями свободы. Если окажется, что 2 x0.01 , то гипотеза H 0 не верна. Значит, предикаты информативны. Пример 4. Подсчитаем информативность предикатов X 1 , X 2 примера 1. Для этого подсчитывается информативность всех пар их совместных значений. 1 Проиллюстрируем на значениях 12 и 111 . По табл. 1 находим частоту их совме1 стного появления, которая равна p12 ,11 0,26 , затем частоту для 12 , равную p12 0,416 , и, наконец, частоту для 111 , равную p11 0,41 . n 680 . Вычисляем n p12,11 p12 p11 30,8 . Полученные информативности всех пар значений склаp12 p11 дываем. В результате имеем I12 106 . Число степеней свободы равно 2 r ( si 1)( s j 1) 2 3 6 . Найдем критическую точку x0.01 для 2 – распределе- ния с r 6 степенями свободы. x0.01 16,8 . Так как I 12 106 x 0. 01 16,8 , то предикаты знания «если X 2 , то X 1 » информативны, а само знание нормально. Процедура извлечения нормальных знаний по данным таблицы следующая. Вначале выбирается множество целевых предикатов, а также делается предположение, что эти предикаты зависят от всех остальных предикатов. Данное предположение представляется в виде некоторого знания, которое называется исходным. В его следствие входят выбранные целевые предикаты, а в условие – остальные предикаты. Для определенности предположим, что это знание имеет вид: «если X 1 & X 2 & X 3 & X K , то X K 1 & X K 2 & X K 3 & X K L ». Может оказаться, что ни один из предикатов условия X 1 , X 2 , X 3 , , X K никак не связан ни с одним из целевых предикатов X K 1 , X K 2 , X K 3 , , X K L . В этом случае исходное знание «ложно». Далее по таблице данных находятся частоты значений предикатов исходного знания и вычисляются информативности всех предикатов условия исходного знания поочередно с каждым целевым предикатом. Полученные значения информативностей проверяются на значимость. Неинформативные предикаты удаляются из условия знания. Если для одного или нескольких целевых предикатов окажется, что все предикаты условия неинформативны, то эти целевые предикаты исключаются из следствия знания. В результате получается нормальное знание. 3 Получение обобщенного и канонического знаний Обнаруженные знания помещаются в базы знаний, в которых может накапливаться большое количество знаний. Вместо всего подмножества знаний удобно иметь дело только с одним из его представителей, который заменяет все это подмножество. В качестве такого представителя берется так называемое обобщенное знание. Кроме того, в качестве такого представителя может браться каноническое знание, которое строится из обобщенного знания путем анализа значимости его значений. Процедура, состоящая в замене всего подмножества нормальных знаний одним из его представителей, называется структуризацией базы знаний. Она позволяет резко уменьшить ее объем. «Штучний інтелект» 3’2004 299 Коваль В.Н., Кук Ю.В. 4К Определение 7. Обобщенным знанием для данного подмножества сравнимых знаний называется знание, состоящее из тех же предикатов, что и сравнимые знания, приведенные к нормальному виду, но частоты элементов содержания этого знания равны усредненным (по всем знаниям данного подмножества) частотам. Обозначим N число знаний в рассматриваемом подмножестве знаний. m m m Пусть i 1mii , 2mii ,..., smiii и j 1 j j , 2 jj ,..., s j jj – множества значений пре- дикатов X i и X j . p i ( ) – частота появления значения mii предиката X i в знании . Будем обозначать предикаты обобщенного знания символом *: «если X 1* & & X K* , то X K* 1 & & X K* L ». Тогда частота появления значения mii пре- 1 N p i ( ) . Пусть p*i , j – частота N 1 обобщенного знания совместно со значе- диката X i* обобщенного знания равна p* i появления значения mii предиката X 1* m нием jj предиката X *j , а p i , j ( ) – частота совместного появления этих значений у предикатов X i и X j в знании . Тогда p*i , j Очевидно, что F * ( y1 , y2 ,..., y K L ) равна функция распределения 1 N N p i, j ( ) . 1 обобщенного знания 1 N F ( y1 , y 2 ,..., y K L ) , N 1 где F ( y1 , y 2 ,..., y K L ) – функция распределения знания . F * ( y1 , y 2 ,..., y K L ) Пример 5. Обобщенное знание «если X 2* , то X 1* » для знаний, полученных по таблицам данных учреждений 1 и 2 примеров 1 и 3, имеет частоты, равные среднеарифметическим частотам табл. 1 и 2 (табл. 3). Таблица 3 111 1 21 1 31 Итог 121 1 22 1 32 1 42 Итог 0,240147 0,102206 0,0175 0,020294 0,380147 0,139853 0,2075 0,115147 0,033382 0,495882 0,018824 0,398824 0,062353 0,372059 0,031912 0,164559 0,010882 0,064559 0,123971 1 Некоторые предикатные константы, входящие во множества значений предикатов условия знания, не оказывают какого-либо влияния на предикатные константы целевых предикатов. Назовем такие значения предикатов условия незначимыми. Кроме того, некоторые значения целевых предикатов могут оказаться никак не связанными со значениями предикатов следствия. Назовем такие значения целевых предикатов несвязанными. Незначимые и несвязанные значения предикатов можно удалить из множеств значений предикатов обобщенного знания. В результате получим каноническое знание. 300 «Искусственный интеллект» 3’2004 Извлечение и анализ знаний 4К Определение 8. Каноническим знанием называется знание, которое получается из обобщенного знания путем удаления незначимых предикатных констант из множеств значений предикатов условия обобщенного знания и несвязанных значений предикатов из множеств значений целевых предикатов. Построение канонического знания основано на процедуре построения так называемых канонических бассейнов предикатов для значений целевых предикатов. Для их построения введем следующие вспомогательные числовые переменные, которые назовем интерпретационными переменными. Определение 9. Под интерпретационными переменными предиката X i будем понимать s i вспомогательных числовых переменных wij , j 1,..., s i , принимающих два значения – 0 и 1: wij равно 1, если предикатная константа ijmi принимает логическое значение «И» при подстановке в нее вместо аргументов mi объектов из данной предметной области, и равно 0, если предикатная константа ijmi принимает логическое значение «Л». При подстановке в обобщенное знание вместо аргументов предикатных констант конкретных объектов из изучаемой предметной области интерпретационные переменные wij , j 1,..., s i , i 1,..., K L , примут определенные значения. Обозначим pij частоту того, что интерпретационная переменная wij предиката X i примет значение, равное 1. Будем также использовать следующие обозначения: p jk , il ,..., sm – частота совместного события, состоящего в том, что переменная w kj предиката X j примет значение, равное 1, переменная wil предиката X i примет значение, равное 1, и т.д., наконец, переменная wsm предиката X s примет значение, равное 1. Математическое ожидание wij равно ij Mwij 1 p ij 0 (1 pij ) pij . Второй начальный момент wij равен ij M ( wi j ) 2 12 p ij 0 2 (1 p ij ) p ij . Вторые центральные моменты, или ковариации переменной wil предиката X i и переменной w kj предиката X j , определяются по формуле ijlk Mwil w kj Mwil Mw kj pil , jk pil p jk . Величина ii jj i j j 2 ji lk ij d p ji p равна дисперсии wi , а коэффициент r ijlk d il d kj называется ко- эффициентом корреляции между wil и w kj . Рассмотрим множество W jk , состоящее из интерпретационной переменной w kj целевого предиката X j и всех интерпретационных переменных предикатов условия знания: W jk {w kj , w11 , w12 , , w1s1 , w12 , w22 , , w2s2 , wKs K } . Корреляционная матрица Q kj для переменных этого множества состоит из коэффициентов корреляции всевозможных пар переменных множества W jk . Если коэффициент корреляции rijlk между переменной wil предиката X i и переменной w kj целевого предиката X j равен нулю, то соответствующие этим переменным значения предика- «Штучний інтелект» 3’2004 301 Коваль В.Н., Кук Ю.В. 4К тов называются некоррелированными. В некоторых случаях корреляция между переменной wil предиката X i и переменной w kj предиката X j в знании целиком или частично вызывается тем, что существует значительная корреляция между этими значениями предикатов, с одной стороны, и неким значением w третьего предиката X – с другой. Для измерения корреляции между переменной wil предиката X i и переменной w kj целевого предиката X j , оставшейся после исключения зависимости этих значений от всех остальных значений предикатов условия знания, используется частный коэффициент корреляции, вычисляемый по формуле lk ij 1, K , i r Cijlk Ciill C kkjj , где Cijlk , C iill , C kkjj – алгебраические дополнения в корреляционной матрице Q kj соответственно элементам rijlk , riill , rjjkk . Коэффициент корреляции значим, если он с вероятностью 0,95 отличен от нуля. Каноническим бассейном B kj целевой переменной w kj назовем подмножество всех интерпретационных переменных условия знания, которые имеют значимый (относительно множества B kj ) частный коэффициент корреляции с w kj . Алгоритм его построения аналогичен построению бассейна для целевой переменной, изложенному нами в [4]. Каноническим бассейном знания назовем объединение канонических бассейнов всех целевых интерпретационных переменных предикатов следствия знания. Каноническое знание строится из обобщенного знания путем удаления из множества значений предикатов условия обобщенного знания предикатных констант, не входящих в канонический бассейн, а также удаления из множества значений целевых предикатов тех значений, для которых соответствующие канонические бассейны пусты. В результате получается более компактное знание. Пример 5. По частотам табл. 3 определим частные коэффициенты корреляции между предикатными константами условия и следствия обобщенного знания примера 4. В табл. 4 они представлены на пересечении соответствующих строк и столбцов. Таблица 4 121 1 22 1 32 1 42 111 1 21 0,36373 –0,15733 –0,23927 –0,05893 –0,22353 0,0683 0,173122 0,034888 1 31 –0,21425 0,12974 0,093959 0,034714 1 Проверка на значимость этих коэффициентов показала, что значение 42 («рыжий цвет волос») можно исключить из обобщенного знания. В результате 1 получим каноническое знание, предикат условия которого не содержит 42 . 302 «Искусственный интеллект» 3’2004 Извлечение и анализ знаний 4К 4 Нахождение уравнений знания В этом разделе рассмотрим методы получения знаний, которые выражают зависимости между значениями предикатов в канонических знаниях. Они позволяют прогнозировать значения целевых предикатов по значениям остальных его предикатов. Для того чтобы установить зависимость между значениями предикатов при данной их интерпретации, нужно установить зависимость между значениями интерпретационных переменных для предикатов условия и следствия знания. Будем искать зависимости между каждой интерпретационной переменной множества целевых предикатов и множеством интерпретационных переменных предикатов условия знания. Пусть w kj – k -я интерпретационная переменная целевого предиката X j . Представим искомую зависимость в следующем виде: w kj b0 b11w11 ... b1s1 w1s1 ... bK1 w1K ... bKs K wKs K . Коэффициенты b0 и bil ( l 1,..., s i , i 1,..., K ) выберем из условия минимума среднеквадратической ошибки: M w kj b0 b11w11 ... b1s1 w1s1 ... bK1 w1K ... bKs K wKs K . 2 Дифференцируя (5) по каждому из коэффициентов и принимая во внимание, что Mw kj 1 p jk , а Mwi j w 1 pij , , получим следующую систему: ... b p ... b p p jk b0 b11 p11 ... b1s1 p1s1 ... bK1 p K 1 ... bKs K p Ks K , b p p jk , 11 b0 b11 p11 ... b1s1 p1s1 ,11 1 K K 1,11 , ... bKs K p Ks K ,11 , s1 sK 1 1 p jk , 12 b0 1 11,12 ... b1 p1s1 , 12 K K 1,12 ... b K p Ks K , 12 …………………………………………………………………… p jk , ks K b0 b11 p11, ksK ... b1s1 p1s1 , ks K ... bK1 p K 1, ks K ... bKs K p Ks K , ksK . Детерминант этой системы D 1 p11 p1s1 1 p11 p1s1 ,11 D 1 p11,12 p1s1 , 12 1 p11, ksK p1s1 , ksK и столбец его свободных членов A равны pK1 p Ks K p jk p K 1, 11 p Ks K ,11 p jk , 11 p K 1, 12 p Ks K ,12 , A p jk , 12 . p K 1, ks K p Ks K , ksK p jk , ks K Обозначим Dil детерминант, получаемый из D путем замены в нем столбца коэффициентов при bil столбцом A . Тогда при D 0 по формулам Крамера по- Dil лучим, что искомые коэффициенты равны b . D Уравнение знания можно усложнить, добавив в правую его часть попарные произведения интерпретационных переменных предикатов условия знания. В этом случае уравнение знания будет учитывать попарные влияния значений предикатов условия на значения целевых предикатов. Неизвестные коэффициенты этого уравнения находятся из условия минимума среднеквадратической ошибки. l i «Штучний інтелект» 3’2004 303 Коваль В.Н., Кук Ю.В. 4К Пример 6. Найдем уравнение для канонического знания примера 5 и переменной w11 . Оно имеет вид w11 b0 b21w12 b22 w22 b23w23 . Коэффициенты определяются из системы 4 уравнений, частоты в которой берутся из табл. 3: b p p11 b0 b21 p21 b22 p22 b23 p23 , p11, 21 b0 b21 p21 b12 p22, 21 b23 p23, 21 , p11, 22 b0 1 2 21, 22 b p22 b p23, 22 , p11, 23 b0 b21 p21, 23 b22 p22 , 23 b23 p23 . 2 2 3 2 Поскольку выборка людей для получения данных формировалась случайным образом, то p22 , 21 p22 p21 , p23, 22 p23 p22 , p21, 23 p21 p23 . Поэтому получаем b0= – 0,17, b21 0,81 , b22 0,3 , b23 0,73 . Заключение Результаты, полученные в работе, показывают, что путем простого подсчета частот различных значений табличных данных, можно получить скрытые в них знания. Основные результаты работы таковы: введена метрика на множестве знаний, разработаны методы извлечения знаний из таблиц данных, преобразования знаний в нормальную, обобщенную и каноническую форму, структуризации базы знаний, получения уравнения знания, которое позволяет прогнозировать значения целевых предикатов. Литература 1. 2. 3. 4. Загоруйко Н.Г. Прикладные методы анализа данных и знаний. – Новосибирск: Изд-во Ин-та математики, 1999. – 269 с. Коваль В.Н., Кук Ю.В. Интеллектуальный анализ данных в системах рассуждений по аналогии // Искусственный интеллект. – 2003. – № 3. – С. 263-275. Koval V.N., Kuk Yu.V. Distances between predicates in by-analogy reasoning systems // Proc. of the X-th Inter. Conf. “Knowledge-Dialogue-Solution”. – Varna. – 2003. – P. 404-412. Коваль В.Н., Кук Ю.В. Структурный метод моделирования сложных систем // УСиМ. – 2003. – № 2. – С. 45-55. В.М. Коваль, Ю.В. Кук Отримання і аналіз знань Запропонована методика отримання знань з таблиці експериментальних даних, що заснована на підрахунку частот спільної появи однакових значень у цій таблиці. Розглянуто зв’язок предикатів у знаннях. Розроблена процедура структуризації бази знань, що дозволяє зменшити її обсяг. Отримане рівняння, що описує залежність між значеннями предикатів у знаннях і дозволяє прогнозувати значення одних предикатів за іншими. V.N. Koval, Ju.V. Kuk Extraction and analysis of knowledges The technique of extraction of knowledges from the table of experimental data is offered. It is based on calculation of frequencies of joint emerging of identical significances in this table. The relations of predicates in knowledges are considered. The procedure of structuring of the base of knowledges is developed. The equation is obtained which describes dependence between their significances. It allows to predict significances of one predicate on significances other. Статья поступила в редакцию 30.07.2004. 304 «Искусственный интеллект» 3’2004