ИНСТРУМЕНТАРИЙ БОЛЬШИХ ДАННЫХ

advertisement

ISSN 1028-7493

ИТ для бизнеса —

архитекторам

информационных систем

www.osmag.ru

ИНСТРУМЕНТАРИЙ

БОЛЬШИХ ДАННЫХ

ISSN 1028-7493

Открытые системы. СУБД №01 2014 Инструментарий Больших Данных • Автоматическое управление ИТ

СУ

БД

Открытые

системы

№01

2014

Боб Меткалф: Ethernet сорок лет спустя

Большие Данные против индустрии ИТ

Секреты интеграции в Airbus

Новые гибридные микропроцессоры

Уязвимости и защита стратегических инфраструктур

•

•

•

•

Toyota демонстрирует

трехколесный гибрид

мотоцикла, автомобиля

и Segway

AltOS

Источник: Electrolux

Компания Toyota представила концептуальную модель трехколесного «персонального средства передвижения» под

названием iRoad. Мини-автомобиль обтекаемой формы имеет два колеса спереди и одно сзади. Заднее поворачивается, тогда как передние на поворотах

автоматически наклоняются.

iRoad обладает необычайной маневренностью: можно повернуть руль прямо

перед препятствием, и автомобиль выполнит поворот не потеряв устойчивости. Максимальная скорость iRoad —

около 50 км/ч, средства управления

очень простые: руль, газ, тормоз и кнопка запуска. В салоне предусмотрены

места для двоих.

Источник: Toyota

Летающие роботы-уборщики и дышащие стены

Компания Electrolux объявила проекты, победившие на организованном ею конкурсе Electrolux Design Lab 2013. Первое место заняла концепция системы уборки дома, представляющей собой рой миниатюрных летающих роботов, которые

чистят поверхности каплями воды. Благодаря им хозяин квартиры может, удобно

устроившись в кресле после трудного дня, наблюдать, как «автоматические феи,

словно по волшебству, преображают дом перед его глазами».

Второй приз достался дышащим стенам. Стены двигаются, имитируя «дыхание»,

и при этом очищают воздух микрофильтрами, работающими по принципу рыбьих

жабр. С помощью приложения для смартфона можно переключать режимы работы

стен — «снятие стресса», «навевание воспоминаний», «поднятие настроения» и т. д.

Третье место занял детский 3D-принтер здоровой еды Atomium. По замыслу, ребенок сможет сперва нарисовать на листке бумаги, как должно выглядеть блюдо,

а принтер из смеси загруженных в него родителями порошкообразных ингредиентов и воды с помощью системы шприцев приготовит заказ.

Hershey собирается печатать

шоколад на 3D-принтере

Источник: NASA

Инженеры НАСА проектируют роботов совершенно нового вида — сферических,

которых можно будет просто сбросить на другую планету без повреждений от

удара и которые будут перемещаться, катаясь по ее поверхности.

Корпус таких роботов будет строиться по принципу «тенсегрити», то есть представлять собой сферическую каркасную структуру натяжения-сжатия, сетку из

тросов и стержней, объясняют проектировщики. Не имея жестких соединений, колес или гусениц, эти аппараты будут обладать уникальным уровнем надежности,

представляя собой легкие конструкции, полностью амортизирующие удар

о поверхность планеты при сбросе с орбиты.

Сегодня ученые исследуют Марс с помощью роботизированных вездеходов

Curiosity и Opportunity — колесных машин, оснащенных научными приборами

и механизированными манипуляторами.

Перекатывающийся шарообразный робот с гораздо меньшей вероятностью застрянет в песке — именно такой инцидент привел к потере марсохода Spirit: после

безуспешных попыток ученых вытащить робота, застрявшего в песчаной дюне,

его миссию пришлось прекратить.

Роботы-сферы смогут

найти применение и

на Земле. Например,

их можно было бы

сбрасывать с самолетов для изучения

труднодоступных

территорий. Кроме

того, такие роботы

помогли бы при обследовании трубопроводов, пещер

и туннелей.

Источник: 3D Systems

НАСА готовится исследовать планеты,

сбрасывая на них роботы-колобки

Hershey и 3D Systems приступают к разработке 3D-принтеров для «печати» пищевых продуктов — шоколадных и других

изделий. На выставке потребительской

электроники CES компания 3D Systems

уже продемонстрировала два подобных

принтера для создания кондитерских изделий, в том числе шоколадных. Первый

из них, под названием ChefJet, предполагается продавать по цене около 5 тыс.

долл., а второй, более мощный ChefJet Pro,

будет стоить около 10 тыс. долл. ChefJet

способен изготавливать объекты с максимальным размером 8х8х6 дюймов, а

ChefJet Pro — 10х14х8 дюймов. Оба принтера могут печатать съедобными материалами со вкусом шоколада, ванили,

мяты, яблока, вишни и арбуза.

колонка редактора

В поисках сокровищ

Б

ольшие Данные меняют жизнь общества — все больше государств,

компаний и отдельных людей устремляются на поиски сокровищ в виде

плодотворных идей, фактов или тенденций,

ранее скрытых в ворохе больших массивов разнообразных данных. Однако данные раскрывают свои секреты лишь тем,

кто готов «слушать» и вооружен необходимыми инструментами, позволяющими

обнаружить неочевидные корреляции и

охватить все имеющиеся массивы. Вместе

с тем облака и Большие Данные выявили

неподготовленность современной индустрии ИТ к работе с невиданными прежде

объемами информации, львиная доля которой хранится в реляционных СУБД, что,

по сути, оставляет, например, за бортом

анализа неструктурированные данные. За

пределами хорошо поддающихся изучению структурированных хранилищ оказываются целые «залежи» данных из малоинтересных, на первый взгляд, или вовсе

необработанных сведений, без вскрытия

которых сокровищ не найти.

Господствовавшая до сих пор идея сведения всего разнообразия данных только

к таблицам морально устарела, однако это

лишь часть проблемы — Большие Данные,

как пишет Леонид Черняк в этом номере

журнала, посвященном инструментам обработки больших массивов информации в

реальном времени, придали цивилизации

новое качество на культурном, научном

и технологическом уровнях. Так, например, родилось понятие электронной науки, основная задача которой — поставить

вопрос «что искать», а не «как», позволив

данным самим говорить за себя: скажем,

по накоплению признаков или по отклонениям буквально «на лету» обнаружить

новую тенденцию, неисправность узла

или зарождение очага социальной напряженности. Сегодня уже недостаточно

довольствоваться выборками из массива

данных, на чем построены многие разделы

традиционной науки, а требуется анализировать все в комплексе — нюансы, как

известно, часто скрываются в деталях,

которые при изучении только выборок

можно упустить.

Технологический уровень предполагает

переориентацию ИТ от поддержки счетных задач на обеспечение процедур сбора,

хранения и обработки больших наборов

данных с одновременным выполнением

аналитических преобразований. Однако

существующие инфраструктуры и инструментальные средства, которые сегодня пытаются применять для обработки Больших

Данных, оказались перед необходимостью

удовлетворения противоречивым требованиям: узкой специализации при решении

конкретных задач, тесной интеграции в

системном стеке, максимальной энергоэффективности и масштабируемости, высокой производительности и надежности,

безопасности и доступности.

Как отмечают авторы этого номера, у

индустрии пока нет целостной программы создания инструментария, адекватного проблеме Больших Данных, хотя

отдельные производители и предлагают

свои концепции, осознав, что MapReduce/

Hadoop — это далеко не единственная технология. Имеющиеся сегодня продукты

от различных стартапов носят фрагментарный характер — на рынке все еще нет

полноценных решений для обработки

огромных массивов неструктурированных данных различной природы, поступающих в режиме реального времени из

многочисленных источников. В перечень

ключевых технологий Больших Данных, по

мнению аналитиков, входят: поколоночные

СУБД и СУБД класса NoSQL; MapReduce/

Hadoop; Hive — средства выполнения традиционных приложений бизнес-аналитики на кластерах Hadoop; PIG — средства,

приближающие Hadoop к разработчикам

и бизнес-пользователям; WibiData — вебаналитика и Hadoop; PLATFORA — платформа автоматического формирования

заданий к Hadoop; системы хранения;

высокопроизводительные аналитические

обучающиеся платформы типа SkyTree.

Однако, по мнению Дмитрия Семынина,

эти и другие технологии хотя уже и вышли

из юношества, но еще не повзрослели, а

стек решений для Больших Данных, что

бы ни заявляли ведущие игроки рынка ИТ,

представляет собой аморфное — правда,

динамичное — образование. Современный

стек технологий Больших Данных — это

некий инкубатор, из которого впоследствии выйдут специализированные приложения, ориентированные на работу с

большими базами данных, аналитику реального времени, обработку разнородной

информации, обеспечение непротиворечивости используемых данных.

На новый ракурс Больших Данных указывает в своей статье Наталья Дубова, которая отмечает, что аналитика огромных

массивов разнообразных сведений и телеметрии нужна сегодня не только финансистам, биоинформатикам и маркетологам,

но и ИТ-специалистам. Существующие

инструменты управления не позволяют

оценить эффективность применения ИТ,

предсказать динамику изменения производительности, а главное — современный

уровень сложности ИТ-сред уже не оставляет места ручному управлению. Конечно,

сотрудники ИТ-служб и ИТ-менеджеры и

раньше решали аналитические задачи для

оптимизации управления инфраструктурой и сервисами, однако теперь требуется

новое поколение средств, позволяющих

справиться с обработкой постоянно растущих объемов разнородных и изменчивых данных, поступающих из всех доменов

инфраструктуры для построения точной

картины ее состояния.

Процесс качественного изменения запускается только после достижения требуемого потенциала — вода закипает лишь

при определенных условиях, и нельзя нагреть ее чуть-чуть, чтобы получить каплю

пара. Нельзя обработать часть Больших

Данных и ожидать, что откроются ворота к информационным сокровищам.

Неспособность существующих ИТ-систем

быстро обрабатывать большие объемы

разнообразных данных из различных источников подтолкнула индустрию к тому,

чтобы всерьез озаботиться созданием необходимого инструментария — аналитики

предсказывают ежегодный 30-процентный

рост рынка таких технологий, что в семь

раз опережает развитие всего рынка ИКТ.

Эпоха малых данных закончилась — будущее за Большими Данными и соответствующими им технологиями.

Дмитрий Волков

www.osmag.ru • 01/2014 • Открытые системы • 1

ОТКРЫТЫЕ СИСТЕМЫ. СУБД

Главный редактор

Дмитрий Волков, с.н.с., ИПМ РАН

Научные редакторы

Наталья Дубова, Леонид Черняк

Редакционный совет:

Валерий Аджиев, к.т.н., с.н.с., Университет Борнмута

(Великобритания);

Михаил Горбунов-Посадов, д.физ.-мат.н.,

доцент ВМК МГУ;

Сергей Кузнецов, д.физ.-мат.н., профессор МГУ;

Михаил Кузьминский, к.хим.н., с.н.с., ИОХ РАН;

Павел Храмцов, к.т.н., доцент, Национальный

исследовательский ядерный университет «МИФИ»;

Игорь Федоров, к.т.н., профессор МЭСИ;

Виктор Шнитман, д.т.н., профессор МФТИ;

Леонид Эйсымонт, к.физ.-мат.н.,

научный консультант, НИИ «Квант».

Корректор Ирина Карпушина

Верстка и графика Мария Рыжкова

Фотографии и дизайн обложки Игорь Лапшин

Адрес редакции:

Россия, 127254, Москва, ул. Руставели, д. 12а, стр. 2

Адрес для корреспонденции:

127254, Москва, а/я 42

Телефоны:

(495) 725-4780 (издательство),

(495) 619-1372 (редакция),

(495) 725-4785 (распространение, подписка)

Факс: (495) 725-4788

E-mail: osmag@osp.ru

Подписной индекс:

99482 — Каталог российской прессы «Почта России» МАП

72773 — Объединенный каталог «Пресса России» АПР

59869 — «Каталог. Издания органов научно-технической

информации»

Реклама

ООО «Рекламное агентство «Чемпионс» (499) 750-0467

Распространение

ООО «ОСП-Курьер» xpress@osp.ru

Содержание № 1 (197) 2014

Новости. факты. тенденции.

HP развивает решения DCIM

Watson коммерциализируется

AMD выпускает первый процессор ARM

IBM Connections: все в одном

Транзисторы на органике

Oracle вошла в число спонсоров OpenStack

EMC продвигается к «третьей вычислительной

платформе»

Шифрование оказалось ненадежным

VoltDB ускоряется в 50 раз

В Microsoft устроили конкурс по поиску простых

чисел

В Facebook открывают лабораторию искусственного

интеллекта

Флэш-хранилище для Больших Данных

Суперкомпьютеры ускорят квантовыми

вычислителями

платформы

10Все в одном: микропроцессор Kaveri

Леонид Черняк

Для получения преимуществ на современном

рынке микропроцессоров производители значительное внимание уделяют универсальности своих изделий, наделяя их возможностями

самоопределения.

инструменты больших данных

12Серьезно о технологиях

для Больших Данных

Леонид Черняк

Большие Данные и облака выявили неподготовленность индустрии ИТ к работе с невиданными прежде объемами информации,

львиная доля которой хранится в реляционных

СУБД. Вместе с тем на рынке нет полноценных

решений для обработки огромных массивов

неструктурированных данных различной природы, поступающих в режиме реального времени из многочисленных источников.

16Большие Данные для управления ИТ

Наталья Дубова

Аналитика Больших Данных становится необходима ИТ-менеджерам — существующие

инструменты управления ИТ не позволяют

оценить эффективность своего применения,

предсказать динамику изменения производительности, а главное — современный уровень

сложности ИТ-сред уже не оставляет места

ручному управлению.

20Большие Данные в руках брокера

©

2014 Издательство «Открытые системы»

Журнал зарегистрирован

в Министерстве РФ по делам печати,

телерадиовещания и средств массовых коммуникаций

04.11.1999

Свидетельство ПИ №77-1051

Журнал выходит 10 раз в год

Цена свободная

Учредитель и издатель:

Олег Болгарчук

Системы алгоритмической торговли широко

используются финансовыми организациями

для автоматизированного выставления биржевых заявок — анализ больших объемов

разнообразных данных позволяет получать

устойчивую прибыль путем выявления незначительных колебаний курсов.

программная инженерия

23Тестирование эластичных

компьютерных систем

ЗАО «Издательство «Открытые системы»

123056, Москва, Электрический пер., д. 8, стр. 3.

Алессио Гамби, Валдемар Хуммер, Хон

Линь Чыонг, Шахрам Дустдар

Президент Михаил Борисов

Генеральный директор Галина Герасина

Директор ИТ-направления Павел Христов

Коммерческий директор Татьяна Филина

Появившись вместе с облаками, эластичные

компьютерные системы привлекают сегодня

все больше внимания — они могут «сжиматься» и «растягиваться» в зависимости от рабочей нагрузки. Однако до сих пор неясно, как

тестировать эластичные системы и каковы

дальнейшие направления их развития.

Все права защищены.

При ис­поль­зо­ва­нии ма­те­ри­а­лов

не­об­хо­ди­мо раз­ре­ше­ние ре­дак­ции и ав­то­ров.

В номере использованы иллюстрации

и фотографии: ЗАО «Издательство «Открытые

системы» и IEEE Computer Society.

12+

Отпечатано в ООО «Богородский

полиграфический комбинат»

142400, Московская область,

г. Ногинск,

ул. Индустриальная, д. 40б

(495) 783-9366, (49651) 73179

Тираж 10 000 экз.

приложения

28Мониторинг рекламных роликов

Константин Селезнев, Максим Ефремов,

Вадим Мельников

Создание средств обработки видеоинформации традиционно считается сложной проблемой, которая под силу лишь крупным

производителям ПО, однако в ряде случаев

решение может быть достаточно простым —

например, при мониторинге показов рекламных видеороликов.

безопасность

30Защита критически важных

систем управления

Кристина Алкарас, Шерали Зидалли

Бесперебойная работа таких критически важных инфраструктур, как системы энергоснабжения, обеспечения водой или продуктами

питания, — задача государственной важности. Какие сегодня имеются архитектуры автоматизированных систем управления, в чем

состоят угрозы, где уязвимые места и как защищать такие инфраструктуры?

Интеграция

36Интеграция для Airbus

Никита Калуцкий

Авиастроительная отрасль — одна из наиболее

конкурентных, особенно в нише пассажирских

узкофюзеляжных лайнеров, однако развитие здесь

в ряде случаев сдерживается необходимостью

работы с унаследованными информационными

системами поддержки моделей самолетов, появившимися десятилетия назад.

стандарты

39Первоклассные объекты

Всемирной паутины

Паоло Чиккарезе, Стиэн Сойленд-Рейес,

Тим Кларк

До недавнего времени в WWW не было единой

модели аннотаций, независимой от контента, что затрудняло возможность их переноса

между системами и предметными областями.

Но сегодня спецификация Open Annotation

Data Model консорциума W3C кардинально

меняет принципы подготовки и распространения аннотаций.

мнение

42Стек для Больших Данных

Дмитрий Семынин

Все сегодня говорят о Больших Данных, но

мало кто знает, как с ними работать. Похоже,

что соответствующие технологии уже вышли

из юношества, но еще не повзрослели.

музей ос

44Закон Меткалфа сорок лет спустя

после рождения Ethernet

Боб Меткалф

Согласно закону Меткалфа, полезность сети пропорциональна квадрату числа ее пользователей.

Правда, критики уверены, что это преувеличение,

однако на реальных данных закон раньше никто не

проверял. Изобретатель Ethernet и автор закона

сам предпринял попытку сделать это.

экстремальные технологии

48Инструменты для «ковбоев»

Леонид Черняк

«Выпас данных» — так можно перевести название новой специальности data wrangling, в

задачу представителей которой входит подготовка больших массивов данных для их последующего анализа.

академия ОС. семинар

51Системы автоматической

обработки текстов

Дмитрий Ильвовский, Екатерина Черняк

Многообразие систем автоматической обработки неструктурированных текстов сегодня

вызывает необходимость их систематизации

и классификации с целью упрощения выбора решения, наиболее адекватного для конкретной задачи.

академия ОС. Библиотека

54Сила в простоте

Сергей Кузнецов

Тема ноябрьского номера журнала Computer

(IEEE Computer Society, V. 46, No 11, 2013) —

простота в информационных технологиях.

новости. факты. тенденции.

Открытые системы

сегодня

Компания Hewlett-Packard представила набор сервисов, призванных помочь организациям повысить эффективность управления своими ЦОД на основе принципов DCIM (Data Center

Infrastructure Management). Появление решений DCIM обусловлено ростом стоимости энергии и упрощением перемещения рабочей нагрузки за счет технологий виртуализации.

Исторически сложилось так, что управление вспомогательным оборудованием ЦОД осуществлялось без привязки к ИТоборудованию. Объединение данных, относящихся к этим независимым друг от друга операциям, позволит получить более

целостную картину затрат на функционирование ЦОД и поможет находить пути экономии за счет консолидации и перераспределения ресурсов.

В новых сервисах HP обобщен опыт управления инфраструктурой ЦОД c помощью системы Converged Management Framework.

Сервис HP Converged Management Workshop должен разъяснять сотрудникам ИТ-подразделения, обслуживающему и

операционному персоналу порядок использования технологий, сценариев и решений DCIM. Второе решение, Converged

Management Roadmap Service, будет анализировать операции

ИТ-департамента и обслуживающих подразделений и выявлять

области, которые можно подвергнуть перестройке в целях повышения эффективности. Если организация принимает решение о

переходе к концепции DCIM, то продукт Converged Management

Design Service предоставит ей подробный план построения архитектуры ЦОД. И наконец, компонент Converged Management

Implementation Services поможет организации внедрить у себя

модель DCIM. Компания HP готова интегрировать все элементы и предоставлять программное обеспечение (например, HP

OneView) для управления операциями.

Как прогнозируют аналитики IDC, в 2014 году модель DCIM

получит достаточно широкое распространение среди операторов ЦОД.

4 • Открытые системы • 01/2014 • www.osmag.ru

Oracle представляет

новую версию Exadata

Компания Oracle представила пятую версию своего аппаратнопрограммного комплекса управления базами данных Exadata.

Утверждается, что во многих областях новые машины позволяют добиться двукратного увеличения производительности

по сравнению с системами предыдущего поколения. В сравнении с версией X-3, Exadata X-4 выполняет в единицу времени

на 77–100% больше операций

ввода-вывода; пропускная способность Infiniband выросла

почти в два раза; в два раза

увеличилась и емкость флэшпамяти. Размер логического

буфера при заполнении всей

стойки увеличился с 44 до

88 Тбайт. Заметно возросли

производительность и емкость

дискового хранения. Теперь в

стойке X-4 при использовании

технологии сжатия Oracle можно хранить петабайты данных.

Благодаря увеличению буфера

флэш-памяти клиенты могут

держать большинство баз данных с оперативной обработкой

транзакций во флэш-памяти.

Таким образом, в одной стойке Exadata X-4 размещаются

сотни баз данных.

Обновленное программное

обеспечение Exadata сравнимо по своим возможностям

с СУБД Oracle 12c и 11gR2.

Источник: Oracle

HP развивает решения DCIM

новости. факты. тенденции.

четырех модулей памяти SODIMM, UDIMM или RDIMM. Что касается программного обеспечения, то в комплект войдет дистрибутив Fedora ARM Linux с драйверами устройств, веб-сервер

Apache, СУБД MySQL, языки PHP и Java 7 и 8, а также стандартный набор инструментов GNU для разработки приложений

Linux. Загрузка системы происходит в защищенном режиме с

помощью интерфейса UEFI.

В AMD уверены, что серверы на основе ее новых процессоров

подойдут для исполнения веб-приложений и управления системами хранения данных в дата-центрах.

Watson коммерциализируется

Новое подразделение корпорации IBM под названием Watson

Business Group займется разработкой облачных когнитивных

приложений и сервисов, ориентированных на корпоративных

пользователей. Первоначальные вложения в этот бизнес составят 1 млрд долл., 100 млн из которых пойдут на финансирование компаний-стартапов, разрабатывающих приложения для

облачной платформы Watson. В штат подразделения переводится около 2 тыс. сотрудников IBM.

Система Watson способна формулировать ответы на вопросы,

поставленные на естественном языке, используя обширную базу

знаний и обучаясь в процессе работы. В 2011 году суперкомпьютер с системой Watson победил в телевикторине Jeopardy, и с тех

пор IBM с переменным успехом пытается коммерциализировать

эту технологию. Компания запустила облачные сервисы на базе

Watson для решения различных проблем в бизнесе и в медицине, а в прошлом году открыла платформу Watson Ecosystem

для создания когнитивных приложений независимыми разработчиками. В подразделении Watson Business Group будут организованы лаборатории для изучения и испытания клиентами

когнитивных систем. Кроме того, будут проводиться различные

семинары и обучающие курсы.

AMD выпускает первый процессор ARM

Компания AMD объявила о планах начать в ближайшие месяцы

поставлять партнерам 64-разрядные процессоры архитектуры

ARM и соответствующие комплекты разработчика. Серия процессоров ARM компании будет носить название Opteron A1100,

а выпускаться они будут по технологии 28 нм. Образцы этих

чипов, под кодовым именем Seattle, партнеры AMD получат в

марте или апреле. Вместе с ними будут поставляться комплекты разработки, состоящие из системной платы и набора инструментов программирования.

Чипы серии Opteron A1100 будут базироваться на ядре ARM

Cortex A57. Процессоры будут иметь 4 Мбайт совместно используемого кэша второго уровня, а также 8 Мбайт кэша третьего

уровня и два канала памяти с поддержкой DDR3 и DDR4 и кодом

коррекции ошибок, обеспечивающие до 1855 млн пересылок в

секунду. Чипы будут выполнены в виде системы на кристалле,

поддерживающей сопроцессоры для шифрования и компрессии данных, а также восемь каналов PCI-Express Generation 3,

столько же портов Serial ATA 3, два порта Gigabit Ethernet и до

Компания «Аскон» представила мобильное приложение

«Компас:24», позволяющее просматривать созданные в системе «Компас-3D» модели на мобильных устройствах на платформе Android. С помощью приложения пользователь сможет

продемонстрировать свои разработки партнерам или коллегам, просмотреть 3D-модели, присланные по почте, обучать

сотрудников на наглядных примерах — и все это без привязки

к рабочему месту. А используя функцию динамического сечения, которая появится в новой версии «Компас-3D V15», прямо

в мобильном приложении можно будет посмотреть, что находится внутри разработанного узла или детали. Доступны следующие функции: вращение, масштабирование и панорамирование изображения; отображение информации о файле (автор,

комментарий); динамическое сечение плоскостью. В компании

надеются, что «Компас:24» станет полезным инструментом и для

инженера, который сможет без компьютера продемонстрировать свою модель на совещании и показать варианты решений,

проработанных в «Компас-3D», и для руководителя, который,

пользуясь планшетом с установленным приложением, будет

оперативно принимать решения вне зависимости от того, где

он находится в данный момент.

«Компас:24» станет первым мобильным приложением, созданным компанией специально для решения профессиональных задач конструктора, и дополнит линейку мобильных разработок

«Аскон». В 2012 году «Аскон» впервые вышел на рынок мобильных приложений с клиентом «Лоцман:24», который позволяет

специалистам сферы строительного проектирования удаленно и

в режиме онлайн вести мониторинг дел по проектам и согласовывать документы. Следующим шагом стал выпуск приложения

для проектирования внешнего облика изделия SubDivFormer,

которое может использоваться как для инженерных разработок,

так и для детских игр. А осенью 2013 года в App Store и Google

Play появилось первое игровое приложение компании — мобильный 3D-конструктор Machinator.

Google Play

Источник: IBM

3D-модели на мобильном

www.osmag.ru • 01/2014 • Открытые системы • 5

новости. факты. тенденции.

IBM Connections: все в одном

IBM перенесет в пакет Connections, состав которого до этого ограничивался средствами организации корпоративных социальных сетей, платформу электронной почты Notes/Domino, систему

аудио/видеосвязи, мгновенного обмена сообщениями и организации веб-конференций Sametime, а также набор офисных онлайн-приложений Docs. Все эти продукты будут в нынешнем году

обновлены и выпущены под брендом Connections. Платформа

корпоративных социальных сетей IBM позволяет создавать профили, блоги, вики, форумы и т. д. Как уточняют в IBM, продукты,

переносимые в пакет, уже интегрированы и взаимодействуют

с ней и друг с другом, а цель ребрендинга — подчеркнуть это.

Кроме того, корпорация сможет демонстрировать потенциальным заказчикам свою альтернативу сервисам Microsoft Office

365 и Google Apps. Приобрести пакет можно будет целиком или

частично. За отдельную плату будут предлагаться дополнения

для руководства (governance), аналитики и помощи в соблюдении нормативных требований.

Вначале будут обновлены облачные версии приложений, позднее — и локальные. Сильнее всего будет переработан почтовый клиент Notes/iNotes — появятся, например, возможности

автоматической сортировки сообщений по приоритетности и

распознавания писем, содержащих еще не выполненные задания. Чтобы подчеркнуть масштаб обновления, клиент получит

название Mail Next.

Транзисторы на органике

Группа исследователей сообщила в Nature Communications о

разработке самых быстрых в мире органических тонкопленочных транзисторов. По оценкам ученых, по сравнению с кремниевыми такие транзисторы будут обходиться гораздо дешевле в производстве. Есть еще одно преимущество: органические

транзисторы могут быть почти прозрачными. До сих пор такие

элементы не могли сравниться с кремниевыми по быстродействию, но авторы публикации, ученые Стэнфорда и Университета

Небраска-Линкольн, заявляют, что добились серьезных успехов

в этой области: их органические транзисторы сопоставимы по

скорости переключения с кремниевыми.

Органические транзисторы изготавливаются путем капания углеродно-пластиковым раствором на быстро вращающуюся стеклянную пластину. Исследователи доработали этот процесс, ускорив вращение и ограничившись частичным покрытием пластины.

Благодаря этому, по их словам, удалось добиться более равномерного и плотного распределения молекул раствора, за счет чего в

полученных транзисторах выросла мобильность носителей тока.

Со временем данная технология позволит выпускать недорогую

прозрачную электронику, считают разработчики.

Директору по данным — быть!

Пост директора по данным (Chief Data Officer, CDO) к концу этого года будет существовать примерно в четверти крупных международных компаний, считает вице-президент аналитической

фирмы Gartner Дебра Логан. Директор по данным занимается

управлением данными в масштабах всей компании. По подсчетам Gartner, сейчас это звание носит около сотни менеджеров

крупных компаний — в два раза больше, чем в 2012 году. 65% из

них работают в американских компаниях, а 20% — в британских.

При этом доля женщин среди директоров по данным составляет

25%, что почти вдвое выше, чем среди директоров информационных служб (13%).

Как правило, пост директора по данным вводят компании, работающие в отраслях со строгим регулированием, прежде всего в

финансах и страховании, а также государственные учреждения.

Однако в 2013 году этот пост начал появляться и в компаниях

других отраслей. Аналитик отмечает назначение директоров по

данным в некоторых рекламных компаниях. Директорам информационных служб не следует рассматривать директоров по данным как конкурентов, подчеркивает аналитик. Они занимаются

управлением данными, что позволяет директору информационной службы сосредоточиться на своих основных задачах.

Oracle вошла в число спонсоров OpenStack

Компания Oracle приобрела статус корпоративного спонсора

организации OpenStack Foundation, занимающейся разработкой программной платформы с открытым исходным кодом для

создания инфраструктурных облачных сервисов. В Oracle рассчитывают использовать компоненты OpenStack в собственных

разработках — в том числе в операционных системах Solaris и

Oracle Linux, виртуализационных платформах Oracle VM и Oracle

Virtual Compute Appliance, инфраструктурных сервисах (IaaS) и

системах семейств S3 Series, Axiom и StorageTek. Кроме того,

Oracle планирует добиться совместимости OpenStack с сервером

приложений Exalogic Elastic Cloud и сервисами Oracle Compute

Cloud и Storage Cloud.

Несмотря на масштабные планы интеграции OpenStack, финансовый вклад компании Oracle в работу OpenStack Foundation невелик и составляет лишь 25 тыс. долл. в год. Компании HP, IBM,

Red Hat и другие, имеющие статус платиновых спонсоров, платят 500 тыс. долл. в год и выделяют для работы над OpenStack

на постоянной основе как минимум двух сотрудников. Тем не

менее участие Oracle в OpenStack весьма важно, отмечают аналитики, и прежде всего — для все еще значительной аудитории

пользователей системы Solaris.

Дожить до 2015-го

Источник: Jinsong Huang, Yongbo Yuan

Аналитик Gartner Вильям Маурер предсказывает начало масштабных процессов консолидации на рынке облачных сервисов. В ближайшие два года около четверти компаний из числа ста крупнейших

облачных провайдеров мира разорятся или будут куплены, заявил

он на конференции Gartner Data Center Conference. Клиентам облачных сервисов придется учитывать высокий риск исчезновения

их провайдера. Некоторые клиенты из-за этого могут предпочесть

работать с крупными компаниями, но мелкие провайдеры, возможно, предложат более выгодные условия и дополнительные гарантии. Впрочем, аналитик не советует клиентам оказывать слишком

6 • Открытые системы • 01/2014 • www.osmag.ru

новости. факты. тенденции.

большое давление на провайдеров. Клиенты сейчас заинтересованы в выживании их провайдера, указывает он.

Участники конференции разделили мнение аналитика о риске

облачных решений. Почти 50% из них в ответах на проведенный

опрос указали, что откажутся от перехода к облачным технологиями при высоком уровне риска, 33% — при среднем, а 12% —

даже при малом. Несмотря на это, в Gartner прогнозировали, что

к концу 2013 года 80% организаций будут в той или иной мере

использовать облачные сервисы.

Графеновые флэш-стикеры dataStickies

вместят до 32 Гбайт

В компании dataStickies объявили о разработке потребительских

флэш-накопителей нового типа: по толщине они такие же, как бумажные стикеры. Устанавливать такой накопитель в разъем USB

не понадобится: как и бумажные аналоги, графеновые «стикеры»

можно приклеить на монитор, и обмен данными будет происходить без проводов через проприетарный интерфейс под названием Optical Data Transfer Surface.

Комплект накопителей будет похож на упаковку обычных стикеров,

обещают в компании, а емкость флэшек dataStickies составит от

4 до 32 Гбайт. Сама флэш-память будет выполнена на одиночном

слое графена. В компании объясняют, что собираются предложить

флэш-стикеры в различных расцветках, чтобы каждый цвет можно

было использовать для своего типа данных. А еще на dataStickies

можно будет писать маркером, как на обычных стикерах.

EMC продвигается

к «третьей вычислительной платформе»

Новую версию программного обеспечения управления ресурсами хранения данных EMC Storage Resource Management Suite

в корпорации EMC рассматривают как очередной шаг в реализации концепции «третьей платформы», объединяющей облачные и мобильные технологии, социальные сети и обработку

Больших Данных. Существующая сейчас на многих предприятиях инфраструктура была спроектирована для «второй платформы», клиент-серверной. Такие предприятия не располагают

ресурсами, необходимыми для перехода к «третьей платформе», считают в EMC.

В пакете SRM 3.0 реализован новый, более простой интерфейс

и новые средства анализа и визуализации для мультивендорных

сред хранения. Интеграция с программно-конфигурируемой

системой хранения данных ViPR дает возможность управления

с помощью одного пакета и традиционными, и программно-определяемыми средами. SRM 3.0 поддерживает также работу со

средствами анализа и оповещения для инфраструктуры резервного копирования и репликации EMC Data Protection Advisor в

масштабах всей инфраструктуры предприятия.

Стандарт или нестандарт?

Поискам ответов на этот вопрос была посвящена конференция

«Стандарт SAP: мифы и реальность», проведенная по инициативе ОАО «Сургутнефтегаз» при поддержке, в частности, компаний

SAP, HP, VMware, Inline Group, а также издательства «Открытые

системы». Безусловно, без стандартов не было бы вообще индустрии ПО, основанной на повторной применимости программ, помогающих различным пользователям вести бизнес, однако вряд

ли стоит считать нормальной ситуацию, когда только 4% исходного функционала системы ERP оказывается стандартным и может быть использовано как есть, а остальное приходится дорабатывать. «По мнению ряда крупнейших заказчиков SAP, включая и

“Сургутнефтегаз”, основная проблема — это необходимость в большом объеме дополнительного программирования», — считает Ринат

Гимранов, начальник управления ИТ компании «Сургутнефтегаз»,

уже 20 лет использующей системы от SAP.

Данная ситуация случайна или закономерна? Где водораздел между стандартом и нестандартом? В идеале все ПО должно применяться стандартно, а если возникает необходимость

в доработках, то как измерить их объем? Многолетний опыт

«Сургутнефтегаза» свидетельствует о том, что нестандарт идет

от версии к версии, причем в постоянной пропорции — лишь

30% кода можно использовать без доработок.

Без сложной системы управления бизнес «Сургутнефтегаза»

невозможен — сегодня в компании работают 29 продуктивных

систем от SAP, обрабатывающих 8 Тбайт данных, доступ к которым имеют 28 тыс. пользователей, однако, как было показано на конференции, во всех бизнес-процессах требовалась

модификация стандартных решений. В аналитических задачах

доля стандартных решений составила только 4%, а остальное —

собственные разработки специалистов «Сургутнефтегаза», выполненные, в частности, на инструментарии SAP. Аналогичная

ситуация, судя по докладам, складывается и у других крупных

заказчиков — в частности, в компании «Башнефть», представитель которой отметил, что доработки от поставщика ПО обычно

приходят с опозданием и не в полном объеме, поэтому предприятия вынуждены держать собственный штат программистов, соизмеримый с численностью сотрудников средней компании, занимающейся разработкой ПО.

Комментируя замечания, представители SAP отметили,

что бизнес компании все-таки состоит в поставке стандартного ПО, однако в ближайшее время планируется сделать акцент на развитии инструментария, упрощающего заказчикам

локализацию решений, и основной платформой разработки

будет HANA. Парируя критику заказчиков, Андрей Трегубов,

представитель SAP Labs, отметил, что в России 150 человек

занимаются локализацией продуктов, однако, по наблюдениям SAP, средний отечественный клиент не знает о функциональности, за которую он уже заплатил. В этой ситуации

требуется найти баланс между стандартом и собственными

разработками заказчиков, учитывающими, в частности, особенности динамичного российского законодательства. Кроме

этого, Трегубов обратил внимание на то, что не всегда ясно,

кто должен раскрывать функционал продуктов: сам заказчик,

интегратор или поставщик. Тем не менее он отметил, что в

компании ведется работа по гармонизации взаимодействия

партнеров и поставщика, особенно в вопросах включения в

стандарт новой функциональности — требуется встречное

движение производителя и заказчика.

www.osmag.ru • 01/2014 • Открытые системы • 7

новости. факты. тенденции.

ходом новой версии VoltDB сможет конкурировать с SAP HANA

и другими СУБД, работающими в памяти, которые рассчитаны

как на транзакционные, так и на аналитические задачи.

Источник: Bryce Vickmark

Бизнес-аналитика

остается в центре внимания

Шифрование оказалось ненадежным

Мариэль Медар и ее коллеги из Массачусетского технологического

института и Национального университета Ирландии опубликовали

доклад, показывающий, что при анализе надежности алгоритмов

шифрования опираться на определение информационной энтропии по Клоду Шеннону, как это принято, неверно. При таком

анализе принимается, что в исходных файлах информационная

энтропия максимально возможная, что, по мнению исследователей из МТИ, допустимо для коммуникационного трафика, при

большом объеме которого распределение битов действительно

приближается к равномерному. Но в криптографии важнее всего

не средний случай, а крайние, подчеркивают ученые: взломщику достаточно лишь одной надежной корреляции между исходным текстом и шифром, чтобы начать обнаруживать остальные

корреляции. Следствие — если заставить компьютер искать корреляции простым перебором, он добьется успеха гораздо быстрее, чем ранее считалось. Взлом шифра все еще будет задачей

колоссальной сложности, подчеркивают исследователи, но, например, в ходе атаки, которая полагается на встречаемость букв

в английских словах, выбранный пользователем пароль можно

угадать существенно скорее, чем предполагалось.

Опираясь на свои выводы, авторы подготовили второй доклад,

в котором они показывают, как можно «вычислить» пароль, перехваченный путем прослушки беспроводного канала связи

между смарт-картой и карт-ридером, когда из-за помех часть

символов перехватить не удалось.

VoltDB ускоряется в 50 раз

Выпуская новую версию своей СУБД, в компании VoltDB надеются добиться более широкого признания на быстрорастущем рынке баз данных, работающих в оперативной памяти. Как

подчеркивают в компании, в VoltDB 4.0 радикально увеличена

скорость обработки аналитических запросов: некоторые из них

выполняются в 50 раз быстрее, чем раньше. Кроме того, теперь

стало проще добавлять новые узлы к работающим кластерам,

причем процесс расширения в большинстве случаев не оказывает влияния на производительность выполнения рабочей задачи, утверждают в компании.

Компания VoltDB была основана профессором Майклом

Стоунбрейкером, создателем Ingres и Postgres. Его новая СУБД

предлагается также в бесплатной версии без некоторых функций, имеющихся в коммерческой. Среди особенностей VoltDB —

автоматическое создание мгновенных снимков базы на диске

на случай необходимости восстановления системы и механизм

дублирования разделов баз K-safety, благодаря которому СУБД

продолжает работу после отказа одного из узлов кластера. С вы-

8 • Открытые системы • 01/2014 • www.osmag.ru

Вплоть до 2017 года руководители информационных служб сохранят высокий интерес к средствам анализа и бизнес-аналитики. В Gartner выделяют несколько основных тенденций развития рынка в ближайшие годы.

Уже к 2015 году для большинства разработчиков средств бизнес-аналитики основным направлением станет не составление

отчетов, а анализ данных с целью получения новой информации.

Сейчас непосредственным доступом к средствам аналитики обладают менее трети сотрудников, но эта доля будет расти. К 2017

году больше половины аналитических средств будут использовать потоки данных, генерируемые оснащенными датчиками

машинами, приложениями или сотрудниками. Аналитические

приложения, предлагаемые разработчиками программного

обеспечения, перестанут отличаться от приложений, предлагаемых сервис-провайдерами. Почти для любого «коробочного»

приложения можно будет найти аналог на базе SaaS.

Несмотря на большой интерес к средствам аналитики, вложения в эту область вплоть до 2016 года будут ограничиваться из-за неясности ситуации с обработкой Больших Данных.

Коммерческие компании пока не уверены, приносят ли эти технологии ощутимую выгоду.

В Microsoft устроили конкурс

по поиску простых чисел

Подразделение Microsoft

Windows Azure выступило в

роли устроителя конкурса

Prime Challenge по поиску

новых простых чисел, принять участие в котором могут как частные лица, так и

организации.

Самое большое из известных

на сегодня простых чисел состоит из 17 млн цифр. Задача

поиска новых простых чисел

становится все сложнее, но решение ее под силу любому, полагают в Microsoft. В первом десятке сразу четыре простых числа,

но чем дальше, тем их становится меньше, отмечают в корпорации. И пока никто не пытался найти их все. Участникам конкурса предоставляется возможность для поиска простых чисел

воспользоваться вычислительными мощностями дата-центров

Microsoft. Конкурс будет проходить до 29 марта 2014 года.

Количество

программистов-любителей растет

Из 18,5 млн разработчиков программного обеспечения в мире

примерно для 7,5 млн программирование не является основной

работой, утверждают аналитики IDC. Количество программистов-любителей растет гораздо быстрее, чем профессиональных

программистов, и, вероятно, темпы роста еще ускорятся.

Любителями программирования считают людей, занимающихся разработкой программ как минимум по 10 часов в месяц, несмотря на то что основной доход они получают от другой работы.

Некоторые из них занимаются программированием в качестве

новости. факты. тенденции.

хобби, другие же пытаются или заработать на продаже приложений, или участвуют в проектах с открытым кодом, или, наконец, пишут программы для автоматизации собственной основной работы. ИТ-компаниям и другим организациям, ведущим

бизнес через Интернет, не следует упускать из виду этих людей,

подчеркивают аналитики. Программисты-любители часто лучше разбираются в новых технологиях, и среди них можно найти подходящих кандидатов на постоянную работу. В странах с

развитым технологическим сектором доля любителей среди

разработчиков меньше как раз из-за того, что многие из них со

временем пополняют ряды профессиональных разработчиков,

отмечают аналитики IDC.

изобретение прокладывает путь к повышению защищенности

облачных сервисов, позволяя работать с зашифрованными данными без раскрытия оригинала. Методика, как поясняют в IBM,

«позволяет создавать зашифрованные большие двоичные объекты, которые можно комбинировать и обрабатывать, получая

результаты, идентичные тем, которые были бы без шифрования». В корпорации добавляют, что испытания практического

применения методики еще не окончены.

На протяжении уже двадцати лет подряд IBM становится лидером по числу американских патентов, полученных за год.

В Facebook открывают лабораторию

искусственного интеллекта

Руководителем лаборатории искусственного интеллекта, организуемой в компании Facebook, назначен специалист по машинному обучению из Нью-Йоркского университета Ян ЛеКун.

Он широко известен работами в области глубокого обучения и

машинного распознавания образов. О назначении ЛеКуна рассказал на конференции по глубокому обучению NIPS Deep Learning

Workshop генеральный директор Facebook Марк Цукерберг. Один

из учеников ЛеКуна, бывший сотрудник Google Марк-Аврелио

Ранзато, тоже приглашен на работу в лабораторию.

Подразделения новой лаборатории будут располагаться в НьюЙорке, Лондоне и в штаб-квартире Facebook в Менло-Парке в

Калифорнии. Основной темой исследований будет машинное

обучение — поиски методов, позволяющих обучить компьютеры извлекать полезную информацию из Больших Данных.

Искусственный интеллект поможет выявить оптимальные способы представления рекламы, взаимодействия с пользователями, определить факторы, привлекающие их к определенным

областям сайта и заставляющие их переходить из одной области в другую.

Флэш-хранилище для Больших Данных

Группа исследователей из Массачусетского технологического

института готовит к демонстрации сетевую систему хранения

Больших Данных на флэш-памяти, обещающую более высокую

скорость произвольного доступа, чем традиционные системы

на основе жестких дисков, соединенных сетью Ethernet.

Система получила название Blue Database Machine. По словам

разработчиков, она состоит из флэш-накопителей, которые управляются объединенными в сеть контроллерами на программируемых логических матрицах. Эти контроллеры также можно

использовать в качестве ускорителей, помогающих приложениям решать вычислительные задачи. Время случайного доступа к

данным на BlueDBM, исчисляемое десятками микросекунд, в отдельных случаях вдвое с лишним короче, чем у сред на жестких

дисках. По словам ученых, их система фактически обещает возможность создания интерактивных баз данных: при достаточном

количестве узлов в сети BlueDBM можно будет анализировать огромные объемы научных данных на такой высокой скорости, что

создастся впечатление мгновенной реакции на запросы.

Запатентован метод полностью

гомоморфного шифрования

В IBM сообщили о получении корпорацией патента на изобретение метода шифрования данных, являющегося полностью гомоморфным, то есть позволяющим свободно выполнять обработку информации без расшифровки. Как полагают в IBM, данное

Суперкомпьютеры ускорят квантовыми

вычислителями

Разработчик квантовых вычислительных систем компания

D-Wave рассчитывает, что ее передовая технология — какие бы

сомнения она ни вызывала в отрасли — найдет применение на

рынке высокопроизводительных вычислений (High Performance

Computing, HPC). По мнению специалистов D-Wave, квантовый

процессор — своего рода гигантский процессор для крупных

высокопроизводительных систем, выделяемый для решения

определенных задач, на обработку которых традиционными

вычислительными средствами может уйти много времени. В

компании назвали такой подход «квантовое ускорение высокопроизводительных вычислений».

Несмотря на то что теоретическая база квантовых вычислений

разрабатывается уже несколько десятилетий, эта технология

еще очень далека от коммерческого использования. D-Wave,

возможно, единственная компания, предлагающая завершенные решения, которые опираются на базовые принципы квантовой механики, изучающей законы поведения материи на микроскопическом уровне. D-Wave пока не предлагает квантовые

компьютеры общего назначения, вместо этого она располагает

системой, которую в компании называют квантовой нормализацией. Эта система рассчитана на обработку одного набора

задач, сложных для решения на классических компьютерах, известных как NP-сложные задачи (класс комбинаторных задач с

нелинейной полиномиальной оценкой числа итераций). Их суть

заключается в поиске наилучшего решения из значительного

числа переменных и, следовательно, возможных решений.

Компания D-Wave основана в 1999 году, в 2011 году она выпустила свое первое вычислительное устройство мощностью 128

кубитов. Кубит, или квантовый бит, — эквивалент бита в квантовых вычислениях. Сейчас компания предлагает устройство

D-Wave 2, его мощность составляет 512 кубитов. D-Wave 2 приобрели компания Google, которая тестирует возможность применения этой системы для распознавания образов, и НАСА.

www.osmag.ru • 01/2014 • Открытые системы • 9

платформы

Все в одном:

микропроцессор Kaveri

Для получения преимуществ на современном рынке микропроцессоров производители значительное внимание уделяют универсальности своих изделий,

наделяя их возможностями самоопределения. Не стала исключением и компания AMD, гибридные микропроцессоры которой можно с равным успехом

использовать в игровых, мобильных и серверных приложениях.

Ключевые слова: гетерогенные архитектуры, общая память, многопоточные вычисления

Keywords: heterogeneous architectures, shared memory, multi-threaded computing, HSA, HSAIL

Леонид Черняк

Н

едавняя премьера микропроцессоров AMD Kaveri A10-7850K и A8-7600

была представлена как сенсация, хотя

их основные параметры были известны давно. Мало того, история их создания растянулась на семь с половиной лет, если вести

отсчет от момента покупки компании ATI,

второго на тот момент производителя GPU

и графических плат. Согласно объявленному тогда плану «Fusion» предполагалось к

2008 году создать первый кристалл от объединенной компании, однако потом срок

был перенесен на 2011 год, и вот, наконец,

в начале 2014 года микропроцессор вышел

на рынок под именем Kaveri. Впрочем, подобная задержка закономерна и лишь подтверждает профессионалам правило — на

создание подлинной новации требуется не

менее семи лет. А в том, что это именно так

и сегодня вместе с Kaveri компания AMD

делает шаг не меньший, чем в 2003 году,

когда был выпущен процессор Opteron [1]

с архитектурой amd64, более известной

под именем x86-64, сомнений нет. Именно

Kaveri вполне можно признать первым полноценным гибридным APU — ускоренным

(Accelerated) или настроенным на приложения (Application). Kaveri — пример синергии

нескольких современных технологических,

архитектурных и программных новаций, и

важно, что микропроцессор появился как

раз в тот момент, когда появляются приложения, способные полноценно использовать

все его преимущества.

Термин APU был предложен в 2006 году

для обозначения устройств, служащих для

специализированных применений, но вскоре его распространили на кристаллы, сочетающие в себе CPU и GPU. Появление этих

гибридов в некоторой степени напоминает историю с процессорами 8086 и 8067.

Сначала был классический центральный

процессор CPU, затем в дополнение к нему

появился FPU — отдельный сопроцессор,

ускоряющий выполнение математических

операций над числами в формате с плавающей точкой. В последующем они объединились путем создания общей системы команд, а FPU как отдельный класс устройств

исчезли, и на протяжении последующих

лет развернулась гонка, в которой Intel и

AMD попеременно предлагали свои усовершенствования в систему команд. Однако

история с объединением CPU и GPU в один

кристалл APU имеет свою специфику —

GPU не передает свои полномочия CPU,

и полного слияния двух систем команд

нет. В APU оба типа устройств упакованы

на одной подложке, но живут раздельно,

хотя и делят между собой одну площадь,

работают в паре, а качество APU определяется тем, насколько эффективно налажено взаимодействие. За несколько лет

APU прочно вошли в жизнь — девять из

десяти современных ноутбуков содержат

такие процессоры. Однако вопрос о том,

какой должна быть пропорция между CPU

и GPU, чтобы процессор можно было назвать «настоящим APU» (True APU), остается

открытым. Некоторые эксперты считают,

что это 50:50 от площади подложки, что

близко к параметрам Kaveri (47% площади занимают ядра GPU), а в процессорах с

микроархитектурой Sandy Bridge — 17%, в

Ivy Bridge — 27%, в Haswell — 31%.

Среди множества особенностей, отличающих Kaveri, можно назвать следующие:

гетерогенная системная архитектура HSA

(Heterogeneous System Architecture) [2];

архитектура ядра x86-64 CPU Steamroller,

Mantle — графический API низкого уровня

и архитектура TrueAudio. Таким образом,

Kaveri с равным успехом может быть использован и для работы с данными, и для

10 • Открытые системы • 01/2014 • www.osmag.ru

выполнения игровых и мультимедийных

приложений, требующих поддержки GPU.

Микропроцессор выпускается в разных

модификациях с минимальным потреблением 35 ватт для серверов и до 95 ватт

для игровых компьютеров. Архитектуры

HSA и Steamroller важны для всех приложений, а Mantle и TrueAudio — для игровых. Универсальность процессора Kaveri

является его несомненным достоинством,

особенно потому, что некоторые возможности, в частности HSA, не могут быть немедленно востребованы, а еще должны

дойти до уровня массового использования

сообществом разработчиков.

Основной функционал HSA обеспечивает гетерогенный единообразный доступ

к памяти hUMA (heterogeneous Uniform

Memory Access) и является главным инструментом для полноценной интеграции

CPU и GPU. Теоретически возможны несколько уровней интеграции: самый примитивный — обмен пакетами данных между процессами; посложнее — управляемое

операционной системой использование

общего пространства памяти; высший

уровень — физическое объединение пространства данных в единой памяти. Эту

последовательность развития интеграции

CPU и GPU компания AMD прошла на экспериментальных чипах APU первых поколений, самыми заметными среди которых были Llano и Trinity, а все начиналось

с простого физического совмещения CPU

и GPU на кристалле при сохранении тех же

самых способов обмена данными, которые

использовались в случае раздельного исполнения на разных «камнях». Затем были

применены более действенные приемы,

но и они оказались малоэффективными,

а компания понесла ощутимые убытки,

вызванные «провалом» в дорожной карте, когда из-за неправильной организации

платформы

работ образовалась задержка с выпуском

очередного изделия. Архитектурные решения были инкрементальными и более-менее

в пределах разумного. В архитектуре HSA

упор сделан на разделяемую на страницы

память, имеются общие указатели и когерентная двунаправленная модель памяти,

что облегчает обмен данными между CPU

и GPU при выполнении общих задач. При

такой организации CPU и GPU могут читать

и модифицировать одни и те же области

памяти без ожидания какого-либо воздействия, а значит — исключаются бутылочные

горла и минимизируются задержки.

Архитектура hUMA сравнима с более

ранними — еще в первых GPU для доступа к памяти применялся метод NUMA (Non

Uniform Memory Access), предполагающий

фрагментацию на независимые разделы,

когда у CPU и GPU имеются собственные

автономные области памяти. Такой упрощенный подход приводит к необходимости копирования больших объемов данных

из одной области в другую, дополнительным сложностям в программировании

через графический драйвер и менеджер

видеопамяти, трудностям при синхронизации и трансляции адресов. Переход

на UMA, в данном случае в реализации

hUMA, позволяет CPU и GPU обращаться

в одну общую память. Для этого в новые

процессоры заложен механизм, поддерживающий когерентность кэшей CPU и GPU

на аппаратном уровне. До появления этого механизма схема взаимодействия CPU

и GPU предполагала, что в случае необходимости CPU записывает нужные для

обработки данные в область памяти GPU,

где выполняется необходимая обработка,

и данные возвращаются обратно в память

CPU. Наличие hUMA позволяет CPU передавать в GPU только указатель на данные,

а не сами данные, а затем после обработки использовать эти данные.

Для поддержки взаимодействия двух

типов процессоров разработан механизм

гетерогенных очередей hQ (Heterogeneous

Queuing), минимизирующий задержки и

позволяющий в полной мере использовать

потенциал APU. В традиционной архитектуре master-slave, где CPU — «хозяин», а

GPU — «раб», все задачи, предназначенные

для выполнения в GPU, сначала направляются в CPU, а затем в GPU. В таком случае

CPU должен взаимодействовать с операционной системой, управляющей очередями. Получив задание, ОС передает его

драйверу, преобразующему это задание в

команды конкретной графической системы. Гетерогенное управление очередями

уравнивает положение CPU и GPU, заменяет

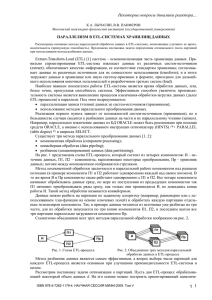

Архитектура master/slave

Архитектура с равенством CPU и GPU

Приложения

Приложения

Очередь

задач-приложений

Очередь

задач-приложений

Очередь

задач-приложений

Сервисы ОС

Драйвер

Очередь, управляемая ОС

CPU

GPU

CPU

GPU

От архитектуры master-slave к равенству процессоров

отношение master-slave — все процессоры

становятся равны (см. рисунок).

В новое ядро Steamroller x86-64 внесены усовершенствования, повышающие

эффективность CPU. Задействование при

проектировании библиотек высокой плотности — прием, заимствованный из проектирования GPU, — позволило на 30% повысить использование площади кристалла и

на столько же снизить энергопотребление.

Согласованность с GPU открывает возможность для сокращения потребления в тех

случаях, когда нагрузка преимущественно

графическая или вычислительная.

Графический интерфейс прикладного

программирования Mantle рассматривается

AMD в качестве более быстрой и приближенной к архитектуре GPU альтернативы

DirectX и OpenGL. К его преимуществам

относят эффективное управление аппаратурой, прямой доступ к памяти GPU и,

как следствие, повышенную по сравнению с DirectX и OpenGL скорость работы. Относительно TrueAudio предполагается, что эта технология окажет такое же

влияние на технологии воспроизведения

звука в игровых приложениях, как ранее

программы построения теней изменили

компьютерную графику.

Графическая архитектура Graphics Core

Next (GCN) Kaveri удовлетворяет не только

специфические игровые запросы, но и в наибольшей степени соответствует требованиям со стороны универсальных вычислений.

Устройство GCN GPU способно выполнять

вычислительные задачи, которые раньше

были доступны только CPU. Архитектура

GCN поддерживает такие языки, как C++

AMP (Accelerated Massive Parallelism) и

OpenCL, поддерживает разрешение UltraHD

(4K) и новые возможности постобработки

видео, улучшая качество изображения с

разрешением 1080 на мониторах, работающих в формате UltraHD.

Процессоры Kaveri производятся по

28-нанометровой технологии компанией

GlobalFoundries, частью акций которой вла-

деет AMD, передавшая GF свои производственные мощности. Теперь GF — один из

крупнейших контрактных производителей

микросхем, а сама AMD c 2012 года перешла в разряд компаний категории fabless,

ограничивающих свою деятельность проектированием и продажами микросхем.

Микропроцессор Kaveri содержит двухъядерные модули CPU Steamroller и GPU GCN

1.1, состоящие из восьми вычислительных

блоков по 512 графических ядер в каждом.

Процессор Kaveri A10-7850K работает на

частоте 3,7 ГГц в обычном режиме и на

3,8 ГГц — в режиме турбо, а GPU функционирует на частоте 720 МГц, что заметно

меньше, чем в предыдущих моделях от

AMD, хотя и может работать быстрее, но

общий лимит на энергопотребление этого

пока не позволяет.

Процессоры Kaveri уже получили доброжелательный отклик у сообщества разработчиков, ориентированных на OpenCL,

поскольку HSA обеспечивает поддержку и

ускорение выполнения всех существующих OpenCL-совместимых приложений.

Разработчики, отдающие предпочтение

Java, Fortran, OpenMP, C++ AMP и другим

средствам, могут воспользоваться непосредственно системой поддержки HSA и языком HSAIL — ассемблером для HSA.

Литература

1. Михаил Кузьминский. Многоядерные

процессоры AMD // Открытые системы.

СУБД. — 2005. — № 10. — С. 16–23.

URL: http://www.osp.ru/os/2005/10/380433

(дата обращения: 11.02.2014).

2. Тимур Палташев, Илья Перминов.

Гетерогенная архитектура для CPU, GPU

и DSP // Открытые системы.СУБД. —

2013. — № 08. — С. 12–15. URL:

http://www.osp.ru/os/2013/08/13037850

(дата обращения: 11.02.2014).

Леонид Черняк (osmag@osp.ru) — научный редактор, «Открытые системы.

СУБД» (Москва).

www.osmag.ru • 01/2014 • Открытые системы • 11

инструменты больших данных

Серьезно о технологиях

для Больших Данных

Большие Данные и облака выявили неподготовленность индустрии ИТ к

работе с невиданными прежде объемами информации, львиная доля которой хранится в реляционных СУБД, — господствовавшая до сих пор

идея сведения всего разнообразия данных к таблицам морально устарела.

Вместе с тем на рынке нет полноценных решений для обработки огромных массивов неструктурированных данных различной природы, поступающих в режиме реального времени из многочисленных источников.

Ключевые слова/keywords: ISTC-BD, CSAIL, MonetDB, ACID, SciDB

Леонид Черняк

С

ама по себе «проблема Больших

Данных» сопровождается рядом

собственных проблем, одна из которых заключается в том, что о Больших

Данных много говорят, но мало что реально делают. Спору нет, на глобальном

уровне проблема обработки больших

массивов данных объективно существует — человечество порождает все больше

контента, требующего переработки, однако действительно осязаемых достижений

на этом поприще пока немного. Отсюда

неоправданно большие ожидания и предвосхищения у одних наряду со скепсисом

у других и, как следствие, распространение недоверия к этой теме. В результате

термин «Большие Данные» оказался замылен раньше, чем понят.

Первые признаки обеспокоенности возможными негативными последствиями

неуправляемого роста объемов данных,

порождаемых мировой цивилизацией, и,

соответственно, проблемой извлечения заключенной в них информации стали проявляться еще с середины 40-х годов XX века.

Сегодня те объемы кажутся незначительными

на фоне непрерывного экспоненциального

роста на протяжении последних десятилетий, придавшего цивилизации совершенно

новое качество на культурном, научном и

технологическом уровнях.

Больше всего говорят о культурном уровне, который сводится к осознанию возможностей, открывающихся при извлечении новых знаний из накопленных данных, и, как

следствие, увеличению когнитивной способности человечества. Научный уровень

образован математическими методами

12 • Открытые системы • 01/2014 • www.osmag.ru

анализа данных, позволяющими совершать

открытия в астрономии, физике, химии и

других дисциплинах, образующие электронную науку (e-Science). Технологический

уровень предполагает переориентацию ИТ

со счетных задач как основного приложения

на сбор, хранение, обработку больших массивов данных с поддержкой тех или иных

аналитических методов.

До конца 90-х годов, когда средства работы с Большими Данными стали превращаться в инструмент для e-science, внимание общественности было сосредоточено

на осознании культурного феномена. Затем

внимание переключилось на переосмысление парадигмы e-science, после чего произошло знаменательное событие — объединение e-science и Big Data. Активное

развитие технологий, специально предназначенных для поддержки Больших Данных,

началось позже [1].

Такая последовательность развития трех

уровней, или феноменов Больших Данных,

по направлению от общих философских

воззрений к конкретным практическим

решениям стала причиной снисходительного отношения профессионалов от ИТ к

Большим Данным, акцентирующих свое

внимание лишь на технологиях и не учитывающих особенностей двух предшествующих феноменов. Успехи в сфере технологий

пока еще достаточно скромны, и интересные

решения имеются у небольших компаний,

а крупные, по законам рынка, поголовно

заявляют о готовности решать проблемы

Больших Данных уже давно имеющимися

в их распоряжении средствами.

От слов к делу

Сегодня все, что говорится на тему Больших

Данных, носит лишь фрагментарный ха-

инструменты больших данных

рактер — целостной программы решения

проблемы пока нет, причем даже на уровне

концепции, однако на этом фоне весьма ярко

обозначилась инициатива Intel. Программа

комплексного подхода предполагает создание крупного исследовательского центра

Intel Science and Technology Center for Big

Data (ISTC-BD), специализирующегося на

Больших Данных и базирующегося в лаборатории CSAIL (Computer Science and Artificial

Intelligence Laboratory). Лаборатория входит

в состав Массачусетского технологического

института, но при этом сохраняет автономность. К моменту создания центра ISTC-BD

в стенах CSAIL уже существовало более десяти коллективов, так или иначе связанных

с Большими Данными, их объединение одной программой позволит преодолеть раздробленность и логически связать вместе

отдельные технологические подходы.

Как же оказалось, что именно Intel поддерживает подобного рода широкомасштабные исследования? И почему в МТИ? К

моменту образования ISTC-BD по инициативе Intel были созданы Intel Science and

Technology Center for Pervasive Computing

(ISTC-PC), Intel Science and Technology Center

for Embedded Computing (ISTC-EC), Intel Science

and Technology Center for Visual Computing

(ISTC-VC) и Intel Science and Technology Center

for Cloud Computing (ISTC-CC). Хотя в явном

виде слова Big Data фигурируют только в

названии ISTC-BD, все остальные центры

каждый по-своему также нацелены на решение проблемы Больших Данных, но со

своими индивидуальными особенностями.

Каждый из центров ориентирован на определенное направление: Pervasive Computing

(повсеместные компьютерные системы) — это

прежде всего интеллектуальные устройства,

Embedded Computing — встроенные системы, Visual Computing — визуализация и Cloud

Computing — облака.

Программа работы на ближайшие несколько лет, принятая в ISTC-BD, охватывает все пять основных направлений современной компьютерной науки, связанной

с Большими Данными: базы, математические основы аналитики, визуализация, архитектура и обработка потоков. Однако какой

бы научной и финансовой базой ни обладал центр ISTC-BD, он сможет справиться

только с отдельными составляющими этих

направлений, и перечисленные пять пунктов можно рассматривать лишь как руководство к действию.

• Базы Больших Данных и аналитика.

Разработка программных платформ для

хранения и обработки больших массивов

данных, способных поддерживать аналитические системы, существенно превосходя-

щие современные. Аналитика переживает на научного руководителя bigdata@CSAIL

сегодня период глубокой трансформации, Майкла Стоунбрейкера, директора ISTC-BD

которая предполагает выход за пределы, Сэма Маддена и директора лаборатории

присущие реляционным системам, уже не параллельных вычислений Intel Прадипа

отвечающим требованиям разнообразных Даби. Тот факт, что именно Стоунбрейкер

методов анализа данных. Базы на основе ре- был призван на роль научного руководиляционных моделей не поддерживают много- теля, обнадеживает: пожалуй, сегодня это

главный авторитет

мерные объекты (масв области работы с

сивы), для которых

Большие Данные —

данными, признаннужна совсем иная,

новая теория и практика

Big Data относится к числу немногих

ный патриарх, создав«массивно-ориенназваний, имеющих вполне достоверший сорок лет назад

тированная» модель.

ную дату своего рождения — 3 сентября

компанию Relational

Кроме того, базы

2008 года, когда вышел специальный

Technology и одну из

общего назначения

номер британского журнала Nature,

первых реляционных

показывают низкую

подытоживающий дискуссии о роли

СУБД Ingres. В своем

производительность

данных в науке вообще и в электронной

почтенном возрасте

на больших объемах,

науке (e-science) в частности.

Леонид Черняк

Стоунбрейкер сохраа многие современ«Открытые системы», № 10, 2011

нил бунтарский дух

ные данные, такие как

Беркли 60-х и до сих

разного рода изображения, результаты наблюдений и экспе- пор проявляет удивительную открытость к

риментов, вообще не могут быть каким-то новшествам.

Основную часть исследований по прообразом индексированы.

• Математика и алгоритмы для Больших грамме ISTC-BD можно отнести к школе

Данных. Предполагается создать новые Стоунбрейкера, что и определяет специалгоритмы и ПО для обработки сигналов, фику программы — практически все ее

поиска и машинного обучения, способные компоненты так или иначе связаны с бамасштабироваться на сотни машин и на пе- зами данных. Например, планируется разтабайты данных. В отличие от большинства вивать СУБД, созданные в последние годы:

современных аналогов они должны быть StreamBase для потоковых данных, Vertica

адаптированы к работе в параллельном для хранилищ данных, VoltDB для операрежиме с данными, которые хранятся вне тивной обработки транзакций, Goby.com

для данных из World Wide Web и SciDB для

оперативной памяти.

• Визуа лизация Больших Данных. научных данных и аналитики. Описывая перНеобходимо создавать средства визуали- спективы развития СУБД, Стоунбрейкер, в

зации, позволяющие пользователям вза- частности, отмечает: «Сейчас у каждого из

имодействовать с большими массивами вертикальных рынков имеются свои проданных через различные устройства от ми- блемы, для решения которых требуются

ниатюрных смартфонов до панелей разме- наиболее удобные средства, и нет нужды

ром со стену, а для этого придется обеспе- ограничиваться унаследованными из прочить масштабирование визуализации при шлого реляционными системами». По его

мнению, для аналитики следует испольизменении объемов данных.

• Архитектура систем для Больших Данных. зовать поколоночные архитектуры, для

Архитектура современных компьютеров из- транзакционной работы — базы данных в

начально создавалась для расчетных опе- памяти, NoSQL-архитектуры — для операций, и необходимо переосмыслить гря- раций с данными, имеющими значениядущие инновации и подготовиться к ним, ключи, при этом с коммерческой точки

в том числе к процессорам с большим чис- зрения сегодня становятся привлекательлом ядер, к энергонезависимой оператив- ны и другие типы данных, включая графоной памяти и к оборудованию, способному вые. Подчеркивая значение новых данных,

Стоунбрейкер отмечает, что вся реформа

к реконфигурации.

• Потоковая обработка Больших Данных. здравоохранения США, получившая назваУвеличение потоков входных данных тре- ние Obamacare, построена именно на базах

бует от систем возможностей по их обра- данных типа NoSQL.

В течение ближайшего десятилетия, по

ботке и выполнения комплекса подготовительных операций, таких как фильтрация мнению Стоунбрейкера, сложится от трех

до шести заметно различающихся межи агрегирование.

ду собой основных категорий СУБД и для

И снова Стоунбрейкер

каждой из них определятся несколько усДетализация пунктов программы ISTC-BD пешных производителей, причем одноврев контексте деятельности Intel возложена менно будет сокращаться влияние реляци-

www.osmag.ru • 01/2014 • Открытые системы • 13

инструменты больших данных

CSAIL

Лаборатория компьютерной науки и искусственного интеллекта — самая крупная в

МТИ — была сформирована в 2003 году путем слияния знаменитых лабораторий:

Laboratory for Computer Science и Artificial Intelligence Laboratory. Образованию этих

двух лабораторий в МТИ предшествовали исследования в области компьютерной

науки с 30-х годов XX века, наибольшую известность получили дифференциальный анализатор Ванневара Буша и работы в области булевой алгебры, выполненные

Клодом Шенноном. Область искусственного интеллекта ярче всего представлена в

трудах Марвина Минского, датируемых 60-ми годами. Кроме этого, лаборатории известны своими достижениями, даже краткое перечисление которых, а также имен

ученых, связанных с ними, — отдельная тема. В итоге сегодня CSAIL признана одной

из самых влиятельных университетских лабораторий мира.

За право участия в инициативе, получившей название bigdata@CSAIL, боролись

более 50 университетов. Победа МТИ закономерна и одновременно символична еще

и потому, что сейчас администрация штата Массачусетс стремится возвратить утраченную позицию технологического лидера страны и стать концентратором исследований в области Больших Данных. К работе в рамках bigdata@CSAIL будут привлечены исследователи из нескольких ведущих университетов, например Стэнфорда,

а ее деятельность поддерживают несколько крупных корпораций, причем не только

компьютерные, такие как EMC, но и страховые, медийные и ряд других.

онных баз. Дать точный прогноз на будущее

Стоунбрейкер не берется, отмечая лишь

некоторые тенденции:

• усовершенствование баз NoSQL до достижения ими соответствия требованиям ACID

(атомарность, согласованность, изолированность, надежность) и создания языков высокого уровня для доступа к данным; например, в Google уже создана система Spanner,

полностью соответствующая ACID;

• обострение борьбы между Oracle и SAP, в

которой последняя имеет преимущество в

виде технологии поколоночной обработки

данных в памяти (СУБД HANA);

• обновление системной платформы Facebook,

которая уже несколько лет пытается освободиться от MySQL, создающей компании

изрядные проблемы.

Большие Данные и ISTC-BD

В своем представлении о сущности Больших

Данных в ISTC-BD опираются на классическое определение «четыре V»: «объем»

(Volume), «скорость обработки» (Velocity),

«достоверность» (Veracity) и «разнообразие»

(Variety) [2]. Но для начала в лаборатории

считают необходимым работать только с

двумя первыми свойствами.

Категорию Большой Объем в лаборатории разделяют на две части, исходя из

природы данных и способов работы с ними.

Для работы с традиционными таблицами

могут быть использованы методы классической аналитики, основанные на SQL

и весьма совершенные, поддерживаемые

серьезной теорией и огромной практикой.

По этой причине в ISTC-BD работ, связанных с обычными табличными данными, не

предполагается. Но есть объемные массивы данных, к которым традиционные методы не применимы, поэтому для работы

с ними приходится использовать разнообразные средства анализа, основанные

на машинном обучении, кластеризации,

предсказательном моделировании, категоризации и т. п.

В случае Большой Скорости данные тоже

могут быть более или менее традиционными,