Некоторые оценки для клеточных сетей с

реклама

УДК 621.8:681:5

А.К. ДЕХТЯРЕНКО, Д.В. НОВИЦКИЙ

НЕЙРОННАЯ АССОЦИАТИВНАЯ ПАМЯТЬ С КЛЕТОЧНОЙ СТРУКТУРОЙ

Введение

В последние годы теория клеточных сетей [3] претерпевает интенсивное развитие. Среди изучаемых моделей

важное место занимают сети ассоциативной памяти [1], для которых применение клеточной архитектуры позволяет значительно сократить количество связей. А также, как отмечено в [1], ассоциативная память хопфилдовского типа встречает серьезные трудности при аппаратной реализации полносвязных нейронных сетей в

СБИС. Эти трудности преодолеваются использованием локально связных нейроструктур, таких как клеточные

сети.

Целью настоящей работы является сравнительное изучение различных методов построения неполносвязных сетей ассоциативной памяти. Следует заметить, что в данной работе рассматриваются только модели, в которых положение ненулевых весов в матрице задается жестко a priori, в отличие от [5] и аналогичных методов, где связи отбираются по абсолютной величине уже после формирования матрицы.

Исследуется модель клеточных сетей, предложенная в [1], с маской типа «линейное соседство» (все

нейроны образуют одномерную цепочку, связь между нейронами существует только тогда, когда они отстоят

друг от друга не дальше, чем на r). Такая сеть обладает самосопряженной весовой матрицей с 2r+1 ненулевыми диагоналями.

В качестве альтернативы алгоритма обучения из [1] рассматривается сеть, весовая матрица которой

представляет собой 2r+1-диагональную матрицу, полученную из весовой матрицы псевдоинверсной сети, в

которой все «лишние» веса обнулены. Оказывается, что такая процедура дает возможность запоминать в сети

m O (r ) векторов, что по порядку совпадает с емкостью клеточной сети. Получено соотношение для ста-

тистической оценки величины аттракторного радиуса H сети при больших

r

2 (H ) m

2(1

m

)

n

n

и

m:

,

где зависит только от гарантированного аттракторного радиуса. Доказана также асимптотика

m O (r )

для клеточных сетей.

Для проверки полученных закономерностей проведены численные эксперименты на сетях размером

до 1000 нейронов. Экспериментальные результаты демонстрируют согласованность с теорией.

Архитектура и алгоритмы исследуемых сетей

Обе сети представляют собой варианты автоассоциативной памяти хопфилдовского типа. Весовая матрица

первой из них получается следующим образом: пусть

vi mi 1 Rn

суть векторы, подлежащие запомина-

нию. Они, как это принято в теории ассоциативной памяти, биполярны, т.е. компоненты принимают значения

1. Матрица V строится из запоминаемых векторов так, что они образуют её столбцы. Тогда исходная полносвязная сеть ассоциативной памяти получается по псевдоинверсному алгоритму:

C VV .

Дехтяренко А.К., Новицкий Д.В.2002

ISSN 1028-9763. Математичні машини і системи, 2002, № 3

37

Это матрица проекции на подпространство, натянутое на векторы

vi mi 1 . Матрица исследуемой се-

ти X в случае псевдоинверсного клеточного алгоритма обучения получается из C обнулением элементов, отстоящих более чем на r от главной диагонали. Возможна также «закольцованная» схема:

cij , (i j ) mod n r

xij

0 , (i j ) mod n r.

Другой тип алгоритма предложен М. Бруколи и др. [1]. Здесь используется упрощенная модель сети, в

которой не учитывается порог, активационная функция имеет форму сигнум (sign), и внешнее воздействие

отсутствует. Основная идея такой клеточной сети состоит в обеспечении её устойчивости благодаря соблюдению симметрии матрицы связей.

Принимается ленточная структура этой матрицы с шириной полосы

2r+1(см. выше), однако алгоритм допускает произвольную конфигурацию связей. Вычисление весовых коэффициентов cij осуществляется последовательно для всех нейронов, начиная с первого (i=1). Величина постсинаптического потенциала каждого нейрона в устойчивом состоянии сети состоит из двух частей:

s i si si y i ;

ir

si ( k ) cij v jk ;

si( k )

где yi – i-я строка матрицы V;

vik

j i

i 1

c v

j i r

ij

jk

,

– значение j-го элемента k-го вектора

v k . Вычисление весовых ко-

эффициентов осуществляется в следующем порядке:

si s i si ciVi ,

где si – вектор-строка

строка

m

(sik )k 1

,

Vi v jk

m, i r

k 1, j i

– матрица размером (r+1)m; а

(cij )i r j i . Решение этого уравнения при условии si y i

ci –

вектор-

имеет вид

ci [y i s i ]Vi ,

где

Vi

– матрица, псевдообратная к

Vi .

Полученные значения

(1)

cij присваиваются

элементам

cij

и

c ji . Вычисление начинают с первого нейрона, для которого считают si 0 , далее находят c2 j , а затем до

i=n. Следует отметить, что существует некоторое «неравноправие» между нейронами: те из них, веса которых

вычисляются в последнюю очередь, обладают меньшим количеством свободных параметров, что ведет к

ухудшению качества получаемого решения. Именно на этих нейронах наиболее вероятно появление ошибки в

ходе экзамена сети.

При условии сохранения набора псевдообратных матриц, использованных для решения систем (1)

для m образов, возможно дальнейшее добавление новых запоминаемых образов с помощью итеративных

формул Гревиля [4], что позволяет избежать полного пересчета весовой матрицы сети.

Техника статистических оценок

Сложность процедуры вычисления проекционной матрицы не позволяет напрямую выразить ее элементы.

Однако существует довольно простой способ, дающий приблизительное описание статистических свойств

матрицы сети C при некоторых дополнительных предположениях. Достаточно принять следующую гипотезу:

38

ISSN 1028-9763. Математичні машини і системи, 2002, №3

Гипотеза 1: Все случайные величины

математическим ожиданием и дисперсией

cii

m

ij

n

имеют одинаковые распределения с нулевым

σ2 .

Используя идемпотентность C

C 2 C;

n

cij cik ckj ,

k 1

легко показать, что это распределение нормально и

зависит от распределения векторов

2

1 m m 2

( ( ) ) . Точность выполнения гипотезы 1

n n

m

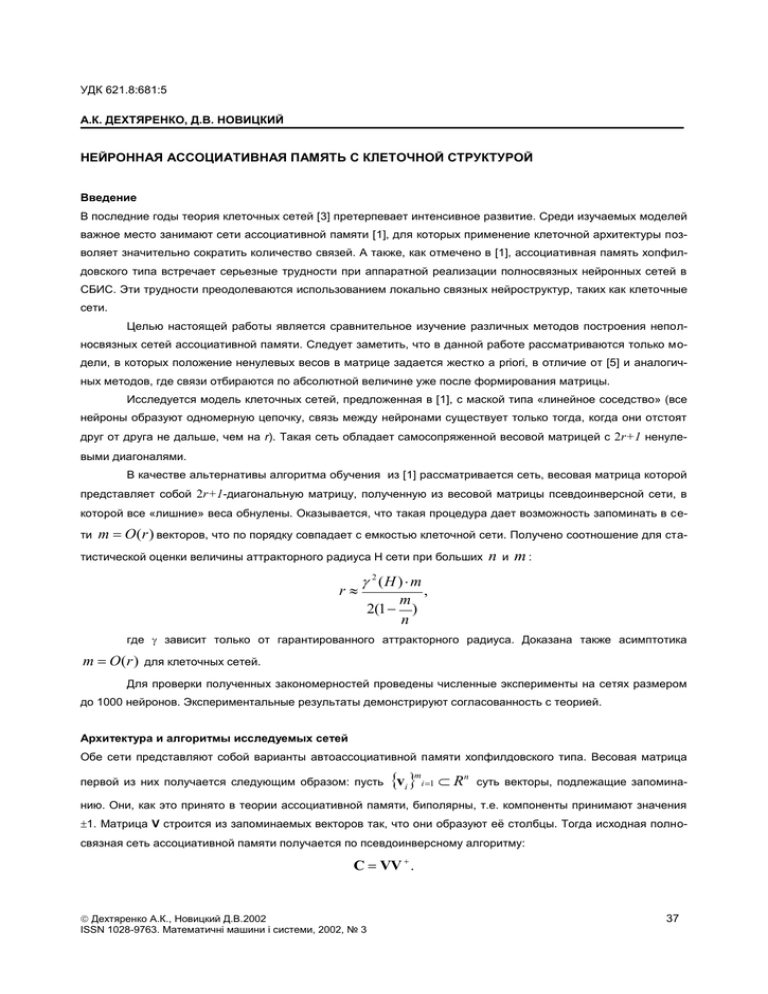

vi mi 1 . Для полностью случайных vi mi 1 пример такого распределе-

ния показан на рис.1.

В частности, верно

Утверждение 1.

Если все компоненты запоминаемых векторов

v i j , i 1m, j 1n

суть независимые

СВ, с равной вероятностью принимающие

значения ±1, то для

m

n ,

( m n,

1

2

0, ) выполня-

ется гипотеза 1.

Рис. 1. Распределение весов проекционной матрицы

Доказательство:

При

0,14

можно воспользоваться хопфилдовским приближением:

C

c

Hopf

ij

1

VV T ;

n

1 m i j

vk vk .

n k 1

Это автоматически по предельной теореме дает нормальность

Hopf

cij

cij (по крайней мере, для i j , иначе

m

).

n

В общем случае

C VV V(V T V) 1 V T V Ψ V T .

Матрица

(V T V) 1

По теореме линейной алгебры

– самосопряженная невырожденная положительно определенная матрица.

!B BT 0

такое, что

ISSN 1028-9763. Математичні машини і системи, 2002, №3

Ψ B 2 BBT .

39

А, значит,

C VBB T V T VB(VB)T ,

т.е.

1 ~~

C V V T , где V~ nVB.

n

Поскольку мы можем произвольным образом перенумеровать элементы матрицы

нумерацией

j

vi

~

V

(соответствующей пере-

), они должны иметь одинаковые распределения, а, значит, верна гипотеза о нормальности

cij

В дальнейшем также понадобится величина

. Поскольку эталон v уже содержится в памяти

vi cij v j

и справедлива гипотеза 1:

n

n

j 1

j 1

j i

vi cij v j cii vi cij v j 1;

cii (n 1) vi cij v j 1;

vi cij v j

1

m

1 .

n 1

n

Некоторые оценки для клеточных сетей с псевдоинверсным алгоритмом обучения

В качестве критерия пригодности сети мы будем использовать устойчивость по искажению диагонального

элемента.

Подействуем матрицей

X

на вектор

vk :

n

i

yk ( Xv) j xij vkj .

j 1

Так как элемент

та

vki

xii наибольший по модулю в i-й строке, мы должны потребовать, чтобы, если даже компонен-

изменила знак (в результате искажения), знак

y ki сохранился. Это достигается при

n

x v

j 1

ij

jk

xii .

(2)

j i

Для того, чтобы это обеспечить с подавляющей вероятностью, достаточно, чтобы среднеквадратическое отклонение величины под модулем в (1), помноженное на некоторую константу

2 , было больше m n M xii .

n

m

STD xij v jk ;

j 1

n

j

i

2r

40

m

;

n

ISSN 1028-9763. Математичні машини і системи, 2002, №3

2 2r 2

r

m2

;

n2

2m

m

21

n

.

(3)

Вычисление аттракторного радиуса

Для оценки AR воспользуемся методом [2]. Пусть

дящийся на расстоянии H по Хэммингу от

v – запомненный вектор, а y – искаженный вектор, нахо-

v . Здесь мы оценим так называемый прямой аттракторный радиус,

то есть такой, при котором неподвижная точка достижима за одну итерацию.

Для этого нужно, чтобы

n

vi sign xij y j .

j 1

Зная, что

vk ( h ) y k ( h )

(где

h 1H ), имеем

1 2vi

2 Hr / n

h 1

jh i

cijh vih 2 cii vi

n / 2r

cij v j vi

j 1

n

c v

ij

j n / 2 r

j

0.

Путем усреднения преобразуем это соотношение к виду:

2r

1 2 H 1 (cij ) 2 cii (n 2r ) vi cij v j 0,

n

то есть

H 1

1 2 cii (n 2r ) vi cij v j

n

2

4r

(cii )

.

И окончательно

H

Неравенство (3) с

γ 1

n m(2 n 2r ) 2rn n n

1

.

2r

2(n 1) m(n m)

получается из (4) фиксацией

H H0

(4)

при больших n. Разбивая матрицу на

полностью независимые проекционные блоки (клетки) размером r и емкостью не меньше r/4, легко получить

для m оценку снизу. Окончательно

r / 4 m 2r.

ISSN 1028-9763. Математичні машини і системи, 2002, №3

(5)

41

Численные эксперименты

К сожалению, для клеточных сетей с алгоритмом обучения М. Бруколи затруднительно дать даже статистическое описание их поведения в терминах аттракторного радиуса. Поэтому был проведен ряд численных экспериментов, чтобы пронаблюдать это поведение и сравнить два алгоритма запоминания образов.

Во всех экспериментах использовалась сеть с маской «линейное соседство», во избежание краевых эффектов

замкнутая в кольцо. Запоминаемые векторы генерировались случайно, все компоненты независимо принимали значения 1 с равной вероятностью. Аттракторный радиус вычислялся как максимально возможная величина расстояния Хемминга H, при

котором среднее остаточное расстояние все еще меньше 1. Для

каждого

запомненного

вектора

проводилось 100 прогонов экзамена. При этом для определенного

значения H случайным образом

выбирались векторы, отстоящие от

запомненного в точности на H.

Рис. 2 показывает, что аттракторный радиус убывает практически

монотонно с ростом числа векторов в памяти и становится равным

нулю при

m r . На этом рисунке

также показаны значения прямого

Рис. 2. Зависимость аттракторного радиуса от числа

запомненных образов

аттрактороного радиуса для псевдоинверсной клеточной сети, полученные в эксперименте и в соот-

ветствии с оценкой (4).

Следующий эксперимент

показывает

зависимость числа

запомненных состояний от размера клеток. Изучалась сеть из

256

нейронов,

ёмкостью

сети

считалось число образов, которые можно запомнить, обеспечив

аттракторный радиус не менее

10.

При

малых

значениях

m

r

, что неплохо

2

(меньше 40)

r

согласуется с теорией (неравенство(5)). При больших значениях

r зависимость становится нерегуРис. 3. Зависимость емкости сети от ширины полосы

лярной. Это отвечает ситуации,

когда сеть близка к полносвязной и приближение клеточности уже не выполняется.

42

ISSN 1028-9763. Математичні машини і системи, 2002, №3

Важно также установить

фактическую зависимость емкости памяти от числа нейронов.

Результаты такого эксперимента

(рис. 4) показывают, что при фиксированной ширине полосы mmax

для обоих алгоритмов практически не зависит от n, в полном соответствии с теорией.

Рис. 4. Зависимость ёмкости от размера сети

при постоянной величине клетки

Фундаментальные ограничения на ёмкость неполносвязных сетей

Хотя во многих случаях аттракторный радиус неполносвязных сетей трудно оценить, существуют естественные ограничения на ассоциативную память с такой архитектурой, справедливые при использовании алгоритмов проекционного типа. Эти ограничения можно получить в предположении, что запоминаемые образы представлены в матрице связей как собственные векторы или натянутые на них собственные подпространства. Как

известно из линейной алгебры, для всякой самосопряженной матрицы сети X существует представление

X UDU T ,

где

(6)

U – унитарна (ортогональна), UU T 1 , а D – вещественная диагональная матрица. В таком

случае столбцы матрицы U будут собственными векторами для X. Унитарность матрицы U накладывает

n( n 1)

2

соотношений на n2 ее элементов:

U exp (), * 0 .

Предположим теперь, что в мат-

рице X имеется лишь 2K(n) ненулевых недиагональных элементов:

xij 0, {(i, j ) S {1...n}2 ; S 2K (n)}.

Это означает, что соотношение (6) накладывает ещё

n(n 1)

K ( n)

2

(7)

ограничений на элементы

матрицы U. Остается не более K(n)+n свободных переменных. Они дают возможность определить всего лишь

K ( n)

n

собственных векторов, все остальные будут от них функционально зависимы. Так, например, в случае

сетей с одномерной клеточной организацией при полуширине полосы r можно запомнить не более r векторов.

Все вышеизложенное справедливо лишь при жесткой организации сети, когда места ненулевых весов

в матрице задается a priori. Такой подход приводит к навязыванию определенной структуры самим данным.

Если данные на самом деле обладают соответствующей организацией, механизмы клеточной памяти позволяют обойтись небольшим числом образов, которые эффективно описывают всю выборку. В противном случае запоминается такое же количество векторов (около

K ( n)

),

n

но возникающие на их основе зависимые

собственные состояния будут лишь паразитными аттракторами. Это ведет к потере эффективности работы

клеточной сети при работе с произвольными образами.

ISSN 1028-9763. Математичні машини і системи, 2002, №3

43

Возможен и принципиально другой механизм построения неполносвязных сетей. Например, в работе

[5] из проекционной матрицы удаляются связи, вес которых меньше по модулю некоторого порога. Это обеспечивает создание неполносвязной матрицы X, оптимальной в том смысле, что

X C min

в классе матриц с определенной степенью заполнения.

Таким образом, структура связей определяется исходя из конкретного набора данных. В этом случае

вышеприведенные ограничения несправедливы, а емкость сравнима с характеристиками полносвязных сетей.

В самом деле, здесь характер функциональных зависимостей между собственными векторами (6), (7) следует

из свойств данных (запоминаемых образов), что позволяет использовать такие зависимости в механизме запоминания. Это не только позволяет увеличить емкость памяти, но и отразить скрытые закономерности данных в структуре весовых матриц.

Заключение

Итак, мы получили теоретические и экспериментальные оценки, указывающие на принципиальное сходство

поведения двух алгоритмов запоминания образов в клеточной ассоциативной памяти. В качестве тестового

материала использовались данные, наиболее неблагоприятные для клеточных сетей: случайные векторы из

независимых, одинаково распределенных компонент. Удалось показать, что емкость сети не растет вместе с

числом нейронов, как это происходит для полносвязных сетей. Зато наблюдается линейный рост запоминающей способности в зависимости от размера клетки. Такое поведение характерно для тех типов клеточных

сетей, где носителями образов служат собственные векторы синаптической матрицы.

Алгоритмическая сложность проекционного алгоритма составляет O(n2m), в то время как для алгоритма из [1] это O(nrm2) (эти оценки легко получить на основе процедуры псевдообращения матрицы по Гревилю, которая используется всеми описанными алгоритмами). Нетрудно видеть, что если сеть растет пропорционально, т.е. r/n=const и m/n=const, псевдоинверсный алгоритм работает эффективнее. Однако при сохранении радиуса связей (а, значит, и количества образов) первенство принадлежит подходу М. Бруколи.

Известно, что если компоненты запоминаемого вектора сильно коррелированны между собой (прежде

всего, соседние компоненты), эффективность клеточных сетей резко возрастает. Наиболее благоприятен случай, когда при этом зависимость между образами отсутствует. Исследование подобной ситуации может стать

естественным продолжением затронутой в данной работе темы.

Благодарности

Авторы выражают признательность коллективу разработчиков программного комплекса NeuroLand™, который

использовался для проведения экспериментальных исследований.

СПИСОК ЛИТЕРАТУРЫ

1.

2.

3.

4.

5.

44

Brucoli M., Carnimeo L., Grassi G. Heteroassociative memories via cellular neural networks // International journal of circuit

theory and applications. - 1998. - N26. - P. 231-241.

Gorodnichy D.O., Reznik A.M. Increasing Attraction of Pseudo-Inverse Neural Networks // Neural Processing Letters. - 1997. N5. - P. 121-125.

Liu D., Michel A.N. Cellular neural networks for associative memories // IEEE Trans. Circuit Systems. - 1993 - N40. - P. 119121.

Кириченко Н., Резник А., Щетинюк С. Псевдообращение матриц в проблеме проектирования ассоциативной памяти //

Кибернетика и системный анализ. - 2001. - №3. - С. 18-27.

Сычев А. Селекция весов в нейронных сетях с псевдоинверсным алгоритмом обучения // Математические машины и

системы. - 1998. - №2. - С. 25-30.

ISSN 1028-9763. Математичні машини і системи, 2002, №3