L_SPPO

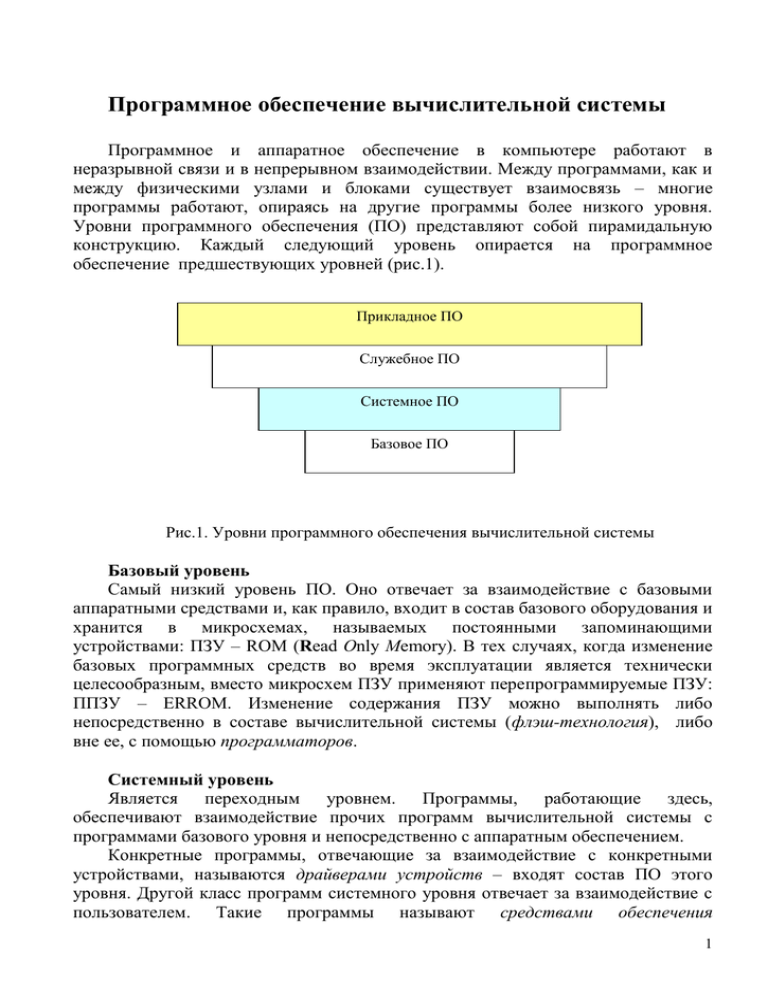

advertisement