Дополнительная информация к разделу "

advertisement

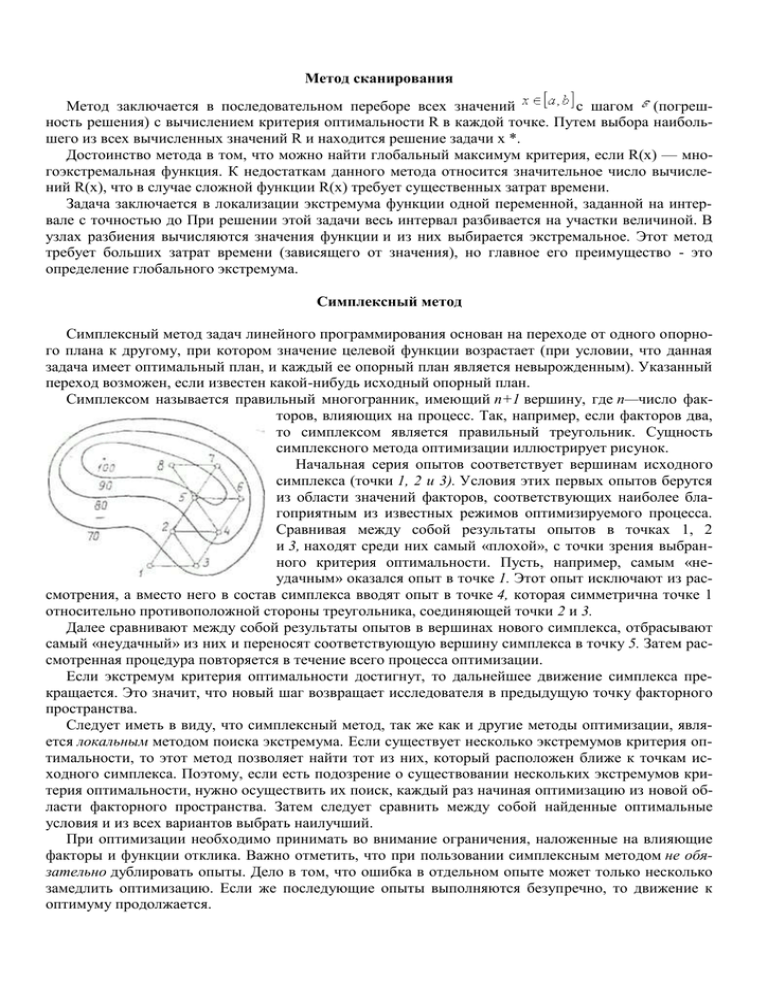

Метод сканирования Метод заключается в последовательном переборе всех значений с шагом (погрешность решения) с вычислением критерия оптимальности R в каждой точке. Путем выбора наибольшего из всех вычисленных значений R и находится решение задачи х *. Достоинство метода в том, что можно найти глобальный максимум критерия, если R(x) — многоэкстремальная функция. К недостаткам данного метода относится значительное число вычислений R(x), что в случае сложной функции R(x) требует существенных затрат времени. Задача заключается в локализации экстремума функции одной переменной, заданной на интервале с точностью до При решении этой задачи весь интервал разбивается на участки величиной. В узлах разбиения вычисляются значения функции и из них выбирается экстремальное. Этот метод требует больших затрат времени (зависящего от значения), но главное его преимущество - это определение глобального экстремума. Симплексный метод Симплексный метод задач линейного программирования основан на переходе от одного опорного плана к другому, при котором значение целевой функции возрастает (при условии, что данная задача имеет оптимальный план, и каждый ее опорный план является невырожденным). Указанный переход возможен, если известен какой-нибудь исходный опорный план. Симплексом называется правильный многогранник, имеющий п+1 вершину, где п—число факторов, влияющих на процесс. Так, например, если факторов два, то симплексом является правильный треугольник. Сущность симплексного метода оптимизации иллюстрирует рисунок. Начальная серия опытов соответствует вершинам исходного симплекса (точки 1, 2 и 3). Условия этих первых опытов берутся из области значений факторов, соответствующих наиболее благоприятным из известных режимов оптимизируемого процесса. Сравнивая между собой результаты опытов в точках 1, 2 и 3, находят среди них самый «плохой», с точки зрения выбранного критерия оптимальности. Пусть, например, самым «неудачным» оказался опыт в точке 1. Этот опыт исключают из рассмотрения, а вместо него в состав симплекса вводят опыт в точке 4, которая симметрична точке 1 относительно противоположной стороны треугольника, соединяющей точки 2 и 3. Далее сравнивают между собой результаты опытов в вершинах нового симплекса, отбрасывают самый «неудачный» из них и переносят соответствующую вершину симплекса в точку 5. Затем рассмотренная процедура повторяется в течение всего процесса оптимизации. Если экстремум критерия оптимальности достигнут, то дальнейшее движение симплекса прекращается. Это значит, что новый шаг возвращает исследователя в предыдущую точку факторного пространства. Следует иметь в виду, что симплексный метод, так же как и другие методы оптимизации, является локальным методом поиска экстремума. Если существует несколько экстремумов критерия оптимальности, то этот метод позволяет найти тот из них, который расположен ближе к точкам исходного симплекса. Поэтому, если есть подозрение о существовании нескольких экстремумов критерия оптимальности, нужно осуществить их поиск, каждый раз начиная оптимизацию из новой области факторного пространства. Затем следует сравнить между собой найденные оптимальные условия и из всех вариантов выбрать наилучший. При оптимизации необходимо принимать во внимание ограничения, наложенные на влияющие факторы и функции отклика. Важно отметить, что при пользовании симплексным методом не обязательно дублировать опыты. Дело в том, что ошибка в отдельном опыте может только несколько замедлить оптимизацию. Если же последующие опыты выполняются безупречно, то движение к оптимуму продолжается. Градиентные методы Градиентные методы безусловной оптимизации используют только первые производные целевой функции и являются методами линейной аппроксимации на каждом шаге, т.е. целевая функция на каждом шаге заменяется касательной гиперплоскостью к ее графику в текущей точке. На k-м этапе градиентных методов переход из точки Xk в точку Xk+1 описывается соотношением: Xk+1 = Xk + k - величина шага, k - вектор в направлении Xk+1-Xk. Методы наискорейшего спуска Впервые такой метод рассмотрел и применил еще О. Коши в XVIII в. Идея его проста: градиент целевой функции f(X) в любой точке есть вектор в направлении наибольшего возрастания значения функции. Следовательно, антиградиент будет направлен в сторону наибольшего убывания функции и является направлением наискорейшего спуска. Антиградиент (и градиент) ортогонален поверхности уровня f(X) в точке X. Если в (1.2) ввести направление , то это будет направление наискорейшего спуска в точке Xk. Получаем формулу перехода из Xk в Xk+1: . Антиградиент дает только направление спуска, но не величину шага. В общем случае один шаг не дает точку минимума, поэтому процедура спуска должна применяться несколько раз. В точке минимума все компоненты градиента равны нулю. Все градиентные методы используют изложенную идею и отличаются друг от друга техническими деталями: вычисление производных по аналитической формуле или конечноразностной аппроксимации; величина шага может быть постоянной, меняться по каким-либо правилам или выбираться после применения методов одномерной оптимизации в направлении антиградиента и т.д. и т.п. Останавливаться подробно мы не будем, т.к. метод наискорейшего спуска не рекомендуется обычно в качестве серьезной оптимизационной процедуры. Одним из недостатков этого метода является то, что он сходится к любой стационарной точке, в том числе и седловой, которая не может быть решением. Но самое главное - очень медленная сходимость наискорейшего спуска в общем случае. Дело в том, что спуск является "наискорейшим" в локальном смысле. Если гиперпространство поиска сильно вытянуто ("овраг"), то антиградиент направлен почти ортогонально дну "оврага", т.е. наилучшему направлению достижения минимума. В этом смысле прямой перевод английского термина "steepest descent", т.е. спуск по наиболее крутому склону более соответствует положению дел, чем термин "наискорейший", принятый в русскоязычной специальной литературе. Одним из выходов в этой ситуации является использование информации даваемой вторыми частными производными. Другой выход - изменение масштабов переменных. Аналитический метод оптимизации предусматривает аналитическое задание соответствующих функций и определение производных от них. В случае наличия таких ограничений, касающихся переменных величин, полезным может оказаться хорошо известный в математике метод множителей Лагранжа. Группа аналитических методов оптимизации объединяет аналитический поиск экстремума функций, заданных без ограничений, метод множителей Лагранжа, вариационные методы и принцип максимума. Для использования аналитических методов оптимизации необходимо, чтобы расчетная формула критерия, ограничения и связи между координатами, управлениями и независимой переменной, а также начальные и конечные условия были представлены в форме функций, которые могут быть по крайней мере один раз дифференцируемыми и могут иметь конечное число точек разрывов. Не отрицая значения аналитических методов оптимизации процесса бурения, авторы настоящей работы отдали предпочтение графо-аналитическим методам, тем более, что последние применительно к некоторым методам проводки стволов скважин больших диаметров не освещены в литературе. На основании изложенного можно заключить что разработка и усовершенствование аналитических методов оптимизации газовых сетей сохраняют свое значение. На основании изложенного можно заключить, что разработка и усовершенствование аналитических методов оптимизации газовых сетей сохраняют свое значение. Вычислительные трудности решения систем при большом числе переменных Xj и ограничениях, накладываемых на область их изменения, преодолены в кибернетике с помощью численных методов оптимизации. Разработка систем оптимального управления требует применения как численных, так и аналитических методов оптимизации. Особенности задач управления обусловливают применение непрерывных или дискретных, детерминированных или вероятностных методов оп- тимизации. Применение на практике аналитического метода оптимизации системы предполагает исследование большого числа вариантов. Понятие устойчивости и оптимизации Важным свойством или требованием, предъявляемым к моделям, является требование их устойчивости. Можно различить несколько аспектов понятия «устойчивость». Устойчивость модели по отношению к изменениям ее параметров означает сохранение аппарата моделирования, основных связей между переменными, типов ограничений в некотором интервале ее параметров. Другим аспектом устойчивости является устойчивость решения задачи (результатов) моделирования(обнаруженных свойств, сценариев, траекторий, состояний) по отношению к изменениям параметров модели или начальных условий. Если зависимость от параметров и начальных условий является регулярной, то малые ошибки в исходных данных приведут к небольшим изменениям результата. Тогда, решая, например, задачу выбора по приближенным данным, можно обоснованно говорить о нахождении приближенного решения. Иногда устойчивость является целью практического моделирования. В частности – поиск алгоритмов деятельности человека без разрушения природной экосистемы. Оптимизация заключается в том, чтобы среди множества объектов (возможных решений, сценариев, вариантов проектируемой системы) найти наилучшие в заданных условиях, при заданных ограничениях, то есть оптимальные альтернативы. Задача многокритериальной оптимизации состоит в поиске вектора целевых переменных, удовлетворяющий наложенным ограничениям и оптимизирует векторную функцию, элементы которой соответствуют целевым функциям. Эти функции образуют математическое описание критерия удовлетворительности и, как правило, взаимно конфликтуют. Отсюда, «оптимизировать» означает найти такое решение, при котором значение целевых функций были бы приемлемыми для постановщика задачи. Методы принятия компромиссных решений широко применяются в практике оптимизации многокритериальных задач. Рассмотрим сначала общие положения в решении таких задач. Сначала определяются критерии оптимизации в порядке их важности: W1, W2, .... Wn. Будем считать, что каждый из них нужно обратить в минимум или максимум. Сначала найдем решения, обращающие в минимум (максимум) главный критерий оптимизации Wt. В практике чаще приходится иметь дело не с одним, а с несколькими критериями оптимизации, что существенным образом усложняет выбор оптимального решения. Такого рода многокритериальные задачи составляют предмет векторной оптимизации. Одним из подходов в решении таких задач является метод Парето. Различают три основных подхода в принятии компромисса. Аддитивные критерии предусматривают образование целевой функции путем сложения нормированных значений частных критериев. При этом следует оперировать не с «натуральными», а с нормированными частными критериями, представляющими собой отношение «натурального» частного критерия к некоторой нормированной величине, измеряемой в тех же единицах, что и сам критерий. Выбор величины нормированного показателя может быть обоснован в следующих двух подходах. Первый подход предполагает принимать в качестве нормированного критерия некоторое значение, директивно заданное заказчиком. Слабым моментом является негласное предположение того, что такое заданное нормированное значение является оптимальным. Второй подход предполагает принимать в качестве нормированного делителя некоторое максимальное значение, достигнутое в области принимаемых решений. Возможен еще третий подход, когда в качестве нормированного делителя принимается разность между максимальным и минимальным значениями критерия в области компромисса. При решении задач оптимизации процессов механической обработки часто возникает необходимость одновременного достижения нескольких противоречащих друг другу целей. Принимая решения, улучшающие оценки одного критерия, например минимальной себестоимости операции, мы ухудшаем тем самым оценки по другим критериям, например наибольшей производительности и др. В таких случаях возникает задача оценки и сравнения различных проектных решений при так называемом векторном критерии эффективности. С этой целью используют обобщенные критерии, которые являются скалярными функциями частных критериев и учитывают степень достижения всех целей в совокупности, отражая относительную значимость каждого критерия в отдельности. Поскольку каждый из частных критериев является фактически функцией управляемых переменных, то и обобщенный критерий в свою очередь можно рассматривать как некоторую функцию управляемых переменных. Эту функцию, как отмечалось выше, обычно называют целевой. При таком подходе, называемом свертыванием векторного критерия, задача сравнения решений по векторному критерию фактически заменяется задачей выбора способа свертывания и определения значения коэффициентов, участвующих в этом свертывании. Существуют следующие виды обобщенных (свернутых) критериев. Аддитивный критерий. В этом случае в качестве обобщенного критерия берется «взвешенная» сумма частных критериев , где х – управляемые переменные; αj – неотрицательные коэффициенты, значения которых выбираются, исходя из степени важности отдельных целей, и определяются на основании ранее решенных аналогичных задач или методом проб. В последнем случае «весовые» коэффициенты подбираются при анализе результатов, получаемых при различных значениях этих коэффициентов, αj является неуправляемой переменной. Мультипликативный критерий. В отличие от предыдущего в данном случае в качестве обобщенного критерия берется «взвешенное» произведение частных критериев . Конъюнктивный критерий. По этому критерию оценивается каждое решение с точки зрения цели, степень достижения которой (с учетом «весового» коэффициента) в данном случае наименьшая: . Дизъюнктивный критерий. Противоположен предыдущему и оценивает решения с точки зрения цели, степень достижения которой (также с учетом «весового» коэффициента) в данном случае максимальна: . Кроме рассмотренных, могут использоваться и другие способы свертывания критериев. Например, способ выделения наиболее важного критерия предусматривает определение из набора частных критериев оптимальности одного, который принимается за обобщенный как критерий допустимости. Для выбора наиболее важного критерия может быть рекомендован метод последовательных уступок, предусматривающий упорядочивание всех количественных целей в порядке убывания их значимости. Метод последовательных уступок решения задач многокритериальной оптимизации применяется в случае, когда частные критерии могут быть упорядочены в порядке убывания их важности. Предположим, что все частные критерии максимизируются и пронумерованы в порядке убывания их важности. Находим максимальное значение , первого по важности критерия в области допустимых решений, путем решения однокритериальной задачи Затем, исходя из практических соображений и принятой точности, назначается величина допустимого отклонения 8, > 0 (экономически оправданной уступки) критерия Z, и находится максимальное значение второго критерия Z'2 при условии, что значение первого критерия не должно отклоняться от своего максимального значения более чем на величину допустимой уступки, т.е. решается задача: Снова назначается величина уступки δ2 > 0 по второму критерию, которая вместе с первой уступкой используется для нахождения условного максимума третьего частого критерия: Аналогичные процедуры повторяются до тех пор, пока не будет выявлено максимальное значение последнего по важности критерия Zm при условии, что значение каждого из первых т - 1 частных критериев отличается от соответствующего условного максимума не более чем на величину допустимой уступки по данному критерию. Полученное на последнем этапе решение считается оптимальным. Следует заметить, что этот метод не всегда приводит к эффективному решению.