Метод микс-матрицы в задачах бинарной оптимизации

Реклама

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

Я.М. КАРАНДАШЕВ, Б.В. КРЫЖАНОВСКИЙ

Научно-исследовательский институт системных исследований РАН,

Москва

Yakov.Karandashev@phystech.edu

МЕТОД МИКС-МАТРИЦЫ В ЗАДАЧАХ БИНАРНОЙ

ОПТИМИЗАЦИИ

Рассматривается задача минимизации бинарного квадратичного функционала. Для повышения эффективности случайного поиска мы предлагаем варьировать область притяжения глубоких минимумов функционала

путём изменения матрицы T, на которой он построен, на новую, названную микс-матрицей. Мы продемонстрировали, что предложенная замена

приводит к значительному сдвигу в спектре находимых минимумов в сторону большей глубины, при этом вероятность отыскания глобального минимума резко увеличивается (в 103 в случае двумерной модели Изинга).

Ключевые слова: квадратичная бинарная оптимизация, область притяжения, случайный поиск, трансформация энергетической поверхности

Введение

Настоящая работа направлена на решение задач бинарной оптимизации. Это класс задач, решение которых сводится к минимизации квадратичного функционала E1 ( S ) , построенного на заданной матрице Т, в Nмерном конфигурационном пространстве состояний S (s1 , s2 ,..., sN ) с

дискретными переменными si 1 , i 1, N .

Задача относится к классу NP-трудных и обычно эффективность процедуры локального поиска пытаются повысить, видоизменяя динамику

спуска по поверхности [1-3], описываемой функционалом E1 ( S ) . В отличие от такого подхода, мы предлагаем изменять не динамику спуска по

поверхности, а трансформировать саму поверхность так, чтобы увеличился радиус области притяжения глобального минимума (равно как и других

минимумов, сравнимых с глобальным по глубине). В предыдущей работе

[9] для осуществления такой модификации предлагалась трансформация

Данная работа выполнена при поддержке проектов ОНИТ РАН № 2.1 и № 1.8.

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

функционала путем возведения матрицы Т в степень k ( k 2,3,... ). Такой подход оказался очень продуктивным: благодаря трансформации

энергетической поверхности, спектр находимых минимумов сдвигался в

сторону глубоких минимумов, и вероятность отыскания глобального минимума в 70 % случаев увеличивалась в тысячу раз. Правда, в остальных

30 % случаев глобальный минимум вообще не удавалось найти.

В настоящей статье предлагается идея, что добавление к матрице T k

исходной матрицы Т, т.е. получение смешанной матрицы (mix-матрицы),

даст более надёжный подход.

Структура статьи следующая. Глава 2 содержит постановку задачи. В

главе 3 изложены некоторые предварительные замечания, касающиеся

энергетической поверхности квадратичного функционала. В главе 4 описана предлагаемая идея mix-матрицы. В главе 5 показано, каким образом

mix-матрица трансформирует энергетическую поверхность квадратичного

функционала и что происходит с его минимумами. Глава 6 содержит полученные результаты для двух типов матриц (равномерные матрицы и

матрицы Изинга). Далее следует заключение.

Постановка задачи

Стандартная постановка задачи бинарной минимизации такова: задана

N N -матрица Т, следует найти N-мерный конфигурационный вектор

Sm (sm1 , sm 2 ,..., smN ) , smi 1 , минимизирующий функционал:

E (S )

1

T N 2

N

N

T s s

i 1 j 1

ij i

j

,

(1)

где T - стандартное отклонение матричных элементов. Функционал (1)

симметризуется, поэтому без ограничения общности будем полагать матрицу симметричной, а диагональные элементы равными нулю.

За основу процедуры минимизации примем модель Хопфилда [4],

асинхронная динамика которой состоит в вычислении величины локального поля hi E1 (S ) / si , действующего на i-й спин:

1 N

(2)

Tij s j

T N 2 j i

и состояние спина обновляется в соответствии с решающим правилом

si sign hi . Эта процедура последовательно применяется ко всем нейронам до тех пор, пока сеть не сойдётся в устойчивое состояние S m .

hi

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

Как известно, NP-полные задачи характеризуются гигантским количеством локальных минимумов. Чтобы найти среди всего этого множества

глобальный минимум, приходится прибегать к случайному поиску, процедура которого заключается в следующем. Произвольным образом задается начальное состояние сети и затем производится спуск в ближайший

локальный минимум. Эта процедура повторяется множество раз до тех

пор, пока не будет найден минимум с приемлемой глубиной.

Предварительные замечания

Прежде чем перейти к вопросу о трансформации поверхности, установим основные соотношения, связанные с глубиной глобального (локального) минимума, на которых будут базироваться все последующие выводы.

Первое соотношение связано с ограничением на глубину минимума.

Пусть S0 (s01 , s02 ,..., s0 N ) – конфигурация, соответствующая глобальному минимуму E0 E1 ( S0 ) . Вычленим из матрицы Т слагаемое Т0, ответственное за образование этого минимума. Для этого представим Т в виде:

T T0 T1 ,

T0 r0 T S0 S0 .

(3)

Число r0 найдем из условия отсутствия корреляции между элементами

матриц T0 и T1 . Рассчитав ковариацию матричных элементов и положив

ее равной нулю, получим соотношение E0 r0 .

Как показано в [5-6], любой вектор S m будет минимумом функционала (1), если его вес rm больше критического значения rc 1.35 / N . Это

утверждение прежде всего относится к точке S0 , которая по определению

является минимумом, и для нее справедливы соотношения:

1 r0 rc , Ec E0 1 ,

Ec rc .

Второе необходимое соотношение связывает глубину минимума с его

шириной. Как показано в [7], с ростом глубины минимума E0 его ширина

возрастает. Соответственно, вероятность отыскания этого минимума возрастает как P( E0 ) ~ exp NEc2 / E02 .

Отсюда вытекает направленность наших усилий по повышению эффективности алгоритма случайного поиска: трансформацию энергетической поверхности (1) необходимо произвести таким образом, чтобы уве-

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

личить глубину глобального минимума и, тем самым, увеличить вероятность его отыскания.

Предложенный алгоритм

В этом разделе мы опишем предлагаемый алгоритм минимизации.

Главным его элементом является трансформация энергетической поверхности функционала.

Трансформировать описываемую квадратичной формой E1 ( S ) поверхность можно только трансформируя матрицу, на которой она построена. Подставим матрицу, которую мы назовём микс-матрицей:

1 z

z 2

(4)

M

T

T ,

T

2T

где T 2 – матрица, получаемая возведением матрицы T в квадрат с последующим обнулением диагональных элементов, T и T k - среднеквадратичное отклонение матриц T и T 2 соответственно, в выражение (1). Изменяя параметр z от 0 до 1 перейдем от матрицы Т к матрице М = Т2.

Соответственно, поверхность, описываемая функционалом E ( S ) , трансформируется в поверхность, описываемую функционалом Ez ( S ) :

Ez ( S )

1

M N 2

N

N

M

i 1 j 1

ss ,

ij i j

(5)

где Ez ( S ) - трансформированный функционал, M – стандартное отклонение элементов матрицы М.

При трансформации поверхности изменяются глубина и ширина области притяжения глобального минимума. Также он сдвигается в пространстве, поэтому мы предлагаем следующий двухэтапный алгоритм минимизации:

На первом шаге выполняется спуск по поверхности Ez ( S ) и находится

конфигурация минимума S m функционала Ez ( S ) .

Второй шаг включает коррекцию, а именно, из точки S m , мы спускаемся по E ( S ) до ближайшего минимума S m функционала E ( S ) .

Спуск по поверхности выполняется как было описано выше, в п. 2.

В работе [9] был рассмотрен простейший случай трансформации, с

матрицей M T k , k 2,3, 4,5 . Было показано, что оптимальным значением степени является k 3 , в этом случае вероятность отыскания гло-

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

бального минимума в 70% случаев повышается примерно на 3 порядка.

Однако в остальных 30% случаях, вероятность может снизиться до нуля

из-за исчезновения минимума Ez ( S ) вблизи S0 .

В связи с этим, в данной работе мы варьируем параметр z от 0 до 1 ,

повышая таким образом надёжность алгоритма. Будет показано, что при

z 0.5 предложенная трансформация приводит к значительному увеличению глубины глобального минимума, при этом уход от минимума будет

сравнительно меньшим (1–2 % от N ) нежели при M T 3 (3 % от N).

Корректность алгоритма

Теоретическое обоснование алгоритма даётся только для случая «случайных» матриц, когда матричные элементы являются независимыми

случайными переменными. Применение предложенного алгоритма для

матриц других типов будет эвристическим.

А. Углубление минимума.

Покажем, что трансформация приводит к углублению минимума. Рассмотрим энергию Ez 0 Ez ( S0 ) в точке S0 . Следуя (3), получим

M (1 z )

T0 T1

T 2 T0T1 T1T0 T12

z 0

.

T

2T

С учетом того, что S0 T1 S0 0 и 2M (1 z) 2 z 2 , из (5) получим:

Ez 0 E z 0 R ,

Ez 0

где

R

(1 z )r0 zr

1

N 2 (1 z ) 2 z 2

2

0

(1 z ) z

2

N

N

2

(6)

,

(1 z )T1 zT12

s0i s0 j .

T

2T ij

j i

N

i 1

В пределе N 1 , Ez 0 можно рассматривать как нормально распределенную величину со средним Ez 0 и относительно небольшим шумом R

со стандартным отклонением порядка R 1/ N .

Изменение энергии при трансформации оценивается формулой:

Ez 0 (1 z ) z N r0

.

(7)

E0

(1 z )2 z 2

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

С учётом Nr0 1.35 , очевидно, что при некотором z отношение (7)

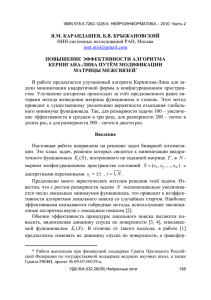

будет больше единицы, значит при N 1 можно со стопроцентной уверенностью считать, что минимум углубится. Рис. 1 подтверждает это.

Наибольшее углубление ( Ez 0 1.6E0 ) наблюдается при z 0.6 .

E z0

E0

z

Рис. 1. Понижение энергии в точке глобального минимума при

трансформации функционала: пунктирная линия – теоретическая (10);

остальные линии – экспериментальные графики для ансамбля из 50

случайных матриц с равномерным распределением

Б. Сдвиг минимума.

Оценим, насколько сдвинется минимум при трансформации поверхности. Среднюю величину сдвига можно представить в виде d N P , где

P Pr{s0i hi( z ) 0 | s0i hi 0} – вероятность того, что направления спина s0i

и локального поля hi( z ) не совпадают. Опуская несущественные константы, величина s0 i hi( z ) может быть представлена в виде:

hi( z ) si 0 (1 z ) Nr0 zN 3/ 2 r02 H ,

(8)

где

N

(1 z )T1 z ( Nr0 T T1 T12 )

H

s0i s0 j .

T

2T

i 1

ij

Из (8) следует, что P выражается следующим образом:

P

1

( x )2

1

dx

e

2 1 x ,

2( ) 2 0

где () – интеграл вероятностей и

(9)

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

Nr0 / 1.9 ,

1

N

2

T

N

h

i 1

2

i

0.7 ,

1 z

N r0 .

z

Заметим, что при z 0 функционал Ez 0 (S ) совпадает с исходным

E1 ( S ) и сдвига действительно нет, что соответствует формуле (9) .

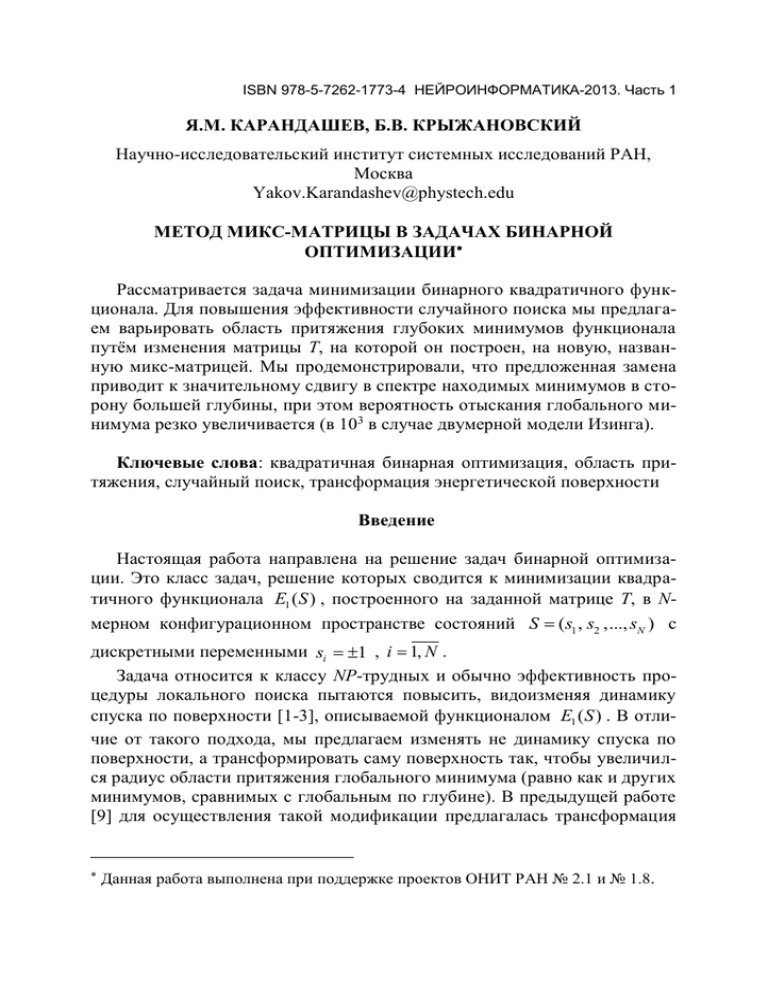

Формула (9) описывает монотонное увеличение сдвига минимума с

ростом z в связи со всё большей трансформацией функционала. Это соответствует здравому смыслу и подтверждается экспериментом (рис. 2).

d

N

z

Рис. 2. Сдвиг минимума как функция от z; кривые с планками

погрешностей получены экспериментально для двух типов матриц:

равномерные матрицы (сплошная кривая) и 2D Изинга (пунктир); штрихпунктирной линией показана теоретическая кривая (9)

Из выражений (7) и (9) можно сделать следующие выводы. Трансформация поверхности с подавляющей вероятностью приводит к углублению

минимумов и, как следствие, к увеличению вероятности их отыскания.

Причем, величина углубления (7) тем больше, чем больше изначальная их

глубина E0 r0 . Иными словами, глубокие минимумы становятся еще

более глубокими, и вероятность их отыскания становится еще больше, а

мелкие минимумы становятся еще мельче (или вовсе исчезают) и вероятность их отыскания становится еще меньше. Это означает, что спектр минимумов, находимых с помощью предлагаемого алгоритма, существенно

сдвинется в сторону глобального минимума, а вероятность отыскания

последнего существенно возрастет. Вызываемый трансформацией пространственный сдвиг минимума относительно невелик: из (9) следует, что

наименьшие сдвиги ожидаются для наиболее глубоких минимумов.

Результаты

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

Эффективность предложенного двухэтапного алгоритма была проверена для различных z от 0 до 1 для матриц размера N 100 500 двух

сортов: матрицы с элементами, имеющими равномерное распределение в

интервале (1;1) и матрицы двумерной модели Изинга [2].

В процессе численных экспериментов строилась mix-матрица при значениях z от 0 до 1 с интервалом z 0.05 . Результаты экспериментов

усреднялись по ансамблю из 50 матриц каждого размера и типа.

Каждый эксперимент включал в себя по N runs 106 стартов. Главным

образом, мы следили лишь за средней энергией Emean найденных минимумов, а также за вероятностью попадания в интервал энергий, близких к

глобальному, а именно с энергией в интервале E [1; 0.99] , где за

1 принята энергия E0 .

В экспериментах мы попробовали использовать не только миксматрицу (4), но также смесь с матрицей T 3 . В этом случае микс-матрица

строилась аналогично (4), где T 2 заменялось на T 3 .

Результаты экспериментов показаны на рис. 3, 4.

Emean / E0

uniform

2d Ising

z

Рис. 3. Среднее значение энергии локальных минимумов, найденных с

помощью предложенного двухступенчатого алгоритма: сплошные линии

– для mix-матрицы с Т2, пунктирные – для mix-матрицы с Т3; два типа

матриц – равномерные (uniform) и матрицы Изинга; величина средней

энергии Еmean нормирована на энергию глобального минимума E0 и

практически не зависит от N

Как видно из рис. 3, с ростом z величина Emean приближается к E0 .

Для mix-матрицы с T 2 наблюдается максимум при z 0.7 , в то время как

для mix-матрицы с T 3 рост монотонный вплоть до z 1 .

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

lg( Pnew / P1 )

lg( Pnew / P1 )

uniform, N=500

2D Ising, N=122

P1 3 105

z

P1 2.6 107

z

Рис. 4. Логарифм отношения вероятностей попадания в интервал энергий

[1, 0.99] : сплошные линии – mix-матрица с Т2, пунктирные – mixматрица с Т3; при малых z на некоторых матрицах (Изинга) алгоритм не

находил глобальный минимум, поэтому точки отсуствуют.

На рис. 4 показано во сколько раз увеличивается вероятность нахождения минимумов с энергией, отличающейся от глобальной меньше чем

на 1% . Для демонстрации мы выбрали максимально возможные размерности задач, с которыми мы ещё можем справиться с помощью обычного

случайного поиска. Для матриц двумерного Изинга уже при размерности

N 122 вероятность отыскания минимумов с энергией E [1; 0.99] не

больше чем P1 3 107 . Для равномерных матриц максимальная размерность N 500 (вероятность P1 3 105 ). Вероятность, получаемую при

помощи нового алгоритма, мы обозначили как Pnew . Разница между Pnew и

P1 оказалась огромной – примерно на 3 порядка величины (см. рис. 4).

Интересно, что для равномерных матриц ход кривых (см. рис. 3-4) для

матриц с T 2 и T 3 практически совпадает, лишь при z 0.7 кривые начинают расходиться. Для матриц Изинга имеет место другая картина: mixматрица с T 2 имеет явное преобладание вплоть до z 0.8 , после чего

начинает преобладать mix-матрица с Т3.

Видно также (рис. 4), что с ростом z начинает увеличиваться дисперсия, что потенциально может привести к нестабильности алгоритма, т.е.

для некоторых задач трансформация функционала может привести не к

улучшению поиска, а наоборот, к ухудшению.

Заключение

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

В работе был предложен новый подход к задаче бинарной квадратичной оптимизации. Он позволяет улучшить случайный поиск для нахождения оптимальных и субоптимальных решений. Предложенный метод состоит не в изменении динамики спуска по энергетической поверхности

функционала, а в изменении статики, т.е. трансформации энергетической

поверхности. В качестве динамики спуска использовалась простейшая

нейросетевая динамика Хопфилда [4].

Сравнение показывает, что трансформация поверхности приводит к

существенному повышению эффективности оптимизационного алгоритма. Так при z 0.7 (см. рис. 3) удалось сократить в 2 раза величину

( E0 Emin ) / E0 (относительную разницу между средней энергией находимых минимумов и глобальным). Вероятность нахождения субоптимальных решений, по энергии отличающихся от глобального минимума меньше чем на 1% , увеличилась благодаря предложенному алгоритму на 2.5

порядка для равномерных матриц размерности N 500 и более чем на 3

порядка для матриц двумерной модели Изинга размерности N 122 .

Список литературы

1. Kernighan B.W., Lin S. An Efficient Heuristic Procedure for

Partitioning Graphs// Bell System Tech. Journal, 1970. 49. Р. 291– 307.

2. Hartmann A.K., Rieger Н. New Optimization Algorithms in Physics.

Wiley, Weinheim, 2004.

3. Dang С., Ma W., Liang J. A deterministic annealing algorithm for

approximating a solution of the min-bisection problem.// Neural Networks,

2009. 22 (1). Р. 58–66.

4. Hopfield J.J. Neural Networks and physical systems with emergent

collective computational abilities.// Proc.Nat.Acad.Sci.USA, 1982. V. 79. Р.

2554-2558.

5. Kryzhanovsky B.V. Expansion of a matrix in terms of external products

of configuration vectors.// Optical Memory and Neural Networks, 2007. 6 (4).

Р. 187–199.

6. Amit D.J., Gutfreund H., Sompolinsky H. Spin-glass models of neural

networks.// Phys. Rev. A, 1985. V. 32. Р. 1007-1018; Annals of Physics, 1987.

V. 173. Р. 30-67.

7. Крыжановский Б.В., Магомедов Б.М. и др. Взаимосвязь глубины

локального минимума и вероятности его обнаружения в обобщённой модели Хопфилда // ДАН, 2005. Т. 405. № 3. С. 320-324.

ISBN 978-5-7262-1773-4 НЕЙРОИНФОРМАТИКА-2013. Часть 1

8. Kryzhanovsky B.V., Kryzhanovsky V.M. The shape of a local minimum

and the probability of its detection in random search.// Lecture Notes in

Electrical Engineering, 2009. V. 24. Р. 51-61.

9. Карандашев Я.М., Крыжановский Б.В. О трансформации энергетической поверхности в задаче бинарной оптимизации // ДАН, 2009. Т. 429.

№ 4.