Теория информации и передачи сигналов

реклама

ГЛАВА 1. Теория информации

и передачи сигналов.

1.1. Основные этапы развития теории информации

и передачи сигналов.

Теория информации, в классическом ее виде, является ветвью

математической теории вероятностей и статистики [62]. Ее абстрактные формулировки применены к любой вероятностной или

статистической системе наблюдений. С этих позиций теория информации используется во многих областях, так же как и теория

вероятностей и статистика. Она играет важную роль в современной

теории связи, которая рассматривает систему связи как стохастический или случайный процесс. Талер [63] отмечает, что статистическую теорию связи часто называют теорией информации.

Математический и статистический по существу характер теории

информации подчеркивался учеными Н. Винером [64], Р. Фишером

[65], К. Шенноном [66], которые внесли значительный вклад в дело

развития этой науки. Идеи теории информации вырастают из

понятия беспорядка или энтропии в термодинамике и статистической механике. Соотношение между понятиями и математической

формой энтропии и информации рассматриваются в работах

А.Н. Колмогорова, А.Я. Хинчина, Л.Б. Бриллюэна, В.

Мандельброта, К. Пауорса, Р. Фишера и других ученых. Мера

количества информации, доставляемого данными о неизвестном

параметре, по Фишеру хорошо известна в теории математической

статистики. Эта мера является самым первым использованием

«информации» в математической статистике, она была выведена

для нужд теории статистических оценок.

Развитие техники связи в первой половине двадцатого столетия привело к возникновению теории информации связи. Элементы

теории информации и передачи сигналов рассматривались в

работах американского ученого Р.А. Хартли в 1928 г. [2], в которых

было предложено логарифмическую меру оценки информации. В

1933 г. опубликована работа В.А. Котельникова [3] в которой

впервые была сформулирована теорема о дискретном представлении сигналов с ограниченным спектром, а также дан ряд практи-

ческих рекомендаций по оценке пропускной способности сигналов

связи. В 1935г. опубликована работа Д.В. Агеева по основам теории

линейной селекции сигналов. В 1946 г. В.А. Котельников в своей

фундаментальной работе [4] заложил основные положения теории

потенциальной помехоустойчивости. Важную роль в становлении

теории и передачи информации сыграл американский математик и

инженер К. Шеннон, опубликовавший в 1947-1948 г.г. свои основополагающие работы [142] и [143], в которых сформулированы

основные положения, касающиеся количественной оценки

информации, и положившие начало теории криптографии в

современном ее понимании.

С этих работ установилось наиболее общее понимание системы связи, с помощью которой можно не только передавать и

принимать сообщения в условиях помех в канале связи, но и

сделать их закрытыми от несанкционированного доступа.

Предложенный К. Шенноном подход к анализу систем связи

стимулировал в дальнейшем их интенсивное развитие и стал

стандартным при исследовании и разработке вычислительных сетей

и систем связи, а полученное им необходимое и достаточное

условие оптимальной передачи сообщений по каналу связи вошло в

учебники.

Некоторые из положений этих работ были строго доказаны

учеными А.Я. Хинчиным и А.Н. Колногоровым, а также американским ученым Л. Файнстейном.

Дальнейшему развитию теории передачи информации

способствовало появление теорий случайных функций и статистических решений. Они позволили установить строгие количественные соотношения в теории передачи информации и сделать ее

точной наукой. К концу 40—50-х годов появились работы ставшие

классическими А.Я. Хинчина (1938 г.) по теории корреляции

стационарных случайных функций, А.Н. Колмогорова (1941 г.) и Н.

Винера (1949 г.) по интерполированию и экстраполированию

стационарных случайных последовательностей, А. Вальда (1950 г.)

по статистическим решающим функциям.

В 50-х годах 20-го века появились монографии советских

ученых, посвященные теоретическим основам теории информации.

В 1957 г. Б.Р. Левин – «Теория случайных процессов и ее применение в радиотехнике». В.С. Пугачев – «Теория случайных функций

и ее применение к задачам автоматического управления». В 1958 г.

появись монографии ученых США В.Б. Давенпорт и В.Л. Рут

[144]. В 1960 г. Д. Мидултон [145].

Позднее вышли учебники по теории информации: А. Фано

(1965 г.); М.В. Назаров, Б.И. Кувшинова и О.В. Попова (1970 г.);

А.Г. Зюко и Ю.Д.Коробова (1972 г.); Д.Д. Кловский (1978 г.);

И.В. Кузьмин и В.А. Кедрус (1977 г.); А.Г. Зюко, Д.Д. Кловский,

М.В. Назаров, Л.М. Финк (1986 г.); Л.Р. Куликовский, В.В. Мотов

(1987 г.); В.И. Дмитриев (1989 г.); В.А. Игнатов (1991 г.); В.А.

Потапов (1999 г.); В.И. Шульгин (2003 г.); [1,5—8] [14—16].

Теория информации, математическим аппаратом которой

является теория вероятностей и математическая статистика, превратились к настоящему времени в строгую и достаточно универсальную науку.

В теории информации и передачи сигналов используют методы функционального анализа, теории вероятностей и математической статистики, теории случайных функций и случайных

процессов, статистической радиотехники, теории оптимальных

статистических решений и др.

Основными в теории информации и передачи сигналов вначале были разделы по структуре сигналов, информации и помехоустойчивости.

По мере получения новых результатов в таких направлениях,

как математическое описание каналов и передачи информации,

создание методов помехоустойчивого и эффективного кодирования,

разделение линии связи, распределение, накопления и передачи

информации в сетях, а также внедрение методов теории информации в информационно измерительную технику, все больше

внимание уделяется системному оптимальному синтезу объектов

информационной техники [9—13].

Значительный вклад в развитие отдельных разделов теории

информации и передачи сигналов внесли А.Н. Колмогоров,

А.Я. Хинчин, В.А. Котльников, А.А. Харкевич, К. Шеннон,

Н. Винер, Д.Мидултон, Р.М. Фано, У. Питерсон, Р.П. Добрушин,

Л.Ф. Бородин, Д.Е. Вакман, Л.Н. Финк, Л.С. Чуткин, Б.Р. Левин,

С.Е. Фалькович, Р.Л. Стратонович, А.Г. Зюко, Н.Л. Гецов, Л.П. Пуртов и многие другие ученые. Теоретической основой системноинформационного подхода явились работы Н. Винера, А.Н. Кол-

могорова и А.Д. Хинчина которые внесли важный вклад в

понимание вероятностной природы шумовых и других случайных

процессов в рассматриваемых в кибернетических явлениях,

моделируемых в пространстве состояний систем. Это позволило в

дальнейшем решать практические задачи на уровне смыслового

понимания информации. В книге «Кибернетика» Н. Винер обратил

внимание на целесообразность рассмотрения «кирпичиков»

мироздания состоящих из элементов, устройств, систем, связи,

управления и информации. Первые три «кирпичика» образуют

произвольную структуру, четвертый характеризует целостность,

пятый – выполняет функции, а шестой – смысловое значение.

Присутствие смысловой информации в кибернетических

системах расширило понимание сущности информации в отличие

от классической постановки определения информации в системах

связи. В настоящее время существует три точки зрения на задачи

теории информации.

К теории информации в узкой классической постановке

относят результаты решения ряда фундаментальных теоретических

вопросов, касающихся повышения эффективности функционирования систем связи. Другая точка зрения состоит в том, что

глобальной проблемой теории информации следует считать

разработку принципов оптимизации системы связи в целом. В

соответствии с третьей крайней точкой зрения к компетентности

теории информации относятся проблемы, и задачи, в формулировку

которых входит понятие информации. Ее предметом считают

изучение процессов связанных с получением, передачей, отработкой, хранением и использованием информации. В такой постановке

она затрагивает проблемы многих наук, в частности кибернетики,

биологии, лингвистики и т.д. В том числе и науки о создании

технических систем.

1.2. Теория информации – основные положения

Вероятностная классическая теория информации окончательно

нашла свое оформление в работах К. Шеннона. К ее результатам

относят результаты решения ряда фундаментальных теоретических

вопросов, касающихся повышения эффективности функциониро-

вания систем связи. В основе этой теории лежит определенный

способ измерения количества информации.

Под информацией в широком смысле понимаются новые

сведения об окружающем мире, которые мы получаем в результате

взаимодействия с ним, приспособления к нему и измерения его и

преобразовании.

Информация – это сведения, являющиеся объектом хранения,

передачи и преобразования [17].

Случайный характер сообщения, сигналов, а также помех

обусловил важнейшее значение теории вероятности в построении

теории связи. Вероятностные свойства сигналов и сообщений, а

также среды, в которой передается сигнал, позволяют определить

количество передаваемой информации и ее потери. Детерминированное сообщение, т. е. заранее известное с полной достоверностью

не содержит информации, и передача его не имеет смысла.

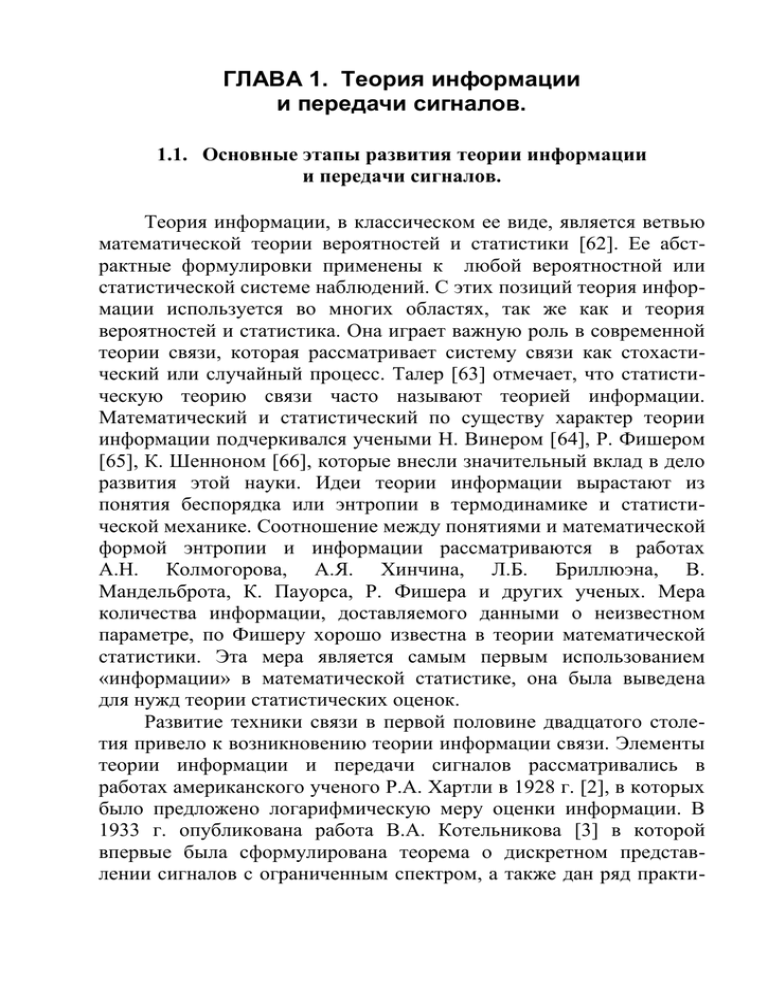

Передачу информации обеспечивает система связи (рис. 1.1).

Передающее устройство

Переобразование

сообщения в

сигнал

(кодирующее

устройство)

Принимающее устройство

b (t) Передатчик

Приемник b (t)

Линия Связи

u (t)

z(t)

Переобразование

сообщения в

сигнал

(декодирующее

устройство)

z (t)

Источник

помех

a

Источник

сообщений

Получатель

сообщений

a

Рис 1.1. Структурная схема системы связи

Система связи состоит из отправителя информации, линии

связи, и получателя информации. Сообщение для передачи его в

соответствующий адрес должно быть предварительно преобразовано в сигнал. Под сигналом понимается изменяющаяся

физическая величина, отображающая сообщение [17]. Сигнал – это

материальный переносчик сообщения.

Физическая среда, по которой происходит передача сигналов

от передатчика к приемнику, называется линией связи.

Совокупность технических средств, для передачи сообщений

от источника к потребителю называется системой связи.

Каналом связи называется совокупность средств, обеспечивающих передачу сигнала от источника сообщений к получателю.

Устройство, преобразующее сообщение в сигнал, называется

передающим устройством.

Устройство, преобразующее принятый сигнал в сообщение,

называется приемным устройством.

Все сообщения по характеру изменения во времени можно

разделить на непрерывные и дискретные.

Непрерывные по времени сообщения отображаются непрерывной функцией времени. Дискретные по времени сообщения

характеризуются тем, что поступают в определенные моменты

времени и описываются дискретной функцией времени. Так как

сообщения носят обычно случайный характер, то непрерывные

сообщения описываются случайной функцией времени, а

дискретные сообщения – как цепь случайных сообщений.

Непрерывные по множеству сообщения характеризуются тем,

что функция, их описывающая может принимать непрерывное

множество значений (континуум значений) в некотором интервале.

Дискретные по множеству сообщения – это сообщения,

которые могут быть описаны с помощью конечного набора чисел

или дискретных значений некоторой функции.

Кодирование – это отображение дискретных сообщений сигналами в виде определенных сочетаний символов.

Декодирование – осуществление обратной операции кодирования, т. е. восстановление по принятому сигналу переданного

сообщения.

Под помехами – подразумеваются любые мешающие внешние

возмущения или воздействия (атмосферные помехи, влияния

посторонних источников сигналов), а также искажения сигналов в

самой аппаратуре (аппаратурные помехи), вызывающие случайное

отклонение принятого сообщения (сигнала) от передаваемого.

При синтезе систем передачи информации решаются две

основные задачи, связанные с передачей сообщений:

1) обеспечение помехоустойчивости передачи сообщений;

2) обеспечение высокой эффективности передачи сообщений.

Под помехоустойчивостью – понимается способность информационной системы противостоять вредному действию помех.

Под верностью – понимается мера соответствия принятого

сообщения (сигнала) переданному сообщению (сигналу).

Под эффективностью системы передачи информации понимается способность системы обеспечивать передачу заданного

количества информации наиболее экономичным способом, т.е.

эффективность будет характеризовать способность системы обеспечить передачу данного количества информации с наименьшими

затратами мощности сигнала, времени и полосы частот.

С помощью преобразователя (рис. 1.1) в передающем

устройстве сообщение а, которое может иметь любую физическую

природу, преобразуется в первичный электрический сигнал в(t).

В передатчике первичный сигнал (обычно низкочастотный)

превращается во вторичный (высокочастотный) сигнал и(t), пригодный для передачи по используемому каналу. Это осуществляется

посредством модуляции.

Приемное устройство обрабатывает принятое колебание

z(t) = u(t) + ξ(t), представляющее собой сумму пришедшего искаженного сигнала и(t) и помехи ξ(t), и восстанавливает по нему

сообщение, â которое с некоторой погрешностью отражает

переданное сообщение а.

Существует различие понятий «информация» и «сообщение».

Под сообщением понимают информацию, выраженную в определенной форме и подлежащую передаче.

Теория информации связи устанавливает критерии оценки

помехоустойчивости и эффективности информационных систем, а

также указывает общие пути повышения помехоустойчивости и

эффективности. Повышение помехоустойчивости практически

всегда сопровождается ухудшением эффективности и, наоборот,

повышение

эффективности

отрицательно

сказывается

на

помехоустойчивости.

1.3. Математические модели детерминированных

сигналов

Все многообразие сигналов, используемых в информационных

системах, можно по своим особенностям разделить на две основные

группы: детерминированные сигналы и случайные сигналы. Детерминированные сигналы характеризуются тем, что в любые моменты

времени их значения являются известными величинами. Сигнал,

значение которого в любые моменты времени будут случайными

величинами, называется случайным.

Деление сигналов на детерминированные и случайные является условным, так как детерминированных сигналов в точном их

понимании в природе нет. Детерминированные сигналы рассматриваются как вырожденные, значения которых в любой момент

известны с вероятностью, равной единице. На практике любой

реальный сигнал случаен в силу воздействия на него многочисленных случайных факторов.

Исследование детерминированных сигналов позволяет:

1) использовать математический аппарат, который проще

аппарата анализа случайных сигналов;

2) полученные выводы могут быть использованы для анализа

случайных сигналов.

Сигналы по своей структуре разделяются на непрерывные и

дискретные.

Непрерывным называется сигнал, который принимает непрерывное множество значений на некотором отрезке времени и в

диапазоне, ограничивающем его максимальную и минимальную

величины.

Дискретным называется сигнал, принимающий конечное множество значений в определенном интервале времени и диапазоне

величин, т.е. сигнал являющийся дискретным как по времени, так и

по уровню.

Сигнал являющийся дискретным по времени, или только по

уровню принято называть дискретно-непрерывным.

Математической моделью – называют систему математических соотношений, описывающих изучаемый процесс или явление.

Построение математических моделей называют математическим

моделирование [18].

Физическими характеристиками сигналов являются длительность T, ширина спектра ∆Fc, динамический диапазон

D = 10 lg(P/Pn) Динамический диапазон характеризует отношение

наибольшей мгновенной мощности (Pmaх = Р) к наименьшей

(Pmin ≥ Рn).

Более общая характеристика – объем сигнала:

Более общая характеристика – объем сигнала:

Vс = T∆FcD.

Важной характеристикой сигналов является база.

υ = 2T∆Fc.

Если υ ≤ 1, то сигнал называют узкополосным (простым).

Если υ > 1, то широкополосным (сложным).

Методы математического описания сигналов и помех объединяет обобщенная спектральная теория сигналов. Наибольшее

распространение получили методы, использующие представление

сигналов в виде колебаний (функций времени) и спектрального

разложения на синусоидальные и косинусоидальные составляющие

(преобразование Фурье). Совокупность методов представления

сигналов имеет вид [8].

S (t ) aê k (t ), t [t1 , t2 ] .

k 0

(1.1)

Реальный сигнал представлен в виде суммы ортогональных

составляющих огромным числом способов. Интервал [t1, t2] показывает время действия сигнала.

Представление (1.1) называют разложением сигнала по системе базисных функций. К системе базисных функций предъявляют

следующие требования:

1) для любого сигнала ряд должен сходиться;

2) функции (t ) должны иметь простую аналитическую форму;

3) коэффициенты ак должны вычисляться относительно просто.

Эти трем условиям удовлетворяют системы ортогональных

функций. Условия ортогональности функций:

t2

i (t ) k (t )dt 0 , i k .

При i k

(1.2)

t1

t2

k (t )dt Ñk .

t1

2

(1.3)

Число Сk называют нормой базисной функции

Нормированная базисная функция

k (t )

Ψk (t )

Cê

k (t ) .

(1.4)

Новая система k (t ) удовлетворяет не только условию

ортогональности, но и условию нормировки:

t2

i (t )k (t )dt ik

(1.5)

t1

0, i k

где ik

– символ Кронекера.

1,

i

k

Систему k (t ) называют ортонормированной.

Если в (1.1) система ортогональных функций k (t ) , применяемая для разложения известна, то сигнал определяется набором

весовых коэффициентов, ak, k = 0, 1, 2…, этих функций. При

приближенном представлении сигналов набор чисел ak конечен.

Такие наборы чисел называется спектрами сигналов [6, 19].

Спектры удобная форма представления сигналов в рамках линейной

теории. Основная задача – правильно выбрать системы ортогональных функций (базис), удобные для анализа прохождения сигнала

через цепи и каналы связи. Таки образом, задачи анализа сигналов

(анализа их формы, внутреннего строения, взаимосвязи элементов и

т.п.) решают с точки зрения прохождения через устройства передачи информации и способности передать информацию.

Для детерминированных сигналов наиболее распространены

методы спектрального анализа, использующие преобразование

Фурье. В роли k (t ) выступают гармонические функции, а в роли

коэффициентов ak амплитуды гармоник.

Для случайных сигналов наибольшее распространение получили методы корреляционного и спектрального анализов основанные

на преобразовании Хинчина-Винера [8]. Это преобразование,

результат распространения метода Фурье на случайные процессы.

При разложении случайных процессов коэффициенты ak -

случайные величины, а оптимальные базисы определяются через

корреляционные функции этих процессов.

Синтез сигналов может включать структурный синтез (определение формы сигналов) и параметрический (определение параметров сигналов известной формы). Если при синтезе необходимо

обеспечить экстремум функционала (или функции),, который

характеризует качество синтеза, то его называют оптимальным.

Рассмотрим определение коэффициентов ak при разложении

сигнала по системе ортонормированных функций. Представим

сигнал.

S (t ) aê (t ) , t [t1 , t2 ] .

k 0

Умножим обе части (1.6) на

интервале [t1 , t2 ] получим

i (t )

t2

t2

t1

k 0

t1

(1.6)

и, проинтегрировав на

S (t )i (t )dt ak (t )i (t )dt

Из (1.5) следует, что в правой части все интегралы при i k

будут равны 0, а при i = k один из них равен 1, следовательно,

t2

àk S (t )i (t )dt

(1.7)

t1

Ортогональное разложение (1.6) называют обобщенным рядом

Фурье, а коэффициенты (1.7), – обобщенными коэффициентами

Фурье. Ортонормированные функции удовлетворяют трем указанным ранее условиям. Выбор базисных ортонормированных функций – одна из ответственных задач, ее решение существенно зависит от характера преобразований сигналов в системе. Коэффициенты ak представляют собой эффективные значения составляющих

спектра (обобщенных гармоник), поэтому выделяемая на сопротивлении 10 м средняя мощность сигнала вычисляется по формуле:

aê2

1 t2 2

.

P

S (t )dt

t2 t1 t1

k 0 (t 2 t1 )

(1.8)

Соотношение (1.8) называют равенством Парсеваля. Из него

следует что, мощность сигнала равна сумме мощностей всех

составляющих спектра.

Определим коэффициенты, минимизирующие погрешность

ортогонального разложения. Используем среднеквадратичную

погрешность.

2

1 t2 2

2

S (t ) ak k (t ) dt

t2 t1 t1

k 0

2

(1.9)

Для минимизации 2 необходимо решит систему уравнений

2

2

0, k = 0, 1, 2 …; при условии 2 > 0 найти из решения ak опт

ak

k

подставить значения этих коэффициентов в (1.9) и определить

2min

ak2î ï ò

1 t2 2

.

S (t )dt

t1 t2 t1

k o (t1 t 2 )

(1.10)

Эту задачу решил Фурье. Он показал, что оптимальными

будут коэффициенты, определяемые по (1.7). Если число членов

ряда n< то имеется некоторая среднеквадратическая погрешность, из-за которой

n

ak2î ï ò

1 t2 2

.

S (t )dt >

(

t

t

)

t1 t2 t1

k 0 1

2

(1.11)

Если n , то это неравенство вырождается в (1.8),

следовательно, 2min 0 .

Таким образом, бесконечный ряд дает адекватное в

среднеквадратическом смысле, ортонормированное разложение

сигнала.

Для реальных сигналов всегда можно указать такое, обычное

небольшое число n при котором 80… 90% мощности заключено в

гармониках с номерами, k n . Поэтому ряды, используемые на

практике конечны, а число членов ряда определяет допустимые

среднеквадратические погрешности. Относительную погрешность

разложения определяют как отношение P(n) ошибки аппроксимации к мощности P самого сигнала:

( n )

ak2

P(n) k n 1

.

2

P

ak

(1.12)

k 0

Величина P(n) – та часть мощности, которая оказывается за

пределами используемой полосы частот и не учитывается при

восстановлении сигнала.

По допустимой относительной погрешности и из соотношения

(n) 0 не трудно определить число n удерживаемых членов ряда.

В качестве базисных сигналов используют системы ортогональных функций, Бесселя, Хаара, Уолша, системы ортогональных

полиномов Лежандра, Чебышева, Эрмита, Логгера и др. Примеры

ортогональных разложений по таким функциям и полиномам

рассмотрены в [19, 20]. Реальные сигналы, всегда ограничены во

времени и имеют неограниченный спектр. Для удобства изучения

сигналы часто рассматривают не на конечном интервале [t1 , t2 ] , а на

полубесконечном (0, ) или на бесконечном (- , ). Для

определенности начало отсчета совмещают с началом сигнала или с

серединой. Если сигнал имеет конечную длительность T = t2 – t1,

его рассматривают на интервале [0, Ò] или [– T/2, T/2]. Реальные

сигналы случайны.

Несмотря на это в теории часто рассматривают сигналы

полностью известные в любой момент. Такие сигналы называют

детерминированными. Теория детерминированных сигналов как

теория первого приближения удобна для решения простейших

задач и полезна для развития теории случайных процессов.

Для изучения взаимосвязей сигналов используют такие

характеристики, как взаимная энергия сигналов

T

2

E12 S1 (t ) S2 (t )dt ,

и взаимная мощность.

T

2

(1.13)

P12

T

2

1

S1 (t ) S2 (t )dt .

T T

(1.14)

2

Различают сигналы, ортогональные по энергии, когда E12 = 0 и

ортогональные по мощности, когда Р12 = 0. Для ортогональных

сигналов средняя мощность и энергия суммы обладают свойством

аддитивности, т.е.

P

T

2

1

2

[ S1 (t ) S2 (t )] dt P1 P2 ,

T T

(1.15)

2

T

2

E [ S1 (t ) S2 (t )]2 dt E1 E2 .

(1.16)

T

2

Сигналы ортогональные по мощности, образуют более широкий класс, частью которого являются сигналы ортогональные по

энергии. Из ортогональности по энергии следует ортогональность

сигнала по мощности, но не наоборот. Только на конечном

интервале, когда Т < , условия ортогональности по мощности и по

энергии

выполняются

одновременно.

Следовательно,

ортогональность сигналов тесно связана с интервалом их

определения. Взаимные энергия и мощность характеризуют степень

сходства сигналов. Если два сигнала полностью совпадают, то Р12 =

Р21 = Р, где Р – мощность сигналов. Такие сигналы называются

полностью когерентными. Для сигналов Р12 = Р21 = 0, сигналы

полностью некогерентные. Если 0 < P12 < P, или 0 < P21 < P, то

сигналы частично когерентны.

Большое значение имеют ортогональности постоянной S0 и

переменной S1,n, составляющих любого сигнала S(t) = S0+S1,n(t), где

постоянная составляющая определяется как среднее значение

1T

сигнала на интервале [0, Т] S0 =

S (t )dt , а переменная составT0

ляющая S1n(t) = S (t) – S0. Взаимная энергия постоянной и переменной составляющих

T

T

0

0

E0;1, n [ S (t ) S0 ]S0 dt S0 S (t )dt

S02

T

dt

0

T

(1.17)

S0 S1, n (t )dt S02T S02T 0

0

Из ортогональности S0 и S1n следует важный вывод о том, что

среднее значение переменной составляющей

T

T

T

0

0

0

S1,n (t )dt S (t )dt S0dt 0 .

Из-за ортогональности постоянной и переменной составляющих сигнала их прохождение через различные цепи может, рассматривается отдельно, а результат определяется простым суммированием.

1.4. Математические модели случайных сигналов

В реальных условиях все сигналы имеют случайный характер.

Поэтому в теории связи источник сообщения следует рассматривать

как устройство, осуществляющее выбор из некоторого множества

возможных сообщений. Каждая конкретная реализация сообщения

возникает с определенной вероятностью, которая в общем случае

зависит от того, какие сообщения передавались ранее. Посылаемая

в канал реализация сигнала является элементом некоторого

множества выбираемого с определенной вероятностью.

Множество, на котором задана вероятностная мера, называют

ансамблем.

Ансамбли сообщений и сигналов могут быть конечными (в

дискретном случае) или бесконечные.

Случайной функцией называется функция одного или

нескольких аргументов, которая при всех или некоторых значениях

этих аргументов является случайной величиной. Ансамбль {Х (t)}

функций времени является случайным процессом. Каждая входящая

функция хr(t) выборочной функцией, или реализацией процесса.

Помехи так же являются случайными процессами, и поэтому по

принятому сигналу можно лишь с некоторой вероятностью

определить, какое сообщение было передано.

Случайный процесс может быть задан на дискретном множестве значений t:t1 t2 …, т.е. дискретный по времени. Такие случайные

процессы называются случайными последовательностями. Процессы, заданные на конечном отрезке времени –Т/2 < t < T/2 называют

финитными.

Для описания вероятностных свойств случайных процессов

рассматривают одномерный, двумерный и т.д. законы (функции и

плотности) распределения [21].

Одномерная функция (интегральный закон) распределения

относящаяся только к одному какому либо сечению случайного

процесса, представляет собой вероятность того, что текущее

значение случайного процесса Х(t) в момент времени t = t, меньше

некоторой текущей неслучайной величины х1, т.е.

Fx(x1t1) = P [X(t1) < x1],

(1.18)

Одномерная плотность (дифференциальный закон) распределения есть производная от функции распределения, т.е.

f X ( x1,t1 )

FX ( x1 , t1 )

x1

(1.19)

Величина

ƒX(x1,t1)dx1 = P[x1 ≤ x(t1) < x1 + dx],

(1.20)

позволяет определить вероятность того, что случайный процесс X(t)

в момент времени t = t1 находится в интервале от х1 до х1 + dx.

В (1.18) и (1.19) первый аргумент х1 обозначает возможное

значение случайной величины X(t1) = х1, а второй аргумент t1 является параметром от которого зависят FX(x1, t1) и ƒX(x1, t1).

Двумерная функция распределения

FX(x1t ; x2, t) = P[X(t1)< x1; X(t2) < x2]

(1.21)

относится к двум произвольным сечениям X(t1), X(t2) случайного

процесса и выражает вероятность того, что в момент t1 случайный

процесс принимает значение меньше х1, а в момент времени t2 –

меньше х2.

Соответствующая двумерная плотность распределения

d2

f x ( x1 , t1 ; x2 , t2 )

Fx ( x1 , t1; x2 , t2 ) .

dx, dx2

(1.22)

Величина

ƒХ (x1,t1; x2,t2) dx1dx2=

= P[x1<X(t1) < x1 + dx1; x2< X(t2) < x2 + dx2]

(1.23)

определяет вероятность того, что случайный процесс X(t) в момент

величины t = t1 принимает значение, которое находится в интервале

от х1 до х1+ dx1, а в момент времени t = t2 в интервале от х2 до х2+ dx2.

Можно рассматривать трехмерные, четырехмерные и т.д.

функции и плотности распределения случайного процесса X(t),

однако оперировать такими сложными и громоздкими характеристиками крайне трудно.

Случайный процесс, который полностью характеризуется

одномерной плотностью вероятности, является так называемым

чистым случайным процессом или «белым шумом». Все плотности

вероятности белого шума определяются из одномерной плотности

вероятности.

ƒХ (x1, t1; x2, t2 … xntn) =

ƒх (x1, t1) · ƒх (x2, t2)· … ƒХ (xn, tn).

(1.24)

Существует особый класс случайных процессов, впервые исследованных известным математиком А.А. Марковым и называемых марковскими случайными процессами, для которых знание и

значение процесса в момент tk уже содержит в себе всю информацию о будущем ходе процесса, какую только можно извлечь из

поведения процесса до того момента. В случае марковского

случайного процесса для определения вероятностных характеристик процесса в момент tm достаточно знать вероятностные

характеристики для любого одного предшествующего момента tk.

Для марковского процесса справедливо следующее соотношение:

f ( x1 , t1 ; x2 , t2 ; ...xntn )

f ( x ,t ; x ,t ) f ( x ,t ; x ,t )... f ( xn 1 ,tn 1; xn ,tn ) .

1 1 2 2 2 2 3 3

f ( x1,t1 ) f x ( x2 ,t2 )... f ( xn 1,tn 1 )

(1.25)

Марковские процессы полностью характеризуются двумерной

плотностью вероятности.

Вероятностными характеристиками случайных процессов

являются функции: математическое ожидание, дисперсия,

среднеквадратическое отклонение и корреляционная функция.

1. Математическим ожиданием или средним по множеству

случайного процесса Х(t) называется неслучайная функция mх(t),

которая при каждом значении аргумента t равна математическому

ожиданию соответствующего сечения случайного процесса. Для

дискретной случайной величины

n

mX M X (t ) pi xi (t ) ,

i 1

для непрерывной случайной величины

m Õ (t ) M [ Õ (t )] x f Õ ( x, t )dt ,

(1.26)

где p i – вероятность события случайной величины,

ƒх (x, t) – одномерная плотность распределения случайного процесса для его сечения в момент времени t;

х – возможное значение случайной величины, соответствующее

рассматриваемому сечению процесса.

Математическое ожидание случайного процесса представляет

собой некоторую среднюю кривую, вокруг которой различным

образом группируются все возможные отдельные реализации этого

процесса.

Часто рассматривают так называемый центрированный случайный процесс, под которым подразумевается отклонение случайного процесса от среднего значения

X (t ) X (t ) mX (t ) .

(1.27)

Тогда случайный процесс равен

X (t ) X (t ) mX (t ) .

Математическое ожидание (среднее по множеству) случайного

процесса Х(t) может быть определено по отдельным его реализациям xv(t). При t = ti значения реализаций представляют x1(ti),

x2(ti)… xn(ti) возможные значения случайной величины, математическое ожидание которой находим как среднее арифметическое

значение:

1 n

mX (ti ) xv (ti ) .

n v 1

(1.28)

2. Дисперсией по множеству случайного процесса Х(t) называется неслучайная функция Dх(t), равная математическому ожиданию квадрата разности между Х(t) и его математическим ожиданием mx(t).

2

DX (t ) M X (t ) mX (t )

2

x mX (t ) f ( x, t )dt

(1.29)

Дисперсия по множеству реализаций случайного процесса Х(t)

для каждого момента времени t1 рассчитывается по известным его

реализациям xv(ti)

1 n

DÕ (t ) [ xv (ti ) mx (ti )]2 .

(1.30)

n v 1

3. Средним значением квадрата случайного процесса называется величина

x 2 (t ) M x(t ) = x 2 f Õ ( x, t )dt .

(1.31)

при этом математическое ожидание mx(t), дисперсия Dx(t) и среднее

значение квадрата х2(t) случайной величин связаны соотношением:

x 2 (t ) DÕ (t ) mÕ2 (t ) .

(1.32)

4. Среднеквадратическое отношение случайного процесса Х(t)

представляет собой положительное значение корня квадратичного

из дисперсии.

x (t ) DÕ (t ) .

(1.32)

5. Среднеквадратическое значение случайного процесса равно

положительному значению квадратного корня из среднего значения

квадрата случайного процесса

xck (t ) x 2 (t ) DÕ (t ) mx2 (t ) .

(1.34)

6. Корреляционной (автокорреляционной) функцией по множеству случайного процесса называется неслучайная функция Rx(t1,

t2), равная математическому ожиданию произведения значений

центрированного случайного процесса X (t ) , взятых при двух

моментах времени t1 и t2

RX (t1 , t2 ) M X (t1 ) X (t2 )

.

x1 x2 f Õ ( x1 , t1 ;x2 , t2 )dx1dx2

(1.35)

При t1 = t2= t корреляционная функция равна дисперсии.

RX(t1, t2)| t1 t2 t = RX(t, t) = D(t),

(1.36)

или при t1 ≠ t2

RX (t1 ,t2 ) DÕ (t1 ) DÕ (t2 ) ,

RX(t1, t2) ≤ σx(t1) σx(t2).

(1.37)

(1.38)

7. Нормированная корреляционная функция равна

rx (t1 , t2 )

RX (t1 , t2 )

x1 x2

RX (t1 , t2 )

.

D X 1 , DX 2

(1.39)

8. Корреляционную функцию по множеству случайного процесса Х(t) по известным из опыта его реализациям xv(ti), где v = 1, 2,

3 … n.

1 n

RÕ (ti ; tk ) [ x (ti ) m(ti )] [ x (tk ) m(tk )] .

n 1

(1.40)

9. Для процессов Х(t) и Y(t) совместная функция распределения

Fxy(x, t; y, t2) = P[X(t1) < x; Y(t2) < y],

(1.41)

совместная плотность распределения определяется выражением

2

f XY ( x, t1 ; y, t2 ) FXY ( x, t1 ; y , t2 ) .

xy

(1.42)

10. Взаимной корреляционной функцией по множеству двух цент

рированных случайных процессов X (t) и Y (t) называется неслучайная функция RXY(t1, t2)

Rxy (t1 , t2 ) M X (t1 ) Y (t2 )

(1.43)

xyf XY ( x,t1; y, t2 )dxdy

При t1 = t2 = t взаимная корреляционная функция Rxy(t1, t2) условно называется взаимной дисперсией Dxy(t).

Dxy(t) = RXY (t, t)

(1.44)

В случае тождественного равенства нулю взаимной корре

ляционной функции случайные процессы X (t) и Y (t) называются

некоррелированными, а если не равна нулю, то коррелированными

случайными процессами.

11. Случайные процессы делятся на две группы: стационарные и нестационарные. Стационарным называется случайный процесс, у которого определенная группа вероятностных характеристик

инвариантна во времени, т.е. не изменяется при сдвиге времени –

замене аргумента t значением t + t , где t произвольный интервал

времени.

Стационарным в узком смысле случайным процессом Х(t)

называется процесс, для которого плотность распределения ƒХ(x1, t1;

x2, t2; … xn, tn) зависит при любом n только от интервалов t , и не

зависит от положения этих интервалов в области изменения

аргумента t.

Стационарным в широком смысле процессом Х(t) называется

процесс, математическое ожидание и дисперсия которого с течением времени остаются постоянными

M [ X (t )] mX (t ) mX const ,

(1.45)

D[ X (t )] DX (t ) DX const ,

(1.46)

а корреляционная функция зависит только от разности r =t1 – t2

RX(t1t2) = RX(t1 – t2) = RX( t ).

(1.47)

Стационарно связными в широком смысле являются случайные процессы Х(t) и Y(t) одного и того же аргумента t, если их

взаимная корреляционная функция зависит только от разности

аргументов t1 – t2= t .

RXY(t1, t2) = RXY(t1 – t2) = RXY( t ).

(1.48)

Стационарный случайный процесс Х(t) называется эргодическим, если с вероятностью, близкой единице, средне по множеству для соответствующей вероятностной характеристики равно

среднему по времени.

Стационарная в узком и широком смысле случайная функция

Х(t) является эргодической по отношению к ее математическому

ожиданию mx, если имеет место соотношение [22].

2

1 t 0 T

(1.49)

lim M X (t )dt mX = 0,

T T

t0

1 T

t

1

RX (t) 0 .

T T 0

T

lim

(1.50)

Стационарная случайная функция Х(t) является эргодической

по отношению к ее корреляционной функции RX( t ), если имеет

место соотношение

2

1 t0 T

lim M X (t ) mX X (t t) mX dt RX (t) 0 . (1.51)

T t0

Условие эргодичности стационарной нормальной случайной

функции Х(t) по отношению к ее корреляционной функции имеет

вид

t

1T

lim (1 1 )[ RX2 (t1 ) RX (t1 t) RX (t1 t)]d t1 0 .

T T 0

T

(1.52)

12. Рассмотрим основные вероятностные характеристики свойств стационарных эргодических случайных процессов – среднее по

множеству равно среднему по времени, для основных его

вероятностных характеристик.

Математическое ожидание или среднее значение

1 T

Ì [ X (t )] x (t ) или mX xf ( x)dx lim

x(t )dt .

T

2

T

T

(1.53)

Дисперсия. Среднее по множеству, равное среднему по времени одной реализации

M [( X m)2 ] M [X 2 ] mX2 x 2 (t ) [ x(t )]2

DX ( x mX ) 2 f X ( x)dx

или

lim M

T

1

1

2

x (t )dt lim

x(t )dt

2T T

2T T

T

T

2

.

(1.54)

Среднее квадратичное отклонение случайного процесса Х(t)

равно

1 Ò 2

X

x (t )dt

2T T

(1.55)

Корреляционная функция. При определении корреляционной

функции, характеризующей стохастическую связь между значениями случайного процесса Х(t) в момент времени t и t + t , среднее

по множеству реализаций

M [ X (t ) X (t t)] x(t ) x(t t)

или

RX (t) x1 x2 f X ( x1 , x2 , t)dx1dx2

Ò

(1.56)

1

x(t ) x(t t)dt.

T 2T

Ò

lim

Если t = 0, то корреляционная функция равна дисперсии случайного процесса:

1 T 2

(1.57)

RX (0) lim

x (t ) 2 DX .

T 2T

T

Размерность корреляционной функции совпадает с размеренностью дисперсии, т.е. равна квадрату размерности процесса.

Физическая сущность корреляционной функции заключается в том,

что она, так же, как и дисперсия представляет собой среднюю

мощность переменной составляющей процесса.

Корреляционная функция являясь «мощностной» характеристикой случайного процесса, не несет информации о фазе реального

случайного процесса.

Два процесса Х(t) и Y(t) называются совместно эргодическими,

если усреднение функций от тех по множеству реализаций с

вероятностью, близкой единицы, дает тот же результат, что и

усреднение по времени одной реализации

M [ X (t ) Y (t

t)] x(t ) ó(t t)

или

RXY ( t) xyf XY ( x, y, t)dxdy

1 T

lim

x(t ) y (t t)dt

T 2T

T

Нормированные корреляционные функции имеют вид

(1.58)

rXY (t)

R XY (r )

R (t)

R (t)

XY

XY .

Õ Ó

RÕ (0) RÓ (0)

D Õ DÓ

(1.59)

13. Спектральной плотностью Sx( ) стационарного, (в широком смысле слова) случайного процесса, называется прямое преобразование Фурье корреляционной функции Rx( t )

S Õ () RX (t)e jt d t ,

(1.60)

где – параметр преобразования Фурье.

Применяя обратное преобразование Фурье к спектральной

плотности SX( ); можно получить корреляционную функцию

1

jt

RX (t)

S X ()e d .

2

(1.61)

Формулы были получены в одно и то же время учеными

А.Я. Хинчином и Н. Винером, и называются формулами ВинераХинчина.

Основные свойства спектральной плотности стационарной

случайной функции следующие.

Спектральная плотность является вещественной четной

неотрицательной функцией

S X () RX (t)e

jt

d t RX (t)cos td t

(1.62)

j RX (t)sin td t.

Корреляционная функция Rx( t ) является четной функцией t ,

поэтому

RX (t)sin td t = 0,

таким образом

S X () RX (t)cos td t ,

(1.63)

S () S () .

(1.64)

Из (1.60) и (1.61) следует с учетом свойств четности спектральной плотности

S () 2 RX (t)cos td t ,

(1.65)

0

1

RX () S ()cos td t .

0

(1.66)

Интеграл от спектральной плотности равен дисперсии или

квадрату среднего квадратического отношения стационарной случайной функции

DX = 2X = RX(0)

поэтому

DÕ

2Õ

1

S ()d

2

(1.67)

Изменение масштаба m переменной t в корреляционной

функции приводит к соответствующему обратному изменению

как масштаба переменной в спектральной плотности, так

и самой величины спектральной плотности. Корреляционной

функции Rm(τ) = RX(mτ), будет соответствовать спектральная плот1

ность Sm( ) = SX .

m m

Нормированная спектральная плотность имеет вид

S X ()

S X ()

,

(1.68)

S X () S X () S X ()

,

2

DX

R X (o )

X

(1.69)

S X ()d

или с учетом (1.67):

S X ()

или с учетом (1.63) выражаем через корреляционную функцию

S X ()

RX (t)cos td t

.

2

X

(1.70)

Так как корреляционная функция RX( t ) = 2X rX( t ) где rX( t ) –

нормированная корреляционная функция, то нормированная спектральная плотность будет иметь вид

S Õ () rÕ (t)cos td t 2 rx (t)cos td t .

(1.71)

Физический смысл спектральной плотности выражается значением корреляционной функции при r = 0 (1.57) и (1.67)

1 2

1

RÕ (0) DÕ lim

õ(t )dt S Õ ()d .

T 2

(1.72)

Так как дисперсия эргодического процесса с физической точки

зрения представляет собой среднюю мощность переменной составляющей процесса, то физическая сущность спектральной плотности

SX( ) заключается в том, что она представляет собой распределение

мощности процесса по частотному спектру.

Поэтому SX( ) называют спектральной плотностью мощности

стационарного случайного процесса. Спектральная плотность мощности случайного процесса не имеет информации о фазе и поэтому

SX( ) не дает возможности восстановить с помощью обратного

преобразования Фурье (1.61) какую либо реализацию процесса.

Взаимная спектральная плотность SXY( ) и взаимная

корреляционная функция RXY( t ) двух совместно эргодических

процессов Õ (t) и Y (t) связаны соотношениями прямого и обратного

преобразования Фурье.

S XY () RXY (t)e jt d t ,

(1.73)

RXY (t)

1

jt

S XY ()e d .

2

(1.74)

14. Основные свойства взаимной спектральной плотности.

Взаимная спектральная плотность SXY( ) является комплексной величиной, причем вещественная часть ее Dхy ( ) есть четная

функция , мнимая Qxy( ) нечетная функция .

S XY () RXY (t)cos td t j RXY (t)sin td t ,

S XY () Re[ S XY ()] j Im[ S XY ()] ,

или

(1.75)

S XY () RXY () jQXY () .

(1.76)

(1.77)

В соответствии с (1.74) и (.177)

1

1

RXY (t)

RXY ()cos td

QXY ()sin td

2

2

(1.78)

1

[ RXY ()cos t QXY ()sin t]d.

Взаимная дисперсия случайных функций равна интегралу в

бесконечных пределах от взаимной спектральной плотности или от

ее вещественной части

DXY

1

RXY (0)

S XY ()d ,

2

(1.79)

или

DXY

1

1

RXY ()d

Re[ S XY ()]d .

2

2

(1.80)

Для вычисления взаимной дисперсии подынтегральное выражение является вещественной четной функцией .

Изменение масштаба переменной τ у взаимной корреляционной функции приводит к соответствующему обратному изме у взаимной спектральной

нению масштаба переменной

плотности. Если Rxy( t ) соответствует Sxy( ) то Rxy(m t ) соответст1

вует Sxy . Это свойство можно получить из (1.74).

m m

Нормированная взаимная спектральная плотность определяется соотношением

S XY ()

S XY ()

S

(

)

d

S

(

)

d

X

Y

,

(1.81)

или в соответствии с (1.67)

S XY ()

S XY () S XY ()

,

X Y

DX DY

(1.82)

или в соответствии с (1.79)

S XY ()

jt

RXY (t)e d t

DX DY

.

(1.83)

Нормированная взаимная спектральная мощность через

нормированную взаимную корреляционную функцию будет иметь

вид

S XY () rXY (t)e jt d t ,

(1.84)

Взаимные спектральные плотности SXY( ) и SYX( ) являются

комплексно сопряженными величинами, как и взаимно корреляционные функции

S XY () SYX ( )

SYX () S XY ( )

RXY (t) RYX ( t)

RYX (t) RXY ( t)

(1.85)

Так как свойства взаимных корреляционных функций аналогичны свойствам корреляционных функций

RXY(t1, t2) = RYX(t2, t1).

1.5. Случайные процессы

Под случайными процессами понимается функция времени Xt,

значениями которой являются случайные величины. Таким образом, случайный процесс можно рассматривать как семейство случайных величин {Xt}, где t – временной параметр.

Функция, полученная в результате наблюдения над случайным

процессом, называется выборочной функцией или реализацией

случайного процесса. Выборочная функция ставит в соответствие

каждому значению временного параметра t T одно из возможных

значений случайной величины Xt. Область возможных значений

функции Xt называют пространством состояния L случайного

процесса.

Конкретные значения хt случайного процесса Xt, наблюдаемые

в ходе эксперимента времени t, является неслучайными величинами, поэтому любую реализацию случайного процесса, полученную в результате наблюдения, следует рассматривать как детерминированную функцию времени.

В общем случае с помощью одной реализации нельзя дать

полную характеристику случайного процесса. Каждая новая реализация, полученная в результате наблюдения, дополняет сведения о

свойствах этого процесса. Поэтому понятие о случайном процессе

так же связывают с некоторым ансамблем функций – множеством

функций (в общем случае бесконечным) заданных явно или с

помощью какого либо признака с определенной на нем вероятной

мерой.

Ансамблем функций случайных процессов могут служить

множества:

– конечное или счетное множество функций xk(t) (k = 1, 2, …)

на котором задано распределение вероятностей {Pk}, где

Pk = P[Xt = xk(t)];

- множество функций xф (t) = Asin(ωt + Ф), где Ф – случайная

величина, плотность распределения которой f(φ);

- множество функций

y (t ) yk

k

sin (2 F k )

,

(2 F k )

(1.86)

где Yk – независимые, нормально распределенные случайные величины.

Признаки, по которым классифицируются случайные процессы, связано:

1) свойствами пространства состояний L;

2) временного параметра Т;

3) статической зависимости {Xt}.

По признакам, связанным с пространством состояний, обычно

выделяют два класса случайных процессов:

1) если множество возможных значений случайных величин

{Xt} конечно или счетное, то процесс относят к классу случайных

процессов с дискретным пространством состояний и к названиям

процессов данного класса обычно добавляют слово «дискретный»;

2) процессы, для которых пространство состояний эквивалентно множеству действительных чисел, относят к классу случайных

процессов с непрерывным пространством состояний, (иногда такие процессы называют действительными случайными процессами.

Другим признаком, по которому осуществляется классификация случайных процессов, является временный параметр Т. При

рассмотрении случайных процессов как последовательности

переходов во времени от одного состояния к другому можно выделить класс процессов, для которых переходы возможны в любые

моменты времени на конечном или бесконечном промежутке

времени Т. Процессы, обладающие этим свойством называются:

случайными процессами с непрерывным временем.

Для другого класса процессов переходы от состояния к

состоянию могут происходить лишь в строго определенные, заранее

обусловленные моменты времени t0, t1, …, составляющие конечное

или счетное множество Т множеств времени называются – случайными процессами с дискретным временем.

Третьим признаком, по которому может осуществляться

классификация случайных процессов, является пространственный

параметр Rn (n – мерное пространство R).

При проявлении случайных процессов во времени в любом

месте пространства, такие процессы называются – 1) случайные

процессы с непрерывным метрическим пространством. Для

другого класса процессов, которые могут проявляться во времени

только на конкретном пространстве называются – 2) случайные

процессы с дискретным метрическим пространством.

Таким образом, в зависимости от того, являются множества L,

T и Rn конечными, счетными или мощности континуума различают

девять основных типа случайных процессов.

1. Дискретный случайный процесс с дискретным временем и

дискретным метрическим пространством;

2. Дискретный случайный процесс с непрерывным временем и

дискретным метрическим пространством;

3. Дискретный случайный процесс с дискретным временем и

непрерывным метрическим пространством;

4. Непрерывный случайный процесс с дискретным временем и

дискретным метрическим пространством.

5. Непрерывный случайный процесс с непрерывным временем

и дискретным метрическим пространством.

6. Непрерывный случайный процесс с дискретным временем и

непрерывным метрическим пространством.

7. Дискретный случайный процесс с непрерывным временем и

непрерывным метрическим пространством.

8. Непрерывный случайный процесс с дискретным временем и

непрерывным метрическим пространством.

9. Непрерывный случайный процесс с непрерывным временем

и непрерывным пространством.

Еще одним признаком, который учитывается при классификации случайных процессов, является зависимость случайных величин {Xt}. Известно, что для математического описания конечного

семейства случайных величин Xt1, Xt2, …, Xtn используются n – мерные законы распределения. В общем случае для исчерпывающего

математического описания случайного процесса Xt, представляющего собой бесконечное семейство случайных величин, необходимо

использовать бесконечно мерные законы распределения.

Поэтому случайные процессы описывают либо приближенно,

используя конечномерные распределения, либо, накладывая специфические ограничения на характер зависимости случайных величин

{Xt}, дают конечномерными распределениями исчерпывающее описание случайного процесса.

И так, чтобы задать случайный процесс, нужно описать

пространство состояний L случайного процесса, временной пара-

метр Т, метрическое пространство Rn, в котором проявляется

случайный процесс, и задать n – мерный закон распределения

семейства случайных величин f X {Xt}, t T .

Стандартные распределения дискретных случайных величин..

1. Биноминальное

распределение

имеет

вид:

N!

pk

p k q N k , где вероятность ð k равна вероятности появk !( N k )!

ления события А k раз в N независимых опытах при условии, что в

каждом опыте это событие появится не более одного раза и с

вероятностью, равной р и не появилось q=1 – p в остальных N–k

опытах. Для случайной величины x, распределенной по

биноминальному закону с параметрами p и q, основные

характеристики равны: mX Np , DX Npq , X Npq .

ak a

2. Распределение Пуассона имеет вид: pk e , и является

k!

предельным для биноминального, когда число N опытов

неограниченно увеличивается, а параметр ð 0, но так,

что их произведение сохраняется в пределе постоянным и

равным а. Основные характеристики равны: m X a , DX a ,

X DX a .

3. Геометрическое распределение имеет вид: pk q k p , вероятности pk для последовательных значений k образуют геометрическую прогрессию с первым членом p и знаменателем q; основные

характеристики равны mX q / p, DX q / p 2 , X q / p ;

Стандартные распределения непрерывных случайных величин

в технических системах.

1. Нормальное распределение имеет вид:

f ( x)

1

( x mX )2

e

2 2X

,

X 2

где mХ и X – соответственно, представляют математическое

ожидание и среднее квадратическое отклонение случайной величины. Нормальное распределение возникает в тех случаях, когда

складываются многие независимые случайные величины Х1, Х2, …,

Хп.

X

1

при

X

ba

a < х < b. Числовые характеристики случайной величины Х, имеюab

(b a)2

щей равномерное распределение: mX

; DX

;

2

12

ba

X

.

2 3

3. Распределение Симпсона имеет вид:

2. Равномерное распределение имеет вид: f ( x)

2

2

b a (b a)2 a b 2 x , x a, b

.

f X ( x)

0, x a, b

Случая величина Х имеет треугольное распределение на

4

отрезке [à, b] . Числовые характеристики mX

[a 2 b 2

2

(b a)

2

(b a)2

ab

.

2

, DX

24

2

Определение вида закона распределения случайной величины

по опытным данным занимает одно из центральных мест при

обработке результатов экспериментов статистическими методами.

Традиционный подход при решении задач сводится к расчету

параметров эмпирического распределения, принятию их в качестве

оценок параметров генеральной совокупности с последующей

проверкой сходимости эмпирического распределения с предполагаемым теоретическим по критериям 2 (Пирсона), (Колмогорова), 2 (Мизеса). Однако, зависимость методики обработки

результатов эксперимента от предполагаемого теоретического распределения, а также большой объем вычислений, особенно при

использовании 2 , 2 , является недостатком традиционного подхода при определении закона распределения случайной величины.

Создание методов определения закона распределения случайной величины не требующих большого количества выборочных

данных и обеспечивающих достаточную надежность расчета, является актуальной задачей. Одним из таких методов является

графоаналитический метод идентификации закона распределения

показателей качества [90–100].

1.6. Информационные модели сигналов

Передающая информационная система, работает по схеме

рис. 2.1. На вход системы подается совокупность сообщений х1, х2,

…, хn. Задача системы передать совокупность этих сообщений с

достаточно высокой достоверностью на выходе y1, у2, ..., уn без

ошибок или с допустимыми ошибками [33, 34, 35, 36, 37].

x1

x2

Информационная система

xn

y1

y

2

yn

Рис. 1.2. Информационные системы

В процессе передачи сообщение подвергается многочисленным преобразованиям, существенно меняющим его физические

характеристики. Однако передаваемая информация должна оставаться инвариантной

при всех преобразованиях. Количество

передаваемой получателю информации связано с неопределенностью, которая имела место относительно передаваемого сообщения. Необходимо отметить, что всякая информация получается

потребителем после принятия сообщения, т.е. в результате опыта.

Сообщение, получаемое на приемной стороне, несет полезную

информацию лишь в том случае, если имеется неопределенность

относительно состояния источника сообщений. Мера количества

информации впервые была предложена К. Шенноном в 1948 году и

затем более строго определена А.Я. Хинчиным [38]. Определение

количества информации, содержащейся в сообщении, подчиняется

следующим требованиям:

а) количество информации должно быть аддитивной величиной, т.е. в двух независимых сообщениях оно должно

равняться сумме количества информации в каждом из них;

б) количество информации в сообщении о достоверном

событии равно нулю;

в) количество информации не должно зависеть от качественного содержания сообщения в частности, от степени его важности

для получателя, возможных последствий его передачи и т.д.

Количество информации и неопределенность для всей совокупности сообщений по К. Шеннону можно получать усреднением

по всем событиям.

I ( X ) ( xii )log a

1

( xii )log a P( xi ) H ( X ) .

P( xi )

(1.87)

В случае равной вероятности сообщений выражение (1.87) для

количества информации приводится к виду

I (X) = – loga p(xi) = loga n,

(1.88)

1

– количество передаваемых сообщений.

p( xi )

Такая мера количества информации была предложена в 1928

году Р. Хартли. Необходимо отметить что энтропия Н(Х) и

количество информации I(X) соответствуют зависимости (1.87)

однако физический смысл у них различный. Н(Х) выражает среднюю неопределенность состояния источника сообщений, является

объективной характеристикой источника сообщений, если известна

статистика сообщений и может быть вычислена априорно, т.е. до

получения сообщения. I(Х) есть мера недостатка информации о

состоянии отдельной системы. С поступлением информации о

состоянии системы энтропия последнего снижается. I(X)

определяется апостериорно, т.е. после получения сообщения.

Совпадение Н(Х) и I(X) свидетельствует о том, что количество

получаемой информации равно численно энтропии, которая имела

место относительно источника сообщений.

Единица измерения количества информации и энтропии

зависит от выбора основания логарифма в формуле (1.87). При

использовании десятичных логарифмов количество информации и

энтропия определяются в десятичных единицах – дитах. В случае

использования двоичных логарифмов измеряются

количество

информации и энтропия в двоичных единицах – битах. При

где n

использовании натуральных логарифмов единицей измерения

является натуральная единица – нит.

При анализе информационных процессов в электронновычислительных машинах и других устройствах, функционирующих на основе двоичной системы счисления, удобно пользоваться

двоичными единицами – битами.

При анализе процессов в приборах, работающих в десятичной

(или двоично-десятичной) системе счисления целесообразно пользоваться десятичными единицами – дитами. В математических выкладках удобно пользоваться натуральными единицами – нитами.

Основным недостатком определения количества информации

по К. Шеннону, как отмечают некоторые исследователи, является

то, что количество информации не зависит от качественного

содержания сообщения. Это положение привело к возникновению и

развитию теории ценности информации, сущность которой

сводится к тому, что ценность некоторого сообщения следует

измерять в соответствии с тем эффектом, который достигается в

результате приема этого сообщения. Основоположником теории

ценности информации считается Дж. Максвелл [39].

Сформулируем свойства энтропии дискретных сообщений:

а) энтропия есть величина вещественная ограниченная и

неотрицательная, это свойство следует из того, что вероятность р(хi)

есть величина неотрицательная, заключенная в промежутке 0≤ р(хi)

≤ 1;

б) энтропия детерминированных сообщений равна нулю,

если заранее известно, какое будет событие, например х1, то

вероятность того события равна единице, а остальных нулю, т.е.

р(хi) = 1, р(х2) = р(хn) = 0.

в) энтропия максимальна, если все события равновероятны

1

1

H ( x)max log à log à n .

n

i 1 n

n

(1.89)

Как видно из выражения (1.89), в случае равновероятных

событий энтропия возрастает с увеличением количества событий.

Энтропия системы двух альтернативных событий может

изменяться в пределах от нуля до единицы. Энтропия системы двух

событий равна

H(X) = –p(x1) logаp(x1) – p(x2)logа2p(x2) =

= p(x1)logа p(x1) – [1 – p(x1)]logа[1 – p(x1)],

из последнего выражения видно, что энтропия равна нулю при

p(x1)=0; p(x2) = 1

p(x1)=1; p(x2) = 0.

Максимум энтропии будет иметь место когда

p(x1) = p(x2).

Энтропия непрерывных сообщений.

Непрерывное сообщение как случайная величина характеризуется дифференциальным законом распределения вероятности

w(х). Дифференциальная энтропия равна

h( x) = – w (x)logаw (x)dx.

(1.90)

Величина h(x) зависит от масштаба х, т.е. от выбора единицы

измерения и отдельно не может служить абсолютной мерой

неопределенности непрерывного сообщения [40, 41]. При решении

задач передачи информации часто имеют дело с несколькими

источниками.

Совокупность

сообщений

вырабатываемых

несколькими источниками называется сложным сообщением.

Сообщения первого источника принимают значения x1, x2, ...,

хn с вероятностями p(x1), p(x2) …, p(xn), и сообщения второго

источника принимают значения y1, y2, …, ym c вероятностями p(y1),

p(y2), …, p(ym).

Совместную энтропию совокупности сообщений Х и Y равно

n m

H ( X , Y ) P( xi , y j )log a p( xi , y j ) .

i 1 j 1

(1.91)

Основные свойства энтропии сложных сообщений:

1) При статически независимых сообщениях Х и Y совместная

энтропия равна сумме энтропий сообщения

H(X, Y) = H(X) + H(Y)

(1.92)

2) При полной статической зависимости Х и Y совместная

энтропия равна безусловной энтропии одного из сообщений.

H(X, Y) = H(X) = H(Y)

(1.93)

3) Условная энтропия может изменяться в пределах

0 ≤ H(Y X,) ≤ H(Y)

(1.94)

4) Для совместной энтропии всегда справедливо соотношение

H(X, Y) ≤ H(X) + H(Y)

(1.95)

5) Дифференциальная энтропия объединения непрерывных

случайных величин X и Y имеет вид

h( X , Y ) w( x)log a w( x)dx

(1.96)

w( x, y )log a w( y x)dxdy h( x) h( y x)

где h(x) – дифференциальная энтропия сообщения х; h(y/x) – условная дифференциальная энтропия сообщений Y; w (X, Y) плотность совместного распределения Х и Y; w (X/Y) – условная плотность распределения X относительно Y.

В реальных условиях передача сообщений происходит при

воздействии помех.

Вследствие отличия принимаемых сообщений от передаваемых при оценке количества передаваемой информации целесообразнее рассматривать две системы: систему передаваемых X и

принимаемых сообщений Y.

Количество информации вследствие помех будет равно

I ( y j , xi ) H ( xi ) H ( xi / y j ) log a

p( xi / y j )

p( xi )

;

(1.97)

где H(xj) – априорная энтропия сообщения xi,

H(xi/yi) – условная энтропия при получении сообщения yi не полностью.

Среднее количество информации обо всех xi, содержащееся в

одном принятом сообщении yi, можно получить усреднением по

всем xi

n

p( xi / y j )

I ( y j , Õ ) p( xi / y j )log a

(1.98)

p

(

x

)

i 1

i

Количество информации, содержащееся во всей совокупности

принятых сообщений Y относительно всей совокупности переданных сообщений Х, при осуществлении усреднения по всем yj

n n

p ( xi / y j )

i 1 i 1

p ( xi )

I (Y , X ) p( y j ) p ( xi / y j )log a

,

(1.99)

или используя равенство p(yj)p(xi/yj) = p(xi, yj)

n n

p( xi / y j )

i 1 i 1

p( xi ) p( y j )

I (Y , X ) p( y j ) p( xi / y j )log a

(1.100)

H (X ) H (X /Y )

Таким образом, среднее количество информации, получаемое

при неполной достоверности сообщений, равно разности безусловной энтропии H(X) и условной энтропии H(X/Y), характеризующей

остаточную (апостериорную) неопределенность сообщений. Количество информации, которое содержится в сообщении Y относительно сообщения Х, равно количеству информации содержащейся

в Х относительно Y.

I(Y, X) = I(X, Y)

(1.101)

Сумма I(Y, X) и I(X, Y) – называют полной взаимной информацией.

Для определения количества информации при непрерывных

сообщениях произведем переход от дискретных к непрерывным

случайным величинам через функции распределения плотности

вероятности

p(xi) = w(xi) xi,

p(yj) = w(yj) yj,

p(xi, yj) = w(xi, yj) xi yj ,

P(xi/yj) = w(xi/yj) xi ,

(1.102)

где xi и Δyj – элементарные участки, на которые разбиты шкалы

уровней случайных величин х и у, w(xi) w(yj), w(xi,yj),

w(xi/yj) – значения функций распределения при аргументах

X = xi, Y = yj

Тогда (1.99) (1.102) произведя замены, получим

n

I (Y , X ) w( xi )xi log a [ w( xi ) xi ]

i 1

n

.

n

(1.103)

w( xi , y j )xi y j log a [ w( xi / y j )xi ]

i 1 j 1

Осуществим

получим [5]

предельный

переход

при

хi 0

и yj 0

I ( I , X ) h( X ) h( X / Y ) w( X )log a w( X )dX

(1.104)

w( X , Y )log a w( X / Y )dXdY

если учесть, что

w( X / Y )

w( X , Y )

,

w(Y )

w( X ) w( X , Y )dY ,

то выражение (1.104) будут иметь вид:

I (Y , X ) w( X , Y )log a w( X )dXdY

w( X , Y )log a

w( X , Y )

dXdY

w(Y )

(1.105)

w( X , Y )

dXdY

w

(

X

)

w

(

Y

)

В отличие от дифференциальной энтропии количество информации не зависит от масштаба непрерывных сообщений, если

масштабы X и Y одинаковы.

w( X , Y )log a

При полной статистической зависимости передаваемых Х= хi

и принимаемых Y=yj сообщений имеет место отсутствие помех

H(X/Y) = 0.

В этом случае количество информации, содержащееся в Y

относительно Х равно энтропии передаваемых сообщений

I(X,Y) = H(X) – H(X/Y) = H(X)max

(1.106)

При полной статистической независимости сообщений X и Y,

имеет место при высоком уровне помех, когда помехи подавляют

сигнал

I(X, Y) = 0

т.е. сообщение не содержит никакой информации о сообщениях X.

При реальной передаче информации непрерывные сообщения

воспроизводятся с ограниченной точностью, поэтому количество

информации зависит не только от статистики сообщений Х, но и от

способа его воспроизведения. При этом количество информации,

содержащееся в отсчетах Х* относительно сообщения Х, определится разностью дифференциальных энтропий

I(X*, X) = h(X) – h(X/X*),

(1.107)

где h(X/X*) – условная дифференциальная энтропия, характеризующая потерю информации за счет ограничений точности воспроизведения сообщения источником. Выражение (1.107) можно

привести к виду

w( X , X )

I ( X , X ) w( X , X )log a

dXdY ,

w

(

X

)

w

(

Y

)

Когда задаются требования к верности воспроизведения Х, в

качестве критерия верности может быть использовано допустимое

значение среднеквадратичного отклонения X*,X

( X X ) w( X , X )dXdX

(1.108)

Наименьшее значение I(X*, X) называют эпсилон энтропий [42]

H (X) = min I(X*,X) = h(X) – max h(X/X*)

при σ*≤ ε°,

где ε° – допустимое значение ошибки воспроизведения, псилон-энтропия определяет информационную емкость источника непрерывных сообщений при заданном критерии верности воспроизведения

[40].

При определении энтропии и количества передаваемой информации предполагают, что элементы сообщений статистически независимы. Однако в реальных условиях независимость элементов

сообщений – явление редкое.

Очевидно, что при определении энтропии и информации в

сообщениях, элементы которых коррелированны, нельзя ограничиваться только безусловными вероятностями элементов сообщения,

необходимо учитывать и условные вероятности появления

элементов.

Будем предполагать, что передается конечное число сообщений x1, x2, …, xn–1xn коррелятивные связи между элементами сообщений могут распространяться на различные группы элементов.

Если элементы сообщений независимы, то условная вероятность

передачи элемента хi будет равна безусловной

р(xj /x1, x2, …, xn) = p(x)j.

(1.109)

Если имеется коррелятивная связь только между двумя

соседними элементами, то вероятности передачи любого элемента

сообщения будет зависеть лишь от того, каков был предшествующий символ, т.е. условная вероятность передачи элемента xj будет

равна р(xj/xi). В этом случае элементы сообщений составляют

простую односвязную цепь Маркова.

Если коррелятивные связи охватывают три элемента

сообщений, то последние представляют двухсвязную цепь Маркова

и условная вероятность передачи элемента xj будет равна р(xj /xi, xn).

Большинство сообщений в реальных условиях представляют

собой эргодическую последовательность, у которой коррелятивные

связи распространяются на конечное число элементов. При доста-

точной длине такой последовательности с достаточной точностью

могут быть определены вероятности и условные вероятности

появления отдельных сообщений.

Пусть сообщения составляют простую, т.е. односвязную цепь

Маркова. В этом случае энтропия элемента xj будет определяться

условной вероятностью р(xj /xi).

Для данного фиксированного xi энтропия сообщений будет

определяться частной условной энтропией.

n

H ( X1 / xi ) p( x j / xi )log a p( x j / xi ) .

j 1

Произведя усреднение по всем xi, получим выражение для

средней энтропии сообщения.

n

n

n

i 1

i 1

j 1

H ( X ) p ( xi ) H ( X / xi ) p ( xi ) p ( x j / xi )log a p( x j / xi )

n

n

(1.110)

p ( xi , x j )log a p ( x j / xi )

i 1 j 1

В случае наличия коррелятивных связей между тремя элементами энтропия сообщений будет равна

n

n

n

H ( Õ ) p ( xi , xn ) p ( x j / xi , xn )log a p ( x j / xi , xn )

n 1 i 1

n

n

n

j 1

(1.111)

p ( x j , xi , xn )log a p ( x j / xi , xn )

n 1 i 1 j 1

Если коррелятивными связями охвачено большое число

элементов, то энтропия определяется аналогично.

При наличии коррелятивных связей между элементами

энтропия сообщений, а, следовательно, и количество передаваемой

информации уменьшается, причем это уменьшение будет тем

интенсивнее, чем сильнее коррелятивные связи и чем большее

число элементов будет охвачено этими связями.

1.6.1. Избыточность сообщений

Средняя энтропия сообщений при одинаковом количестве

элементов может быть различной в зависимости от статистических

характеристик сообщений. Энтропия максимальная и определяется

выражением (1.88), если элементы сообщений равновероятны и

взаимно независимы. Если поступление элементов сообщений не

равновероятно, то энтропия уменьшается и определяется выражением (1.87).

Еще меньшей будет энтропия при наличии коррелятивных

связей между элементами сообщений. Для случаев, когда

коррелятивные связи схватывают два или три элемента, энтропия

определяется выражениями (1.111). Сообщения, энтропия которых

максимальна, являются оптимальными с точки зрения наибольшего

количества передаваемой информации.

Мерой количественной оценки того, насколько данное

реальное сообщение по своей энтропии отличается от соответствующего ему оптимального сообщения, является коэффициент

сжатия

H(X )

,

(1.112)

H ( X )max

где Н(Х) энтропия реального сообщения;

H(X)max – энтропия соответствующего ему оптимального сообщения.

Если неоптимальное и оптимальное сообщение характеризуется одинаковой общей энтропией, то справедливо равенство

M

nH(X) = n' H(X)max .

где n – число элементов неоптимального сообщения;

n' – число элементов соответствующего оптимального сообщения.

Так как средняя на элемент энтропия оптимального сообщения

максимальна, то число элементов неоптимального сообщения

всегда будет больше числа элементов соответствующего ему

оптимального сообщения. Коэффициент сжатия (1.112) будет равен

n

.

(1.113)

n

Таким образом, реальные сообщения при одинаковой информативности обладают определенной избыточностью в элементах по

сравнению с оптимальными сообщениями.

M=

Мерой количественной оценки избыточности является коэффициент избыточности

Ku

n n H ( X )max H ( X )

1 .

n

H ( X )max

(1.114)

Избыточность приводит к увеличению времени передачи

сообщений, излишней загрузке канала связи. Некоторая избыточность бывает иногда полезной для обеспечения требуемой надежности систем, повышения помехоустойчивости передачи связи

сообщений.

Под производительностью источника сообщений подразумевают количество информации, вырабатываемое источником в

единицу времени. Эту характеристику источника называют также

скоростью создания сообщений или источником входной информации. Поскольку взаимное воздействие помех на источник сообщений принято учитывать эквивалентным изменением характеристик

модели канала связи, то производительность источника сообщений

равна энтропии источника, приходящейся на единицу времени.

Длительность выдачи знаков источником в каждом из

состояний в общем случае может быть различной. Обозначим длительность выдачи знака хі, формируемого источником в состоянии

Sq через τqxi. Тогда средняя длительность выдачи источником одного

знака

R

e

q 1

i 1

tu p( Sq ) pq ( x1 )tqxi

(1.119)

Производительность источника I ( xi ) можно выразить формулой

I ( X ) H ( X ) / tu

(1.120)

Как следует из (1.119) повышение производительности истоника

возможно не только за счет увеличения энтропии, но и за счет

снижения средней длительности формирования знаков, поэтому

желательно выбирать с обратно пропорциональными вероятностями

их появления.

Основным достоинством статистической меры количества информации является ее универсальность. Информация измеряется в

одних и тех же единицах независимо от ее физической природы и со-

держания. В связи с этим рассмотренная мера количества информации является во многих случаях весьма удобной при анализе и

синтезе сложных информационных систем и наиболее рациональной

при оптимизации характеристик систем. Важным преимуществом

статистической меры количества информации является ее объективность. Статистическая оценка событий не зависит от психологических

факторов, ибо устанавливается на основе экспериментальных данных.

Вместе с тем то обстоятельство, что в основу измерения количества информации положены лишь статистические характеристики

событий, ограничивает возможности данной меры информации.

В ряде случаев важно оценить смысловое содержание (семантику), а также ценность или целесообразность информации. Статистическая мера количества информации не в состоянии обеспечить

решение данных задач.

В последнее время делаются попытки расширения области применения теории информации за счет введения семантических мер

информации, мер содержательности целесообразности информации

[43, 44, 45].